Vytvoření a spuštění úloh Azure Databricks

Tento článek podrobně popisuje, jak vytvářet a spouštět úlohy Azure Databricks pomocí uživatelského rozhraní úloh.

Informace o možnostech konfigurace pro úlohy a o tom, jak upravit existující úlohy, najdete v tématu Konfigurace nastavení pro úlohy Azure Databricks.

Informace o správě a monitorování spuštění úloh najdete v tématu Zobrazení a správa spuštění úloh.

Pokud chcete vytvořit první pracovní postup pomocí úlohy Azure Databricks, podívejte se na rychlý start.

Důležité

- Pracovní prostor je omezený na 1 000 souběžných spuštění úloh. Když si vyžádáte spuštění, které nejde zahájit okamžitě, vrátí se odpověď

429 Too Many Requests. - Počet úloh, které může pracovní prostor vytvořit za hodinu, je omezený na 1 0000 (zahrnuje "spuštění odeslat"). Toto omezení platí také pro úlohy vytvořené pomocí rozhraní REST API a pracovních postupů poznámkových bloků.

Vytváření a spouštění úloh pomocí rozhraní příkazového řádku, rozhraní API nebo poznámkových bloků

- Další informace o vytváření a spouštění úloh pomocí rozhraní příkazového řádku Databricks najdete v tématu Co je rozhraní příkazového řádku Databricks?

- Další informace o použití rozhraní API úloh k vytváření a spouštění úloh najdete v tématu Úlohy v referenčních informacích k rozhraní REST API.

- Informace o tom, jak spouštět a plánovat úlohy přímo v poznámkovém bloku Databricks, najdete v tématu Vytváření a správa naplánovaných úloh poznámkového bloku.

Vytvoření úlohy

Proveďte některou z následujících akcí:

- Na bočním panelu klikněte na

Pracovní postupy a klikněte na .

Pracovní postupy a klikněte na .

- Na bočním panelu klikněte na

Nový a vyberte Úloha.

Nový a vyberte Úloha.

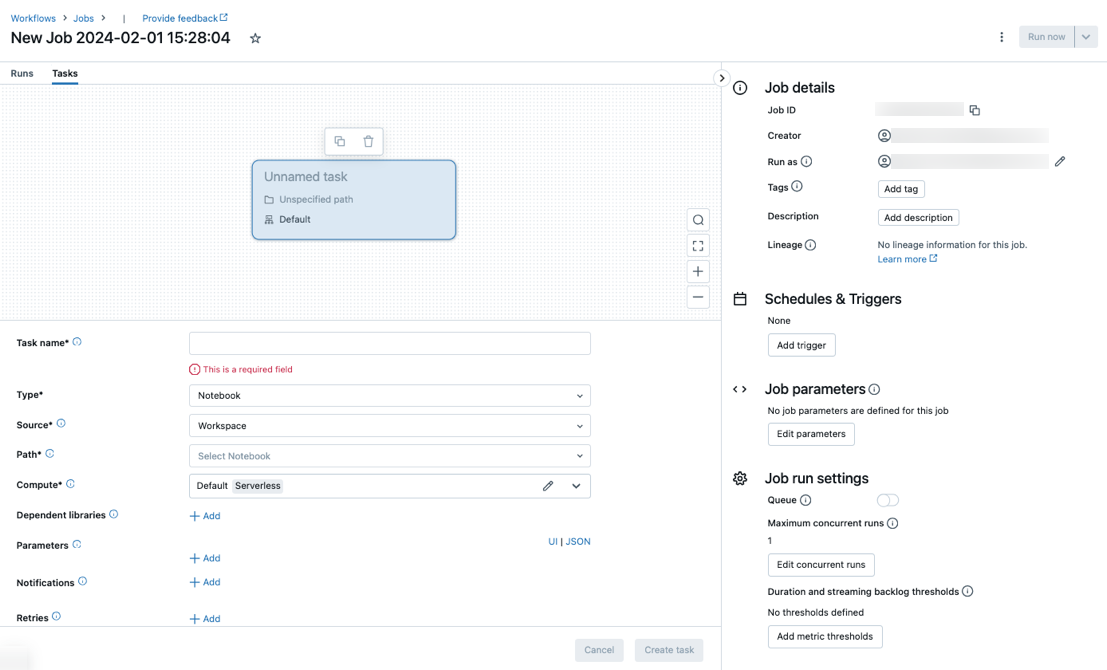

Zobrazí se karta Úkoly s dialogovým oknem vytvořit úkol spolu s bočním panelem Podrobnosti úlohy obsahujícím nastavení na úrovni úlohy.

- Na bočním panelu klikněte na

Nahraďte novou úlohu... názvem vaší úlohy.

Do pole Název úkolu zadejte název úkolu.

V rozevírací nabídce Typ vyberte typ úlohy, která se má spustit. Viz Možnosti typu úkolu.

Nakonfigurujte cluster, ve kterém se úloha spouští. Ve výchozím nastavení se výpočetní prostředky bez serveru vyberou, pokud je váš pracovní prostor v pracovním prostoru s podporou katalogu Unity a pro pracovní postupy jste vybrali úlohu podporovanou bezserverovým výpočetním prostředím. Viz Spuštění úlohy Azure Databricks s bezserverovými výpočetními prostředky pro pracovní postupy. Pokud výpočetní prostředky bez serveru nejsou dostupné nebo chcete použít jiný typ výpočetních prostředků, můžete v rozevírací nabídce Compute vybrat nový cluster úloh nebo existující cluster pro všechny účely.

- Nový cluster úloh: V rozevírací nabídce Cluster klikněte na Upravit a dokončete konfiguraci clusteru.

- Existující cluster pro všechny účely: V rozevírací nabídce Cluster vyberte existující cluster. Pokud chcete cluster otevřít na nové stránce, klikněte na

ikonu napravo od názvu a popisu clusteru.

ikonu napravo od názvu a popisu clusteru.

Další informace o výběru a konfiguraci clusterů pro spouštění úloh najdete v tématu Použití výpočetních prostředků Azure Databricks s úlohami.

Chcete-li přidat závislé knihovny, klikněte na + Přidat vedle závislých knihoven. Viz Konfigurace závislých knihoven.

Pro svůj úkol můžete předat parametry. Informace o požadavcích na formátování a předávání parametrů najdete v tématu Předání parametrů úloze Azure Databricks.

Pokud chcete volitelně dostávat oznámení o zahájení, úspěchu nebo neúspěchu úkolu, klikněte na + Přidat vedle e-mailů. Oznámení o selhání se odesílají při počátečním selhání úkolu a případné následné opakování. Pokud chcete filtrovat oznámení a snížit počet odeslaných e-mailů, zkontrolujte ztlumení oznámení o přeskočených spuštěních, ztlumení oznámení pro zrušená spuštění nebo ztlumení oznámení do posledního opakování.

Pokud chcete volitelně nakonfigurovat zásadu opakování úkolu, klikněte na + Přidat vedle opakování. Viz Konfigurace zásad opakování pro úlohu.

Pokud chcete volitelně nakonfigurovat očekávanou dobu trvání nebo vypršení časového limitu úkolu, klikněte na + Přidat vedle prahové hodnoty doby trvání. Viz Konfigurace očekávaného času dokončení nebo časového limitu úkolu.

Klikněte na Vytvořit.

Po vytvoření prvního úkolu můžete nakonfigurovat nastavení na úrovni úlohy, jako jsou oznámení, triggery úloh a oprávnění. Viz Úprava úlohy.

Pokud chcete přidat další úkol, klikněte  v zobrazení DAG. Možnost sdíleného clusteru je k dispozici, pokud jste pro předchozí úlohu vybrali bezserverový výpočetní výkon nebo nakonfigurovali nový cluster úloh. Cluster můžete také nakonfigurovat pro každou úlohu při vytváření nebo úpravě úlohy. Další informace o výběru a konfiguraci clusterů pro spouštění úloh najdete v tématu Použití výpočetních prostředků Azure Databricks s úlohami.

v zobrazení DAG. Možnost sdíleného clusteru je k dispozici, pokud jste pro předchozí úlohu vybrali bezserverový výpočetní výkon nebo nakonfigurovali nový cluster úloh. Cluster můžete také nakonfigurovat pro každou úlohu při vytváření nebo úpravě úlohy. Další informace o výběru a konfiguraci clusterů pro spouštění úloh najdete v tématu Použití výpočetních prostředků Azure Databricks s úlohami.

Volitelně můžete nakonfigurovat nastavení na úrovni úlohy, jako jsou oznámení, triggery úloh a oprávnění. Viz Úprava úlohy. Můžete také nakonfigurovat parametry na úrovni úlohy, které jsou sdíleny s úkoly úlohy. Viz Přidání parametrů pro všechny úkoly úlohy.

Možnosti typu úkolu

Níže jsou uvedené typy úloh, které můžete přidat do úlohy Azure Databricks a dostupné možnosti pro různé typy úloh:

Poznámkový blok: V rozevírací nabídce Zdroj vyberte Pracovní prostor a použijte poznámkový blok umístěný ve složce pracovního prostoru Azure Databricks nebo poskytovateli Gitu pro poznámkový blok umístěný ve vzdáleném úložišti Git.

Pracovní prostor: Pomocí prohlížeče souborů vyhledejte poznámkový blok, klikněte na název poznámkového bloku a klikněte na Potvrdit.

Poskytovatel Gitu: Klikněte na Upravit nebo přidat odkaz na Git a zadejte informace o úložišti Git. Viz Použití poznámkového bloku ze vzdáleného úložiště Git.

Poznámka:

Celkový výstup buňky poznámkového bloku (kombinovaný výstup všech buněk poznámkového bloku) podléhá limitu velikosti 20 MB. Výstup jednotlivých buněk navíc podléhá limitu velikosti 8 MB. Pokud celkový výstup buňky přesahuje velikost 20 MB nebo pokud je výstup jednotlivé buňky větší než 8 MB, spuštění se zruší a označí jako neúspěšné.

Pokud potřebujete pomoc s hledáním buněk poblíž nebo nad limitem, spusťte poznámkový blok proti clusteru pro všechny účely a použijte tuto techniku automatického ukládání poznámkového bloku.

JAR: Zadejte hlavní třídu. Použijte plně kvalifikovaný název třídy obsahující hlavní metodu,

org.apache.spark.examples.SparkPinapříklad . Potom klikněte na Přidat v části Závislé knihovny a přidejte knihovny potřebné ke spuštění úlohy. Jedna z těchto knihoven musí obsahovat hlavní třídu.Další informace o úkolech JAR najdete v tématu Použití souboru JAR v úloze Azure Databricks.

Spark Submit: Do textového pole Parametry zadejte hlavní třídu, cestu k souboru JAR knihovny a všechny argumenty formátované jako pole řetězců JSON. Následující příklad nakonfiguruje úlohu spark-submit pro spuštění

DFSReadWriteTestz příkladů Apache Sparku:["--class","org.apache.spark.examples.DFSReadWriteTest","dbfs:/FileStore/libraries/spark_examples_2_12_3_1_1.jar","/discover/databricks-datasets/README.md","/FileStore/examples/output/"]Důležité

Úlohy spark-submit mají několik omezení:

- Úlohy spark-submit můžete spouštět jenom v nových clusterech.

- Spark-submit nepodporuje automatické škálování clusteru. Další informace o automatickém škálování najdete v tématu Automatické škálování clusteru.

- Spark-submit nepodporuje referenční informace k nástrojům Databricks (dbutils). Pokud chcete použít nástroje Databricks, použijte místo toho úlohy JAR.

- Pokud používáte cluster s podporou katalogu Unity, podporuje se spark-submit jenom v případě, že cluster používá přiřazený režim přístupu. Režim sdíleného přístupu není podporován.

- Úlohy streamování Sparku by nikdy neměly mít maximální počet souběžných spuštění nastavený na vyšší než 1. Úlohy streamování by se měly nastavit tak, aby běžely pomocí výrazu

"* * * * * ?"cron (každou minutu). Vzhledem k tomu, že úloha streamování běží nepřetržitě, měla by být vždy konečným úkolem v úloze.

Skript Pythonu: V rozevírací nabídce Zdroj vyberte umístění skriptu Pythonu, buď pracovní prostor skriptu v místním pracovním prostoru, DBFS pro skript umístěný v DBFS nebo poskytovatel Gitu pro skript umístěný v úložišti Git. Do textového pole Cesta zadejte cestu ke skriptu Pythonu:

Pracovní prostor: V dialogovém okně Vybrat soubor Pythonu přejděte do skriptu Pythonu a klikněte na Potvrdit.

DBFS: Zadejte identifikátor URI skriptu Pythonu v DBFS nebo cloudovém úložišti,

dbfs:/FileStore/myscript.pynapříklad .Poskytovatel Gitu: Klikněte na Upravit a zadejte informace o úložišti Git. Viz Použití kódu Pythonu ze vzdáleného úložiště Git.

Kanál delta živých tabulek: V rozevírací nabídce kanálu vyberte existující kanál dynamických tabulek Delta.

Důležité

S úlohou Kanálu můžete použít pouze aktivované kanály. Průběžné kanály nejsou podporovány jako úloha úlohy. Další informace o aktivovaných a průběžných kanálech najdete v tématu Průběžné a aktivované spuštění kanálu.

Python Wheel: Do textového pole Název balíčku zadejte balíček, který chcete importovat,

myWheel-1.0-py2.py3-none-any.whlnapříklad . Do textového pole Vstupní bod zadejte funkci, která se má volat při spuštění souboru kola Pythonu. Kliknutím na Přidat v části Závislé knihovny přidejte knihovny potřebné ke spuštění úlohy.SQL: V rozevírací nabídce úkolu SQL vyberte dotaz, řídicí panel starší verze, upozornění nebo soubor.

Poznámka:

- Úloha SQL vyžaduje Databricks SQL a bezserverový nebo pro SQL Warehouse.

Dotaz: V rozevírací nabídce dotazu SQL vyberte dotaz, který se má spustit při spuštění úlohy.

Starší řídicí panel: V rozevírací nabídce řídicího panelu SQL vyberte řídicí panel, který se má aktualizovat při spuštění úlohy.

Výstraha: V rozevírací nabídce upozornění SQL vyberte výstrahu, která se má aktivovat pro vyhodnocení.

Soubor: Pokud chcete použít soubor SQL umístěný ve složce pracovního prostoru Azure Databricks, vyberte v rozevírací nabídce Zdroj pracovní prostor, pomocí prohlížeče souborů vyhledejte soubor SQL, klikněte na název souboru a klikněte na Potvrdit. Pokud chcete použít soubor SQL umístěný ve vzdáleném úložišti Git, vyberte poskytovatele Gitu, klikněte na Upravit nebo Přidat odkaz gitu a zadejte podrobnosti o úložišti Git. Viz Použití dotazů SQL ze vzdáleného úložiště Git.

V rozevírací nabídce SQL Warehouse vyberte bezserverový nebo pro SQL Warehouse, aby se úloha spustila.

dbt: Podrobný příklad konfigurace úlohy dbt najdete v tématu Použití transformací dbt v úloze Azure Databricks.

Spustit úlohu: V rozevírací nabídce Úloha vyberte úlohu, kterou má úkol spustit. Pokud chcete vyhledat úlohu, která se má spustit, začněte psát název úlohy v nabídce Úloha .

Důležité

Při použití

Run Jobúkolu nebo úloh, které vnoří více než třiRun Jobúkoly, byste neměli vytvářet úlohy s cyklickými závislostmi. Cyklické závislosti jsouRun Jobúkoly, které se vzájemně přímo nebo nepřímo aktivují. Úloha A například aktivuje úlohu B a úloha B aktivuje úlohu A. Databricks nepodporuje úlohy s cyklovými závislostmi nebo které vnoří více než třiRun Jobúkoly a nemusí povolit spouštění těchto úloh v budoucích verzích.If/else: Informace o použití

If/else conditionúkolu najdete v tématu Přidání logiky větvení do úlohy pomocí úlohy podmínky If/else.

Předání parametrů do úlohy Azure Databricks

Parametry můžete předat mnoha typům úloh. Každý typ úlohy má jiné požadavky na formátování a předávání parametrů.

Chcete-li získat přístup k informacím o aktuálním úkolu, například název úkolu nebo předat kontext aktuálního spuštění mezi úkoly úlohy, například čas zahájení úlohy nebo identifikátor aktuálního spuštění úlohy, použijte odkazy na dynamické hodnoty. Chcete-li zobrazit seznam dostupných odkazů na dynamické hodnoty, klepněte na tlačítko Procházet dynamické hodnoty.

Pokud jsou pro úlohu nakonfigurované parametry úlohy, do které úkol patří, zobrazí se tyto parametry při přidávání parametrů úkolu. Pokud parametry úlohy a úkolu sdílejí klíč, má přednost parametr úlohy. Pokud se pokusíte přidat parametr úkolu se stejným klíčem jako parametr úlohy, zobrazí se v uživatelském rozhraní upozornění. Chcete-li předat parametry úlohy úkolům, které nejsou nakonfigurovány s parametry klíč-hodnota, jako JAR jsou nebo Spark Submit úkoly, formátovat argumenty jako {{job.parameters.[name]}}, nahradit [name]key tím, který identifikuje parametr.

Poznámkový blok: Klikněte na Přidat a zadejte klíč a hodnotu každého parametru, který se má předat úkolu. Pokud ručně spustíte úlohu pomocí možnosti Spustit úlohu s různými parametry, můžete přepsat nebo přidat další parametry . Parametry nastaví hodnotu widgetu poznámkového bloku určeného klíčem parametru.

JAR: K zadání parametrů použijte pole formátované ve formátu JSON. Tyto řetězce se předávají jako argumenty hlavní metodě hlavní třídy. Viz Konfigurace parametrů úlohy JAR.

Spark Submit: Parametry se zadají jako pole řetězců ve formátu JSON. Při souladu s konvencí Apache Spark spark-submit jsou parametry po cestě JAR předány hlavní metodě hlavní třídy.

Kolo Pythonu: V rozevírací nabídce Parametry vyberte Poziční argumenty a zadejte parametry jako pole řetězců ve formátu JSON nebo vyberte Argumenty > klíčového slova Přidat a zadejte klíč a hodnotu každého parametru. Poziční argumenty i argumenty klíčových slov se předávají úloze kolečka Pythonu jako argumenty příkazového řádku. Příklad čtení argumentů ve skriptu Pythonu zabaleného v souboru kola Pythonu najdete v tématu Použití souboru kola Pythonu v úloze Azure Databricks.

Spustit úlohu: Zadejte klíč a hodnotu každého parametru úlohy, který se má do úlohy předat.

Skript Jazyka Python: K zadání parametrů použijte pole řetězců formátované ve formátu JSON. Tyto řetězce se předávají jako argumenty a dají se číst jako poziční argumenty nebo analyzovat pomocí modulu argparse v Pythonu. Příklad čtení pozičních argumentů ve skriptu Pythonu najdete v kroku 2: Vytvoření skriptu pro načtení dat GitHubu.

SQL: Pokud vaše úloha spustí parametrizovaný dotaz nebo parametrizovaný řídicí panel, zadejte hodnoty parametrů do zadaných textových polí.

Zkopírování cesty k úkolu

Některé typy úkolů, například úkoly poznámkového bloku, umožňují zkopírovat cestu ke zdrojovému kódu úkolu:

- Klikněte na kartu Úkoly .

- Vyberte úkol obsahující cestu, kterou chcete zkopírovat.

- Kliknutím

vedle cesty úkolu zkopírujte cestu do schránky.

vedle cesty úkolu zkopírujte cestu do schránky.

Vytvoření úlohy z existující úlohy

Novou úlohu můžete rychle vytvořit klonováním existující úlohy. Klonování úlohy vytvoří identickou kopii úlohy s výjimkou ID úlohy. Na stránce úlohy klikněte na Další ... vedle názvu úlohy a v rozevírací nabídce vyberte Clone (Klonovat ).

Vytvoření úkolu z existujícího úkolu

Nový úkol můžete rychle vytvořit klonováním existujícího úkolu:

- Na stránce úlohy klikněte na kartu Úkoly .

- Vyberte úkol, který chcete klonovat.

- Klikněte a

vyberte Klonovat úkol.

vyberte Klonovat úkol.

Odstranění úlohy

Pokud chcete odstranit úlohu, klikněte na stránce úlohy na Další ... vedle názvu úlohy a v rozevírací nabídce vyberte Odstranit .

Odstranění úkolu

Odstranění úkolu:

- Klikněte na kartu Úkoly .

- Vyberte úkol, který chcete odstranit.

- Klikněte

a vyberte Odebrat úkol.

a vyberte Odebrat úkol.

Spuštění úlohy

- Na bočním panelu klikněte na

Pracovní postupy.

Pracovní postupy. - Vyberte úlohu a klikněte na kartu Spuštění . Úlohu můžete spustit okamžitě nebo naplánovat, aby se úloha spustila později.

Pokud jeden nebo více úkolů v úloze s více úkoly není úspěšné, můžete znovu spustit podmnožinu neúspěšných úkolů. Viz Znovu spustit neúspěšné a přeskočené úlohy.

Okamžité spuštění úlohy

Chcete-li úlohu spustit okamžitě, klikněte na  tlačítko .

tlačítko .

Tip

Testovací spuštění úlohy s úlohou poznámkového bloku můžete provést kliknutím na Spustit nyní. Pokud potřebujete v poznámkovém bloku udělat změny, po úpravách poznámkového bloku se po úpravě poznámkového bloku automaticky spustí nová verze poznámkového bloku.

Spuštění úlohy s různými parametry

Funkci Spustit nyní s různými parametry můžete použít k opětovnému spuštění úlohy s různými parametry nebo různými hodnotami pro existující parametry.

Poznámka:

Parametry úlohy nelze přepsat, pokud úloha, která byla spuštěna před zavedením parametrů úlohy, přetíží parametry úlohy se stejným klíčem.

- Klikněte vedle

možnosti Spustit a vyberte Spustit s různými parametry nebo v tabulce Aktivní spuštění klikněte na Spustit s různými parametry. Zadejte nové parametry v závislosti na typu úlohy. Viz Předání parametrů úloze Azure Databricks.

možnosti Spustit a vyberte Spustit s různými parametry nebo v tabulce Aktivní spuštění klikněte na Spustit s různými parametry. Zadejte nové parametry v závislosti na typu úlohy. Viz Předání parametrů úloze Azure Databricks. - Klepněte na položku Spustit.

Spuštění úlohy jako instančního objektu

Poznámka:

Pokud vaše úloha spouští dotazy SQL pomocí úlohy SQL, identita použitá ke spuštění dotazů je určena nastavením sdílení každého dotazu, i když se úloha spustí jako instanční objekt. Pokud je dotaz nakonfigurovaný Run as ownerna , dotaz se vždy spustí pomocí identity vlastníka, nikoli identity instančního objektu. Pokud je dotaz nakonfigurovaný Run as viewerna , spustí se dotaz pomocí identity instančního objektu. Další informace o nastavení sdílení dotazů najdete v tématu Konfigurace oprávnění dotazu.

Ve výchozím nastavení se úlohy spouští jako identita vlastníka úlohy. To znamená, že úloha předpokládá oprávnění vlastníka úlohy. Úloha může přistupovat pouze k datům a objektům Azure Databricks, ke kterým má vlastník úlohy oprávnění. Můžete změnit identitu, kterou úloha běží jako instanční objekt. Úloha pak předpokládá oprávnění tohoto instančního objektu místo vlastníka.

Pokud chcete změnit nastavení Spustit jako , musíte mít oprávnění MŮŽE SPRAVOVAT nebo JE VLASTNÍK úlohy. Nastavení Spustit jako můžete nastavit sami nebo na jakýkoli instanční objekt v pracovním prostoru, ve kterém máte roli instančního objektu. Další informace naleznete v tématu Role pro správu instančních objektů.

Poznámka:

RestrictWorkspaceAdmins Když je nastavení v pracovním prostoru nastavenéALLOW ALL, můžou správci pracovního prostoru také změnit nastavení Spustit jako na libovolného uživatele ve svém pracovním prostoru. Pokud chcete správcům pracovního prostoru omezit jenom nastavení Spustit jako na sebe nebo na instanční objekty, ve kterých mají zapnutou roli uživatele instančního objektu, přečtěte si téma Omezení správců pracovního prostoru.

Pokud chcete změnit pole Spustit jako, postupujte takto:

- Na bočním panelu klikněte na

Pracovní postupy.

Pracovní postupy. - Ve sloupci Název klikněte na název úlohy.

- Na bočním panelu Podrobnosti úlohy klikněte na ikonu tužky vedle pole Spustit jako.

- Vyhledejte a vyberte instanční objekt.

- Klikněte na Uložit.

Pomocí rozhraní API instančních objektů pracovních prostorů můžete také zobrazit seznam instančních objektů, na kterých máte roli Uživatel . Další informace najdete v tématu Seznam instančních objektů, které můžete použít.

Spuštění úlohy podle plánu

Pomocí plánu můžete automaticky spouštět úlohu Azure Databricks v zadaných časech a obdobích. Viz Přidání plánu úlohy.

Spuštění průběžné úlohy

Můžete zajistit, aby vaše úloha byla vždy aktivní. Viz Spuštění průběžné úlohy.

Spuštění úlohy při přijetí nových souborů

Pokud chcete aktivovat spuštění úlohy při příchodu nových souborů do externího umístění nebo svazku katalogu Unity, použijte trigger přijetí souboru.

Zobrazení a spuštění úlohy vytvořené pomocí sady prostředků Databricks

Pomocí uživatelského rozhraní úloh Azure Databricks můžete zobrazit a spustit úlohy nasazené sadou prostředků Databricks. Ve výchozím nastavení jsou tyto úlohy v uživatelském rozhraní úloh jen pro čtení. Pokud chcete upravit úlohu nasazenou sadou, změňte konfigurační soubor sady a znovu ji nasaďte. Použití změn pouze u konfigurace sady zajišťuje, že zdrojové soubory sady vždy zaznamenávají aktuální konfiguraci úlohy.

Pokud ale musíte provést okamžité změny úlohy, můžete úlohu odpojit od konfigurace sady a povolit úpravy nastavení úlohy v uživatelském rozhraní. Chcete-li úlohu odpojit, klepněte na tlačítko Odpojit od zdroje. V dialogovém okně Odpojit od zdroje potvrďte kliknutím na Odpojit .

Všechny změny provedené v úloze v uživatelském rozhraní se na konfiguraci sady nepoužijí. Pokud chcete u sady použít změny, které provedete v uživatelském rozhraní, musíte konfiguraci sady aktualizovat ručně. Pokud chcete úlohu znovu připojit ke konfiguraci sady prostředků, znovu ji nasaďte pomocí sady.

Co když se moje úloha nemůže spustit kvůli limitům souběžnosti?

Poznámka:

Při vytváření úloh v uživatelském rozhraní je ve výchozím nastavení povolená fronta.

Pokud chcete zabránit vynechání spuštění úlohy kvůli omezením souběžnosti, můžete pro úlohu povolit zařazení do fronty. Pokud jsou prostředky pro spuštění úlohy nedostupné, po dobu až 48 hodin se spuštění zařadí do fronty. Pokud je k dispozici kapacita, spuštění úlohy se zruší a spustí. Spuštění ve frontě se zobrazí v seznamu spuštění pro úlohu a v seznamu posledních spuštění úloh.

Spuštění se zařadí do fronty při dosažení jednoho z následujících limitů:

- Maximální počet souběžných aktivních spuštění v pracovním prostoru.

- Maximální počet souběžných

Run Jobúloh běží v pracovním prostoru. - Maximální počet souběžných spuštění úlohy.

Queueing je vlastnost na úrovni úlohy, která se spouští pouze pro danou úlohu.

Chcete-li povolit nebo zakázat fronty, klepněte na tlačítko Upřesnit nastavení a klepněte na přepínač Frontana bočním panelu Podrobnosti úlohy.

Váš názor

Připravujeme: V průběhu roku 2024 budeme postupně vyřazovat problémy z GitHub coby mechanismus zpětné vazby pro obsah a nahrazovat ho novým systémem zpětné vazby. Další informace naleznete v tématu: https://aka.ms/ContentUserFeedback.

Odeslat a zobrazit názory pro