Kopiér fra Azure Blob Storage til Lakehouse

I dette selvstudium skal du oprette en datapipeline for at flytte en CSV-fil fra en inputmappe i en Azure Blob Storage-kilde til en Lakehouse-destination.

Forudsætninger

For at komme i gang skal du fuldføre følgende forudsætninger:

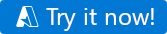

Sørg for, at du har et Project Microsoft Fabric-aktiveret arbejdsområde: Opret et arbejdsområde.

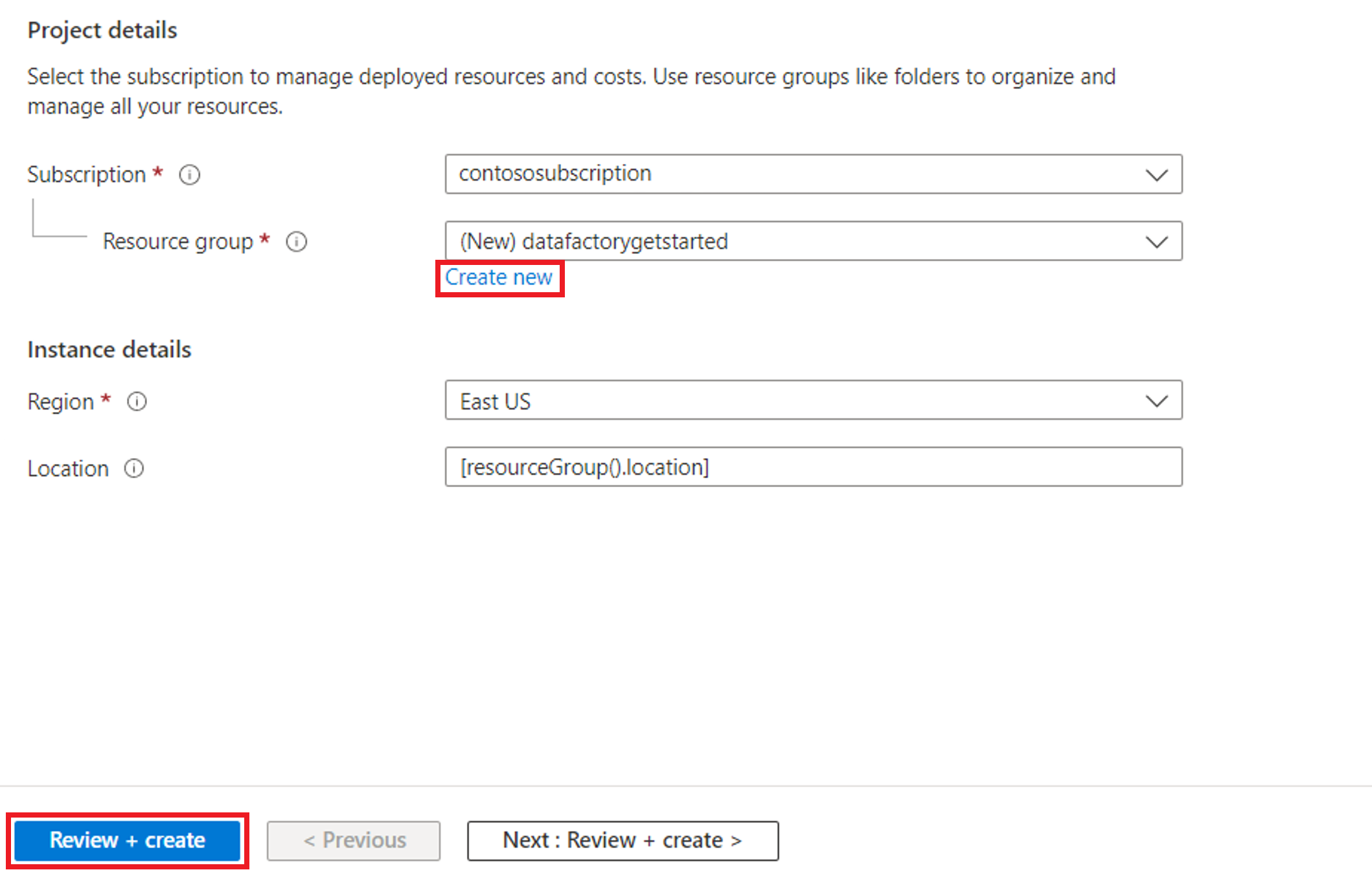

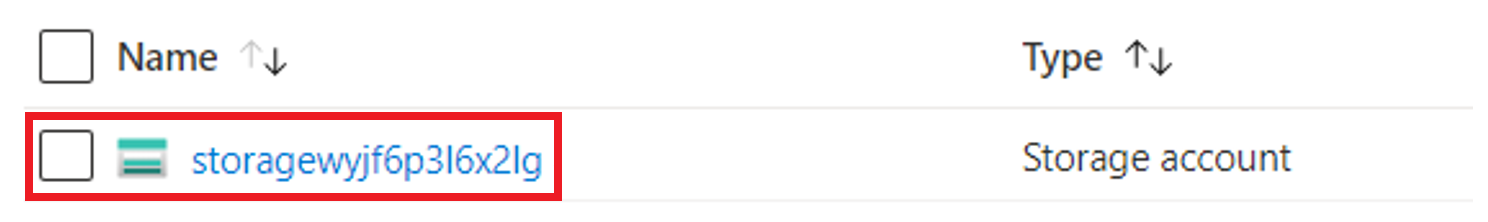

Vælg knappen Prøv det nu! for at forberede Azure Blob Storage-datakilden for Kopiér. Opret en ny ressourcegruppe for dette Azure Blob Storage, og vælg Gennemse + Opret>opret.

Derefter oprettes der et Azure Blob Storage, og moviesDB2.csv overføres til inputmappen for det oprettede Azure Blob Storage.

Opret en datapipeline

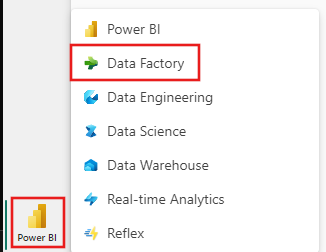

Skift til Data factory på siden app.powerbi.com.

Opret et nyt arbejdsområde til denne demo.

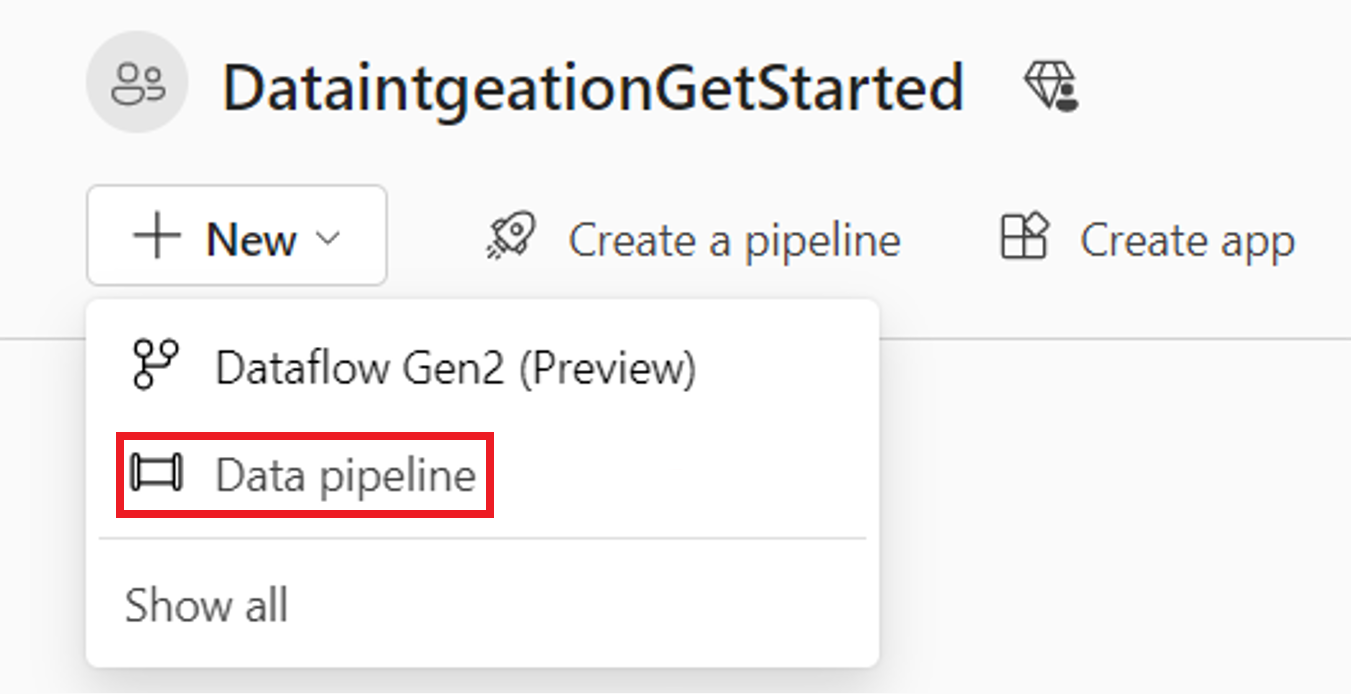

Vælg Ny, og vælg derefter Datapipeline.

Kopiér data ved hjælp af Kopiér assistent

I denne session skal du begynde at oprette en datapipeline ved hjælp af følgende trin. Disse trin kopierer en CSV-fil fra en inputmappe i et Azure Blob Storage til en Lakehouse-destination ved hjælp af kopiassistenten.

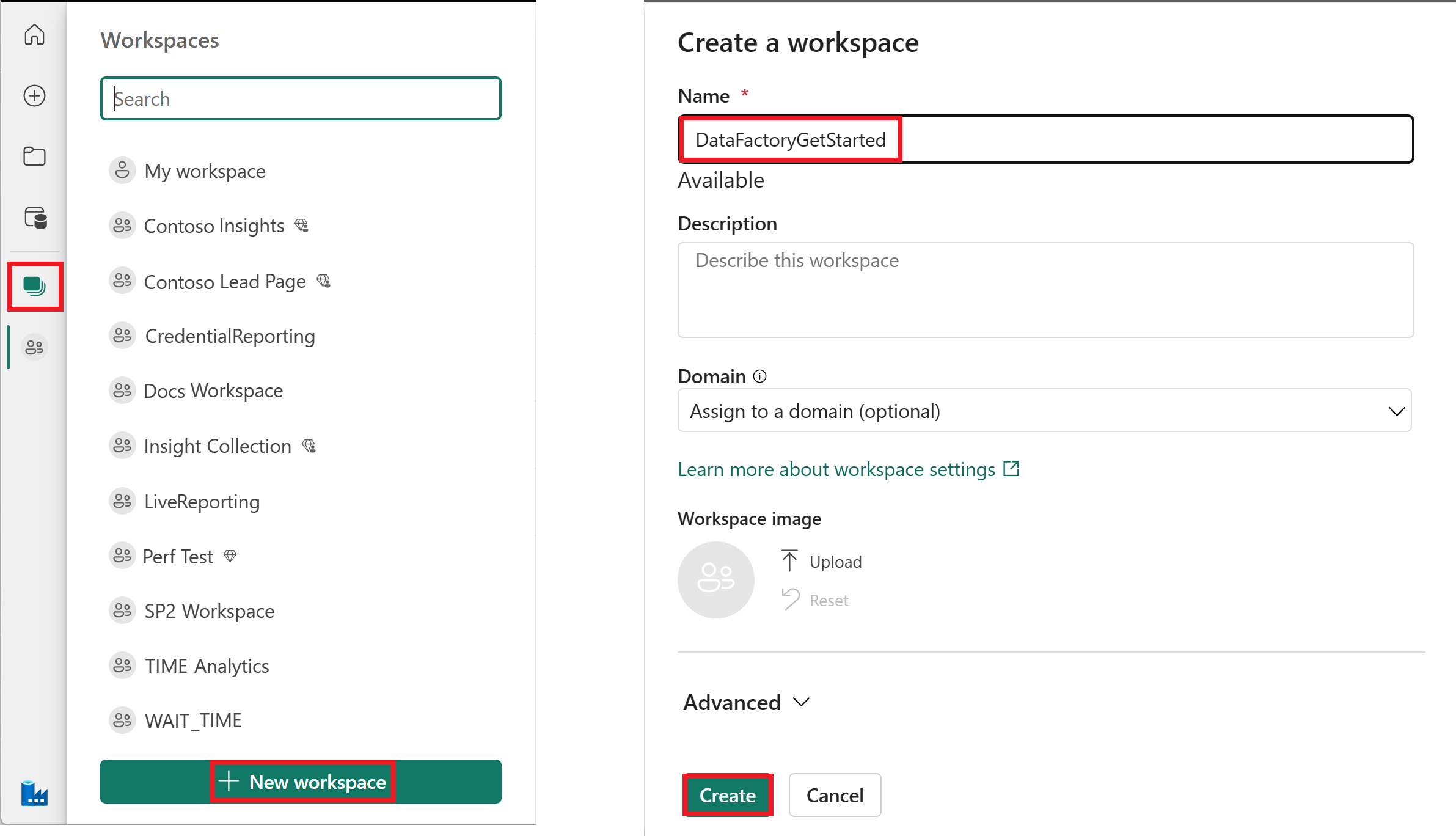

Trin 1: Start med kopiassistenten

Vælg Kopiér data på lærredet for at åbne kopiassistentværktøjet for at komme i gang. Eller vælg Brug kopiassistent på rullelisten Kopiér data under fanen Aktiviteter på båndet.

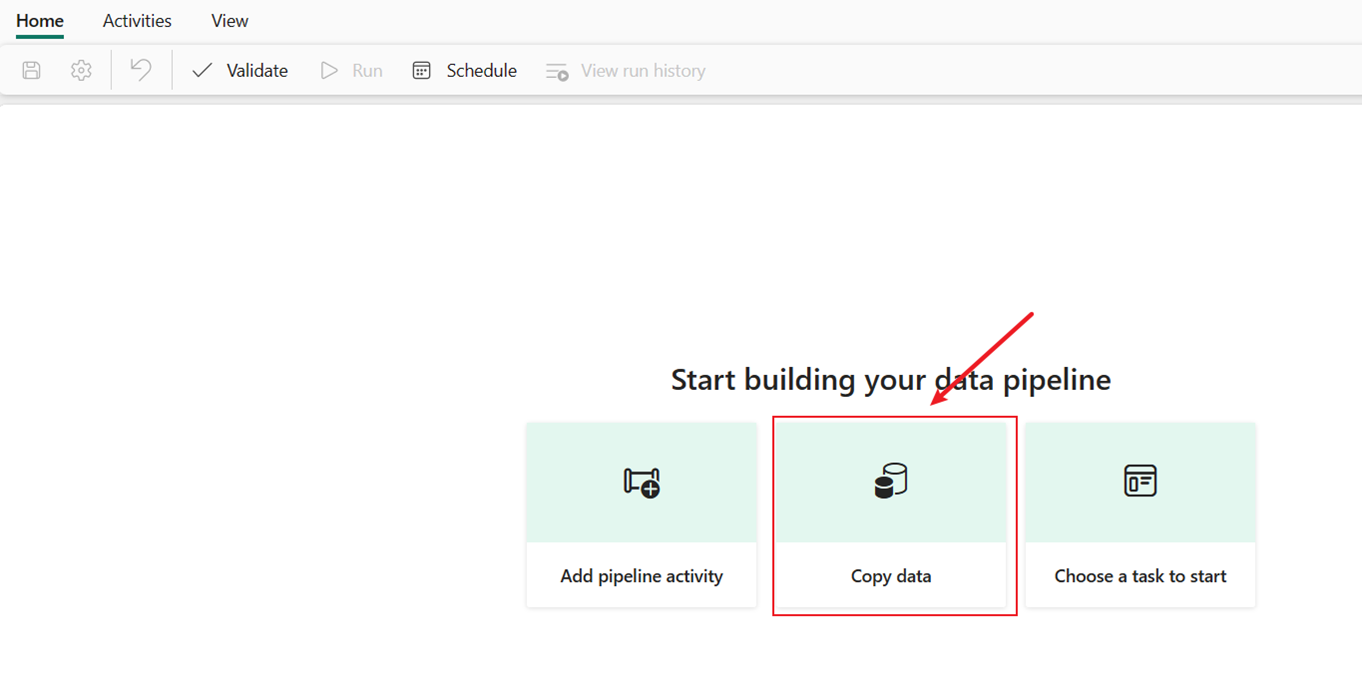

Trin 2: Konfigurer din kilde

Vælg Azure Blob Storage, og vælg derefter Næste.

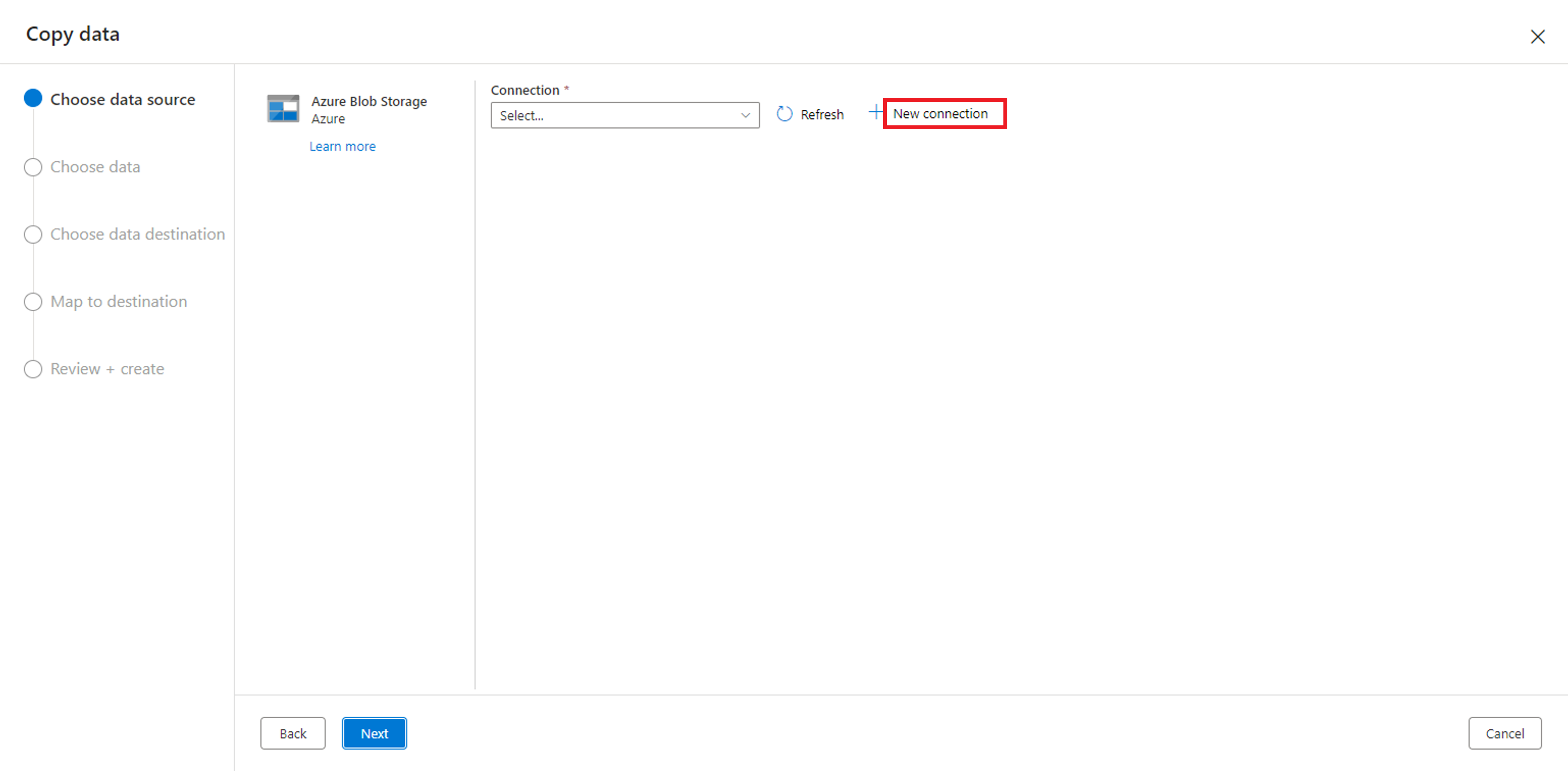

Opret en forbindelse til datakilden ved at vælge Ny forbindelse.

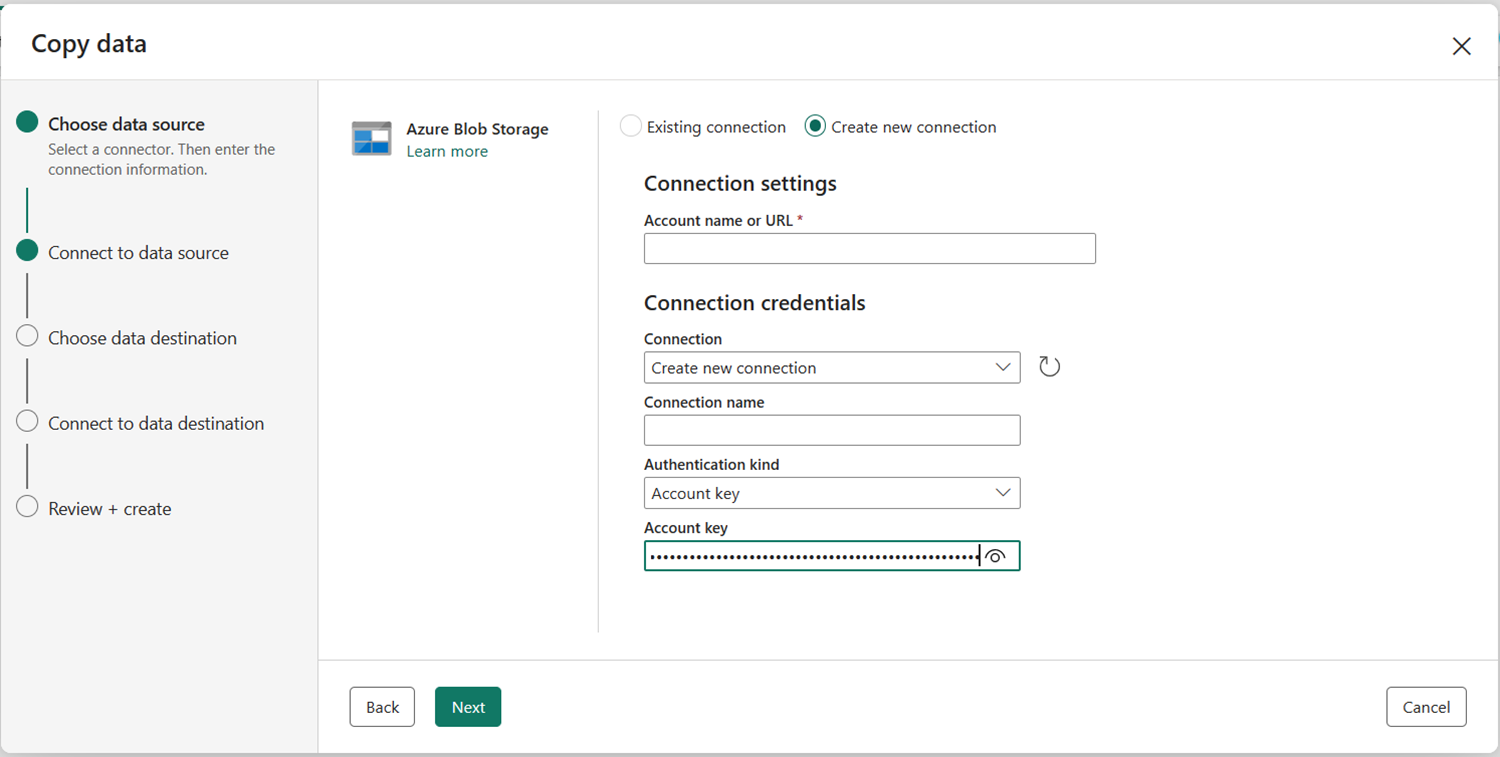

Når du har valgt Opret ny forbindelse, skal du kun udfylde Kontonavn eller URL-adresse og Godkendelsestype. Hvis du angiver Kontonavn eller URL-adresse ved hjælp af dit Azure Blob Storage-kontonavn , udfyldes forbindelsen automatisk. I denne demo vælger vi Kontonøgle , men du kan vælge en anden godkendelsestype vedrørende dine præferencer. Når du har valgt Log på, skal du kun logge på én konto, der har denne bloblagertilladelse.

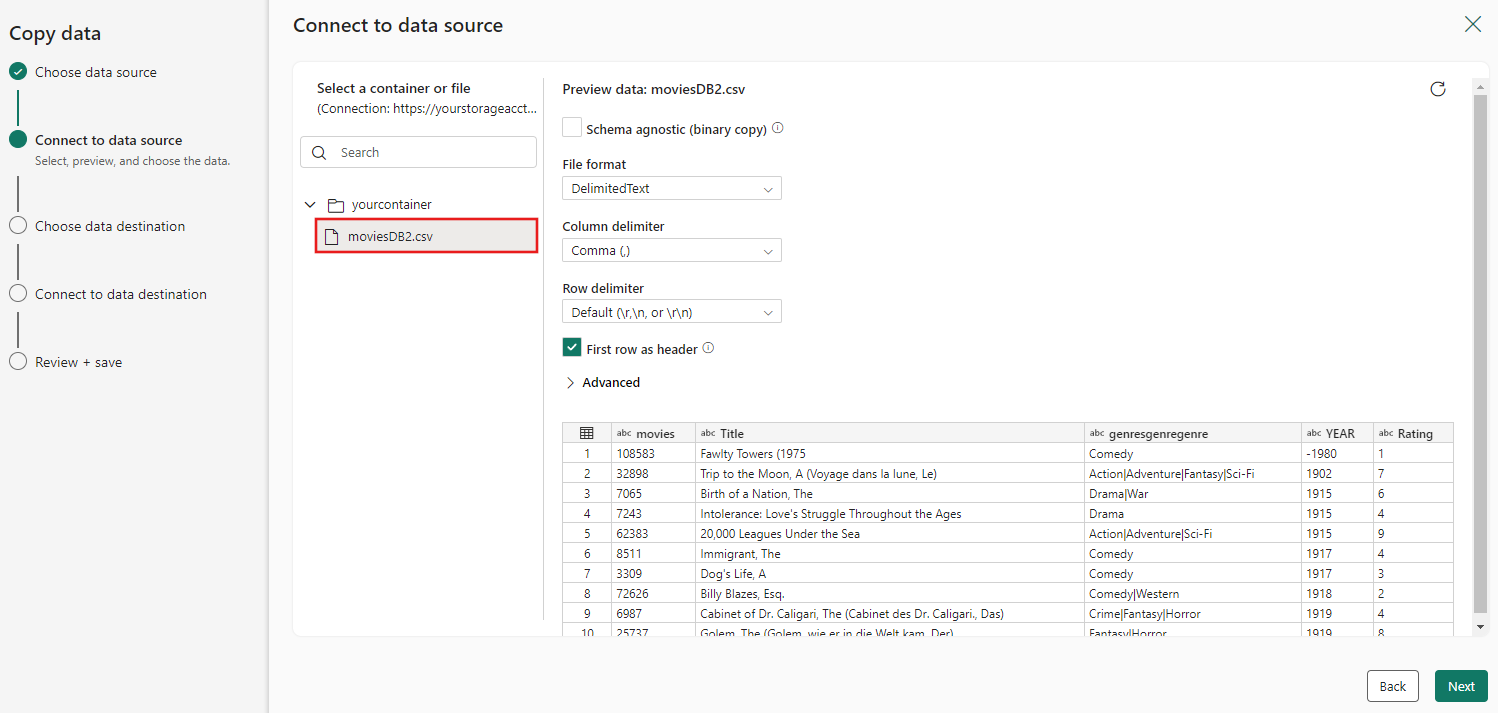

Når forbindelsen er oprettet, skal du kun vælge Næste for at Forbind til datakilden.

Vælg den fil moviesDB2.csv i kildekonfigurationen, der skal vises, og vælg derefter Næste.

Trin 3: Konfigurer din destination

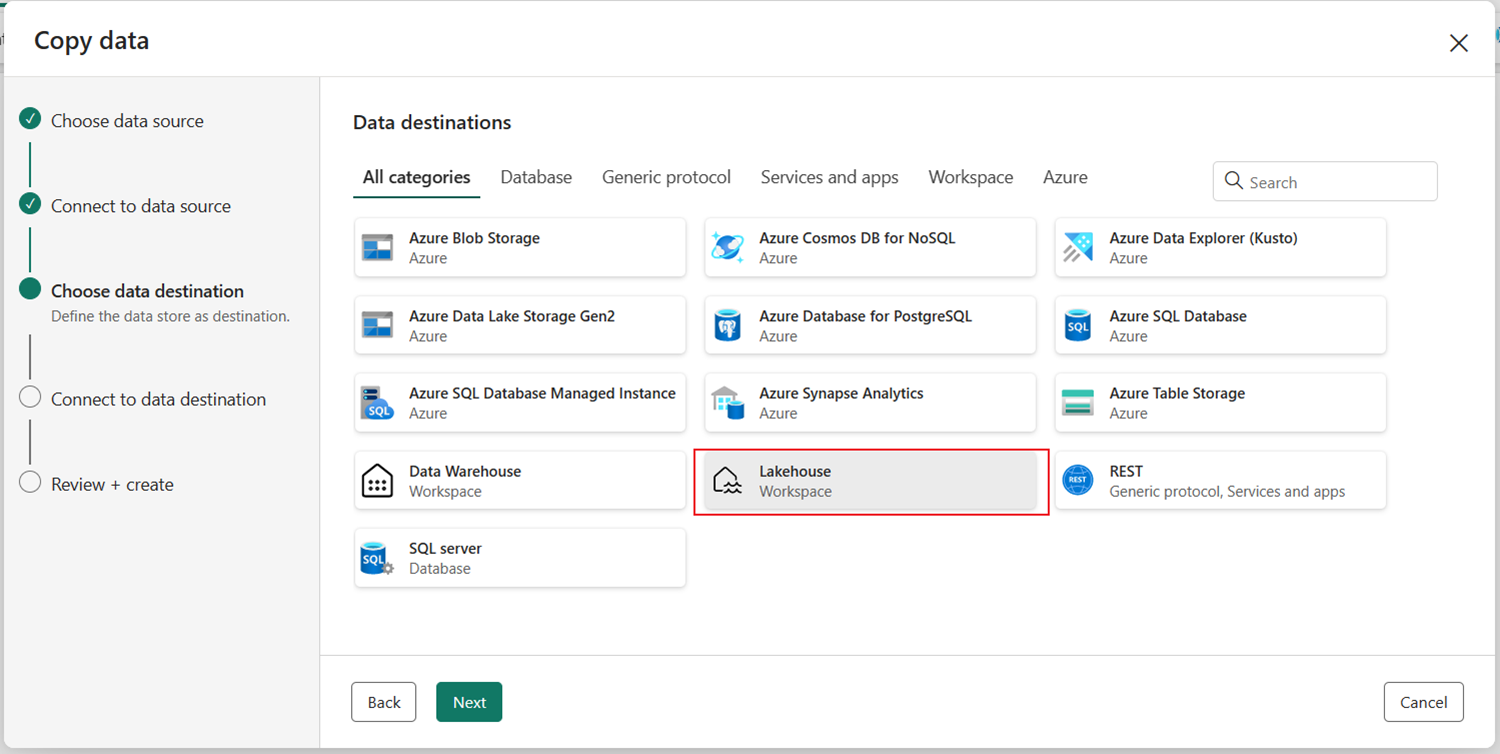

Vælg Lakehouse og derefter Næste.

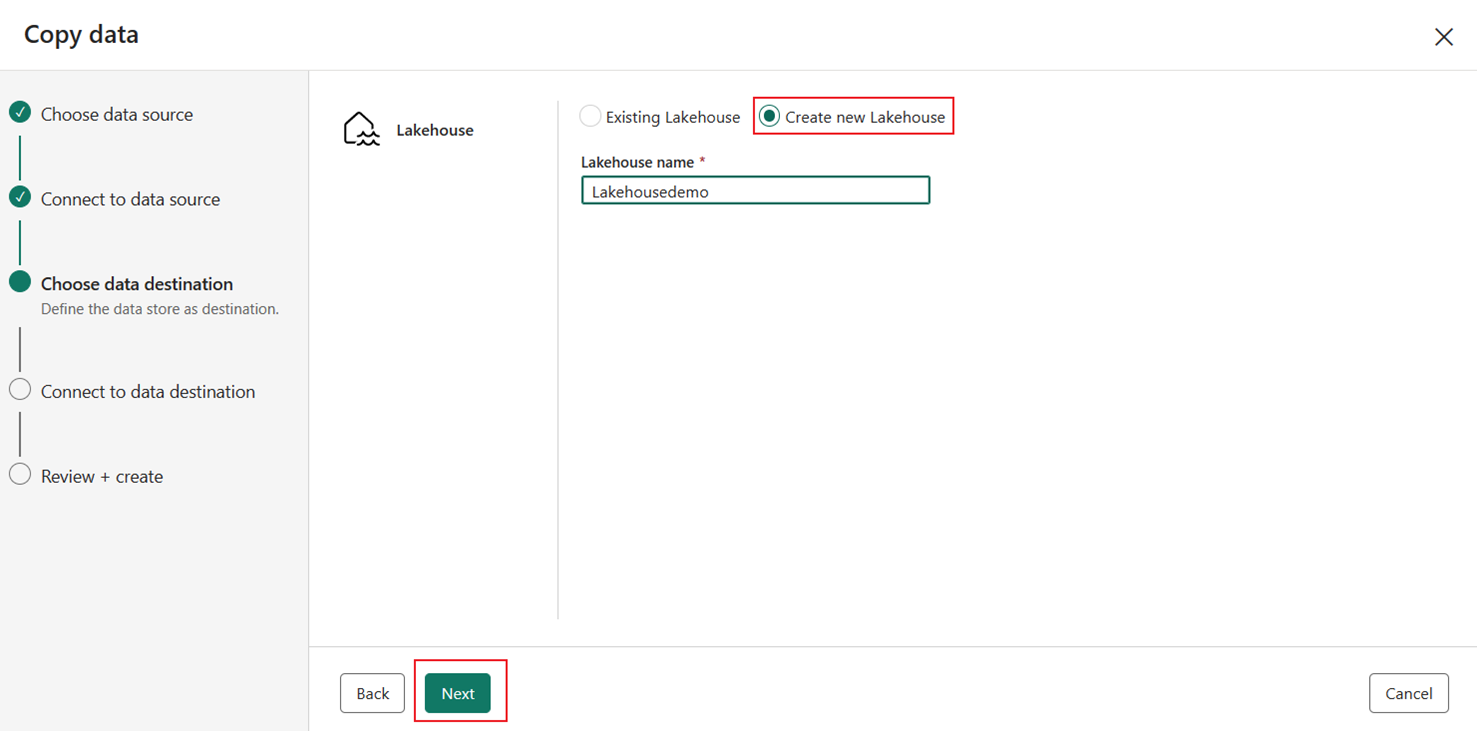

Opret et nyt Lakehouse, og angiv Navnet på Lakehouse. Vælg derefter Næste.

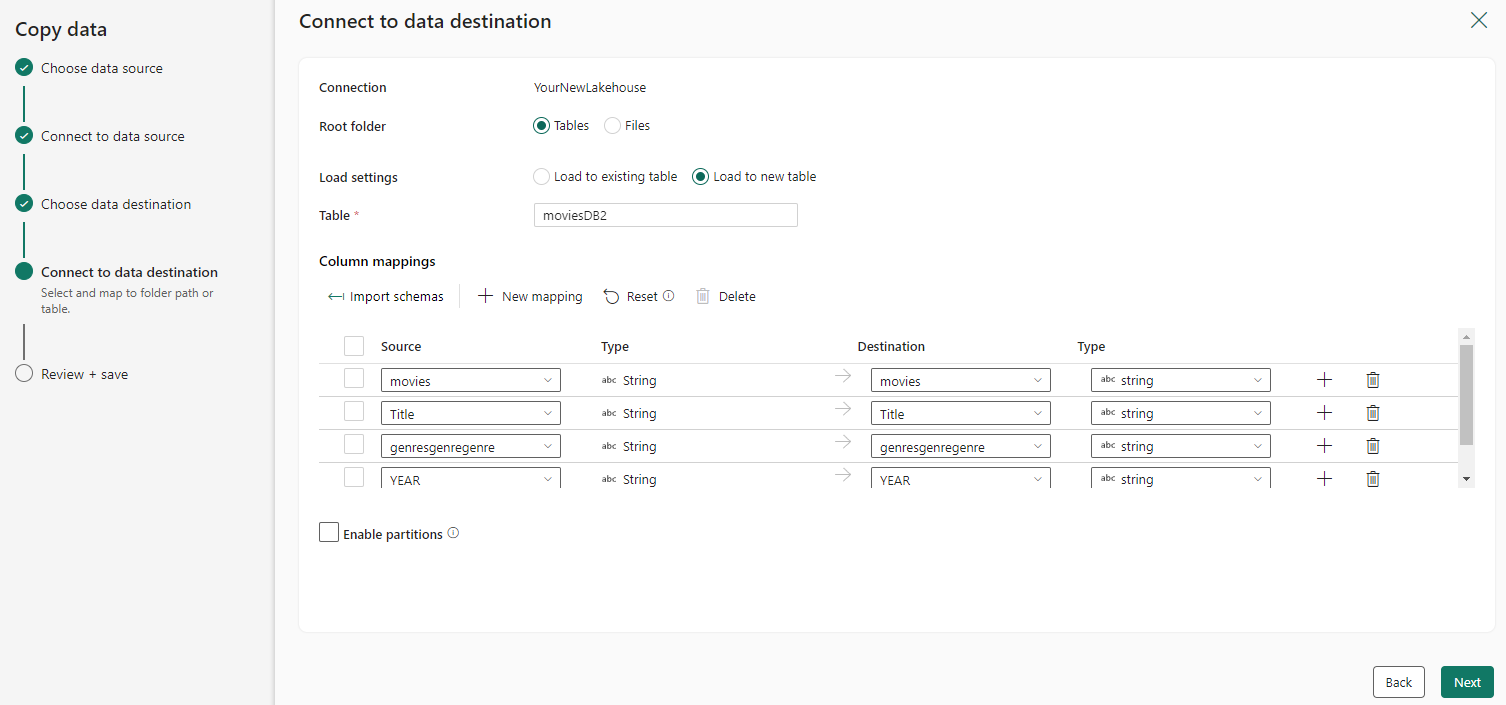

Konfigurer og knyt kildedataene til destinationen. Vælg derefter Næste for at afslutte dine destinationskonfigurationer.

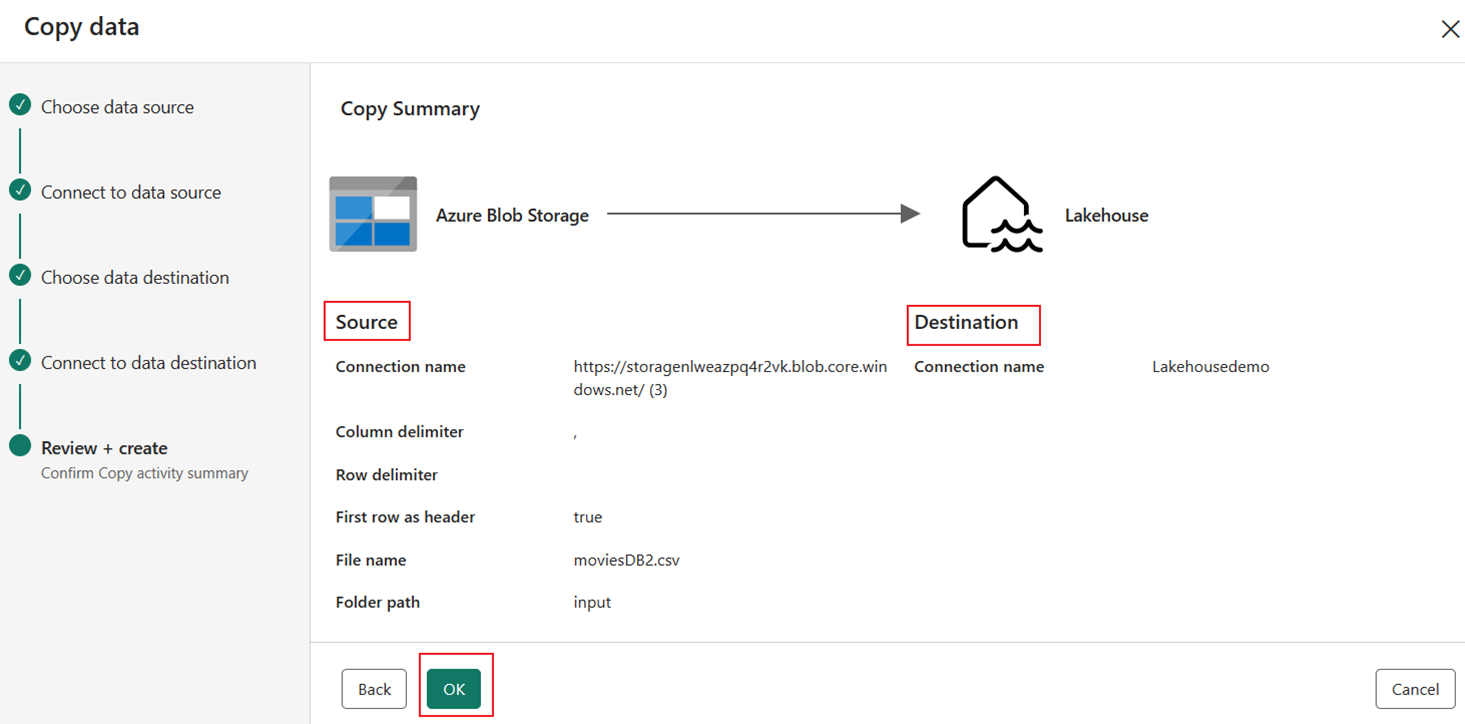

Trin 4: Gennemse og opret din kopiaktivitet

Gennemse indstillingerne for kopiaktivitet i de forrige trin, og vælg OK for at afslutte. Du kan også gå tilbage til de forrige trin for at redigere dine indstillinger, hvis det er nødvendigt i værktøjet.

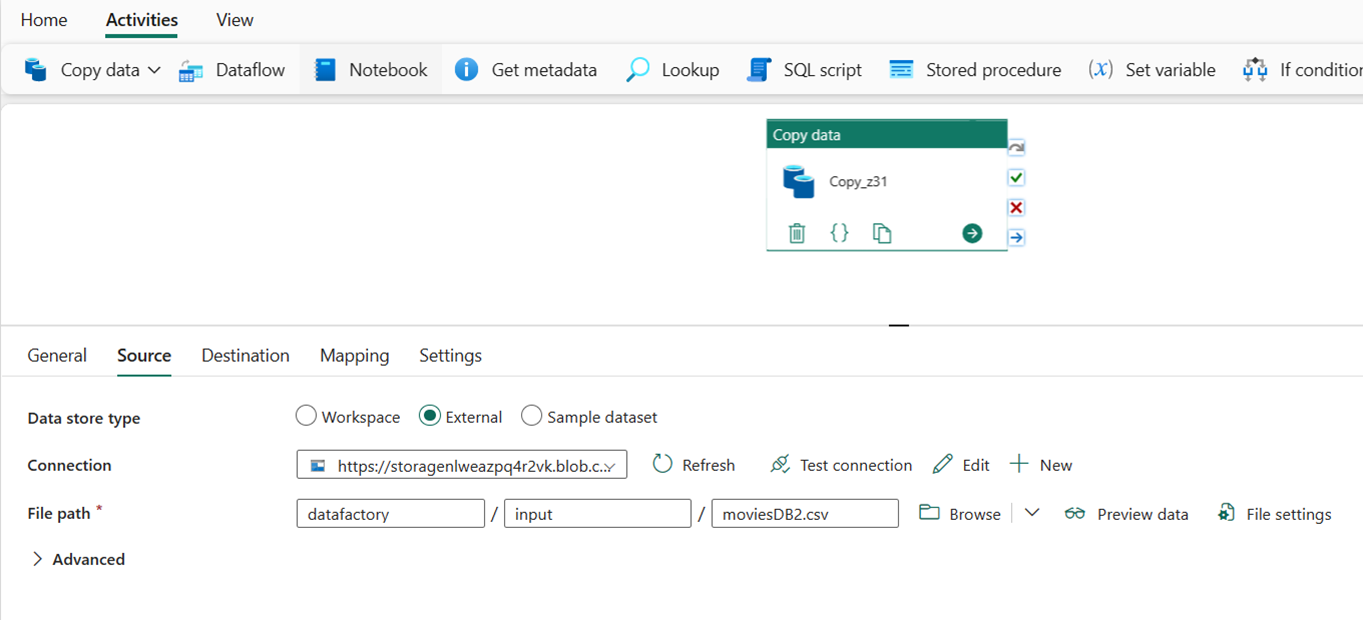

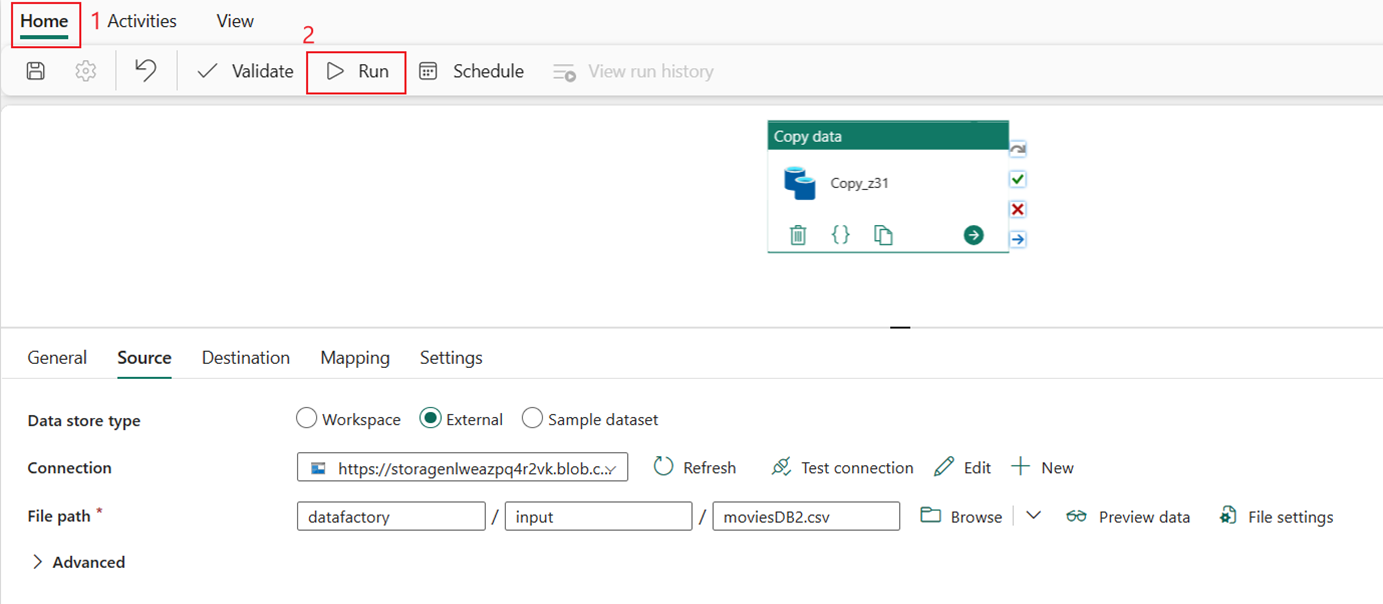

Når kopiaktiviteten er fuldført, føjes den derefter til dit datapipelinelærred. Alle indstillinger, herunder avancerede indstillinger for denne kopiaktivitet, er tilgængelige under fanerne nedenfor, når den er valgt.

Kør og planlæg din datapipeline

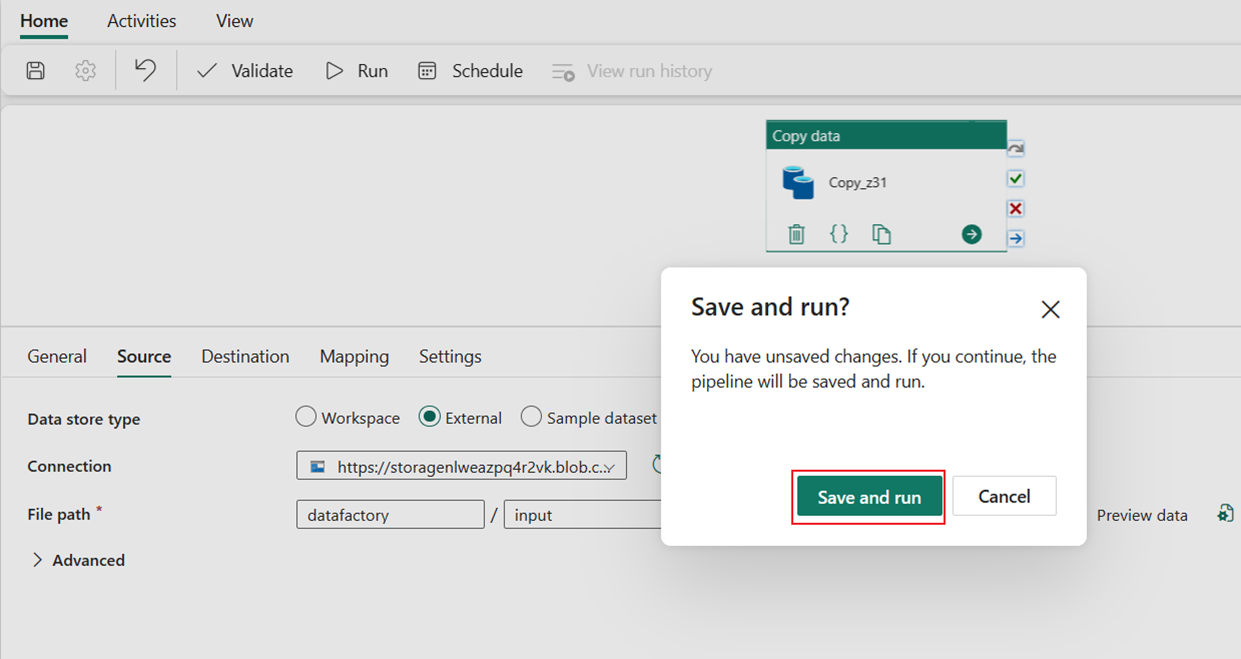

Skift til fanen Hjem, og vælg Kør. Vælg derefter Gem og kør.

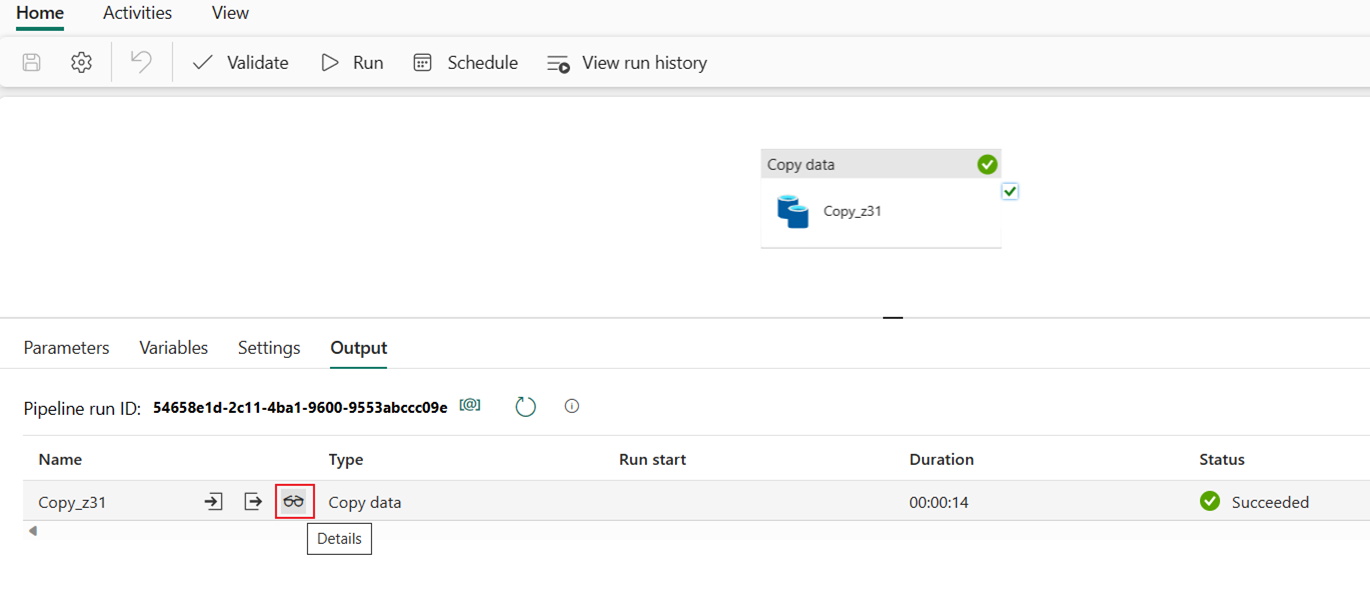

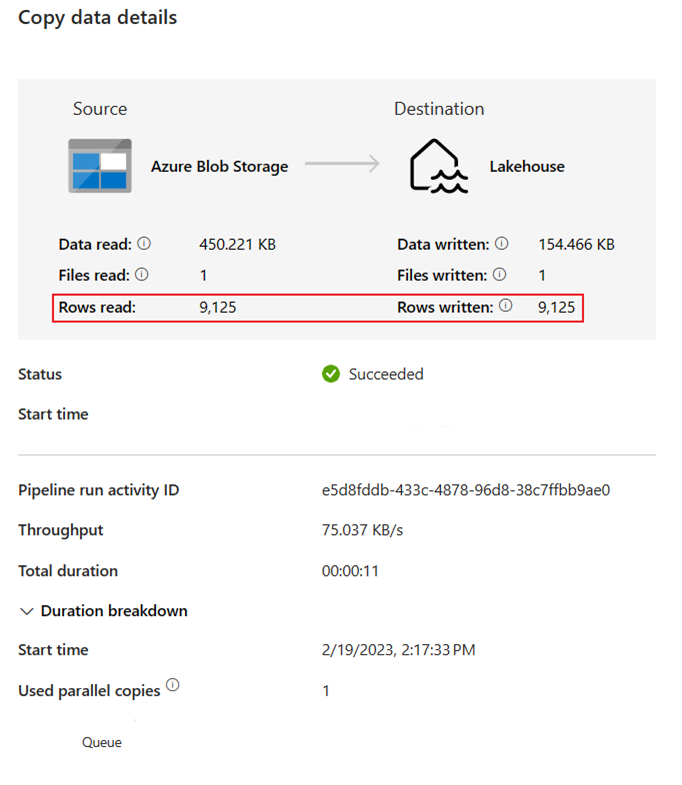

Vælg knappen Detaljer for at overvåge status og kontrollere resultaterne af kørslen.

Dialogboksen Kopiér datadetaljer viser resultaterne af kørslen, herunder status, mængden af data, der er læst og skrevet, start- og stoptider og varighed.

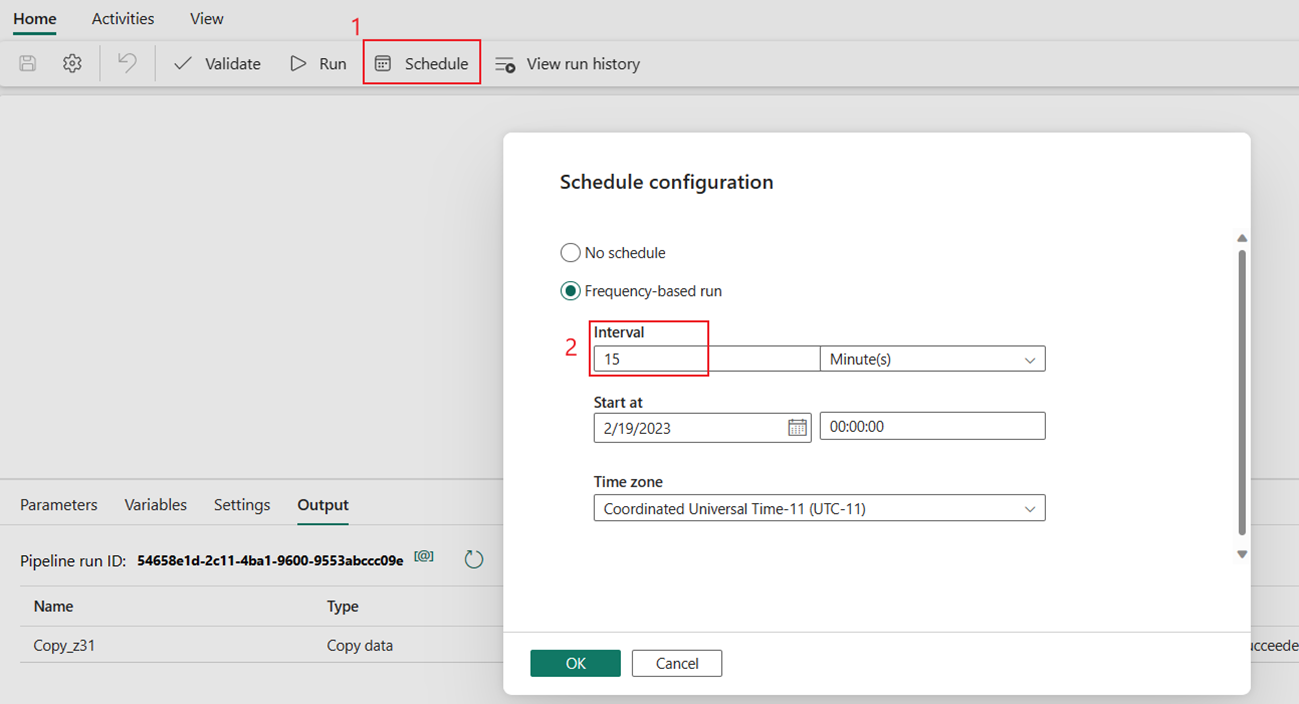

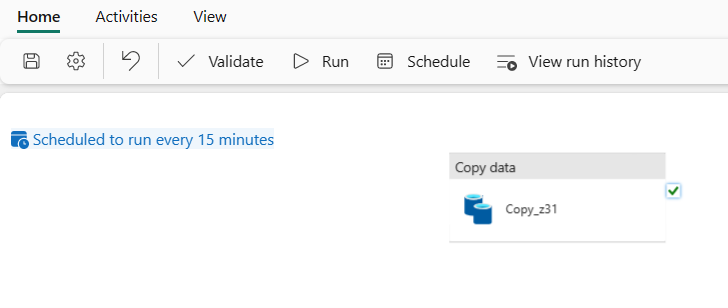

Du kan også planlægge, at pipelinen skal køre med en bestemt hyppighed efter behov. Nedenfor kan du se eksemplet på, hvordan pipelinen skal køre hvert 15. minut.

Relateret indhold

Pipelinen i dette eksempel viser, hvordan du kopierer data fra Azure Blob Storage til Lakehouse. Du har lært, hvordan du:

- Opret en datapipeline.

- Kopiér data med Kopiér assistent.

- Kør og planlæg din datapipeline.

Gå derefter videre for at få mere at vide om overvågning af dine pipelinekørsler.

Feedback

Kommer snart: I hele 2024 udfaser vi GitHub-problemer som feedbackmekanisme for indhold og erstatter det med et nyt feedbacksystem. Du kan få flere oplysninger under: https://aka.ms/ContentUserFeedback.

Indsend og få vist feedback om