Was ist Azure Content Moderator?

Wichtig

Azure Content Moderator wird im Februar 2024 als veraltet markiert und bis zum Februar 2027 eingestellt. Er wird durch den Dienst Azure KI Inhaltssicherheit ersetzt, der erweiterte KI-Features und eine verbesserte Leistung bietet.

Azure KI Inhaltssicherheit ist eine umfassende Lösung für die Erkennung benutzer- und KI-generierter Inhalte in Anwendungen und Diensten. Azure KI Inhaltssicherheit ist für zahlreiche Szenarien geeignet, z. B. für Online-Marketplaces, Spieleanbieter, Social Messaging-Plattformen, Medienunternehmen und Anbieter von Lösungen für den primären und sekundären Bildungsbereich. Hier finden Sie eine Übersicht über die Features und Funktionen:

- APIs für Text- und Bilderkennung: Überprüfung von Texten und Bildern auf sexuelle Inhalte, Gewalt, Hass und selbstverletzendes Verhalten mit verschiedenen Schweregraden.

- Inhaltssicherheit Studio: Ein Onlinetool für den Umgang mit potenziell anstößigen, gefährlichen oder unerwünschten Inhalten unter Verwendung unserer neuesten ML-Modelle für die Inhaltsmoderation. Es bietet Vorlagen und benutzerdefinierte Workflows, mit denen Benutzer*innen eigene Systeme für die Inhaltsmoderation entwickeln können.

- Sprachunterstützung: Azure KI Inhaltssicherheit unterstützt mehr als 100 Sprachen und ist speziell für Englisch, Deutsch, Japanisch, Spanisch, Französisch, Italienisch, Portugiesisch und Chinesisch trainiert.

Azure KI Inhaltssicherheit bietet eine robuste und flexible Lösung für Ihre Anforderungen an die Inhaltsmoderation. Durch den Wechsel von Content Moderator zu Azure KI Inhaltssicherheit können Sie die Vorteile der neuesten Tools und Technologien nutzen und sicherstellen, dass Ihre Inhalte immer genau nach Ihren Spezifikationen moderiert werden.

Erfahren Sie mehr über Azure KI Inhaltssicherheit und darüber, wie es Ihre Strategie zur Inhaltsmoderation verbessern kann.

Azure Content Moderator ist ein KI-Dienst für die Behandlung potenziell anstößiger, riskanter oder anderweitig unerwünschter Inhalte. Darin enthalten ist der KI-gestützten Dienst zur Inhaltsmoderation, um Text, Bilder und Videos zu scannen und Inhaltsflags automatisch anzuwenden.

Die Integration einer Inhaltsüberprüfungssoftware in Ihre App kann beispielsweise empfehlenswert sein, um gesetzliche Vorschriften einzuhalten oder Benutzern die für sie beabsichtigte Umgebung zu bieten.

Diese Dokumentation enthält die folgenden Arten von Artikeln:

- Schnellstarts sind Anleitungen zu den ersten Schritten, die Sie durch das Senden von Anforderungen an den Dienst führen.

- Schrittanleitungen enthalten Anweisungen zur spezifischeren oder individuelleren Verwendung des Diensts.

- Die Artikel zu Konzepten enthalten ausführliche Erläuterungen der Dienstfunktionen und -features.

Folgen Sie für einen strukturierteren Ansatz einem Trainingsmodul für Content Moderator.

Verwendung des Diensts

Im Anschluss finden Sie einige Szenarien, in denen ein Softwareentwickler oder Team einen Inhaltsmoderationsdienst benötigt:

- Onlinemarktplätze, die Produktkataloge und andere benutzergenerierte Inhalte moderieren

- Gamingunternehmen, die benutzergenerierte Spielartefakte und Chatrooms moderieren

- Messagingplattformen sozialer Medien, die von Benutzern hinzugefügte Bilder, Texte und Videos moderieren

- Medienunternehmen, die eine zentrale Moderation für ihre Inhalte implementieren

- Anbieter im Bildungswesen, die unangemessene Inhalte für Schüler und Lehrer herausfiltern

Wichtig

Sie können Content Moderator nicht verwenden, um nach Bildern zu suchen, auf denen Kinder in nicht zulässiger Weise dargestellt sind. Qualifizierte Organisationen können jedoch den PhotoDNA Cloud Service verwenden, um nach derartigen Inhalten zu suchen.

Lieferumfang

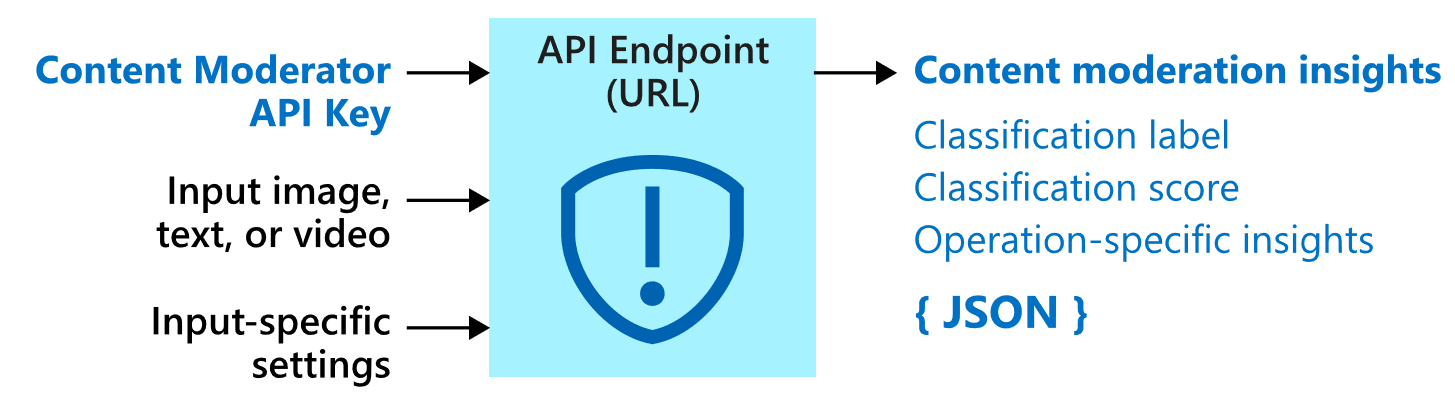

Der Content Moderator-Dienst umfasst mehrere Webdienst-APIs, die sowohl über REST-Aufrufe als auch über ein .NET SDK verfügbar sind.

Moderations-APIs

Der Content Moderator-Dienst umfasst Moderations-APIs, die Inhalte auf potenziell ungeeignetes oder anstößiges Material überprüfen.

Die folgende Tabelle beschreibt die verschiedenen Typen von Moderations-APIs.

| API-Gruppe | BESCHREIBUNG |

|---|---|

| Textmoderation | Durchsucht Text nach anstößigen Inhalten, explizit sexuellen oder anzüglichen Inhalten, Obszönitäten und personenbezogenen Daten. |

| Benutzerdefinierte Begriffslisten | Überprüft Text auf Begriffe aus einer benutzerdefinierten Begriffsliste (zusätzlich zu den integrierten Begriffen). Mithilfe von benutzerdefinierten Listen können Sie Inhalte im Einklang mit Ihren eigenen Inhaltsrichtlinien blockieren oder zulassen. |

| Bildmoderation | Überprüft Bilder auf nicht jugendfreie oder freizügige Inhalte, erkennt Text in Bildern mithilfe der optischen Zeichenerkennung (Optical Character Recognition, OCR) und erkennt Gesichter. |

| Benutzerdefinierte Bildlisten | Überprüft Bilder anhand einer benutzerdefinierten Liste von Bildern. Mithilfe benutzerdefinierter Bildlisten können Sie Instanzen häufig wiederkehrender Inhalte herausfiltern, die Sie nicht erneut klassifizieren möchten. |

| Videomoderation | Überprüft Videos auf nicht jugendfreie oder freizügige Inhalte und gibt Zeitmarkierungen für entsprechende Inhalte zurück. |

Datenschutz und Sicherheit

Wie bei allen Azure KI Services müssen Entwickler, die den Content Moderator-Dienst nutzen, die Microsoft-Richtlinien zu Kundendaten beachten. Weitere Informationen finden Sie im Microsoft Trust Center auf der Seite zu Azure KI Services.

Nächste Schritte

- Arbeiten Sie eine Schnellstartanleitung für eine Clientbibliothek oder REST-API durch, um die grundlegenden Szenarien im Code zu implementieren.