Uso de Azure Data Lake Storage Gen1 para requisitos de macrodatos

Nota

Azure Data Lake Storage Gen1 ya está retirado. Consulte el anuncio de retirada aquí. Data Lake Storage Gen1 los recursos ya no son accesibles. Si necesita asistencia especial, por favor póngase en contacto con nosotros.

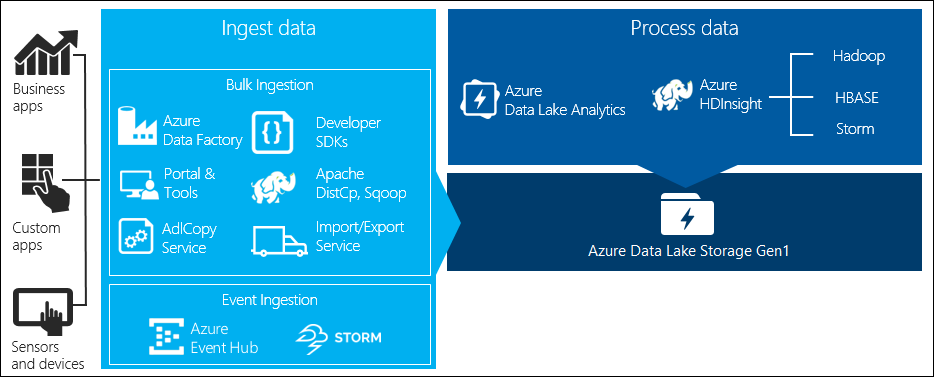

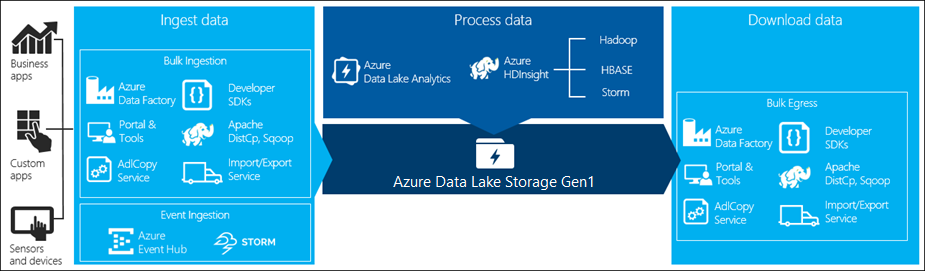

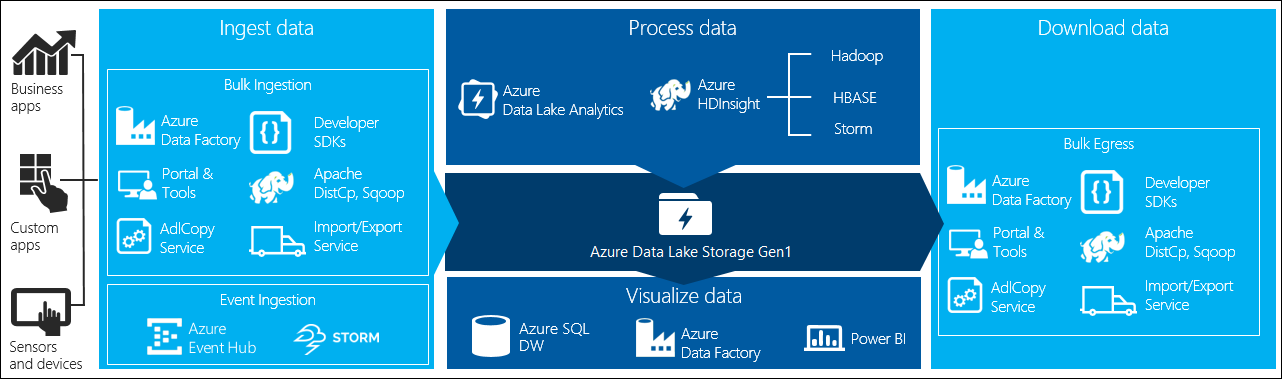

Hay cuatro fases principales en el procesamiento de macrodatos:

- Introducción de grandes cantidades de datos en un almacén de datos, en tiempo real o por lotes

- Procesamiento de los datos

- Descarga de los datos

- Visualización de los datos

En este artículo nos centramos en estas fases relativas a Azure Data Lake Storage Gen1 para comprender las opciones y herramientas disponibles para satisfacer sus necesidades de macrodatos.

Ingesta de datos en Data Lake Storage Gen1

En esta sección se resaltan los distintos orígenes de datos y las distintas formas en que esos datos se pueden ingerir en una cuenta de Data Lake Storage Gen1.

Datos ad-hoc

Representan conjuntos de datos más pequeños que se utilizan para la creación de un prototipo de una aplicación de macrodatos. Hay diferentes maneras de introducir datos ad hoc, según el origen de los datos.

| Origen de datos | Introducir mediante |

|---|---|

| Equipo local | |

| Blob de Azure Storage |

Datos de streaming

Representa los datos que se pueden generar por diversos orígenes, como aplicaciones, dispositivos o sensores, entre otros. Estos datos se pueden ingerir en Data Lake Storage Gen1 mediante distintas herramientas. Estas herramientas normalmente capturan y procesan los datos en eventos individuales y en tiempo real y, después, escriben los eventos en lotes en Data Lake Storage Gen1 para que puedan procesarse posteriormente.

A continuación, se muestran las herramientas que se pueden usar:

- Azure Stream Analytics: los eventos ingeridos en Event Hubs se pueden escribir en Azure Data Lake Storage Gen1 mediante una salida de Azure Data Lake Storage Gen1.

- EventProcessorHost: se pueden recibir eventos desde Event Hubs y, después, escribirlos en Data Lake Storage Gen1 con el SDK de .NET para Data Lake Store Gen1.

Datos relacionales

También se pueden originar datos desde bases de datos relacionales. Durante un tiempo, las bases de datos relacionales recopilan grandes cantidades de datos que pueden proporcionar información clave si se procesan a través de una canalización de macrodatos. Puede usar las herramientas siguientes para mover estos datos a Data Lake Storage Gen1.

Datos de registro de servidor web (carga mediante aplicaciones personalizadas)

Este tipo de conjunto de datos es específicamente necesario porque el análisis de los datos de registro del servidor web es un caso de uso común para aplicaciones de macrodatos y requiere que se carguen grandes volúmenes de archivos de registro en Data Lake Storage Gen1. Puede utilizar cualquiera de las herramientas siguientes para escribir sus propios scripts o aplicaciones para cargar dichos datos.

Para cargar datos de registro del servidor web y también para cargar otros tipos de datos (por ejemplo, datos de opiniones sociales), un buen enfoque es escribir sus propios aplicaciones o scripts personalizados, porque le ofrece la flexibilidad de incluir el componente que carga los datos como parte de su aplicación de macrodatos mayor. En algunos casos, este código puede adoptar la forma de un script o de una utilidad de línea de comandos simple. En otros casos, el código puede utilizarse para integrar el procesamiento de macrodatos en una aplicación o solución de negocio.

Datos asociados con los clústeres de HDInsight de Azure

La mayoría de los tipos de clúster de HDInsight (Hadoop, HBase, Storm) admiten Data Lake Storage Gen1 como repositorio de almacenamiento de datos. Los clústeres de HDInsight acceden a los datos de Azure Storage Blob (WASB). Para mejorar el rendimiento, puede copiar los datos de WASB en una cuenta de Data Lake Storage Gen1 asociada con el clúster. Puede usar las herramientas siguientes para copiar los datos.

Datos almacenados en clústeres locales o de IaaS de Hadoop

Es posible que haya grandes cantidades de datos almacenados en clústeres de Hadoop existentes, de forma local en los equipos mediante HDFS. Los clústeres de Hadoop pueden encontrarse en una implementación local o dentro de un clúster de IaaS en Azure. Podrían existir requisitos para copiar estos datos en Azure Data Lake Storage Gen1 de forma puntual o periódica. Existen diversas opciones que puede usar para lograr esto. A continuación se muestra una lista de alternativas, además de las ventajas y desventajas asociadas.

| Enfoque | Detalles | Ventajas | Consideraciones |

|---|---|---|---|

| Usar Azure Data Factory (ADF) para copiar datos directamente desde los clústeres de Hadoop hasta Azure Data Lake Storage Gen1 | ADF admite HDFS como origen de datos | ADF proporciona compatibilidad inmediata con HDFS, así como una supervisión y administración integrales y de primera clase. | Requiere que se implemente Data Management Gateway localmente o en el clúster de IaaS. |

| Exportar datos desde Hadoop como archivos. Luego, copiar los archivos en Azure Data Lake Storage Gen1 con el mecanismo adecuado. | Puede copiar archivos en Azure Data Lake Storage Gen1 por medio de:

|

Se empieza rápido. Se pueden usar cargas personalizadas. | Proceso de varios pasos en el que participan varias tecnologías. La administración y la supervisión presentarán dificultades con el tiempo, dada la naturaleza personalizada de las herramientas. |

| Usar Distcp para copiar datos de Hadoop en Azure Storage. Después, copiar los datos de Azure Storage en Data Lake Store Gen1 con el mecanismo adecuado. | Puede copiar datos de Azure Storage a Data Lake Store Gen1 por medio de: | Puede usar herramientas de código abierto. | Proceso de varios pasos en el que participan varias tecnologías. |

Conjuntos de datos realmente grandes

Para cargar conjuntos de datos cuyo tamaño oscila en varios terabytes, el uso de los métodos descritos anteriormente puede a veces resultar lento y costoso. En tales casos, puede utilizar las opciones siguientes.

Uso de Azure ExpressRoute. Azure ExpressRoute permite crear conexiones privadas entre los centros de datos de Azure y la infraestructura de un entorno local. Esto ofrece una opción confiable para transferir grandes cantidades de datos. Para obtener más información, consulte la documentación de Azure ExpressRoute.

Carga "sin conexión" de los datos. Si por cualquier razón no es posible utilizar Azure ExpressRoute, puede usar el servicio Azure Import/Export para enviar unidades de disco duro con sus datos a un centro de datos de Azure. Los datos se cargan primero a Blobs de Azure Storage. Después, puede usar Azure Data Factory o la herramienta AdlCopy para copiar datos de Azure Storage Blobs en Data Lake Store.

Nota

Al usar el servicio Import/Export, el tamaño de los archivos en los discos que se envían al centro de datos de Azure no debe ser mayor que 195 GB.

Procesamiento de los datos almacenados en Data Lake Storage Gen1

Cuando los datos están disponibles en Data Lake Storage Gen1, puede ejecutar un análisis en esos datos mediante las aplicaciones de macrodatos admitidas. Actualmente, se puede usar Azure HDInsight y Azure Data Lake Analytics para ejecutar trabajos de análisis de datos en los datos almacenados en Data Lake Storage Gen1.

Puede buscar en los ejemplos siguientes.

- Creación de un clúster de HDInsight con Data Lake Storage Gen1 como almacenamiento

- Use Azure Data Lake Analytics with Data Lake Storage Gen1 (Uso de Azure Data Lake Analytics con Data Lake Storage Gen1)

Descarga de datos de Data Lake Storage Gen1

También puede descargar o mover datos de Azure Data Lake Storage Gen1 en escenarios como los siguientes:

- Mover datos a otros repositorios para interactuar con las canalizaciones de procesamiento de datos existentes. Por ejemplo, puede mover los datos de Data Lake Storage Gen1 a Azure SQL Database o a SQL Server.

- Descargar datos en el equipo local para procesarlos en entornos IDE durante la creación de prototipos de aplicaciones.

En tales casos, puede utilizar cualquiera de las opciones siguientes.

También puede usar los métodos siguientes para escribir su propio script o aplicación para descargar datos de Data Lake Storage Gen1.

Visualización de datos en Data Lake Storage Gen1

Puede usar una combinación de servicios para crear representaciones visuales de los datos almacenados en Data Lake Storage Gen1.

- Puede comenzar con Azure Data Factory para mover datos desde Data Lake Storage Gen1 a Azure Synapse Analytics.

- Después, puede integrar Power BI con Azure Synapse Analytics para crear una representación visual de los datos.