Pre-procesar datos con un procedimiento almacenado antes de cargarlos en Lakehouse

En este tutorial, se muestra cómo usar una actividad de script de canalización para ejecutar un procedimiento almacenado para crear una tabla y pre-procesar los datos en un almacén de datos de Synapse. Después, cargamos la tabla pre-procesada en Lakehouse.

Requisitos previos

Un área de trabajo habilitada para Microsoft Fabric. Si aún no tiene uno, consulte el artículo Crear un espacio de trabajo.

Prepare un procedimiento almacenado en el almacén de datos de Azure Synapse. Cree el siguiente procedimiento almacenado de antemano:

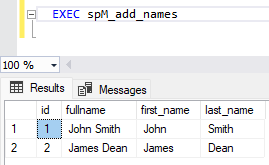

CREATE PROCEDURE spM_add_names AS --Create initial table IF EXISTS (SELECT * FROM sys.objects WHERE object_id = OBJECT_ID(N'[dbo].[names]') AND TYPE IN (N'U')) BEGIN DROP TABLE names END; CREATE TABLE names (id INT,fullname VARCHAR(50)); --Populate data INSERT INTO names VALUES (1,'John Smith'); INSERT INTO names VALUES (2,'James Dean'); --Alter table for new columns ALTER TABLE names ADD first_name VARCHAR(50) NULL; ALTER TABLE names ADD last_name VARCHAR(50) NULL; --Update table UPDATE names SET first_name = SUBSTRING(fullname, 1, CHARINDEX(' ', fullname)-1); UPDATE names SET last_name = SUBSTRING(fullname, CHARINDEX(' ', fullname)+1, LEN(fullname)-CHARINDEX(' ', fullname)); --View Result SELECT * FROM names;

Creación de una actividad de script de canalización para ejecutar el procedimiento almacenado

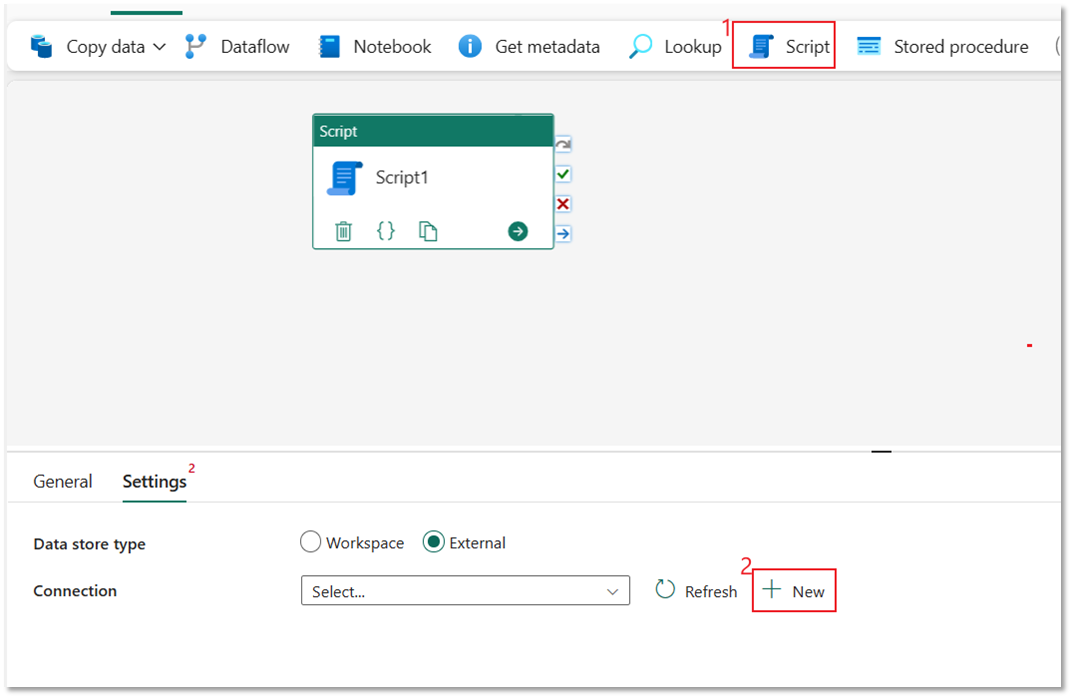

En esta sección, se usa una actividad Script para ejecutar el procedimiento almacenado creado en los requisitos previos.

Elija Actividad de script y, a continuación, seleccione Nuevo para conectarse al almacén de datos de Azure Synapse.

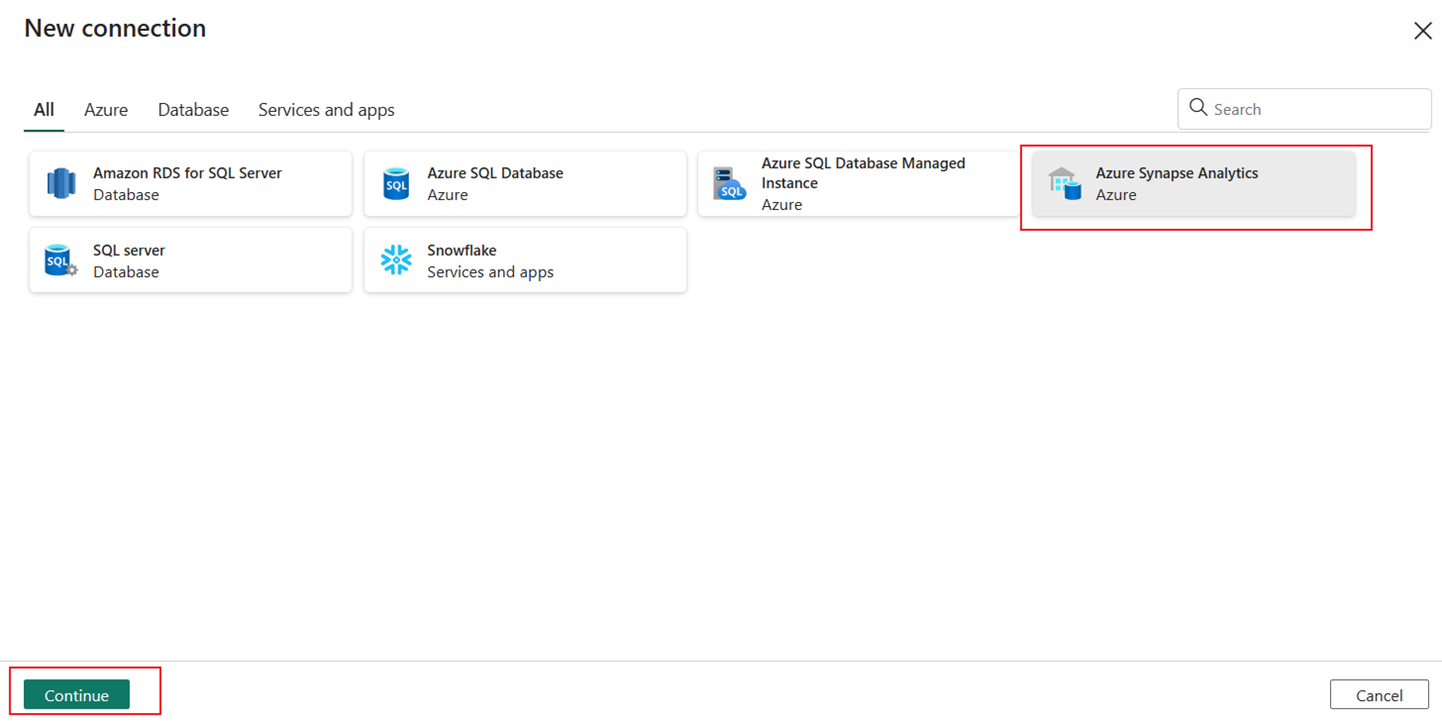

Seleccione Azure Synapse Analytics y, a continuación, Continuar.

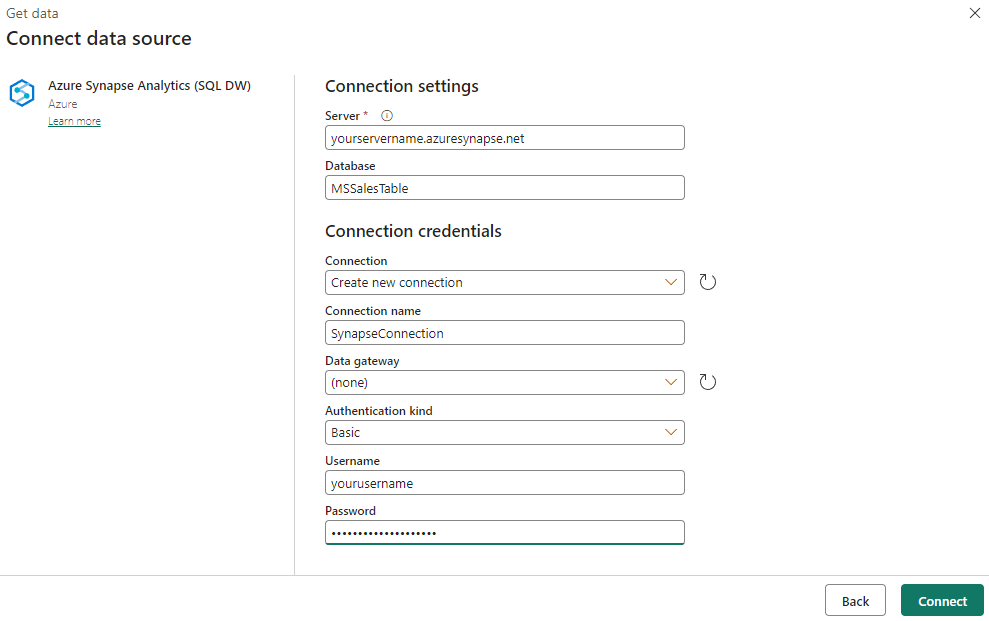

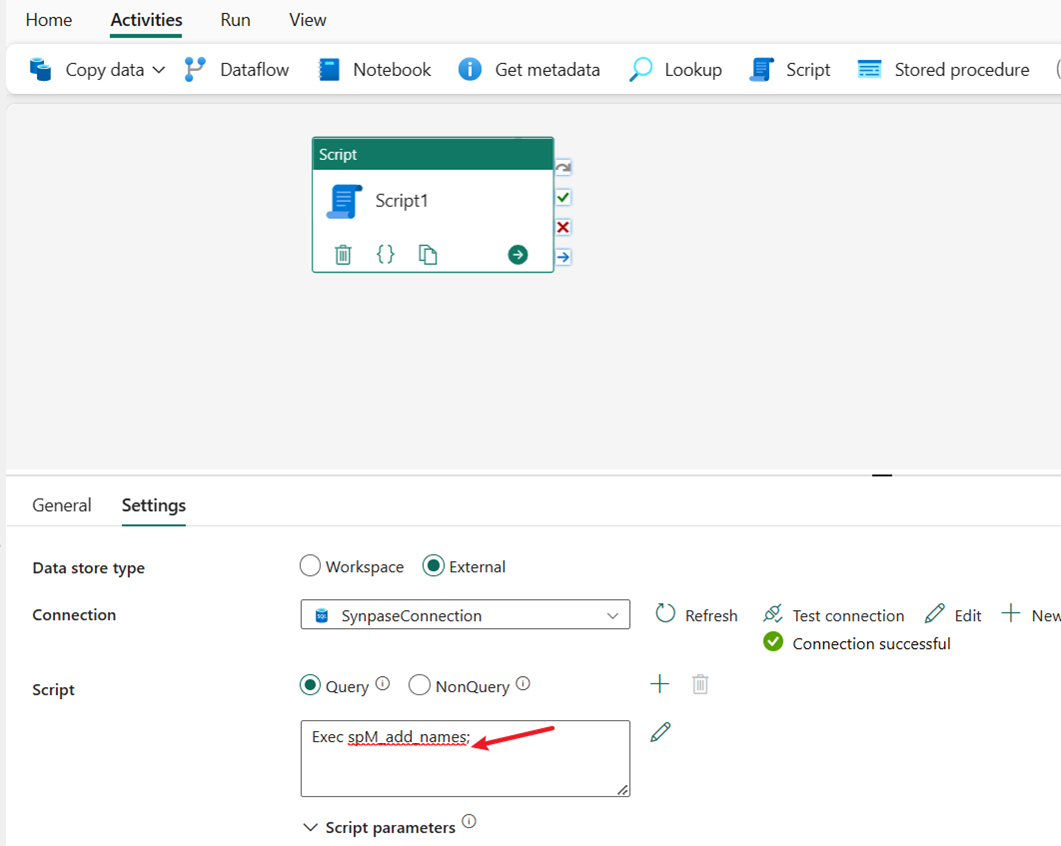

Proporcione los campos Servidor, Base de datos y Nombre de usuario y Contraseña para la autenticación básica e introduzca SynapseConnection para el Nombre de conexión . A continuación, seleccione Crear para crear la nueva conexión.

Introduzca EXEC spM_add_names para ejecutar el procedimiento almacenado. Crea una nueva tabla dbo.name y pre-procesa los datos con una simple transformación para cambiar el campo fullname en dos campos, first_name y last_name.

Uso de una actividad de canalización para cargar datos de tabla pre-procesados en Lakehouse

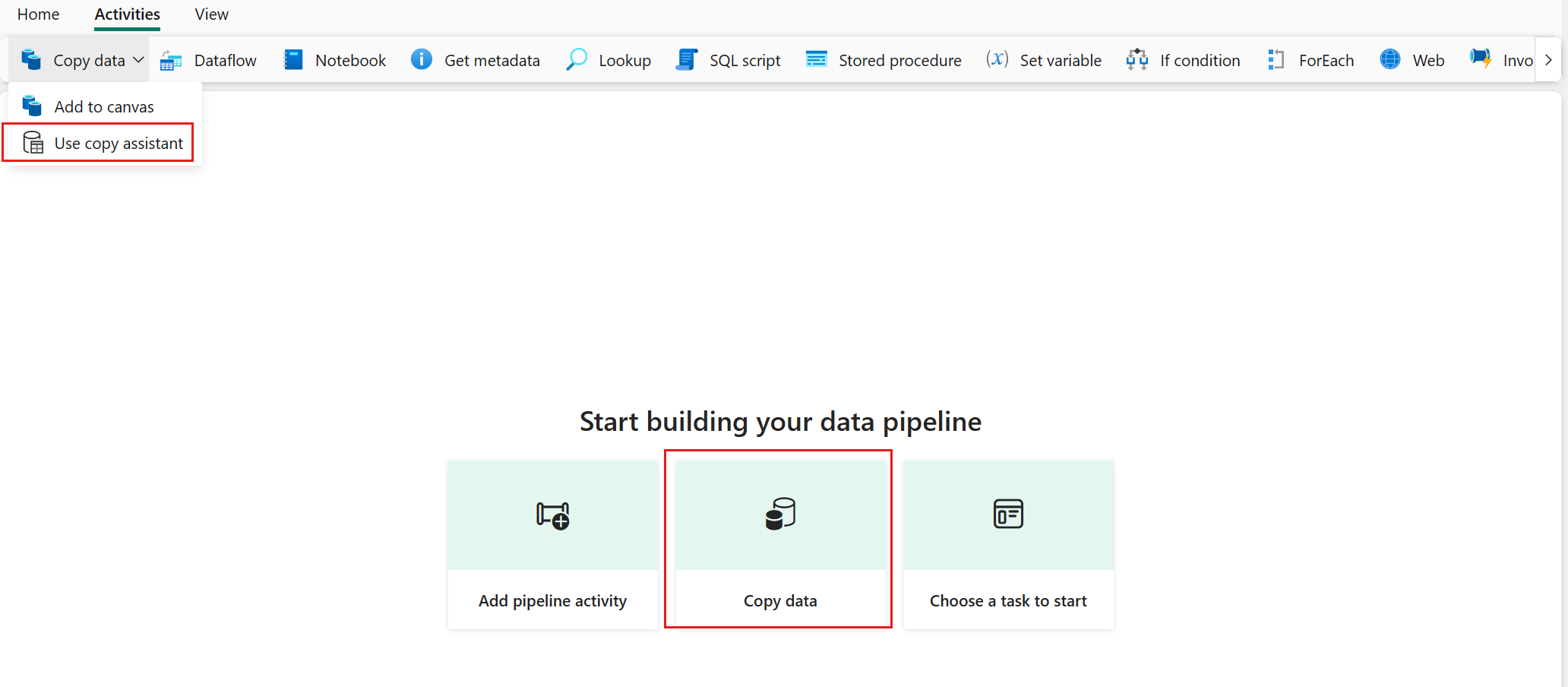

Seleccione Copiar datos y, a continuación, seleccione Usar asistente de copia .

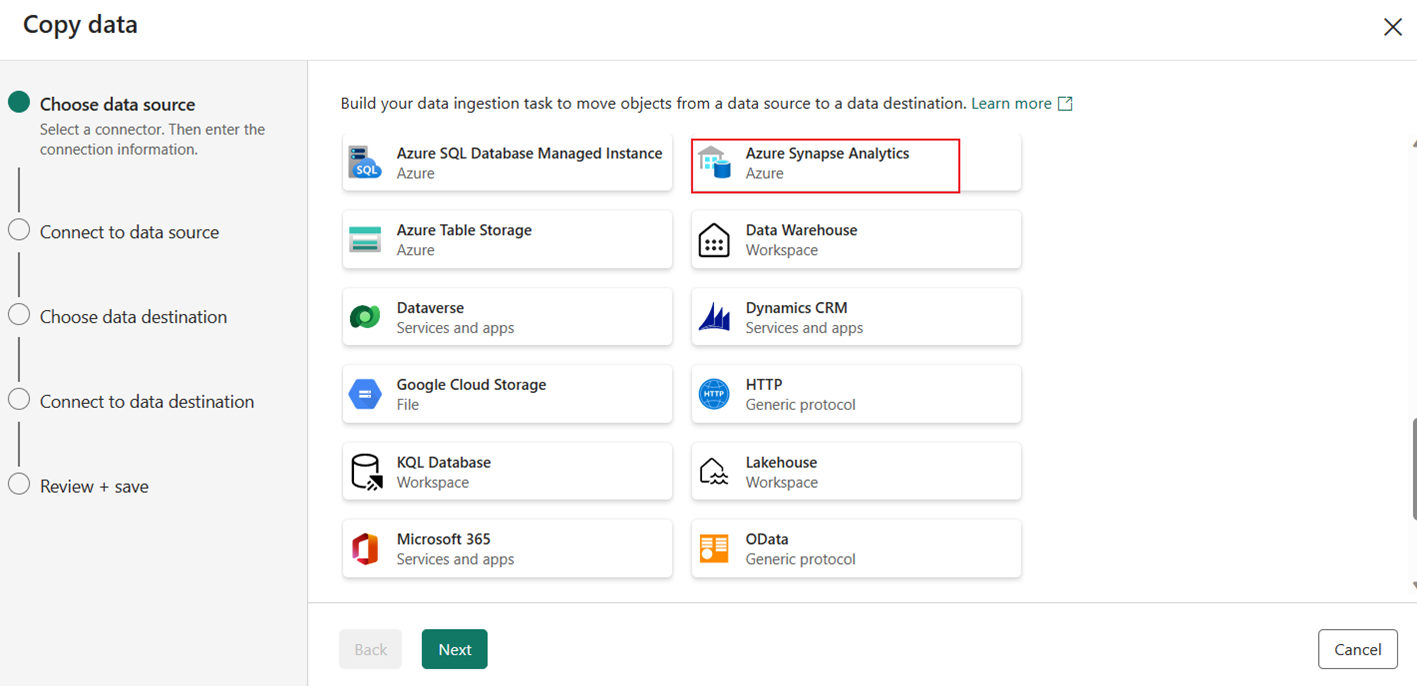

Seleccione Azure Synapse Analytics para el origen de datos y, a continuación, seleccione Siguiente.

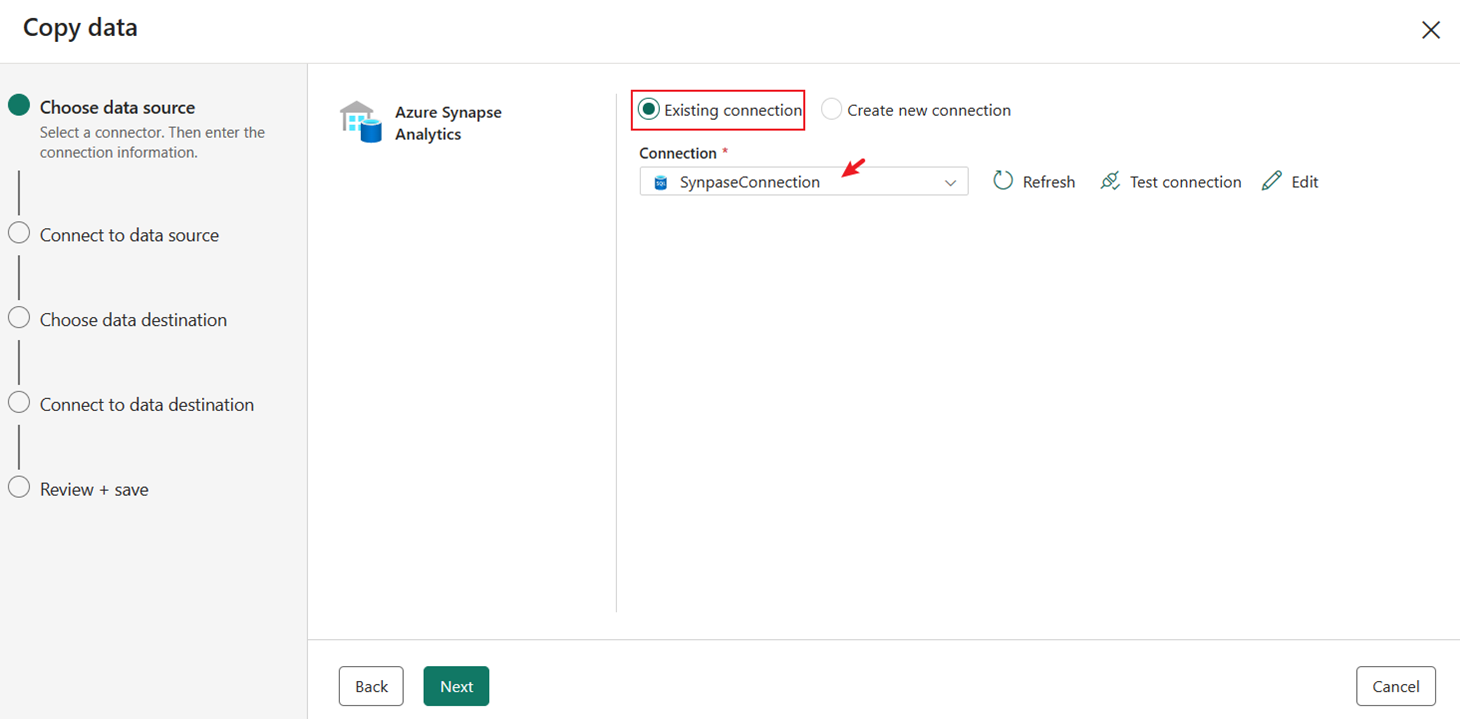

Elija la conexión SynapseConnection existente que creó anteriormente.

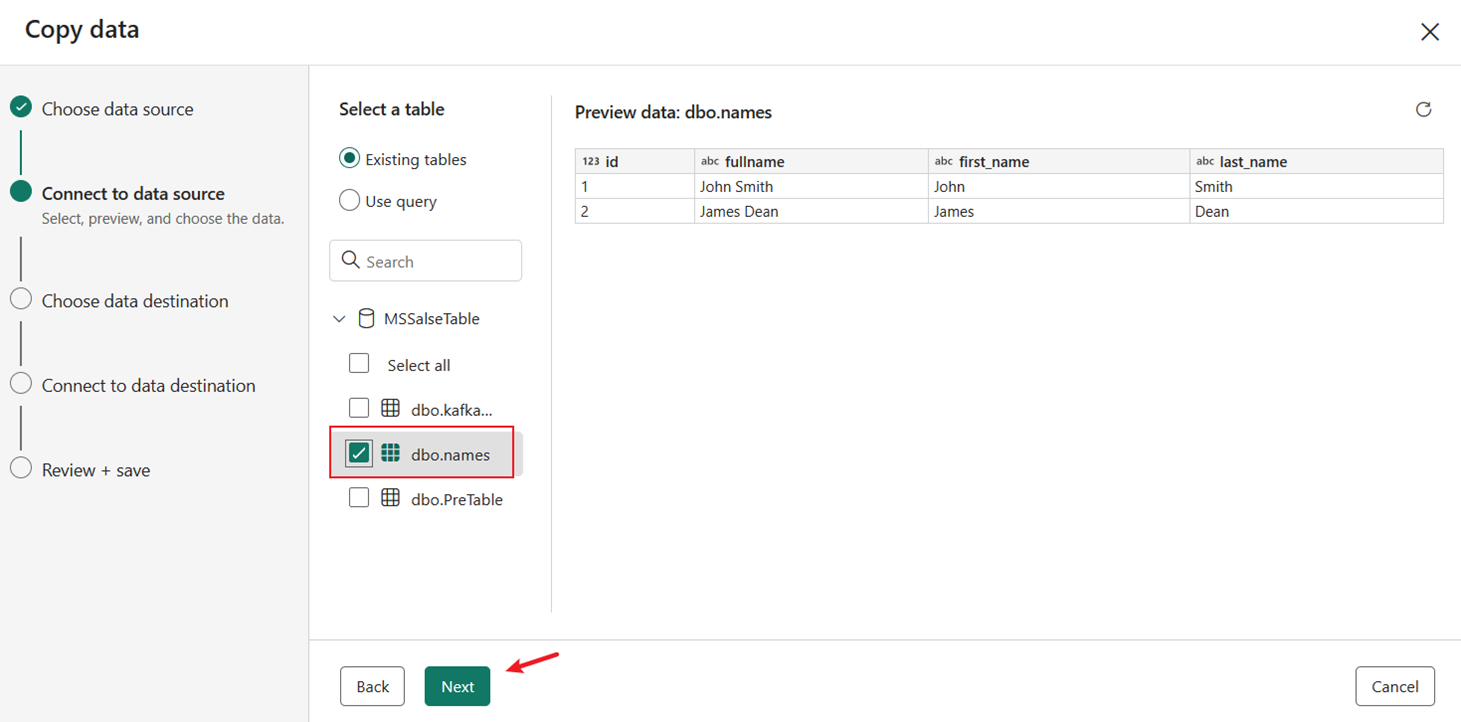

Elija la tabla dbo.names que fue creada y pre-procesada por el procedimiento almacenado. Seleccione Siguiente.

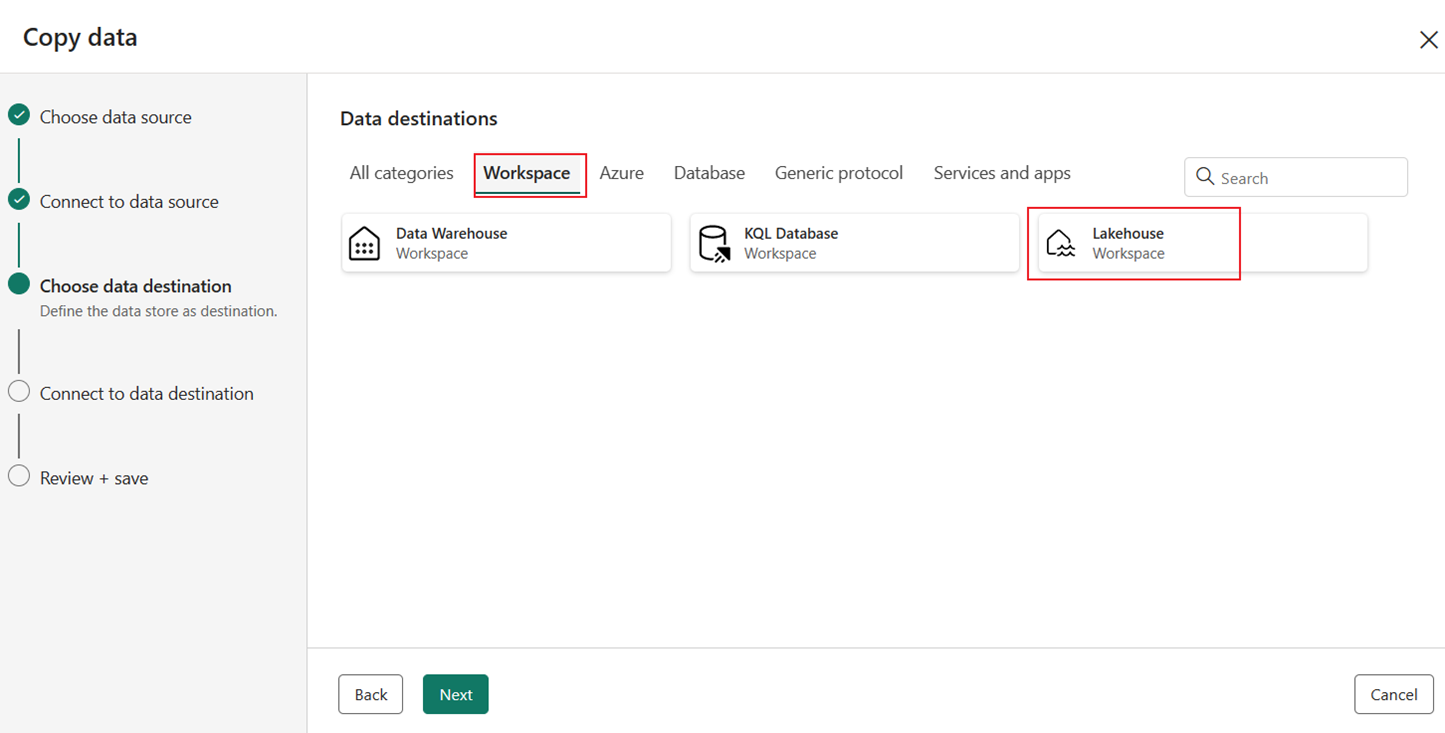

Seleccione Lakehouse en la pestañaEspacio de trabajo como destino y, a continuación, seleccione Siguiente de nuevo.

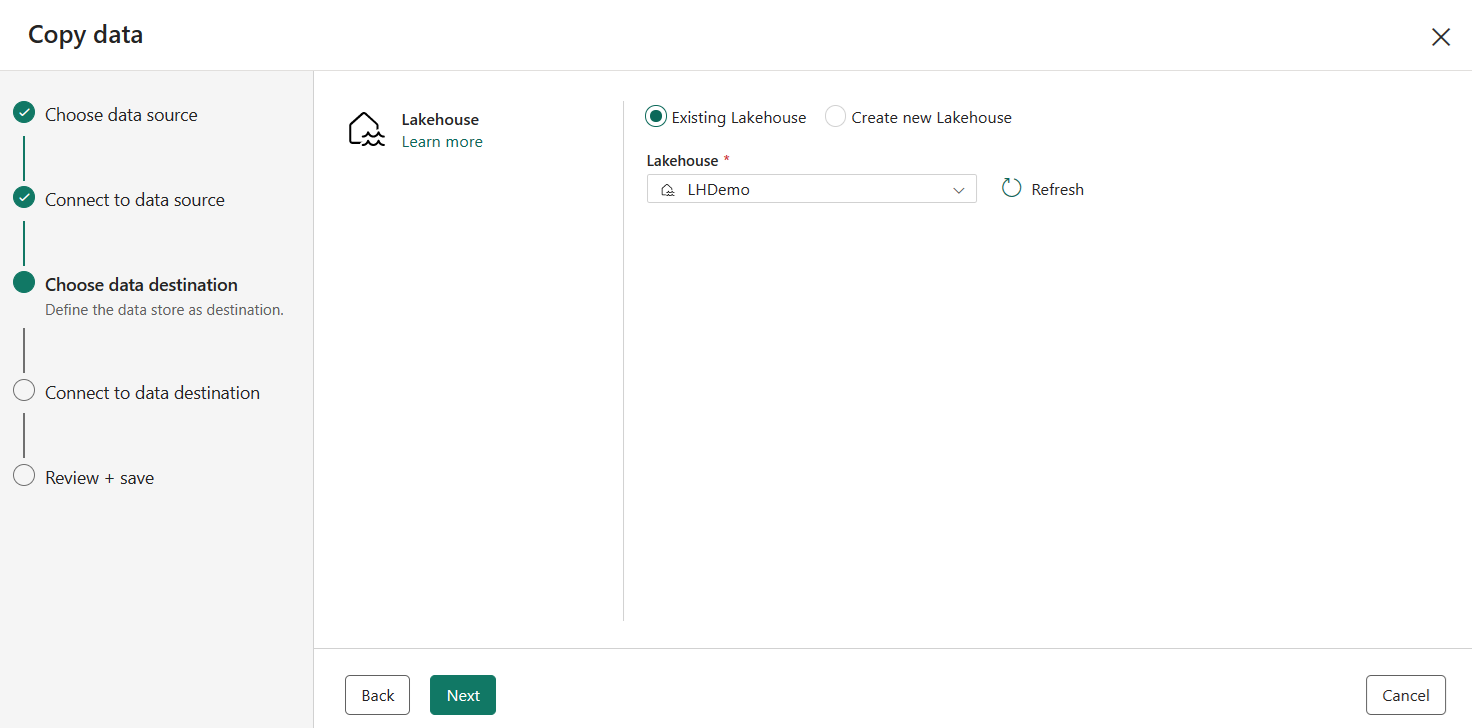

Elija una instancia existente o cree una nueva instancia de Lakehouse y, a continuación, seleccione Siguiente.

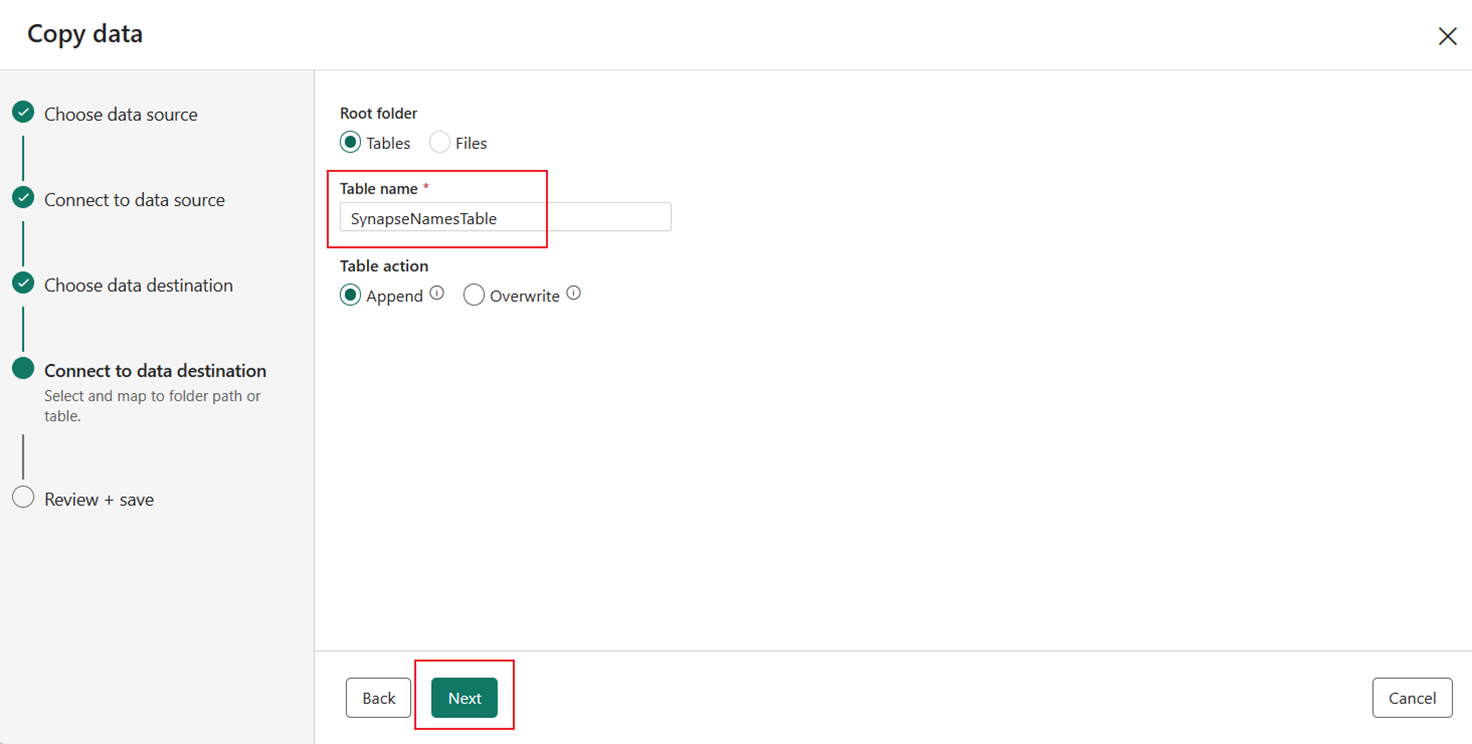

Introduzca un nombre de tabla de destino para los datos que se copiarán en el destino de Lakehouse y seleccione Siguiente.

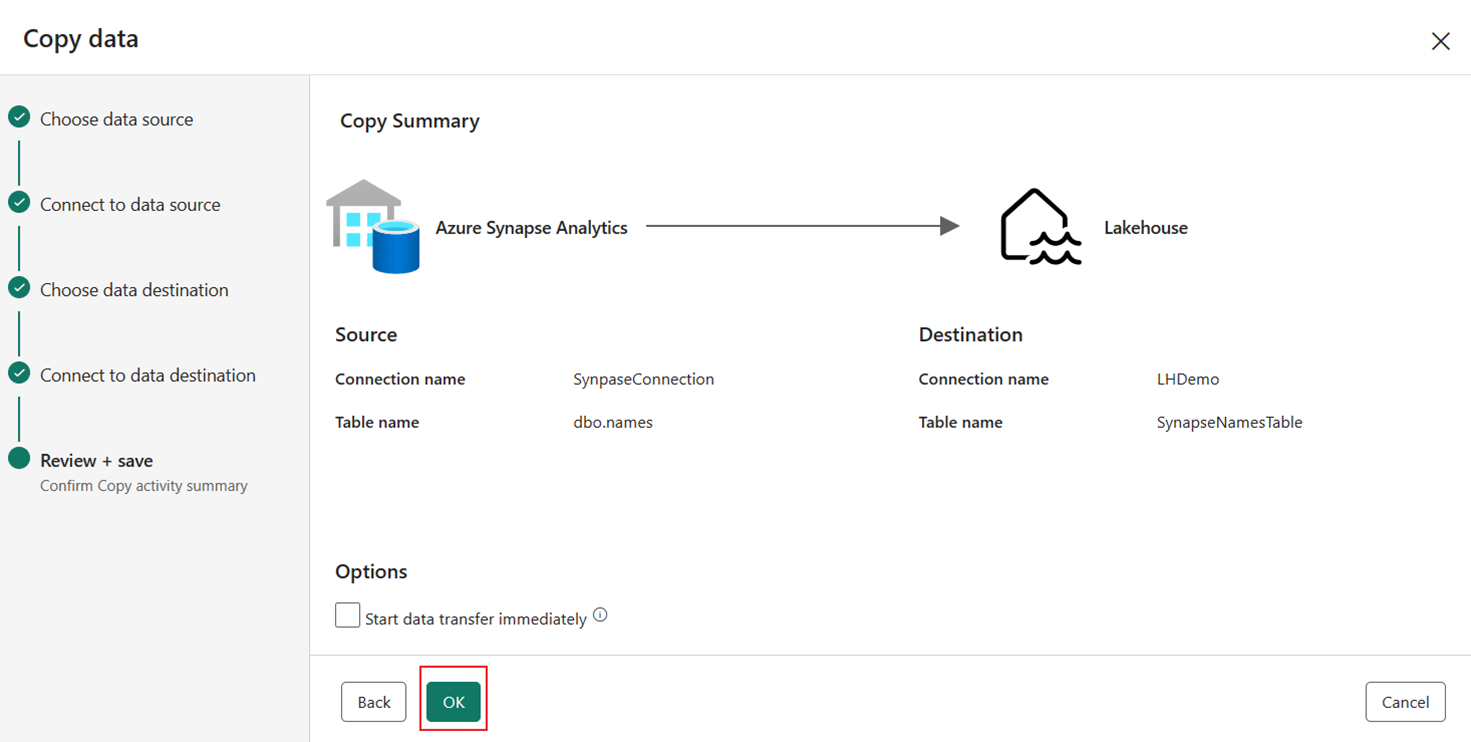

Revise el resumen en la página final del asistente de copia y, a continuación, seleccione Aceptar.

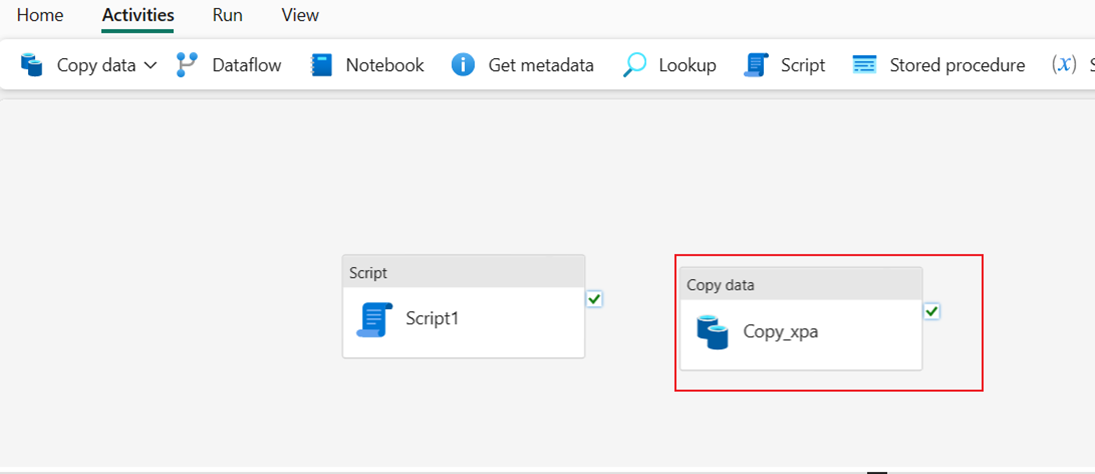

Después de seleccionar Aceptar, la nueva actividad Copiar se añadirá al lienzo de la canalización.

Ejecución de las dos actividades de canalización para cargar los datos

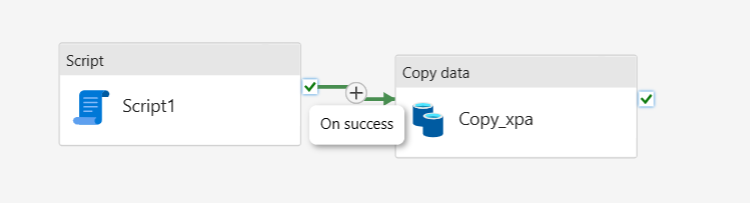

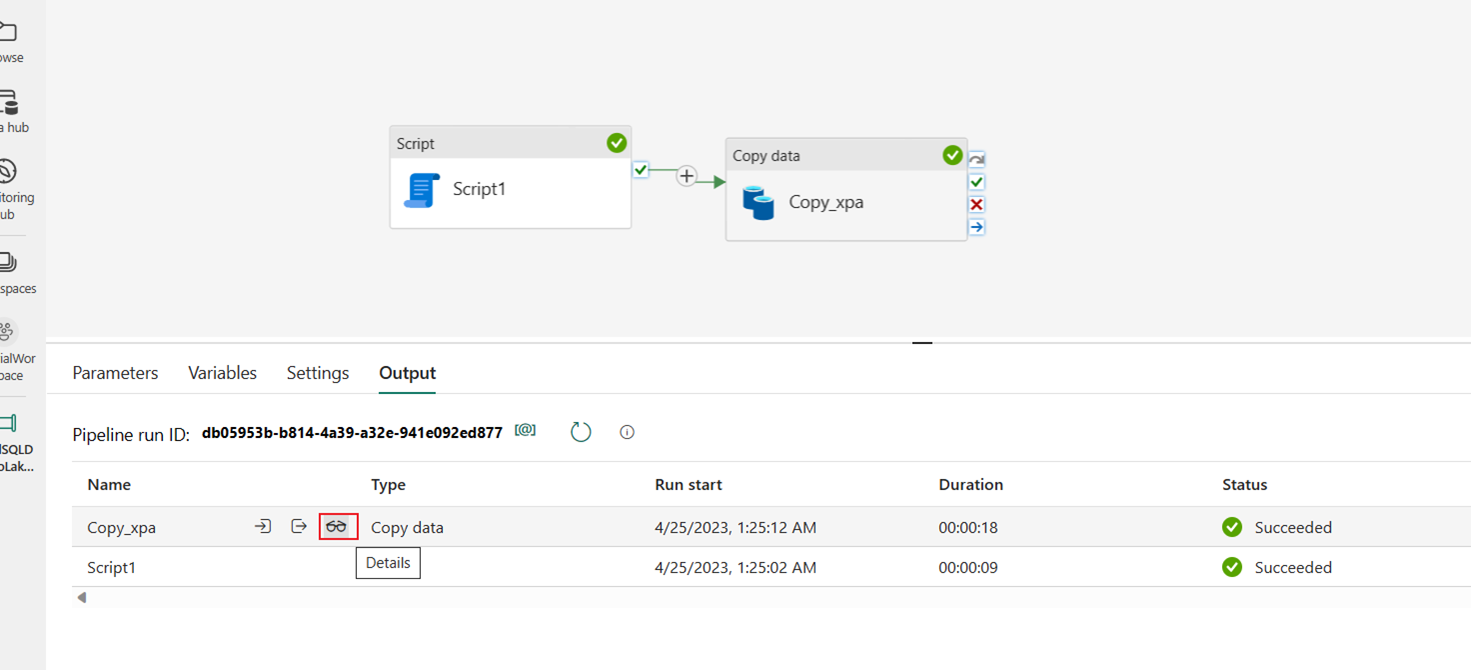

Conecte las actividades Script y Copy data mediante On success desde la actividad Script.

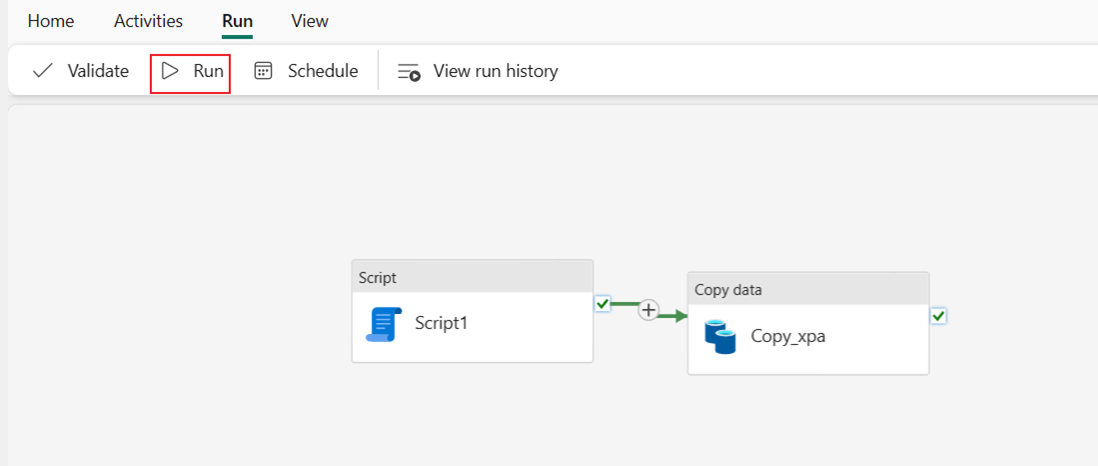

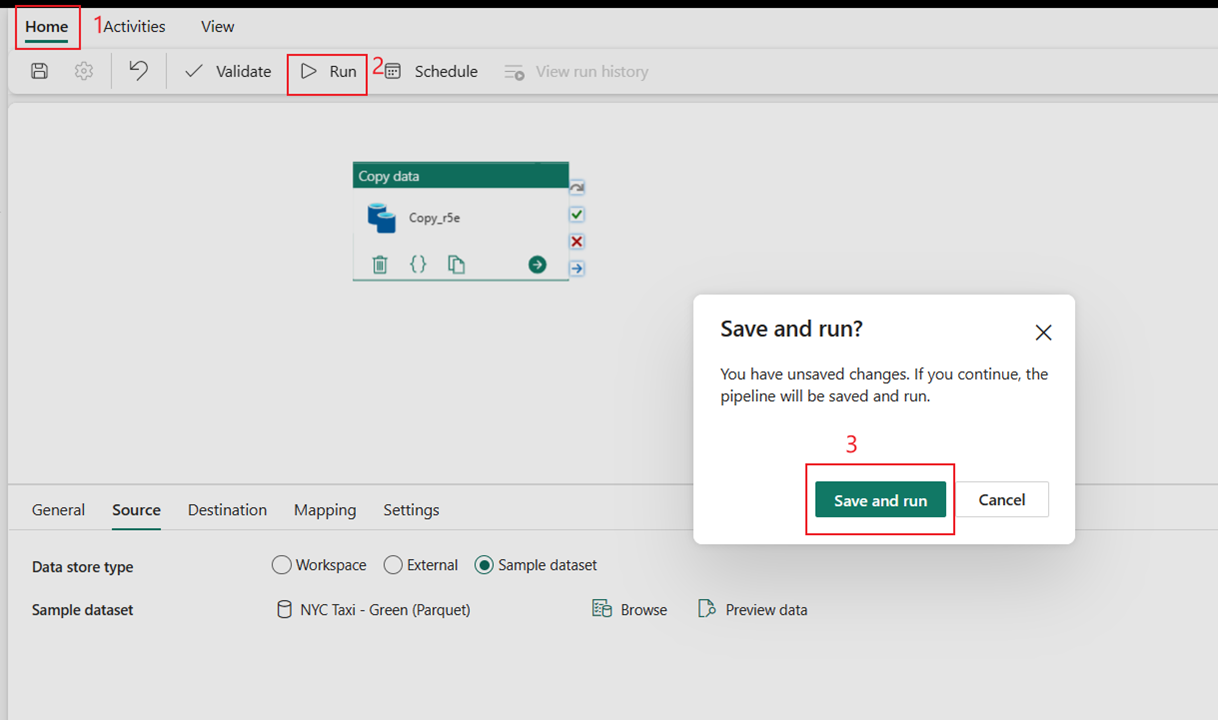

Seleccione Ejecutar y, a continuación, Guardar y ejecutar para ejecutar las dos actividades de la canalización.

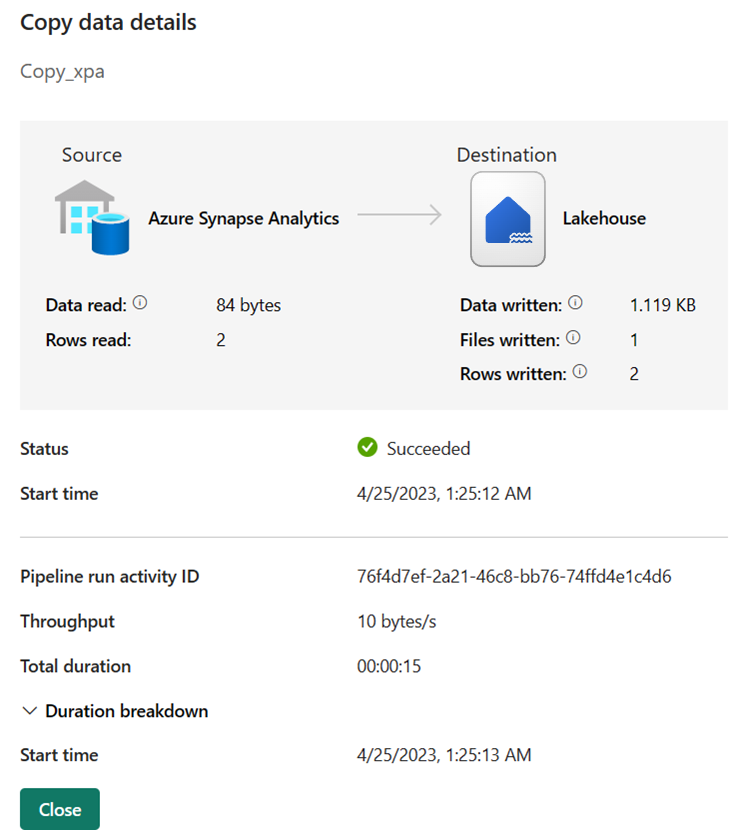

Una vez que la canalización se ejecuta correctamente, puede ver los detalles para obtener más información.

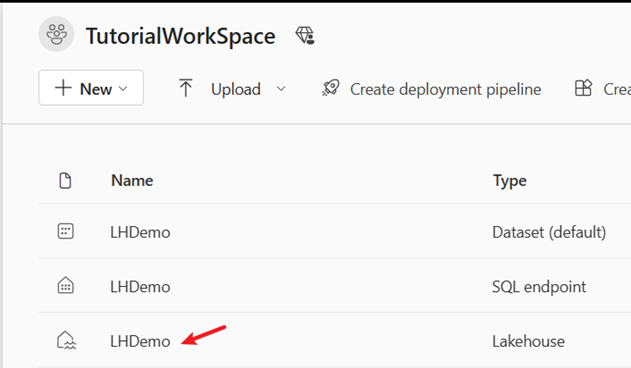

Cambie al área de trabajo y seleccione Lakehouse para comprobar los resultados.

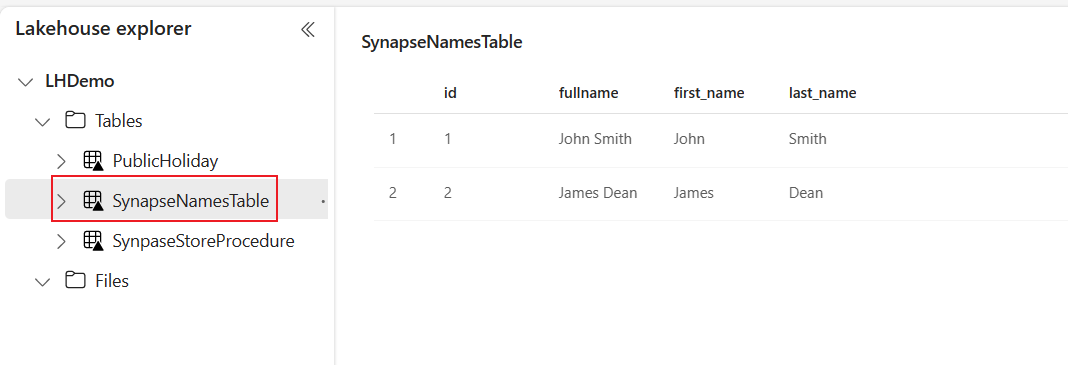

Seleccione la tabla SynapseNamesTable para ver los datos cargados en Lakehouse.

Contenido relacionado

En este ejemplo se muestra cómo preprocesar datos con un procedimiento almacenado antes de cargar los resultados en Lakehouse. Ha aprendido a:

- Cree una canalización de datos con una actividad script para ejecutar un procedimiento almacenado.

- Use una actividad de canalización para cargar los datos de tabla pre-procesados en Lakehouse.

- Ejecución de las actividades de canalización para cargar los datos

A continuación, avance para obtener más información sobre la supervisión de las ejecuciones de canalización.

Comentarios

Próximamente: A lo largo de 2024 iremos eliminando gradualmente GitHub Issues como mecanismo de comentarios sobre el contenido y lo sustituiremos por un nuevo sistema de comentarios. Para más información, vea: https://aka.ms/ContentUserFeedback.

Enviar y ver comentarios de