Événement

31 mars, 23 h - 2 avr., 23 h

Le plus grand événement d’apprentissage Fabric, Power BI et SQL. Du 31 mars au 2 avril. Utilisez le code FABINSIDER pour économiser 400 $.

Inscrivez-vous maintenantCe navigateur n’est plus pris en charge.

Effectuez une mise à niveau vers Microsoft Edge pour bénéficier des dernières fonctionnalités, des mises à jour de sécurité et du support technique.

Ce tutoriel vous montre comment utiliser l’éditeur no code Stream Analytics pour créer un travail qui capture les données Event Hubs dans Azure Data Lake Storage Gen2 au format Parquet.

Ce tutoriel vous montre comment effectuer les opérations suivantes :

Avant de commencer, vous devez avoir suivi les étapes ci-dessous :

Recherchez le groupe de ressources dans lequel le générateur d’événements TollApp a été déployé.

Sélectionnez l’espace de noms Azure Event Hubs. Vous souhaiterez peut-être l’ouvrir dans un onglet ou une fenêtre distincts.

Dans la page Espace de noms Event Hubs, sélectionnez Event Hubs sous Entités dans le menu de gauche.

Sélectionnez l’instance entrystream.

Dans la page Instance Event Hubs, sélectionnez Traiter les données sous la section Fonctionnalités du menu de gauche.

Sélectionnez Démarrer sur la vignette Capturer des données dans ADLS Gen2 au format Parquet.

Nommez votre travail parquetcapture, puis sélectionnez Créer.

Dans la page de configuration Event Hub, procédez comme suit :

Pour Groupe de consommateurs, sélectionnez Use existing (Utiliser existant).

Vérifiez que $Default groupe de consommateurs est sélectionné.

Vérifiez que Sérialisation est définie sur JSON.

Vérifiez que Méthode d’authentification est définie sur Chaîne de connexion.

Vérifiez que Nom de clé d’accès partagé de Event Hub est défini sur RootManageSharedAccessKey.

Sélectionnez Se connecter au bas de la fenêtre.

Dans quelques secondes, vous verrez s’afficher des exemples de données d’entrée ainsi que le schéma. Vous pouvez choisir de supprimer des champs, de les renommer ou de modifier le type de données.

Sélectionnez la vignette Azure Data Lake Storage Gen2 sur votre canevas et configurez-la en spécifiant

L’abonnement dans lequel se trouve votre compte Azure Data Lake Gen2

Le nom du compte de stockage, qui doit être le même compte ADLS Gen2 que celui utilisé avec votre espace de travail Azure Synapse Analytics dans la section Conditions préalables.

Le conteneur à l’intérieur duquel les fichiers Parquet seront créés.

Pour Chemin d'accès de la table delta, spécifiez un nom pour la table.

Les valeurs du modèle de date et d’heure par défaut doivent être aaaa-mm-jj et HH.

Sélectionnez Se connecter.

Sélectionnez Enregistrer dans le ruban supérieur pour enregistrer votre travail, puis Démarrer pour exécuter votre tâche. Une fois le travail démarré, sélectionnez X dans le coin droit pour fermer la page du travail Stream Analytics.

Vous verrez ensuite la liste de tous les travaux Stream Analytics créés à l’aide de l’éditeur sans code. Et au bout de deux minutes, votre travail passe à l’état En cours d’exécution. Sélectionnez le bouton Actualiser sur la page pour voir l’état passer de Création -> Démarrage -> En cours d’exécution.

Recherchez le compte Azure Data Lake Storage Gen2 que vous avez utilisé à l’étape précédente.

Accédez au conteneur que vous avez utilisé à l’étape précédente. Vous verrez les fichiers Parquet créés dans le dossier que vous avez spécifié précédemment.

Recherchez votre espace de travail Azure Synapse Analytics et ouvrez Synapse Studio.

Créez un pool Apache Spark serverless dans votre espace de travail s’il n’en existe pas déjà un.

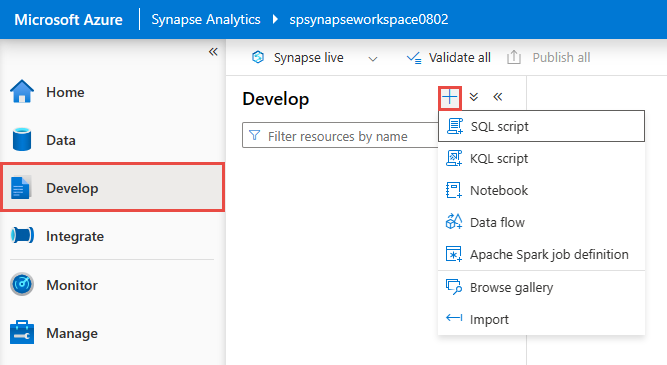

Dans Synapse Studio, accédez au hub Développer et créez un Notebook.

Créez une cellule de code et collez-y le code suivant. Remplacez conteneur et adlsname par le nom du conteneur et du compte ADLS Gen2 utilisé à l’étape précédente.

%%pyspark

df = spark.read.load('abfss://container@adlsname.dfs.core.windows.net/*/*.parquet', format='parquet')

display(df.limit(10))

df.count()

df.printSchema()

Pour Attacher à dans la barre d’outils, sélectionnez votre pool Spark dans la liste déroulante.

Sélectionnez Exécuter tout pour afficher les résultats

Dans le hub Développer, créez un script SQL.

Collez le script suivant et exécutez-le à l’aide du point de terminaison SQL serverless intégré. Remplacez conteneur et adlsname par le nom du conteneur et du compte ADLS Gen2 utilisé à l’étape précédente.

SELECT

TOP 100 *

FROM

OPENROWSET(

BULK 'https://adlsname.dfs.core.windows.net/container/*/*.parquet',

FORMAT='PARQUET'

) AS [result]

Dans ce tutoriel, vous avez appris à créer un travail Stream Analytics sans éditeurs de code pour capturer des flux de données Event Hubs au format Parquet. Vous avez ensuite utilisé Azure Synapse Analytics pour interroger les fichiers Parquet à l’aide de Synapse Spark et de Synapse SQL.

Événement

31 mars, 23 h - 2 avr., 23 h

Le plus grand événement d’apprentissage Fabric, Power BI et SQL. Du 31 mars au 2 avril. Utilisez le code FABINSIDER pour économiser 400 $.

Inscrivez-vous maintenantFormation

Module

Azure Stream Analytics fournit un moteur de traitement des données en temps réel que vous pouvez utiliser pour ingérer des données d’événements de streaming dans Azure Synapse Analytics en vue d’une analyse supplémentaire et de la création de rapports.

Certification

Microsoft Certified : Azure Data Engineer Associate - Certifications

Faites la démonstration d’une compréhension des tâches d’engineering données courantes pour implémenter et gérer des charges de travail d’engineering données sur Microsoft Azure en utilisant un certain nombre de services Azure.