Démarrage rapide : Utiliser l’outil Copier des données dans Azure Data Factory Studio pour copier des données

S’APPLIQUE À : Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Conseil

Essayez Data Factory dans Microsoft Fabric, une solution d’analyse tout-en-un pour les entreprises. Microsoft Fabric couvre tous les aspects, du déplacement des données à la science des données, en passant par l’analyse en temps réel, l’aide à la décision et la création de rapports. Découvrez comment démarrer un nouvel essai gratuitement !

Dans ce guide de démarrage rapide, vous utilisez l’outil Copier des données pour créer un pipeline qui copie les données du dossier source dans le dossier cible du Stockage Blob Azure.

Prérequis

Abonnement Azure

Si vous n’avez pas d’abonnement Azure, créez un compte gratuit avant de commencer.

Préparer les données sources dans le Stockage Blob Azure

Sélectionnez le bouton ci-dessous pour l’essayer !

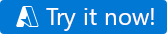

Vous êtes redirigé vers la page de configuration affichée dans l’image ci-dessous pour déployer le modèle. Ici, vous devez uniquement créer un groupe de ressources. (Vous pouvez laisser toutes les autres valeurs par défaut.) Cliquez ensuite sur Vérifier + créer, puis sur Créer pour déployer les ressources.

Notes

L’utilisateur qui déploie le modèle doit attribuer un rôle à une identité managée. Cela nécessite des autorisations qui peuvent être accordées avec les rôles Propriétaire, Administrateur de l’accès utilisateur ou Opérateur d’identité managée.

Un compte de stockage blob est créé dans le nouveau groupe de ressources et le fichier moviesDB2.csv est stocké dans un dossier appelé input dans le stockage blob.

Créer une fabrique de données

Vous pouvez utiliser votre fabrique de données existante ou en créer une comme décrit dans Démarrage rapide : Créer une fabrique de données en utilisant le portail Azure.

Utiliser l’outil Copier des données pour copier des données

Les étapes ci-dessous vous expliquent comment copier facilement des données avec l’outil Copier des données dans Azure Data Factory.

Étape 1 : Démarrer l’outil Copier des données

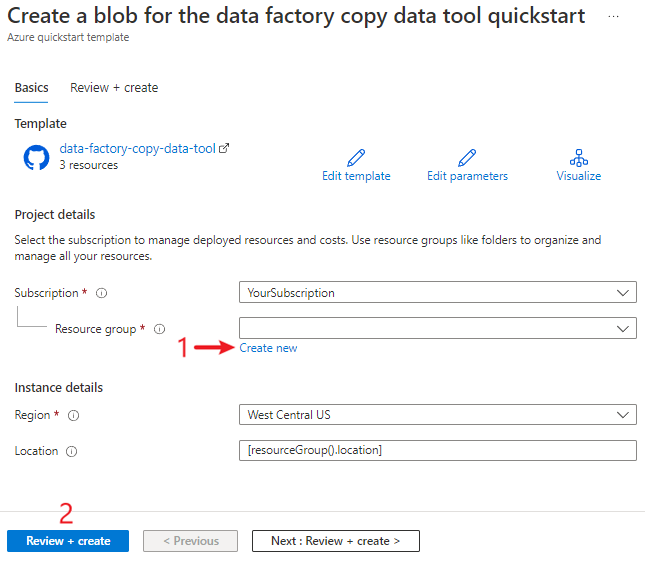

Sur la page d’accueil d’Azure Data Factory, sélectionnez la mosaïque Ingérer pour démarrer l’outil Copier des données.

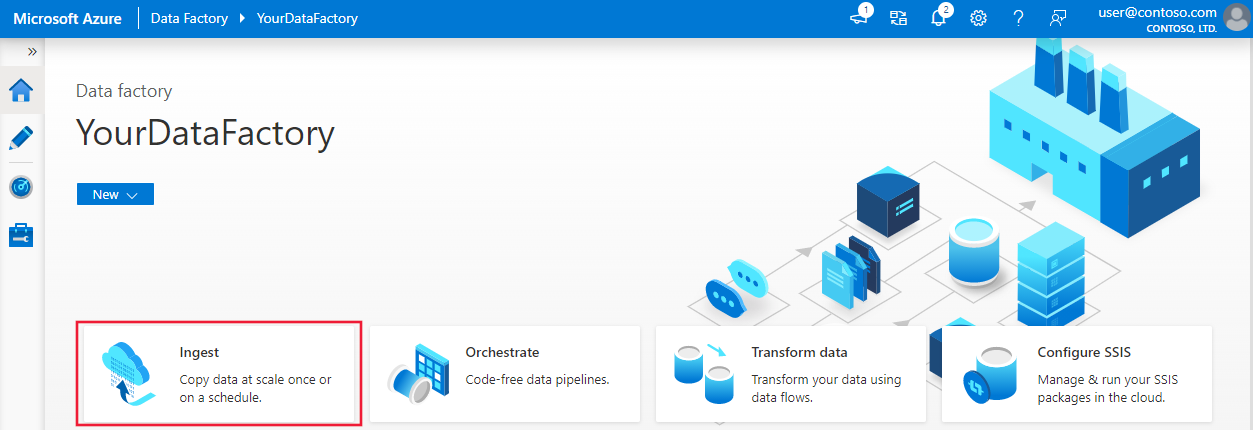

Sur la page Propriétés de l’outil Copier des données, choisissez Tâche de copie intégrée sous Type de tâche, puis Suivant.

Étape 2 : Configurer la source

Cliquez sur +Créer une connexion pour ajouter une connexion.

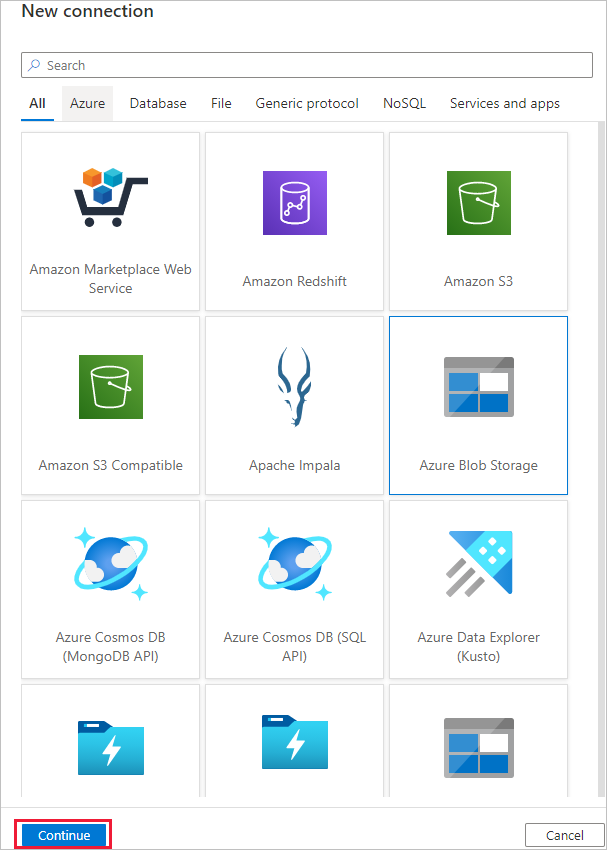

Sélectionnez le type de service lié à créer pour la connexion source. Dans ce tutoriel, nous utilisons le Stockage Blob Azure. Sélectionnez-le dans la galerie, puis sélectionnez Continuer.

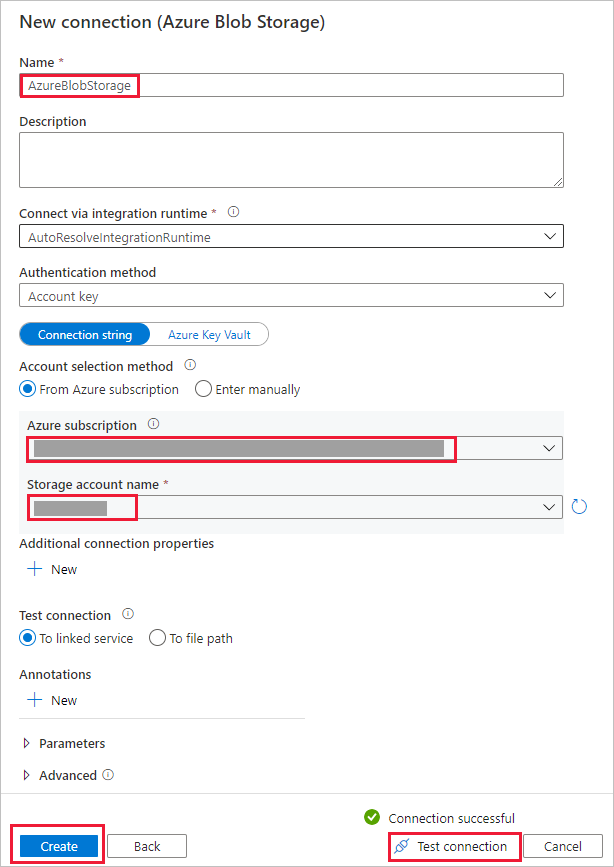

Sur la page Nouvelle connexion (Stockage Blob Azure) , donnez un nom à votre connexion. Sélectionnez votre abonnement Azure dans la liste Abonnement Azure et votre compte de stockage dans la liste Nom du compte de stockage, testez la connexion, puis sélectionnez Créer.

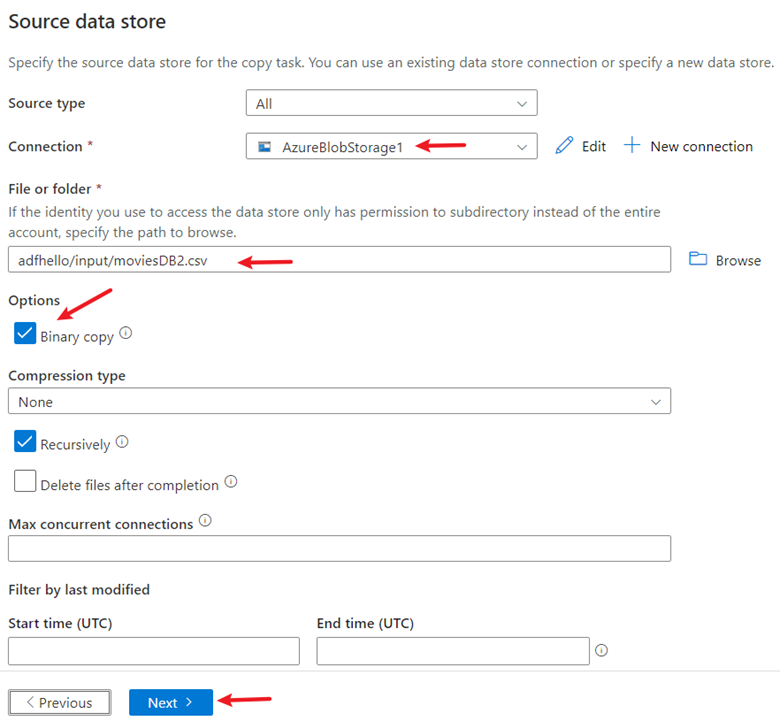

Sélectionnez la nouvelle connexion dans le bloc Connexion.

Dans la section Fichier ou dossier, sélectionnez Parcourir pour accéder au dossier adftutorial/input, sélectionnez le fichier emp.txt, puis cliquez sur OK.

Cochez la case Copie binaire pour copier le fichier tel quel, puis sélectionnez Suivant.

Étape 3 : Configurer la destination

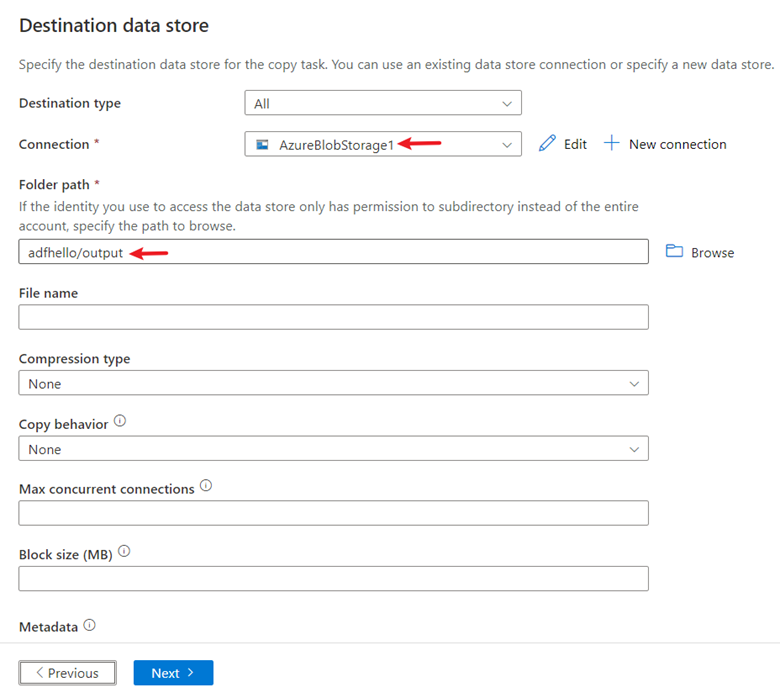

Sélectionnez la connexion AzureBlobStorage que vous avez créée dans le bloc Connexion.

Dans la section Chemin du dossier, entrez adftutorial/output.

Conservez les autres paramètres par défaut, puis sélectionnez Suivant.

Étape 4 : Passer en revue tous les paramètres et le déploiement

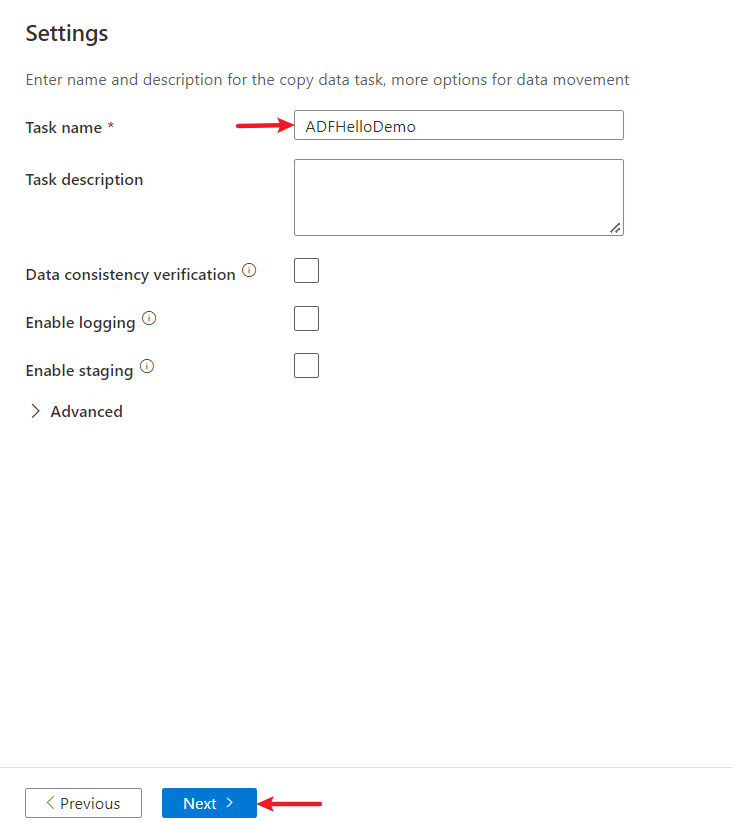

Sur la page Paramètres, donnez un nom au pipeline, ajoutez sa description, puis sélectionnez Suivant pour utiliser d’autres configurations par défaut.

Dans la page Résumé, passez en revue tous les paramètres, puis cliquez sur Suivant.

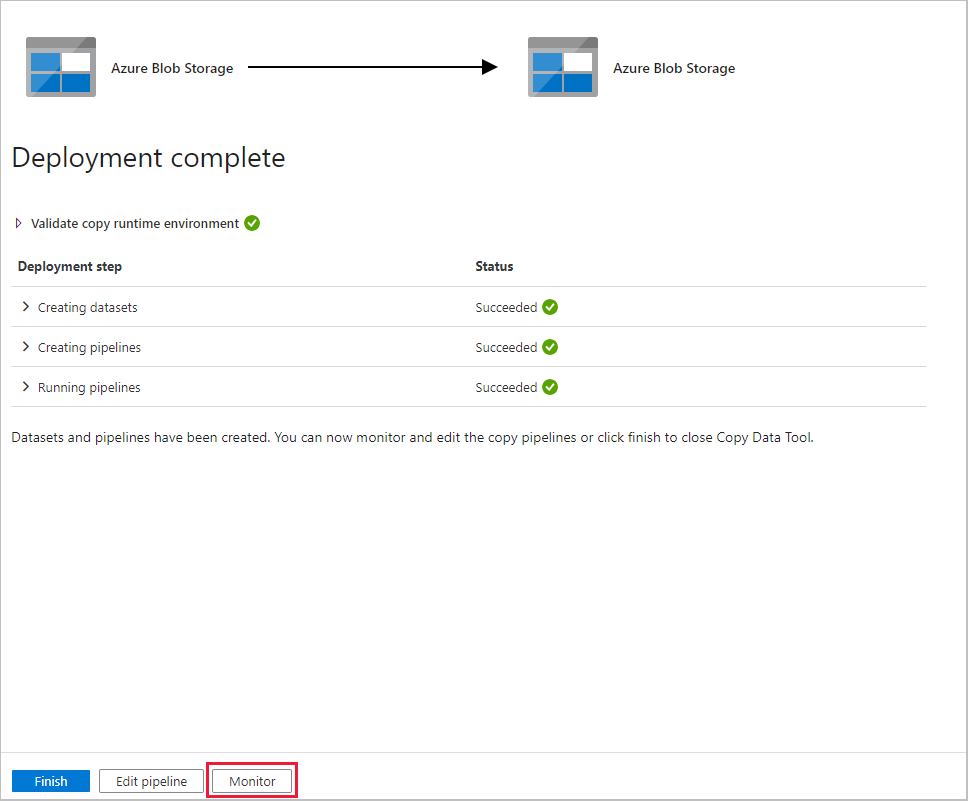

Sur la page Déploiement terminé, sélectionnez Surveiller pour surveiller le pipeline que vous avez créé.

Étape 5 : Superviser les résultats d’exécution

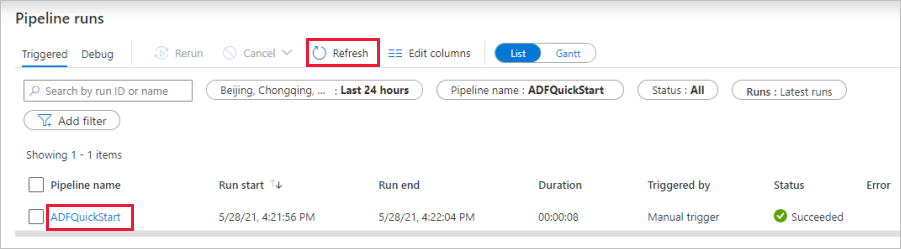

L’application bascule vers l’onglet Surveiller. Vous voyez l’état du pipeline dans cet onglet. Sélectionnez Actualiser pour actualiser la liste. Cliquez sur le lien situé sous Nom du pipeline pour afficher les détails de l’exécution d’activité ou réexécuter le pipeline.

Sur la page Exécutions d’activité, sélectionnez le lien Détails (icône en forme de lunettes) sous la colonne Nom de l’activité pour plus d’informations sur l’opération de copie. Pour plus d’informations sur les propriétés, consultez Vue d’ensemble de l’activité de copie.

Contenu connexe

Dans cet exemple, le pipeline copie les données d’un emplacement vers un autre dans un stockage Blob Azure. Pour en savoir plus sur l’utilisation de Data Factory dans d’autres scénarios, consultez les didacticiels.