Comprendre Azure Data Factory

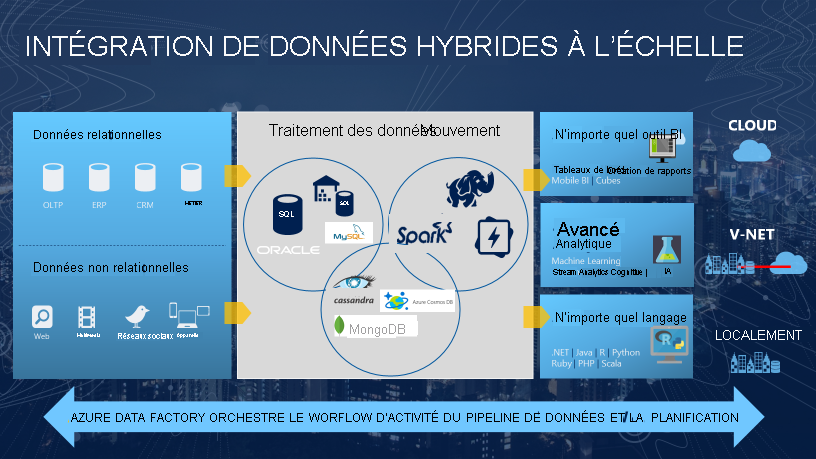

Le besoin de déclencher le déplacement par lots des données ou de configurer une planification régulière est incontournable dans la plupart des solutions d’analytique. Le service Azure Data Factory (ADF) est celui que vous pouvez utiliser pour satisfaire à une telle exigence. ADF fournit un service d’intégration de données basé sur le cloud qui orchestre le déplacement et la transformation des données entre les divers magasins de données et ressources de calcul.

Azure Data Factory est le service cloud d’ETL et d’intégration de données qui vous permet de créer des workflows basés sur les données pour orchestrer le déplacement des données et transformer des données à grande échelle. À l’aide d’Azure Data Factory, vous pouvez créer et planifier des flux de travail pilotés par les données (appelés pipelines) qui peuvent ingérer des données provenant de différents magasins de données. Vous pouvez créer des processus ETL complexes qui transforment des données visuellement avec des flux de données, ou en utilisant des services comme Azure HDInsight Hadoop, Azure Databricks et Azure Synapse Analytics.

La plupart des fonctionnalités d’Azure Data Factory apparaissent dans Azure Synapse Analytics sous la forme d’une fonctionnalité appelée Pipelines, qui vous permet d’intégrer des pipelines de données entre des pools SQL, des pools Spark et SQL Serverless, ce qui permet de répondre à tous vos besoins analytiques en même temps.

Signification de l’orchestration

Pour utiliser une analogie, pensez à un orchestre symphonique. Son membre central est le chef d’orchestre. Le chef d’orchestre ne joue pas d’un instrument. Il dirige simplement les musiciens pendant toute la pièce musicale qu’ils interprètent. Les musiciens utilisent leurs propres compétences pour produire des sons particuliers lors des différents mouvements de la symphonie, si bien qu’ils peuvent se contenter d’en apprendre uniquement certaines parties. Le chef d’orchestre coordonne toute la pièce musicale et, par conséquent, il connaît l’intégralité de l’interprétation. Il utilise aussi des mouvements de bras précis pour donner des instructions aux musiciens sur leur façon de jouer.

Le service ADF peut utiliser une approche similaire. Alors qu’il comporte des fonctionnalités natives pour l’ingestion et la transformation des données, il demande parfois à un autre service d’effectuer le travail réel nécessaire à sa place, par exemple Databricks, pour d’exécuter une requête de transformation. Ainsi, dans ce cas, c’est Databricks qui effectue le travail, et non ADF. ADF orchestre simplement l’exécution de la requête, puis fournit les pipelines pour déplacer les données vers l’étape ou la destination suivante.

Il fournit également des affichages élaborés pour visualiser le lignage et les dépendances entre vos pipelines de données, ainsi qu’une vue unifiée depuis laquelle vous pouvez surveiller l’ensemble de ces pipelines afin d’identifier les problèmes et de configurer des alertes d’analyse en toute simplicité.