Számítások kezelése

Ez a cikk bemutatja, hogyan kezelheti az Azure Databricks-számításokat, beleértve a megjelenítést, szerkesztést, indítást, megszüntetést, törlést, hozzáférés-vezérlést, valamint a teljesítmény és naplók monitorozását. A Clusters API-val programozott módon is kezelheti a számítást.

Számítás megtekintése

A számítás megtekintéséhez kattintson a Számítási gombra ![]() a munkaterület oldalsávjában.

a munkaterület oldalsávjában.

A bal oldalon két oszlop látható, amelyek jelzik, hogy a számítás rögzítve van-e, és hogy a számítás állapota van-e rögzítve. Vigye az egérmutatót az állapot fölé további információkért.

Számítási konfiguráció megtekintése JSON-fájlként

Néha hasznos lehet JSON-ként tekinteni a számítási konfigurációra. Ez különösen akkor hasznos, ha hasonló számítást szeretne létrehozni a Clusters API használatával. Meglévő számítás megtekintésekor lépjen a Konfiguráció lapra, kattintson a lap jobb felső sarkában található JSON elemre, másolja ki a JSON-t, és illessze be az API-hívásba. A JSON-nézet írásvédett.

Számítás rögzítése

A számítás leállása után 30 nappal véglegesen törlődik. Ha egy 30 napnál hosszabb ideig végzett számítás leállása után meg szeretné tartani a teljes célú számítási konfigurációt, a rendszergazda rögzítheti a számítást. Legfeljebb 100 számítási erőforrás rögzíthető.

Rendszergazda a rögzítés ikonra kattintva rögzíthetnek számításokat a számítási listáról vagy a számítás részleteiről.

Számítás szerkesztése

A számítás konfigurációját a számítási adatok felhasználói felületén szerkesztheti.

Feljegyzés

- A számításhoz csatolt jegyzetfüzetek és feladatok a szerkesztés után is csatolva maradnak.

- A számításra telepített kódtárak a szerkesztés után is telepítve maradnak.

- Ha egy futó számítás bármely attribútumát szerkessze (kivéve a számítási méretet és az engedélyeket), újra kell indítania. Ez megzavarhatja a számítást jelenleg használó felhasználókat.

- Csak futó vagy leállított számításokat szerkeszthet. A számítási adatok oldalán azonban nem ezekben az állapotokban frissítheti a számítási engedélyeket .

Számítás klónozása

Meglévő számítás klónozásához válassza a Klónozás lehetőséget a számítás  kebab menüjében.

kebab menüjében.

A Klónozás kiválasztása után a számítási létrehozás felhasználói felülete a számítási konfigurációval előre feltöltve nyílik meg. A klón nem tartalmazza a következő attribútumokat:

- Számítási engedélyek

- Csatolt jegyzetfüzetek

Ha nem szeretné belefoglalni a korábban telepített kódtárakat a klónozott számításba, kattintson a Számítás létrehozása gomb melletti legördülő menüre, és válassza a Tárak nélküli létrehozás lehetőséget.

Számítási engedélyek

A számításhoz négy engedélyszint létezik: NINCS ENGEDÉLY, CSATOLHATÓ, ÚJRAINDÍTHATÓ és KEZELHETŐ. A táblázat felsorolja az egyes engedélyek képességeit.

Fontos

A CAN ATTACH TO engedélyekkel rendelkező felhasználók megtekinthetik a szolgáltatásfiók kulcsait a log4j fájlban. A jogosultsági szint megadásakor körültekintően járjon el.

| Képesség | NINCS ENGEDÉLY | CSATOLHATÓ | ÚJRAINDULHAT | KEZELHETŐ |

|---|---|---|---|---|

| Jegyzetfüzet csatolása a számításhoz | x | x | x | |

| A Spark felhasználói felületének megtekintése | x | x | x | |

| Számítási metrikák megtekintése | x | x | x | |

| Illesztőprogram-naplók megtekintése | x (lásd a megjegyzést) | |||

| Számítási feladat leállítja | x | x | ||

| Számítás indítása és újraindítása | x | x | ||

| Számítás szerkesztése | x | |||

| Erőforrástár csatolása a számításhoz | x | |||

| Számítás átméretezése | x | |||

| Engedélyek módosítása | x |

A munkaterület rendszergazdái rendelkeznek a CAN MANAGE engedéllyel a munkaterület összes számításához. A felhasználók automatikusan rendelkeznek a CAN MANAGE engedéllyel a létrehozott számításhoz.

Feljegyzés

A titkos kulcsok nem jelennek meg a fürt Spark-illesztőprogramjának naplójából stdout és stderr streamjeiből. A bizalmas adatok védelme érdekében a Spark-illesztőprogramok naplói alapértelmezés szerint csak a FELADATKEZELÉS engedéllyel, az egyfelhasználós hozzáférési móddal és a megosztott hozzáférési módú fürtökkel rendelkező felhasználók számára tekinthetők meg. Ha engedélyezni szeretné, hogy a CAN ATTACH TO vagy CAN RESTART engedéllyel rendelkező felhasználók megtekinthetik a fürtök naplóit, állítsa be a következő Spark-konfigurációs tulajdonságot a fürtkonfigurációban: spark.databricks.acl.needAdminPermissionToViewLogs false

Nincs elkülönítési megosztott hozzáférési módú fürt, a Spark-illesztőprogram-naplókat azok a felhasználók tekinthetik meg, aki rendelkezik CSATOLÁSI vagy KEZELÉSI engedéllyel. Ha csak a CAN MANAGE engedéllyel rendelkező felhasználókra szeretné korlátozni a naplók olvasását, állítsa be spark.databricks.acl.needAdminPermissionToViewLogs a következőt true: .

Tekintse meg a Spark-konfigurációt , amelyből megtudhatja, hogyan adhat hozzá Spark-tulajdonságokat egy fürtkonfigurációhoz.

Számítási engedélyek konfigurálása

Ez a szakasz azt ismerteti, hogyan kezelheti az engedélyeket a munkaterület felhasználói felületén. Használhatja a Permissions API-t vagy a Databricks Terraform-szolgáltatót is.

A számítási engedélyek konfigurálásához rendelkeznie kell a CAN MANAGE engedéllyel egy számításon.

- Az oldalsávon kattintson a Számítás gombra.

- A számítás sorában kattintson a jobb oldali kebab menüre

, és válassza az Engedélyek szerkesztése lehetőséget.

, és válassza az Engedélyek szerkesztése lehetőséget. - Az Engedély Gépház kattintson a Felhasználó, csoport vagy szolgáltatásnév kiválasztása... legördülő menüre, és válasszon ki egy felhasználót, csoportot vagy szolgáltatásnevet.

- Válasszon egy engedélyt az engedély legördülő menüből.

- Kattintson a Hozzáadás és a Mentés gombra.

Számítási feladat leállása

A számítási erőforrások mentéséhez leállíthat egy számítást. A leállított számítás konfigurációja úgy van tárolva, hogy később újra felhasználható legyen (vagy feladatok esetén automatikusan üzembe helyezhető). Manuálisan is leállíthat egy számítást, vagy konfigurálhatja a számítást úgy, hogy egy adott inaktivitási időszak után automatikusan leálljon. Ha a leállított számítás száma meghaladja a 150-et, a rendszer törli a legrégebbi számítást.

Ha nem rögzített vagy újraindult számítás, a rendszer a leállítás után 30 nappal automatikusan és véglegesen törli azt.

A megszakított számítás megjelenik a számítási listában, a számítási név bal oldalán egy szürke körrel.

Feljegyzés

Amikor egy feladatot egy új feladatszámításon futtat (ami általában ajánlott), a számítás leáll, és a feladat befejezésekor nem indítható újra. Ha viszont ütemez egy feladatot egy leállított, meglévő, teljes célú számítás futtatására, az automatikusan elindul.

Fontos

Ha prémium szintű próbaverziós munkaterületet használ, a rendszer az összes futó számítási erőforrást leállítja:

- Amikor egy munkaterületet teljes prémium szintűre frissít.

- Ha a munkaterület nincs frissítve, és a próbaidőszak lejár.

Manuális leállítás

Manuálisan leállíthat egy számítást a számítási listáról (a számítás sorának négyzetére kattintva) vagy a számítás részletei lapra (a Leállítás gombra kattintva).

Automatikus leállítás

A számítás automatikus leállítását is beállíthatja. A számítás létrehozása során megadhat egy inaktivitási időszakot percek alatt, amely után le szeretné állítani a számítást.

Ha a számításon az aktuális idő és az utolsó parancsfuttatás közötti különbség nagyobb, mint a megadott inaktivitási időszak, az Azure Databricks automatikusan leállítja a számítást.

A számítás akkor minősül inaktívnak, ha a számítás összes parancsa, beleértve a Spark-feladatokat, a strukturált streamelést és a JDBC-hívásokat, befejeződött a végrehajtás.

Figyelmeztetés

- A számítás nem jelenti a D adatfolyamok használatából eredő tevékenységet. Ez azt jelenti, hogy egy automatikusan megszüntető számítás leállhat a D adatfolyamok futtatása közben. Kapcsolja ki az automatikus leállítást a D adatfolyamok futtató számításhoz, vagy fontolja meg a strukturált streamelés használatát.

- Az inaktív számítás továbbra is halmozódik fel dBU- és felhőpéldány-díjakat a leállítás előtti inaktivitási időszakban.

Automatikus leállítás konfigurálása

Az automatikus leállítást az új számítási felületen konfigurálhatja. Győződjön meg arról, hogy a jelölőnégyzet be van jelölve, és adja meg a percek számát az inaktivitási percek ___ utáni leállítása beállításban.

Az automatikus megszüntetés letiltását az Automatikus megszüntetés jelölőnégyzet törlésével vagy a következő inaktivitási 0időszak megadásával tilthatja le:

Feljegyzés

Az automatikus leállítás a legújabb Spark-verziókban támogatott legjobban. A régebbi Spark-verziók ismert korlátozásokkal rendelkeznek, amelyek pontatlan jelentéskészítést eredményezhetnek a számítási tevékenységről. A JDBC, R vagy streamelési parancsokat futtató számítás például jelenthet egy elavult tevékenységidőt, amely idő előtt leáll. Frissítsen a legújabb Spark-verzióra, hogy kihasználhassa a hibajavításokat és az automatikus megszüntetés fejlesztéseit.

Váratlan megszüntetés

Előfordulhat, hogy egy számítás váratlanul leáll, nem manuális leállítás vagy konfigurált automatikus leállítás eredményeként.

A megszüntetési okok és a szervizelési lépések listáját a Tudásbázisban találja.

Számítás törlése

A számítás törlése leállítja a számítást, és eltávolítja annak konfigurációját. Ha törölni szeretne egy számítást, válassza a Delete (Törlés) lehetőséget a számítás  menüjében.

menüjében.

Figyelmeztetés

Ezt a műveletet nem vonhatja vissza.

A rögzített számítás törléséhez először a rendszergazdának kell törölnie.

Meghívhatja a Clusters API-végpontot is, hogy programozott módon töröljön egy számítást.

Számítás újraindítása

A korábban leállított számításokat újraindíthatja a számítási listáról, a számítás részleteinek oldaláról vagy egy jegyzetfüzetből. A Clusters API-végpontot is meghívhatja a számítás programozott elindításához.

Az Azure Databricks egyedi fürtazonosítójával azonosítja a számításokat. A leállított számítás indításakor a Databricks ugyanazzal az azonosítóval hozza létre újra a számítást, automatikusan telepíti az összes kódtárat, és újratelepíti a jegyzetfüzeteket.

Feljegyzés

Ha próbaverziós munkaterületet használ, és a próbaidőszak lejárt, nem fog tudni számítást indítani.

Indítsa újra a számítást a legújabb rendszerképekkel való frissítéshez

Amikor újraindít egy számítást, a rendszer lekéri a számítási erőforrás-tárolók és a virtuálisgép-gazdagépek legfrissebb rendszerképeit. Fontos, hogy rendszeres újraindításokat ütemezzen a hosszú ideig futó számításokhoz, például a streamelési adatok feldolgozásához.

Az Ön felelőssége, hogy rendszeresen újraindítsa az összes számítási erőforrást, hogy a rendszerkép naprakész legyen a legújabb rendszerkép-verzióval.

Fontos

Ha engedélyezi a fiók vagy a munkaterület megfelelőségi biztonsági profilját , a rendszer szükség szerint automatikusan újraindítja a hosszú ideig futó számítást egy ütemezett karbantartási időszak során. Ez csökkenti az ütemezett feladatok automatikus újraindításának kockázatát. A karbantartási időszak alatt is kényszerítheti az újraindítást. Lásd: Automatikus fürtfrissítés.

Példa jegyzetfüzetre: Hosszú ideig futó számítás keresése

Ha Ön munkaterület-rendszergazda, futtathat egy szkriptet, amely meghatározza, hogy az egyes számítások mennyi ideig futnak, és szükség esetén újraindíthatja őket, ha egy megadott számú napnál régebbiek. Az Azure Databricks ezt a szkriptet jegyzetfüzetként biztosítja.

A szkript első sorai a konfigurációs paramétereket határozzák meg:

min_age_output: A számítás által futtatható napok maximális száma. Az alapértelmezett érték 1.perform_restart: HaTrue, a szkript újraindítja azokat a számításokat, amelynek életkora meghaladja a megadottmin_age_outputnapok számát. Az alapértelmezett beállítás aFalsehosszú ideig futó számításokat azonosítja, de nem indítja újra őket.secret_configuration: Cserélje leREPLACE_WITH_SCOPEaREPLACE_WITH_KEYtitkos kulcs hatókörét és kulcsnevét. A titkos kódok beállításával kapcsolatos további részletekért tekintse meg a jegyzetfüzetet.

Figyelmeztetés

Ha be Truevan állítvaperform_restart, a szkript automatikusan újraindítja a jogosult számítást, ami az aktív feladatok meghiúsulását és a megnyitott jegyzetfüzetek alaphelyzetbe állítását okozhatja. A munkaterület üzleti szempontból kritikus feladatainak megzavarásának kockázatának csökkentése érdekében tervezze meg az ütemezett karbantartási időszakot, és mindenképpen értesítse a munkaterület felhasználóit.

A hosszú ideig futó számítás azonosítása és opcionális újraindítása

Számítási automatikus útmutató feladatokhoz és JDBC-/ODBC-lekérdezésekhez

Ha egy leállított számításhoz hozzárendelt feladat futtatása ütemezve van, vagy egy JDBC/ODBC-adapterről csatlakozik egy leállított számításhoz, a számítás automatikusan újraindul. Lásd: Feladat létrehozása és JDBC-csatlakozás.

A számítási automatikus indítás lehetővé teszi, hogy a számítás automatikusan leálljon anélkül, hogy manuális beavatkozásra van szükség az ütemezett feladatok számításának újraindításához. Emellett ütemezheti a számítási inicializálást úgy is, hogy ütemez egy feladatot, hogy leállított számításon fusson.

Mielőtt egy számítás automatikusan újraindul, a számítási és feladathozzáférés-vezérlési engedélyek ellenőrzése megtörténik.

Feljegyzés

Ha a számítás az Azure Databricks platform 2.70-es vagy korábbi verziójában lett létrehozva, nincs automatikus indítás: a leállított számításon való futtatásra ütemezett feladatok sikertelenek lesznek.

Számítási adatok megtekintése az Apache Spark felhasználói felületén

A Spark-feladatok részletes információit a Számítási adatok lapon található Spark felhasználói felület fülre kattintva tekintheti meg.

Ha újraindít egy leállított számítást, a Spark felhasználói felülete az újraindított számítás adatait jeleníti meg, nem pedig a leállított számítás előzményadatait.

A Költség- és teljesítményproblémák diagnosztizálása a Spark felhasználói felületén a költség- és teljesítményproblémák diagnosztizálásához a Spark felhasználói felületén.

Számítási naplók megtekintése

Az Azure Databricks háromféle naplózást biztosít a számítással kapcsolatos tevékenységekhez:

- Számítási eseménynaplók, amelyek rögzítik a számítási életciklus eseményeit, például a létrehozást, a leállítást és a konfigurációs módosításokat.

- Apache Spark-illesztőprogram és feldolgozói napló, amelyet hibakereséshez használhat.

- Számítási init-szkriptnaplók, amelyek értékesek az init-szkriptek hibakereséséhez.

Ez a szakasz a számítási eseménynaplókat, valamint az illesztőprogram- és feldolgozónaplókat ismerteti. Az init-script naplókkal kapcsolatos részletekért lásd az Init-szkriptnaplózást.

Számítási eseménynaplók

A számítási eseménynapló olyan fontos számítási életciklus-eseményeket jelenít meg, amelyeket manuálisan, felhasználói műveletek vagy az Azure Databricks automatikusan aktivál. Az ilyen események hatással vannak a számítás egészének működésére és a számításban futó feladatokra.

A támogatott eseménytípusokért tekintse meg a Clusters API adatstruktúráját.

Az események tárolása 60 napig történik, ami hasonló az Azure Databricks más adatmegőrzési idejéhez.

Számítási eseménynapló megtekintése

A számítás eseménynaplójának megtekintéséhez válassza az Eseménynapló fület a számítási részletek lapjain.

Az eseményekkel kapcsolatos további információkért kattintson a napló sorára, majd a JSON fülre a részletekért.

Számítási illesztőprogramok és feldolgozói naplók

A notebookokból, feladatokból és kódtárakból származó közvetlen nyomtatási és naplóutasítások a Spark-illesztőprogram naplóiba kerülnek. Ezeket a naplófájlokat a számítási adatok lap Illesztőprogram-naplók lapján érheti el. A fájl letöltéséhez kattintson a naplófájl nevére.

Ezeknek a naplóknak három kimenete van:

- Standard kimenet

- Standard hiba

- Log4j-naplók

A Spark-feldolgozói naplók megtekintéséhez használja a Spark felhasználói felület lapfülét. A számítási naplók kézbesítési helyét is konfigurálhatja. A feldolgozói és a számítási naplók is a megadott helyre kerülnek.

Teljesítmény figyelése

Az Azure Databricks számítási teljesítményének monitorozásához az Azure Databricks hozzáférést biztosít a metrikákhoz a számítási részletek oldalról. A Databricks Runtime 12.2 és újabb verzió esetén az Azure Databricks hozzáférést biztosít a Ganglia-metrikákhoz. A Databricks Runtime 13.0-s vagy újabb verziója esetén a számítási metrikákat az Azure Databricks biztosítja.

Emellett konfigurálhat egy Azure Databricks-számítást, hogy metrikákat küldjön egy Log Analytics-munkaterületre az Azure Monitorban, az Azure monitorozási platformjában.

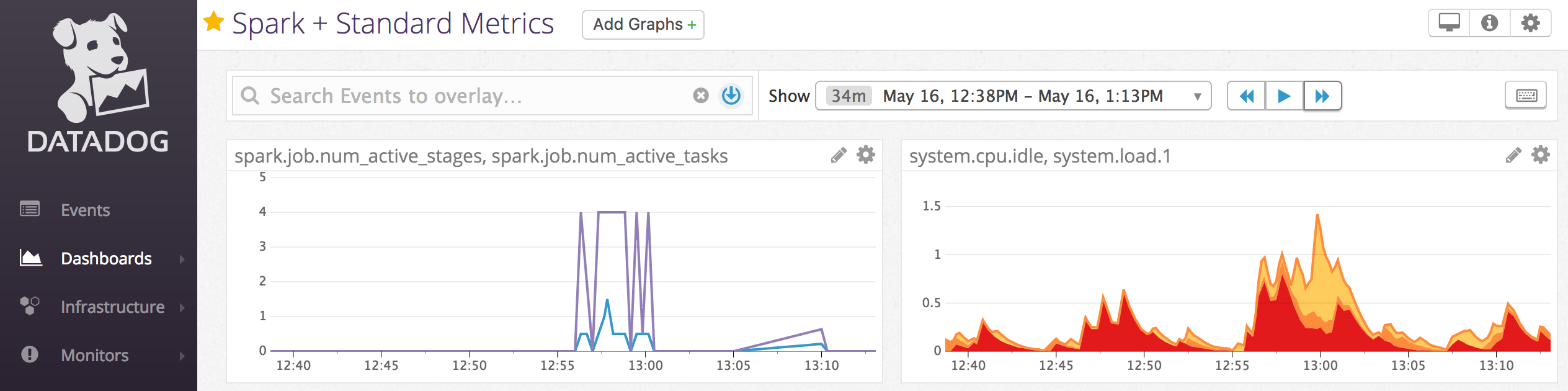

A Datadog-ügynököket a számítási csomópontokra is telepítheti, hogy Datadog-metrikákat küldjön a Datadog-fióknak.

Számítási metrikák

A számítási metrikák a Databricks Runtime 13.0-s és újabb verziók alapértelmezett monitorozási eszköze. A számítási metrikák felhasználói felületének eléréséhez lépjen a Számítás részletei lap Metrikák lapjára.

Az előzménymetrikák megtekintéséhez válasszon ki egy időtartományt a dátumválasztó szűrővel. A metrikákat percenként gyűjtjük. A legújabb metrikákat a Frissítés gombra kattintva is lekérheti. További információ: Számítási metrikák megtekintése.

Ganglia-metrikák

Feljegyzés

A Ganglia-metrikák csak a Databricks Runtime 12.2-hez és az alábbi verzióhoz érhetők el.

A Ganglia felhasználói felületének eléréséhez lépjen a Számítások lap Metrikák lapjára a számítási részletek lapon. A CPU-metrikák a Ganglia felhasználói felületén érhetők el az összes Databricks-futtatókörnyezethez. A GPU-metrikák GPU-kompatibilis számítási feladatokhoz érhetők el.

Az élő metrikák megtekintéséhez kattintson a Ganglia felhasználói felületére .

Az előzménymetrikák megtekintéséhez kattintson egy pillanatképfájlra. A pillanatkép a kiválasztott időpont előtti óra összesített metrikáit tartalmazza.

Feljegyzés

A Ganglia nem támogatott a Docker-tárolókban. Ha Docker-tárolót használ a számítással, a Ganglia-metrikák nem lesznek elérhetők.

Ganglia-metrikák gyűjteményének konfigurálása

Alapértelmezés szerint az Azure Databricks 15 percenként gyűjt Ganglia-metrikákat. A gyűjtési időszak konfigurálásához állítsa be a DATABRICKS_GANGLIA_SNAPSHOT_PERIOD_MINUTES környezeti változót init-szkripttelvagy a spark_env_vars Fürt létrehozása API mezőjében.

Azure Monitor

Konfigurálhat egy Azure Databricks-számítást, hogy metrikákat küldjön egy Log Analytics-munkaterületre az Azure Monitorban, az Azure monitorozási platformjában. A teljes útmutatót itt találja: Az Azure Databricks monitorozása.

Feljegyzés

Ha az Azure Databricks-munkaterületet a saját virtuális hálózatában telepítette, és hálózati biztonsági csoportokat (NSG) konfigurált az Azure Databricks által nem szükséges kimenő forgalom letiltására, akkor konfigurálnia kell egy további kimenő szabályt az "AzureMonitor" szolgáltatáscímkéhez.

Példa jegyzetfüzetre: Datadog-metrikák

Datadog-ügynököket telepítheti a számítási csomópontokra, hogy Datadog-metrikákat küldjön a Datadog-fióknak. Az alábbi jegyzetfüzet bemutatja, hogyan telepíthet Datadog-ügynököt egy számítási hatókörű init-szkript használatával.

A Datadog-ügynök minden számításra való telepítéséhez kezelje a számítási hatókörű init-szkriptet egy számítási szabályzat használatával.

A Datadog-ügynök init szkriptfüzetének telepítése

Kihasználatlan példányok leszerelése

Mivel a kihasználatlan példányok csökkenthetik a költségeket, a feladatok futtatásának gyakori módja a kihasználatlan példányok helyett a számítás létrehozása. A kihasználatlan példányokat azonban a felhőszolgáltatók ütemezési mechanizmusai elő tudják készíteni. A kihasználatlan példányok előzetes észlelése problémákat okozhat a futó feladatokkal kapcsolatban, például:

- Lekérési hibák az shuffle-ben

- Adatvesztés elfojtása

- RDD-adatvesztés

- Sikertelen feladatok

Engedélyezheti a leszerelést a problémák megoldásához. A leszerelés kihasználja azt az értesítést, amelyet a felhőszolgáltató általában a kihasználatlan példány leszerelése előtt küld. Amikor egy végrehajtót tartalmazó kihasználatlan példány előzetes értesítést kap, a leszerelési folyamat megpróbálja áttelepíteni az shuffle- és RDD-adatokat az kifogástalan végrehajtókra. A végső előzés előtti időtartam általában 30 másodperc és 2 perc között van a felhőszolgáltatótól függően.

A Databricks azt javasolja, hogy engedélyezze az adatmigrálást, ha a leszerelés is engedélyezve van. A hibák lehetősége általában csökken, mivel több adat migrálása történik, beleértve a lekérési hibákat, az elegyítő adatvesztést és az RDD-adatvesztést. Az adatmigrálás alacsonyabb újraszámítást és megtakarított költségeket is eredményezhet.

Feljegyzés

A leszerelés a legjobb megoldás, és nem garantálja, hogy az összes adat migrálható a végső előkészület előtt. A leszerelés nem garantálható az shuffle-beolvasási hibák ellen, ha a futtatott feladatok az shuffle-adatokat lekérik a végrehajtótól.

Ha engedélyezve van a leszerelés, a rendszer nem adja hozzá a sikertelen kísérletek teljes számához a kihasználatlan példányok előzményei által okozott feladathibákat. A preemption által okozott feladathibák nem számítanak sikertelen kísérletnek, mert a hiba oka kívül esik a tevékenységen, és nem eredményez feladathibát.

Leszerelés engedélyezése

A számítás leszerelésének engedélyezéséhez írja be a következő tulajdonságokat a Spark lap Speciális beállítások csoportjába a számítási konfiguráció felhasználói felületén. Ezekről a tulajdonságokról további információt a Spark-konfigurációban talál.

Az alkalmazások leszerelésének engedélyezéséhez írja be ezt a tulajdonságot a Spark konfigurációs mezőjébe:

spark.decommission.enabled trueHa a leszerelés során engedélyezni szeretné az adatmigrálást, írja be ezt a tulajdonságot a Spark konfigurációs mezőjébe:

spark.storage.decommission.enabled true spark.storage.decommission.shuffleBlocks.enabled trueHa engedélyezni szeretné az RDD-gyorsítótár adatmigrálását a leszerelés során, írja be ezt a tulajdonságot a Spark konfigurációs mezőjébe:

spark.storage.decommission.enabled true spark.storage.decommission.rddBlocks.enabled trueFeljegyzés

Ha az RDD StorageLevel replikációja 1-nél többre van állítva, a Databricks nem javasolja az RDD-adatok áttelepítésének engedélyezését, mivel a replikák biztosítják, hogy az RDD-k ne veszítsék el az adatokat.

A dolgozók leszerelésének engedélyezéséhez írja be ezt a tulajdonságot a Környezeti változók mezőbe:

SPARK_WORKER_OPTS="-Dspark.decommission.enabled=true"

A leszerelési állapot és a veszteség okának megtekintése a felhasználói felületen

Ha egy feldolgozó leszerelési állapotát szeretné elérni a felhasználói felületen, lépjen a Spark számítási felhasználói felülete – Master lapra.

Ha a leszerelés befejeződött, a végrehajtó veszteségi okát a Számítási részletek lapon, a Spark felhasználói > felület végrehajtói lapján tekintheti meg.

Visszajelzés

Hamarosan elérhető: 2024-ben fokozatosan kivezetjük a GitHub-problémákat a tartalom visszajelzési mechanizmusaként, és lecseréljük egy új visszajelzési rendszerre. További információ: https://aka.ms/ContentUserFeedback.

Visszajelzés küldése és megtekintése a következőhöz: