Databricks Runtime 6.0 (nem támogatott)

A Databricks 2019 októberében adta ki ezt a képet.

Az alábbi kibocsátási megjegyzések az Apache Spark által üzemeltetett Databricks Runtime 6.0-ról nyújtanak információkat.

Új funkciók

Python-környezet

A Databricks Runtime 6.0 tartalmazza a Python és a Python-környezetek konfigurálásának főbb változásait, beleértve a Python 3.7.3-ra való frissítését, a telepített Python-csomagok listájának pontosítását és a telepített csomagok újabb verziókra való frissítését. További információ: Telepített Python-kódtárak.

Emellett, ahogy korábban bejelentették, a Databricks Runtime 6.0 nem támogatja a Python 2-t.

A főbb változások a következők:

- A Python 3.5.2-ről 3.7.3-ra frissült. Előfordulhat, hogy a Python-csomagok egyes régi verziói nem kompatibilisek a Python 3.7-es verziójával, mert a Cython régi verzióitól függenek, amelyek nem kompatibilisek a Python 3.7-es verziójával. Egy ilyen csomag telepítése hasonló

‘PyThreadState’ {‘struct _ts’} has no member named ‘exc_type’hibákat válthat ki (részletekért lásd a GitHub 1978-ra vonatkozó problémáját). Telepítse helyette a Python-csomagok Python 3.7-kompatibilis verzióit. - Főbb csomagfrissítések:

- boto3–1.9.162

- ipythonról 7.4.0-ra

- matplotlib–3.0.3

- numpy to 1.16.2

- pandas to 0.24.2

- pyarrow to 0.13.0

- A Databricks Runtime 5.5 LTS-sel (nem támogatott) összehasonlítva a következő Python-csomagok találhatók meg újonnan: asn1crypto, backcall, jedi, kiwisolver, parso és PySocks.

- A Databricks Runtime 5.5 LTS -hez (nem támogatott) képest a következő Python-csomagok nincsenek telepítve: ansi2html, brewer2mpl, colorama, configobj, enum34, et-xmlfile, freetype-py, funcsigs, fusepy, ggplot, html5lib, ipaddress, jdcal, Jinja2, llvmlite, lxml, Markup Széf, mpld3, msgpack-python, ndg-httpsclient, numba, openpyxl, pathlib2, Pillow, ply, pyasn1, pypng, python-geohash, scour, simplejson és singledispatch.

- A

displayPython ggplot-objektumok függvénye már nem támogatott, mert a ggplot-csomag nem kompatibilis a pandas újabb verziójával. /databricks/python2/bin/pythonA beállításPYSPARK_PYTHONnem támogatott, mert a Databricks Runtime 6.0 nem támogatja a Python 2-t. Az ilyen beállításokkal rendelkező fürtök továbbra is elindulhatnak. A Python-jegyzetfüzetek és a Python-parancsok azonban nem működnek, vagyis a Python-parancscellák "Megszakítva" hibával meghiúsulnak, ésPython shell failed to starthiba jelenik meg az illesztőprogram-naplókban.- Ha

PYSPARK_PYTHONa Virtualenv által felügyelt környezetben futtatható Python-futtathatóra mutat, a környezet init szkriptekhez és jegyzetfüzetekhez lesz aktiválva. Az aktivált környezetben definiált parancsokat éspipparancsokat közvetlenül anélkül használhatjapython, hogy meg kellene adnia ezeknek a parancsoknak az abszolút helyét. Alapértelmezés szerintPYSPARK_PYTHONa következőre/databricks/python3/bin/pythonvan állítva: . Így alapértelmezés szerintpythoninit szkriptekre éspipjegyzetfüzetekre mutat/databricks/python3/bin/pythonés mutat/databricks/python3/bin/pip. Ha olyanPYSPARK_PYTHONPython-végrehajthatóra mutat, amely nem a Virtualenv által felügyelt környezetben található, vagy init szkriptet ír a megadott PythonPYSPARK_PYTHONlétrehozásához, akkor abszolút elérési utakat kell használnia a helyes éspipa .pythonHa a Python-kódtár elkülönítése engedélyezve van (alapértelmezés szerint engedélyezve van), az aktivált környezet továbbra is az a környezet, amelyhezPYSPARK_PYTHONtársítva van. Javasoljuk, hogy a Python-jegyzetfüzethez társított izolált környezet módosításához használja a Library segédprogramot (dbutils.library) (örökölt).

Scala és Java API-k Delta Lake DML-parancsokhoz

Mostantól programozott API-k használatával módosíthatja a Delta-táblák adatait törlésre, frissítésre és egyesítésre. Ezek az API-k tükrözik a megfelelő SQL-parancsok szintaxisát és szemantikáját, és számos számítási feladathoz kiválóan használhatók, például lassan változó dimenziós (SCD- ) műveletekhez, a replikáció változásadatainak egyesítéséhez és a streamelési lekérdezések frissítéséhez.

További részletekért lásd : Mi az a Delta Lake?.

Scala és Java API-k a Delta Lake segédprogram parancsaihoz

A Databricks Runtime mostantól programozott API-kkal rendelkezik az és history a vacuum segédprogram-parancsokhoz. Ezek az API-k a Databricks Runtime korábbi verzióiban elérhető megfelelő SQL-parancsok szintaxisát és szemantikáját tükrözik.

A tábla futtatásával vacuum törölheti azokat a fájlokat, amelyekre már nem hivatkozik deltatábla, és amelyek régebbiek a megőrzési küszöbértéknél. A tábla parancsának vacuum futtatása rekurzívan vákuumozza a Delta táblához társított könyvtárakat. A fájlok alapértelmezett megőrzési küszöbértéke 7 nap. A megőrzési időnél régebbi verzióra való visszautazás lehetősége a futtatás vacuumután elveszik. A vacuum nincs automatikusan aktiválva.

A parancs futtatásával history lekérheti a műveletekkel, a felhasználóval, az időbélyegzővel stb. kapcsolatos információkat minden egyes íráshoz egy Delta-táblába. A rendszer fordított időrendi sorrendben adja vissza a műveleteket. Alapértelmezés szerint a táblaelőzmények 30 napig maradnak meg.

További részletekért lásd : Mi az a Delta Lake?.

Az Azure Lsv2-példányokhoz elérhető lemez gyorsítótárazása

[Lemez gyorsítótárazása]] (.. /.. A /optimizations/disk-cache.md) mostantól alapértelmezés szerint engedélyezve van az összes Lsv2-példány esetében.

Optimalizált tárolás helyi fájl API-k használatával

A helyi fájl API-k hasznosak, mivel lehetővé teszik a mögöttes elosztott objektumtárolóból származó fájlok helyi fájlként való elérését. A Databricks Runtime 6.0-ban bővítettük a FU Standard kiadás csatlakoztatást, amely lehetővé teszi a helyi fájl API-k számára a kulcskorlátozások kezelését. A Databricks Runtime 6.0 jelentősen javítja az olvasási és írási sebességet, és támogatja a 2 GB-nál nagyobb fájlokat. Ha gyorsabb és megbízhatóbb olvasási és írási műveletekre van szüksége, például az elosztott modell betanításához, ez a fejlesztés különösen hasznosnak bizonyulhat. Emellett nem kell adatokat betöltenie egy helyi tárolóba a számítási feladatokhoz, ami költségmegtakarítást és a termelékenység növelését is lehetővé teszi.

További részletekért lásd : Mi az a Databricks fájlrendszer (DBFS)?.

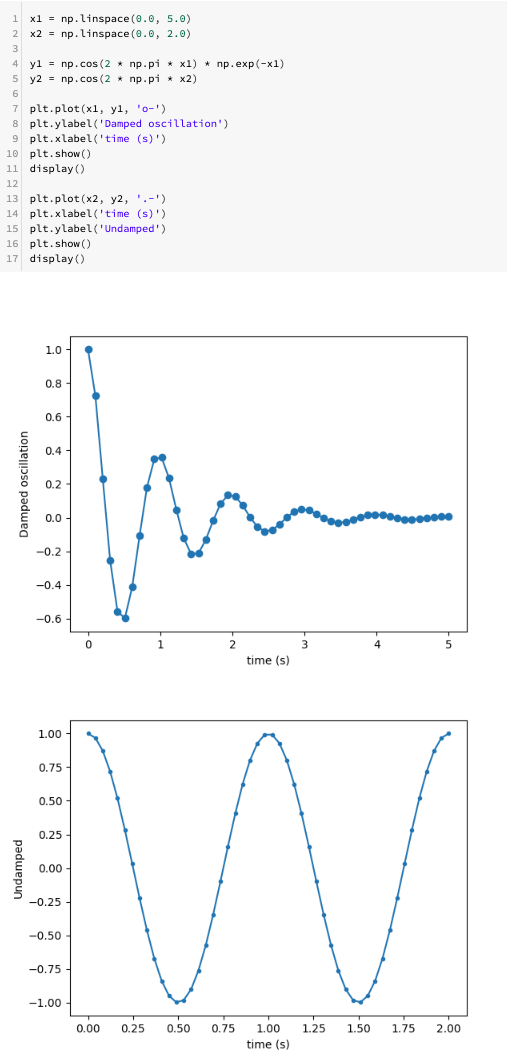

Több matplotlib-diagram jegyzetfüzetcellánként

Mostantól jegyzetfüzetcellánként több matplotlib-diagramot is megjeleníthet:

Szolgáltatás hitelesítő adatai több Azure Data Lake Storage Gen1-fiókhoz

Most már beállíthatja a szolgáltatás hitelesítő adatait az Azure Databricks-fiókokból több Azure Data Lake Storage Gen1-hez való hozzáféréshez egyetlen Apache Spark-munkamenetben való használatra. Ehhez adja hozzá account.<account-name> a konfigurációs kulcsokat. Ha például hitelesítő adatokat szeretne beállítani a fiókokhoz mind a kettő adl://example1.azuredatalakestore.netadl://example2.azuredatalakestore.neteléréséhez, ezt a következőképpen teheti meg:

spark.conf.set("fs.adl.oauth2.access.token.provider.type", "ClientCredential")

spark.conf.set("fs.adl.account.example1.oauth2.client.id", "<application-id-example1>")

spark.conf.set("fs.adl.account.example1.oauth2.credential", dbutils.secrets.get(scope = "<scope-name>", key = "<key-name-for-service-credential-example1>"))

spark.conf.set("fs.adl.account.example1.oauth2.refresh.url", "https://login.microsoftonline.com/<directory-id-example1>/oauth2/token")

spark.conf.set("fs.adl.account.example2.oauth2.client.id", "<application-id-example2>")

spark.conf.set("fs.adl.account.example2.oauth2.credential", dbutils.secrets.get(scope = "<scope-name>", key = "<key-name-for-service-credential-example2>"))

spark.conf.set("fs.adl.account.example2.oauth2.refresh.url", "https://login.microsoftonline.com/<directory-id-example2>/oauth2/token")

Fejlesztések

- Az AWS SDK 1.11.596-ra frissült.

- Frissítette az Azure Storage SDK-t a WASB-illesztőben 7.0-ra.

OPTIMIZEMost olyan metrikák összegzését adja meg, mint a hozzáadott fájlok száma, az eltávolított fájlok száma, valamint a fájlok maximális és minimális mérete. Lásd: Adatfájlok tömörítése optimalizálással a Delta Lake-en.

Eltávolítása

A Databricks ML-modell exportálása el lesz távolítva. Ehelyett használja az MLeap-t modellek importálásához és exportálásához.

Apache Spark

Feljegyzés

Ez a cikk a rabszolga kifejezésre hivatkozik, amely az Azure Databricks által nem használt kifejezés. Ha a kifejezés el lesz távolítva a szoftverből, a cikkből is eltávolítjuk.

A Databricks Runtime 6.0 tartalmazza az Apache Spark 2.4.3-at. Ez a kiadás tartalmazza a Databricks Runtime 5.5 LTS (nem támogatott) összes Spark-javítását és fejlesztését, valamint a Spark következő további hibajavításait és fejlesztéseit:

- [SPARK-27992][SPARK-28881][PYTHON] A Python csatlakozásának engedélyezése kapcsolati szállal a hibák propagálásához

- [SPARK-27330][SS]support task abort in foreach writer (6.0, 5.x)

- [SPARK-28642][SQL] Hitelesítő adatok elrejtése a CREATE TABLE megjelenítése alkalmazásban

- [SPARK-28699][CORE] A határozatlan fázis megszakításához használt sarokeset javítása

- [SPARK-28647][WEBUI] További metrikafunkció helyreállítása

- [SPARK-28766][R] [DOC] CrAN bejövő megvalósíthatósági figyelmeztetés javítása érvénytelen URL-címen

- [SPARK-28486][CORE] [PYTHON] A PythonBroadcast adatfájljának leképezése BroadcastBlock-ra a GC általi törlés elkerülése érdekében

- [SPARK-25035][CORE] Memórialeképezés elkerülése a lemezen tárolt blokkok replikációjakor

- [SPARK-27234][SS] [PYTHON] Az InheritableThreadLocal használata az EpochTracker aktuális korszakához (a Python UDF-ek támogatásához)

- [SPARK-28638][WEBUI] A tevékenység összegzése csak a sikeres tevékenységek metrikáit tartalmazza

- [SPARK-28153][PYTHON] Az AtomicReference használata az InputFileBlockHolderben (a Python UDF input_file_name támogatásához)

- [SPARK-28564][CORE] Az Access-előzményalkalmazás alapértelmezés szerint az utolsó kísérletazonosítóra van bekapcsolva

- [SPARK-28260] A fürt automatikusan leállhat, miközben a thriftserver-lekérdezés még mindig lekéri az eredményeket

- [SPARK-26152][CORE] Feldolgozói karbantartás szinkronizálása a feldolgozó leállításával

- [SPARK-28545][SQL] Adja hozzá a kivonattérkép méretét az ObjectAggregationIterator iránynaplójához

- [SPARK-28489][SS] Kijavítottuk azt a hibát, amely miatt a KafkaOffsetRangeCalculator.getRanges elvetheti az eltolódásokat

- [SPARK-28421][ML] SparseVector.apply performance optimization

- [SPARK-28156][SQL] Az öncsatlakozás nem hagyható ki a gyorsítótárazott nézetből

- [SPARK-28152][SQL] ShortType leképezése SMALLINT-re és FloatType-ra VALÓS értékre msSqlServerDialect esetén

- [SPARK-28054][SQL] Hiba kijavítása a Hive particionált tábla dinamikus beszúrásakor, ahol a partíció neve nagybetűs

- [SPARK-27159][SQL] frissítse az mssql-kiszolgáló dialektusát a bináris típus támogatásához

- [SPARK-28355][CORE] [PYTHON] A Spark conf használata a küszöbértékhez, ahol a com...

- [SPARK-27989][CORE] Újrapróbálkozások a k8s illesztőprogramhoz való csatlakozáshoz

- [SPARK-27416][SQL] UnsafeMapData & UnsafeArrayData Kryo szerializálás ...

- [SPARK-28430][Felhasználói felület] Szakasztábla-renderelés javítása, ha egyes tevékenységek metrikái hiányoznak

- [SPARK-27485] A EnsureRequirements.reordernek elegánsan kell kezelnie az ismétlődő kifejezéseket

- [SPARK-28404][SS] Negatív időtúllépési érték javítása a RateStreamContinuousPartitionReaderben

- [SPARK-28378][PYTHON] A cgi.escape használatának eltávolítása

- [SPARK-28371][SQL] Parquet "StartsWith" szűrő null-biztonságossá tétele

- [SPARK-28015][SQL] Ellenőrizze, hogy a stringToDate() az yyyy és az y-[m]m formátumok teljes bemenetét használja-e

- [SPARK-28302][CORE] Győződjön meg arról, hogy egyedi kimeneti fájlt hoz létre a SparkLauncherhez Windows rendszeren

- [SPARK-28308][CORE] A CalendarInterval sub-second részt az elemzés előtt ki kell párnázni

- [SPARK-28170][ML] [PYTHON] Egységes vektorok és mátrix dokumentációja

- [SPARK-28160][CORE] Kijavítottuk azt a hibát, amely miatt a visszahívási függvény lefagyhat, ha a nem ellenőrzött kivétel kimaradt

- [SPARK-27839][SQL] Az UTF8String.replace() módosítása UTF8 bájton való működéshez

- [SPARK-28157][CORE] Az SHS törlése a KVStore LogInfo-ból a feketelistán szereplő bejegyzések esetében

- [SPARK-28128][PYTHON] [SQL] pandas Csoportosított UDF-ek kihagyják az üres partíciókat

- [SPARK-28012][SQL] A Hive UDF támogatja a strukturált típusú összecsukható kifejezést

- [SPARK-28164] A start-slave.sh használati leírásának javítása

- [SPARK-27100][SQL] A StackOverflowError megelőzéséhez használja a Tömböt a FilePartitionBan a Seq helyett

- [SPARK-28154][ML] GMM– dupla gyorsítótárazás javítása

Karbantartási frissítések

Lásd a Databricks Runtime 6.0 karbantartási frissítéseit.

Rendszerkörnyezet

- Operációs rendszer: Ubuntu 16.04.6 LTS

- Java: 1.8.0_232

- Scala: 2.11.12

- Python: 3.7.3

- R: R 3.6.1-es verzió (2019-07-05)

- Delta Lake: 0.3.0

Feljegyzés

Bár a Scala 2.12 kísérleti funkcióként érhető el az Apache Spark 2.4-ben, a Databricks Runtime 6.0 nem támogatja.

Telepített Python-kódtárak

| Könyvtár | Verzió | Könyvtár | Verzió | Könyvtár | Verzió |

|---|---|---|---|---|---|

| asn1crypto | 0.24.0 | backcall | 0.1.0 | boto | 2.49.0 |

| boto3 | 1.9.162 | botocore | 1.12.163 | minősítés | 2019.3.9 |

| cffi | 1.12.2 | karakterkészlet | 3.0.4 | Titkosítás | 2.6.1 |

| cycler | 0.10.0 | Cython | 0.29.6 | Dekoratőr | 4.4.0 |

| docutils | 0,14 | idna | 2.8 | ipython | 7.4.0 |

| ipython-genutils | 0.2.0 | Jedi | 0.13.3 | jmespath | 0.9.4 |

| kiwisolver | 1.1.0 | matplotlib | 3.0.3 | numpy | 1.16.2 |

| pandas | 0.24.2 | parso | 0.3.4 | Patsy | 0.5.1 |

| pexpect | 4.6.0 | pickleshare | 0.7.5 | Pip | 19.0.3 |

| prompt-toolkit | 2.0.9 | psycopg2 | 2.7.6.1 | ptyprocess | 0.6.0 |

| pyarrow | 0.13.0 | pycparser | 2.19 | pycurl | 7.43.0 |

| Pygments | 2.3.1 | PyGObject | 3.20.0 | pyOpenSSL | 19.0.0 |

| pyparsing | 2.4.2 | PySocks | 1.6.8 | python-apt | 1.1.0.b1+ubuntu0.16.04.5 |

| python-dateutil | 2.8.0 | pytz | 2018.9 | kérelmek | 2.21.0 |

| s3transfer | 0.2.1 | scikit-learn | 0.20.3 | scipy | 1.2.1 |

| tengeri | 0.9.0 | setuptools | 40.8.0 | Hat | 1.12.0 |

| ssh-import-id | 5,5 | statsmodels | 0.9.0 | árulók | 4.3.2 |

| felügyelet nélküli frissítések | 0,1 | urllib3 | 1.24.1 | virtualenv | 16.4.1 |

| wcwidth | 0.1.7 | Kerék | 0.33.1 |

Telepített R-kódtárak

| Könyvtár | Verzió | Könyvtár | Verzió | Könyvtár | Verzió |

|---|---|---|---|---|---|

| abind | 1.4-5 | askpass | 1,1 | assertthat | 0.2.1 |

| Backports | 1.1.3 | alap | 3.6.1 | base64enc | 0.1-3 |

| BH | 1.69.0-1 | Kicsit | 1.1-14 | bit64 | 0.9-7 |

| bitops | 1.0-6 | blob | 1.1.1 | indítás | 1.3-23 |

| Sört | 1.0-6 | hívó | 3.2.0 | autó | 3.0-2 |

| carData | 3.0-2 | Billentyűzettel | 6.0-82 | cellranger | 1.1.0 |

| chron | 2.3-53 | osztály | 7.3-15 | Cli | 1.1.0 |

| clipr | 0.5.0 | clisymbols | 1.2.0 | Fürt | 2.1.0 |

| kódtoolok | 0.2-16 | színtér | 1.4-1 | commonmark | 1,7 |

| Fordító | 3.6.1 | config | 0.3 | Zsírkréta | 1.3.4 |

| Curl | 3.3 | data.table | 1.12.0 | adatkészletek | 3.6.1 |

| DBI | 1.0.0 | dbplyr | 1.3.0 | Desc | 1.2.0 |

| devtools | 2.0.1 | Digest | 0.6.18 | doMC | 1.3.5 |

| dplyr | 0.8.0.1 | három pont | 0.1.0 | fani | 0.4.0 |

| forcats | 0.4.0 | foreach | 1.4.4 | Külföldi | 0.8-72 |

| Forge | 0.2.0 | Fs | 1.2.7 | gbm | 2.1.5 |

| Generikus | 0.0.2 | ggplot2 | 3.1.0 | Gh | 1.0.1 |

| git2r | 0.25.2 | glmnet | 2.0-16 | Ragasztó | 1.3.1 |

| Gower | 0.2.0 | grafika | 3.6.1 | grDevices | 3.6.1 |

| Rács | 3.6.1 | gridExtra | 2.3 | gsubfn | 0,7 |

| gtable | 0.3.0 | H2o | 3.22.1.1 | Haven | 2.1.0 |

| Hms | 0.4.2 | htmltoolok | 0.3.6 | htmlwidgets | 1.3 |

| httr | 1.4.0 | hwriter | 1.3.2 | hwriterPlus | 1.0-3 |

| Ini | 0.3.1 | ipred | 0.9-8 | iterátorok | 1.0.10 |

| jsonlite | 1.6 | KernSmooth | 2.23-15 | Címkézés | 0.3 |

| Rács | 0.20-38 | Láva | 1.6.5 | lazyeval | 0.2.2 |

| kicsi | 0.3.7 | lme4 | 1.1-21 | lubridate | 1.7.4 |

| magrittr | 1,5 | mapproj | 1.2.6 | Térképek | 3.3.0 |

| maptools | 0.9-5 | MASS | 7.3-51.4 | Mátrix | 1.2-17 |

| MatrixModels | 0.4-1 | memoise | 1.1.0 | metódusok | 3.6.1 |

| mgcv | 1.8-28 | Mime | 0,6 | minqa | 1.2.4 |

| ModelMetrics | 1.2.2 | munsell | 0.5.0 | mvtnorm | 1.0-10 |

| nlme | 3.1-141 | nloptr | 1.2.1 | nnet | 7.3-12 |

| numDeriv | 2016.8-1 | Openssl | 1.3 | openxlsx | 4.1.0 |

| parallel | 3.6.1 | pbkrtest | 0.4-7 | Pillér | 1.3.1 |

| pkgbuild | 1.0.3 | pkgconfig | 2.0.2 | pkgKitten | 0.1.4 |

| pkgload | 1.0.2 | plogr | 0.2.0 | rétegelt | 1.8.4 |

| Dicséret | 1.0.0 | prettyunits | 1.0.2 | Proc | 1.14.0 |

| processx | 3.3.0 | prodlim | 2018.04.18 | Haladás | 1.2.0 |

| Proto | 1.0.0 | Ps | 1.3.0 | purrr | 0.3.2 |

| quantreg | 5.38 | R.methodsS3 | 1.7.1 | R.oo | 1.22.0 |

| R.utils | 2.8.0 | r2d3 | 0.2.3 | R6 | 2.4.0 |

| randomForest | 4.6-14 | rappdirs | 0.3.1 | rcmdcheck | 1.3.2 |

| RColorBrewer | 1.1-2 | Rcpp | 1.0.1 | RcppEigen | 0.3.3.5.0 |

| RcppRoll | 0.3.0 | RCurl | 1.95-4.12 | olvasó | 1.3.1 |

| readxl | 1.3.1 | receptek | 0.1.5 | Visszavágót | 1.0.1 |

| Távirányító | 2.0.2 | újraformázás2 | 1.4.3 | Rio | 0.5.16 |

| rlang | 0.3.3 | RODBC | 1.3-15 | roxygen2 | 6.1.1 |

| rpart | 4.1-15 | rprojroot | 1.3-2 | Rserve | 1.8-6 |

| RSQLite | 2.1.1 | rstudioapi | 0.10 | Mérlegek | 1.0.0 |

| sessioninfo | 1.1.1 | Sp | 1.3-1 | sparklyr | 1.0.0 |

| SparkR | 2.4.4 | SparseM | 1.77 | Térbeli | 7.3-11 |

| splines | 3.6.1 | sqldf | 0.4-11 | NÉGYZET | 2017.10-1 |

| statmod | 1.4.30 | Statisztika | 3.6.1 | statisztikák4 | 3.6.1 |

| stringi | 1.4.3 | sztring | 1.4.0 | Túlélési | 2.44-1.1 |

| sys | 3.1 | tcltk | 3.6.1 | TeachingDemos | 2.10 |

| testthat | 2.0.1 | tibble | 2.1.1 | tidyr | 0.8.3 |

| tidyselect | 0.2.5 | timeDate | 3043.102 | eszközök | 3.6.1 |

| usethis | 1.4.0 | utf8 | 1.1.4 | eszközök | 3.6.1 |

| viridisLite | 0.3.0 | bajusz | 0.3-2 | withr | 2.1.2 |

| xml2 | 1.2.0 | xopen | 1.0.0 | Yaml | 2.2.0 |

| Zip | 2.0.1 |

Telepített Java- és Scala-kódtárak (Scala 2.11-fürtverzió)

| Csoportazonosító | Összetevő azonosítója | Verzió |

|---|---|---|

| antlr | antlr | 2.7.7 |

| com.amazonaws | amazon-kinesis-client | 1.8.10 |

| com.amazonaws | aws-java-sdk-autoscaling | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudformation | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudfront | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudhsm | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudsearch | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudtrail | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudwatch | 1.11.595 |

| com.amazonaws | aws-java-sdk-cloudwatchmetrics | 1.11.595 |

| com.amazonaws | aws-java-sdk-codedeploy | 1.11.595 |

| com.amazonaws | aws-java-sdk-cognitoidentity | 1.11.595 |

| com.amazonaws | aws-java-sdk-cognitosync | 1.11.595 |

| com.amazonaws | aws-java-sdk-config | 1.11.595 |

| com.amazonaws | aws-java-sdk-core | 1.11.595 |

| com.amazonaws | aws-java-sdk-datapipeline | 1.11.595 |

| com.amazonaws | aws-java-sdk-directconnect | 1.11.595 |

| com.amazonaws | aws-java-sdk-directory | 1.11.595 |

| com.amazonaws | aws-java-sdk-dynamodb | 1.11.595 |

| com.amazonaws | aws-java-sdk-ec2 | 1.11.595 |

| com.amazonaws | aws-java-sdk-ecs | 1.11.595 |

| com.amazonaws | aws-java-sdk-efs | 1.11.595 |

| com.amazonaws | aws-java-sdk-elasticache | 1.11.595 |

| com.amazonaws | aws-java-sdk-elasticbeanstalk | 1.11.595 |

| com.amazonaws | aws-java-sdk-elasticloadbalancing | 1.11.595 |

| com.amazonaws | aws-java-sdk-elastictranscoder | 1.11.595 |

| com.amazonaws | aws-java-sdk-emr | 1.11.595 |

| com.amazonaws | aws-java-sdk-glacier | 1.11.595 |

| com.amazonaws | aws-java-sdk-glue | 1.11.595 |

| com.amazonaws | aws-java-sdk-iam | 1.11.595 |

| com.amazonaws | aws-java-sdk-importexport | 1.11.595 |

| com.amazonaws | aws-java-sdk-kinesis | 1.11.595 |

| com.amazonaws | aws-java-sdk-kms | 1.11.595 |

| com.amazonaws | aws-java-sdk-lambda | 1.11.595 |

| com.amazonaws | aws-java-sdk-logs | 1.11.595 |

| com.amazonaws | aws-java-sdk-machinelearning | 1.11.595 |

| com.amazonaws | aws-java-sdk-opsworks | 1.11.595 |

| com.amazonaws | aws-java-sdk-rds | 1.11.595 |

| com.amazonaws | aws-java-sdk-redshift | 1.11.595 |

| com.amazonaws | aws-java-sdk-route53 | 1.11.595 |

| com.amazonaws | aws-java-sdk-s3 | 1.11.595 |

| com.amazonaws | aws-java-sdk-ses | 1.11.595 |

| com.amazonaws | aws-java-sdk-simpledb | 1.11.595 |

| com.amazonaws | aws-java-sdk-simpleworkflow | 1.11.595 |

| com.amazonaws | aws-java-sdk-sns | 1.11.595 |

| com.amazonaws | aws-java-sdk-sqs | 1.11.595 |

| com.amazonaws | aws-java-sdk-ssm | 1.11.595 |

| com.amazonaws | aws-java-sdk-storagegateway | 1.11.595 |

| com.amazonaws | aws-java-sdk-sts | 1.11.595 |

| com.amazonaws | aws-java-sdk-support | 1.11.595 |

| com.amazonaws | aws-java-sdk-swf-libraries | 1.11.22 |

| com.amazonaws | aws-java-sdk-workspaces | 1.11.595 |

| com.amazonaws | jmespath-java | 1.11.595 |

| com.carrotsearch | hppc | 0.7.2 |

| com.chuusai | shapeless_2.11 | 2.3.2 |

| com.clearspring.analytics | Patak | 2.7.0 |

| com.databricks | Rserve | 1.8-3 |

| com.databricks | dbml-local_2.11 | 0.5.0-db8-spark2.4 |

| com.databricks | dbml-local_2.11-tesztek | 0.5.0-db8-spark2.4 |

| com.databricks | jets3t | 0.7.1-0 |

| com.databricks.scalapb | compilerplugin_2.11 | 0.4.15-9 |

| com.databricks.scalapb | scalapb-runtime_2.11 | 0.4.15-9 |

| com.esotericsoftware | kryo-shaded | 4.0.2 |

| com.esotericsoftware | minlog | 1.3.0 |

| com.fasterxml | Osztálytárs | 1.0.0 |

| com.fasterxml.jackson.core | jackson-annotations | 2.6.7 |

| com.fasterxml.jackson.core | jackson-core | 2.6.7 |

| com.fasterxml.jackson.core | jackson-databind | 2.6.7.1 |

| com.fasterxml.jackson.dataformat | jackson-dataformat-cbor | 2.6.7 |

| com.fasterxml.jackson.datatype | jackson-datatype-joda | 2.6.7 |

| com.fasterxml.jackson.module | jackson-module-paranamer | 2.6.7 |

| com.fasterxml.jackson.module | jackson-module-scala_2.11 | 2.6.7.1 |

| com.github.fommil | jniloader | 1,1 |

| com.github.fommil.netlib | core | 1.1.2 |

| com.github.fommil.netlib | native_ref-java | 1,1 |

| com.github.fommil.netlib | native_ref-java-natívok | 1,1 |

| com.github.fommil.netlib | native_system-java | 1,1 |

| com.github.fommil.netlib | native_system-java-natívok | 1,1 |

| com.github.fommil.netlib | netlib-native_ref-linux-x86_64-natives | 1,1 |

| com.github.fommil.netlib | netlib-native_system-linux-x86_64-natives | 1,1 |

| com.github.luben | zstd-jni | 1.3.2-2 |

| com.github.rwl | jtransforms | 2.4.0 |

| com.google.code.findbugs | jsr305 | 2.0.1 |

| com.google.code.gson | gson | 2.2.4 |

| com.google.guava | Guava | 15,0 |

| com.google.protobuf | protobuf-java | 2.6.1 |

| com.googlecode.javaewah | JavaEWAH | 0.3.2 |

| com.h2database | h2 | 1.3.174 |

| com.jcraft | jsch | 0.1.50 |

| com.jolbox | bonecp | 0.8.0.RELEA Standard kiadás |

| com.microsoft.azure | azure-data-lake-store-sdk | 2.2.8 |

| com.microsoft.azure | azure-storage | 7.0.0 |

| com.microsoft.sqlserver | mssql-jdbc | 6.2.2.jre8 |

| com.ning | compress-lzf | 1.0.3 |

| com.sun.mail | javax.mail | 1.5.2 |

| com.thoughtworks.paranamer | paranamer | 2.8 |

| com.trueaccord.lenses | lenses_2.11 | 0.3 |

| com.twitter | chill-java | 0.9.3 |

| com.twitter | chill_2.11 | 0.9.3 |

| com.twitter | parquet-hadoop-bundle | 1.6.0 |

| com.twitter | util-app_2.11 | 6.23.0 |

| com.twitter | util-core_2.11 | 6.23.0 |

| com.twitter | util-jvm_2.11 | 6.23.0 |

| com.typesafe | config | 1.2.1 |

| com.typesafe.scala-logging | scala-logging-api_2.11 | 2.1.2 |

| com.typesafe.scala-logging | scala-logging-slf4j_2.11 | 2.1.2 |

| com.univocity | univocity-parsers | 2.7.3 |

| com.vlkan | flatbuffers | 1.2.0-3f79e055 |

| com.zaxxer | HikariCP | 3.1.0 |

| commons-beanutils | commons-beanutils | 1.9.3 |

| commons-cli | commons-cli | 1,2 |

| commons-codec | commons-codec | 1.10 |

| commons-collections | commons-collections | 3.2.2 |

| commons-configuration | commons-configuration | 1.6 |

| commons-dbcp | commons-dbcp | 1.4 |

| commons-digester | commons-digester | 1.8 |

| commons-httpclient | commons-httpclient | 3.1 |

| commons-io | commons-io | 2,4 |

| commons-lang | commons-lang | 2.6 |

| commons-naplózás | commons-naplózás | 1.1.3 |

| commons-net | commons-net | 3.1 |

| commons-pool | commons-pool | 1.5.4 |

| info.ganglia.gmetric4j | gmetric4j | 1.0.7 |

| io.airlift | aircompressor | 0.10 |

| io.dropwizard.metrics | metrikamag | 3.1.5 |

| io.dropwizard.metrics | metrics-ganglia | 3.1.5 |

| io.dropwizard.metrics | metrics-graphite | 3.1.5 |

| io.dropwizard.metrics | metrics-healthchecks | 3.1.5 |

| io.dropwizard.metrics | metrics-jetty9 | 3.1.5 |

| io.dropwizard.metrics | metrics-json | 3.1.5 |

| io.dropwizard.metrics | metrics-jvm | 3.1.5 |

| io.dropwizard.metrics | metrics-log4j | 3.1.5 |

| io.dropwizard.metrics | metrics-servlets | 3.1.5 |

| io.netty | netty | 3.9.9.Final |

| io.netty | netty-all | 4.1.17.Final |

| javax.activation | aktiválás | 1.1.1 |

| javax.annotation | javax.annotation-api | 1,2 |

| javax.el | javax.el-api | 2.2.4 |

| javax.jdo | jdo-api | 3.0.1 |

| javax.servlet | javax.servlet-api | 3.1.0 |

| javax.servlet.jsp | jsp-api | 2.1 |

| javax.transaction | jta | 1,1 |

| javax.validation | validation-api | 1.1.0.Final |

| javax.ws.rs | javax.ws.rs-api | 2.0.1 |

| javax.xml.bind | jaxb-api | 2.2.2 |

| javax.xml.stream | stax-api | 1.0-2 |

| javolution | javolution | 5.5.1 |

| jline | jline | 2.14.6 |

| joda-time | joda-time | 2.9.3 |

| Junit | Junit | 4.12 |

| log4j | apache-log4j-extras | 1.2.17 |

| log4j | log4j | 1.2.17 |

| net.hydromatic | eigenbase-properties | 1.1.5 |

| net.razorvine | pyrolite | 4.13 |

| net.sf.jpam | jpam | 1,1 |

| net.sf.opencsv | opencsv | 2.3 |

| net.sf.supercsv | super-csv | 2.2.0 |

| net.snowflake | snowflake-ingest-sdk | 0.9.5 |

| net.snowflake | snowflake-jdbc | 3.6.15 |

| net.snowflake | spark-snowflake_2.11 | 2.4.10-spark_2.4 |

| net.sourceforge.f2j | arpack_combined_all | 0,1 |

| org.acplt | oncrpc | 1.0.7 |

| org.antlr | ST4 | 4.0.4 |

| org.antlr | antlr-runtime | 3.4 |

| org.antlr | antlr4-runtime | 4.7 |

| org.antlr | stringtemplate | 3.2.1 |

| org.apache.ant | ant | 1.9.2 |

| org.apache.ant | ant-jsch | 1.9.2 |

| org.apache.ant | ant-launcher | 1.9.2 |

| org.apache.arrow | nyílformátum | 0.10.0 |

| org.apache.arrow | nyíl-memória | 0.10.0 |

| org.apache.arrow | nyíl-vektor | 0.10.0 |

| org.apache.avro | avro | 1.8.2 |

| org.apache.avro | avro-ipc | 1.8.2 |

| org.apache.avro | avro-mapred-hadoop2 | 1.8.2 |

| org.apache.calcite | kalcit-avatica | 1.2.0-inkubálás |

| org.apache.calcite | kalcitmag | 1.2.0-inkubálás |

| org.apache.calcite | calcite-linq4j | 1.2.0-inkubálás |

| org.apache.commons | commons-compress | 1.8.1 |

| org.apache.commons | commons-crypto | 1.0.0 |

| org.apache.commons | commons-lang3 | 3,5 |

| org.apache.commons | commons-math3 | 3.4.1 |

| org.apache.curator | kurátor-ügyfél | 2.7.1 |

| org.apache.curator | kurátor-keretrendszer | 2.7.1 |

| org.apache.curator | kurátor-receptek | 2.7.1 |

| org.apache.derby | Derby | 10.12.1.1 |

| org.apache.directory.api | api-asn1-api | 1.0.0-M20 |

| org.apache.directory.api | api-util | 1.0.0-M20 |

| org.apache.directory.server | apacheds-i18n | 2.0.0-M15 |

| org.apache.directory.server | apacheds-kerberos-codec | 2.0.0-M15 |

| org.apache.hadoop | hadoop-annotations | 2.7.3 |

| org.apache.hadoop | hadoop-auth | 2.7.3 |

| org.apache.hadoop | hadoop-client | 2.7.3 |

| org.apache.hadoop | hadoop-common | 2.7.3 |

| org.apache.hadoop | hadoop-hdfs | 2.7.3 |

| org.apache.hadoop | hadoop-mapreduce-client-app | 2.7.3 |

| org.apache.hadoop | hadoop-mapreduce-client-common | 2.7.3 |

| org.apache.hadoop | hadoop-mapreduce-client-core | 2.7.3 |

| org.apache.hadoop | hadoop-mapreduce-client-jobclient | 2.7.3 |

| org.apache.hadoop | hadoop-mapreduce-client-shuffle | 2.7.3 |

| org.apache.hadoop | hadoop-yarn-api | 2.7.3 |

| org.apache.hadoop | hadoop-yarn-client | 2.7.3 |

| org.apache.hadoop | hadoop-yarn-common | 2.7.3 |

| org.apache.hadoop | hadoop-yarn-server-common | 2.7.3 |

| org.apache.htrace | htrace-core | 3.1.0-inkubálás |

| org.apache.httpcomponents | httpclient | 4.5.6 |

| org.apache.httpcomponents | httpcore | 4.4.10 |

| org.apache.ivy | Ivy | 2.4.0 |

| org.apache.orc | orc-core-nohive | 1.5.5 |

| org.apache.orc | orc-mapreduce-nohive | 1.5.5 |

| org.apache.orc | orc-shims | 1.5.5 |

| org.apache.parquet | parquet-column | 1.10.1.2-databricks3 |

| org.apache.parquet | parquet-common | 1.10.1.2-databricks3 |

| org.apache.parquet | parquet-kódolás | 1.10.1.2-databricks3 |

| org.apache.parquet | parquet-format | 2.4.0 |

| org.apache.parquet | parquet-hadoop | 1.10.1.2-databricks3 |

| org.apache.parquet | parquet-jackson | 1.10.1.2-databricks3 |

| org.apache.thrift | libfb303 | 0.9.3 |

| org.apache.thrift | libthrift | 0.9.3 |

| org.apache.xbean | xbean-asm6-shaded | 4.8 |

| org.apache.zookeeper | zookeeper | 3.4.6 |

| org.codehaus.jackson | jackson-core-asl | 1.9.13 |

| org.codehaus.jackson | jackson-jaxrs | 1.9.13 |

| org.codehaus.jackson | jackson-mapper-asl | 1.9.13 |

| org.codehaus.jackson | jackson-xc | 1.9.13 |

| org.codehaus.janino | commons-compiler | 3.0.10 |

| org.codehaus.janino | janino | 3.0.10 |

| org.datanucleus | datanucleus-api-jdo | 3.2.6 |

| org.datanucleus | datanucleus-core | 3.2.10 |

| org.datanucleus | datanucleus-rdbms | 3.2.9 |

| org.eclipse.jetty | jetty-client | 9.3.27.v20190418 |

| org.eclipse.jetty | móló-folytatás | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-http | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-io | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-jndi | 9.3.27.v20190418 |

| org.eclipse.jetty | móló plusz | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-proxy | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-security | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-server | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-servlet | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-servlets | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-util | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-webapp | 9.3.27.v20190418 |

| org.eclipse.jetty | jetty-xml | 9.3.27.v20190418 |

| org.fusesource.leveldbjni | leveldbjni-all | 1.8 |

| org.glassfish.hk2 | hk2-api | 2.4.0-b34 |

| org.glassfish.hk2 | hk2-lokátor | 2.4.0-b34 |

| org.glassfish.hk2 | hk2-utils | 2.4.0-b34 |

| org.glassfish.hk2 | osgi-resource-locator | 1.0.1 |

| org.glassfish.hk2.external | aopalliance-repackaged | 2.4.0-b34 |

| org.glassfish.hk2.external | javax.inject | 2.4.0-b34 |

| org.glassfish.jersey.bundles.repackaged | jersey-guava | 2.22.2 |

| org.glassfish.jersey.containers | jersey-container-servlet | 2.22.2 |

| org.glassfish.jersey.containers | jersey-container-servlet-core | 2.22.2 |

| org.glassfish.jersey.core | jersey-client | 2.22.2 |

| org.glassfish.jersey.core | jersey-common | 2.22.2 |

| org.glassfish.jersey.core | jersey-server | 2.22.2 |

| org.glassfish.jersey.media | jersey-media-jaxb | 2.22.2 |

| org.hamcrest | hamcrest-core | 1.3 |

| org.hamcrest | hamcrest-library | 1.3 |

| org.hibernate | hibernate-validator | 5.1.1.Végleges |

| org.iq80.snappy | Snappy | 0,2 |

| org.javassist | javassist | 3.18.1-GA |

| org.jboss.logging | jboss-logging | 3.1.3.GA |

| org.jdbi | jdbi | 2.63.1 |

| org.joda | joda-convert | 1,7 |

| org.jodd | jodd-core | 3.5.2 |

| org.json4s | json4s-ast_2.11 | 3.5.3 |

| org.json4s | json4s-core_2.11 | 3.5.3 |

| org.json4s | json4s-jackson_2.11 | 3.5.3 |

| org.json4s | json4s-scalap_2.11 | 3.5.3 |

| org.lz4 | lz4-java | 1.4.0 |

| org.mariadb.jdbc | mariadb-java-client | 2.1.2 |

| org.mockito | mockito-core | 1.10.19 |

| org.objenesis | objenesis | 2.5.1 |

| org.postgresql | postgresql | 42.1.4 |

| org.roaringbitmap | RoaringBitmap | 0.7.45 |

| org.roaringbitmap | Alátéteket | 0.7.45 |

| org.rocksdb | rocksdbjni | 6.2.2 |

| org.rosuda.REngine | REngine | 2.1.0 |

| org.scala-lang | scala-compiler_2.11 | 2.11.12 |

| org.scala-lang | scala-library_2.11 | 2.11.12 |

| org.scala-lang | scala-reflect_2.11 | 2.11.12 |

| org.scala-lang.modules | scala-parser-combinators_2.11 | 1.1.0 |

| org.scala-lang.modules | scala-xml_2.11 | 1.0.5 |

| org.scala-sbt | teszt-interfész | 1,0 |

| org.scalacheck | scalacheck_2.11 | 1.12.5 |

| org.scalactic | scalactic_2.11 | 3.0.3 |

| org.scalanlp | breeze-macros_2.11 | 0.13.2 |

| org.scalanlp | breeze_2.11 | 0.13.2 |

| org.scalatest | scalatest_2.11 | 3.0.3 |

| org.slf4j | jcl-over-slf4j | 1.7.16 |

| org.slf4j | jul-to-slf4j | 1.7.16 |

| org.slf4j | slf4j-api | 1.7.16 |

| org.slf4j | slf4j-log4j12 | 1.7.16 |

| org.spark-project.hive | hive-beeline | 1.2.1.spark2 |

| org.spark-project.hive | hive-cli | 1.2.1.spark2 |

| org.spark-project.hive | hive-jdbc | 1.2.1.spark2 |

| org.spark-project.hive | hive-metastore | 1.2.1.spark2 |

| org.spark-project.spark | Használatlan | 1.0.0 |

| org.spire-math | spire-macros_2.11 | 0.13.0 |

| org.spire-math | spire_2.11 | 0.13.0 |

| org.springframework | spring-core | 4.1.4.RELEA Standard kiadás |

| org.springframework | rugós teszt | 4.1.4.RELEA Standard kiadás |

| org.tukaani | xz | 1,5 |

| org.typelevel | machinist_2.11 | 0.6.1 |

| org.typelevel | makró-compat_2.11 | 1.1.1 |

| org.xerial | sqlite-jdbc | 3.8.11.2 |

| org.xerial.snappy | snappy-java | 1.1.7.3 |

| org.yaml | snakeyaml | 1.16 |

| Oro | Oro | 2.0.8 |

| software.amazon.ion | ion-java | 1.0.2 |

| stax | stax-api | 1.0.1 |

| xmlenc | xmlenc | 0,52 |