Azure Databricks-feladatok létrehozása és futtatása

Ez a cikk bemutatja, hogyan hozhat létre és futtathat Azure Databricks-feladatokat a Feladatok felhasználói felületen.

A feladatok konfigurációs beállításairól és a meglévő feladatok szerkesztéséről az Azure Databricks-feladatok beállításainak konfigurálása című témakörben olvashat.

A feladatfuttatások kezeléséről és figyeléséről a feladatfuttatások megtekintése és kezelése című témakörben olvashat.

Az első munkafolyamat Azure Databricks-feladattal való létrehozásához tekintse meg a rövid útmutatót.

Fontos

- Egy munkaterület legfeljebb 1000 egyidejű tevékenységfuttatásra korlátozódik.

429 Too Many Requestsválasz jelenik meg, ha olyan futtatást kér, amelyet a rendszer nem tud azonnal elindítani. - A munkaterület egy órán belül létrehozható feladatainak száma legfeljebb 10000 lehet (beleértve a "futtatások elküldését"). Ez a korlát a REST API- és jegyzetfüzet-munkafolyamatokkal létrehozott feladatokra is vonatkozik.

Feladatok létrehozása és futtatása parancssori felülettel, API-val vagy jegyzetfüzetekkel

- A Databricks parancssori felületének a feladatok létrehozására és futtatására való használatával kapcsolatos további információkért lásd: Mi a Databricks parancssori felület?

- A Feladatok API feladatok létrehozására és futtatására való használatával kapcsolatos további információkért tekintse meg a REST API-referenciában szereplő Feladatok című témakört.

- Ha szeretné megtudni, hogyan futtathat és ütemezhet feladatokat közvetlenül a Databricks-jegyzetfüzetekben, olvassa el az ütemezett jegyzetfüzet-feladatok létrehozását és kezelését ismertető cikket.

Feladat létrehozása

Hajtsa végre a megfelelő műveletet:

- Kattintson

a Munkafolyamatok elemre az oldalsávon, és kattintson a gombra

a Munkafolyamatok elemre az oldalsávon, és kattintson a gombra  .

. - Az oldalsávon kattintson az Új gombra

, és válassza a Feladat lehetőséget.

, és válassza a Feladat lehetőséget.

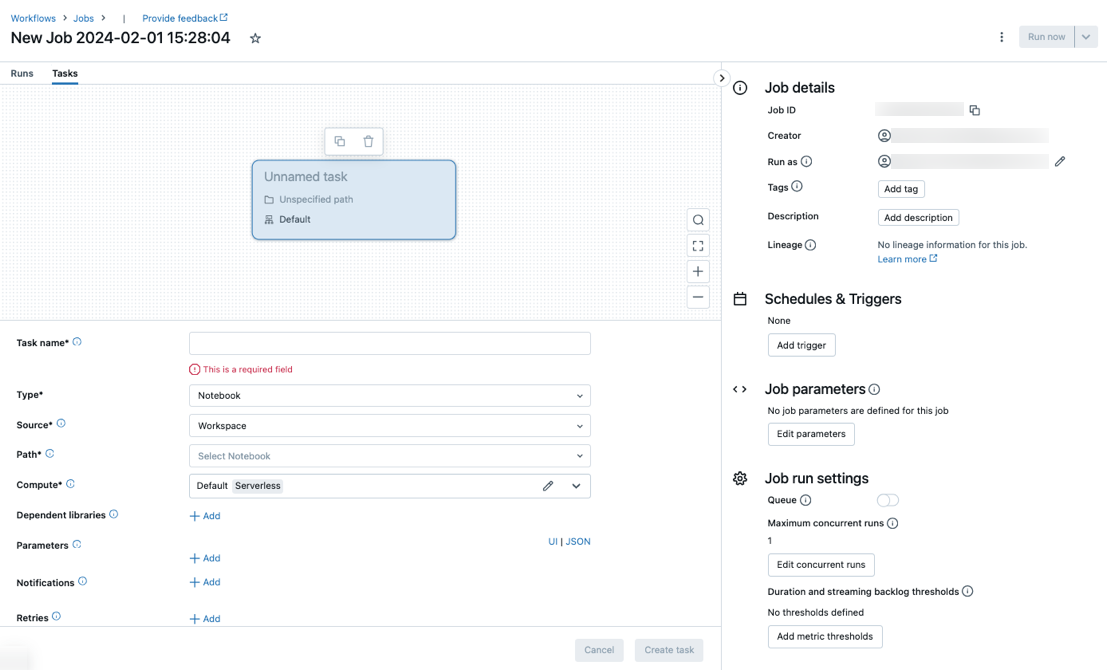

Megjelenik a Feladatok lap a Feladat létrehozása párbeszédpanellel, valamint a feladatszintű beállításokat tartalmazó Feladat részletei oldalpanellel.

- Kattintson

Cserélje le az Új feladatot... a feladat nevére.

Adja meg a tevékenység nevét a Tevékenység neve mezőben.

A Típus legördülő menüben válassza ki a futtatni kívánt feladat típusát. Lásd: Tevékenységtípus beállításai.

Konfigurálja azt a fürtöt, ahol a feladat fut. Alapértelmezés szerint a kiszolgáló nélküli számítás akkor van kiválasztva, ha a munkaterület unitykatalógus-kompatibilis munkaterületen található, és a munkafolyamatokhoz kiszolgáló nélküli számítással támogatott feladatot választott ki. Lásd: Azure Databricks-feladat futtatása kiszolgáló nélküli számítással munkafolyamatokhoz. Ha a kiszolgáló nélküli számítás nem érhető el, vagy más számítási típust szeretne használni, a Számítási legördülő menüben kiválaszthat egy új feladatfürtöt vagy egy meglévő teljes célú fürtöt.

- Új feladatfürt: Kattintson a Fürt legördülő menü Szerkesztés gombjára, és fejezze be a fürtkonfigurációt.

- Meglévő teljes célú fürt: Válasszon ki egy meglévő fürtöt a Fürt legördülő menüben. Ha új lapon szeretné megnyitni a fürtöt, kattintson a

fürt neve és leírása jobb oldalán található ikonra.

fürt neve és leírása jobb oldalán található ikonra.

Ha többet szeretne megtudni a fürtök feladatok futtatására való kiválasztásáról és konfigurálásáról, olvassa el az Azure Databricks számítási feladataival való használatát ismertető témakört.

Függő kódtárak hozzáadásához kattintson a + Hozzáadás a Függő tárak mellett elemre. Lásd: Függő könyvtárak konfigurálása.

A feladat paramétereit átadhatja. A formázás és a paraméterek átadásának követelményeiről további információt az Azure Databricks-feladat paramétereinek átadása című témakörben talál.

Ha szeretne értesítéseket kapni a feladat indításáról, sikerességről vagy sikertelenségről, kattintson a + Hozzáadás gombra az E-mailek mellett. A hibaértesítések a kezdeti feladathibáról és az azt követő újrapróbálkozásról lesznek elküldve. Az értesítések szűréséhez és az elküldött e-mailek számának csökkentéséhez ellenőrizze a kihagyott futtatások elnémításáról szóló értesítéseket, a megszakított futtatások értesítéseinek elnémítását vagy az értesítések elnémítását az utolsó újrapróbálkozásig.

Ha újrapróbálkozési szabályzatot szeretne konfigurálni a feladathoz, kattintson a + Hozzáadás gombra az Újrapróbálkozás mellett. Lásd: Feladat újrapróbálkozési szabályzatának konfigurálása.

A tevékenység várható időtartamának vagy időtúllépésének konfigurálásához kattintson a + Hozzáadás gombra az Időtartam küszöbértéke mellett. Lásd: A tevékenységek várható befejezési idejének vagy időtúllépésének konfigurálása.

Kattintson a Létrehozás gombra.

Az első feladat létrehozása után konfigurálhatja a feladatszintű beállításokat, például az értesítéseket, a feladat-eseményindítókat és az engedélyeket. Lásd: Feladat szerkesztése.

Másik feladat hozzáadásához kattintson  a DAG nézetben. Megosztott fürtbeállítás akkor érhető el, ha kiszolgáló nélküli számítást választott, vagy új feladatfürtöt konfigurált egy korábbi feladathoz. Fürtöt is konfigurálhat minden tevékenységhez, amikor létrehoz vagy szerkeszt egy tevékenységet. Ha többet szeretne megtudni a fürtök feladatok futtatására való kiválasztásáról és konfigurálásáról, olvassa el az Azure Databricks számítási feladataival való használatát ismertető témakört.

a DAG nézetben. Megosztott fürtbeállítás akkor érhető el, ha kiszolgáló nélküli számítást választott, vagy új feladatfürtöt konfigurált egy korábbi feladathoz. Fürtöt is konfigurálhat minden tevékenységhez, amikor létrehoz vagy szerkeszt egy tevékenységet. Ha többet szeretne megtudni a fürtök feladatok futtatására való kiválasztásáról és konfigurálásáról, olvassa el az Azure Databricks számítási feladataival való használatát ismertető témakört.

Igény szerint konfigurálhatja a feladatszintű beállításokat, például az értesítéseket, a feladat-eseményindítókat és az engedélyeket. Lásd: Feladat szerkesztése. Olyan feladatszintű paramétereket is konfigurálhat, amelyek meg vannak osztva a feladat tevékenységeivel. Lásd: Paraméterek hozzáadása az összes feladattevékenységhez.

Tevékenységtípus beállításai

Az Azure Databricks-feladathoz hozzáadható tevékenységtípusok és a különböző tevékenységtípusokhoz elérhető lehetőségek a következők:

Jegyzetfüzet: A Forrás legördülő menüben válassza a Munkaterület lehetőséget az Azure Databricks-munkaterület mappájában vagy a Git-szolgáltatóban található jegyzetfüzet távoli Git-adattárban található jegyzetfüzet használatához.

Munkaterület: A fájlböngészővel keresse meg a jegyzetfüzetet, kattintson a jegyzetfüzet nevére, és kattintson a Megerősítés gombra.

Git-szolgáltató: Kattintson a Git-referencia szerkesztése vagy hozzáadása elemre, és adja meg a Git-adattár adatait. Lásd: Jegyzetfüzet használata távoli Git-adattárból.

Feljegyzés

A teljes jegyzetfüzetcella-kimenetre (az összes jegyzetfüzetcella összesített kimenetére) 20 MB-os méretkorlát vonatkozik. Emellett az egyes cellák kimenetére 8 MB-os méretkorlát vonatkozik. Ha az összes cellakimenet meghaladja a 20 MB-ot, vagy ha egy adott cella kimenete nagyobb, mint 8 MB, a futtatás megszakad, és sikertelenként van megjelölve.

Ha segítségre van szüksége a korláthoz közeli vagy annál több cella megtalálásához, futtassa a jegyzetfüzetet egy teljes célú fürtön, és használja ezt a jegyzetfüzet automatikus mentési technikáját.

JAR: Adja meg a főosztályt. Használja például a fő metódust

org.apache.spark.examples.SparkPitartalmazó osztály teljes nevét. Ezután kattintson a Hozzáadás a Függő tárak területen a feladat futtatásához szükséges kódtárak hozzáadásához. Ezen kódtárak egyikének tartalmaznia kell a főosztályt.A JAR-feladatokkal kapcsolatos további információkért lásd : JAR használata Azure Databricks-feladatokban.

Spark Submit: A Paraméterek szövegmezőben adja meg a főosztályt, a jar kódtár elérési útját és az összes argumentumot, sztringek JSON-tömbjeként formázva. Az alábbi példa egy Spark-küldési feladatot konfigurál az

DFSReadWriteTestApache Spark-példák futtatásához:["--class","org.apache.spark.examples.DFSReadWriteTest","dbfs:/FileStore/libraries/spark_examples_2_12_3_1_1.jar","/discover/databricks-datasets/README.md","/FileStore/examples/output/"]Fontos

A spark-submit tevékenységekre számos korlátozás vonatkozik:

- A spark-submit feladatokat csak új fürtökön futtathatja.

- A Spark-submit nem támogatja a fürt automatikus skálázását. Az automatikus skálázásról további információt a Fürt automatikus skálázása című témakörben talál.

- A Spark-submit nem támogatja a Databricks Utilities (dbutils) referenciáját. A Databricks Utilities használatához használjon JAR-feladatokat.

- Unity Catalog-kompatibilis fürt használata esetén a spark-submit csak akkor támogatott, ha a fürt a hozzárendelt hozzáférési módot használja. A megosztott hozzáférési mód nem támogatott.

- A Spark Streaming-feladatoknak soha nem szabad 1-nél nagyobbra állítaniuk az egyidejű futtatások maximális értékét. A streamelési feladatokat úgy kell beállítani, hogy a cron kifejezéssel

"* * * * * ?"fussanak (percenként). Mivel a streamelési tevékenységek folyamatosan futnak, mindig az utolsó feladatnak kell lennie egy feladatban.

Python-szkript: A Forrás legördülő menüben válassza ki a Python-szkript helyét, vagy a helyi munkaterületen lévő szkript munkaterületét , a DBFS-en található szkript dbFS-ét , vagy egy Git-adattárban található szkript Git-szolgáltatóját . Az Elérési út szövegmezőbe írja be a Python-szkript elérési útját:

Munkaterület: A Python-fájl kiválasztása párbeszédpanelen keresse meg a Python-szkriptet, és kattintson a Megerősítés gombra.

DBFS: Adja meg egy Python-szkript URI-ját a DBFS-en vagy a felhőbeli tárolón,

dbfs:/FileStore/myscript.pypéldául.Git-szolgáltató: Kattintson a Szerkesztés gombra, és adja meg a Git-adattár adatait. Lásd: Python-kód használata távoli Git-adattárból.

Delta Live Tables-folyamat: A Folyamat legördülő menüben válasszon ki egy meglévő Delta Live Tables-folyamatot .

Fontos

A Folyamat tevékenységgel csak aktivált folyamatokat használhat. A folyamatos folyamatok nem támogatottak feladatfeladatként. Az aktivált és a folyamatos folyamatokról további információt a Folyamatos és az aktivált folyamat végrehajtása című témakörben talál.

Python Wheel: A Csomagnév szövegmezőbe írja be az importálni kívánt csomagot, például

myWheel-1.0-py2.py3-none-any.whl. A Belépési pont szövegmezőbe írja be a Python-kerékfájl indításakor meghívni kívánt függvényt. A Feladat futtatásához szükséges kódtárak hozzáadásához kattintson a Hozzáadás gombra a Függő tárak csoportban.SQL: Az SQL-feladat legördülő menüjében válassza a Lekérdezés, az Örökölt irányítópult, a Riasztás vagy a Fájl lehetőséget.

Feljegyzés

- Az SQL-feladathoz a Databricks SQL és egy kiszolgáló nélküli vagy pro SQL-raktár szükséges.

Lekérdezés: Az SQL-lekérdezés legördülő menüjében válassza ki a feladat futtatásakor futtatni kívánt lekérdezést.

Örökölt irányítópult: Az SQL-irányítópult legördülő menüjében válassza ki a tevékenység futtatásakor frissíteni kívánt irányítópultot.

Riasztás: Az SQL-riasztás legördülő menüjében válasszon ki egy riasztást, amely kiértékelésre aktiválódik.

Fájl: Az Azure Databricks-munkaterület mappájában található SQL-fájl használatához a Forrás legördülő menüben válassza a Munkaterület lehetőséget, a fájlböngészővel keresse meg az SQL-fájlt, kattintson a fájlnévre, és kattintson a Megerősítés gombra. Ha távoli Git-adattárban található SQL-fájlt szeretne használni, válassza a Git-szolgáltató lehetőséget, kattintson a Git-referencia szerkesztése vagy hozzáadása elemre, és adja meg a Git-adattár részleteit. Lásd: SQL-lekérdezések használata távoli Git-adattárból.

Az SQL Warehouse legördülő menüjében válasszon ki egy kiszolgáló nélküli vagy pro SQL-raktárt a feladat futtatásához.

dbt: A dbt-feladatok konfigurálásának részletes példáját az Azure Databricks-feladatok dbt-transzformációinak használata című témakörben találja.

Feladat futtatása: A Feladat legördülő menüben válassza ki a feladat által futtatandó feladatot. A futtatandó feladat kereséséhez kezdje el beírni a feladat nevét a Feladat menübe.

Fontos

Ne hozzon létre körkörös függőségekkel rendelkező feladatokat a

Run JobháromnálRun Jobtöbb tevékenységet beágyazott tevékenység vagy feladatok használatakor. A körkörös függőségek olyanRun Jobtevékenységek, amelyek közvetlenül vagy közvetve aktiválják egymást. Az A feladat például a B feladatot aktiválja, a B feladat pedig az A feladatot aktiválja. A Databricks nem támogatja a körkörös függőségekkel rendelkező vagy háromnálRun Jobtöbb feladatot beágyazott feladatokat, és előfordulhat, hogy a jövőbeli kiadásokban nem engedélyezi ezeket a feladatokat.Ha/egyéb: A tevékenység használatának megismeréséhez olvassa el az

If/else conditionElágaztatási logika hozzáadása a feladathoz a Ha/más feltétel tevékenységgel című témakört.

Paraméterek átadása Egy Azure Databricks-feladat feladatának

Számos feladattevékenység-típusnak átadhat paramétereket. Minden tevékenységtípus különböző formázási és továbbítási követelményekkel rendelkezik.

Az aktuális tevékenységre vonatkozó információk( például a tevékenység neve) vagy a feladattevékenységek közötti aktuális futtatás kontextusának (például a feladat kezdési időpontjának vagy az aktuális feladatfuttatás azonosítójának) eléréséhez használjon dinamikus értékhivatkozásokat. Az elérhető dinamikus értékhivatkozások listájának megtekintéséhez kattintson a Dinamikus értékek tallózása gombra.

Ha a feladatparaméterek azon a feladaton vannak konfigurálva, amelyhez egy tevékenység tartozik, ezek a paraméterek megjelennek a tevékenységparaméterek hozzáadásakor. Ha a feladat- és tevékenységparaméterek közösek egy kulccsal, a feladatparaméter elsőbbséget élvez. Figyelmeztetés jelenik meg a felhasználói felületen, ha egy feladatparaméterrel azonos kulccsal rendelkező tevékenységparamétert próbál hozzáadni. Ha a feladatparamétereket olyan tevékenységeknek szeretné átadni, amelyek nem kulcs-érték paraméterekkel vannak konfigurálva, például JARSpark Submit a tevékenységekhez, formázza az argumentumokat {{job.parameters.[name]}}a paramétert azonosító értékre key cserélve[name].

Jegyzetfüzet: Kattintson a Hozzáadás gombra, és adja meg a feladatnak átadni kívánt paraméterek kulcsát és értékét. Felülbírálhatja vagy hozzáadhat további paramétereket, ha manuálisan futtat egy feladatot a Különböző paraméterekkel rendelkező feladat futtatása beállítással. A paraméterek a paraméter kulcsával megadott notebook widget értékét állítják be.

JAR: A paraméterek megadásához használjon JSON-formátumú sztringtömböt. Ezek a sztringek argumentumként lesznek átadva a főosztály fő metódusának. Lásd: JAR-feladatparaméterek konfigurálása.

Spark Submit: A paraméterek JSON-formátumú sztringtömbként vannak megadva. Az Apache Spark spark-submit konvenciónak megfelelően a JAR-elérési út utáni paraméterek a főosztály fő metódusának lesznek átadva.

Python Wheel: A Paraméterek legördülő menüben válassza a Pozícióargumentumok lehetőséget a paraméterek JSON-formátumú sztringtömbként való megadásához, vagy válassza a Kulcsszó argumentumok > Hozzáadása lehetőséget az egyes paraméterek kulcsának és értékének megadásához. A rendszer parancssori argumentumként továbbítja a hely- és kulcsszóargumentumokat a Python-kerekes feladatnak. Ha egy Python-kerekes fájlba csomagolt Python-szkript argumentumainak olvasására szeretne példát látni, olvassa el a Python-kerekes fájl használata egy Azure Databricks-feladatban című témakört.

Feladat futtatása: Adja meg az egyes feladatparaméterek kulcsát és értékét a feladatnak való továbbításhoz.

Python-szkript: A paraméterek megadásához használjon JSON-formátumú sztringtömböt. Ezek a sztringek argumentumként vannak átadva, és pozícióargumentumokként olvashatók, vagy elemezhetők a Python argparse moduljának használatával. A pozícióargumentumok Python-szkriptekben való olvasására vonatkozó példát a 2. lépésben találhatja meg: Szkript létrehozása GitHub-adatok beolvasásához.

SQL: Ha a feladat paraméteres lekérdezést vagy paraméteres irányítópultot futtat, adja meg a paraméterek értékeit a megadott szövegmezőkben.

Tevékenységútvonal másolása

Bizonyos tevékenységtípusok, például a jegyzetfüzet-tevékenységek, lehetővé teszik az elérési út másolását a tevékenység forráskódjába:

- Kattintson a Feladatok fülre.

- Jelölje ki a másolandó elérési utat tartalmazó feladatot.

- Kattintson

a tevékenységútvonal mellett az elérési út vágólapra másolásához.

a tevékenységútvonal mellett az elérési út vágólapra másolásához.

Feladat létrehozása meglévő feladatból

Egy meglévő feladat klónozásával gyorsan létrehozhat egy új feladatot. A feladatok klónozása a feladat azonos másolatát hozza létre, kivéve a feladatazonosítót. A feladat lapján kattintson a Feladat neve melletti Egyebek ... elemre, és válassza a Klónozás lehetőséget a legördülő menüből.

Tevékenység létrehozása meglévő tevékenységből

Egy meglévő tevékenység klónozásával gyorsan létrehozhat egy új feladatot:

- A feladat lapján kattintson a Feladatok fülre.

- Válassza ki a klónozni kívánt feladatot.

- Kattintson

és válassza a Klónozás feladat lehetőséget.

és válassza a Klónozás feladat lehetőséget.

Feladat törlése

Feladat törléséhez a feladat lapján kattintson a Feladat neve melletti Egyebek ... elemre, és válassza a Törlés lehetőséget a legördülő menüből.

Tevékenység törlése

Feladat törlése:

- Kattintson a Feladatok fülre.

- Jelölje ki a törölni kívánt feladatot.

- Kattintson

és válassza a Feladat eltávolítása lehetőséget.

és válassza a Feladat eltávolítása lehetőséget.

Feladat futtatása

- Kattintson

a Munkafolyamatok elemre az oldalsávon.

a Munkafolyamatok elemre az oldalsávon. - Jelöljön ki egy feladatot, és kattintson a Futtatások fülre. Egy feladatot azonnal futtathat, vagy ütemezheti a feladat későbbi futtatását.

Ha egy több feladatot tartalmazó feladat egy vagy több feladata sikertelen, újra futtathatja a sikertelen tevékenységek részhalmazát. Lásd: Sikertelen és kihagyott feladatok újrafuttatása.

Feladat azonnali futtatása

A feladat azonnali futtatásához kattintson a gombra  .

.

Tipp.

A feladat tesztfuttatását jegyzetfüzet-feladattal a Futtatás most gombra kattintva hajthatja végre. Ha módosítania kell a jegyzetfüzetet, a jegyzetfüzet szerkesztése után a Futtatás most gombra kattintva automatikusan lefuttathatja a jegyzetfüzet új verzióját.

Feladat futtatása különböző paraméterekkel

A Futtatás most más paraméterekkel lehetőséggel újra futtathat feladatokat különböző paraméterekkel vagy a meglévő paraméterek eltérő értékeivel.

Feljegyzés

Nem bírálhatja felül a feladatparamétereket, ha a feladatparaméterek bevezetése előtt futtatott feladat felülírja a tevékenységparamétereket ugyanazzal a kulccsal.

- Kattintson

a Futtatás most lehetőség mellett, és válassza a Futtatás most különböző paraméterekkel lehetőséget, vagy az Aktív futtatások táblában kattintson a Futtatás most más paraméterekkel elemre. Adja meg az új paramétereket a tevékenység típusától függően. Lásd: Paraméterek átadása egy Azure Databricks-feladathoz.

a Futtatás most lehetőség mellett, és válassza a Futtatás most különböző paraméterekkel lehetőséget, vagy az Aktív futtatások táblában kattintson a Futtatás most más paraméterekkel elemre. Adja meg az új paramétereket a tevékenység típusától függően. Lásd: Paraméterek átadása egy Azure Databricks-feladathoz. - Kattintson a Futtatás elemre.

Feladat futtatása szolgáltatásnévként

Feljegyzés

Ha a feladat SQL-lekérdezéseket futtat az SQL-feladat használatával, a lekérdezések futtatásához használt identitást az egyes lekérdezések megosztási beállításai határozzák meg, még akkor is, ha a feladat szolgáltatásnévként fut. Ha egy lekérdezés konfigurálva Run as ownervan, a lekérdezés mindig a tulajdonos identitásával fut, nem pedig a szolgáltatásnév identitásával. Ha a lekérdezés konfigurálva Run as viewervan, a lekérdezés a szolgáltatásnév identitásával fut. A lekérdezésmegosztási beállításokról további információt a lekérdezési engedélyek konfigurálása című témakörben talál.

Alapértelmezés szerint a feladatok a feladat tulajdonosának identitásaként futnak. Ez azt jelenti, hogy a feladat a feladat tulajdonosának engedélyeit veszi át. A feladat csak olyan adatokat és Azure Databricks-objektumokat tud elérni, amelyekhez a feladat tulajdonosa hozzáféréssel rendelkezik. Módosíthatja azt az identitást, amelyet a feladat egy szolgáltatásnévként futtat. Ezután a feladat a tulajdonos helyett az adott szolgáltatásnév engedélyeit veszi fel.

A Futtatás mint beállítás módosításához rendelkeznie kell a feladatHOZ tartozó CAN MANAGE vagy IS OWNER engedéllyel. Beállíthatja a Futtatás beállítást saját magának vagy bármely szolgáltatásnévnek azon a munkaterületen, amelyen a szolgáltatásnév felhasználói szerepköre van. További információ: Szerepkörök a szolgáltatásnevek kezeléséhez.

Feljegyzés

Ha egy munkaterületen a RestrictWorkspaceAdmins beállítás értéke meg van adva ALLOW ALL, a munkaterület rendszergazdái a Futtatás beállítást a munkaterület bármely felhasználójára módosíthatják. Ha azt szeretné, hogy a munkaterület rendszergazdái csak saját magukra vagy a szolgáltatásnév felhasználói szerepkörével rendelkező szolgáltatásnevekre módosítják a Futtatás beállítást, olvassa el a Munkaterület rendszergazdáinak korlátozása című témakört.

A futtatás mezőként való módosításához tegye a következőket:

- Az oldalsávon kattintson

a Munkafolyamatok elemre.

a Munkafolyamatok elemre. - A Név oszlopban kattintson a feladat nevére.

- A Feladat részletei oldalpanelen kattintson a Futtatás mező melletti ceruza ikonra.

- Keresse meg és válassza ki a szolgáltatásnevet.

- Kattintson a Mentés gombra.

Felsorolhatja azokat a szolgáltatásneveket is, amelyeken felhasználói szerepkörrel rendelkezik a Workspace Service Principals API használatával. További információ: A használható szolgáltatásnevek listázása.

Feladat futtatása ütemezés szerint

Ütemezéssel automatikusan futtathatja az Azure Databricks-feladatot a megadott időpontokban és időszakokban. Lásd: Feladatütemezés hozzáadása.

Folyamatos feladat futtatása

Gondoskodhat arról, hogy a feladat mindig aktív legyen. Lásd: Folyamatos feladat futtatása.

Feladat futtatása új fájlok érkezésekor

Ha egy feladatfuttatást szeretne elindítani, amikor új fájlok érkeznek egy Unity-katalógus külső helyére vagy kötetére, használjon egy fájlbetöltési eseményindítót.

Databricks-eszközcsomaggal létrehozott feladat megtekintése és futtatása

Az Azure Databricks Jobs felhasználói felületén megtekintheti és futtathatja a Databricks-eszközcsomag által üzembe helyezett feladatokat. Alapértelmezés szerint ezek a feladatok írásvédettek a Feladatok felhasználói felületén. A köteg által üzembe helyezett feladat szerkesztéséhez módosítsa a csomag konfigurációs fájlját, és telepítse újra a feladatot. A módosítások csak a csomagkonfigurációra való alkalmazása biztosítja, hogy a csomag forrásfájljai mindig rögzítsék az aktuális feladatkonfigurációt.

Ha azonban azonnal módosítania kell egy feladatot, leválaszthatja a feladatot a csomagkonfigurációról, hogy lehetővé tegye a feladatbeállítások szerkesztését a felhasználói felületen. A feladat leválasztásához kattintson a Forrás leválasztása elemre. A Forrás leválasztása párbeszédpanelen kattintson a Leválasztás gombra a megerősítéshez.

A felhasználói felületen végzett feladat módosításai nem lesznek alkalmazva a csomagkonfigurációra. Ha a felhasználói felületen végrehajtott módosításokat a csomagra szeretné alkalmazni, manuálisan kell frissítenie a csomagkonfigurációt. Ha újra szeretné csatlakoztatni a feladatot a csomagkonfigurációhoz, helyezze újra üzembe a feladatot a köteg használatával.

Mi a teendő, ha a feladat nem futtatható egyidejűségi korlátok miatt?

Feljegyzés

A várólistázás alapértelmezés szerint engedélyezve van, amikor a feladatok a felhasználói felületen jönnek létre.

Ha meg szeretné akadályozni, hogy egy feladat futtatásai az egyidejűségi korlátok miatt ne legyenek kihagyva, engedélyezheti az üzenetsor-kezelést a feladathoz. Ha a várólistázás engedélyezve van, ha az erőforrások nem érhetők el egy feladatfuttatáshoz, a futtatás akár 48 óráig is várólistára kerül. Ha a kapacitás rendelkezésre áll, a feladatfuttatás le lesz törölve és futtatva. A várólistás futtatások megjelennek a feladat futtatáslistájában és a legutóbbi feladatfuttatások listájában.

A futtatás az alábbi korlátok valamelyikének elérésekor lesz várólistára helyezve:

- A munkaterületen az egyidejű aktív futtatások maximális száma.

- Az egyidejű

Run Jobtevékenység maximális futása a munkaterületen. - A feladat maximális egyidejű futtatása.

A várólista egy feladatszintű tulajdonság, amely csak az adott feladathoz fut.

Az üzenetsorok engedélyezéséhez vagy letiltásához kattintson a Speciális beállítások gombra, majd a Feladat részletei oldalpanelen az Üzenetsor-váltó gombra.

Visszajelzés

Hamarosan elérhető: 2024-ben fokozatosan kivezetjük a GitHub-problémákat a tartalom visszajelzési mechanizmusaként, és lecseréljük egy új visszajelzési rendszerre. További információ: https://aka.ms/ContentUserFeedback.

Visszajelzés küldése és megtekintése a következőhöz: