Eseguire un notebook di esempio con Spark

Si applica a: SQL Server 2019 (15.x)

Importante

Il componente aggiuntivo per i cluster Big Data di Microsoft SQL Server 2019 verrà ritirato. Il supporto per i cluster Big Data di SQL Server 2019 terminerà il 28 febbraio 2025. Tutti gli utenti esistenti di SQL Server 2019 con Software Assurance saranno completamente supportati nella piattaforma e fino a quel momento il software continuerà a ricevere aggiornamenti cumulativi di SQL Server. Per altre informazioni, vedere il post di blog relativo all'annuncio e Opzioni per i Big Data nella piattaforma Microsoft SQL Server.

Questa esercitazione illustra come caricare ed eseguire un notebook di Azure Data Studio in un cluster Big Data di SQL Server 2019. Questa operazione consente infatti ai data scientist e ai data engineer di eseguire codice Python, R o Scala sul cluster.

Suggerimento

Se si preferisce, è possibile scaricare ed eseguire uno script per i comandi descritti in questa esercitazione. Per istruzioni, vedere gli esempi di Spark in GitHub.

Prerequisiti

- Strumenti per Big Data

- kubectl

- Azure Data Studio

- Estensione di SQL Server 2019

- Caricare dati di esempio nel cluster Big Data

Scaricare il file del notebook di esempio

Usare le istruzioni seguenti per caricare il file del notebook di esempio spark-sql.ipynb in Azure Data Studio.

Aprire un prompt dei comandi Bash (Linux) o Windows PowerShell.

Passare alla directory in cui si vuole scaricare il file del notebook di esempio.

Eseguire il comando curl seguente per scaricare il file del notebook da GitHub:

curl https://raw.githubusercontent.com/Microsoft/sql-server-samples/master/samples/features/sql-big-data-cluster/spark/data-loading/transform-csv-files.ipynb -o transform-csv-files.ipynb

Aprire il notebook

Questa procedura illustra come aprire il file del notebook in Azure Data Studio:

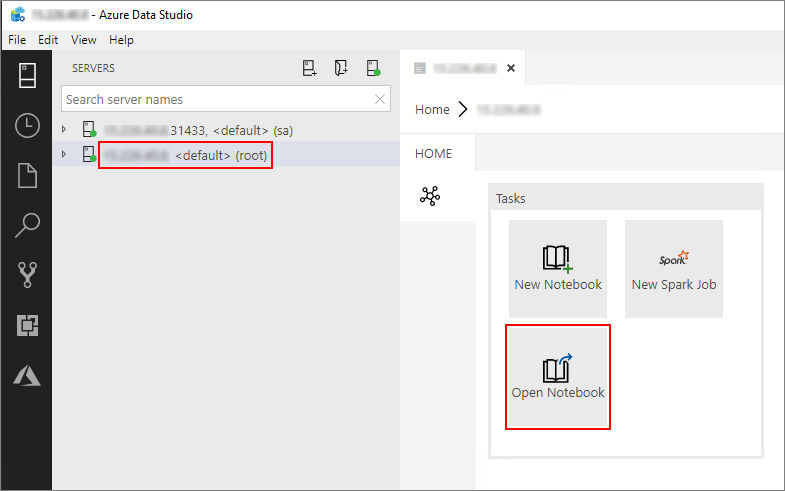

In Azure Data Studio connettersi all'istanza master del cluster Big Data. Per altre informazioni, vedere Connettersi a un cluster Big Data.

Fare doppio clic sulla connessione del gateway HDFS/Spark nella finestra Server. Selezionare quindi Open Notebook (Apri notebook).

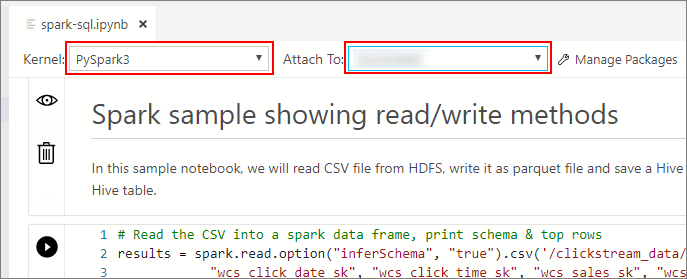

Attendere che il kernel e il contesto di destinazione(Connetti a) siano popolati. Impostare il kernel su PySpark3 e l'opzione Connetti a sull'indirizzo IP dell'endpoint del cluster Big Data.

Importante

In Azure Data Studio tutti i tipi di notebook Spark (Scala Spark, PySpark e SparkR) definiscono in modo convenzionale alcune importanti variabili correlate alla sessione Spark al momento della prima esecuzione della cella. Queste variabili sono: spark, sc e sqlContext. Quando si copia la logica dai notebook per l'invio in batch (ad esempio, in un file Python da eseguire con azdata bdc spark batch create), assicurarsi di definire le variabili di conseguenza.

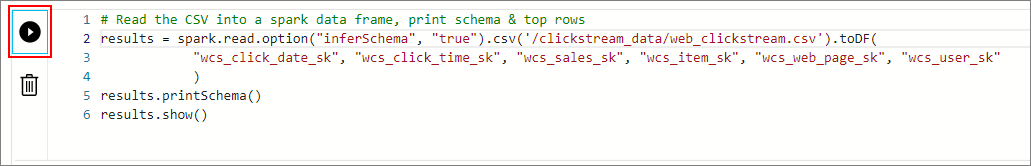

Eseguire le celle del notebook

È possibile eseguire ogni cella del notebook premendo il pulsante di riproduzione a sinistra della cella. I risultati verranno visualizzati nel notebook al termine dell'esecuzione della cella.

Eseguire tutte le celle del notebook di esempio in successione. Per altre informazioni sull'utilizzo dei notebook con cluster Big Data di SQL Server, vedere le risorse seguenti:

Passaggi successivi

Altre informazioni sui notebook: