Azure Event Hubs: een realtime platform voor gegevensstreaming met systeemeigen Ondersteuning voor Apache Kafka

Azure Event Hubs is een cloudeigen gegevensstreamingservice waarmee miljoenen gebeurtenissen per seconde, met lage latentie, van elke bron naar elke bestemming kunnen worden gestreamd. Event Hubs is compatibel met Apache Kafka en stelt u in staat om bestaande Kafka-workloads uit te voeren zonder codewijzigingen.

Met Event Hubs voor het opnemen en opslaan van streaminggegevens kunnen bedrijven gebruikmaken van de kracht van streaminggegevens om waardevolle inzichten te verkrijgen, realtime analyses te stimuleren en te reageren op gebeurtenissen wanneer ze plaatsvinden, waardoor de algehele efficiëntie en klantervaring worden verbeterd.

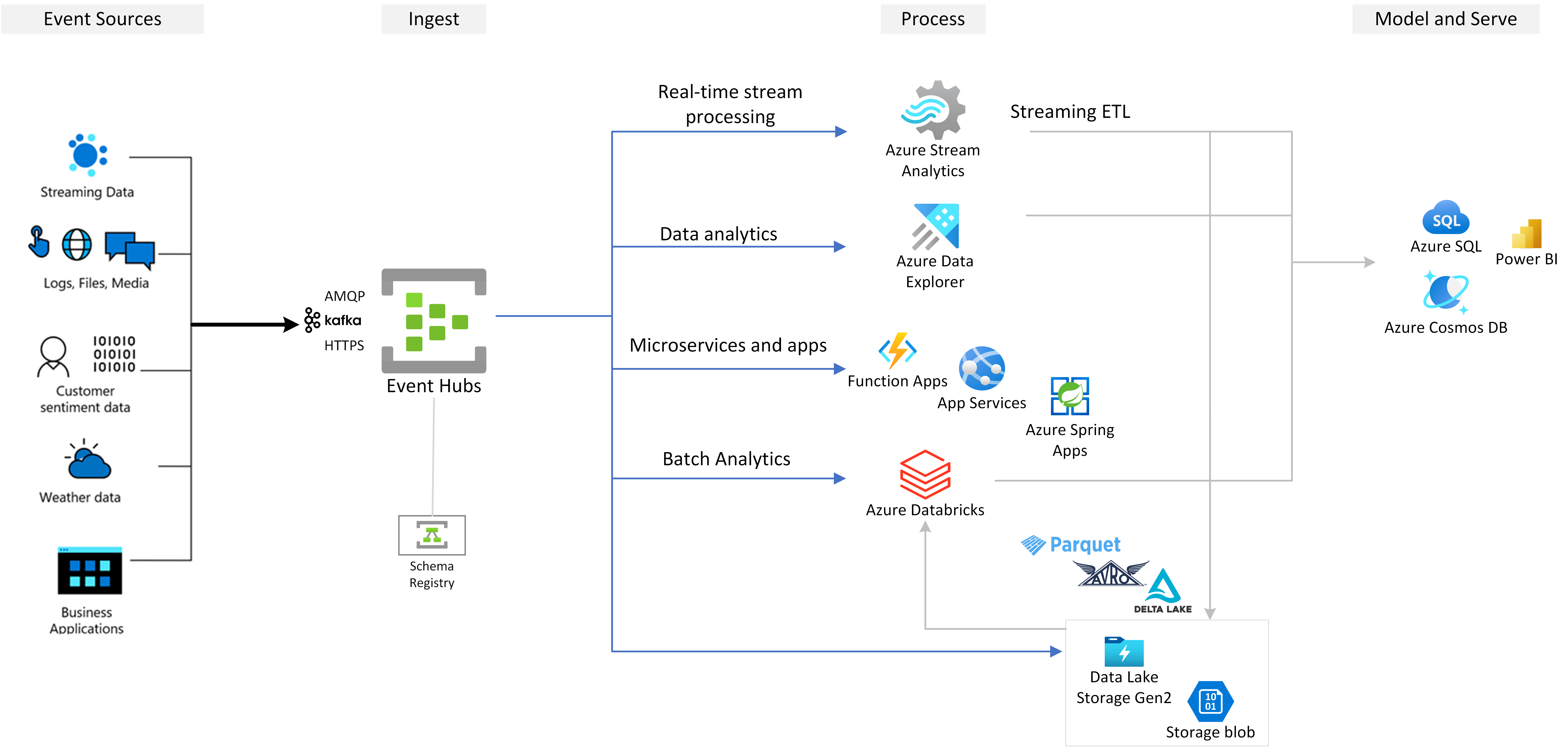

Azure Event Hubs is de voorkeurslaag voor gebeurtenisopname van een oplossing voor gebeurtenisstreaming die u op Azure bouwt. Het integreert naadloos met gegevens- en analyseservices binnen en buiten Azure om uw volledige pijplijn voor gegevensstreaming te bouwen om de volgende gebruiksscenario's te leveren.

- Realtime analyses met Azure Stream Analytics om realtime inzichten te genereren op basis van streaminggegevens.

- Streaminggegevens analyseren en verkennen met Azure Data Explorer.

- Maak uw eigen cloudeigen toepassingen, functies of microservices die worden uitgevoerd op streaminggegevens van Event Hubs.

- Stream gebeurtenissen met schemavalidatie met behulp van een ingebouwd schemaregister om de kwaliteit en compatibiliteit van streaminggegevens te waarborgen.

Belangrijke mogelijkheden

Apache Kafka in Azure Event Hubs

Azure Event Hubs is een streaming-engine met meerdere protocollen die systeemeigen ondersteuning biedt voor AMQP-, Apache Kafka- en HTTPs-protocollen. Omdat Het Apache Kafka ondersteunt, brengt u Kafka-workloads naar Azure Event Hubs zonder codewijziging uit te voeren. U hoeft uw eigen Kafka-clusters niet in te stellen, te configureren en te beheren of een Kafka-as-a-Service-aanbieding te gebruiken die niet systeemeigen is voor Azure.

Event Hubs is vanaf de grond opgebouwd als een cloudeigen broker-engine. Daarom kunt u Kafka-workloads uitvoeren met betere prestaties, betere kostenefficiëntie en zonder operationele overhead.

Zie Azure Event Hubs voor Apache Kafka voor meer informatie.

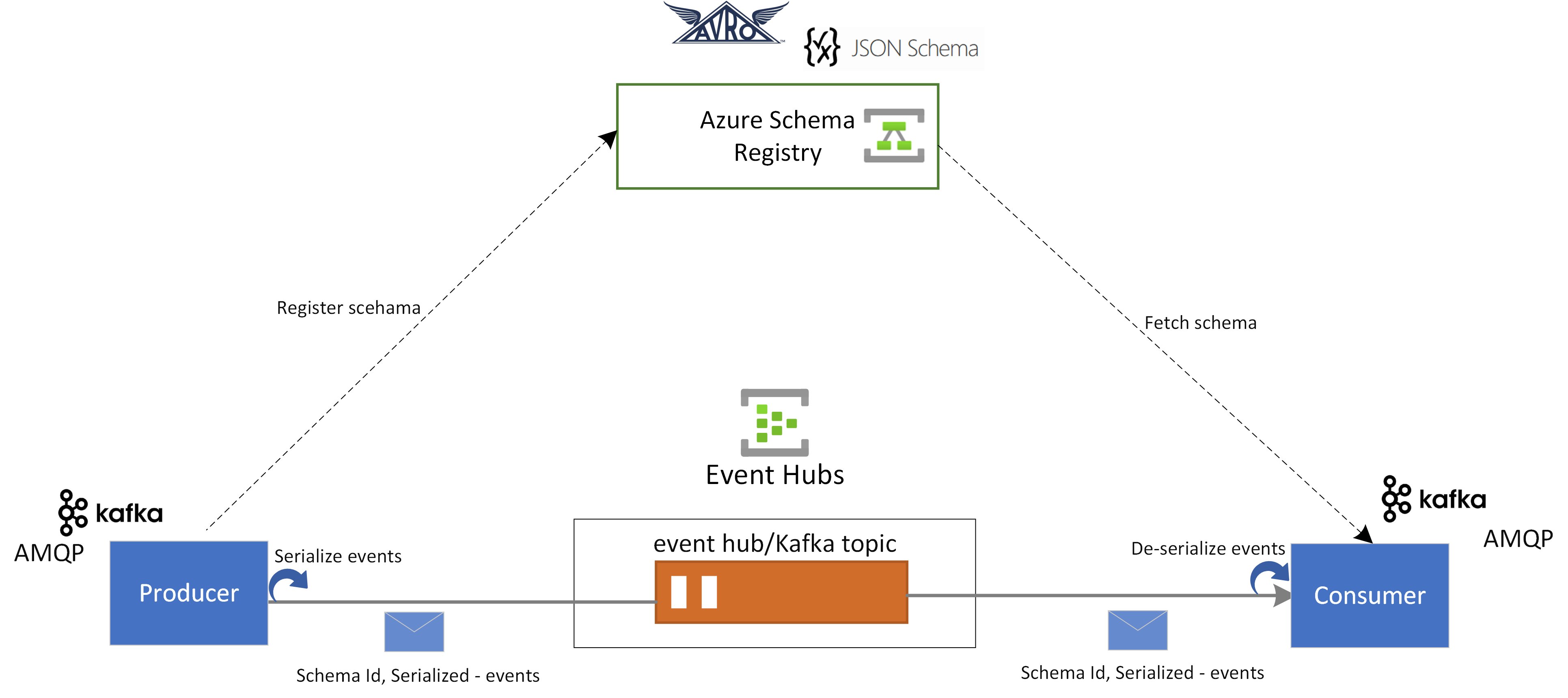

Schemaregister in Azure Event Hubs

Azure Schema Registry in Event Hubs biedt een gecentraliseerde opslagplaats voor het beheren van schema's van streamingtoepassingen voor gebeurtenissen. Azure Schema Registry wordt gratis geleverd bij elke Event Hubs-naamruimte en kan naadloos worden geïntegreerd met uw Kafka-toepassingen of Event Hubs SDK-toepassingen.

Het zorgt voor gegevenscompatibiliteit en consistentie tussen gebeurtenisproducenten en consumenten. Schema Registry maakt naadloze schemaontwikkeling, validatie en governance mogelijk en bevordert efficiënte gegevensuitwisseling en interoperabiliteit.

Schema Registry kan naadloos worden geïntegreerd met uw bestaande Kafka-toepassingen en ondersteunt meerdere schema-indelingen, waaronder Avro- en JSON-schema's.

Zie Azure Schema Registry in Event Hubs voor meer informatie.

Realtime verwerking van streaminggebeurtenissen met Azure Stream Analytics

Event Hubs kan naadloos worden geïntegreerd met Azure Stream Analytics om realtime stroomverwerking mogelijk te maken. Met de ingebouwde no-code-editor kunt u moeiteloos een Stream Analytics-taak ontwikkelen met behulp van slepen en neerzetten, zonder code te schrijven.

Ontwikkelaars kunnen ook de op SQL gebaseerde Stream Analytics-querytaal gebruiken om realtime streamverwerking uit te voeren en te profiteren van een breed scala aan functies voor het analyseren van streaminggegevens.

Zie de artikelen in de sectie Azure Stream Analytics-integratie van de inhoudsopgave voor meer informatie.

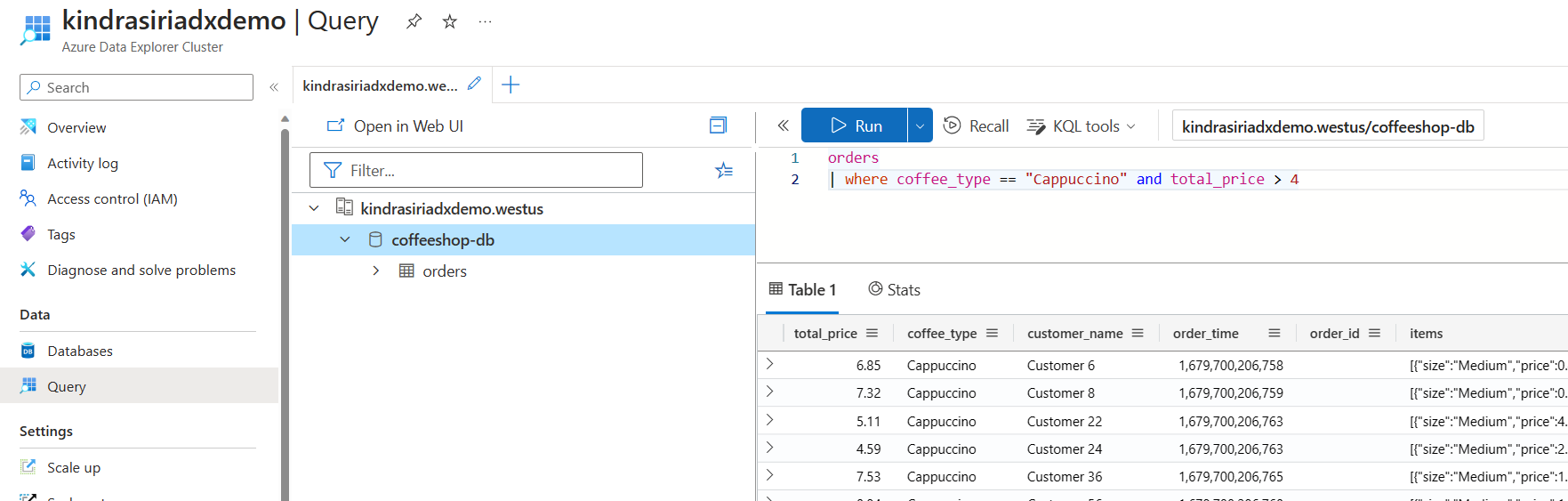

Streaminggegevens verkennen met Azure Data Explorer

Azure Data Explorer is een volledig beheerd platform voor big data-analyses die hoge prestaties leveren en waarmee grote hoeveelheden gegevens in bijna realtime kunnen worden geanalyseerd. Door Event Hubs te integreren met Azure Data Explorer, kunt u eenvoudig bijna realtime analyses uitvoeren en streaminggegevens verkennen.

Zie Gegevens van een Event Hub opnemen in Azure Data Explorer en artikelen in dezelfde sectie voor meer informatie.

Uitgebreid ecosysteem: Azure-functies, SDK's en Kafka-ecosysteem

U kunt uw stroom in realtime opnemen, bufferen, opslaan en verwerken om bruikbare inzichten te krijgen. Event Hubs maakt gebruik van een gepartitioneerd consumermodel, waardoor meerdere toepassingen de stroom gelijktijdig kunnen verwerken en u de verwerkingssnelheid kunt regelen. Azure Event Hubs kan ook worden geïntegreerd met Azure Functions voor serverloze architecturen.

Met een breed ecosysteem dat beschikbaar is voor het industriestandaard AMQP 1.0-protocol en SDK's die beschikbaar zijn in verschillende talen: .NET, Java, Python, JavaScript, kunt u eenvoudig beginnen met het verwerken van uw streams vanuit Event Hubs. Alle ondersteunde clienttalen bieden integratie op laag niveau.

Het ecosysteem biedt u ook naadloze integratie met Azure Functions, Azure Spring Apps, Kafka Verbinding maken ors en andere platformen en technologieën voor gegevensanalyse, zoals Apache Spark en Apache Flink.

Flexibele en kostenefficiënte gebeurtenisstreaming

U kunt flexibele en kostenefficiënte gebeurtenisstreaming ervaren via de diverse selectie lagen van Event Hubs, waaronder Standard, Premium en Dedicated. Deze opties zijn geschikt voor gegevensstreaming, variërend van een paar MB/s tot verschillende GB/s, zodat u de perfecte overeenkomst kunt kiezen voor uw vereisten.

Schaalbaar

Met Event Hubs kunt u beginnen met gegevensstromen van megabytes en uitgroeien tot gigabytes of terabytes. De functie Automatisch vergroten is een van de vele opties die beschikbaar zijn om het aantal doorvoereenheden of verwerkingseenheden te schalen om aan uw gebruiksbehoeften te voldoen.

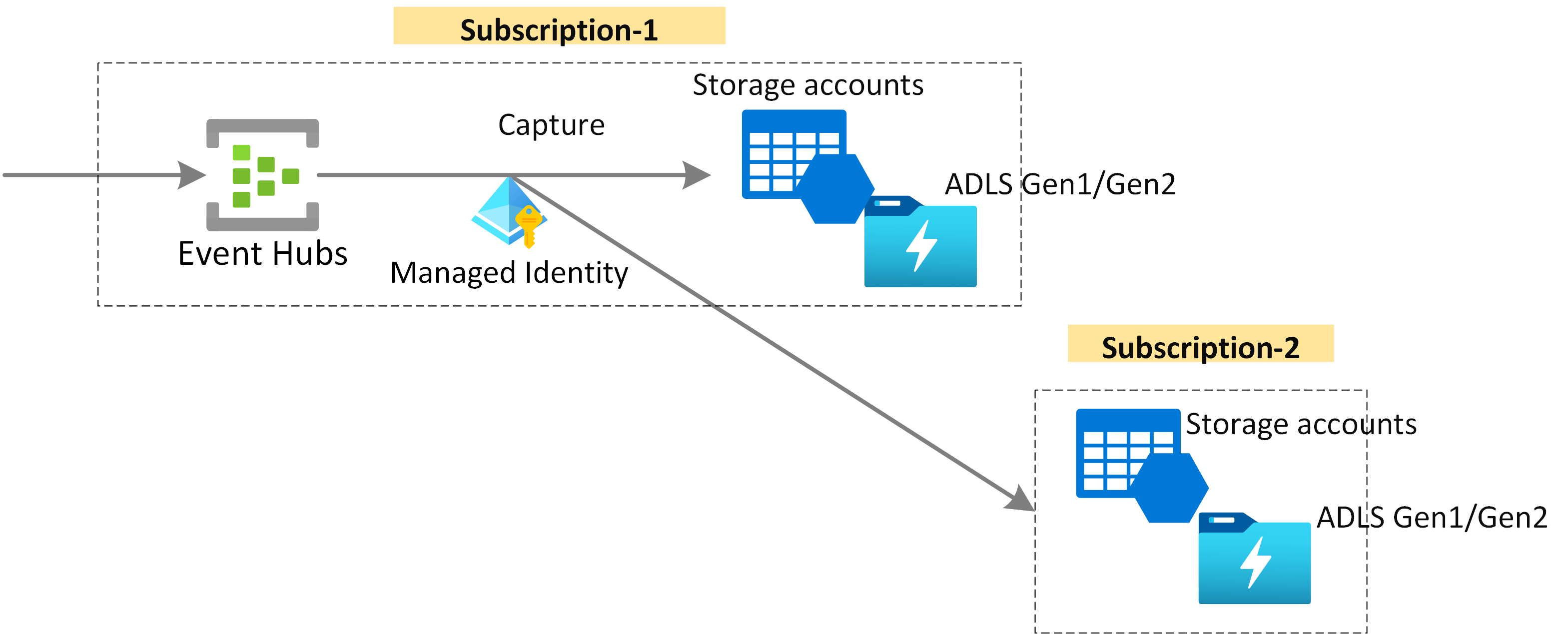

Streaminggegevens vastleggen voor langetermijnretentie en batchanalyse

Leg uw gegevens in bijna realtime vast in een Azure Blob-opslag of Azure Data Lake Storage voor langetermijnretentie of microbatchverwerking. U kunt dit gedrag bereiken op dezelfde stroom die u gebruikt voor het afleiden van realtime analyses. Het instellen van het vastleggen van gebeurtenisgegevens gaat snel.

Hoe het werkt

Event Hubs biedt een geïntegreerd gebeurtenisstreamingplatform met een buffer voor tijdretentie, het ontkoppelen van gebeurtenisproducenten van gebeurtenisgebruikers. De producenten en consumententoepassingen kunnen grootschalige gegevensopname uitvoeren via meerdere protocollen.

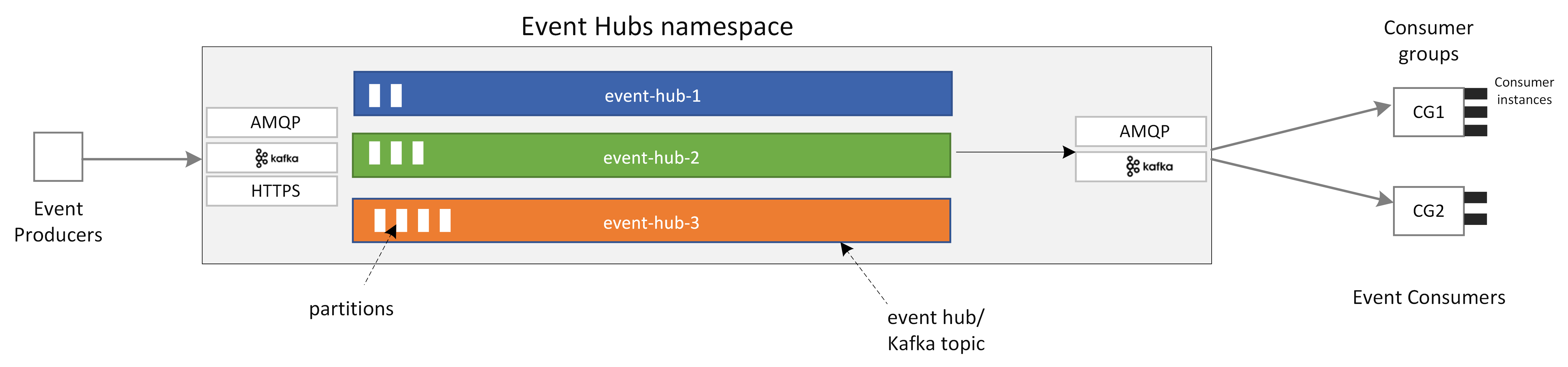

In de volgende afbeelding ziet u de belangrijkste onderdelen van de Event Hubs-architectuur:

De belangrijkste functionele onderdelen van Event Hubs zijn:

- Producenttoepassingen kunnen gegevens opnemen in een Event Hub met behulp van Event Hubs SDK's of een Kafka-producerclient.

- Naamruimte is de beheercontainer voor een of meer Event Hubs of Kafka-onderwerpen. De beheertaken, zoals het toewijzen van streamingcapaciteit, het configureren van netwerkbeveiliging, het inschakelen van herstel na geo-noodgeval, enzovoort, worden verwerkt op naamruimteniveau.

- Event Hub/Kafka-onderwerp: In Event Hubs kunt u gebeurtenissen organiseren in een Event Hub of een Kafka-onderwerp. Het is een toevoeg alleen gedistribueerd logboek, dat kan bestaan uit een of meer partities.

- Partities worden gebruikt om een Event Hub te schalen. Ze zijn als banen in een snelweg. Als u meer streamingdoorvoer nodig hebt, moet u meer partities toevoegen.

- Consumententoepassingen verbruiken gegevens door naar het gebeurtenislogboek te zoeken en de verschuiving van de consument te behouden. Consumenten kunnen Kafka-consumentenclients of Event Hubs SDK-clients zijn.

- Consumentengroep is een logische groep consumentenexemplaren die gegevens uit een Event Hub/Kafka-onderwerp leest. Hiermee kunnen meerdere consumenten dezelfde streaminggegevens in een Event Hub onafhankelijk in hun eigen tempo en met hun eigen offsets lezen.

Volgende stappen

Raadpleeg de volgende quickstartgidsen om aan de slag te gaan met Event Hubs.

Gegevens streamen met behulp van Event Hubs SDK (AMQP)

U kunt een van de volgende voorbeelden gebruiken om gegevens naar Event Hubs te streamen met behulp van SDK's.

Gegevens streamen met Apache Kafka

U kunt de volgende voorbeelden gebruiken om gegevens van uw Kafka-toepassingen naar Event Hubs te streamen.

Schemavalidatie met schemaregister

U kunt Event Hubs Schema Registry gebruiken om schemavalidatie uit te voeren voor uw gebeurtenisstreamingtoepassingen.