Compute

Azure Databricks Compute verwijst naar de selectie van rekenresources die beschikbaar zijn in de Azure Databricks-werkruimte. Gebruikers moeten toegang hebben tot berekeningen voor het uitvoeren van data engineering-, data science- en gegevensanalyseworkloads, zoals productie-ETL-pijplijnen, streaminganalyses, ad-hocanalyses en machine learning.

Gebruikers kunnen verbinding maken met bestaande berekeningen of nieuwe berekeningen maken als ze over de juiste machtigingen beschikken.

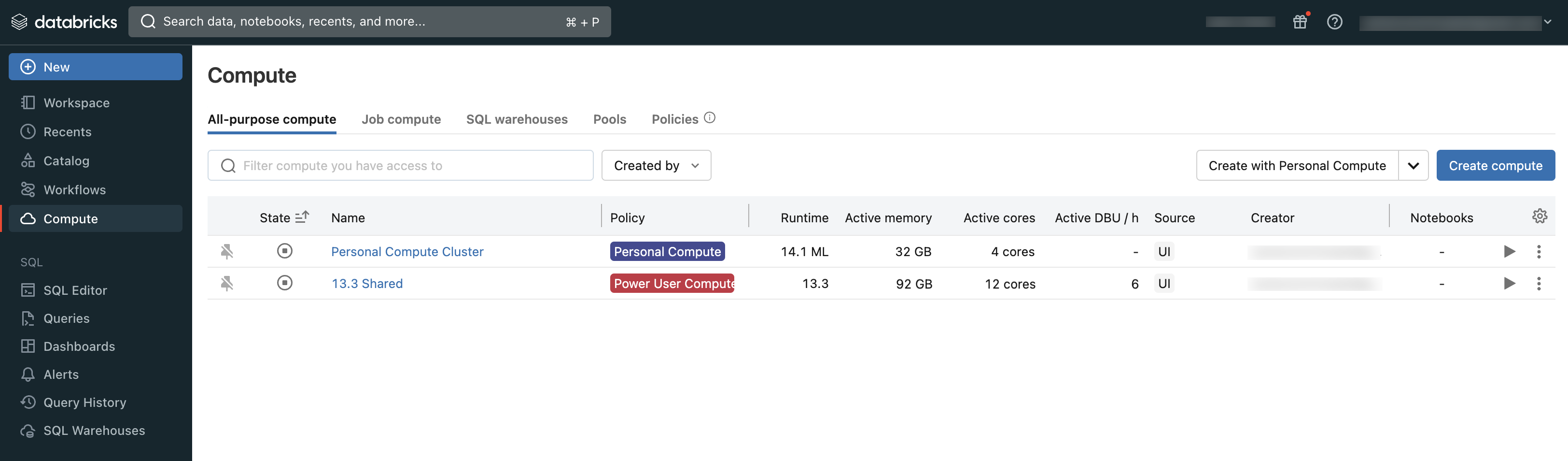

U kunt de rekenkracht bekijken die u kunt gebruiken met behulp van de sectie Compute van de werkruimte:

Typen berekeningen

Dit zijn de typen rekenkracht die beschikbaar zijn in Azure Databricks:

Serverloze rekenkracht voor notebooks (openbare preview): schaalbare rekenkracht op aanvraag die wordt gebruikt voor het uitvoeren van SQL- en Python-code in notebooks.

Serverloze berekening voor werkstromen (openbare preview): schaalbare berekeningen op aanvraag die worden gebruikt om uw Databricks-taken uit te voeren zonder infrastructuur te configureren en te implementeren.

All-purpose compute: ingericht rekenproces dat wordt gebruikt voor het analyseren van gegevens in notebooks. U kunt deze berekening maken, beëindigen en opnieuw starten met behulp van de gebruikersinterface, CLI of REST API.

Taak berekenen: ingericht rekenproces dat wordt gebruikt om geautomatiseerde taken uit te voeren. Met de Azure Databricks-taakplanner wordt automatisch een taak berekend wanneer een taak is geconfigureerd voor uitvoering op nieuwe berekeningen. De berekening wordt beëindigd wanneer de taak is voltooid. U kunt een taak berekenen niet opnieuw opstarten. Zie Azure Databricks Compute gebruiken met uw taken.

Exemplaargroepen: Reken met niet-actieve, kant-en-klare exemplaren, die worden gebruikt om de begin- en automatische schaalaanpassing te verminderen. U kunt deze berekening maken met behulp van de gebruikersinterface, CLI of REST API.

Serverloze SQL-magazijnen: elastische berekeningen op aanvraag die worden gebruikt om SQL-opdrachten uit te voeren op gegevensobjecten in de SQL-editor of interactieve notebooks. U kunt SQL-warehouses maken met behulp van de GEBRUIKERSinterface, CLI of REST API.

Klassieke SQL-magazijnen: ingerichte rekenkracht die wordt gebruikt voor het uitvoeren van SQL-opdrachten op gegevensobjecten in de SQL-editor of interactieve notebooks. U kunt SQL-warehouses maken met behulp van de GEBRUIKERSinterface, CLI of REST API.

In de artikelen in deze sectie wordt beschreven hoe u kunt werken met rekenresources met behulp van de Gebruikersinterface van Azure Databricks. Zie De opdrachtregel en de Databricks REST API-verwijzing gebruiken voor andere methoden.

Databricks Runtime

Databricks Runtime is de set kernonderdelen die worden uitgevoerd op uw rekenproces. De Databricks Runtime is een configureerbare instelling voor het berekenen van taken voor alle doeleinden, maar automatisch geselecteerd in SQL Warehouses.

Elke Databricks Runtime-versie bevat updates die de bruikbaarheid, prestaties en beveiliging van big data-analyses verbeteren. De Databricks Runtime op uw rekenproces voegt veel functies toe, waaronder:

- Delta Lake, een opslaglaag van de volgende generatie die is gebouwd op Apache Spark, dat ACID-transacties, geoptimaliseerde indelingen en indexen biedt, en verbeteringen van de uitvoeringsengine voor het bouwen van gegevenspijplijnen. Zie Wat is Delta Lake?

- Geïnstalleerde Java-, Scala-, Python- en R-bibliotheken.

- Ubuntu en de bijbehorende systeembibliotheken.

- GPU-bibliotheken voor clusters met GPU-functionaliteit.

- Azure Databricks-services die kunnen worden geïntegreerd met andere onderdelen van het platform, zoals notebooks, taken en clusterbeheer.

Zie de releaseopmerkingen voor informatie over de inhoud van elke runtimeversie.

Runtimeversiebeheer

Databricks Runtime-versies worden regelmatig uitgebracht:

- Langetermijnondersteuningsversies worden vertegenwoordigd door een LTS-kwalificatie (bijvoorbeeld 3.5 LTS). Voor elke grote release declareren we een "canonieke" functieversie, waarvoor we drie volledige jaren ondersteuning bieden. Zie de ondersteuningslevenscycli van Databricks Runtime voor meer informatie.

- Primaire versies worden vertegenwoordigd door een verhoging van het versienummer dat voorafgaat aan het decimaalteken (bijvoorbeeld de sprong van 3,5 naar 4.0). Ze worden vrijgegeven wanneer er grote wijzigingen zijn, waarvan sommige mogelijk niet achterwaarts compatibel zijn.

- Functieversies worden weergegeven door een verhoging van het versienummer dat volgt op het decimaalteken (bijvoorbeeld de sprong van 3.4 naar 3,5). Elke primaire release bevat meerdere functiereleases. Functiereleases zijn altijd achterwaarts compatibel met eerdere versies binnen hun primaire release.

Feedback

Binnenkort beschikbaar: In de loop van 2024 zullen we GitHub-problemen geleidelijk uitfaseren als het feedbackmechanisme voor inhoud en deze vervangen door een nieuw feedbacksysteem. Zie voor meer informatie: https://aka.ms/ContentUserFeedback.

Feedback verzenden en weergeven voor