Inleiding tot instinctuele interacties

De filosofie van eenvoudige, instinctieve interacties is in het mixed reality-platform (MR) met elkaar vervlochten. We hebben drie stappen ondernomen om ervoor te zorgen dat toepassingsontwerpers en -ontwikkelaars hun klanten kunnen voorzien van eenvoudige en intuïtieve interacties.

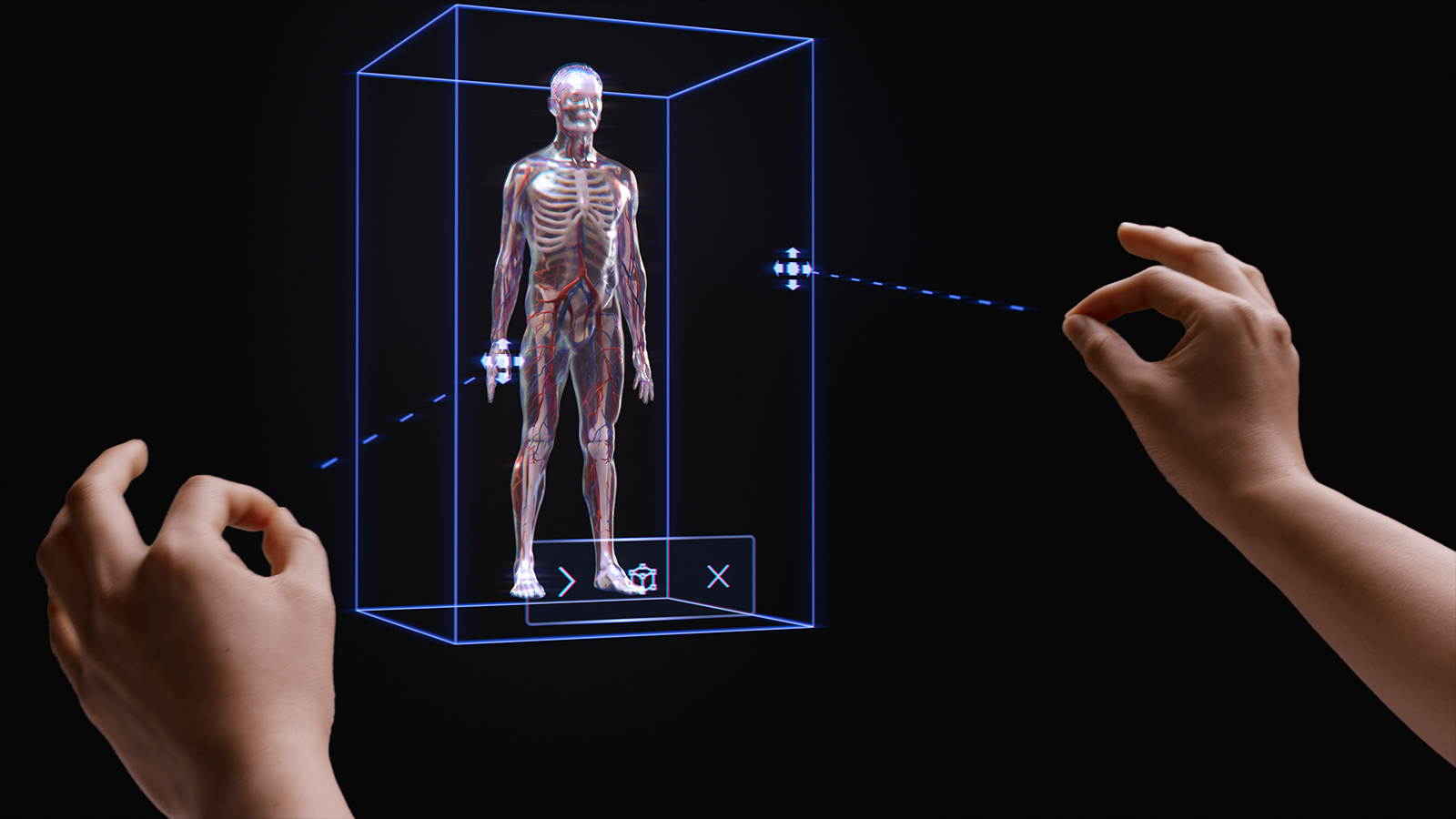

Ten eerste hebben we ervoor gezorgd dat onze sensoren en invoertechnologieën worden gecombineerd tot multimodale interactiemodellen. Deze interactiemodellen omvatten hand- en oogtracering samen met invoer in natuurlijke taal. Op basis van ons onderzoek is het ontwerpen en ontwikkelen binnen een multimodaal kader (en niet op basis van individuele input) de sleutel tot het creëren van instinctuele ervaringen.

Ten tweede erkennen we dat veel ontwikkelaars zich richten op meerdere HoloLens-apparaten, zoals HoloLens 2 en HoloLens (1e generatie) of HoloLens en VR. Daarom hebben we onze interactiemodellen ontworpen voor gebruik op verschillende apparaten, zelfs als de invoertechnologie op elk apparaat varieert. Verre interactie op een Windows Immersive-headset met een 6DoF-controller en HoloLens 2 beide identieke affordances en patronen gebruiken. Dit maakt het eenvoudig voor het ontwikkelen van toepassingen op meerdere apparaten en biedt een natuurlijk gevoel voor gebruikersinteracties.

Hoewel we erkennen dat er duizenden effectieve, boeiende en magische interacties mogelijk zijn in MR, hebben we ontdekt dat het opzettelijk toepassen van één interactiemodel in een toepassing de beste manier is om ervoor te zorgen dat gebruikers succesvol zijn en een geweldige ervaring hebben. Daarom hebben we drie dingen opgenomen in deze interactierichtlijnen:

- Specifieke richtlijnen voor de drie primaire interactiemodellen en de onderdelen en patronen die voor elk model zijn vereist.

- Aanvullende richtlijnen over andere voordelen die ons platform biedt.

- Algemene richtlijnen voor het selecteren van het juiste interactiemodel voor uw ontwikkelingsscenario.

Demo van eenvoudige handtracering en instinctuele interacties

Bekijk onze videodemo Hologrammen ontwerpen - Hoofdtracering en Oogtracering hieronder en ga verder met meer specifieke onderwerpen:

Deze video is afkomstig uit de HoloLens 2-app Hologrammen ontwerpen. Download en geniet hier van de volledige ervaring.

Multimodale interactiemodellen

Op basis van ons onderzoek en feedback van klanten hebben we ontdekt dat drie primaire interactiemodellen geschikt zijn voor de meeste mixed reality-ervaringen. In veel opzichten is het interactiemodel het mentale model van de gebruiker voor het voltooien van een werkstroom. Elk van deze interactiemodellen is geoptimaliseerd voor een set klantbehoeften en is handig, krachtig en bruikbaar wanneer het op de juiste manier wordt gebruikt.

De onderstaande grafiek is een vereenvoudigd overzicht. Gedetailleerde informatie voor het gebruik van elk interactiemodel wordt op de onderstaande pagina's gekoppeld met afbeeldingen en codevoorbeelden.

| Model | Voorbeeldscenario's | Geschikt voor | Hardware |

| Hand- en bewegingscontrollers | Ruimtelijke ervaringen in 3D, zoals ruimtelijke indeling en ontwerp, inhoudsmanipulatie, of simulatie. | Ideaal voor nieuwe gebruikers, gekoppeld aan spraak, oogcontact of hoofdbewegingen. Lage leercurve. Consistente UX tijdens het bijhouden van handbewegingen en voor 6DoF-controllers. | HoloLens 2 Immersive headsets |

| Handsfree | Contextuele ervaringen waarbij een gebruiker geen handen vrij heeft, zoals leren op de werkvloer, en onderhoud. | Enige training vereist. Als de gebruiker geen handen vrij heeft, kan het apparaat ook worden bediend via spraak en natuurlijke taal. | HoloLens 2 HoloLens (1e generatie) Immersive headsets |

| Staren en doorvoeren | Doorklikervaringen, bijvoorbeeld 3D-presentaties, demo's. | Vereist training op HMD's, maar niet op mobiele apparaten. Meest geschikt voor toegankelijke controllers. Geschikt voor HoloLens (1e generatie). | HoloLens 2 HoloLens (1e generatie) Immersive headsets Mobiele AR |

Om hiaten in de gebruikersinteractie te voorkomen, kunt u het beste de richtlijnen voor één model van begin tot eind volgen.

In de onderstaande secties worden de stappen beschreven voor het selecteren en implementeren van een van deze interactiemodellen.

Aan het einde van deze pagina begrijpt u onze richtlijnen voor:

- Een interactiemodel voor uw klant kiezen

- Het interactiemodel implementeren

- Overgang tussen interactiemodellen

- Volgende stappen ontwerpen

Een interactiemodel voor uw klant kiezen

Ontwikkelaars en makers hebben doorgaans nagedacht over de typen interacties die hun klanten kunnen hebben. Om een klantgerichte ontwerpbenadering aan te moedigen, raden we de volgende richtlijnen aan voor het selecteren van het interactiemodel dat is geoptimaliseerd voor uw klant.

Waarom deze richtlijnen volgen?

- We testen onze interactiemodellen op objectieve en subjectieve criteria, waaronder fysieke en cognitieve inspanning, intuïtiefheid en leerbaarheid.

- Omdat interacties verschillen, kunnen visuele/audio-affordances en objectgedrag verschillen tussen interactiemodellen.

- Het combineren van onderdelen van meerdere interactiemodellen creëert het risico van concurrerende affordances, zoals gelijktijdige handstralen en een hoofd-starencursor. Dit kan overweldigend zijn voor gebruikers en verwarrend werken.

Hier volgen enkele voorbeelden van hoe affordances en gedrag worden geoptimaliseerd voor elk interactiemodel. We zien vaak dat nieuwe gebruikers vergelijkbare vragen hebben, zoals 'hoe weet ik dat het systeem werkt', 'hoe weet ik wat ik kan doen' en 'hoe weet ik of het begreep wat ik net heb gedaan?'

| Model | Hoe kan ik weet dat het werkt? | weet Hoe kan ik wat ik kan doen? | Hoe kan ik weet wat ik net deed? |

| Hand- en bewegingscontrollers | Ik zie een handgaas, een vingertop betaalbaarheid of hand/controller stralen. | Ik zie grijpbare grepen of er wordt een begrenzingsvak weergegeven wanneer mijn hand zich in de buurt van een object bevindt. | Ik hoor hoor hoorbare tonen en zie animaties bij het ophalen en loslaten. |

| Hoofd staren en doorvoeren | Ik zie een cursor in het midden van mijn gezichtsveld. | De status van de cursor verandert wanneer deze zich boven bepaalde objecten bevindt. | Ik zie/hoor visuele en hoorbare bevestigingen wanneer ik actie onderneem. |

| Handsfree (hoofd-staren en wonen) | Ik zie een cursor in het midden van mijn gezichtsveld. | Ik zie een voortgangsindicator wanneer ik me op een interactief object fix. | Ik zie/hoor visuele en hoorbare bevestigingen wanneer ik actie onderneem. |

| Handsfree (spraakopdrachten) | Ik zie een luisterindicator en bijschriften die laten zien wat het systeem heeft gehoord. | Ik krijg spraakprompts en hints. Als ik zeg: "Wat kan ik zeggen?" Ik zie feedback. | Ik zie/hoor visuele en hoorbare bevestigingen wanneer ik een opdracht geef, of krijg ondubbelzinnige UX wanneer dat nodig is. |

Hieronder vindt u vragen die we hebben gevonden bij het selecteren van een interactiemodel door teams:

V: Willen mijn gebruikers hologrammen aanraken en holografische precisiebewerkingen uitvoeren?

A: Als dat het zo is, bekijkt u het interactiemodel handen en bewegingscontrollers voor precisie richten en manipuleren.V: Moeten mijn gebruikers hun handen vrij houden voor taken in de echte wereld?

A: Zo ja, bekijk dan het handsfree-interactiemodel, dat een geweldige handsfree-ervaring biedt door middel van staren en spraakgebaseerde interacties.V: Hebben mijn gebruikers tijd om interacties voor mijn MR-toepassing te leren of hebben ze de interacties nodig met de laagst mogelijke leercurve?

A: Voor de laagste leercurve en de meest intuïtieve interacties raden we het model Handen en bewegingscontrollers aan, zolang gebruikers hun handen voor interactie kunnen gebruiken.V: Gebruiken mijn gebruikers bewegingscontrollers voor aanwijzen en bewerken?

A: Het model Handen en bewegingscontrollers bevat alle richtlijnen voor een geweldige ervaring met bewegingscontrollers.V: Gebruiken mijn gebruikers een toegankelijkheidscontroller of een algemene Bluetooth-controller, zoals een clicker?

A: We raden het model Head-staren en doorvoeren aan voor alle niet-getraceerde controllers. Het is ontworpen om een gebruiker in staat te stellen een hele ervaring te doorlopen met een eenvoudig mechanisme voor doel en doorvoer.V: Gaan mijn gebruikers alleen door een ervaring door te 'doorklikken' (bijvoorbeeld in een 3D-diavoorstellingachtige omgeving), in plaats van door compacte indelingen van UI-besturingselementen te navigeren?

A: Als gebruikers niet veel gebruikersinterfaces hoeven te beheren, biedt Head-staren en doorvoeren een leerbare optie waarbij gebruikers zich geen zorgen hoeven te maken over targeting.V: Gebruiken mijn gebruikers zowel HoloLens (1e generatie) als HoloLens 2/Windows Mixed Reality immersive headsets (VR)?

A: Aangezien Head-staren en doorvoeren het interactiemodel zijn voor HoloLens (1e generatie), raden we aan dat makers die HoloLens (1e generatie) ondersteunen, Head-staren en doorvoeren gebruiken voor alle functies of modi die gebruikers ervaren op een HoloLens-headset (1e generatie). Zie de volgende sectie over het overzetten van interactiemodellen voor meer informatie over het maken van een geweldige ervaring voor meerdere HoloLens-generaties.V: Hoe zit het met gebruikers die mobiel zijn, een grote ruimte beslaan of tussen ruimten bewegen, versus gebruikers die vaak in één ruimte werken?

A: Elk van de interactiemodellen werkt voor deze gebruikers.

Notitie

Meer richtlijnen die specifiek zijn voor het ontwerpen van apps, komen binnenkort beschikbaar.

Interactiemodellen overzetten

Er zijn ook gebruiksvoorbeelden waarvoor mogelijk meer dan één interactiemodel moet worden gebruikt. De aanmaakstroom van uw toepassing maakt bijvoorbeeld gebruik van het interactiemodel 'handen en bewegingscontrollers' , maar u wilt een handsfreemodus gebruiken voor veldtechnici. Als uw ervaring meerdere interactiemodellen vereist, kunnen gebruikers mogelijk moeite hebben om van het ene model naar het andere over te stappen, met name wanneer ze nog geen ervaring hebben met mixed reality.

Notitie

We werken voortdurend aan meer richtlijnen die beschikbaar zullen zijn voor ontwikkelaars en ontwerpers en informeren hen over het hoe, wanneer en waarom voor het gebruik van meerdere MR-interactiemodellen.