Rozpoznawanie mowy i analiza zarejestrowanych połączeń klientów mogą zapewnić firmie cenne informacje na temat bieżących trendów, niedociągnięć produktów i sukcesów.

Przykładowe rozwiązanie opisane w tym artykule zawiera powtarzalny potok do transkrypcji i analizowania danych konwersacji.

Architektura

Architektura składa się z dwóch potoków: potoku transkrypcji w celu konwersji dźwięku na tekst oraz potoku wzbogacania i wizualizacji.

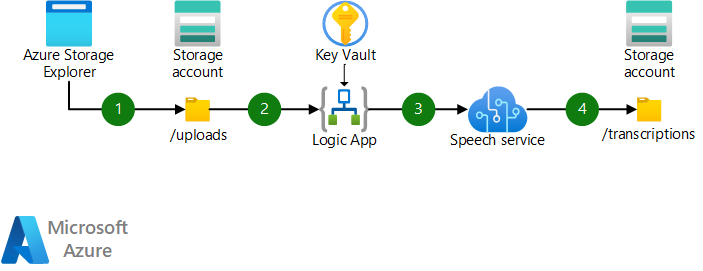

Potok transkrypcji

Pobierz plik programu Visio z tą architekturą.

Przepływ danych

- Pliki audio są przekazywane do konta usługi Azure Storage za pośrednictwem dowolnej obsługiwanej metody. Możesz użyć narzędzia opartego na interfejsie użytkownika, takiego jak Eksplorator usługi Azure Storage lub zestawu SDK magazynu lub interfejsu API.

- Przekazywanie do usługi Azure Storage wyzwala aplikację logiki platformy Azure. Aplikacja logiki uzyskuje dostęp do wszelkich niezbędnych poświadczeń w usłudze Azure Key Vault i wysyła żądanie do interfejsu API transkrypcji wsadowej usługi Mowa.

- Aplikacja logiki przesyła wywołanie plików audio do usługi Mowa, w tym opcjonalne ustawienia dotyczące diaryzacji osoby mówiącej.

- Usługa mowa kończy transkrypcję wsadową i ładuje wyniki transkrypcji do konta magazynu.

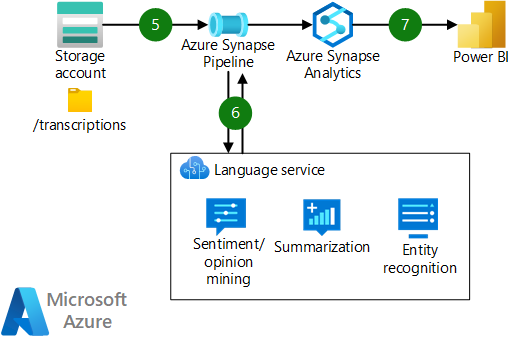

Wzbogacanie i potok wizualizacji

Pobierz plik programu Visio z tą architekturą.

Przepływ danych

- Potok usługi Azure Synapse Analytics jest uruchamiany w celu pobrania i przetworzenia transkrypcji tekstu audio.

- Potok wysyła przetworzony tekst za pośrednictwem wywołania interfejsu API do usługi językowej. Usługa wykonuje różne wzbogacania przetwarzania języka naturalnego (NLP), takie jak wyszukiwanie tonacji i opinii, podsumowanie oraz niestandardowe i wstępnie utworzone rozpoznawanie nazwanych jednostek.

- Przetworzone dane są przechowywane w puli SQL usługi Azure Synapse Analytics, gdzie można je obsłużyć do narzędzi do wizualizacji, takich jak power BI.

Składniki

- Azure Blob Storage. Wysoce skalowalny i bezpieczny magazyn obiektów dla obciążeń natywnych dla chmury, archiwów, magazynów typu data lake, obliczeń o wysokiej wydajności i uczenia maszynowego. W tym rozwiązaniu przechowuje pliki audio i wyniki transkrypcji oraz służy jako usługa data lake do analizy podrzędnej.

- Usługa Azure Logic Apps. Platforma integracji jako usługa (iPaaS), która jest oparta na konteneryzowanym środowisku uruchomieniowym. W tym rozwiązaniu integruje usługi magazynu i sztucznej inteligencji mowy.

- Usługa rozpoznawania mowy sztucznej inteligencji. Interfejs API oparty na sztucznej inteligencji, który zapewnia funkcje mowy, takie jak zamiana mowy na tekst, zamiana tekstu na mowę, tłumaczenie mowy i rozpoznawanie osoby mówiącej. Jej funkcja transkrypcji wsadowej jest używana w tym rozwiązaniu.

- Język sztucznej inteligencji. Usługa zarządzana oparta na sztucznej inteligencji, która zapewnia funkcje języka naturalnego, takie jak analiza tonacji, wyodrębnianie jednostek i automatyczne odpowiadanie na pytania.

- Azure Synapse Analytics. Pakiet usług zapewniających integrację danych, magazynowanie danych przedsiębiorstwa i analizę danych big data. W tym rozwiązaniu przekształca i wzbogaca dane transkrypcji oraz udostępnia dane do narzędzi do wizualizacji podrzędnych.

- Power BI. Narzędzie do modelowania danych i analizy wizualnej. W tym rozwiązaniu przedstawia transkrypcji szczegółowe informacje audio dla użytkowników i osób podejmujących decyzje.

Alternatywy

Oto kilka alternatywnych podejść do tej architektury rozwiązania:

- Rozważ skonfigurowanie konta usługi Blob Storage do korzystania z hierarchicznej przestrzeni nazw. Ta konfiguracja zapewnia mechanizmy kontroli dostępu (ACL) oparte na zabezpieczeniach i mogą zwiększyć wydajność niektórych obciążeń danych big data.

- Możesz użyć usługi Azure Functions jako narzędzia integracji opartego na kodzie zamiast potoków usługi Logic Apps lub Azure Synapse, w zależności od rozmiaru i skali obciążenia.

Szczegóły scenariusza

Centra obsługi klienta są integralną częścią sukcesu wielu firm w wielu branżach. To rozwiązanie korzysta z interfejsu API rozpoznawania mowy z usług azure AI na potrzeby transkrypcji audio i diaryzacji zarejestrowanych wywołań klientów. Usługa Azure Synapse Analytics służy do przetwarzania i wykonywania zadań NLP, takich jak analiza tonacji i niestandardowe rozpoznawanie nazwanych jednostek za pomocą wywołań interfejsu API do języka sztucznej inteligencji.

Usług i potoku opisanych tutaj można używać do przetwarzania transkrypcji tekstu w celu rozpoznawania i usuwania poufnych informacji, przeprowadzania analizy tonacji i nie tylko. Możesz skalować usługi i potok, aby uwzględnić dowolną ilość zarejestrowanych danych.

Potencjalne przypadki użycia

To rozwiązanie może stanowić wartość dla organizacji w wielu branżach, w tym usług telekomunikacyjnych, usług finansowych i instytucji rządowych. Dotyczy to każdej organizacji, która rejestruje konwersacje. W szczególności centra telefoniczne lub wewnętrzne centra telefoniczne lub działy pomocy technicznej mogą korzystać ze szczegółowych informacji uzyskanych z tego rozwiązania.

Kwestie wymagające rozważenia

Te zagadnienia implementują filary platformy Azure Well-Architected Framework, która jest zestawem wytycznych, których można użyć do poprawy jakości obciążenia. Aby uzyskać więcej informacji, zobacz Microsoft Azure Well-Architected Framework.

Zabezpieczenia

Zabezpieczenia zapewniają ochronę przed celowymi atakami i nadużyciami cennych danych i systemów. Aby uzyskać więcej informacji, zobacz Omówienie filaru zabezpieczeń.

- Żądanie interfejsu API rozpoznawania mowy może zawierać identyfikator URI sygnatury dostępu współdzielonego (SAS) dla kontenera docelowego w usłudze Azure Storage. Identyfikator URI sygnatury dostępu współdzielonego umożliwia usłudze Mowa bezpośrednie wyprowadzanie plików transkrypcji do lokalizacji kontenera. Jeśli twoja organizacja nie zezwala na używanie identyfikatorów URI sygnatur dostępu współdzielonego na potrzeby magazynu, musisz zaimplementować funkcję, aby okresowo sondować interfejs API rozpoznawania mowy pod kątem ukończonych zasobów.

- Poświadczenia, takie jak konto lub klucze interfejsu API, powinny być przechowywane w usłudze Azure Key Vault jako wpisy tajne. Skonfiguruj aplikacje logiki i potoki usługi Azure Synapse, aby uzyskać dostęp do magazynu kluczy przy użyciu tożsamości zarządzanych, aby uniknąć przechowywania wpisów tajnych w ustawieniach aplikacji lub kodzie.

- Pliki audio przechowywane w obiekcie blob mogą zawierać poufne dane klienta. Jeśli wielu klientów korzysta z rozwiązania, musisz ograniczyć dostęp do tych plików. Użyj hierarchicznej przestrzeni nazw na koncie magazynu i wymuś uprawnienia na poziomie folderu i pliku, aby ograniczyć dostęp tylko do wymaganego wystąpienia firmy Microsoft Entra.

Optymalizacja kosztów

Optymalizacja kosztów dotyczy sposobów zmniejszenia niepotrzebnych wydatków i poprawy wydajności operacyjnej. Aby uzyskać więcej informacji, zobacz Omówienie filaru optymalizacji kosztów.

Wszystkie usługi platformy Azure opisane w tej architekturze zapewniają opcję rozliczeń zgodnie z rzeczywistym użyciem, więc koszty rozwiązania są skalowane liniowo.

Usługa Azure Synapse oferuje opcję bezserwerowych pul SQL, dzięki czemu obliczenia obciążenia magazynowania danych mogą być skalowane na żądanie. Jeśli nie używasz usługi Azure Synapse do obsługi innych podrzędnych przypadków użycia, rozważ użycie bezserwerowego w celu zmniejszenia kosztów.

Zobacz Omówienie filaru optymalizacji kosztów, aby uzyskać więcej strategii optymalizacji kosztów.

Aby uzyskać cennik usług sugerowanych tutaj, zobacz to oszacowanie w kalkulatorze cen platformy Azure.

Efektywność wydajności

Efektywność wydajności to możliwość skalowania obciążenia w celu zaspokojenia zapotrzebowania użytkowników w wydajny sposób. Aby uzyskać więcej informacji, zobacz Omówienie filaru wydajności.

Interfejs API rozpoznawania mowy wsadowej został zaprojektowany pod kątem dużego woluminu, ale inne interfejsy API usług AI platformy Azure mogą mieć limity żądań dla każdej warstwy subskrypcji. Rozważ konteneryzowanie tych interfejsów API, aby uniknąć ograniczania przetwarzania dużych woluminów. Kontenery zapewniają elastyczność wdrażania, w chmurze lub środowisku lokalnym. Można również ograniczyć skutki uboczne nowych wdrożeń wersji przy użyciu kontenerów. Aby uzyskać więcej informacji, zobacz Obsługa kontenerów w usługach Azure AI.

Współautorzy

Ten artykuł jest obsługiwany przez firmę Microsoft. Pierwotnie został napisany przez następujących współautorów.

Autorzy zabezpieczeń:

- Dhanashri Kshirsagar | Starszy menedżer programu zawartości

- Brady Leavitt | Dir Specialist GBB

- Kirpa Singh | Starszy inżynier oprogramowania

- Christina Skarpathiotaki | Architekt rozwiązań w chmurze

Inny współautor:

- Mick Alberts | Składnik zapisywania technicznego

Aby wyświetlić niepubalne profile serwisu LinkedIn, zaloguj się do serwisu LinkedIn.

Następne kroki

- Szybki start: rozpoznawanie i konwertowanie mowy na tekst

- Szybki start: tworzenie przepływu pracy integracji z wielodostępną usługą Azure Logic Apps i witryną Azure Portal

- Szybki start: wprowadzenie do programu Language Studio

- Usługi azure AI w usłudze Azure Synapse Analytics

- Co to jest usługa rozpoznawania mowy?

- Co to jest Azure Logic Apps?

- Co to jest język sztucznej inteligencji?

- Co to jest usługa Azure Synapse Analytics?

- Wyodrębnianie szczegółowych informacji z tekstu za pomocą usługi językowej

- Modelowanie, wykonywanie zapytań i eksplorowanie danych w usłudze Azure Synapse