Criar um assistente de voz sem código no Azure Percept Studio

Importante

Desativação do Azure Percept DK:

Atualização de 22 de fevereiro de 2023: uma atualização de firmware para os componentes do acessório Percept DK Vision and Audio (também conhecido como Som de Visão e Áudio) agora está disponível aqui e permitirá que os componentes acessórios continuem funcionando além da data de desativação.

A versão prévia pública do Azure Percept estará evoluindo para dar suporte a novas plataformas de dispositivos de borda e experiências de desenvolvedor. Como parte dessa evolução, o Azure Percept DK e o Audio Accessory e os serviços de suporte associados do Azure para o Percept DK serão desativados em 30 de março de 2023.

A partir de 30 de março de 2023, o Azure Percept DK e o Audio Accessory não terão mais suporte de nenhum serviço do Azure, incluindo o Azure Percept Studio, atualizações do sistema operacional, atualizações de contêineres, exibição de fluxo da Web e integração de Visão Personalizada. A Microsoft não fornecerá mais suporte de sucesso do cliente e quaisquer serviços de suporte associados. Para obter mais informações, visite a Postagem no blog sobre o aviso de desativação.

Neste tutorial, você criará um assistente de voz de um modelo para usar com o Azure Percept DK e o Áudio do Azure Percept. A demonstração do assistente de voz é executada no Azure Percept Studio e contém uma seleção de objetos virtuais controlados por voz. Para controlar um objeto, diga sua palavra-chave, que é uma palavra ou frase curta que ativa seu dispositivo, seguida por um comando. Cada modelo responde a um conjunto de comandos específicos.

Este guia orientará você pelo processo de configuração de seus dispositivos, criando um assistente de voz e os recursos de Serviços de Fala necessários, testando seu assistente de voz, configurando sua palavra-chave e criando palavras-chaves personalizadas.

Pré-requisitos

- Azure Percept DK (kit de desenvolvimento)

- Áudio do Azure Percept

- Alto-falante ou fones de ouvido que podem ser conectados à entrada de áudio de 3,5 mm (opcional)

- Assinatura do Azure

- Experiência de instalação do Azure Percept DK: você conectou o kit de desenvolvimento a uma rede Wi-Fi, criou um Hub IoT e conectou o kit de desenvolvimento ao Hub IoT

- Configuração do Áudio do Azure Percept

Criar um assistente de voz usando um modelo disponível

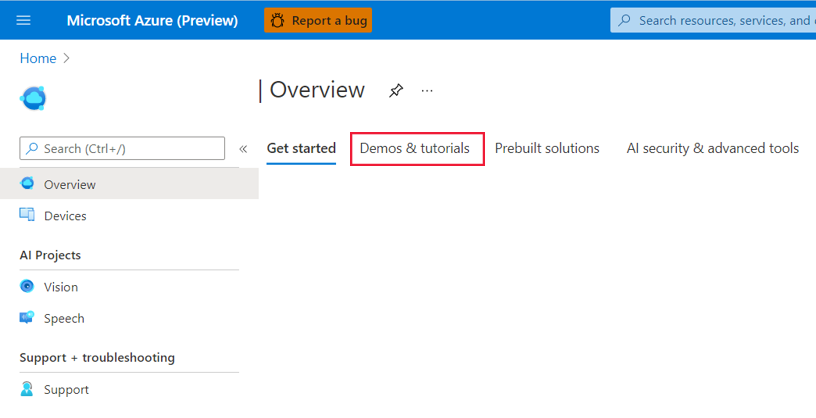

Navegar para o Azure Percept Studio.

Abra a guia Demonstrações e tutoriais.

Clique em Experimentar modelos do assistente de voz em Tutoriais e demonstrações de fala. Isso abrirá uma janela no lado direito da tela.

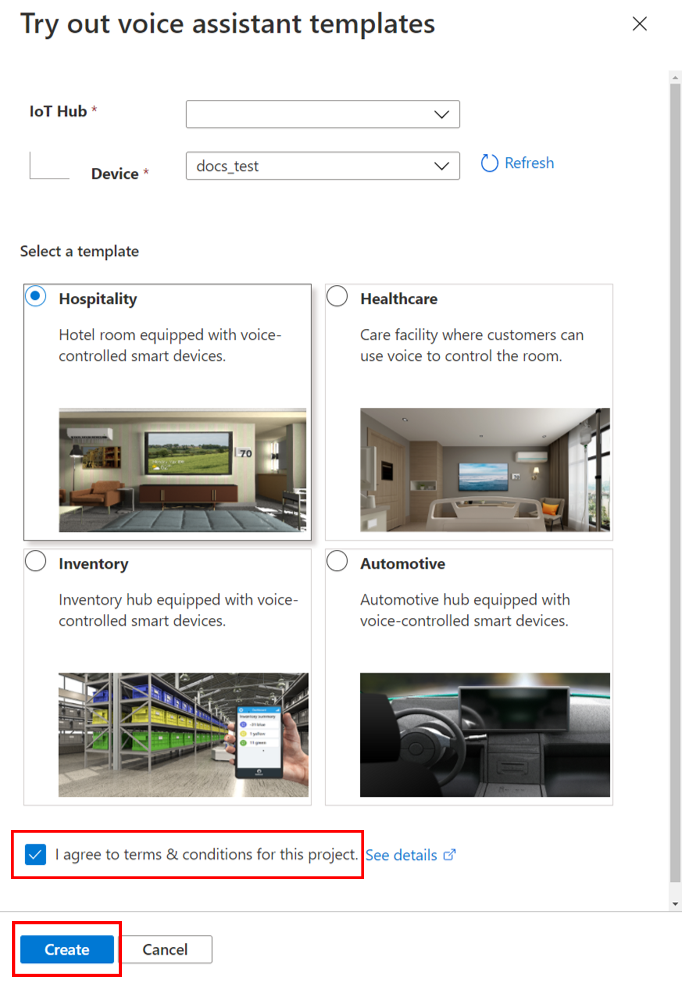

Nessa janela, faça o seguinte:

No menu suspenso Hub IoT, selecione o Hub IoT ao qual seu devkit está conectado.

No menu suspenso Dispositivo, selecione seu devkit.

Selecione um dos modelos disponíveis do assistente de voz.

Clique na caixa de seleção Eu concordo com os termos e condições deste projeto.

Clique em Criar.

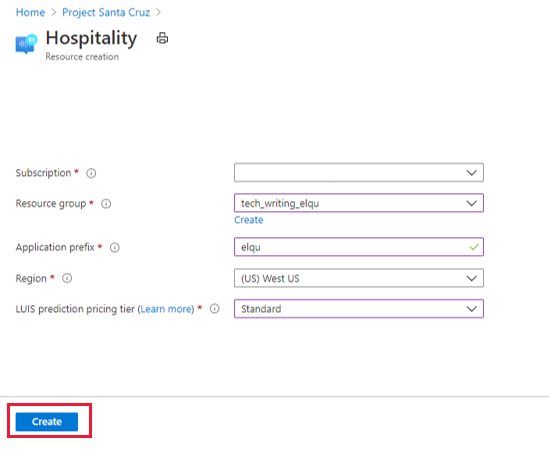

Depois de clicar em Criar, o portal abre outra janela para criar o recurso de tema de fala. Nessa janela, faça o seguinte:

Selecione a assinatura do Azure na caixa Assinatura.

Selecione o grupo de recursos preferencial no menu suspenso Grupo de recursos. Se você quiser criar um grupo de recursos para usar com o assistente de voz, clique em Criar no menu suspenso e siga os prompts.

Para o Prefixo do aplicativo, insira um nome. Esse será o prefixo do projeto e o nome de comando personalizado.

Em Região, selecione a região na qual os recursos serão implantados.

Em Tipo de preço de previsão do LUIS, selecione Standard (a camada gratuita não dá suporte a solicitações de fala).

Selecione o botão Criar. Os recursos do aplicativo de assistente de voz serão implantados em sua assinatura.

Aviso

NÃO feche a janela até que o portal conclua a implantação do recurso. O fechamento prematuro da janela pode resultar em um comportamento inesperado do assistente de voz. Depois que o recurso tiver sido implantado, a demonstração será exibida.

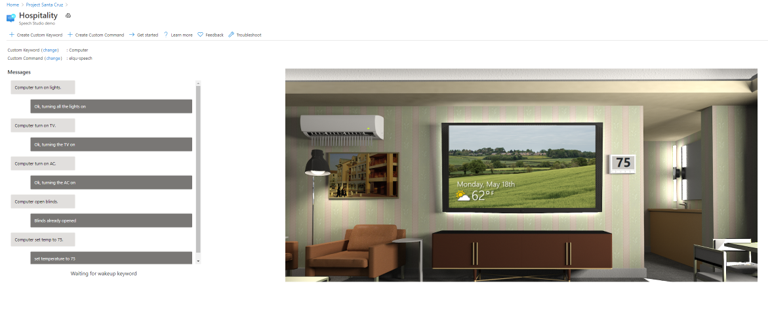

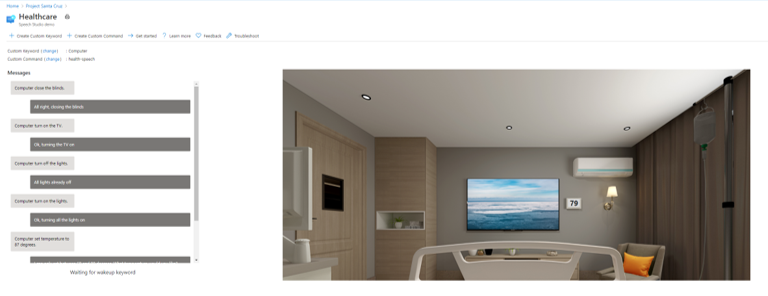

Testar o assistente de voz

Para interagir com o assistente de voz, diga a palavra-chave seguida por um comando. Quando o SoM Ear reconhecer sua palavra-chave, o dispositivo emitirá um alarme (que você poderá ouvir se um alto-falante ou fone de ouvido estiver conectado) e os LEDs piscarão em azul. Os LEDs mudarão para azul em rápida intermitência enquanto o comando for processado. A resposta do assistente de voz para o comando será impressa em texto na janela de demonstração e emitida de maneira audível por meio de fones de ouvido/alto-falantes. A palavra-chave padrão (listada ao lado de Palavra-chave Personalizada) é definida como "Computer", e cada modelo tem um conjunto de comandos compatíveis que permitem que você interaja com objetos virtuais na janela de demonstração. Por exemplo, se você estiver usando a demonstração de hospedagem ou saúde, diga "Computador, ligar TV" para ligar a TV virtual.

Comandos de demonstração de hotelaria e saúde

Ambas as demonstrações de saúde e hotelaria têm TVs virtuais, luzes, persianas e termostatos conectados com os quais você pode interagir. Os seguintes comandos (e variações adicionais) são compatíveis:

- "Ligar/desligar luzes."

- "Ligar/desligar TV."

- "Ligar/desligar ar-condicionado."

- "Abrir/fechar as persianas".

- "Definir a temperatura como X graus". (X é a temperatura desejada, por exemplo, 25.)

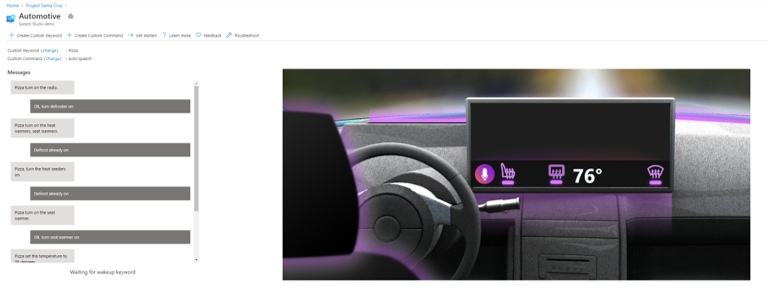

Comandos de demonstração automotiva

A demonstração automotiva tem um aquecedor de assento, um descongelador e um termostato virtuais com os quais você pode interagir. Os seguintes comandos (e variações adicionais) são compatíveis:

- "Ligar/desligar descongelador."

- "Ligar/desligar aquecedor de assento."

- "Definir a temperatura como X graus". (X é a temperatura desejada, por exemplo, 25.)

- "Aumentar/diminuir a temperatura em Y graus."

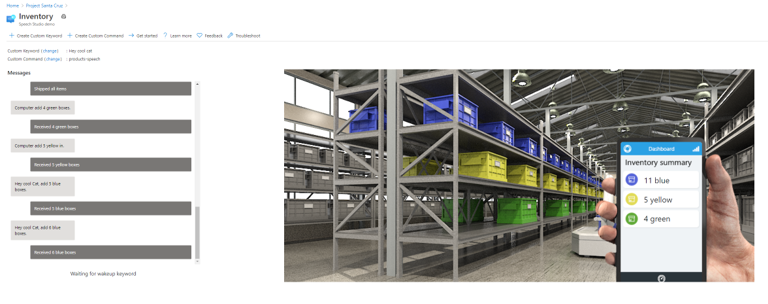

Comandos de demonstração de inventário

A demonstração de inventário tem uma seleção de caixas azuis, amarelas e verdes virtuais com as quais é possível interagir, junto com um aplicativo de inventário virtual. Os seguintes comandos (e variações adicionais) são compatíveis:

- "Adicionar/remover X caixas". (X é o número de caixas, por exemplo, 4.)

- "Solicitar/enviar X caixas".

- "Quantas caixas estão em estoque?"

- "Contar caixas Y." (Y é a cor das caixas, por exemplo, amarelas.)

- "Enviar tudo o que está em estoque".

Configurar sua palavra-chave

Você pode personalizar a palavra-chave do seu aplicativo de assistente de voz.

Clique em alterar ao lado de Palavra-chave Personalizada na janela de demonstração.

Selecione uma das palavras-chave disponíveis. Você poderá escolher entre uma seleção de palavras-chave de amostra e as palavras-chave personalizadas que você tenha criado.

Clique em Save (Salvar).

Criar uma palavra-chave personalizada

Você pode criar sua própria palavra-chave para o aplicativo de voz. O treinamento para a palavra-chave personalizada pode ser concluído em apenas alguns minutos.

Clique em + Criar Palavra-chave Personalizada próximo à parte superior da janela de demonstração.

Insira a palavra-chave desejada, a qual pode ser uma única palavra ou uma frase curta.

Selecione o seu Recurso de fala (que está listado próximo a Comando Personalizado na janela de demonstração e contém o prefixo do seu aplicativo).

Clique em Save (Salvar).

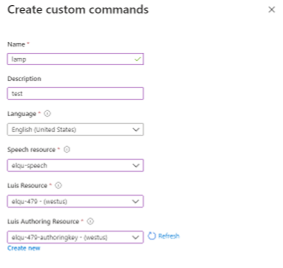

Criar um comando personalizado

O portal também fornece funcionalidade para a criação de comandos personalizados com recursos de fala existentes. "Comando personalizado" refere-se ao próprio aplicativo de assistente de voz, não a um comando específico dentro do aplicativo existente. Ao criar um comando personalizado, você cria um projeto de fala, que você precisa continuar a desenvolver no Speech Studio.

Para criar um comando personalizado de dentro da janela de demonstração, clique em + Criar Comando Personalizado na parte superior da página e faça o seguinte:

Insira um nome para o comando personalizado.

Insira uma descrição do projeto (opcional).

Selecione o idioma preferido.

Selecione o recurso de fala.

Selecione o recurso LUIS.

Selecione seu recurso de criação do LUIS ou crie um.

Clique em Criar.

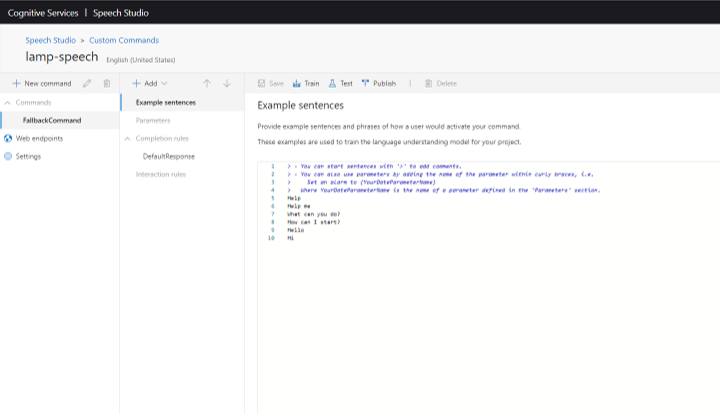

Depois de criar um comando personalizado, você precisa ir para o Speech Studio para continuar a desenvolvê-lo. Se você abrir o Speech Studio e não vir o comando personalizado listado, siga estas etapas:

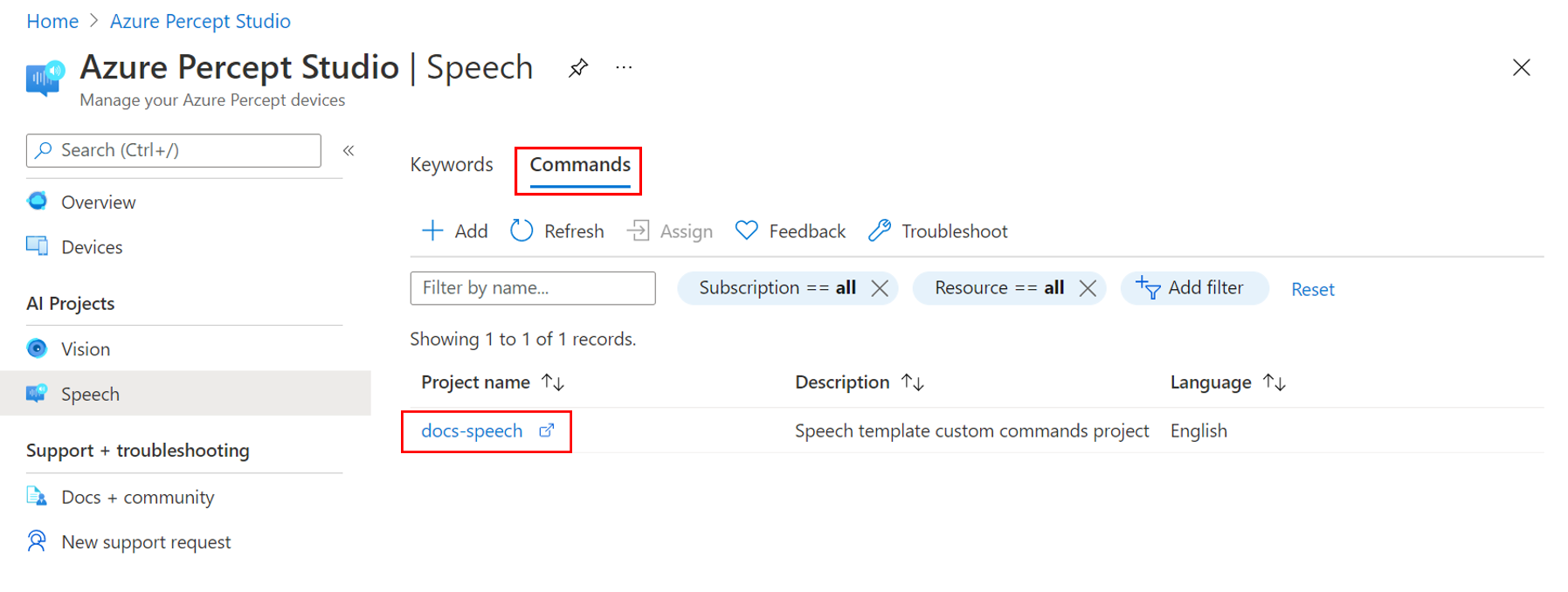

No painel de menu à esquerda no Azure Percept Studio, clique em Fala em Projetos de IA.

Selecione a guia Comandos.

Selecione o comando personalizado que você deseja desenvolver. Isso abre o projeto no Speech Studio.

Para obter mais informações sobre como desenvolver comandos personalizados, confira a Documentação do Serviço de Fala.

Solução de problemas

O assistente de voz foi criado, mas não responde a comandos

Verifique as luzes do LED na placa intermediária:

- Três luzes azuis sólidas indicam que o assistente de voz está pronto e aguardando a palavra-chave.

- Se o LED central (L02) estiver branco, o devkit terá concluído a inicialização e precisará ser configurado com uma palavra-chave.

- Se o LED central (L02) estiver piscando em branco, significa que o SoM de áudio ainda não concluiu a inicialização. A inicialização pode demorar alguns minutos para ser concluída.

Para obter mais informações sobre os indicadores de LED, confira o artigo sobre o LED.

O assistente de voz não responde a uma palavra-chave personalizada criada no Speech Studio

Isso poderá ocorrer se o módulo de fala estiver desatualizado. Siga estas etapas para atualizar o módulo de fala para a versão mais recente:

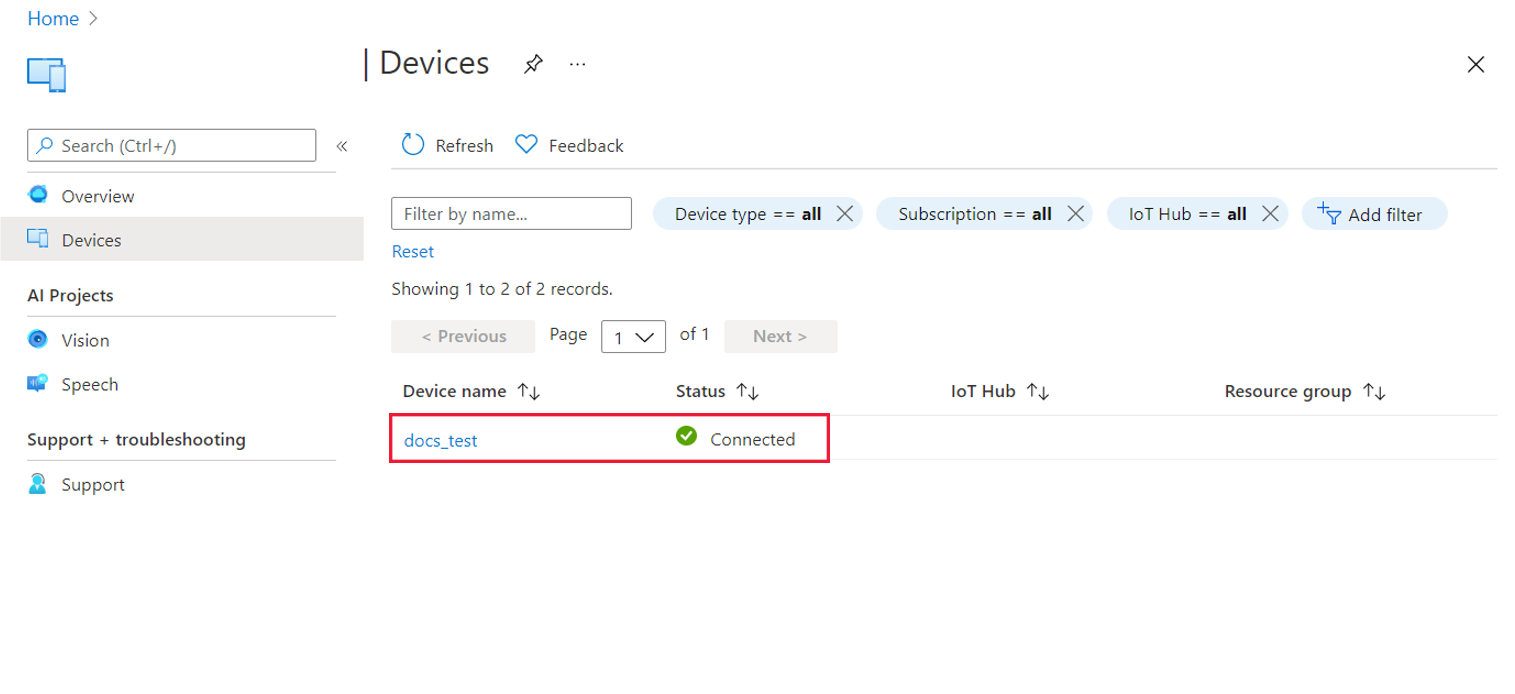

Clique em Dispositivos no painel de menu à esquerda da home page do Azure Percept Studio.

Localize e selecione o dispositivo.

Na janela do dispositivo, selecione a guia Fala.

Verifique a versão do módulo de fala. Se uma atualização estiver disponível, você verá um botão de Atualização ao lado do número de versão.

Clique em Atualizar para implantar a atualização do módulo de fala. O processo de atualização geralmente leva de 2 a 3 minutos para ser concluído.

Limpar os recursos

Quando terminar de trabalhar com seu aplicativo de assistente de voz, siga estas etapas para limpar os recursos de fala implantados durante este tutorial:

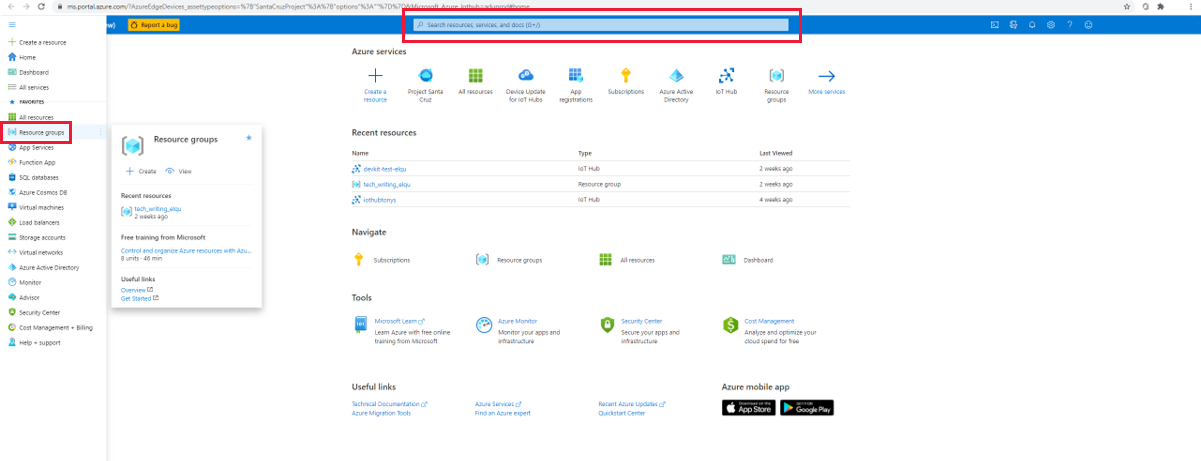

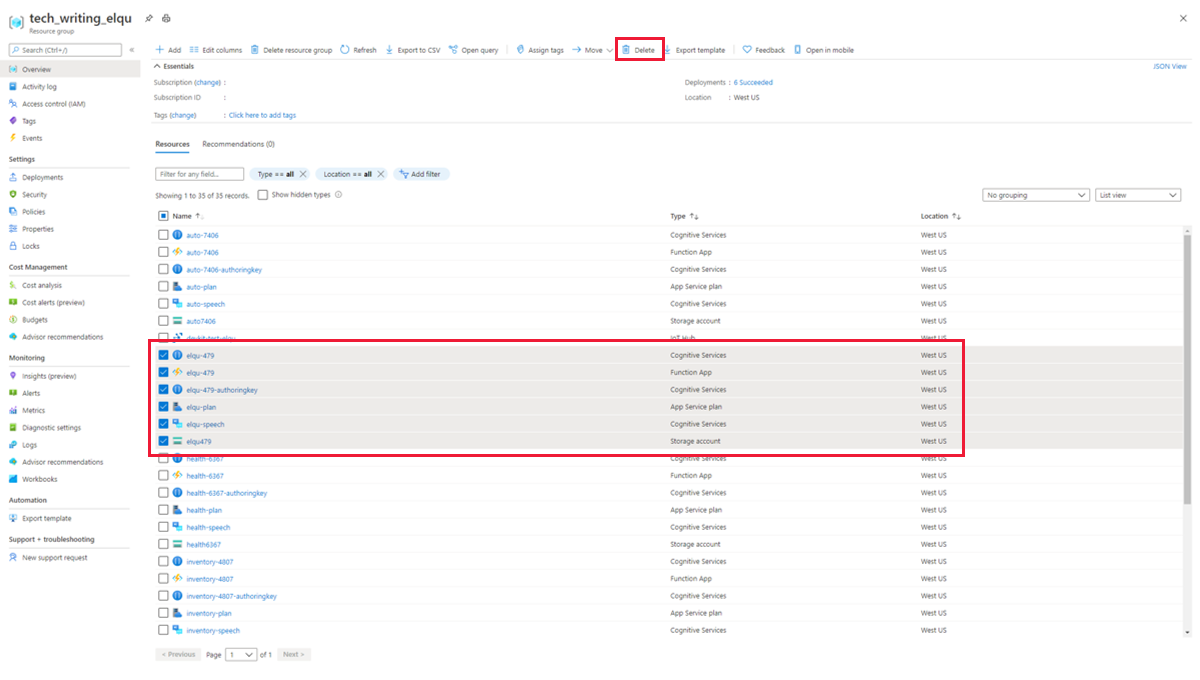

No portal do Azure, selecione Grupos de recursos no painel de menu à esquerda ou digite isso na barra de pesquisa.

Selecione o grupo de recursos.

Selecione todos os seis recursos que contêm o prefixo do aplicativo e clique no ícone Excluir no painel de menu superior.

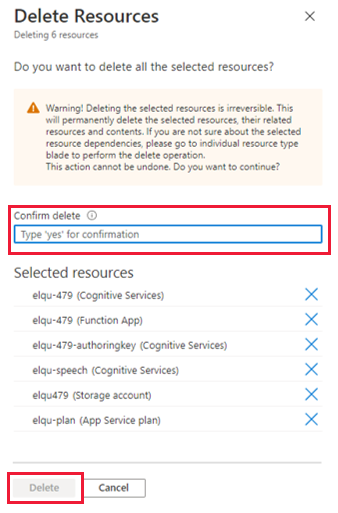

Para confirmar a exclusão, digite sim na caixa de confirmação, verifique se você selecionou os recursos corretos e clique em Excluir.

Aviso

Isso removerá todas as palavras-chave personalizadas criadas com os recursos de fala que você está excluindo, e a demonstração do assistente de voz deixará de funcionar.

Próximas etapas

Agora que você criou uma solução de fala sem código, tente criar uma solução de pesquisa visual sem código para o Azure Percept DK.