Se a atividade de condição nos pipelines do Azure Data Factory e do Synapse Analytics

APLICA-SE A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Gorjeta

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange tudo, desde a movimentação de dados até ciência de dados, análises em tempo real, business intelligence e relatórios. Saiba como iniciar uma nova avaliação gratuitamente!

A atividade Se Condição disponibiliza a mesma funcionalidade que as instruções “se” fornecem nas linguagens de programação. Ele executa um conjunto de atividades quando a condição é avaliada e true outro conjunto de atividades quando a condição é avaliada como false.

Criar uma atividade If Condition com a interface do usuário

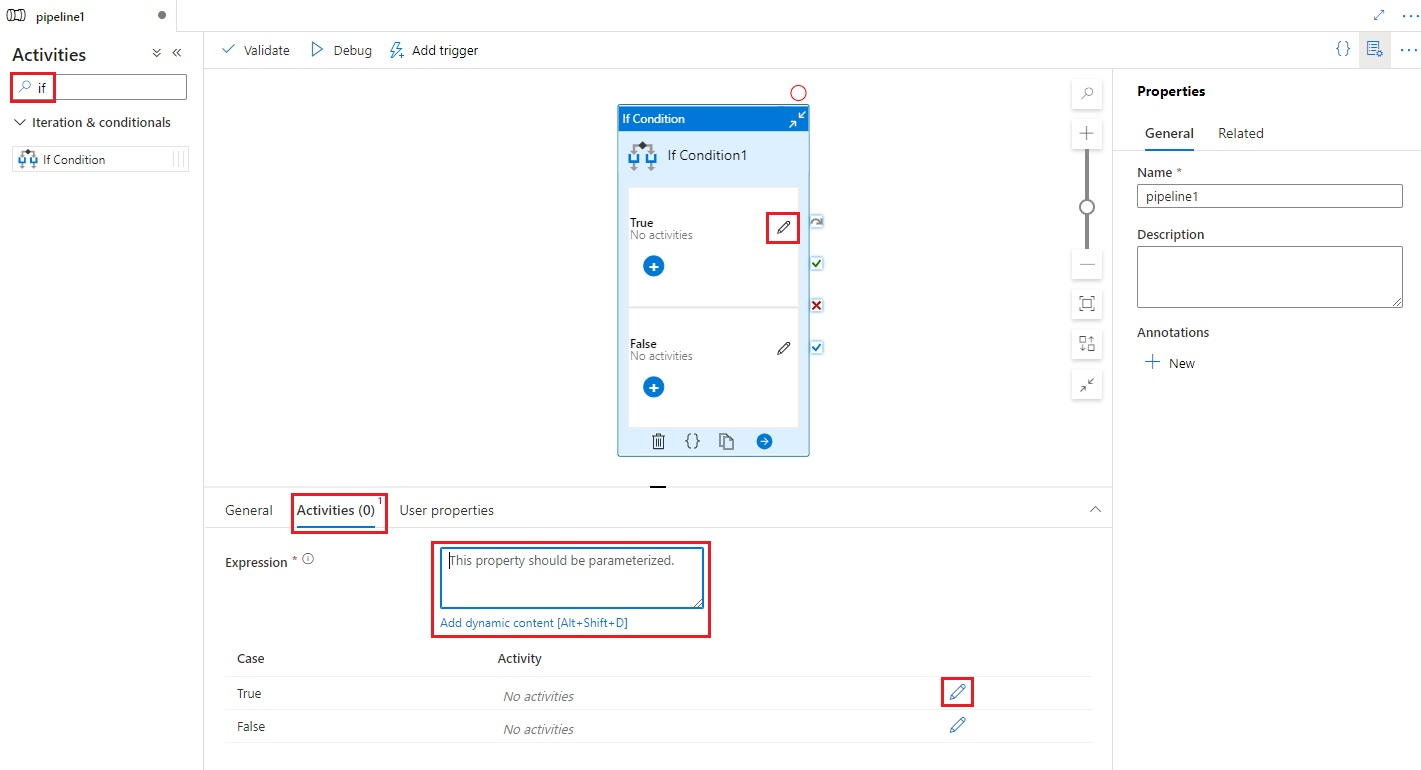

Para usar uma atividade If Condition em um pipeline, conclua as seguintes etapas:

Procure Se no painel Atividades do pipeline e arraste uma atividade Se Condição para a tela do pipeline.

Selecione a nova atividade Se Condição na tela, se ainda não estiver selecionada, e a guia Atividades para editar seus detalhes.

Insira uma expressão que retorne um valor booleano verdadeiro ou falso. Pode ser qualquer combinação de expressões dinâmicas , funções, variáveis de sistema ou saídas de outras atividades.

Selecione os botões Editar Atividades na guia Atividades para a Condição If ou diretamente na Condição If na tela do pipeline para adicionar atividades que serão executadas quando a expressão for avaliada como

trueoufalse.

Sintaxe

{

"name": "<Name of the activity>",

"type": "IfCondition",

"typeProperties": {

"expression": {

"value": "<expression that evaluates to true or false>",

"type": "Expression"

},

"ifTrueActivities": [

{

"<Activity 1 definition>"

},

{

"<Activity 2 definition>"

},

{

"<Activity N definition>"

}

],

"ifFalseActivities": [

{

"<Activity 1 definition>"

},

{

"<Activity 2 definition>"

},

{

"<Activity N definition>"

}

]

}

}

Propriedades do tipo

| Propriedade | Description | Valores permitidos | Necessário |

|---|---|---|---|

| nome | Nome da atividade if-condition. | Cadeia (de carateres) | Sim |

| tipo | Deve ser definido como IfCondition | Cadeia (de carateres) | Sim |

| expressão | Expressão que deve ser avaliada como verdadeira ou falsa | Expressão com tipo de resultado booleano | Sim |

| ifTrueActivities | Conjunto de atividades que são executadas quando a expressão é avaliada como true. |

Matriz | Sim |

| ifFalseActivities | Conjunto de atividades que são executadas quando a expressão é avaliada como false. |

Matriz | Sim |

Exemplo

O pipeline neste exemplo copia dados de uma pasta de entrada para uma pasta de saída. A pasta de saída é determinada pelo valor do parâmetro pipeline: routeSelection. Se o valor de routeSelection for true, os dados serão copiados para outputPath1. E, se o valor de routeSelection for false, os dados serão copiados para outputPath2.

Nota

Esta seção fornece definições JSON e comandos PowerShell de exemplo para executar o pipeline. Para obter um passo a passo com instruções passo a passo para criar um pipeline usando definições do Azure PowerShell e JSON, consulte tutorial: criar uma fábrica de dados usando o Azure PowerShell.

Pipeline com atividade IF-Condition (Adfv2QuickStartPipeline.json)

{

"name": "Adfv2QuickStartPipeline",

"properties": {

"activities": [

{

"name": "MyIfCondition",

"type": "IfCondition",

"typeProperties": {

"expression": {

"value": "@bool(pipeline().parameters.routeSelection)",

"type": "Expression"

},

"ifTrueActivities": [

{

"name": "CopyFromBlobToBlob1",

"type": "Copy",

"inputs": [

{

"referenceName": "BlobDataset",

"parameters": {

"path": "@pipeline().parameters.inputPath"

},

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "BlobDataset",

"parameters": {

"path": "@pipeline().parameters.outputPath1"

},

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "BlobSource"

},

"sink": {

"type": "BlobSink"

}

}

}

],

"ifFalseActivities": [

{

"name": "CopyFromBlobToBlob2",

"type": "Copy",

"inputs": [

{

"referenceName": "BlobDataset",

"parameters": {

"path": "@pipeline().parameters.inputPath"

},

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "BlobDataset",

"parameters": {

"path": "@pipeline().parameters.outputPath2"

},

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "BlobSource"

},

"sink": {

"type": "BlobSink"

}

}

}

]

}

}

],

"parameters": {

"inputPath": {

"type": "String"

},

"outputPath1": {

"type": "String"

},

"outputPath2": {

"type": "String"

},

"routeSelection": {

"type": "String"

}

}

}

}

Outro exemplo de expressão é:

"expression": {

"value": "@equals(pipeline().parameters.routeSelection,1)",

"type": "Expression"

}

Serviço vinculado do Armazenamento do Azure (AzureStorageLinkedService.json)

{

"name": "AzureStorageLinkedService",

"properties": {

"type": "AzureStorage",

"typeProperties": {

"connectionString": "DefaultEndpointsProtocol=https;AccountName=<Azure Storage account name>;AccountKey=<Azure Storage account key>"

}

}

}

Conjunto de dados de Blob do Azure parametrizado (BlobDataset.json)

O pipeline define o folderPath como o valor do parâmetro outputPath1 ou outputPath2 do pipeline.

{

"name": "BlobDataset",

"properties": {

"type": "AzureBlob",

"typeProperties": {

"folderPath": {

"value": "@{dataset().path}",

"type": "Expression"

}

},

"linkedServiceName": {

"referenceName": "AzureStorageLinkedService",

"type": "LinkedServiceReference"

},

"parameters": {

"path": {

"type": "String"

}

}

}

}

Parâmetro de pipeline JSON (PipelineParameters.json)

{

"inputPath": "adftutorial/input",

"outputPath1": "adftutorial/outputIf",

"outputPath2": "adftutorial/outputElse",

"routeSelection": "false"

}

Comandos do PowerShell

Nota

Recomendamos que utilize o módulo do Azure Az PowerShell para interagir com o Azure. Veja Instalar o Azure PowerShell para começar. Para saber como migrar para o módulo do Az PowerShell, veja Migrar o Azure PowerShell do AzureRM para o Az.

Esses comandos pressupõem que você salvou os arquivos JSON na pasta: C:\ADF.

Connect-AzAccount

Select-AzSubscription "<Your subscription name>"

$resourceGroupName = "<Resource Group Name>"

$dataFactoryName = "<Data Factory Name. Must be globally unique>";

Remove-AzDataFactoryV2 $dataFactoryName -ResourceGroupName $resourceGroupName -force

Set-AzDataFactoryV2 -ResourceGroupName $resourceGroupName -Location "East US" -Name $dataFactoryName

Set-AzDataFactoryV2LinkedService -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -Name "AzureStorageLinkedService" -DefinitionFile "C:\ADF\AzureStorageLinkedService.json"

Set-AzDataFactoryV2Dataset -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -Name "BlobDataset" -DefinitionFile "C:\ADF\BlobDataset.json"

Set-AzDataFactoryV2Pipeline -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -Name "Adfv2QuickStartPipeline" -DefinitionFile "C:\ADF\Adfv2QuickStartPipeline.json"

$runId = Invoke-AzDataFactoryV2Pipeline -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -PipelineName "Adfv2QuickStartPipeline" -ParameterFile C:\ADF\PipelineParameters.json

while ($True) {

$run = Get-AzDataFactoryV2PipelineRun -ResourceGroupName $resourceGroupName -DataFactoryName $DataFactoryName -PipelineRunId $runId

if ($run) {

if ($run.Status -ne 'InProgress') {

Write-Host "Pipeline run finished. The status is: " $run.Status -foregroundcolor "Yellow"

$run

break

}

Write-Host "Pipeline is running...status: InProgress" -foregroundcolor "Yellow"

}

Start-Sleep -Seconds 30

}

Write-Host "Activity run details:" -foregroundcolor "Yellow"

$result = Get-AzDataFactoryV2ActivityRun -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -PipelineRunId $runId -RunStartedAfter (Get-Date).AddMinutes(-30) -RunStartedBefore (Get-Date).AddMinutes(30)

$result

Write-Host "Activity 'Output' section:" -foregroundcolor "Yellow"

$result.Output -join "`r`n"

Write-Host "\nActivity 'Error' section:" -foregroundcolor "Yellow"

$result.Error -join "`r`n"

Conteúdos relacionados

Veja outras atividades de fluxo de controle suportadas: