В этой статье приводятся ответы на некоторые распространенные вопросы о запуске Azure HDInsight.

Сведения о типах кластеров HDInsight и методах подготовки см. в разделе Настройка кластеров в HDInsight с помощью Apache Hadoop, Apache Spark, Apache Kafka и др.

Дополнительные сведения об удалении кластера, когда он больше не используется, см. в статье "Удаление кластера HDInsight".

Старайтесь, чтобы между операциями создания и удаления проходило хотя бы 30–60 минут. В противном случае операция может завершиться неудачно со следующим сообщением об ошибке:

Conflict (HTTP Status Code: 409) error when attempting to delete a cluster immediately after creation of a cluster. If you encounter this error, wait until the newly created cluster is in operational state before attempting to delete it.

Соответствующее количество ядер и другие параметры конфигурации зависят от многих факторов.

Дополнительные сведения см. в разделе Планирование ресурсов для кластеров HDInsight.

См. раздел Типы ресурсов в кластерах Azure HDInsight.

- Рекомендуется настраивать кластеры HDInsight с пользовательской базой данных Ambari DB, чтобы улучшить масштабируемость кластера.

- Используйте Azure Data Lake Storage 2-го поколения для создания кластеров HDInsight, чтобы воспользоваться преимуществами более высокой пропускной способности и других характеристик производительности Azure Data Lake Storage 2-го поколения.

- Головные узлы должны быть достаточно большими, чтобы разместить на них несколько главных служб.

- Для некоторых особых рабочих нагрузок, таких как Interactive Query, также требуются узлы Zookeeper большего размера. Рассмотрите как минимум восемь основных виртуальных машин.

- В случае Hive и Spark используйте внешние хранилище метаданных Hive.

Да. Чтобы установить дополнительные компоненты или настроить конфигурацию кластера, используйте:

Скрипты во время или после создания. Скрипты вызываются с помощью действия скрипта. Действие скрипта — это параметр конфигурации, который можно использовать на портале Azure, в командлетах HDInsight Windows PowerShell или в пакете SDK .NET HDInsight. Этот параметр конфигурации можно использовать на портале Azure, в командлетах HDInsight Windows PowerShell или в пакете SDK .NET HDInsight.

Платформу приложений HDInsight для установки приложений.

Список поддерживаемых компонентов см. в разделе Что представляют собой компоненты и версии Apache Hadoop, доступные в HDInsight?

При обновлении встроенных компонентов или приложений, предварительно установленных в кластере, результирующая конфигурация не будет поддерживаться корпорацией Майкрософт. Эти системные конфигурации не были протестированы корпорацией Майкрософт. Попробуйте использовать другую версию кластера HDInsight, которая уже может иметь обновленную версию компонента.

Например, обновление Hive в качестве отдельного компонента не поддерживается. HDInsight — управляемая служба, и многие службы интегрированы с сервером Ambari и протестированы. Обновление Hive само по себе вызывает изменение индексированных двоичных файлов других компонентов и приводит к проблемам интеграции компонентов в вашем кластере.

Нет, невозможно запустить Apache Kafka и Apache Spark в одном том же кластере HDInsight. Создайте отдельные кластеры для Kafka и Spark, чтобы избежать проблем состязания за ресурсы.

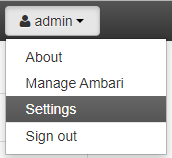

Откройте веб-интерфейс Ambari по адресу

https://CLUSTERNAME.azurehdinsight.net, где CLUSTERNAME — имя вашего кластера.В правом верхнем углу выберите admin | Settings.

В окне "Параметры пользователя" выберите новый часовой пояс в раскрывающемся списке часового пояса и нажмите кнопку "Сохранить".

Подробные сведения о миграции из SQL Server в Базу данных SQL Azure см. в учебнике Автономная миграция из SQL Server в отдельную базу данных или базу данных в пуле в Базе данных SQL Azure с помощью DMS.

Это зависит от типа хранилища метаданных, для использования которого настроен ваш кластер.

Для хранилища метаданных по умолчанию: хранилище метаданных по умолчанию является частью жизненного цикла кластера. При удалении кластера соответствующее хранилище метаданных и метаданные также удаляются.

Для настраиваемого хранилища метаданных: жизненный цикл хранилища метаданных не привязан к жизненному циклу кластера. Таким образом, вы можете создавать и удалять кластеры без потери метаданных. Метаданные, такие как схемы Hive, сохраняются даже после удаления и повторного создания кластера HDInsight.

Дополнительную информацию см. в статье Использование внешних хранилищ метаданных в Azure HDInsight.

При миграции хранилища метаданных Hive выполняется ли также перенос политик по умолчанию базы данных Ranger?

Нет, определение политики находится в базе данных Ranger, поэтому миграция базы данных Ranger переносит свою политику.

Можно ли перенести хранилище метаданных Hive из кластера Корпоративного пакета безопасности (ESP) в кластер не ESP, и наоборот?

Да, можно переносить хранилище метаданных Hive из ESP в кластер не ESP.

Хранилище метаданных Hive используется для хранения метаданных источников данных, используемых сервером Hive. Требования к размеру частично зависят от количества и сложности ваших источников данных Hive. Предварительная оценка этих элементов невозможна. Как описано в разделе Рекомендации по хранилищу метаданных Hive, можно начать с уровня S2. Этот уровень предоставляет 50 DTU и 250 ГБ хранилища, и если вы увидите узкие места, увеличьте масштаб базы данных.

Поддерживается ли любая другая база данных, кроме базы данных SQL Azure, в качестве внешнего хранилища метаданных?

Нет, Майкрософт поддерживает только базу данных SQL Azure в качестве внешнего пользовательского хранилища метаданных.

Да, вы можете совместно использовать пользовательское хранилище метаданных в нескольких кластерах, если они используют одну и ту же версию HDInsight.

Если вы блокируете порты 22 и 23, то у вас не будет доступа к кластеру по протоколу SSH. Эти порты не используются службой HDInsight.

Дополнительные сведения см. в следующих документах:

Да, можно развернуть больше виртуальных машин в той же подсети, что и кластер HDInsight. Возможны следующие конфигурации.

Граничные узлы. Вы можете добавить в кластер другой граничный узел, как описано в разделе Использование пустых граничных узлов в кластерах Apache Hadoop в HDInsight.

Изолированные узлы. Вы можете добавить изолированную виртуальную машину в ту же подсеть и получать доступ к кластеру из этой виртуальной машины с помощью частной конечной точки

https://<CLUSTERNAME>-int.azurehdinsight.net. См. статью Управление сетевым трафиком.

Нет, хранение данных на локальном диске не рекомендуется. В случае сбоя узла все хранящиеся локально данные будут потеряны. Мы рекомендуем хранить данные в Azure Data Lake Storage 2-го поколения или хранилище BLOB-объектов Azure, либо подключить общую папку службы "Файлы Azure" для хранения данных.

Нет, нельзя. Виртуальная сеть должна быть указана во время подготовки. Если во время подготовки виртуальная сеть не была указана, то при развертывании создается внутренняя сеть, недоступная извне. Дополнительные сведения см. в разделе Добавление HDInsight в существующую виртуальную сеть.

Сведения о защите от вредоносных программ см. в разделе Microsoft Antimalware для облачных служб и виртуальных машин Azure.

Создайте keytab Kerberos для вашего имени пользователя домена. Позже этот keytab можно использовать для проверки подлинности в удаленных присоединенных к домену кластерах без ввода пароля. Имя домена указано прописными буквами.

ktutil

ktutil: addent -password -p <username>@<DOMAIN.COM> -k 1 -e aes256-cts-hmac-sha1-96

Password for <username>@<DOMAIN.COM>: <password>

ktutil: wkt <username>.keytab

ktutil: q

Если имя клиента и доменное имя отличаются (например, TenantName — bob@CONTOSO.ONMICROSOFT.COM и DomainName— ), bob@CONTOSOMicrosoft.ONMICROSOFT.COMнеобходимо добавить значение SALT с помощью параметра -s.

- Используйте интерактивный вход Kerberos, чтобы определить правильное значение соли для keytab. По умолчанию в интерактивном входе Kerberos используется самое высокое шифрование. Трассировка должна быть включена для наблюдения за солью. Ниже приведен пример входа Kerberos:

$ KRB5_TRAACE=/dev/stdout kinit <username> -V

- Просмотрите выходные данные для соли "......." линия.

- Используйте это значение соли при создании keytab.

ktutil

ktutil: addent -password -p <username>@<DOMAIN.COM> -k 1 -e aes256-cts-hmac-sha1-96 -s <SALTvalue>

Password for <username>@<DOMAIN.COM>: <password>

ktutil: wkt <username>.keytab

ktutil: q

Включите доменные службы Microsoft Entra перед созданием кластера HDInsight с помощью ESP. Hadoop с открытым кодом использует протокол Kerberos для аутентификации (вместо OAuth).

Чтобы присоединить виртуальные машины к домену, необходимо иметь контроллер домена. Доменные службы Microsoft Entra — это управляемый контроллер домена и считается расширением идентификатора Microsoft Entra. Доменные службы Microsoft Entra предоставляют все требования Kerberos для создания безопасного кластера Hadoop с помощью управляемого способа. HDInsight как управляемая служба интегрируется с доменными службами Microsoft Entra для обеспечения безопасности.

Можно ли использовать самозаверяющий сертификат в защищенной настройке LDAP доменных служб Microsoft Entra и подготовке кластера ESP?

Рекомендуется использовать сертификат, выданный центром сертификации. Но в ESP также поддерживается и использование самозаверяющего сертификата. Дополнительные сведения см. в разделе:

Нет, установка DAS в кластерах ESP не поддерживается.

Для требований аудита Майкрософт рекомендует включить журналы Azure Monitor, как описано в разделе Использование журналов Azure Monitor для мониторинга кластеров HDInsight.

Clamscan — антивирусное программное обеспечение, которое работает в кластере HDInsight и используется системой безопасности Azure (azsecd) для защиты кластеров от вирусных атак. Майкрософт настоятельно рекомендует пользователям не изменять конфигурацию Clamscan по умолчанию.

Этот процесс не мешает никаким циклам от других процессов и не вредит им. Он всегда будет уступать другому процессу. Вы будете наблюдать пики загрузки ЦП от Clamscan только в том случае, если система бездействует.

В сценариях, в которых необходимо управлять расписанием, можно выполнить следующие действия.

Отключить автоматическое выполнение с помощью следующей команды:

sudo

usr/local/bin/azsecd config -s clamav -d Disabledsudo service azsecd restartДобавить задание Cron, которое выполняет следующую команду от имени пользователя root:

/usr/local/bin/azsecd manual -s clamav

Дополнительные сведения о настройке и выполнении задания Cron см. в разделе Как настроить задание Cron.

LLAP включен по соображениям безопасности (Apache Ranger), а не для производительности. Используйте виртуальные машины большего размера, чтобы приспособиться к использованию ресурсов LLAP (например, минимум D13V2).

Для этого существует два способа. 1. Можно повторно создать кластер и добавить дополнительную группу во время создания кластера. Если вы используете синхронизацию с областью действия в доменных службах Microsoft Entra, убедитесь, что группа B включена в синхронизацию с областью действия.

2. Добавьте группу в качестве вложенной подгруппы предыдущей группы, которая использовалась для создания кластера ESP. Например, если вы создали кластер ESP с группой A, позднее можно добавить группу B в качестве вложенной подгруппы A, и примерно через один час она будет автоматически синхронизирована и доступна в кластере.

Можно ли добавить Azure Data Lake Storage 2-го поколения в существующий кластер HDInsight в качестве дополнительной учетной записи хранения?

Нет, в настоящее время невозможно добавить учетную запись хранения Azure Data Lake Storage 2-го поколения в кластер, имеющий хранилище BLOB-объектов в качестве основного хранилища. Дополнительные сведения см. в разделе Сравнение вариантов хранилищ.

Параметры можно найти в разделе Доступ к Data Lake Storage 1-го поколения в свойствах вашего кластера на портале Azure. Дополнительные сведения см. в разделе Проверка настройки кластера.

Как можно рассчитать потребление учетных записей хранения и контейнеров больших двоичных объектов для кластеров HDInsight?

Выполните одно из следующих действий:

Найдите размер папки /user/hive/.Trash/ в кластере HDInsight с помощью следующей команды:

hdfs dfs -du -h /user/hive/.Trash/

Для аудита учетных записей хранения больших двоичных объектов настройте мониторинг с помощью процедуры, описанной в разделе Мониторинг учетной записи хранения на портале Azure. Журнал аудита HDFS содержит только данные аудита для локальной файловой системы HDFS (hdfs://mycluster). Он не включает операции, выполняемые в удаленном хранилище.

Выполните скрипт, аналогичный следующему скрипту оболочки, на головном узле:

for i in cat filenames.txt

do

hadoop fs -get $i <local destination>

done

Примечание

Файл filenames.txt будет иметь абсолютный путь к файлам в контейнерах больших двоичных объектов.

В настоящее время для хранилища больших двоичных объектов и Azure Data Lake Storage 1-го или 2-го поколения не существует подключаемого модуля Ranger. Для кластеров ESP следует использовать Azure Data Lake Storage. Вы можете по крайней мере задать точные разрешения на уровне файловой системы вручную с помощью средств HDFS. Кроме того, при использовании Azure Data Lake Storage кластеры ESP будут выполнять некоторые из элементов управления доступом к файловой системе с помощью идентификатора Microsoft Entra на уровне кластера.

Вы можете назначать политики доступа к данным для групп безопасности пользователей с помощью Обозревателя службы хранилища Azure. Дополнительные сведения см. в разделе:

№ Вы не можете увеличить размер диска любого рабочего узла. Поэтому единственным способом увеличения размера диска является удаление кластера и его повторное создание с использованием виртуальных машин большего размера. Не используйте HDFS для хранения ваших данных HDInsight, так как данные удаляются при удалении кластера. Вместо этого храните данные в Azure. Масштабирование кластера также может увеличить емкость кластера HDInsight.

После создания граничного узла вы можете подключаться к нему по протоколу SSH через порт 22. Имя граничного узла можно найти на портале кластера. Эти имена обычно оканчиваются на -ed.

Сохраняемые скрипты применяются при настройке новых рабочих узлов, добавленных в кластер при операциях масштабирования. Сохраняемые скрипты не применяются к граничным узлам.

Для получения необходимой информации в формате JSON можно использовать следующие конечные точки REST. Для выполнения запросов используйте заголовки обычной проверки подлинности.

-

Tez Query View: https:// <cluster name>.azurehdinsight.net/ws/v1/timeline/HIVE_QUERY_ID/ -

Tez Dag View: https://<cluster name>.azurehdinsight.net/ws/v1/timeline/TEZ_DAG_ID/

Разделы справки получить сведения о конфигурации из кластера HDI с помощью пользователя Microsoft Entra?

Чтобы согласовать правильные маркеры проверки подлинности с пользователем Microsoft Entra, перейдите через шлюз с помощью следующего формата:

- https://

<cluster dnsname>.azurehdinsight.net/api/v1/clusters/testclusterdem/stack_versions/1/repository_versions/1

При вызове команды Curl в той же или в одноранговой виртуальной сети используйте следующий формат команды.

curl -u <cluster login username> -sS -G

http://<headnodehost>:8080/api/v1/clusters/<ClusterName>/services/YARN/components/NODEMANAGER?fields=metrics/cpu

При вызове этой команды извне виртуальной сети или не из одноранговой виртуальной сети используйте следующий формат команды.

Для кластера, отличного от ESP:

curlcurl -u <cluster login username> -sS -G https://<ClusterName>.azurehdinsight.net/api/v1/clusters/<ClusterName>/services/YARN/components/NODEMANAGER?fields=metrics/cpuДля кластера ESP:

curlcurl -u <cluster login username>-sS -G https://<ClusterName>.azurehdinsight.net/api/v1/clusters/<ClusterName>/services/YARN/components/NODEMANAGER?fields=metrics/cpu

Примечание

Curl запрашивает пароль. Необходимо ввести допустимый пароль для имени пользователя входа в кластер.

Дополнительные сведения о ценах и часто задаваемые вопросы, связанные с выставлением счетов, см. на странице Цены на Azure HDInsight.

Начисление оплаты начинается после создания кластера HDInsight и прекращается только после его удаления. Оплата начисляется пропорционально поминутно.

Сведения о том, как отменить подписку, см. в разделе Отмена подписки Azure.

Сведения о том, что происходит после отмены подписки, см. в разделе Что происходит после отмены подписки?

Почему версия Hive отображается как 1.2.1000 вместо 2.1 в пользовательском интерфейсе Ambari, хотя я выполняю кластер HDInsight 3.6?

Хотя в пользовательском интерфейсе Ambari отображается только версия 1.2, HDInsight 3.6 содержит как Hive 1.2, так и Hive 2.1.

Сведения о возможностях интеграции потоковой обработки см. в разделе Выбор технологии потоковой обработки в Azure.

Существует ли способ динамического уничтожения головного узла кластера, когда кластер бездействует в течение определенного периода?

Это действие нельзя выполнить с кластерами HDInsight. В этих сценариях можно использовать Фабрику данных Azure.

Сведения о соответствии см. в Центре управления безопасностью Майкрософт.