GlusterFS на виртуальных машинах Azure с Red Hat Enterprise Linux для SAP NetWeaver

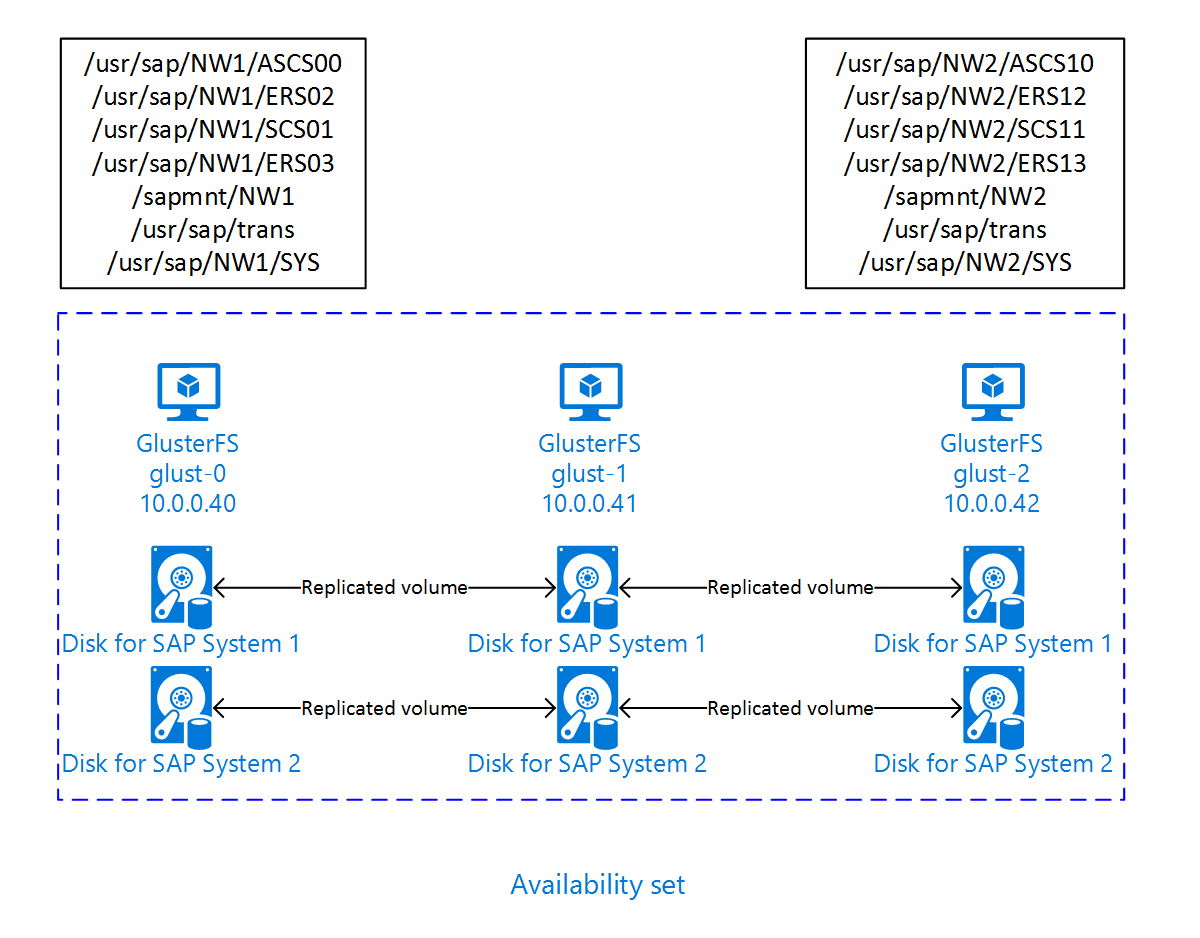

В этой статье описывается развертывание виртуальных машин, их настройка и установка кластера GlusterFS, который можно использовать для хранения общих данных высокодоступной системы SAP. В этом руководстве описывается настройка кластера GlusterFS, который используется двумя системами SAP: NW1 и NW2. Имена ресурсов (например, виртуальных машин или виртуальных сетей) в примере предполагают, что вы использовали шаблон файлового сервера SAP с префиксом ресурсов glust.

Помните, что как описано в Red Hat Gluster служба хранилища Жизненный цикл Red Hat Gluster служба хранилища достигнет конца жизни в конце 2024 года. Конфигурация будет поддерживаться для SAP в Azure до тех пор, пока она не завершится. Не следует использовать GlusterFS для новых развертываний. Мы рекомендуем развернуть общие каталоги SAP в NFS на Файлы Azure или томах Azure NetApp Files, как описано в высокой доступности для SAP NW в RHEL с помощью NFS на Файлы Azure или высокой доступности для SAP NW в RHEL с Помощью Azure NetApp Files.

Сначала прочитайте следующие примечания и документы SAP:

примечание к SAP 1928533, которое содержит:

- список размеров виртуальных машин Azure, поддерживаемых для развертывания ПО SAP;

- важные сведения о доступных ресурсах для каждого размера виртуальной машины Azure;

- сведения о поддерживаемом программном обеспечении SAP и сочетаниях операционных систем и баз данных;

- сведения о требуемой версии ядра SAP для Windows и Linux в Microsoft Azure.

примечание к SAP 2015553, в котором описываются предварительные требования к SAP при развертывании программного обеспечения SAP в Azure;

примечание к SAP 2002167, содержащее рекомендуемые параметры ОС для Red Hat Enterprise Linux;

примечание к SAP 2009879, содержащее рекомендации по SAP HANA для Red Hat Enterprise Linux;

примечание к SAP 2178632, содержащее подробные сведения обо всех доступных метриках мониторинга для SAP в Azure;

примечание к SAP 2191498, содержащее сведения о необходимой версии агента SAP Host Agent для Linux в Azure;

примечание к SAP 2243692, содержащее сведения о лицензировании SAP в Linux в Azure;

примечание к SAP 1999351, содержащее дополнительные сведения об устранении неполадок, связанных с расширением для расширенного мониторинга Azure для SAP;

вики-сайт сообщества SAP, содержащий все необходимые примечания к SAP для Linux;

SAP NetWeaver на виртуальных машинах Linux. Руководство по планированию и внедрению

Развертывание виртуальных машин Azure для SAP в Linux (данная статья)

Развертывание СУБД Виртуальных машин Azure для SAP на Linux.

Общая документация по RHEL

Документация по RHEL для Azure:

Обзор

Чтобы добиться высокого уровня доступности, SAP NetWeaver необходимо общее хранилище. GlusterFS настраивается в отдельном кластере и может использоваться несколькими системами SAP.

Настройка GlusterFS

В этом примере ресурсы были развернуты вручную с помощью портала Azure.

Развертывание Linux вручную с помощью портала Azure

В этом документе предполагается, что вы уже развернули группу ресурсов, Azure виртуальная сеть и подсеть.

Развертывание виртуальных машин для GlusterFS. Выберите подходящий образ RHEL, который поддерживается для хранилища Gluster. Вы можете развернуть виртуальную машину в любом из вариантов доступности — масштабируемый набор, зону доступности или группу доступности.

Настройка GlusterFS

Ниже приведены элементы с префиксами: [A] — применяется ко всем узлам; [1] — применяется только к узлу 1; [2] — применяется только к узлу 2; [3] — применяется только к узлу 3.

[A] Установите разрешения имен.

Можно использовать DNS-сервер или внести изменения в файл /etc/hosts на всех узлах. В этом примере показано, как использовать файл /etc/hosts. Замените IP-адрес и имя узла в следующих командах.

sudo vi /etc/hostsВставьте следующие строки в /etc/hosts. Измените IP-адрес и имя узла в соответствии со своей средой.

# IP addresses of the Gluster nodes 10.0.0.40 glust-0 10.0.0.41 glust-1 10.0.0.42 glust-2[A] Регистрация

Зарегистрируйте виртуальные машины и подключите их к пулу, содержащему репозитории для RHEL 7 и GlusterFS.

sudo subscription-manager register sudo subscription-manager attach --pool=<pool id>[A] Включение репозиториев GlusterFS

Чтобы установить необходимые пакеты, включите приведенные ниже репозитории.

sudo subscription-manager repos --disable "*" sudo subscription-manager repos --enable=rhel-7-server-rpms sudo subscription-manager repos --enable=rh-gluster-3-for-rhel-7-server-rpms[A] Установка пакетов GlusterFS

Установите эти пакеты во всех узлах GlusterFS.

sudo yum -y install redhat-storage-serverПосле установки перезапустите узлы.

[A] Изменение правил брандмауэра

Добавьте правила брандмауэра, разрешающие передачу трафика клиентов в узлы GlusterFS.

# list the available zones firewall-cmd --get-active-zones sudo firewall-cmd --zone=public --add-service=glusterfs --permanent sudo firewall-cmd --zone=public --add-service=glusterfs[A] Включение и запуск службы GlusterFS

Запустите службу GlusterFS во всех узлах.

sudo systemctl start glusterd sudo systemctl enable glusterd[1] Создание GluserFS

Чтобы создать кластер GlusterFS, выполните следующие команды:

sudo gluster peer probe glust-1 sudo gluster peer probe glust-2 # Check gluster peer status sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-1 # Uuid: 10d43840-fee4-4120-bf5a-de9c393964cd # State: Accepted peer request (Connected) # # Hostname: glust-2 # Uuid: 9e340385-12fe-495e-ab0f-4f851b588cba # State: Accepted peer request (Connected)[2] Проверка состояния кэширующего узла

Проверьте состояние кэширующего узла во втором узле.

sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-0 # Uuid: 6bc6927b-7ee2-461b-ad04-da123124d6bd # State: Peer in Cluster (Connected) # # Hostname: glust-2 # Uuid: 9e340385-12fe-495e-ab0f-4f851b588cba # State: Peer in Cluster (Connected)[3] Проверка состояния кэширующего узла

Проверьте состояние кэширующего узла в третьем узле.

sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-0 # Uuid: 6bc6927b-7ee2-461b-ad04-da123124d6bd # State: Peer in Cluster (Connected) # # Hostname: glust-1 # Uuid: 10d43840-fee4-4120-bf5a-de9c393964cd # State: Peer in Cluster (Connected)[A] Создание LVM

В этом руководстве GlusterFS используется для двух систем SAP: NW1 и NW2. Чтобы создать конфигурации LVM для этих систем SAP, используйте приведенные ниже команды.

Для NW1 используйте следующие команды:

sudo pvcreate --dataalignment 1024K /dev/disk/azure/scsi1/lun0 sudo pvscan sudo vgcreate --physicalextentsize 256K rhgs-NW1 /dev/disk/azure/scsi1/lun0 sudo vgscan sudo lvcreate -l 50%FREE -n rhgs-NW1/sapmnt sudo lvcreate -l 20%FREE -n rhgs-NW1/trans sudo lvcreate -l 10%FREE -n rhgs-NW1/sys sudo lvcreate -l 50%FREE -n rhgs-NW1/ascs sudo lvcreate -l 100%FREE -n rhgs-NW1/aers sudo lvscan sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/sapmnt sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/trans sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/sys sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/ascs sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/aers sudo mkdir -p /rhs/NW1/sapmnt sudo mkdir -p /rhs/NW1/trans sudo mkdir -p /rhs/NW1/sys sudo mkdir -p /rhs/NW1/ascs sudo mkdir -p /rhs/NW1/aers sudo chattr +i /rhs/NW1/sapmnt sudo chattr +i /rhs/NW1/trans sudo chattr +i /rhs/NW1/sys sudo chattr +i /rhs/NW1/ascs sudo chattr +i /rhs/NW1/aers echo -e "/dev/rhgs-NW1/sapmnt\t/rhs/NW1/sapmnt\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/trans\t/rhs/NW1/trans\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/sys\t/rhs/NW1/sys\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/ascs\t/rhs/NW1/ascs\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/aers\t/rhs/NW1/aers\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab sudo mount -aДля NW2 используйте следующие команды:

sudo pvcreate --dataalignment 1024K /dev/disk/azure/scsi1/lun1 sudo pvscan sudo vgcreate --physicalextentsize 256K rhgs-NW2 /dev/disk/azure/scsi1/lun1 sudo vgscan sudo lvcreate -l 50%FREE -n rhgs-NW2/sapmnt sudo lvcreate -l 20%FREE -n rhgs-NW2/trans sudo lvcreate -l 10%FREE -n rhgs-NW2/sys sudo lvcreate -l 50%FREE -n rhgs-NW2/ascs sudo lvcreate -l 100%FREE -n rhgs-NW2/aers sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/sapmnt sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/trans sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/sys sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/ascs sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/aers sudo mkdir -p /rhs/NW2/sapmnt sudo mkdir -p /rhs/NW2/trans sudo mkdir -p /rhs/NW2/sys sudo mkdir -p /rhs/NW2/ascs sudo mkdir -p /rhs/NW2/aers sudo chattr +i /rhs/NW2/sapmnt sudo chattr +i /rhs/NW2/trans sudo chattr +i /rhs/NW2/sys sudo chattr +i /rhs/NW2/ascs sudo chattr +i /rhs/NW2/aers sudo lvscan echo -e "/dev/rhgs-NW2/sapmnt\t/rhs/NW2/sapmnt\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/trans\t/rhs/NW2/trans\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/sys\t/rhs/NW2/sys\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/ascs\t/rhs/NW2/ascs\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/aers\t/rhs/NW2/aers\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab sudo mount -a[1] Создание распределенного тома

Чтобы создать том GlusterFS для NW1 и запустить его, выполните приведенные ниже команды.

sudo gluster vol create NW1-sapmnt replica 3 glust-0:/rhs/NW1/sapmnt glust-1:/rhs/NW1/sapmnt glust-2:/rhs/NW1/sapmnt force sudo gluster vol create NW1-trans replica 3 glust-0:/rhs/NW1/trans glust-1:/rhs/NW1/trans glust-2:/rhs/NW1/trans force sudo gluster vol create NW1-sys replica 3 glust-0:/rhs/NW1/sys glust-1:/rhs/NW1/sys glust-2:/rhs/NW1/sys force sudo gluster vol create NW1-ascs replica 3 glust-0:/rhs/NW1/ascs glust-1:/rhs/NW1/ascs glust-2:/rhs/NW1/ascs force sudo gluster vol create NW1-aers replica 3 glust-0:/rhs/NW1/aers glust-1:/rhs/NW1/aers glust-2:/rhs/NW1/aers force sudo gluster volume start NW1-sapmnt sudo gluster volume start NW1-trans sudo gluster volume start NW1-sys sudo gluster volume start NW1-ascs sudo gluster volume start NW1-aersЧтобы создать том GlusterFS для NW2 и запустить его, выполните приведенные ниже команды.

sudo gluster vol create NW2-sapmnt replica 3 glust-0:/rhs/NW2/sapmnt glust-1:/rhs/NW2/sapmnt glust-2:/rhs/NW2/sapmnt force sudo gluster vol create NW2-trans replica 3 glust-0:/rhs/NW2/trans glust-1:/rhs/NW2/trans glust-2:/rhs/NW2/trans force sudo gluster vol create NW2-sys replica 3 glust-0:/rhs/NW2/sys glust-1:/rhs/NW2/sys glust-2:/rhs/NW2/sys force sudo gluster vol create NW2-ascs replica 3 glust-0:/rhs/NW2/ascs glust-1:/rhs/NW2/ascs glust-2:/rhs/NW2/ascs force sudo gluster vol create NW2-aers replica 3 glust-0:/rhs/NW2/aers glust-1:/rhs/NW2/aers glust-2:/rhs/NW2/aers force sudo gluster volume start NW2-sapmnt sudo gluster volume start NW2-trans sudo gluster volume start NW2-sys sudo gluster volume start NW2-ascs sudo gluster volume start NW2-aers

Следующие шаги

- Настройка кластера Pacemaker в SUSE Linux Enterprise Server в Azure

- Планирование и реализация виртуальных машин Azure для SAP

- Развертывание виртуальных машин Azure для SAP NetWeaver

- SAP NetWeaver на виртуальных машинах Azure. Руководство по развертыванию СУБД SQL Server

- Дополнительные сведения об обеспечении высокого уровня доступности и планировании аварийного восстановления SAP HANA в Azure (крупные экземпляры) см. в этой статье.

- См. сведения в статье Обеспечение высокого уровня доступности SAP HANA на виртуальных машинах Azure в SUSE Linux Enterprise Server.