İşlem yapılandırma başvurusu

Bu makalede, İşlem Oluşturma kullanıcı arabiriminde kullanılabilen tüm yapılandırma ayarları açıklanmaktadır. Kullanıcıların çoğu, yapılandırılabilir ayarları sınırlayan atanmış ilkelerini kullanarak işlem oluşturur. Kullanıcı arabiriminizde belirli bir ayar görmüyorsanız, bunun nedeni seçtiğiniz ilkenin bu ayarı yapılandırmanıza izin vermemesidir.

Bu makalede açıklanan yapılandırmalar ve yönetim araçları hem çok amaçlı hem de iş işlemi için geçerlidir. İş işlemini yapılandırma hakkında daha fazla bilgi için bkz . Azure Databricks işlemini işlerinizle birlikte kullanma.

Koşullarıdır

İlkeler, kullanıcılar işlem oluştururken kullanabilecekleri yapılandırma seçeneklerini sınırlamak için kullanılan bir kural kümesidir. Bir kullanıcının Sınırsız küme oluşturma yetkilendirmesi yoksa, yalnızca verilen ilkelerini kullanarak işlem oluşturabilir.

bir ilkeye göre işlem oluşturmak için, İlke açılan menüsünden bir ilke seçin.

Varsayılan olarak, tüm kullanıcılar Kişisel İşlem ilkesine erişebilir ve tek makineli işlem kaynakları oluşturmalarına olanak sağlar. Kişisel İşlem'e veya ek ilkelere erişmeniz gerekiyorsa çalışma alanı yöneticinize ulaşın.

Tek düğümlü veya çok düğümlü işlem

İlkeye bağlı olarak, Tek düğümlü işlem veya Çok düğümlü işlem oluşturma arasında seçim yapabilirsiniz.

Tek düğümlü işlem, az miktarda veri veya tek düğümlü makine öğrenmesi kitaplıkları gibi dağıtılmış olmayan iş yükleri kullanan işler için tasarlanmıştır. Dağıtılmış iş yüklerine sahip daha büyük işler için çok düğümlü işlem kullanılmalıdır.

Tek düğüm özellikleri

Tek düğüm işlem aşağıdaki özelliklere sahiptir:

- Spark'ı yerel olarak çalıştırır.

- Sürücü, çalışan düğümü olmadan hem ana hem de çalışan işlevi görür.

- İşlemde mantıksal çekirdek başına bir yürütücü iş parçacığı, sürücü için eksi 1 çekirdek oluşturur.

- Tüm

stderr,stdoutvelog4jgünlük çıkışlarını sürücü günlüğüne kaydeder. - Çok düğümlü bir işlem dönüştürülemez.

Tek veya çok düğümlü seçme

Tek veya çok düğümlü bir işlem arasında karar verirken kullanım örneğinizi göz önünde bulundurun:

Büyük ölçekli veri işleme, tek düğümlü işlemdeki kaynakları tüketecektir. Bu iş yükleri için Databricks, çok düğümlü işlem kullanılmasını önerir.

Tek düğümlü işlem paylaşılacak şekilde tasarlanmamıştır. Kaynak çakışmalarını önlemek için Databricks, işlem paylaşılması gerektiğinde çok düğümlü bir işlem kullanılmasını önerir.

Çok düğümlü işlem 0 çalışana ölçeklendirilemez. Bunun yerine tek düğüm işlem kullanın.

Tek düğümlü işlem, işlem yalıtımıyla uyumlu değildir.

GPU zamanlaması tek düğüm işlemde etkinleştirilmez.

Tek düğümlü işlemde Spark, UDT sütunu olan Parquet dosyalarını okuyamaz. Aşağıdaki hata iletisi sonuçları:

The Spark driver has stopped unexpectedly and is restarting. Your notebook will be automatically reattached.Bu sorunu geçici olarak çözmek için yerel Parquet okuyucuyu devre dışı bırakın:

spark.conf.set("spark.databricks.io.parquet.nativeReader.enabled", False)

Erişim modları

Erişim modu, işlemi kimlerin kullanabileceğini ve işlem aracılığıyla erişebilecekleri verileri belirleyen bir güvenlik özelliğidir. Azure Databricks'teki her işlem bir erişim moduna sahiptir.

Databricks, tüm iş yükleri için paylaşılan erişim modunu kullanmanızı önerir. Tek kullanıcı erişim modunu yalnızca gerekli işlevselliğiniz paylaşılan erişim modu tarafından desteklenmiyorsa kullanın.

| Erişim Modu | Kullanıcıya görünür | UC Desteği | Desteklenen Diller | Notlar |

|---|---|---|---|---|

| Tek bir kullanıcı | Her zaman | Yes | Python, SQL, Scala, R | Tek bir kullanıcı tarafından atanabilir ve kullanılabilir. Bazı çalışma alanlarında Atanan erişim modu olarak adlandırılır. |

| Paylaşılan | Her zaman (Premium plan gereklidir) | Yes | Python (Databricks Runtime 11.3 LTS ve üzeri), SQL, Scala (Databricks Runtime 13.3 LTS ve üzerini kullanan Unity Kataloğu özellikli işlemde) | Kullanıcılar arasında veri yalıtımı olan birden çok kullanıcı tarafından kullanılabilir. |

| Yalıtım Paylaşılmamalıdır | Yönetici, yönetici ayarları sayfasında kullanıcı yalıtımını zorunlu kılarak bu erişim modunu gizleyebilir. | Hayır | Python, SQL, Scala, R | YalıtımSız Paylaşılan işlem için ilgili bir hesap düzeyi ayarı vardır. |

| Özel | Gizli (Tüm yeni işlem için) | Hayır | Python, SQL, Scala, R | Bu seçenek yalnızca belirtilen erişim modu olmadan mevcut bir işlem varsa gösterilir. |

Erişim modunu Tek Kullanıcı veya Paylaşılan olarak ayarlayarak Unity Kataloğu'nun gereksinimlerini karşılamak için mevcut bir işlem yükseltebilirsiniz.

Not

Databricks Runtime 13.3 LTS ve üzerinde, tüm erişim modlarında başlatma betikleri ve kitaplıkları desteklenir. Gereksinimler ve destek farklılık gösterir. Bkz. Init betikleri nereye yüklenebilir? ve Küme kapsamlı kitaplıklar.

Databricks Runtime sürümleri

Databricks Runtime, işleminizde çalışan temel bileşenler kümesidir. Databricks Runtime Sürümü açılan menüsünü kullanarak çalışma zamanını seçin. Belirli Databricks Runtime sürümleri hakkında ayrıntılı bilgi için bkz . Databricks Runtime sürüm notları sürümleri ve uyumluluğu. Tüm sürümler Apache Spark içerir. Databricks aşağıdakileri önerir:

- Tüm amaçlı işlemlerde, kodunuzla önceden yüklenmiş paketleriniz arasında en son iyileştirmelere ve en güncel uyumluluğa sahip olduğunuzdan emin olmak için en güncel sürümü kullanın.

- İşletimsel iş yüklerini çalıştıran iş işlemi için Uzun Vadeli Destek (LTS) Databricks Runtime sürümünü kullanmayı göz önünde bulundurun. LTS sürümünü kullanmak, uyumluluk sorunlarıyla karşılaşmayın ve yükseltmeden önce iş yükünüzü kapsamlı bir şekilde test edebilirsiniz.

- Veri bilimi ve makine öğrenmesi kullanım örnekleri için Databricks Runtime ML sürümünü göz önünde bulundurun.

Foton hızlandırmayı kullanma

Photon, Databricks Runtime 9.1 LTS ve üzerini çalıştıran işlemde varsayılan olarak etkindir.

Foton hızlandırmayı etkinleştirmek veya devre dışı bırakmak için Foton Hızlandırma kullan onay kutusunu seçin. Photon hakkında daha fazla bilgi edinmek için bkz . Photon nedir?.

Çalışan ve sürücü düğümü türleri

İşlem, bir sürücü düğümünden ve sıfır veya daha fazla çalışan düğümünden oluşur. Sürücü düğümü varsayılan olarak çalışan düğümüyle aynı örnek türünü kullansa da, sürücü ve çalışan düğümleri için ayrı bulut sağlayıcısı örnek türleri seçebilirsiniz. Farklı örnek türü aileleri, yoğun bellek kullanan veya işlem yoğunluklu iş yükleri gibi farklı kullanım örneklerine uyar.

Çalışan veya sürücü düğümü olarak kullanılacak bir havuz da seçebilirsiniz. Bkz. Azure Databricks havuzları nedir?.

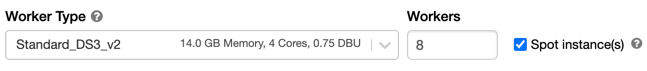

Çalışan türü

Çok düğümlü işlemde, çalışan düğümleri düzgün çalışan işlem için gereken Spark yürütücülerini ve diğer hizmetleri çalıştırır. İş yükünüzü Spark ile dağıttığınızda tüm dağıtılmış işlemler çalışan düğümlerinde gerçekleşir. Azure Databricks, çalışan düğümü başına bir yürütücü çalıştırır. Bu nedenle yürütücü ve çalışan terimleri Databricks mimarisi bağlamında birbirinin yerine kullanılır.

İpucu

Spark işini çalıştırmak için en az bir çalışan düğümüne ihtiyacınız vardır. İşlemde sıfır çalışan varsa, sürücü düğümünde Spark olmayan komutları çalıştırabilirsiniz, ancak Spark komutları başarısız olur.

Çalışan düğümü IP adresleri

Azure Databricks, her biri iki özel IP adresine sahip çalışan düğümlerini başlatır. Düğümün birincil özel IP adresi Azure Databricks iç trafiğini barındırıyor. İkincil özel IP adresi Spark kapsayıcısı tarafından küme içi iletişim için kullanılır. Bu model, Azure Databricks'in aynı çalışma alanında birden çok işlem arasında yalıtım sağlamasına olanak tanır.

Sürücü türü

Sürücü düğümü, işlemle ilgili tüm not defterlerinin durum bilgilerini korur. Sürücü düğümü ayrıca SparkContext'i korur, işlemdeki bir not defterinden veya kitaplıktan çalıştırdığınız tüm komutları yorumlar ve Spark yürütücüleriyle eşgüdümlü Apache Spark yöneticisini çalıştırır.

Sürücü düğümü türünün varsayılan değeri çalışan düğümü türününkiyle aynıdır. Spark çalışanlarından çok fazla veri almayı ve bunları not defterinde analiz etmeyi collect() planlıyorsanız daha fazla belleğe sahip daha büyük bir sürücü düğümü türü seçebilirsiniz.

İpucu

Sürücü düğümü ekli not defterlerinin tüm durum bilgilerini koruduğundan, kullanılmayan not defterlerini sürücü düğümünden ayırdığından emin olun.

GPU örneği türleri

Azure Databricks, derin öğrenmeyle ilişkili olanlar gibi yüksek performans gerektiren hesaplama açısından zorlu görevler için grafik işleme birimleri (GPU) ile hızlandırılmış işlem desteği sağlar. Daha fazla bilgi için bkz . GPU özellikli işlem.

Azure gizli bilgi işlem VM'leri

Azure gizli bilgi işlem VM türleri, bulut operatörü de dahil olmak üzere kullanımda olan verilere yetkisiz erişimi engeller. Bu VM türü, yüksek düzeyde düzenlenmiş sektörler ve bölgelerin yanı sıra bulutta hassas verilere sahip işletmeler için yararlıdır. Azure'ın gizli bilgi işlemi hakkında daha fazla bilgi için bkz . Azure gizli bilgi işlem.

Azure gizli bilgi işlem VM'lerini kullanarak iş yüklerinizi çalıştırmak için çalışan ve sürücü düğümü açılır listelerindeki DC veya EC serisi VM türleri arasından seçim yapın. Bkz. Azure Gizli VM seçenekleri.

Spot örnekleri

Maliyetten tasarruf etmek için Spot örnekleri onay kutusunu işaretleyerek Azure Spot VM'leri olarak da bilinen spot örnekleri kullanmayı seçebilirsiniz.

İlk örnek her zaman isteğe bağlı olacaktır (sürücü düğümü her zaman isteğe bağlıdır) ve sonraki örnekler spot örnekler olacaktır.

Örnekler kullanılamadığı için çıkarılırsa, Azure Databricks çıkarılan örnekleri değiştirmek için yeni spot örnekleri almayı dener. Spot örnekler alınamazsa, çıkarılan örneklerin yerine isteğe bağlı örnekler dağıtılır. Ayrıca, mevcut işleme yeni düğümler eklendiğinde Azure Databricks bu düğümler için spot örnekler almayı dener.

Otomatik ölçeklendirmeyi etkinleştirme

Otomatik ölçeklendirmeyi etkinleştir seçeneği işaretlendiğinde işlem için en az ve en fazla çalışan sayısını sağlayabilirsiniz. Databricks daha sonra işinizi çalıştırmak için gereken uygun sayıda çalışanı seçer.

İşleminizin otomatik olarak ölçeklenecek en düşük ve en fazla çalışan sayısını ayarlamak için Çalışan türü açılan listesinin yanındaki En az çalışan ve En fazla çalışan alanı alanlarını kullanın.

Otomatik ölçeklendirmeyi etkinleştirmezseniz, Çalışan türü açılan listesinin yanındaki Çalışanlar alanına sabit sayıda çalışan girersiniz.

Not

İşlem çalışırken, işlem ayrıntıları sayfasında ayrılan çalışanların sayısı görüntülenir. Ayrılan çalışan sayısını çalışan yapılandırmasıyla karşılaştırabilir ve gerektiğinde ayarlamalar yapabilirsiniz.

Otomatik ölçeklendirmenin avantajları

Otomatik ölçeklendirme sayesinde Azure Databricks, çalışanlarınızı işinizin özelliklerini hesaba eklemek için dinamik olarak yeniden ayırır. İşlem hattınızın bazı bölümleri diğerlerinden daha hesaplama açısından daha zorlu olabilir ve Databricks işinizin bu aşamalarında otomatik olarak ek çalışanlar ekler (ve artık gerekli olmadığında bunları kaldırır).

Otomatik ölçeklendirme, bir iş yüküyle eşleşmesi için işlem sağlamanız gerekmeyen yüksek kullanımın elde edilebildiğinden daha kolay hale getirir. Bu, özellikle gereksinimleri zaman içinde değişen iş yükleri için geçerlidir (örneğin, bir gün boyunca bir veri kümesini keşfetmek gibi), ancak sağlama gereksinimleri bilinmeyen bir kerelik daha kısa bir iş yükü için de geçerli olabilir. Bu nedenle otomatik ölçeklendirme iki avantaj sunar:

- İş yükleri, sabit boyutlu, az sağlanan bir işlemle karşılaştırıldığında daha hızlı çalışabilir.

- Otomatik ölçeklendirme, statik olarak boyutlandırılmış bir işlemle karşılaştırıldığında genel maliyetleri azaltabilir.

İşlemin ve iş yükünün sabit boyutuna bağlı olarak, otomatik ölçeklendirme size bu avantajlardan birini veya ikisini aynı anda sağlar. İşlem boyutu, bulut sağlayıcısı örnekleri sonlandırdığında seçilen en düşük çalışan sayısının altına inebilir. Bu durumda Azure Databricks, en az çalışan sayısını korumak için örnekleri yeniden sağlamayı sürekli olarak yeniden denenir.

Not

spark-submit işleri için otomatik ölçeklendirme kullanılamıyor.

Not

İşlem otomatik ölçeklendirmesi, Yapılandırılmış Akış iş yükleri için küme boyutunu azaltmayla ilgili sınırlamalara sahiptir. Databricks, akış iş yükleri için Gelişmiş Otomatik Ölçeklendirme ile Delta Live Tablolarının kullanılmasını önerir. Bkz . Gelişmiş Otomatik Ölçeklendirme ile Delta Live Tables işlem hatlarının küme kullanımını iyileştirme.

Otomatik ölçeklendirmenin davranışı

Premium ve Kurumsal fiyatlandırma planlarındaki çalışma alanı, iyileştirilmiş otomatik ölçeklendirmeyi kullanır. Standart fiyatlandırma planındaki çalışma alanları standart otomatik ölçeklendirmeyi kullanır.

İyileştirilmiş otomatik ölçeklendirme aşağıdaki özelliklere sahiptir:

- 2 adımda en düşükten maks.'ye ölçeklendirilir.

- İşlem boşta olmasa bile karışık dosya durumuna bakarak ölçeği küçültebilir.

- Geçerli düğümlerin yüzdesine göre ölçeği küçültür.

- İş işlemlerinde, işlem son 40 saniye içinde az kullanılıyorsa ölçeği azaltılır.

- Tüm amaçlı işlemlerde, işlem son 150 saniye içinde az kullanılıyorsa ölçeği küçültür.

spark.databricks.aggressiveWindowDownSSpark yapılandırma özelliği, saniyeler içinde işlem ölçeği azaltma kararları alma sıklıklarını belirtir. Değerin artırılması, işlem ölçeğinin daha yavaş küçültülmesine neden olur. En yüksek değer 600'dür.

Standart otomatik ölçeklendirme, standart plan çalışma alanlarında kullanılır. Standart otomatik ölçeklendirme aşağıdaki özelliklere sahiptir:

- 8 düğüm ekleyerek başlar. Ardından üstel olarak ölçeği artırarak maksimuma ulaşmak için gereken kadar adım atabilirsiniz.

- Düğümlerin %90'ı 10 dakika meşgul olmadığında ve işlem en az 30 saniye boşta kaldığında ölçeği küçültür.

- 1 düğümden başlayarak ölçeği üstel olarak daraltır.

Havuzlarla otomatik ölçeklendirme

İşleminizi bir havuza ekliıyorsanız aşağıdakileri göz önünde bulundurun:

- İstenen işlem boyutunun havuzdaki en az boştaki örnek sayısından küçük veya buna eşit olduğundan emin olun. Daha büyükse, işlem başlatma süresi havuz kullanmayan işlemle eşdeğer olacaktır.

- Maksimum işlem boyutunun havuzun maksimum kapasitesinden küçük veya buna eşit olduğundan emin olun. Daha büyükse işlem oluşturma işlemi başarısız olur.

Otomatik ölçeklendirme örneği

Statik bir işlemi otomatik ölçeklendirme için yeniden yapılandırırsanız, Azure Databricks işlemi en düşük ve en yüksek sınırlar içinde hemen yeniden boyutlandırır ve ardından otomatik ölçeklendirmeyi başlatır. Örnek olarak, işlemi 5 ile 10 düğüm arasında otomatik ölçeklendirme için yeniden yapılandırırsanız, aşağıdaki tabloda belirli bir başlangıç boyutuyla hesaplamanın ne olacağı gösterilmektedir.

| İlk boyut | Yeniden yapılandırmadan sonra boyut |

|---|---|

| 6 | 6 |

| 12 | 10 |

| 3 | 5 |

Yerel depolamayı otomatik ölçeklendirmeyi etkinleştirme

Genellikle belirli bir işin ne kadar disk alanı alacağını tahmin etmek zor olabilir. Azure Databricks, oluşturma sırasında işleminize kaç gigabaytlık yönetilen disk iliştirmek zorunda olmadığınızı tahmin etmek zorunda kalmaktan kurtarmak için, tüm Azure Databricks işlemlerinde yerel depolamanın otomatik olarak ölçeklenmesine otomatik olarak olanak tanır.

Yerel depolamayı otomatik ölçeklendirme ile Azure Databricks, işleminizin Spark çalışanlarında kullanılabilir boş disk alanı miktarını izler. Bir çalışan diskte çok az çalışmaya başlarsa Databricks, disk alanı dolmadan önce çalışana otomatik olarak yeni bir yönetilen disk ekler. Diskler, sanal makine başına toplam 5 TB disk alanı sınırına (sanal makinenin ilk yerel depolama alanı dahil) bağlanır.

Bir sanal makineye bağlı yönetilen diskler yalnızca sanal makine Azure'a döndürülürken ayrılır. Yani, yönetilen diskler çalışan bir işlem parçası oldukları sürece hiçbir zaman bir sanal makineden ayrılmaz. Azure Databricks, yönetilen disk kullanımının ölçeğini küçültmek için bu özelliğin otomatik ölçeklendirme işlemi veya otomatik sonlandırma ile yapılandırılmış işlemde kullanılmasını önerir.

Yerel disk şifrelemesi

Önemli

Bu özellik Genel Önizlemededir.

İşlemi çalıştırmak için kullandığınız bazı örnek türlerinde yerel olarak bağlı diskler olabilir. Azure Databricks, karışık verileri veya kısa ömürlü verileri bu yerel olarak eklenmiş disklerde depolar. İşleminizin yerel disklerinde geçici olarak depolanan karıştırma verileri de dahil olmak üzere bekleyen tüm verilerin tüm depolama türleri için şifrelendiğinden emin olmak için yerel disk şifrelemesini etkinleştirebilirsiniz.

Önemli

Yerel birimlere şifrelenmiş verileri okuma ve yazmanın performans üzerindeki etkisi nedeniyle iş yükleriniz daha yavaş çalışabilir.

Yerel disk şifrelemesi etkinleştirildiğinde, Azure Databricks yerel olarak her işlem düğümü için benzersiz olan ve yerel disklerde depolanan tüm verileri şifrelemek için kullanılan bir şifreleme anahtarı oluşturur. Anahtarın kapsamı her işlem düğümü için yereldir ve işlem düğümünün kendisiyle birlikte yok edilir. Anahtar, kullanım ömrü boyunca şifreleme ve şifre çözme için bellekte bulunur ve diskte şifrelenmiş olarak depolanır.

Yerel disk şifrelemesini etkinleştirmek için Kümeler API'sini kullanmanız gerekir. İşlem oluşturma veya düzenleme sırasında olarak trueayarlayınenable_local_disk_encryption.

Otomatik sonlandırma

İşlem için otomatik sonlandırma ayarlayabilirsiniz. İşlem oluşturma sırasında, işlem sonlandırılmasını istediğiniz işlem dışı süreyi dakika cinsinden belirtin.

geçerli saat ile işlemdeki son komut çalıştırması arasındaki fark belirtilen etkinlik dışı süreden fazlaysa, Azure Databricks bu işlemi otomatik olarak sonlandırır. İşlem sonlandırma hakkında daha fazla bilgi için bkz . İşlemi sonlandırma.

Etiketler

Etiketler, kuruluşunuzdaki çeşitli gruplar tarafından kullanılan bulut kaynaklarının maliyetini kolayca izlemenizi sağlar. İşlem oluştururken etiketleri anahtar-değer çiftleri olarak belirtin; Azure Databricks bu etiketleri VM'ler ve disk birimleri gibi bulut kaynaklarına ve DBU kullanım raporlarına uygular.

Havuzlardan başlatılan işlem için özel etiketler yalnızca DBU kullanım raporlarına uygulanır ve bulut kaynaklarına yayılmaz.

Havuz ve işlem etiketi türlerinin birlikte nasıl çalıştığı hakkında ayrıntılı bilgi için bkz. Etiketleri kullanarak kullanımı izleme

İşleminize etiket eklemek için:

- Etiketler bölümünde, her özel etiket için bir anahtar-değer çifti ekleyin.

- Ekle'yi tıklatın.

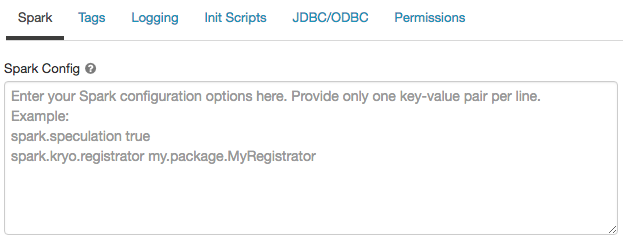

Spark yapılandırması

Spark işlerine ince ayar yapmak için özel Spark yapılandırma özellikleri sağlayabilirsiniz.

İşlem yapılandırması sayfasında Gelişmiş Seçenekler iki durumlu düğmesine tıklayın.

Spark sekmesine tıklayın.

Spark yapılandırmasında yapılandırma özelliklerini satır başına bir anahtar-değer çifti olarak girin.

Kümeler API'sini kullanarak işlem yapılandırdığınızda, küme oluşturma API'sindeki veya Kümeyi güncelleştir API'sindekispark_confalanda Spark özelliklerini ayarlayın.

İşlemde Spark yapılandırmalarını zorunlu kılmak için çalışma alanı yöneticileri işlem ilkelerini kullanabilir.

Gizli diziden Spark yapılandırma özelliği alma

Databricks, parolalar gibi hassas bilgilerin düz metin yerine gizli dizide depolanmasını önerir. Spark yapılandırmasında gizli diziye başvurmak için aşağıdaki söz dizimini kullanın:

spark.<property-name> {{secrets/<scope-name>/<secret-name>}}

Örneğin, içinde depolanan secrets/acme_app/passwordgizli dizi değerine çağrılan password bir Spark yapılandırma özelliği ayarlamak için:

spark.password {{secrets/acme-app/password}}

Daha fazla bilgi için bkz . Spark yapılandırma özelliğinde veya ortam değişkeninde gizli dizilere başvurmak için söz dizimi.

İşlem için SSH erişimi

Güvenlik nedeniyle, Azure Databricks'te SSH bağlantı noktası varsayılan olarak kapatılır. Spark kümelerinize SSH erişimini etkinleştirmek istiyorsanız bkz . Sürücü düğümüne SSH.

Not

SSH yalnızca çalışma alanınız kendi Azure sanal ağınızda dağıtıldığında etkinleştirilebilir.

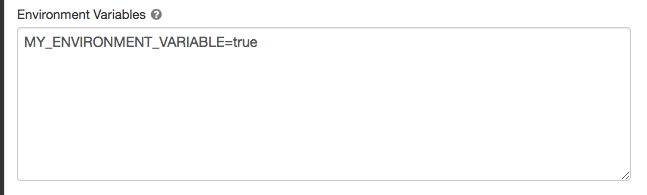

Ortam değişkenleri

İşlem üzerinde çalışan init betiklerinden erişebileceğiniz özel ortam değişkenlerini yapılandırın. Databricks, başlatma betiklerinde kullanabileceğiniz önceden tanımlanmış ortam değişkenleri de sağlar. Önceden tanımlanmış bu ortam değişkenlerini geçersiz kılamazsınız.

İşlem yapılandırması sayfasında Gelişmiş Seçenekler iki durumlu düğmesine tıklayın.

Spark sekmesine tıklayın.

Ortam Değişkenleri alanında ortam değişkenlerini ayarlayın.

Ortam değişkenlerini küme oluşturma API'sindeki spark_env_vars veya Kümeyi güncelleştir API'sindekialanı kullanarak da ayarlayabilirsiniz.

İşlem günlüğü teslimi

İşlem oluştururken Spark sürücü düğümü, çalışan düğümleri ve olaylar için günlükleri teslim etmek için bir konum belirtebilirsiniz. Günlükler beş dakikada bir teslim edilir ve seçtiğiniz hedefte saatlik olarak arşivlenir. Bir işlem sonlandırıldığında Azure Databricks, işlem sonlandırılana kadar oluşturulan tüm günlükleri teslim etme garantisi sağlar.

Günlüklerin hedefi, işleminin cluster_idöğesine bağlıdır. Belirtilen hedef ise dbfs:/cluster-log-delivery, için 0630-191345-leap375 işlem günlükleri adresine dbfs:/cluster-log-delivery/0630-191345-leap375teslim edilir.

Günlük teslim konumunu yapılandırmak için:

- İşlem sayfasında Gelişmiş Seçenekler iki durumlu düğmesine tıklayın.

- Günlük sekmesine tıklayın.

- Bir hedef türü seçin.

- İşlem günlüğü yolunu girin.

Geri Bildirim

Çok yakında: 2024 boyunca, içerik için geri bildirim mekanizması olarak GitHub Sorunları’nı kullanımdan kaldıracak ve yeni bir geri bildirim sistemiyle değiştireceğiz. Daha fazla bilgi için bkz. https://aka.ms/ContentUserFeedback.

Gönderin ve geri bildirimi görüntüleyin