Microsoft Fabric'te Pandas ile veri okuma ve yazma

Microsoft Fabric not defterleri, veri araştırma ve işleme için en popüler Python kitaplığı olan Pandas'ı kullanarak Lakehouse verileriyle sorunsuz etkileşimi destekler. Bir not defteri içinde, Lakehouse kaynaklarından çeşitli dosya biçimlerindeki verileri hızla okuyabilir ve bu kaynaklara geri yazabilirsiniz. Bu kılavuz, kendi not defterinize başlamanıza yardımcı olacak kod örnekleri sağlar.

Önkoşullar

Microsoft Fabric aboneliği alın. Alternatif olarak, ücretsiz bir Microsoft Fabric deneme sürümüne kaydolun.

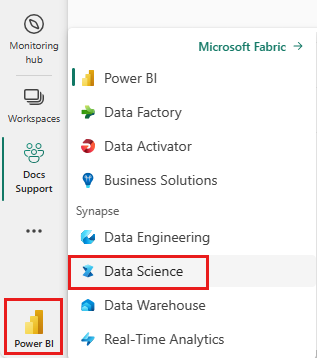

Synapse Veri Bilimi deneyimine geçmek için giriş sayfanızın sol tarafındaki deneyim değiştiriciyi kullanın.

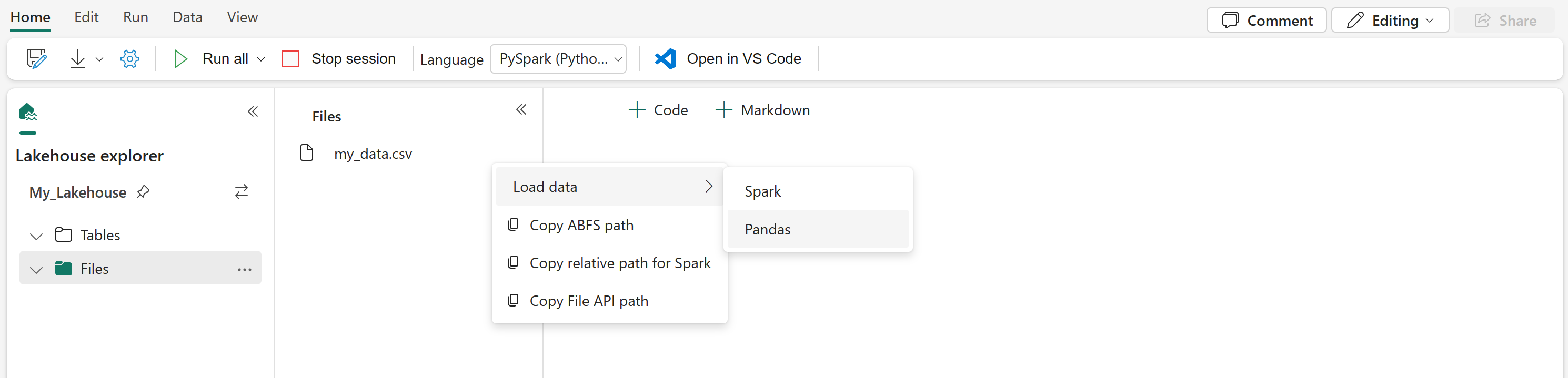

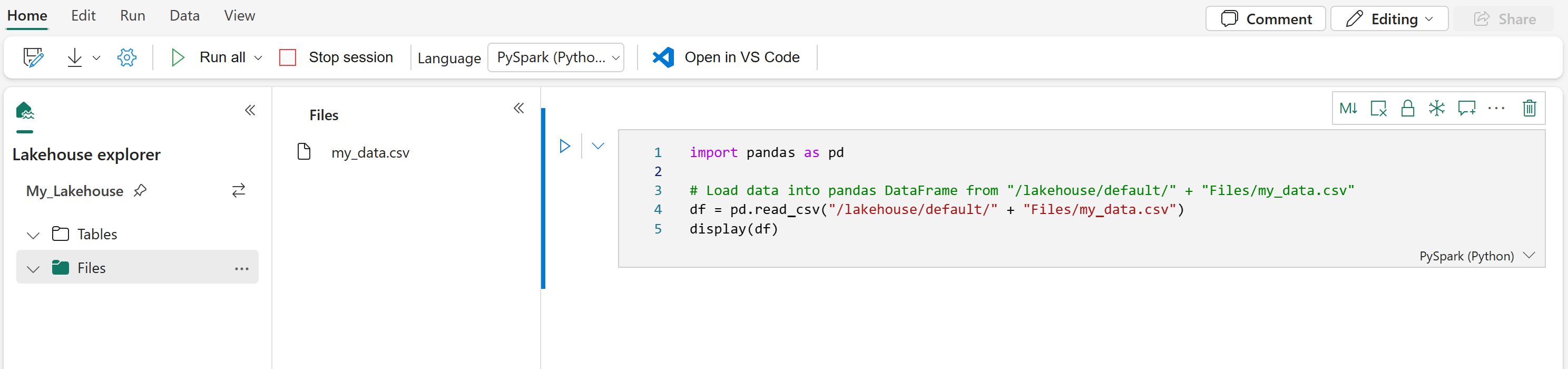

Lakehouse verilerini not defterine yükleme

Microsoft Fabric not defterinize bir Lakehouse ekledikten sonra, depolanan verileri sayfadan çıkmadan keşfedebilir ve birkaç adımda not defterinizde okuyabilirsiniz. Herhangi bir Lakehouse dosyasının seçilmesi, Spark veya Pandas DataFrame'e "Veri yükleme" seçeneklerini ortaya çıkar. Dosyanın tam ABFS yolunu veya kolay bir göreli yolu da kopyalayabilirsiniz.

"Verileri yükle" istemlerinden birinin seçilmesi, bu dosyayı not defterinizdeki bir DataFrame'e yüklemek için bir kod hücresi oluşturur.

Spark DataFrame'i Pandas DataFrame'e dönüştürme

Başvuru için, bu komut Spark DataFrame'in Pandas DataFrame'e nasıl dönüştürüldüğünü gösterir:

# Replace "spark_df" with the name of your own Spark DataFrame

pandas_df = spark_df.toPandas()

Çeşitli dosya biçimlerini okuma ve yazma

Bu kod örnekleri, çeşitli dosya biçimlerini okumak ve yazmak için Pandas işlemlerini açıklar.

Not

Bu kod örneklerindeki dosya yollarını değiştirmeniz gerekir. Pandas burada gösterildiği gibi hem göreli yolları hem de tam ABFS yollarını destekler. Her iki türdeki yollar önceki adıma göre arabirimden alınabilir ve kopyalanabilir.

CSV dosyasından veri okuma

import pandas as pd

# Read a CSV file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

display(df)

Verileri CSV dosyası olarak yazma

import pandas as pd

# Write a Pandas DataFrame into a CSV file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

Parquet dosyasından veri okuma

import pandas as pd

# Read a Parquet file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pandas.read_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

display(df)

Parquet dosyası olarak veri yazma

import pandas as pd

# Write a Pandas DataFrame into a Parquet file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

Excel dosyasından veri okuma

import pandas as pd

# Read an Excel file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pandas.read_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

display(df)

Verileri Excel dosyası olarak yazma

import pandas as pd

# Write a Pandas DataFrame into an Excel file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

JSON dosyasından veri okuma

import pandas as pd

# Read a JSON file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pandas.read_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

display(df)

Verileri JSON dosyası olarak yazma

import pandas as pd

# Write a Pandas DataFrame into a JSON file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

İlgili içerik

- Verilerinizi temizlemek ve hazırlamak için Data Wrangler kullanma

- ML modellerini eğitmeye başlama

Geri Bildirim

Çok yakında: 2024 boyunca, içerik için geri bildirim mekanizması olarak GitHub Sorunları’nı kullanımdan kaldıracak ve yeni bir geri bildirim sistemiyle değiştireceğiz. Daha fazla bilgi için bkz. https://aka.ms/ContentUserFeedback.

Gönderin ve geri bildirimi görüntüleyin