在 Azure Data Studio 的 SQL Server 大数据群集 上提交 Spark 作业

适用于: SQL Server 2019 (15.x)

重要

Microsoft SQL Server 2019 大数据群集附加产品将停用。 对 SQL Server 2019 大数据群集的支持将于 2025 年 2 月 28 日结束。 具有软件保障的 SQL Server 2019 的所有现有用户都将在平台上获得完全支持,在此之前,该软件将继续通过 SQL Server 累积更新进行维护。 有关详细信息,请参阅公告博客文章和 Microsoft SQL Server 平台上的大数据选项。

大数据群集的关键方案之一是能够为 SQL Server 提交 Spark 作业。 使用 Spark 作业提交功能,你可以提交引用 SQL Server 2019 大数据群集的的本地 Jar 或 Py 文件。 它还允许你执行已经位于 HDFS 文件系统中的 Jar 或 Py 文件。

先决条件

-

- Azure Data Studio

- SQL Server 2019 扩展

- kubectl

打开 Spark 作业提交对话框

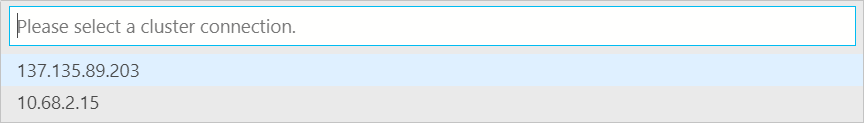

可以通过多种方式打开 Spark 作业提交对话框。 其中包括仪表板、对象资源管理器中的上下文菜单和命令面板。

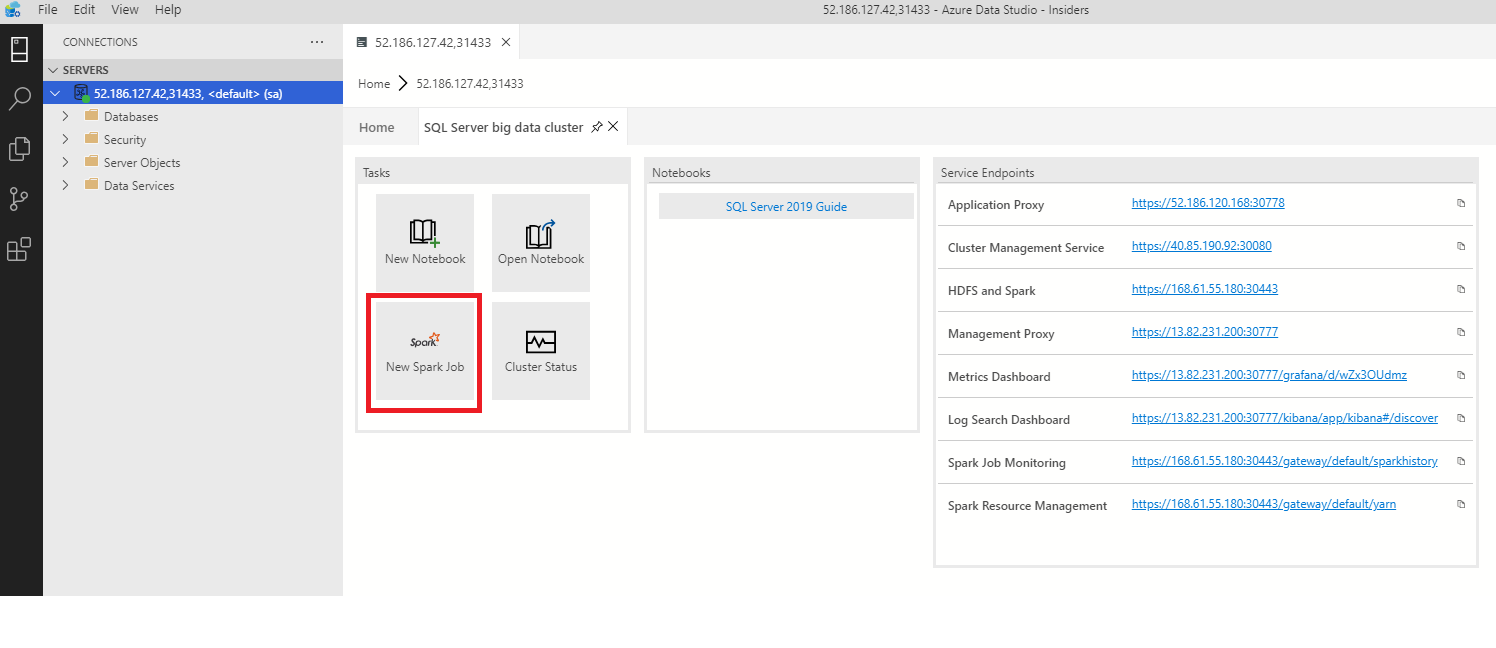

若要打开 Spark 作业提交对话框,请单击仪表板中的“新建 Spark 作业”。

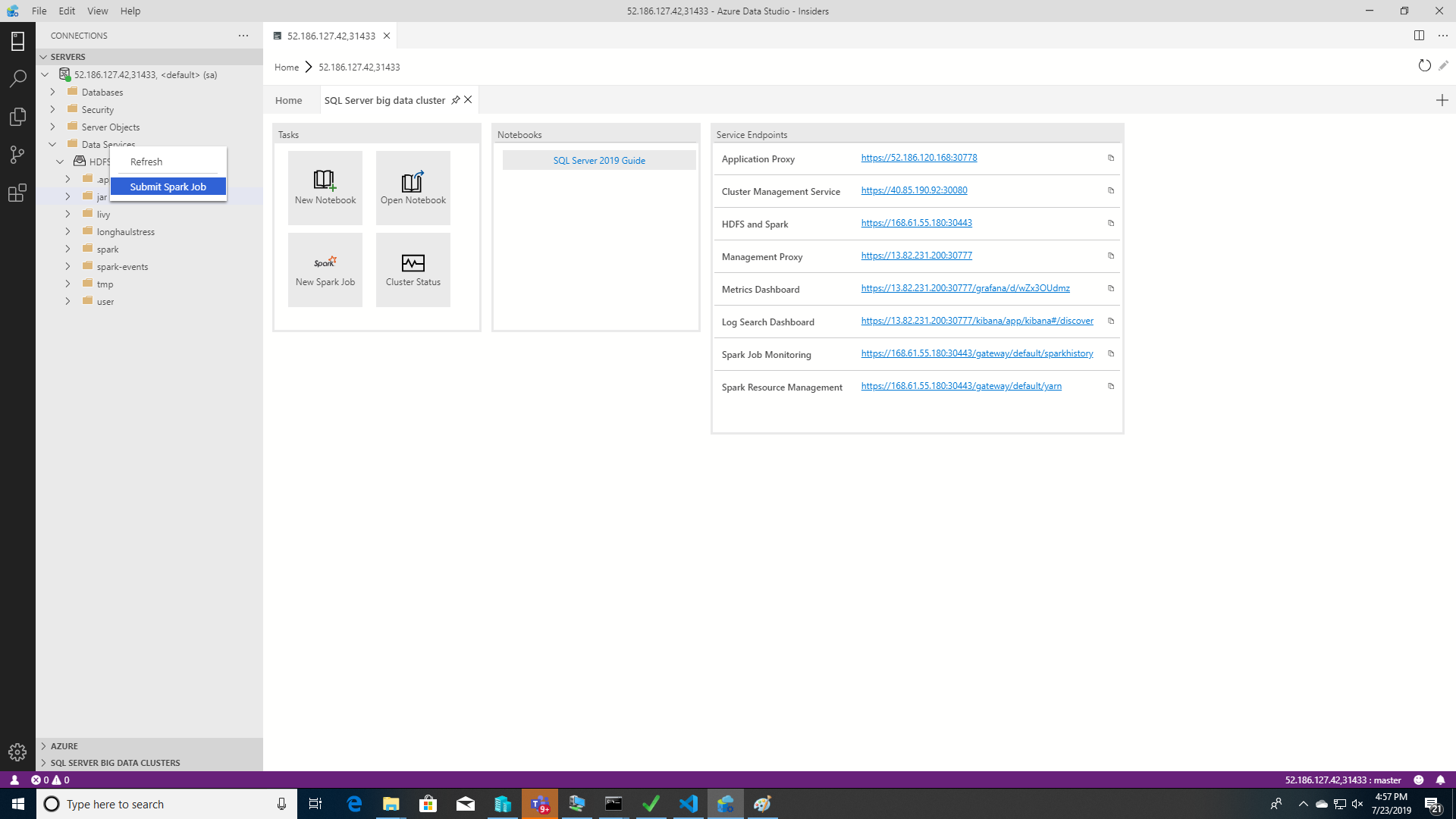

或者在对象资源管理器中右键单击群集,然后从上下文菜单中选择“提交 Spark 作业”。

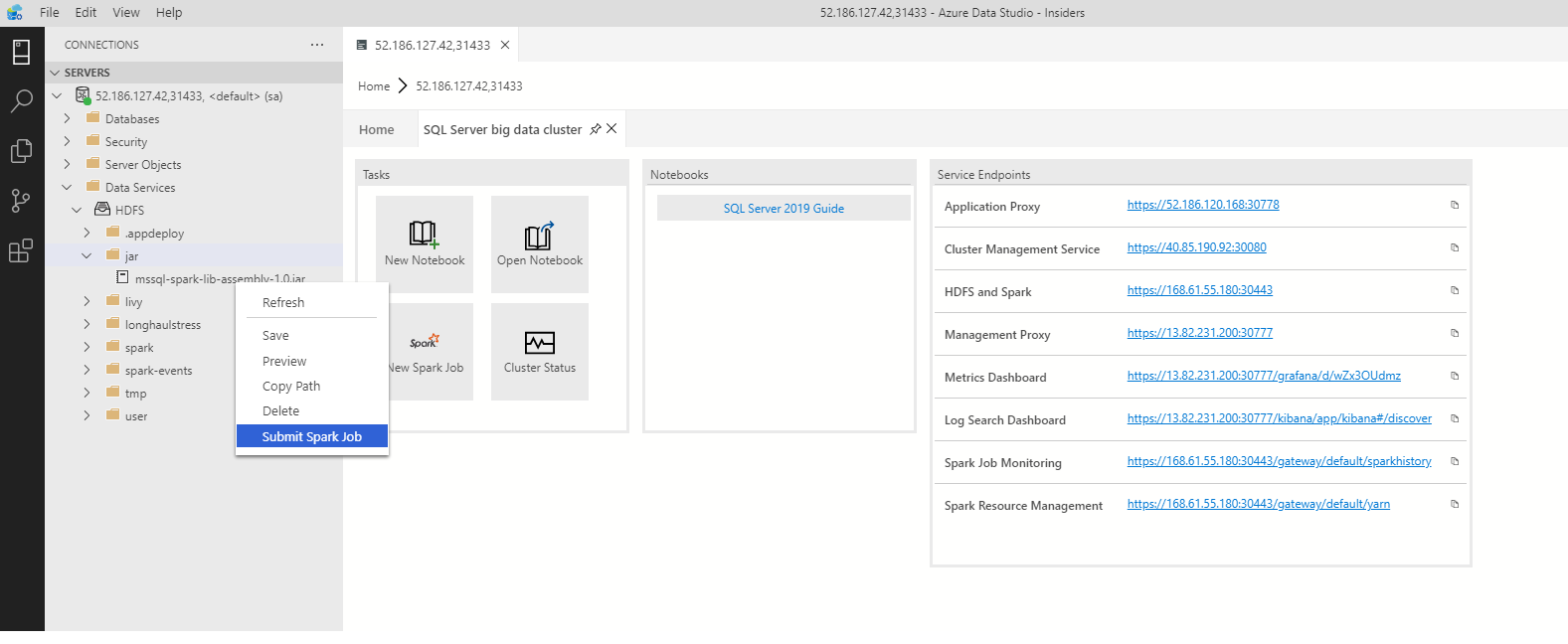

若要打开预填充了 Jar/Py 字段的 Spark 作业提交对话框,请在对象资源管理器中右键单击某个 Jar/Py 文件,然后从上下文菜单中选择“提交 Spark 作业”。

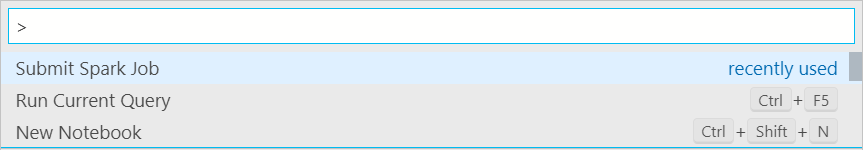

通过键入“Ctrl+Shift+P”(在 Windows 中)和“Cmd+Shift+P”(在 Mac 中),从命令面板中使用“提交 Spark 作业” 。

提交 Spark 作业

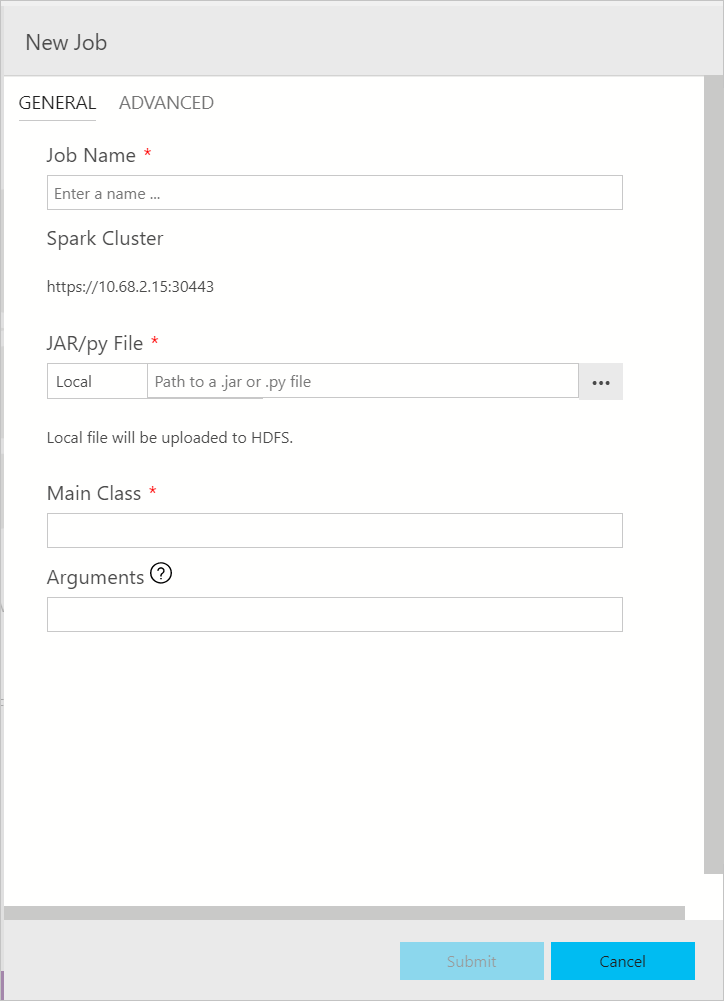

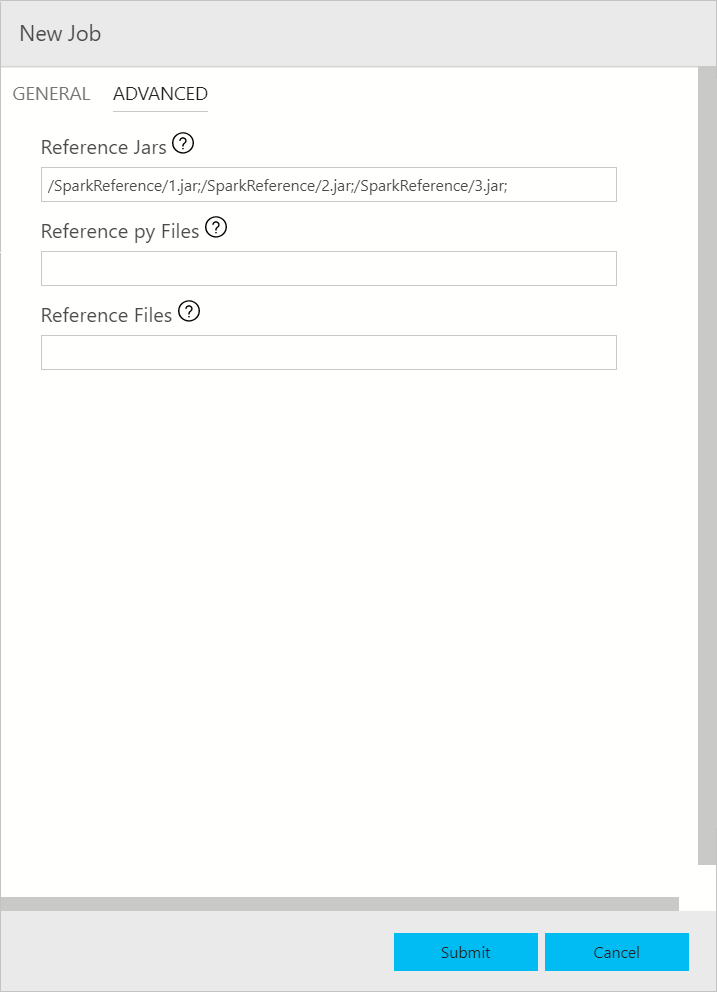

Spark 作业提交对话框如下所示。 输入作业名称、JAR/Py 文件路径、主类和其他字段。 Jar/Py 文件源可以来自本地或 HDFS。 如果 Spark 作业引用了 Jar、Py 文件或其他文件,请单击“高级”选项卡并输入相应的文件路径。 单击“提交”以提交 Spark 作业。

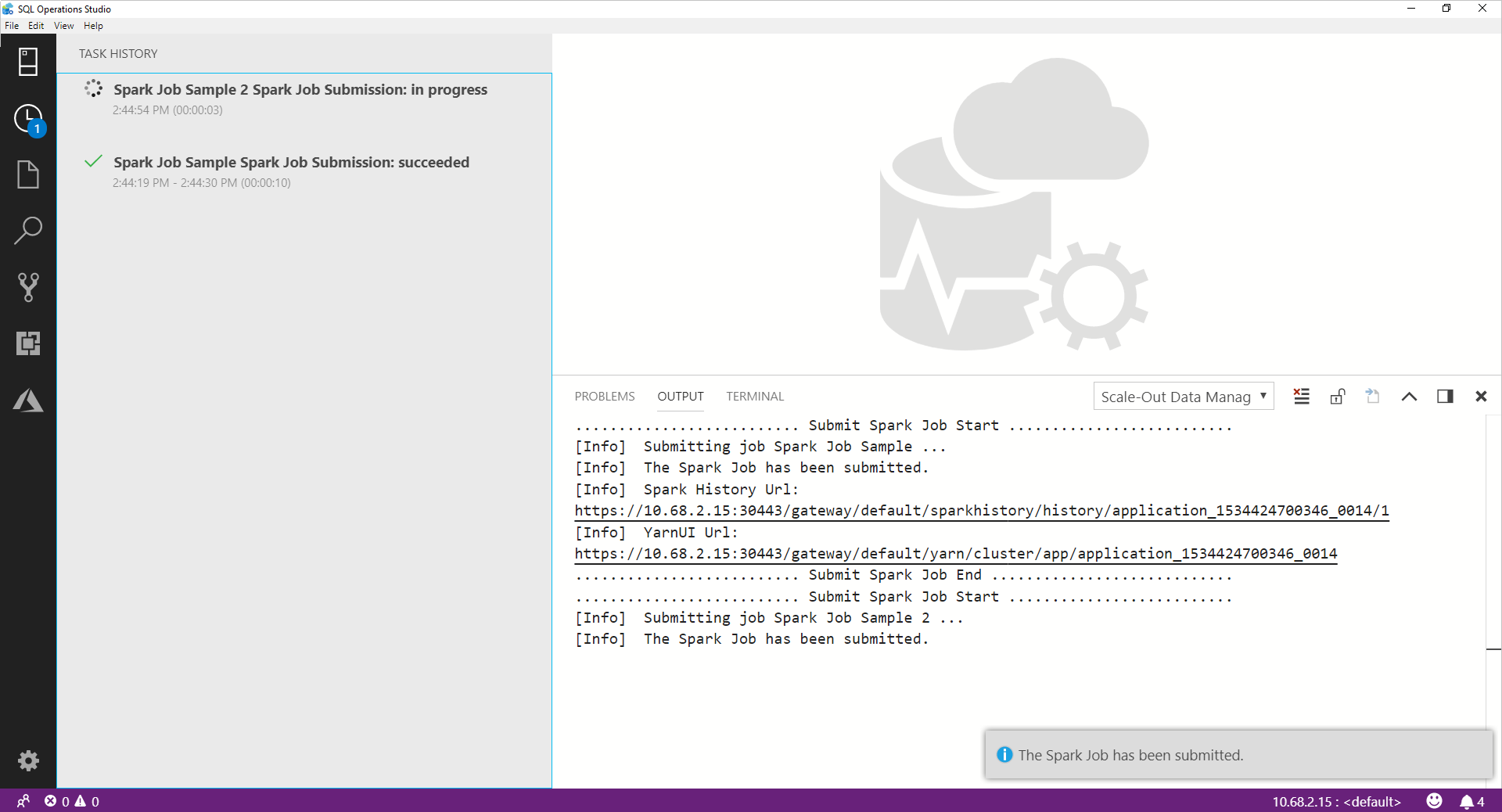

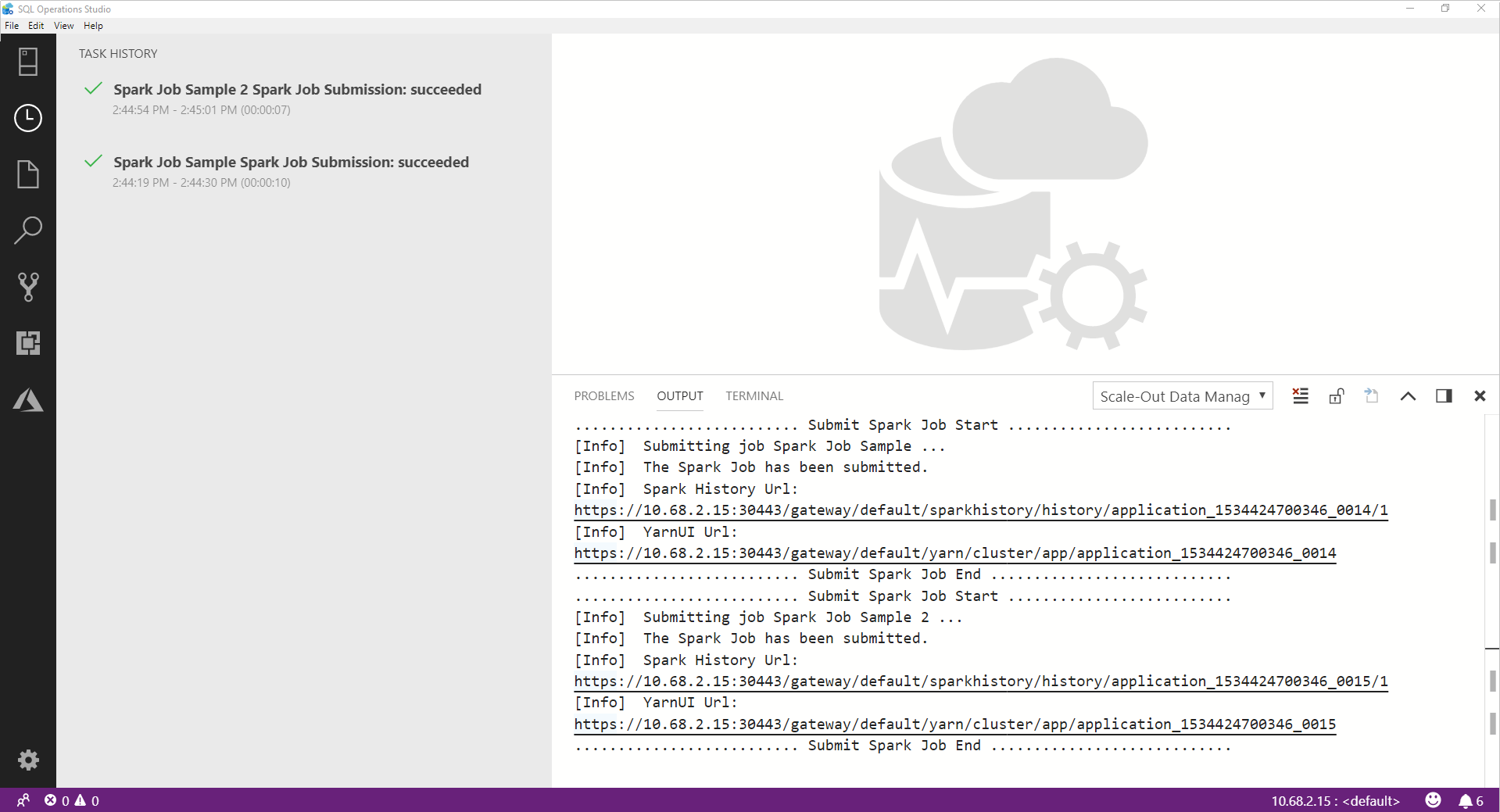

监视 Spark 作业提交

提交 Spark 作业后,Spark 作业提交和执行状态信息显示在左侧的“任务历史记录”中。 有关进度和日志的详细信息也显示在底部的“输出”窗口中。

当 Spark 作业正在进行时,“任务历史记录”面板和“输出”窗口会刷新进度 。

当 Spark 作业成功完成后,Spark UI 和 Yarn UI 链接显示在“输出”窗口中。 单击链接可获取详细信息。

后续步骤

有关 SQL Server 大数据群集和相关方案的详细信息,请参阅 SQL Server 大数据群集简介。

反馈

即将发布:在整个 2024 年,我们将逐步淘汰作为内容反馈机制的“GitHub 问题”,并将其取代为新的反馈系统。 有关详细信息,请参阅:https://aka.ms/ContentUserFeedback。

提交和查看相关反馈