مرجع تكوين الحساب

تشرح هذه المقالة جميع إعدادات التكوين المتوفرة في واجهة مستخدم Create Compute. يقوم معظم المستخدمين بإنشاء حساب باستخدام النهج المعينة، ما يحد من الإعدادات القابلة للتكوين. إذا لم تشاهد إعدادا معينا في واجهة المستخدم الخاصة بك، فهذا لأن النهج الذي حددته لا يسمح لك بتكوين هذا الإعداد.

تنطبق التكوينات وأدوات الإدارة الموضحة في هذه المقالة على كل من الأغراض والحوسبة الوظيفية. لمزيد من الاعتبارات حول تكوين حساب الوظيفة، راجع استخدام حساب Azure Databricks مع وظائفك.

السياسات

النهج هي مجموعة من القواعد المستخدمة للحد من خيارات التكوين المتاحة للمستخدمين عند إنشاء الحوسبة. إذا لم يكن لدى المستخدم استحقاق إنشاء نظام المجموعة غير المقيد، فيمكنه إنشاء حساب فقط باستخدام النهج الممنوحة له.

لإنشاء حساب وفقا لنهج، حدد نهج من القائمة المنسدلة Policy .

بشكل افتراضي، يمكن لجميع المستخدمين الوصول إلى نهج الحوسبة الشخصية، ما يسمح لهم بإنشاء موارد حساب جهاز واحد. إذا كنت بحاجة إلى الوصول إلى الحوسبة الشخصية أو أي نهج إضافية، فتواصل مع مسؤول مساحة العمل.

حساب عقدة واحدة أو حوسبة متعددة العقد

اعتمادا على النهج، يمكنك التحديد بين إنشاء حساب عقدة واحدة أو حساب عقدة متعددة.

حساب العقدة الواحدة مخصص للوظائف التي تستخدم كميات صغيرة من البيانات أو أحمال العمل غير الموزعة مثل مكتبات التعلم الآلي ذات العقدة الواحدة. يجب استخدام الحوسبة متعددة العقد للوظائف الأكبر حجما مع أحمال العمل الموزعة.

خصائص عقدة واحدة

يحتوي حساب عقدة واحدة على الخصائص التالية:

- تشغيل Spark محليا.

- يعمل برنامج التشغيل كعامل رئيسي وعامل، مع عدم وجود عقد عاملة.

- يولد مؤشر ترابط منفذ واحد لكل نواة منطقية في الحساب، ناقص 1 نواة لبرنامج التشغيل.

- يحفظ جميع

stderrمخرجات السجلstdoutو وlog4jفي سجل برنامج التشغيل. - لا يمكن تحويلها إلى حساب متعدد العقد.

تحديد عقدة واحدة أو متعددة

ضع في اعتبارك حالة الاستخدام عند اتخاذ قرار بين حساب واحد أو متعدد العقد:

ستستنفد معالجة البيانات على نطاق واسع الموارد على حساب عقدة واحدة. بالنسبة لأحمال العمل هذه، توصي Databricks باستخدام حساب متعدد العقد.

لم يتم تصميم الحوسبة أحادية العقدة لمشتركة. لتجنب تعارضات الموارد، توصي Databricks باستخدام حساب متعدد العقد عندما يجب مشاركة الحساب.

لا يمكن توسيع نطاق الحوسبة متعددة العقد إلى 0 عامل. استخدم حساب عقدة واحدة بدلا من ذلك.

حساب عقدة واحدة غير متوافق مع عزل العملية.

لم يتم تمكين جدولة وحدة معالجة الرسومات على حساب عقدة واحدة.

في الحساب أحادي العقدة، لا يمكن ل Spark قراءة ملفات Parquet باستخدام عمود UDT. نتائج رسالة الخطأ التالية:

The Spark driver has stopped unexpectedly and is restarting. Your notebook will be automatically reattached.لحل هذه المشكلة، قم بتعطيل قارئ Parquet الأصلي:

spark.conf.set("spark.databricks.io.parquet.nativeReader.enabled", False)

أوضاع الوصول

وضع الوصول هو ميزة أمان تحدد من يمكنه استخدام الحساب والبيانات التي يمكنه الوصول إليها عبر الحساب. كل حساب في Azure Databricks لديه وضع وصول.

توصي Databricks باستخدام وضع الوصول المشترك لجميع أحمال العمل. استخدم وضع وصول مستخدم واحد فقط إذا كانت الوظيفة المطلوبة غير مدعومة من قبل وضع الوصول المشترك.

| وضع الوصول | مرئي للمستخدم | دعم UC | اللغات المعتمدة | ملاحظات |

|---|---|---|---|---|

| مستخدم واحد | دائمًا | نعم | Python وSQL وSc scala وR | يمكن تعيينها واستخدامها من قبل مستخدم واحد. يشار إليه باسم وضع الوصول المعين في بعض مساحات العمل. |

| مشتركة | دائما (خطة متميزة مطلوبة) | نعم | Python (على Databricks Runtime 11.3 LTS وما فوق)، SQL، Scala (على الحوسبة الممكنة في كتالوج Unity باستخدام Databricks Runtime 13.3 LTS وما فوق) | يمكن استخدامها من قبل عدة مستخدمين مع عزل البيانات بين المستخدمين. |

| لا يوجد عزل مشترك | يمكن مسؤول إخفاء وضع الوصول هذا عن طريق فرض عزل المستخدم في صفحة إعدادات المسؤول. | لا | Python وSQL وSc scala وR | يوجد إعداد على مستوى الحساب ذي الصلة للحساب المشترك بلا عزل. |

| مخصص | مخفي (لجميع الحوسبة الجديدة) | لا | Python وSQL وSc scala وR | يظهر هذا الخيار فقط إذا كان لديك حساب موجود دون وضع وصول محدد. |

يمكنك ترقية حساب موجود لتلبية متطلبات كتالوج Unity عن طريق تعيين وضع الوصول الخاص به إلى مستخدم واحد أو مشترك.

إشعار

في Databricks Runtime 13.3 LTS وما فوق، يتم دعم البرامج النصية والمكتبات init على جميع أوضاع الوصول. تختلف المتطلبات والدعم. راجع أين يمكن تثبيت البرامج النصية init؟ والمكتبات ذات نطاق نظام المجموعة.

إصدارات وقت تشغيل Databricks

Databricks Runtime هو مجموعة من المكونات الأساسية التي تعمل على الحساب الخاص بك. حدد وقت التشغيل باستخدام القائمة المنسدلة Databricks Runtime Version . للحصول على تفاصيل حول إصدارات محددة من Databricks Runtime، راجع إصدارات ملاحظات إصدار Databricks Runtime والتوافق. تتضمن جميع الإصدارات Apache Spark. توصي Databricks بما يلي:

- للحوسبة لجميع الأغراض، استخدم أحدث إصدار للتأكد من أن لديك أحدث التحسينات وأحدث توافق بين التعليمات البرمجية والحزم المحملة مسبقا.

- لحساب الوظيفة التي تشغل أحمال العمل التشغيلية، ضع في اعتبارك استخدام إصدار وقت تشغيل الدعم طويل الأجل (LTS) Databricks. سيضمن استخدام إصدار LTS عدم تعرضك لمشكلات التوافق ويمكن اختبار حمل العمل بدقة قبل الترقية.

- بالنسبة لحالات استخدام علوم البيانات والتعلم الآلي، ضع في اعتبارك إصدار التعلم الآلي من Databricks Runtime.

استخدام تسريع الفوتون

يتم تمكين الفوتون بشكل افتراضي على حساب تشغيل Databricks Runtime 9.1 LTS وما فوق.

لتمكين تسريع Photon أو تعطيله، حدد خانة الاختيار Use Photon Acceleration . لمعرفة المزيد حول Photon، راجع ما هو Photon؟.

أنواع عقدة العامل وبرنامج التشغيل

تتكون الحوسبة من عقدة برنامج تشغيل واحدة وعقد عاملة صفرية أو أكثر. يمكنك اختيار أنواع مثيل موفر السحابة المنفصلة لعقد برنامج التشغيل والعامل، على الرغم من أن عقدة برنامج التشغيل تستخدم بشكل افتراضي نفس نوع المثيل مثل عقدة العامل. تناسب مجموعات مختلفة من أنواع المثيلات حالات استخدام مختلفة، مثل أحمال العمل كثيفة الذاكرة أو كثيفة الحوسبة.

يمكنك أيضا تحديد تجمع لاستخدامه كعقدة العامل أو برنامج التشغيل. راجع ما هي تجمعات Azure Databricks؟.

نوع العامل

في الحوسبة متعددة العقد، تقوم العقد العاملة بتشغيل منفذي Spark والخدمات الأخرى المطلوبة لحساب الأداء السليم. عند توزيع حمل العمل الخاص بك مع Spark، تحدث جميع المعالجة الموزعة على العقد العاملة. يقوم Azure Databricks بتشغيل منفذ واحد لكل عقدة عاملة. لذلك، يتم استخدام المصطلحين المنفذ والعامل بالتبادل في سياق بنية Databricks.

تلميح

لتشغيل وظيفة Spark، تحتاج إلى عقدة عاملة واحدة على الأقل. إذا كان الحساب يحتوي على صفر عامل، يمكنك تشغيل أوامر غير Spark على عقدة برنامج التشغيل، ولكن ستفشل أوامر Spark.

عناوين IP لعقدة العامل

يقوم Azure Databricks بتشغيل العقد العاملة مع عنواني IP خاصين لكل منهما. يستضيف عنوان IP الخاص الأساسي للعقدة نسبة استخدام الشبكة الداخلية ل Azure Databricks. يتم استخدام عنوان IP الخاص الثانوي بواسطة حاوية Spark للاتصال داخل نظام المجموعة. يسمح هذا النموذج ل Azure Databricks بتوفير العزل بين الحوسبة المتعددة في نفس مساحة العمل.

نوع برنامج التشغيل

تحتفظ عقدة برنامج التشغيل بمعلومات حالة جميع دفاتر الملاحظات المرفقة بالحوسبة. تحتفظ عقدة برنامج التشغيل أيضا ب SparkContext، وتفسر جميع الأوامر التي تقوم بتشغيلها من دفتر ملاحظات أو مكتبة على الحساب، وتشغل Apache Spark master الذي ينسق مع منفذي Spark.

القيمة الافتراضية لنوع عقدة برنامج التشغيل هي نفس نوع عقدة العامل. يمكنك اختيار نوع عقدة برنامج تشغيل أكبر مع ذاكرة أكبر إذا كنت تخطط للحصول على collect() الكثير من البيانات من عمال Spark وتحليلها في دفتر الملاحظات.

تلميح

نظرا لأن عقدة برنامج التشغيل تحتفظ بجميع معلومات حالة دفاتر الملاحظات المرفقة، تأكد من فصل دفاتر الملاحظات غير المستخدمة من عقدة برنامج التشغيل.

أنواع مثيلات GPU

بالنسبة للمهام الصعبة حسابيا التي تتطلب أداء عاليا، مثل تلك المرتبطة بالتعلم العميق، يدعم Azure Databricks الحوسبة المتسارعة مع وحدات معالجة الرسومات (GPUs). لمزيد من المعلومات، راجع الحوسبة الممكنة بواسطة وحدة معالجة الرسومات.

أجهزة Azure الظاهرية للحوسبة السرية

تمنع أنواع أجهزة Azure الظاهرية للحوسبة السرية الوصول غير المصرح به إلى البيانات أثناء استخدامها، بما في ذلك من مشغل السحابة. هذا النوع من الأجهزة الظاهرية مفيد للصناعات والمناطق عالية التنظيم، بالإضافة إلى الشركات التي لها بيانات حساسة في السحابة. لمزيد من المعلومات حول الحوسبة السرية في Azure، راجع حوسبة Azure السرية.

لتشغيل أحمال العمل الخاصة بك باستخدام أجهزة Azure الظاهرية للحوسبة السرية، حدد من أنواع الأجهزة الظاهرية لسلسلة DC أو EC في القوائم المنسدلة لعقدة العامل وبرنامج التشغيل. راجع خيارات Azure Confidential VM.

المثيلات الموضعية

لتوفير التكلفة، يمكنك اختيار استخدام المثيلات الموضعية، والمعروفة أيضا باسم Azure Spot VMs عن طريق تحديد خانة الاختيار مثيلات Spot.

سيكون المثيل الأول دائما عند الطلب (عقدة برنامج التشغيل دائما عند الطلب) وستكون المثيلات اللاحقة مثيلات موضعية.

إذا تم إخلاء المثيلات بسبب عدم التوفر، فسيحاول Azure Databricks الحصول على مثيلات موضعية جديدة لاستبدال المثيلات التي تم إخلاؤها. إذا تعذر الحصول على المثيلات الموضعية، يتم نشر المثيلات عند الطلب لاستبدال المثيلات التي تم إخلاؤها. بالإضافة إلى ذلك، عند إضافة عقد جديدة إلى الحوسبة الموجودة، سيحاول Azure Databricks الحصول على مثيلات موضعية لتلك العقد.

تمكين التحجيم التلقائي

عند تحديد تمكين التحجيم التلقائي، يمكنك توفير الحد الأدنى والحد الأقصى لعدد العمال للحساب. ثم يختار Databricks العدد المناسب من العمال المطلوبين لتشغيل وظيفتك.

لتعيين الحد الأدنى والحد الأقصى لعدد العمال الذين ستتدرج بينهم الحوسبة تلقائيا، استخدم حقلي Min workers وMax workers بجوار القائمة المنسدلة Worker type .

إذا لم تقم بتمكين التحجيم التلقائي، فستدخل عددا ثابتا من العمال في الحقل Workers بجوار القائمة المنسدلة Worker type .

إشعار

عند تشغيل الحساب، تعرض صفحة تفاصيل الحساب عدد العمال المخصصين. يمكنك مقارنة عدد العمال المخصصين بتكوين العامل وإجراء التعديلات حسب الحاجة.

فوائد التحجيم التلقائي

مع التحجيم التلقائي، يقوم Azure Databricks بإعادة تخصيص العمال ديناميكيا لحساب خصائص وظيفتك. قد تكون أجزاء معينة من البنية الأساسية لبرنامج ربط العمليات التجارية الخاصة بك أكثر تطلبا من غيرها من الناحية الحسابية، ويضيف Databricks تلقائيا عمالا إضافيين خلال هذه المراحل من وظيفتك (ويزيلها عندما لا تكون هناك حاجة إليها).

يسهل التحجيم التلقائي تحقيق الاستخدام العالي لأنك لا تحتاج إلى توفير الحساب لمطابقة حمل العمل. ينطبق هذا بشكل خاص على أحمال العمل التي تتغير متطلباتها بمرور الوقت (مثل استكشاف مجموعة بيانات خلال اليوم)، ولكن يمكن أن تنطبق أيضا على حمل عمل أقصر لمرة واحدة تكون متطلبات التوفير الخاصة به غير معروفة. وبالتالي، يوفر التوسع التلقائي ميزتين:

- يمكن تشغيل أحمال العمل بشكل أسرع مقارنة بالحوسبة غير المتوفرة بأحجام ثابتة.

- يمكن أن يقلل التحجيم التلقائي من التكاليف الإجمالية مقارنة بحساب بحجم ثابت.

اعتمادا على الحجم الثابت للحساب وعبء العمل، يمنحك التحجيم التلقائي إحدى هاتين المزايا أو كليهما في نفس الوقت. يمكن أن يقل حجم الحساب عن الحد الأدنى لعدد العمال المحدد عندما ينهي موفر السحابة المثيلات. في هذه الحالة، يعيد Azure Databricks المحاولة باستمرار لإعادة توفير المثيلات من أجل الحفاظ على الحد الأدنى لعدد العمال.

إشعار

لا يتوفر التحجيم التلقائي للوظائف spark-submit .

إشعار

يحتوي التحجيم التلقائي للحساب على قيود على تقليص حجم نظام المجموعة لأحمال عمل Structured Streaming. توصي Databricks باستخدام Delta Live Tables مع التحجيم التلقائي المحسن لأحمال العمل المتدفقة. راجع تحسين استخدام نظام المجموعة لخطوط أنابيب Delta Live Tables باستخدام التحجيم التلقائي المحسن.

كيفية عمل التحجيم التلقائي

تستخدم مساحة العمل في خطط تسعير Premium وEnterprise مقياسا تلقائيا محسنا. تستخدم مساحات العمل على خطة التسعير القياسية التحجيم التلقائي القياسي.

التحجيم التلقائي المحسن له الخصائص التالية:

- يتدرج من الحد الأدنى إلى الحد الأقصى في خطوتين.

- يمكن تقليص الحجم، حتى إذا لم تكن الحوسبة خاملة، من خلال النظر إلى حالة ملف التبديل العشوائي.

- يتدرج استنادا إلى نسبة مئوية من العقد الحالية.

- عند حساب الوظيفة، يتم تقليص الحجم إذا لم يتم استخدام الحوسبة بشكل صحيح خلال ال 40 ثانية الماضية.

- في الحوسبة لجميع الأغراض، يتم تقليص الحجم إذا لم يتم استخدام الحوسبة بشكل كامل خلال آخر 150 ثانية.

spark.databricks.aggressiveWindowDownSتحدد خاصية تكوين Spark بالثوان عدد المرات التي يتخذ فيها الحساب قرارات تقليص الحجم. تؤدي زيادة القيمة إلى تقليص الحوسبة ببطء أكبر. الحد الأقصى للقيمة هو 600.

يتم استخدام التحجيم التلقائي القياسي في مساحات عمل الخطة القياسية. التحجيم التلقائي القياسي له الخصائص التالية:

- يبدأ بإضافة 8 عقد. ثم يتوسع بشكل كبير، مع اتخاذ العديد من الخطوات كما هو مطلوب للوصول إلى الحد الأقصى.

- يتم تقليصه عندما لا تكون 90٪ من العقد مشغولة لمدة 10 دقائق وكان الحساب خاملا لمدة 30 ثانية على الأقل.

- يتدرج بشكل كبير، بدءا من عقدة واحدة.

التحجيم التلقائي مع التجمعات

إذا كنت تقوم بإرفاق الحساب الخاص بك بتجمع، ففكر في ما يلي:

- تأكد من أن حجم الحساب المطلوب أقل من أو يساوي الحد الأدنى لعدد المثيلات الخاملة في التجمع. إذا كان أكبر، فسيكون وقت بدء تشغيل الحساب مكافئا للحساب الذي لا يستخدم تجمعا.

- تأكد من أن الحد الأقصى لحجم الحساب أقل من أو يساوي الحد الأقصى لسعة التجمع. إذا كان أكبر، فسيفشل إنشاء الحساب.

مثال التحجيم التلقائي

إذا قمت بإعادة تكوين حساب ثابت للتحجيم التلقائي، يقوم Azure Databricks على الفور بتغيير حجم الحساب ضمن الحد الأدنى والحد الأقصى ثم يبدأ التوسع التلقائي. على سبيل المثال، يوضح الجدول التالي ما يحدث للحساب بحجم أولي معين إذا قمت بإعادة تكوين الحساب للتحجيم التلقائي بين 5 و10 عقد.

| الحجم الأولي | الحجم بعد إعادة التكوين |

|---|---|

| 6 | 6 |

| 12 | 10 |

| 3 | 5 |

تمكين التخزين المحلي للتحجيم التلقائي

قد يكون من الصعب في كثير من الأحيان تقدير مقدار مساحة القرص التي ستستغرقها مهمة معينة. لحفظك من الاضطرار إلى تقدير عدد الجيجابايت من القرص المدار لإرفاقه بالحوسبة الخاصة بك في وقت الإنشاء، تمكن Azure Databricks تلقائيا من التحجيم التلقائي للتخزين المحلي على جميع حوسبة Azure Databricks.

مع التخزين المحلي للتحجيم التلقائي، يراقب Azure Databricks مقدار مساحة القرص الفارغة المتوفرة على عمال Spark لحسابك. إذا بدأ العامل في التشغيل منخفضا جدا على القرص، يقوم Databricks تلقائيا بإرفاق قرص مدار جديد بالعامل قبل نفاد مساحة القرص. يتم إرفاق الأقراص بحد أقصى 5 ТБ من إجمالي مساحة القرص لكل جهاز ظاهري (بما في ذلك التخزين المحلي الأولي للجهاز الظاهري).

يتم فصل الأقراص المدارة المرفقة بجهاز ظاهري فقط عند إرجاع الجهاز الظاهري إلى Azure. أي أن الأقراص المدارة لا يتم فصلها أبدا عن جهاز ظاهري طالما أنها جزء من حساب قيد التشغيل. لتقليل استخدام القرص المدار، توصي Azure Databricks باستخدام هذه الميزة في الحوسبة التي تم تكوينها باستخدام حساب التحجيم التلقائي أو الإنهاء التلقائي.

تشفير القرص المحلي

قد تحتوي بعض أنواع المثيلات التي تستخدمها لتشغيل الحساب على أقراص مرفقة محليا. قد يخزن Azure Databricks بيانات عشوائية أو بيانات سريعة الزوال على هذه الأقراص المرفقة محليا. للتأكد من تشفير جميع البيانات الثابتة لجميع أنواع التخزين، بما في ذلك تبديل البيانات المخزنة مؤقتا على الأقراص المحلية للحساب، يمكنك تمكين تشفير القرص المحلي.

هام

قد تعمل أحمال العمل الخاصة بك ببطء أكبر بسبب تأثير أداء قراءة وكتابة البيانات المشفرة من وإلى وحدات التخزين المحلية.

عند تمكين تشفير القرص المحلي، ينشئ Azure Databricks مفتاح تشفير محليا فريدا لكل عقدة حساب ويستخدم لتشفير جميع البيانات المخزنة على الأقراص المحلية. نطاق المفتاح محلي لكل عقدة حساب ويتم إتلافه جنبا إلى جنب مع عقدة الحساب نفسها. خلال مدة بقائه، يتواجد المفتاح في الذاكرة للتشفير وفك التشفير ويتم تخزينه مشفرا على القرص.

لتمكين تشفير القرص المحلي، يجب استخدام واجهة برمجة تطبيقات أنظمة المجموعات. أثناء إنشاء الحساب أو تحريره، قم بتعيين enable_local_disk_encryption إلى true.

الإنهاء التلقائي

يمكنك تعيين الإنهاء التلقائي للحساب. أثناء إنشاء الحساب، حدد فترة عدم النشاط بالدقائق التي تريد إنهاء الحساب بعدها.

إذا كان الفرق بين الوقت الحالي والأمر الأخير الذي يتم تشغيله على الحساب أكثر من فترة عدم النشاط المحددة، يقوم Azure Databricks تلقائيا بإنهاء هذا الحساب. لمزيد من المعلومات حول إنهاء الحساب، راجع إنهاء حساب.

علامات

تسمح لك العلامات بمراقبة تكلفة موارد السحابة المستخدمة من قبل مجموعات مختلفة في مؤسستك بسهولة. حدد العلامات كأزواج قيم المفاتيح عند إنشاء حساب، ويطبق Azure Databricks هذه العلامات على موارد السحابة مثل الأجهزة الظاهرية ووحدات تخزين القرص، بالإضافة إلى تقارير استخدام DBU.

بالنسبة للحساب الذي تم تشغيله من التجمعات، يتم تطبيق العلامات المخصصة فقط على تقارير استخدام DBU ولا يتم نشرها إلى موارد السحابة.

للحصول على معلومات مفصلة حول كيفية عمل أنواع علامات التجمع والحوسبة معا، راجع مراقبة الاستخدام باستخدام العلامات

لإضافة علامات إلى الحساب الخاص بك:

- في قسم Tags ، أضف زوجا من قيم المفاتيح لكل علامة مخصصة.

- انقر فوق إضافة.

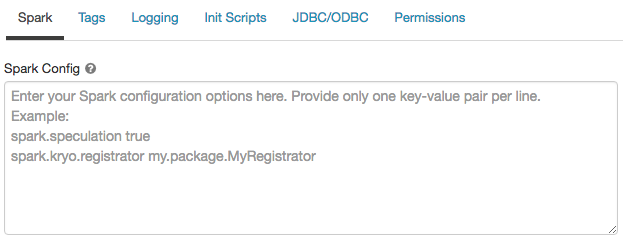

تكوين Spark

لضبط مهام Spark، يمكنك توفير خصائص تكوين Spark مخصصة.

في صفحة تكوين الحساب، انقر فوق تبديل خيارات متقدمة.

انقر فوق علامة التبويب Spark.

في تكوين Spark، أدخل خصائص التكوين كزوج قيمة مفتاح واحد لكل سطر.

عند تكوين الحوسبة باستخدام واجهة برمجة تطبيقات المجموعات، قم بتعيين خصائص Spark في spark_conf الحقل في إنشاء واجهة برمجة تطبيقات نظام المجموعة أو تحديث واجهة برمجة تطبيقات نظام المجموعة.

لفرض تكوينات Spark على الحوسبة، يمكن لمسؤولي مساحة العمل استخدام نهج الحوسبة.

استرداد خاصية تكوين Spark من سر

توصي Databricks بتخزين المعلومات الحساسة، مثل كلمات المرور، في بيانات سرية بدلا من نص عادي. للإشارة إلى سر في تكوين Spark، استخدم بناء الجملة التالي:

spark.<property-name> {{secrets/<scope-name>/<secret-name>}}

على سبيل المثال، لتعيين خاصية تكوين Spark التي تم استدعاؤها password إلى قيمة السر المخزن في secrets/acme_app/password:

spark.password {{secrets/acme-app/password}}

لمزيد من المعلومات، راجع بناء الجملة للإشارة إلى الأسرار في خاصية تكوين Spark أو متغير البيئة.

وصول SSH إلى الحوسبة

لأسباب أمنية، في Azure Databricks يتم إغلاق منفذ SSH بشكل افتراضي. إذا كنت ترغب في تمكين وصول SSH إلى مجموعات Spark، فشاهد SSH إلى عقدة برنامج التشغيل.

إشعار

يمكن تمكين SSH فقط إذا تم نشر مساحة العمل الخاصة بك في شبكة Azure الظاهرية الخاصة بك.

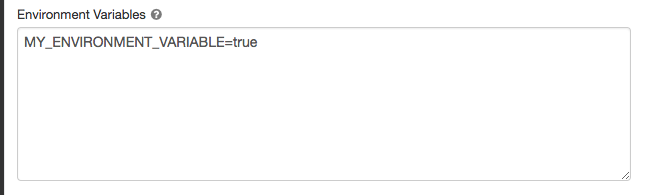

متغيرات البيئة

تكوين متغيرات البيئة المخصصة التي يمكنك الوصول إليها من البرامج النصية init التي تعمل على الحساب. يوفر Databricks أيضا متغيرات بيئة محددة مسبقا يمكنك استخدامها في البرامج النصية init. لا يمكنك تجاوز متغيرات البيئة المعرفة مسبقا هذه.

في صفحة تكوين الحساب، انقر فوق تبديل خيارات متقدمة.

انقر فوق علامة التبويب Spark.

تعيين متغيرات البيئة في حقل متغيرات البيئة.

يمكنك أيضا تعيين متغيرات البيئة باستخدام spark_env_vars الحقل في Create cluster API أو Update cluster API.

تسليم سجل الحساب

عند إنشاء حساب، يمكنك تحديد موقع لتسليم سجلات عقدة برنامج تشغيل Spark وعقد العامل والأحداث. يتم تسليم السجلات كل خمس دقائق وأرشفة كل ساعة في الوجهة التي اخترتها. عند إنهاء حساب، يضمن Azure Databricks تسليم جميع السجلات التي تم إنشاؤها حتى يتم إنهاء الحساب.

تعتمد وجهة السجلات على حساب cluster_id. إذا كانت الوجهة المحددة هي dbfs:/cluster-log-delivery، يتم تسليم سجلات الحوسبة ل 0630-191345-leap375 إلى dbfs:/cluster-log-delivery/0630-191345-leap375.

لتكوين موقع تسليم السجل:

- في صفحة الحوسبة، انقر فوق تبديل خيارات متقدمة.

- انقر فوق علامة التبويب تسجيل.

- حدد نوع الوجهة.

- أدخل مسار سجل الحساب.

إشعار

تتوفر هذه الميزة أيضا في واجهة برمجة تطبيقات REST. راجع واجهة برمجة تطبيقات المجموعات.

الملاحظات

قريبًا: خلال عام 2024، سنتخلص تدريجيًا من GitHub Issues بوصفها آلية إرسال ملاحظات للمحتوى ونستبدلها بنظام ملاحظات جديد. لمزيد من المعلومات، راجع https://aka.ms/ContentUserFeedback.

إرسال الملاحظات وعرضها المتعلقة بـ