إشعار

يتطلب الوصول إلى هذه الصفحة تخويلاً. يمكنك محاولة تسجيل الدخول أو تغيير الدلائل.

يتطلب الوصول إلى هذه الصفحة تخويلاً. يمكنك محاولة تغيير الدلائل.

إشعار

تتناول هذه المقالة Databricks Connect ل Databricks Runtime 13.3 LTS وما فوق.

توضح هذه المقالة كيفية بدء استخدام Databricks Connect بسرعة باستخدام Python وPyCharm.

- للحصول على إصدار R من هذه المقالة، راجع Databricks Connect for R.

- للحصول على إصدار Scala من هذه المقالة، راجع Databricks Connect ل Scala.

يمكنك Databricks Connect من توصيل IDEs الشائعة مثل PyCharm وخوادم دفتر الملاحظات والتطبيقات المخصصة الأخرى إلى مجموعات Azure Databricks. راجع ما هو Databricks Connect؟.

برنامج تعليمي

لتخطي هذا البرنامج التعليمي واستخدام IDE مختلف بدلا من ذلك، راجع الخطوات التالية.

المتطلبات

لإكمال هذا البرنامج التعليمي، يجب أن تفي بالمتطلبات التالية:

- يجب تمكين كتالوج Unity لمساحة عمل Azure Databricks المستهدفة.

- لديك PyCharm مثبت. تم اختبار هذا البرنامج التعليمي مع PyCharm Community Edition 2023.3.5. إذا كنت تستخدم إصدارا أو إصدارا مختلفا من PyCharm، فقد تختلف الإرشادات التالية.

- يفي الحساب الخاص بك بمتطلبات تثبيت Databricks Connect ل Python.

- إذا كنت تستخدم الحوسبة الكلاسيكية، فستحتاج إلى معرف نظام المجموعة. للحصول على معرف نظام المجموعة، في مساحة العمل، انقر فوق حساب على الشريط الجانبي، ثم انقر فوق اسم نظام المجموعة. في شريط عناوين مستعرض الويب، انسخ سلسلة الأحرف بين

clustersعنوان URL وفيهconfiguration.

الخطوة 1: تكوين مصادقة Azure Databricks

يستخدم هذا البرنامج التعليمي مصادقة Azure Databricks OAuth من مستخدم إلى جهاز (U2M) وملف تعريف تكوين Azure Databricks للمصادقة على مساحة عمل Azure Databricks. لاستخدام نوع مصادقة مختلف، راجع تكوين خصائص الاتصال.

يتطلب تكوين مصادقة OAuth U2M CLI Databricks. للحصول على معلومات حول تثبيت Databricks CLI، راجع تثبيت Databricks CLI أو تحديثه.

بدء مصادقة OAuth U2M، كما يلي:

استخدم Databricks CLI لبدء إدارة الرمز المميز OAuth محليا عن طريق تشغيل الأمر التالي لكل مساحة عمل هدف.

في الأمر التالي، استبدل

<workspace-url>بعنوان URL الخاص ب Azure Databricks لكل مساحة عمل، على سبيل المثالhttps://adb-1234567890123456.7.azuredatabricks.net.databricks auth login --configure-cluster --host <workspace-url>تلميح

لاستخدام حساب بلا خادم مع Databricks Connect، راجع تكوين اتصال بالحوسبة بلا خادم.

يطالبك Databricks CLI بحفظ المعلومات التي أدخلتها كملف تعريف تكوين Azure Databricks. اضغط

Enterلقبول اسم ملف التعريف المقترح، أو أدخل اسم ملف تعريف جديد أو موجود. تتم الكتابة فوق أي ملف تعريف موجود بنفس الاسم بالمعلومات التي أدخلتها. يمكنك استخدام ملفات التعريف لتبديل سياق المصادقة بسرعة عبر مساحات عمل متعددة.للحصول على قائمة بأي ملفات تعريف موجودة، في محطة طرفية منفصلة أو موجه أوامر، استخدم Databricks CLI لتشغيل الأمر

databricks auth profiles. لعرض الإعدادات الموجودة لملف تعريف معين، قم بتشغيل الأمرdatabricks auth env --profile <profile-name>.في مستعرض الويب الخاص بك، أكمل الإرشادات التي تظهر على الشاشة لتسجيل الدخول إلى مساحة عمل Azure Databricks.

في قائمة المجموعات المتوفرة التي تظهر في الوحدة الطرفية أو موجه الأوامر، استخدم مفاتيح الأسهم لأعلى ولأسفل لتحديد مجموعة Azure Databricks الهدف في مساحة العمل الخاصة بك، ثم اضغط

Enterعلى . يمكنك أيضا كتابة أي جزء من اسم عرض نظام المجموعة لتصفية قائمة المجموعات المتوفرة.لعرض قيمة رمز OAuth المميز الحالي لملف التعريف والطوابع الزمنية لانتهاء الصلاحية القادمة للرمز المميز، قم بتشغيل أحد الأوامر التالية:

databricks auth token --host <workspace-url>databricks auth token -p <profile-name>databricks auth token --host <workspace-url> -p <profile-name>

إذا كان لديك ملفات تعريف متعددة بنفس

--hostالقيمة، فقد تحتاج إلى تحديد--hostالخيارات و-pمعا لمساعدة Databricks CLI في العثور على معلومات الرمز المميز OAuth المتطابقة الصحيحة.

الخطوة 2: إنشاء المشروع

- ابدأ تشغيل PyCharm.

- في القائمة الرئيسية، انقر فوق ملف > مشروع جديد.

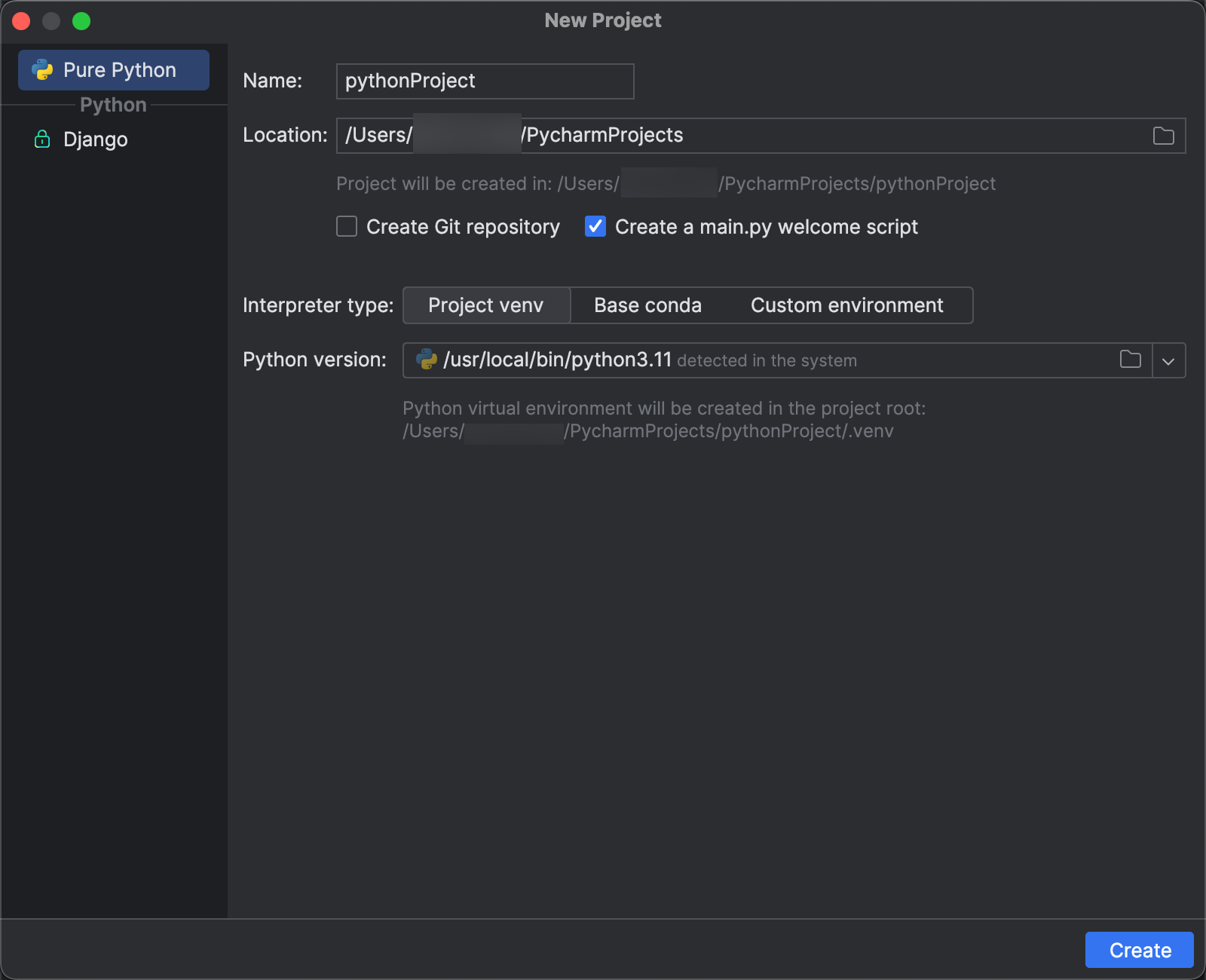

- في مربع الحوار New Project ، انقر فوق Pure Python.

- بالنسبة إلى الموقع، انقر فوق أيقونة المجلد، وأكمل التوجيهات التي تظهر على الشاشة لتحديد المسار إلى مشروع Python الجديد.

- اترك Create a main.py welcome script محددا.

- بالنسبة لنوع المترجم، انقر فوق Project venv.

- قم بتوسيع إصدار Python، واستخدم أيقونة المجلد أو القائمة المنسدلة لتحديد المسار إلى مترجم Python من المتطلبات السابقة.

- انقر فوق Create.

الخطوة 3: إضافة حزمة Databricks Connect

- في القائمة الرئيسية ل PyCharm، انقر فوق عرض > أداة حزم Windows > Python.

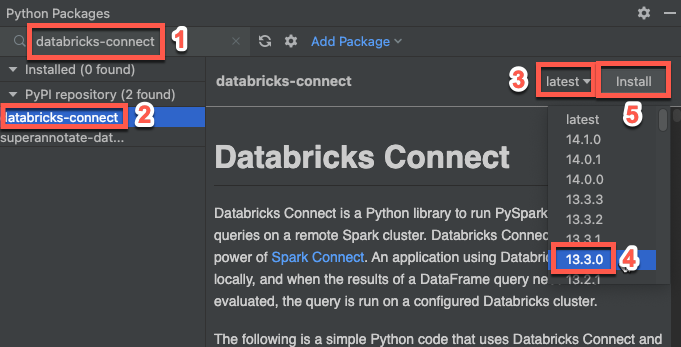

- في مربع البحث، أدخل

databricks-connect. - في قائمة مستودع PyPI، انقر فوق databricks-connect.

- في القائمة المنسدلة الأحدث لجزء النتائج، حدد الإصدار الذي يطابق إصدار Databricks Runtime لنظام المجموعة. على سبيل المثال، إذا كانت مجموعتك تحتوي على Databricks Runtime 14.3 مثبتة، فحدد 14.3.1.

- انقر فوق تثبيت الحزمة.

- بعد تثبيت الحزمة، يمكنك إغلاق نافذة حزم Python .

الخطوة 4: إضافة تعليمة برمجية

في نافذة أداة Project، انقر بزر الماوس الأيمن فوق المجلد الجذر للمشروع، وانقر فوق ملف Python جديد>.

أدخل

main.pyملف Python وانقر نقرا مزدوجا فوقه.أدخل التعليمات البرمجية التالية في الملف ثم احفظ الملف، اعتمادا على اسم ملف تعريف التكوين الخاص بك.

إذا كان ملف تعريف التكوين الخاص بك من الخطوة 1 يسمى

DEFAULT، فأدخل التعليمات البرمجية التالية في الملف، ثم احفظ الملف:from databricks.connect import DatabricksSession spark = DatabricksSession.builder.getOrCreate() df = spark.read.table("samples.nyctaxi.trips") df.show(5)إذا لم تتم تسمية

DEFAULTملف تعريف التكوين الخاص بك من الخطوة 1 ، أدخل التعليمات البرمجية التالية في الملف بدلا من ذلك. استبدل العنصر النائب<profile-name>باسم ملف تعريف التكوين من الخطوة 1، ثم احفظ الملف:from databricks.connect import DatabricksSession spark = DatabricksSession.builder.profile("<profile-name>").getOrCreate() df = spark.read.table("samples.nyctaxi.trips") df.show(5)

الخطوة 5: تشغيل التعليمات البرمجية

- ابدأ تشغيل نظام المجموعة الهدف في مساحة عمل Azure Databricks البعيدة.

- بعد بدء تشغيل نظام المجموعة، في القائمة الرئيسية، انقر فوق Run > Run 'main'.

- في نافذة أداة التشغيل (عرض > أداة تشغيل Windows>)، في الجزء الرئيسي لعلامة التبويب تشغيل، تظهر أول 5 صفوف من .

samples.nyctaxi.trips

الخطوة 6: تصحيح التعليمات البرمجية

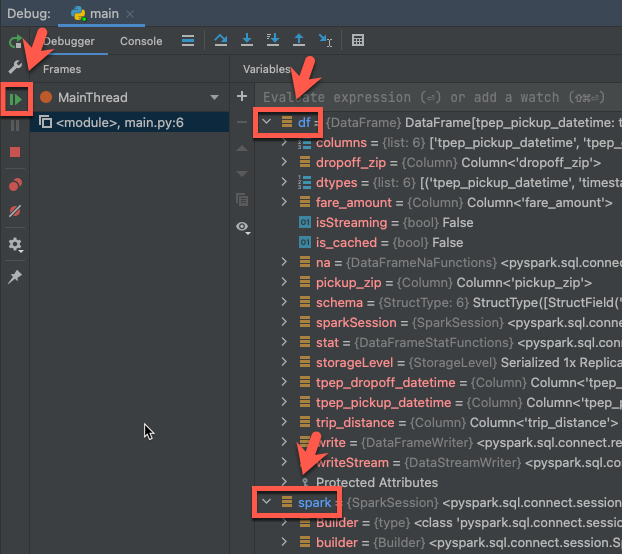

- مع استمرار تشغيل نظام المجموعة، في التعليمات البرمجية السابقة، انقر فوق التوثيق بجوار

df.show(5)لتعيين نقطة توقف. - في القائمة الرئيسية، انقر فوق Run > Debug 'main'.

- في نافذة أداة تتبع الأخطاء (View > Tool Windows > Debug)، في جزء المتغيرات في علامة التبويب Debugger، قم بتوسيع العقد المتغيرة df وspark لاستعراض معلومات حول التعليمات البرمجية

dfوالمتغيراتspark. - في الشريط الجانبي لنافذة أداة التصحيح ، انقر فوق أيقونة السهم الأخضر (استئناف البرنامج).

- في جزء وحدة تحكم علامة التبويب Debugger، تظهر أول 5 صفوف من .

samples.nyctaxi.trips

الخطوات التالية

لمعرفة المزيد حول Databricks Connect، راجع مقالات مثل ما يلي:

- لاستخدام نوع مصادقة مختلف، راجع تكوين خصائص الاتصال.

- لاستخدام معرفات أخرى وخوادم دفتر ملاحظات وSpark shell، راجع ما يلي:

- لعرض أمثلة تعليمات برمجية بسيطة إضافية، راجع أمثلة التعليمات البرمجية ل Databricks Connect ل Python.

- لعرض أمثلة تعليمات برمجية أكثر تعقيدا، راجع أمثلة التطبيقات لمستودع Databricks Connect في GitHub، على وجه التحديد:

- لاستخدام Databricks Utilities مع Databricks Connect، راجع Databricks Utilities with Databricks Connect for Python.

- للترحيل من Databricks Connect ل Databricks Runtime 12.2 LTS والإصدارات أدناه إلى Databricks Connect ل Databricks Runtime 13.3 LTS وما فوق، راجع الترحيل إلى Databricks Connect ل Python.

- راجع أيضا معلومات حول استكشاف الأخطاء وإصلاحها والقيود.