قابلية تفسير النموذج

توضح هذه المقالة الأساليب التي يمكنك استخدامها لقابلية تفسير النموذج في التعلم الآلي من Microsoft Azure.

هام

مع إصدار لوحة معلومات AI المسؤولة التي تتضمن إمكانية تفسير النموذج، نوصي بالترحيل إلى التجربة الجديدة، لأنه لن يتم الاحتفاظ بلوحة معلومات تفسير نموذج إصدار أولي SDK الإصدار 1 الأقدم بشكل نشط.

لماذا تعد قابلية تفسير النموذج مهمة لنموذج تصحيح الأخطاء

عند استخدام نماذج التعلم الآلي بطرق تؤثر على حياة الأشخاص، من المهم للغاية فهم ما يؤثر على سلوك النماذج. قابلية التفسير تساعد على الإجابة عن الأسئلة في سيناريوهات مثل:

- تصحيح أخطاء النموذج: لماذا ارتكب نموذجي هذا الخطأ؟ كيف يمكنني تحسين نموذجي؟

- التعاون بين الإنسان الذكاء الاصطناعي: كيف يمكنني فهم قرارات النموذج والثقة بها؟

- الامتثال التنظيمي: هل يلبي نموذجي المتطلبات القانونية؟

يساهم مكون قابلية التفسير في لوحة معلومات الذكاء الاصطناعي المسؤولة في مرحلة "التشخيص" لسير عمل دورة حياة النموذج من خلال إنشاء أوصاف يمكن فهمها من قبل الإنسان لتوقعات نموذج التعلم الآلي. يوفر طرق عرض متعددة في سلوك النموذج:

- التفسيرات العالمية: على سبيل المثال، ما الميزات التي تؤثر على السلوك العام لنموذج تخصيص القرض؟

- التفسيرات المحلية: على سبيل المثال، لماذا تمت الموافقة على طلب قرض العميل أو رفضه؟

يمكنك أيضًا ملاحظة تفسيرات النموذج لمجموعة من المستخدمين مختارة كمجموعة فرعية من نقاط البيانات. هذا النهج ذو قيمة عندما يقيم، على سبيل المثال، فأنت تقوم بتقييم الإنصاف في تنبؤات النموذج للأفراد في مجموعة ديموغرافية معينة. تمثل علامة التبويب التفسير المحلي لهذا المكون أيضًا تصورًا كاملاً للبيانات، وهو أمر رائع لمقلة البيانات العامة والنظر في الاختلافات بين التنبؤات الصحيحة وغير الصحيحة لكل مجموعة من المستخدمين.

يتم تأسيس إمكانيات هذا المكوّن من خلال حزمة InterpretML، والتي تنشئ تفسيرات النموذج.

استخدم القابلية للتفسير عندما تحتاج إلى:

- حدد مدى موثوقية تنبؤات نظام الذكاء الاصطناعي من خلال فهم الميزات الأكثر أهمية للتنبؤات.

- اقترب من تصحيح أخطاء النموذج الخاص بك عن طريق فهمه أولاً وتحديد ما إذا كان النموذج يستخدم ميزات صحية أم مجرد ارتباطات زائفة.

- اكتشف المصادر المحتملة للظلم من خلال فهم ما إذا كان النموذج يؤسس التنبؤ على ميزات حساسة أو ميزات مرتبطة ارتباطًا وثيقًا بها.

- بناء ثقة المستخدم في قرارات النموذج الخاص بك من خلال إنشاء تفسيرات محلية لتوضيح نتائجها.

- أكمل تدقيقاً تنظيمياً لنظام الذكاء الاصطناعي للتحقق من صحة النماذج ومراقبة تأثير القرارات النموذجية على البشر.

كيف تفسر نموذجك؟

في التعلم الآلي، الميزات هي حقول البيانات التي استخدمتها للتنبؤ بنقطة البيانات المستهدفة. على سبيل المثال، للتنبؤ بخطر الرصيد، يمكنك استخدام حقول البيانات للعمر وحجم الحساب وعمر الحساب. هنا، يعتبر العمر وحجم الحساب وعمر الحساب من الميزات. تخبرك أهمية الميزة كيف يؤثر كل حقل بيانات على تنبؤات النموذج. على سبيل المثال، على الرغم من أنك قد تستخدم العمر بكثافة في التنبؤ، قد لا يؤثر حجم الحساب وعمر الحساب على قيم التنبؤ بشكل كبير. من خلال هذه العملية، يمكن لعلماء البيانات شرح التنبؤات الناتجة بطرق تمنح أصحاب المصلحة رؤية لأهم ميزات النموذج.

باستخدام الفئات والأساليب في لوحة معلومات الذكاء الاصطناعي المسؤولة وباستخدام SDK الإصدار 2 وCLI الإصدار 2، يمكنك:

- اشرح تنبؤ النموذج عن طريق إنشاء قيم أهمية الميزة للنموذج بأكمله (شرح شامل) أو نقاط بيانات فردية (تفسير محلي).

- حقق إمكانية تفسير النموذج في مجموعات البيانات الواقعية على نطاق واسع.

- استخدم لوحة معلومات مرئية تفاعلية لاكتشاف الأنماط في البيانات الخاصة بك والتفسيرات الخاصة بها في وقت التدريب.

باستخدام الفئات والأساليب في SDK الإصدار 1، يمكنك:

- اشرح تنبؤ النموذج عن طريق إنشاء قيم أهمية الميزة للنموذج بأكمله ونقاط البيانات الفردية.

- حقق إمكانية تفسير النموذج في مجموعات البيانات الواقعية على نطاق واسع، أثناء التدريب والاستدلال.

- استخدم لوحة معلومات مرئية تفاعلية لاكتشاف الأنماط في البيانات الخاصة بك والتفسيرات الخاصة بها في وقت التدريب.

إشعار

يتم توفير فئات قابلية تفسير النموذج من خلال حزمة SDK v1. لمزيد من المعلومات، راجع تثبيت حزم SDK للتعلم الآلي من Azure وazureml.interpret.

تقنيات تفسير النموذج المدعومة

لوحة معلومات الذكاء الاصطناعي المسؤولة وazureml-interpret استخدام التقنيات القابلية للتفسير التي تم تطويرها في Interpret-Community، وهي حزمة Python مفتوحة المصدر لتدريب النماذج القابلة للتفسير والمساعدة في شرح أنظمة الذكاء الاصطناعي ذات الصناديق غير الشفافة. نماذج مربعات النص غير الشفافة هي تلك النماذج التي ليس لدينا معلومات بشأن طريقة عملها الداخلية.

Interpret-Community يعمل كمضيف للمفسرين المدعومين التاليين، ويدعم حاليًا تقنيات التفسير المقدمة في الأقسام التالية.

مدعوم في لوحة معلومات AI المسؤولة في Python SDK الإصدار 2 وCLI الإصدار 2

| تقنية التفسير | الوصف | النوع |

|---|---|---|

| شرح تقليد (بديل عمومي) + شجرة SHAP | يستند مقلد الشرح على فكرة تدريب نماذج بديلة عمومية لتقليد نماذج مربعات النص غير الشفافة. النموذج البديل العمومي هو نموذج قابل للتفسير جوهريًا يتم تدريبه لتقريب تنبؤات أي نموذج مربعات نص غير شفاف بأكبر قدر ممكن من الدقة. يمكن لعلماء البيانات تفسير النموذج البديل لاستخلاص استنتاجات بشأن نموذج مربعات النص غير الشفاف. تستخدم لوحة معلومات الذكاء الاصطناعي المسؤولة LightGBM (LGBMExplainableModel)، مقترنًا بشرح الشجرة SHAP (SHapley Additive exPlanations)، وهو شرح محدد للأشجار ومجموعات الأشجار. يوفر مزيج LightGBM وشجرة SHAP تفسيرات عمومية ومحلية لا تعتمد على نماذج التعلم الآلي الخاصة بك. |

حيادي النموذج |

تقنيات قابلية تفسير النموذج المدعومة لنماذج النص

| تقنية التفسير | الوصف | النوع | مهمة نصية |

|---|---|---|---|

| نص SHAP | SHAP (المخططات المضافة SHapley) هي طريقة شرح شائعة للشبكات العصبية العميقة التي توفر رؤى حول مساهمة كل ميزة إدخال في تنبؤ معين. وهو يستند إلى مفهوم قيم Shapley، وهو أسلوب لتعيين الائتمان للاعبين الفرديين في لعبة تعاونية. يطبق SHAP هذا المفهوم على ميزات الإدخال للشبكة العصبية من خلال حساب متوسط مساهمة كل ميزة في إخراج النموذج عبر جميع مجموعات الميزات الممكنة. بالنسبة للنص على وجه التحديد، يقسم SHAP على الكلمات بطريقة هرمية، ويعامل كل كلمة أو رمز مميز كميزة. ينتج عن هذا مجموعة من قيم الإسناد التي تحدد أهمية كل كلمة أو رمز مميز للتنبؤ المحدد. يتم إنشاء خريطة الإسناد النهائية عن طريق تصور هذه القيم كخريطة التمثيل اللوني عبر مستند النص الأصلي. SHAP هو أسلوب غير محدد للنموذج ويمكن استخدامه لشرح مجموعة واسعة من نماذج التعلم العميق، بما في ذلك شبكات CNN وRNNs والمحولات. بالإضافة إلى ذلك، يوفر العديد من الخصائص المرغوب فيها، مثل الاتساق والدقة والإنصاف، ما يجعله تقنية موثوقة وقابلة للتفسير لفهم عملية صنع القرار للنموذج. | نموذج غير محدد | تصنيف متعدد الفئات للنص، تصنيف متعدد التسميات للنص |

تقنيات قابلية تفسير النموذج المدعومة لنماذج الصور

| تقنية التفسير | الوصف | النوع | مهمة الرؤية |

|---|---|---|---|

| رؤية SHAP | SHAP (المخططات المضافة SHapley) هي طريقة شرح شائعة للشبكات العصبية العميقة التي توفر رؤى حول مساهمة كل ميزة إدخال في تنبؤ معين. وهو يستند إلى مفهوم قيم Shapley، وهو أسلوب لتعيين الائتمان للاعبين الفرديين في لعبة تعاونية. يطبق SHAP هذا المفهوم على ميزات الإدخال للشبكة العصبية من خلال حساب متوسط مساهمة كل ميزة في إخراج النموذج عبر جميع مجموعات الميزات الممكنة. للرؤية على وجه التحديد، ينقسم SHAP على الصورة بطريقة هرمية، ويتعامل مع مناطق الواجهة الفائقة للصورة على أنها كل ميزة. ينتج عن هذا مجموعة من قيم الإسناد التي تحدد أهمية كل حرف كبير أو منطقة صورة للتنبؤ المحدد. يتم إنشاء خريطة الإسناد النهائية عن طريق تصور هذه القيم كخريطة التمثيل اللوني. SHAP هو أسلوب غير محدد للنموذج ويمكن استخدامه لشرح مجموعة واسعة من نماذج التعلم العميق، بما في ذلك شبكات CNN وRNNs والمحولات. بالإضافة إلى ذلك، يوفر العديد من الخصائص المرغوب فيها، مثل الاتساق والدقة والإنصاف، ما يجعله تقنية موثوقة وقابلة للتفسير لفهم عملية صنع القرار للنموذج. | نموذج غير محدد | تصنيف متعدد الفئات للصور، تصنيف متعدد التسميات للصور |

| Guided Backprop | Guided-backprop هو طريقة شرح شائعة للشبكات العصبية العميقة التي توفر رؤى حول التمثيلات المستفادة من النموذج. فإنه يولد تصورا لميزات الإدخال التي تعمل على تنشيط خلية عصبية معينة في النموذج، عن طريق حساب تدرج الإخراج فيما يتعلق بصورة الإدخال. على عكس الأساليب الأخرى المستندة إلى التدرج، يقوم guided-backprop فقط بالدعم من خلال التدرجات الإيجابية ويستخدم دالة تنشيط ReLU معدلة للتأكد من أن التدرجات السالبة لا تؤثر على المرئيات. يؤدي هذا إلى خريطة أكثر قابلية للتفسير وعالية الدقة تبرز أهم الميزات في صورة الإدخال للتنبؤ المحدد. يمكن استخدام Guided-backprop لشرح مجموعة واسعة من نماذج التعلم العميق، بما في ذلك الشبكات العصبية الالتفافية (CNNs)، والشبكات العصبية المتكررة (RNNs)، والمحولات. | AutoML | تصنيف متعدد الفئات للصور، تصنيف متعدد التسميات للصور |

| gradCAM الموجه | GradCAM الإرشادي هو طريقة شرح شائعة للشبكات العصبية العميقة التي توفر رؤى حول التمثيلات المستفادة من النموذج. يقوم بإنشاء تصور لميزات الإدخال التي تساهم بشكل أكبر في فئة إخراج معينة، من خلال الجمع بين النهج المستند إلى التدرج للتبخير الخلفي الموجه مع نهج الترجمة ل GradCAM. على وجه التحديد، فإنه يحسب تدرجات فئة الإخراج فيما يتعلق بخرائط الميزات لآخر طبقة التفافية في الشبكة، ثم يرجح كل خريطة ميزة وفقا لأهمية تنشيطها لتلك الفئة. ينتج عن ذلك خريطة التمثيل اللوني عالية الدقة التي تسلط الضوء على المناطق الأكثر تميزا في صورة الإدخال لفئة الإخراج المحددة. يمكن استخدام GradCAM الموجهة لشرح مجموعة واسعة من نماذج التعلم العميق، بما في ذلك شبكات CNN وRNNs والمحولات. بالإضافة إلى ذلك، من خلال دمج backpropagation الموجه، فإنه يضمن أن تكون المرئيات ذات معنى وقابلة للتفسير، وتجنب التنشيطات الزائفة والمساهمات السلبية. | AutoML | تصنيف متعدد الفئات للصور، تصنيف متعدد التسميات للصور |

| تدرجات متكاملة | التدرجات المتكاملة هي طريقة شرح شائعة للشبكات العصبية العميقة التي توفر رؤى حول مساهمة كل ميزة إدخال في تنبؤ معين. يحسب جزءا لا يتجزأ من تدرج فئة الإخراج فيما يتعلق بصورة الإدخال، على طول مسار مستقيم بين صورة الأساس وصورة الإدخال الفعلية. يتم اختيار هذا المسار عادة ليكون استنتاجا خطيا بين الصورتين، مع كون الخط الأساسي صورة محايدة لا تحتوي على ميزات البارزة. من خلال دمج التدرج على طول هذا المسار، توفر التدرجات المتكاملة مقياسا لكيفية مساهمة كل ميزة إدخال في التنبؤ، ما يسمح بإنشاء خريطة إسناد. تسلط هذه الخريطة الضوء على ميزات الإدخال الأكثر تأثيرا، ويمكن استخدامها للحصول على رؤى حول عملية صنع القرار في النموذج. يمكن استخدام التدرجات المتكاملة لشرح مجموعة واسعة من نماذج التعلم العميق، بما في ذلك شبكات CNN وRNNs والمحولات. بالإضافة إلى ذلك، إنها تقنية نظرية تقوم على استيفاء مجموعة من الخصائص المرغوب فيها، مثل الحساسية، وتباين التنفيذ، والاكتمال. | AutoML | تصنيف متعدد الفئات للصور، تصنيف متعدد التسميات للصور |

| XRAI | XRAI هو أسلوب جديد قائم على المنطقة يعتمد على التدرجات المتكاملة (IG). فهو يفرط في تقسيم الصورة ويختبر بشكل متكرر أهمية كل منطقة، ويدمج المناطق الأصغر في شرائح أكبر استنادا إلى درجات الإسناد. ينتج عن هذه الاستراتيجية جودة عالية، ومناطق ذات حدود ضيقة تتفوق على تقنيات الأداء الحالية. يمكن استخدام XRAI مع أي نموذج يستند إلى DNN طالما أن هناك طريقة لدمج ميزات الإدخال في مقاطع من خلال بعض مقياس التشابه. | AutoML | تصنيف متعدد الفئات للصور، تصنيف متعدد التسميات للصور |

| D-RISE | D-RISE هو أسلوب غير محدد للنموذج لإنشاء تفسيرات مرئية للتنبؤات بنماذج الكشف عن الكائنات. من خلال محاسبة كل من جوانب الترجمة والتصنيف للكشف عن الكائنات، يمكن أن تنتج D-RISE خرائط متميزة تبرز أجزاء من الصورة التي تساهم أكثر في التنبؤ بالكاشف. على عكس الأساليب المستندة إلى التدرج، فإن D-RISE أكثر عمومية ولا يحتاج إلى الوصول إلى الأعمال الداخلية للكشف عن الكائنات؛ يتطلب الوصول إلى مدخلات ومخرجات النموذج فقط. يمكن تطبيق الأسلوب على أجهزة الكشف من مرحلة واحدة (على سبيل المثال، YOLOv3)، وأجهزة الكشف على مرحلتين (على سبيل المثال، أسرع-RCNN)، ومحولات الرؤية (على سبيل المثال، DETR، OWL-ViT). يوفر D-Rise خريطة السمات من خلال إنشاء أقنعة عشوائية لصورة الإدخال وسيرسلها إلى كاشف الكائنات مع الأقنعة العشوائية لصورة الإدخال. من خلال تقييم تغيير درجة كاشف الكائنات، فإنه يجمع جميع الاكتشافات مع كل قناع وينتج خريطة نهائية للسمة. |

نموذج غير محدد | الكشف عن العنصر |

مدعوم في Python SDK الإصدار 1

| تقنية التفسير | الوصف | النوع |

|---|---|---|

| شرح شجرة SHAP | شرح شجرة SHAP، والذي يركز على خوارزمية قيمة وقت SHAP السريعة متعددة الحدود الخاصة بـ الأشجار ومجموعات الأشجار. | نموذج خاص |

| شرح عميق | استنادًا إلى الشرح المقدم من SHAP، يعد Deep Explainer "خوارزمية تقريبية عالية السرعة لقيم SHAP في نماذج التعلم العميق التي تعتمد على اتصال مع DeepLIFT الموضح في ورقة SHAP NIPS. نماذج TensorFlow ونماذج Keras التي تستخدم خلفية TensorFlow مدعومة (هناك أيضًا دعم أولي لـ PyTorch)." | نموذج خاص |

| الشرح الخطي SHAP | الشرح الخطي لـ SHAP يحسب قيم SHAP لـ النموذج الخطي، ويحسب اختياريًا الارتباطات بين الميزات. | نموذج خاص |

| شرح SHAP Kernel | يستخدم شرح Kernel لـSHAP تراجعًا خطيًا محليًا مرجحًا بشكل خاص لتقدير قيم SHAP لأي نموذج. | حيادي النموذج |

| شرح تقليد (بديل عمومي) | يستند مقلد الشرح على فكرة تدريب نماذج بديلة عمومية لتقليد نماذج مربعات النص غير الشفافة. النموذج البديل العمومي هو نموذج قابل للتفسير جوهريًا يتم تدريبه لتقريب تنبؤات أي نموذج مربعات نص غير شفاف بأكبر قدر ممكن من الدقة. يمكن لعلماء البيانات تفسير النموذج البديل لاستخلاص استنتاجات بشأن نموذج مربعات النص غير الشفاف. يمكنك استخدام أحد النماذج التالية القابلة للتفسير كنموذج بديل: LightGBM (LGBMExplainableModel)، أو التراجع الخطي (LinearExplainableModel)، أو نموذج التدرج العشوائي القابل للتفسير (SGDExplainableModel)، أو شجرة القرارات (DecisionTreeExplainableModel). | حيادي النموذج |

| شرح أهمية ميزة التقليب | أهمية ميزة التقليب (PFI) هي تقنية تستخدم لشرح نماذج التصنيف والتراجع المستوحاة من ورقة Breiman Random Forests (انظر القسم 10). على مستوى عالٍ، تتمثل الطريقة التي يعمل بها في خلط البيانات عشوائياً لميزة واحدة في كل مرة لمجموعة البيانات بأكملها وحساب مقدار تغير مقياس أداء الفائدة. كلما كان التغيير أكبر، زادت أهمية هذه الميزة. يمكن أن يشرح PFI السلوك العام لـأي نموذج أساسي ولكنه لا يفسر التنبؤات الفردية. | حيادي النموذج |

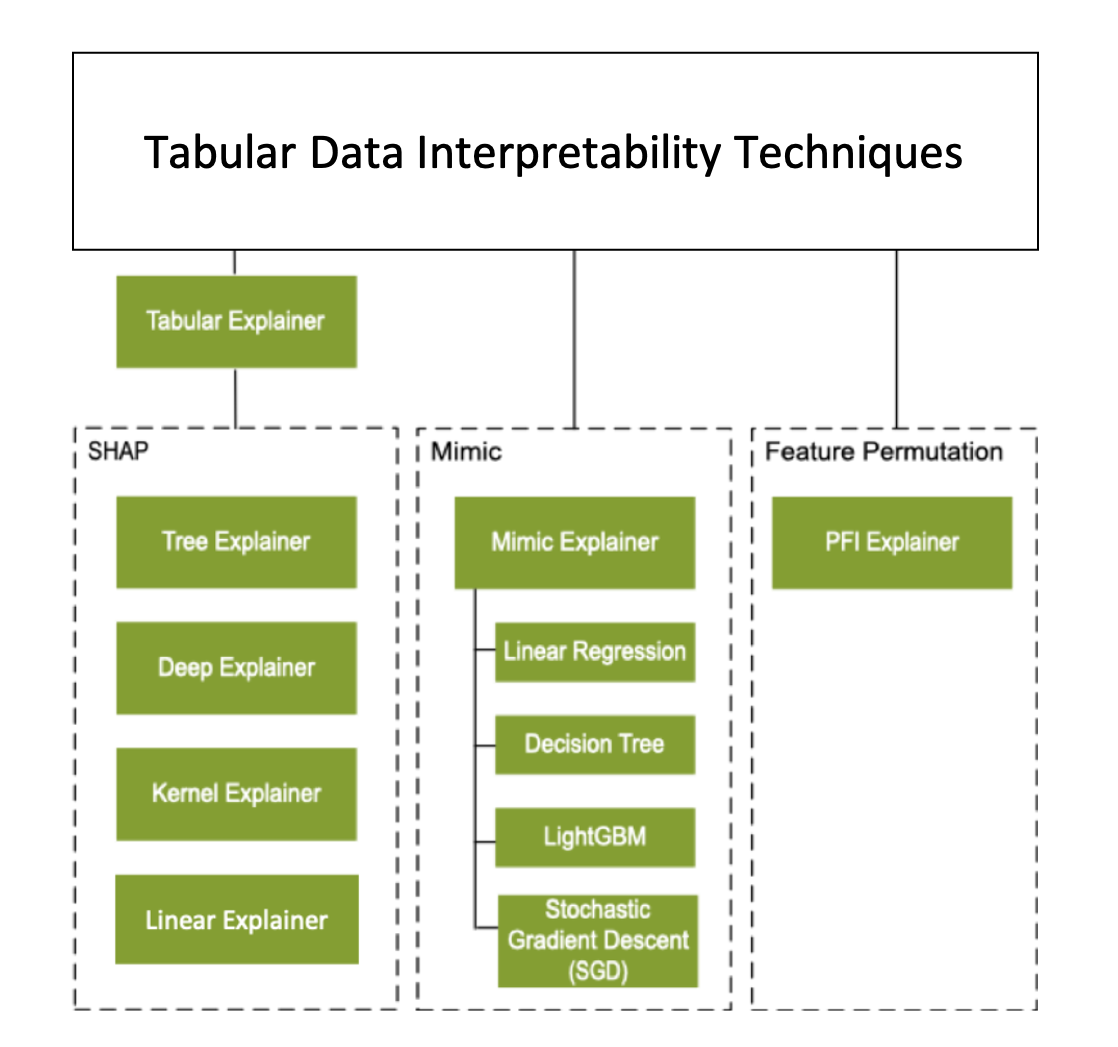

بالإضافة إلى تقنيات قابلية التفسير الموضحة في القسم السابق، ندعم مفسرا آخر يستند إلى SHAP، يسمى Tabular Explainer. اعتمادًا على النموذج، يستخدم المفسر الجدولي أحد توضيحات SHAP المدعومة:

- شرح الشجرة لجميع النماذج القائمة على الأشجار

- الشرح العميق لنماذج الشبكة العصبية العميقة (DNN)

- الشرح الخطي للنماذج الخطية

- شرح Kernel لجميع النماذج الأخرى

المفسر الجدولي أجري أيضًا تحسينات مهمة على الميزات والأداء عبر مفسرات SHAP المباشرة:

- تلخيص مجموعة بيانات التهيئة: عندما تكون سرعة الشرح أكثر أهمية، نقوم بتلخيص مجموعة بيانات التهيئة وإنشاء مجموعة صغيرة من العينات التمثيلية. هذا النهج يعمل على تسريع إنشاء قيم أهمية الميزات الإجمالية والفردية.

- أخذ عينات من مجموعة بيانات التقييم: إذا مر المستخدم في مجموعة كبيرة من عينات التقييم، ولكنه لا يحتاج فعليًا إلى تقييمها جميعًا، يمكنك ضبط معلمة أخذ العينات على

trueلتسريع حساب تفسيرات النموذج الشاملة.

يوضح الرسم التخطيطي التالي الهيكل الحالي للمفسرين المدعومين:

نماذج التعلم الآلي المدعومة

تدعم حزمة azureml.interpret SDK النماذج المدربة على تنسيقات مجموعات البيانات التالية:

numpy.arraypandas.DataFrameiml.datatypes.DenseDatascipy.sparse.csr_matrix

تقبل وظائف التفسير كلاً من النماذج والبنية الأساسية لبرنامج ربط العمليات التجارية كمدخلات. إذا تم توفير نموذج، يجب أن ينفذ وظيفة التنبؤ predict أو predict_proba التي تتوافق مع اصطلاح Scikit. إذا كان نموذجك لا يدعم هذا، فيمكنك تضمينه في وظيفة تولد نفس النتيجة كما في predict أو predict_proba في Scikit واستخدام وظيفة الغلاف هذه مع الشرح المحدد.

إذا قمت بتوفير البنية الأساسية لبرنامج ربط العمليات التجارية، فإن وظيفة التفسير تفترض أن البرنامج النصي للبنية الأساسية لبرنامج ربط العمليات التجارية قيد التشغيل يقوم بإرجاع تنبؤ. عند استخدام تقنية الالتفاف هذه، azureml.interpret يمكن أن تدعم النماذج التي يتم تدريبها عبر PyTorch، وTensorFlow، وأطر عمل التعلم العميق Keras، ونماذج التعلم الآلي الكلاسيكية.

الهدف حساب المحلية والبعيدة

تم تصميم الحزمة azureml.interpret للعمل مع أهداف الحوسبة المحلية والبعيدة. إذا قم بتشغيل الحزمة محليًا، فلن تتصل وظائف SDK بأي من خدمات Azure.

يمكنك تشغيل الشرح عن بُعد على حساب التعلم الآلي من Microsoft Azure وتسجيل معلومات الشرح في Azure Machine Learning Run History Service. بعد تسجيل هذه المعلومات، تصبح التقارير والمرئيات من الشرح متاحة بسهولة في أستوديو التعلم الآلي من Microsoft Azure لتحليلها.

الخطوات التالية

- تعرف على كيفية إنشاء لوحة معلومات الذكاء الاصطناعي المسؤولة عبر CLI v2 وSDK v2 أو واجهة مستخدم استوديو التعلم الآلي من Microsoft Azure.

- استكشف مرئيات قابلية التفسير المدعومة للوحة معلومات الذكاء الاصطناعي المسؤولة.

- تعرف على طريقة إنشاء بطاقة أداء مسؤولة للذكاء الاصطناعي بناءً على نتائج التحاليل الملاحظة في لوحة معلومات الذكاء الاصطناعي المسؤول.

- تعرف على كيفية تمكين قابلية التفسير لنماذج التعلم الآلي المؤتمتة (SDK v1).

الملاحظات

قريبًا: خلال عام 2024، سنتخلص تدريجيًا من GitHub Issues بوصفها آلية إرسال ملاحظات للمحتوى ونستبدلها بنظام ملاحظات جديد. لمزيد من المعلومات، راجع https://aka.ms/ContentUserFeedback.

إرسال الملاحظات وعرضها المتعلقة بـ