فتح أداة نموذج LLM

تتيح أداة Open Model LLM استخدام مختلف نماذج Open Model و Foundational Models، مثل Falcon و Llama 2، لمعالجة اللغة الطبيعية في Azure التعلم الآلي تدفق المطالبة.

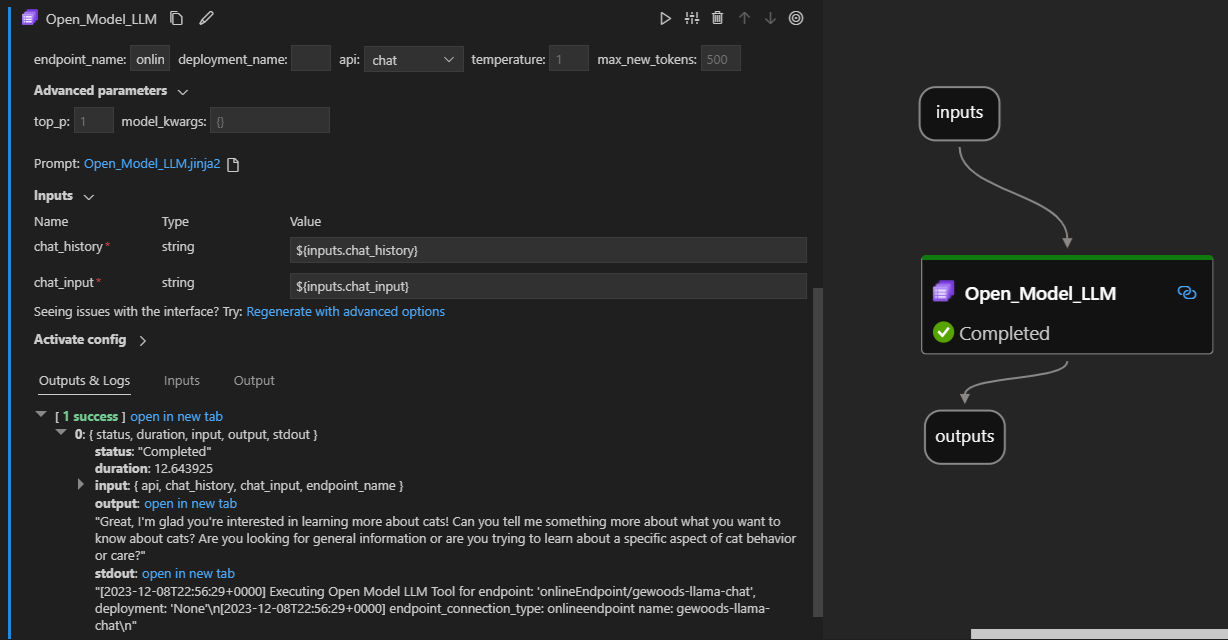

فيما يلي كيفية ظهوره في الإجراء على ملحق تدفق مطالبة Visual Studio Code. في هذا المثال، يتم استخدام الأداة للاتصال بنقطة نهاية دردشة LlaMa-2 وسؤال "ما هي CI؟".

تدعم أداة تدفق المطالبة هذه نوعين مختلفين من واجهة برمجة تطبيقات LLM:

- الدردشة: موضحة في المثال السابق. يسهل نوع واجهة برمجة تطبيقات الدردشة المحادثات التفاعلية مع المدخلات والاستجابات المستندة إلى النص.

- الإكمال: يتم استخدام نوع واجهة برمجة تطبيقات الإكمال لإنشاء عمليات إكمال نص استجابة واحدة استنادا إلى إدخال المطالبة المقدم.

نظرة عامة سريعة: كيف أعمل استخدام أداة Open Model LLM؟

- اختر نموذجا من كتالوج نماذج Azure التعلم الآلي ونشره.

- الاتصال إلى نشر النموذج.

- تكوين إعدادات أداة llm للنموذج المفتوح.

- قم بإعداد المطالبة.

- تشغيل سير المهام.

المتطلبات الأساسية: توزيع النموذج

- اختر النموذج الذي تطابق مع السيناريو الخاص بك من كتالوج نموذج Azure التعلم الآلي.

- استخدم الزر Deploy لنشر النموذج إلى نقطة نهاية الاستدلال عبر الإنترنت التعلم الآلي Azure.

- استخدم أحد خيارات النشر الدفع أثناء التنقل.

لمعرفة المزيد، راجع نشر نماذج الأساس إلى نقاط النهاية للاستدلال.

المتطلبات الأساسية: الاتصال إلى النموذج

من أجل التدفق السريع لاستخدام النموذج المنشور، تحتاج إلى الاتصال به. هناك طريقتان للاتصال.

اتصالات نقطة النهاية

بمجرد إقران التدفق الخاص بك بمساحة عمل Azure التعلم الآلي أو Azure الذكاء الاصطناعي Studio، يمكن لأداة Open Model LLM استخدام نقاط النهاية على مساحة العمل هذه.

استخدام مساحات عمل Azure التعلم الآلي أو Azure الذكاء الاصطناعي Studio: إذا كنت تستخدم تدفق المطالبة في إحدى مساحات عمل المستعرضات المستندة إلى صفحة الويب، فإن نقاط النهاية عبر الإنترنت المتوفرة على مساحة العمل هذه التي تعمل تلقائيا.

استخدام VS Code أو التعليمات البرمجية أولا: إذا كنت تستخدم تدفق المطالبة في VS Code أو أحد عروض التعليمات البرمجية أولا، فأنت بحاجة إلى الاتصال بمساحة العمل. تستخدم أداة Open Model LLM عميل azure.identity DefaultAzureCredential للتخويل. إحدى الطرق هي من خلال تعيين قيم بيانات اعتماد البيئة.

اتصالات مخصصة

تستخدم أداة Open Model LLM custom الاتصال ion. يدعم تدفق المطالبة نوعين من الاتصالات:

اتصالات مساحة العمل - الاتصال التي يتم تخزينها كأسرار على مساحة عمل Azure التعلم الآلي. بينما يمكن استخدام هذه الاتصالات، في العديد من الأماكن، يتم عادة إنشاء وصيانة في واجهة مستخدم Studio. لمعرفة كيفية إنشاء اتصال مخصص في واجهة مستخدم Studio، راجع كيفية إنشاء اتصال مخصص.

الاتصالات المحلية - الاتصال التي يتم تخزينها محليا على جهازك. هذه الاتصالات غير متوفرة في Studio UX، ولكن يمكن استخدامها مع ملحق VS Code. لمعرفة كيفية إنشاء الاتصال مخصص محلي، راجع كيفية إنشاء اتصال محلي.

المفاتيح المطلوبة لتعيينها هي:

- endpoint_url

- يمكن العثور على هذه القيمة في نقطة نهاية الاستدلال التي تم إنشاؤها مسبقا.

- endpoint_api_key

- تأكد من تعيينه كقيمة سرية.

- يمكن العثور على هذه القيمة في نقطة نهاية الاستدلال التي تم إنشاؤها مسبقا.

- model_family

- القيم المدعومة: LLAMA أو DOLLY أو GPT2 أو FALCON

- تعتمد هذه القيمة على نوع التوزيع الذي تستهدفه.

تشغيل الأداة: الإدخالات

تحتوي أداة Open Model LLM على العديد من المعلمات، وبعضها مطلوب. راجع الجدول التالي للحصول على التفاصيل، يمكنك مطابقة هذه المعلمات مع لقطة الشاشة السابقة للوضوح المرئي.

| Name | كتابة | الوصف | مطلوب |

|---|---|---|---|

| واجهة برمجة التطبيقات | سلسلة | وضع واجهة برمجة التطبيقات الذي يعتمد على النموذج المستخدم والسيناريو المحدد. القيم المدعومة: (الإكمال | الدردشة) | نعم |

| endpoint_name | سلسلة | اسم نقطة نهاية الاستدلال عبر الإنترنت مع نموذج مدعوم تم نشره عليه. يأخذ الأولوية على الاتصال. | نعم |

| درجة الحرارة | عائم | عشوائية النص الذي تم إنشاؤه. القيمة الافتراضية هي 1. | لا |

| max_new_tokens | integer | الحد الأقصى لعدد الرموز المميزة التي يجب إنشاؤها في الاكتمال. الافتراضي هو 500. | لا |

| top_p | عائم | احتمال استخدام الخيار العلوي من الرموز المميزة التي تم إنشاؤها. القيمة الافتراضية هي 1. | لا |

| model_kwargs | القاموس | يستخدم هذا الإدخال لتوفير تكوين خاص بالنموذج المستخدم. على سبيل المثال، قد يستخدم نموذج Llama-02 {"temperature":0.4}. الافتراضي: {} | لا |

| deployment_name | سلسلة | اسم النشر المطلوب استهدافه على نقطة نهاية الاستدلال عبر الإنترنت. إذا لم يتم تمرير أي قيمة، يتم استخدام إعدادات حركة مرور موازن التحميل للاستدلال. | لا |

| prompt | سلسلة | المطالبة النصية التي يستخدمها نموذج اللغة لإنشاء استجابته. | نعم |

المخرجات

| واجهة برمجة التطبيقات (API) | نوع الإرجاع | الوصف |

|---|---|---|

| الاكتمال | سلسلة | نص أحد الإكمال المتوقع |

| محادثة | سلسلة | نص استجابة واحدة في المحادثة |

النشر إلى نقطة نهاية عبر الإنترنت

عند نشر تدفق يحتوي على أداة Open Model LLM إلى نقطة نهاية عبر الإنترنت، هناك خطوة إضافية لإعداد الأذونات. أثناء النشر من خلال صفحات الويب، هناك خيار بين أنواع الهوية المعينة من قبل النظام والمخصصة من قبل المستخدم. في كلتا الحالتين، باستخدام مدخل Microsoft Azure (أو وظيفة مماثلة)، أضف دور وظيفة وظيفة "القارئ" إلى الهوية على مساحة عمل Azure التعلم الآلي أو مشروع Ai Studio، الذي يستضيف نقطة النهاية. قد يلزم تحديث نشر تدفق المطالبة.

الملاحظات

قريبًا: خلال عام 2024، سنتخلص تدريجيًا من GitHub Issues بوصفها آلية إرسال ملاحظات للمحتوى ونستبدلها بنظام ملاحظات جديد. لمزيد من المعلومات، راجع https://aka.ms/ContentUserFeedback.

إرسال الملاحظات وعرضها المتعلقة بـ