التقاط البيانات من مراكز الأحداث بتنسيق Parquet

تشرح هذه المقالة كيفية استخدام محرر التعليمات البرمجية دون تسجيل بيانات الدفق تلقائيا في مراكز الأحداث في حساب Azure Data Lake Storage Gen2 بتنسيق Parquet.

المتطلبات الأساسية

مساحة اسم Azure Event Hubs مع مركز أحداث وحساب Azure Data Lake Storage Gen2 مع حاوية لتخزين البيانات الملتقطة. يجب أن تكون هذه الموارد متاحة للجمهور ولا يمكن أن تكون خلف جدار حماية أو مؤمنة في شبكة Azure الظاهرية.

إذا لم يكن لديك مركز أحداث، فبادر بإنشاء مركز عن طريق اتباع الإرشادات من التشغيل السريع: إنشاء مركز أحداث.

إذا لم يكن لديك حساب Data Lake Storage Gen2، فبادر بإنشاء حساب باتباع الإرشادات من إنشاء حساب تخزين

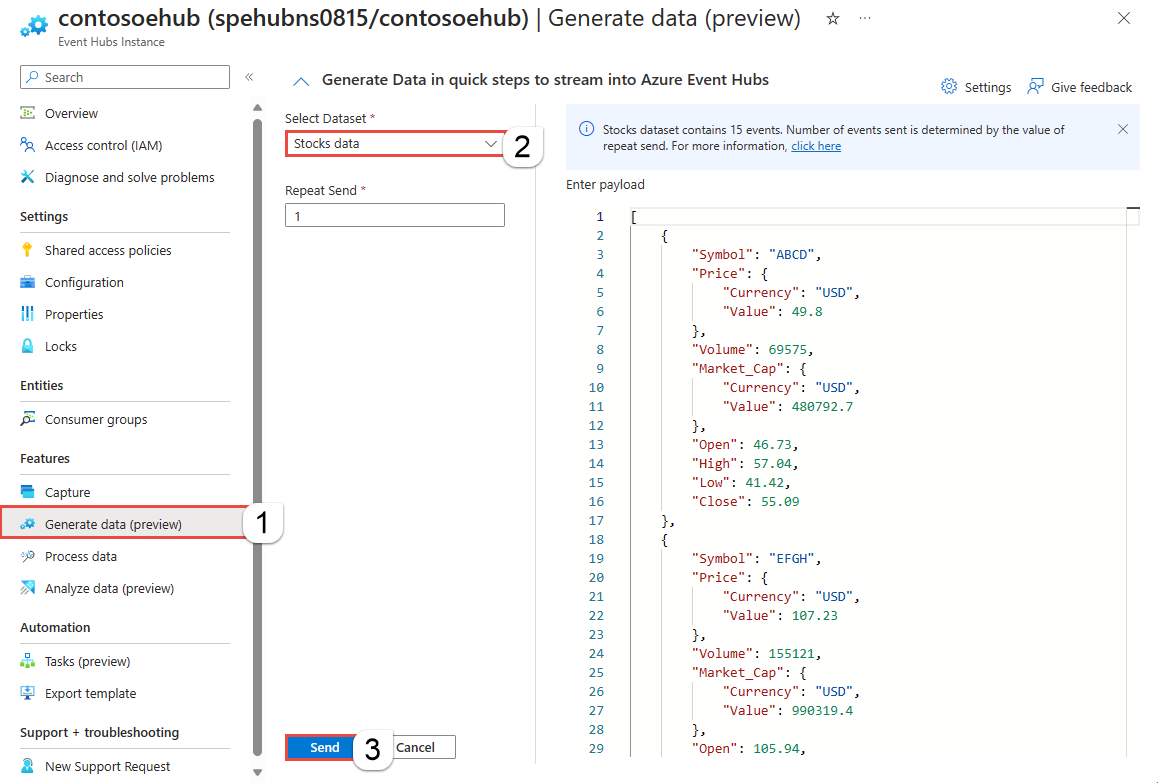

يجب إجراء تسلسل للبيانات الموجودة في مراكز الأحداث بتنسيق JSON أو CSV أو Avro. لأغراض الاختبار، حدد إنشاء بيانات (معاينة) في القائمة اليسرى، وحدد بيانات الأسهم لمجموعة البيانات، ثم حدد إرسال.

تكوين وظيفة لالتقاط البيانات

استخدم الخطوات التالية لتكوين وظيفة Stream Analytics لالتقاط البيانات في Azure Data Lake Storage Gen2.

في مدخل Microsoft Azure، توجه إلى مركز الأحداث.

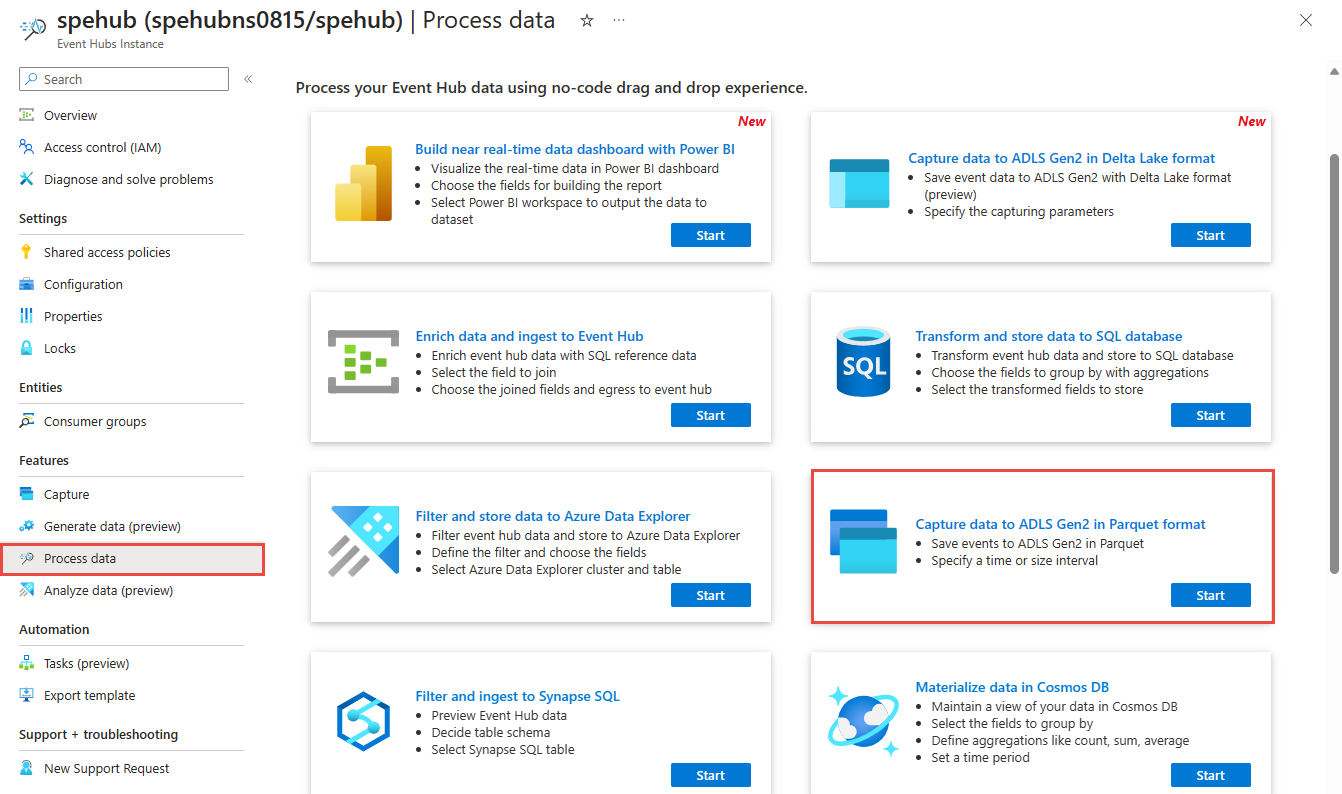

في القائمة اليسرى، حدد معالجة البيانات ضمن الميزات. ثم حدد البدء على بطاقة Capture data to ADLS Gen2 بتنسيق Parquet.

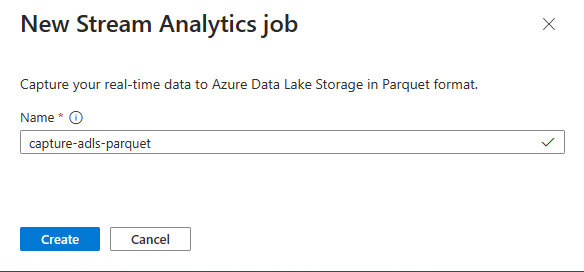

أدخل اسما لمهمة Stream Analytics، ثم حدد Create.

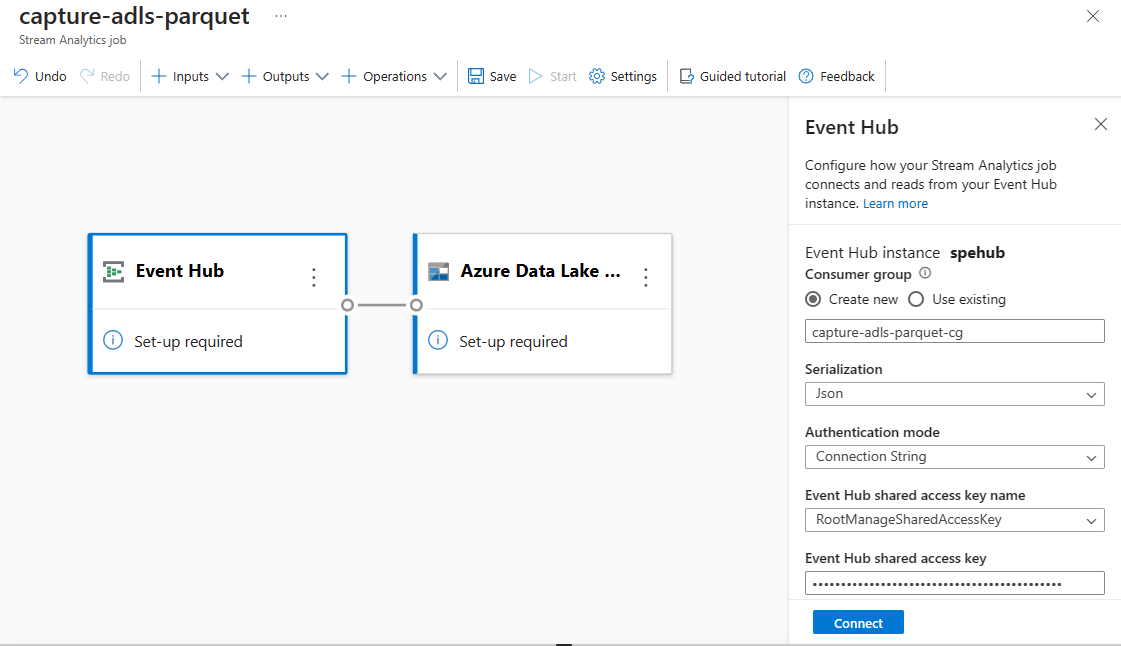

حدد نوع التسلسل لبياناتك في مراكز الأحداث وطريقة المصادقة التي تستخدمها الوظيفة للاتصال بمراكز الأحداث. وبعد ذلك حدد Connect.

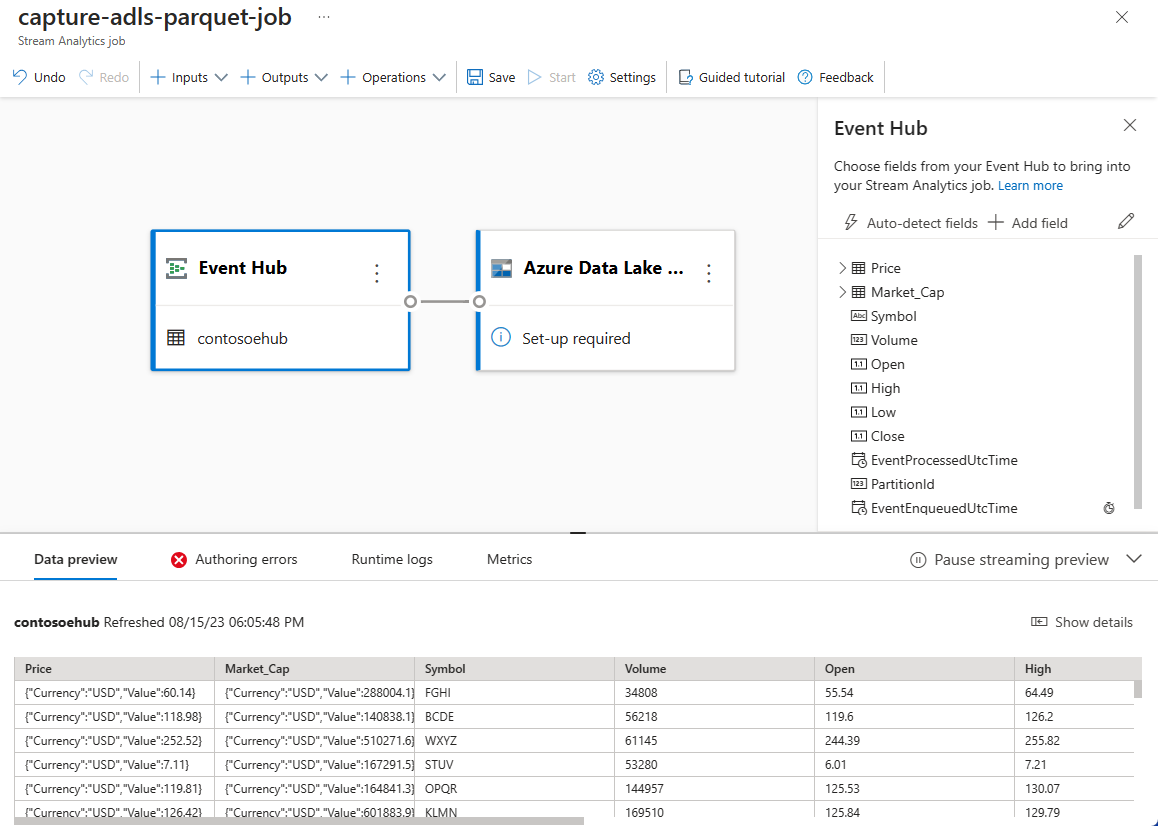

عند تأسيس الاتصال بنجاح، سترى:

الحقول الموجودة في بيانات الإدخال. يمكنك اختيار إضافة حقل أو يمكنك تحديد رمز النقاط الثلاث المجاور للحقل لإزالة اسمه اختيارياً أو إعادة تسميته أو تغييره.

عينة مباشرة من البيانات الواردة في جدول معاينة البيانات ضمن طريقة عرض الرسم التخطيطي. يتم تحديثه بشكلٍ دوري. يمكنك تحديد إيقاف معاينة البث مؤقتاً لمشاهدة طريقة عرض ثابتة لنموذج الإدخال.

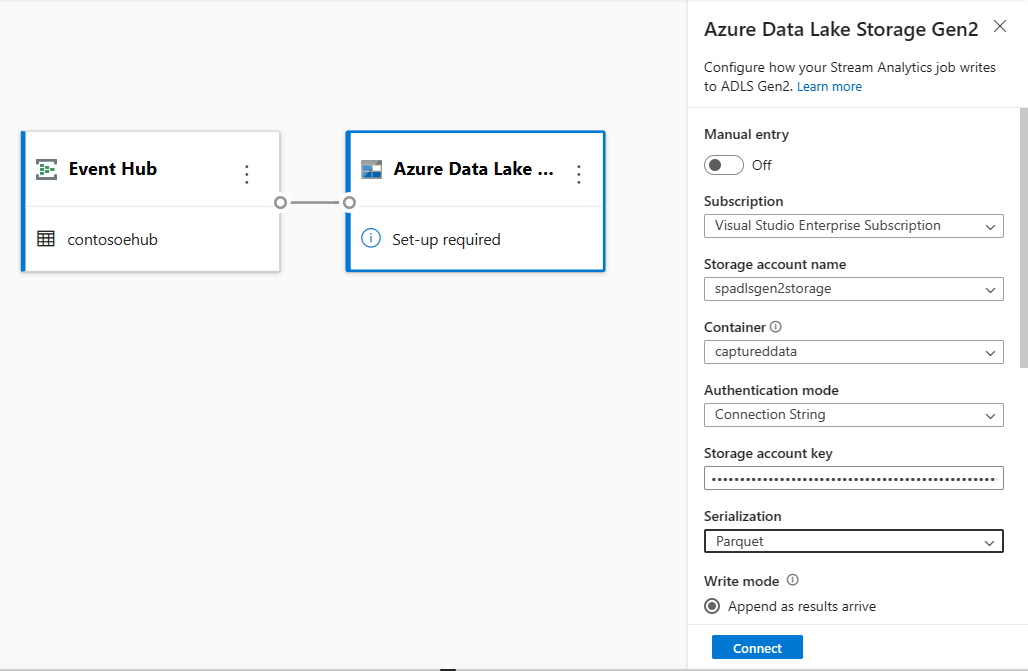

حدد تجانب Azure Data Lake Storage Gen2 لتحرير التكوين.

في صفحة تكوين Azure Data Lake Storage Gen2، اتبع هذه الخطوات:

حدد الاشتراك واسم حساب التخزين والحاوية من القائمة المنسدلة.

بمجرد تحديد الاشتراك، يجب تعبئة أسلوب المصادقة ومفتاح حساب التخزين تلقائياً.

حدد Parquet لتنسيق التسلسل .

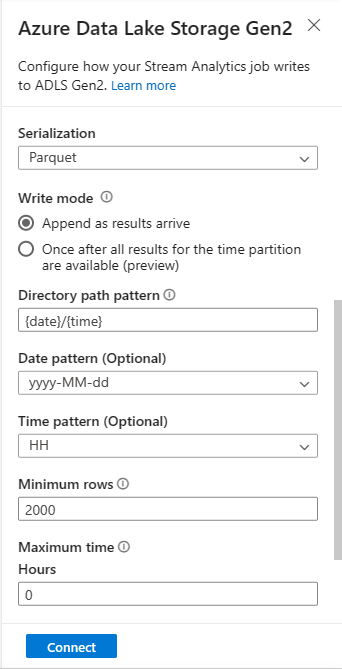

بالنسبة إلى الكائنات الثنائية كبيرة الحجم المتدفقة، من المتوقع أن يكون نمط مسار الدليل قيمة ديناميكية. من المطلوب أن يكون التاريخ جزءاً من مسار الملف للكائن الثنائي كبير الحجم - المشار إليه باسم

{date}. للتعرف على أنماط المسار المخصصة، راجع تقسيم إخراج كائن ثنائي كبير الحجم المخصص في Azure Stream Analytics.حدد اتصال

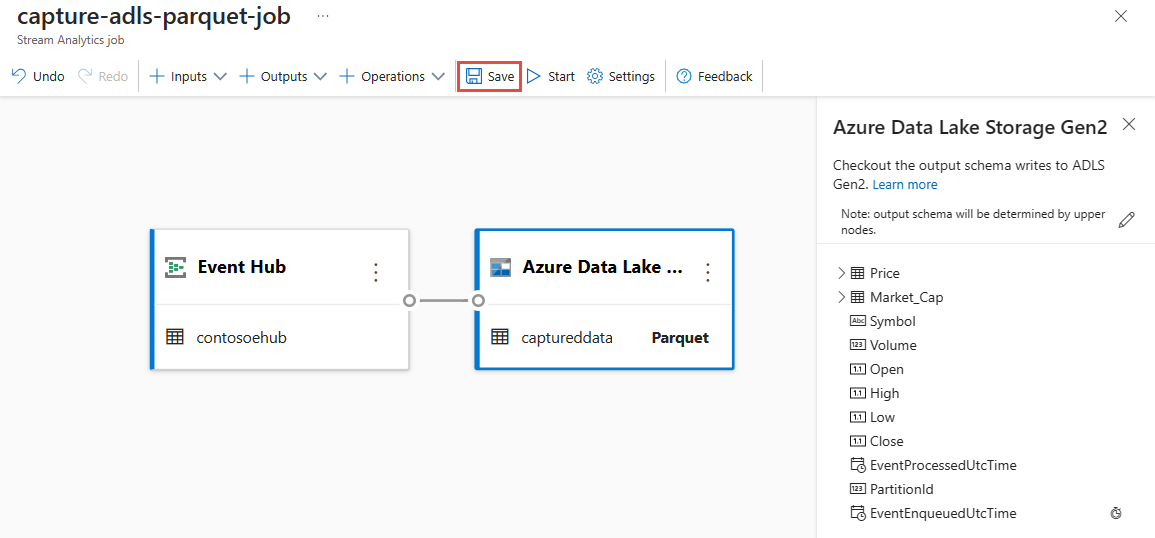

عند تأسيس الاتصال، سترى الحقول الموجودة في بيانات الإخراج.

حدد Save من شريط الأوامر لحفظ التكوين الخاص بك.

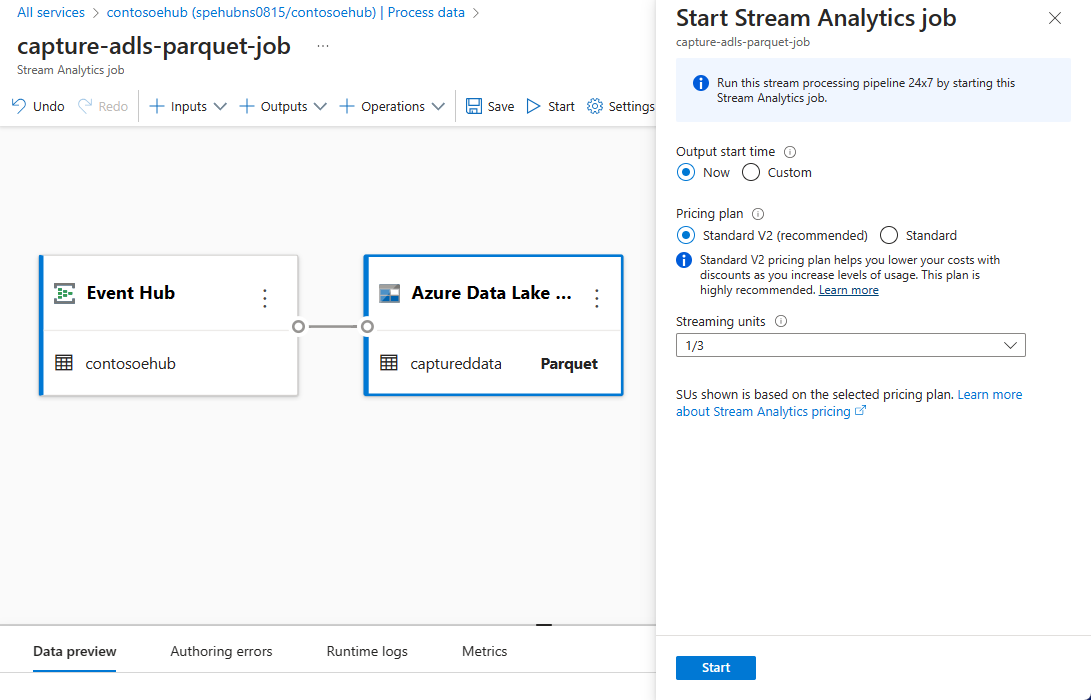

حدد Start من شريط الأوامر لبدء تدفق الدفق لالتقاط البيانات. ثم في نافذة وظيفة Start Stream Analytics:

اختر وقت بدء الإخراج.

حدد خطة التسعير.

حدد عدد وحدات الدفق (SU) التي تعمل بها الوظيفة. تمثل SU موارد الحوسبة المخصصة لتنفيذ وظيفة Stream Analytics. لمزيدٍ من المعلومات، راجع وحدات الدفق في Azure Stream Analytics.

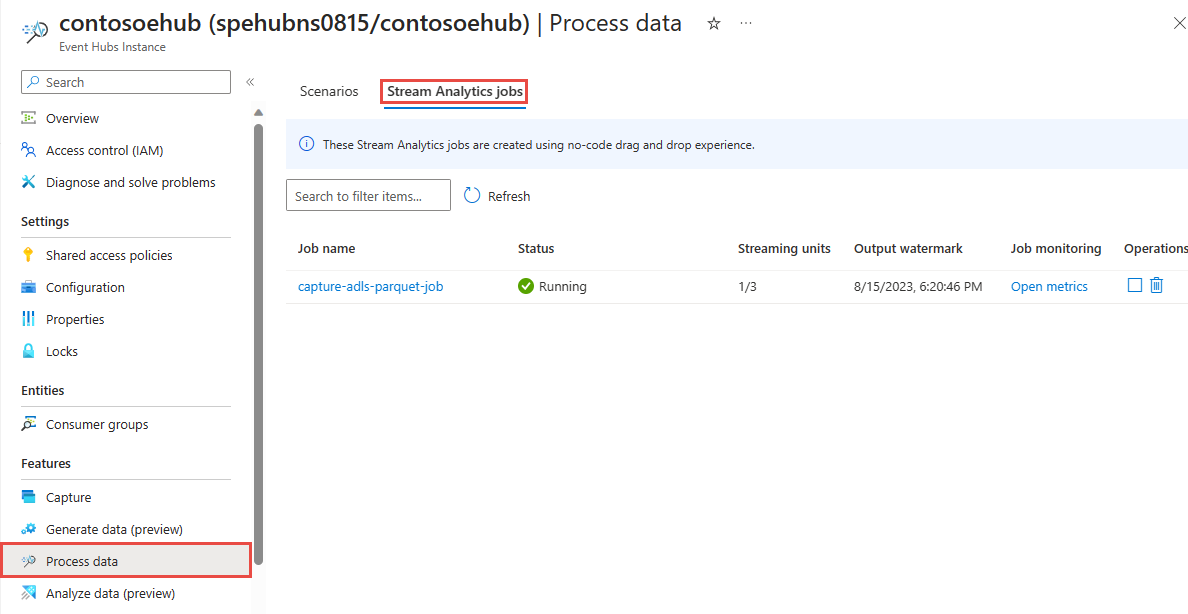

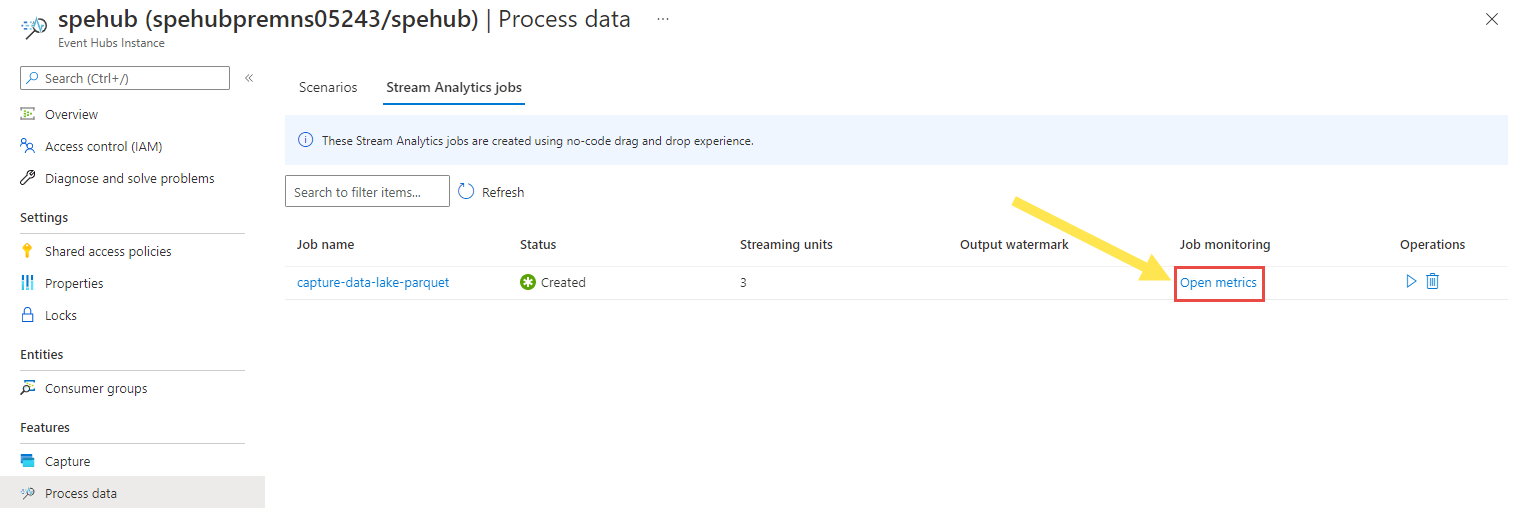

يجب أن تشاهد وظيفة Stream Analytic في علامة تبويب وظيفة Stream Analytics في صفحة بيانات العملية لمركز الحدث الخاص بك.

تحقق من الإخراج

في صفحة Event Hubs instance لمركز الأحداث، حدد Generate data، وحدد Stocks data for dataset، ثم حدد Send لإرسال بعض بيانات العينة إلى مركز الأحداث.

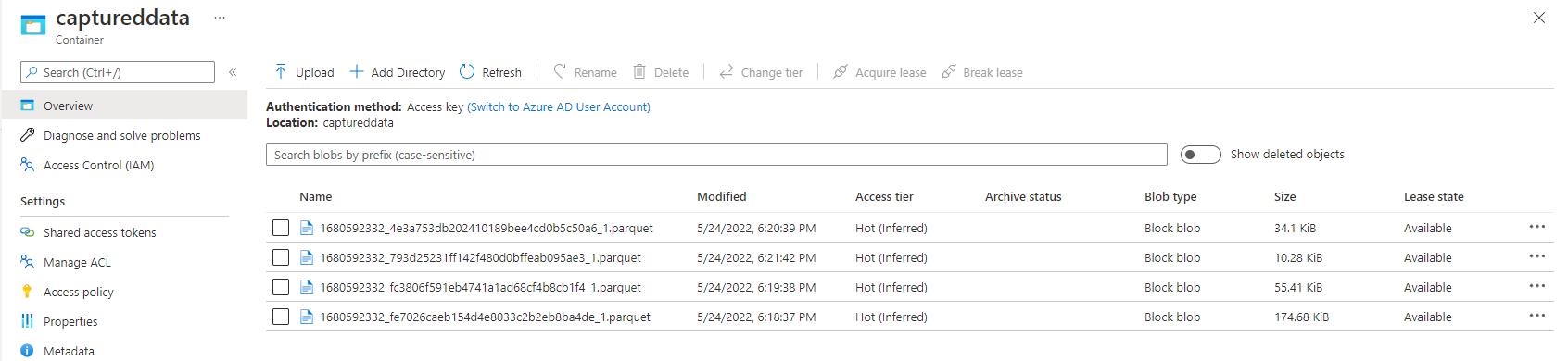

تحقق من إنشاء ملفات Parquet في حاوية Azure Data Lake Storage.

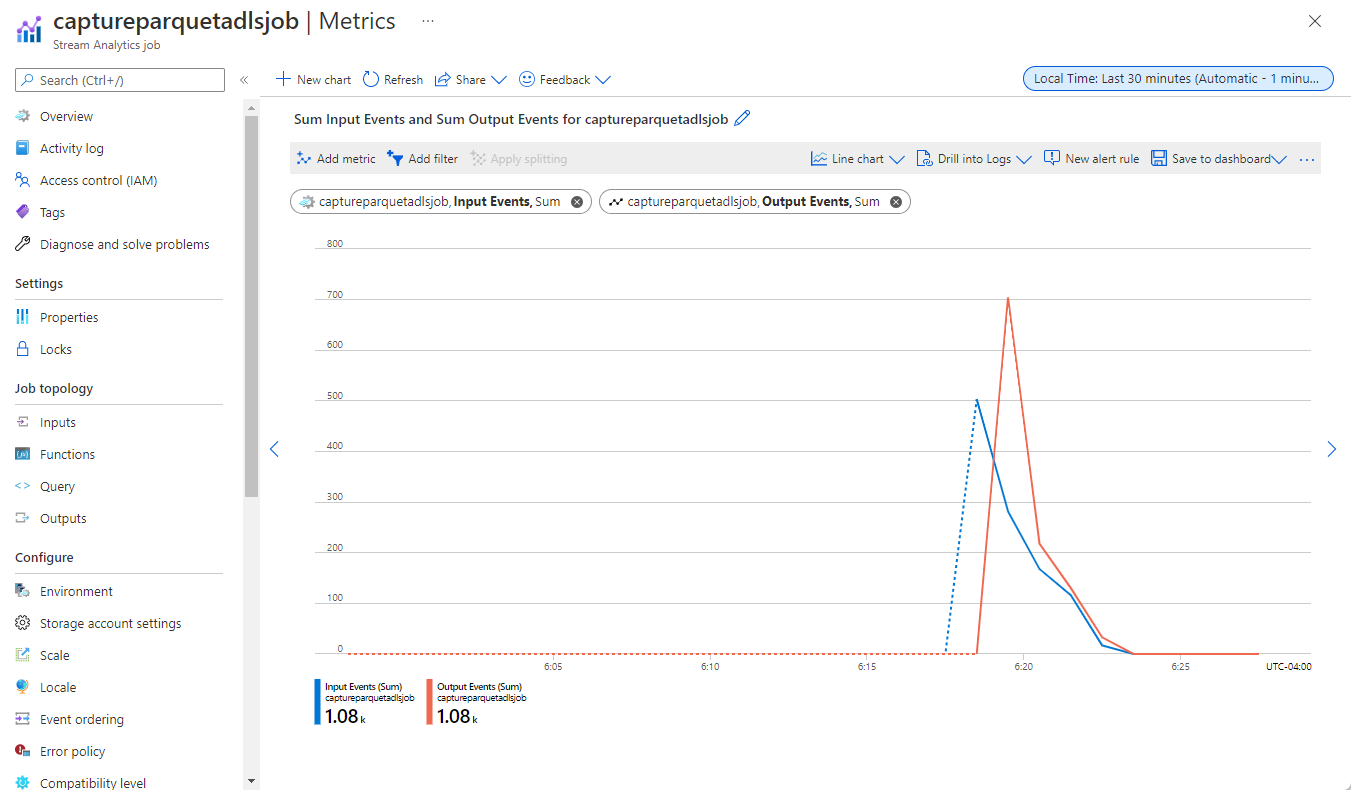

حدد معالجة البيانات في القائمة اليسرى. قم بالتبديل إلى علامة التبويب Stream Analytics jobs . حدد Open metrics لمراقبتها.

فيما يلي مثال على لقطة شاشة للمقاييس التي تعرض أحداث الإدخال والإخراج.

اعتبارات عند استخدام ميزة النسخ المتماثل الجغرافي لمراكز الأحداث

أطلقت مراكز الأحداث مؤخرا ميزة النسخ المتماثل الجغرافي في المعاينة العامة. تختلف هذه الميزة عن ميزة التعافي من الكوارث الجغرافية في Azure Event Hubs.

عندما يكون نوع تجاوز الفشل إجباريا وتناسق النسخ المتماثل غير متزامن، لا تضمن وظيفة Stream Analytics الإخراج مرة واحدة بالضبط إلى إخراج مراكز أحداث Azure.

قد تلاحظ Azure Stream Analytics، كمنتج مع مركز أحداث ناتج، تأخير العلامة المائية على المهمة أثناء مدة تجاوز الفشل وأثناء التقييد بواسطة مراكز الأحداث في حالة وصول تأخر النسخ المتماثل بين الأساسي والثانوي إلى الحد الأقصى للتأخر المكون.

قد تلاحظ Azure Stream Analytics، كمستهلك مع مراكز الأحداث كإدخل، تأخير العلامة المائية في المهمة أثناء مدة تجاوز الفشل وقد تتخطى البيانات أو تجد بيانات مكررة بعد اكتمال تجاوز الفشل.

نظرا لهذه المحاذير، نوصي بإعادة تشغيل وظيفة Stream Analytics مع وقت البدء المناسب مباشرة بعد اكتمال تجاوز فشل مراكز الأحداث. أيضا، نظرا لأن ميزة النسخ المتماثل الجغرافي لمراكز الأحداث في المعاينة العامة، لا نوصي باستخدام هذا النمط لمهام Stream Analytics للإنتاج في هذه المرحلة. سيتحسن سلوك Stream Analytics الحالي قبل أن تتوفر ميزة النسخ المتماثل الجغرافي لمراكز الأحداث بشكل عام ويمكن استخدامها في مهام إنتاج Stream Analytics.

الخطوات التالية

الآن أنت تعرف كيفية استخدام Stream Analytics دون محرر تعليمات برمجية لإنشاء وظيفة تلتقط بيانات مراكز الأحداث من Azure إلى Data Lake Storage Gen2 بتنسيق Parquet. بعد ذلك، يمكنك معرفة المزيد حول Azure Stream Analytics وكيفية مراقبة الوظيفة التي قمت بإنشائها.