Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Gilt für: Azure Stack HCI, Versionen 22H2 und 21H2; Windows Server 2022, Windows Server 2019

In diesem Artikel werden die verfügbaren Resilienzoptionen erläutert und die Skalierungsanforderungen, die Speichereffizienz und die allgemeinen Vorteile und Nachteile der einzelnen Optionen erläutert.

Überblick

Direkte Speicherplätze bieten Fehlertoleranz, häufig als "Resilienz" bezeichnet, für Ihre Daten. Die Implementierung ist ähnlich wie bei RAID, wird jedoch über Server verteilt und in Software durchgeführt.

Wie bei RAID gibt es einige verschiedene Möglichkeiten, wie Speicherplätze dies tun können, was verschiedene Kompromisse zwischen Fehlertoleranz, Speichereffizienz und Rechenkomplexität macht. Hierbei gelten im Allgemeinen zwei Kategorien: „Spiegelung“ und „Parität“ (auch als „Erasure Coding“ bezeichnet).

Spiegelung

Die Spiegelung bietet Fehlertoleranz, indem mehrere Kopien aller Daten beibehalten werden. Dies ähnelt am ehesten RAID-1. Wie diese Daten gestreift und platziert werden, ist nicht trivial (siehe diesen Blog, um mehr zu erfahren), aber es ist absolut wahr zu sagen, dass alle Daten, die mit Spiegelung gespeichert sind, mehrfach vollständig geschrieben werden. Jede Kopie wird auf unterschiedliche physische Hardware (unterschiedliche Laufwerke auf unterschiedlichen Servern) geschrieben, die angenommen werden, dass sie unabhängig voneinander fehlschlagen.

Sie können zwischen zwei Spiegelungsvarianten wählen: „Zwei-Wege-Spiegelung“ und „Drei-Wege-Spiegelung“.

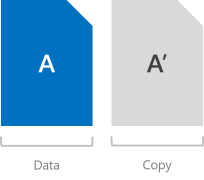

Zwei-Wege-Spiegelung

Bei der Zwei-Wege-Spiegelung werden jeweils zwei Kopien aller Daten geschrieben. Die Speichereffizienz beträgt 50 Prozent – um 1 TB Daten zu schreiben, benötigen Sie mindestens 2 TB physische Speicherkapazität. Ebenso benötigen Sie mindestens zwei Hardwarefehlerdomänen bei „Direkte Speicherplätze“, d. h. zwei Server.

Warnung

Wenn Sie mehr als zwei Server haben, empfehlen wir stattdessen die Verwendung der Drei-Wege-Spiegelung.

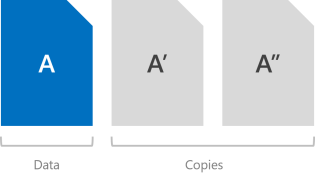

Drei-Wege-Spiegelung

Bei der Drei-Wege-Spiegelung werden jeweils drei Kopien aller Daten geschrieben. Die Speichereffizienz beträgt 33,3 Prozent – um 1 TB Daten zu schreiben, benötigen Sie mindestens 3 TB physische Speicherkapazität. Ebenso benötigen Sie mindestens drei Hardwarefehlerdomänen – bei Storage Spaces Direct bedeutet das drei Server.

Die Drei-Wege-Spiegelung kann mindestens zwei Hardwareprobleme (Laufwerk oder Server) gleichzeitig sicher tolerieren. Wenn Sie beispielsweise einen Server neu starten, wenn plötzlich ein anderes Laufwerk oder ein anderer Server fehlschlägt, bleiben alle Daten sicher und kontinuierlich zugänglich.

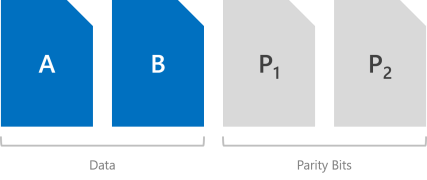

Parität

Die Paritätscodierung, häufig auch als „Erasure Coding“ bezeichnet, erzielt Fehlertoleranz durch bitweise Arithmetik, die außerordentlich kompliziert sein kann. Die Funktionsweise ist weniger offensichtlich als die Spiegelung, und es gibt viele großartige Onlineressourcen (z. B. diesen Dummies-Leitfaden für Erasure Coding von Drittanbietern), die Ihnen helfen können, das Konzept zu verstehen. Es genügt zu sagen, dass es eine bessere Speichereffizienz bietet, ohne die Fehlertoleranz zu beeinträchtigen.

Es gibt für „Direkte Speicherplätze“ zwei Arten von Parität: „Einzelparität“ und „Duale Parität“. Bei der dualen Parität wird bei größeren Umfängen ein erweitertes Verfahren mit dem Namen „Local Reconstruction Codes“ (Lokale Wiederherstellungscodes) genutzt.

Wichtig

Wir empfehlen die Verwendung der Spiegelung für die meisten leistungsempfindlichen Workloads. Weitere Informationen darüber, wie Sie das Gleichgewicht zwischen Leistung und Kapazität je nach Workload herstellen können, finden Sie unter "Planen von Volumes".

Einfache Parität

Bei Einzelparität wird nur ein Symbol für bitweise Parität beibehalten, sodass nur Fehlertoleranz für jeweils einen Fehler vorhanden ist. Es ähnelt am ehesten RAID-5. Um eine einzelne Parität zu verwenden, benötigen Sie mindestens drei Hardwarefehlerdomänen – mit Storage Spaces Direct, d. h. drei Server. Da die Drei-Wege-Spiegelung mehr Fehlertoleranz in derselben Skala bietet, wird davon abgeraten, eine einzelne Parität zu verwenden. Aber es ist vorhanden, wenn Sie darauf bestehen, es zu verwenden, und es wird vollständig unterstützt.

Warnung

Es wird davon abgeraten, eine einzelne Parität zu verwenden, da sie jeweils nur einen Hardwarefehler sicher tolerieren kann: Wenn Sie einen Server neu starten, wenn plötzlich ein anderer Laufwerk oder Server fehlschlägt, treten Ausfallzeiten auf. Wenn Sie nur über drei Server verfügen, empfehlen wir die Verwendung der Drei-Wege-Spiegelung. Wenn Sie vier oder mehr haben, lesen Sie den nächsten Abschnitt.

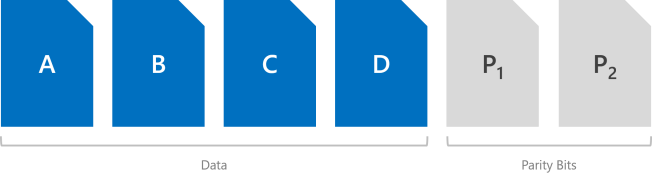

Duale Parität

Die duale Parität implementiert Reed-Solomon Fehlerkorrekturcodes, um zwei bitweise Paritätssymbole beizubehalten, wodurch die gleiche Fehlertoleranz wie die Drei-Wege-Spiegelung (d. h. bis zu zwei Fehler gleichzeitig) bereitgestellt wird, aber mit besserer Speichereffizienz. Es ähnelt am ehesten RAID-6. Um duale Parität zu verwenden, benötigen Sie mindestens vier Hardware-Fehlerdomänen – mit Storage Spaces Direct heißt das, vier Server. In diesem Maßstab beträgt die Speichereffizienz 50% – zum Speichern von 2 TB Daten benötigen Sie 4 TB physische Speicherkapazität.

Die Speichereffizienz der dualen Parität steigt mit der Anzahl der Hardware-Fehlerdomänen, von 50 Prozent bis zu 80 Prozent. Bei sieben (mit "Direkte Speicherplätze" bedeutet das z. B. sieben Server) springt die Effizienz auf 66,7 Prozent – um 4 TB Daten zu speichern, benötigen Sie nur 6 TB physische Speicherkapazität.

Im Abschnitt Zusammenfassung finden Sie Informationen zur Effizienz der Codes für duale Parität und lokale Nachbildung auf jeder Ebene.

Codes für die lokale Wiederherstellung

Für „Speicherplätze“ wird ein erweitertes Verfahren eingeführt, das von Microsoft Research entwickelt wurde und als „Local Reconstruction Codes“ (LRC) bezeichnet wird. Bei größerem Umfang wird LRC für die duale Parität genutzt, um die Codierung bzw. Decodierung in kleinere Gruppen zu unterteilen. So soll der Mehraufwand reduziert werden, der mit Schreibvorgängen oder der Wiederherstellung nach Fehlern verbunden ist.

Bei Festplattenlaufwerken (HDD) ist die Gruppengröße vier Symbole; mit Solid-State-Laufwerken (SSD) ist die Gruppengröße sechs Symbole. So sieht das Layout beispielsweise mit Festplattenlaufwerken und 12 Hardwarefehlerdomänen aus (d. h. 12 Server) – es gibt zwei Gruppen von vier Datensymbolen. Es erzielt 72,7 Prozent Speichereffizienz.

Wir empfehlen diese ausführliche und dennoch hervorragend lesbare Anleitung , wie lokale Wiederaufbaucodes verschiedene Fehlerszenarien behandeln und warum sie ansprechend sind, von Claus Joergensen.

Parität mit Beschleunigung per Spiegelung

Bei einem Volume von „Direkte Speicherplätze“ kann teilweise die Spiegelung und teilweise die Parität festgelegt werden. Schreibvorgänge landen zuerst im gespiegelten Teil und werden später dann allmählich in den Paritätsteil verschoben. Effektiv wird Spiegelung verwendet, um Erasure Coding zu beschleunigen.

Um dreiseitige Spiegelung und duale Parität zu kombinieren, benötigen Sie mindestens vier Fehlerdomänen, d. h. vier Server.

Die Speichereffizienz der Parität mit Beschleunigung per Spiegelung liegt zwischen den Ergebnissen, die Sie bei reiner Spiegelung und bei reiner Parität erzielen, und hängt von den gewählten Proportionen ab.

Wichtig

Wir empfehlen die Verwendung der Spiegelung für die meisten leistungsempfindlichen Workloads. Weitere Informationen darüber, wie Sie das Gleichgewicht zwischen Leistung und Kapazität je nach Workload herstellen können, finden Sie unter "Planen von Volumes".

Zusammenfassung

In diesem Abschnitt werden die in "Direkte Speicherplätze" verfügbaren Resilienztypen, die Mindestmaßstabanforderungen für die Verwendung der einzelnen Typen, die Anzahl der Fehler, die jeder Typ tolerieren kann, und die entsprechende Speichereffizienz zusammengefasst.

Resilienztypen

| Elastizität | Fehlertoleranz | Speichereffizienz |

|---|---|---|

| Zwei-Wege-Spiegelung | 1 | 50,0 % |

| Drei-Wege-Spiegelung | 2 | 33,3 % |

| Duale Parität | 2 | 50,0 %–80,0 % |

| Gemischt | 2 | 33,3 % bis 80,0 % |

Mindestmaßstabanforderungen

| Elastizität | Mindestens erforderliche Fehlerdomänen |

|---|---|

| Zwei-Wege-Spiegelung | 2 |

| Drei-Wege-Spiegelung | 3 |

| Duale Parität | 4 |

| Gemischt | 4 |

Tipp

Sofern Sie keine Gehäuse- oder Rack-Fehlertoleranz verwenden, bezieht sich die Anzahl der Fehlerdomänen auf die Anzahl der Server. Die Anzahl der Laufwerke auf jedem Server hat keinen Einfluss darauf, welche Resilienztypen Sie verwenden können, solange Sie die Mindestanforderungen für direkte Speicherplätze erfüllen.

Effizienz der dualen Parität für Hybridbereitstellungen

Diese Tabelle zeigt die Speichereffizienz von Dualparitäts- und lokalen Wiederherstellungscodes in jedem Maßstab für Hybridbereitstellungen, die sowohl Festplattenlaufwerke (HDD) als auch Solid-State-Laufwerke (SSD) enthalten.

| Fehlerdomänen | Gestaltung | Effizienz |

|---|---|---|

| 2 | – | – |

| 3 | – | – |

| 4 | RS 2+2 | 50,0 % |

| 5 | RS 2+2 | 50,0 % |

| 6 | RS 2+2 | 50,0 % |

| 7 | RS 4+2 | 66.7 % |

| 8 | RS 4+2 | 66.7 % |

| 9 | RS 4+2 | 66.7 % |

| 10 | RS 4+2 | 66.7 % |

| 11 | RS 4+2 | 66.7 % |

| 12 | LRC (8, 2, 1) | 72,7 % |

| 13 | LRC (8, 2, 1) | 72,7 % |

| 14 | LRC (8, 2, 1) | 72,7 % |

| 15 | LRC (8, 2, 1) | 72,7 % |

| 16 | LRC (8, 2, 1) | 72,7 % |

Effizienz der dualen Parität für reine Flash-Bereitstellungen

Diese Tabelle zeigt die Speichereffizienz von Dualparitäts- und lokalen Rekonstruktionscodes auf jeder Skala für All-Flash-Bereitstellungen, die nur Solid-State-Laufwerke (SSD) enthalten. Das Paritätslayout kann größere Gruppengrößen verwenden und eine bessere Speichereffizienz in einer All-Flash-Konfiguration erzielen.

| Fehlerdomänen | Gestaltung | Effizienz |

|---|---|---|

| 2 | – | – |

| 3 | – | – |

| 4 | RS 2+2 | 50,0 % |

| 5 | RS 2+2 | 50,0 % |

| 6 | RS 2+2 | 50,0 % |

| 7 | RS 4+2 | 66.7 % |

| 8 | RS 4+2 | 66.7 % |

| 9 | RS 6+2 | 75,0 % |

| 10 | RS 6+2 | 75,0 % |

| 11 | RS 6+2 | 75,0 % |

| 12 | RS 6+2 | 75,0 % |

| 13 | RS 6+2 | 75,0 % |

| 14 | RS 6+2 | 75,0 % |

| 15 | RS 6+2 | 75,0 % |

| 16 | LRC (12, 2, 1) | 80,0 % |

Beispiele

Wenn Sie nicht nur über zwei Server verfügen, empfehlen wir die Verwendung der Drei-Wege-Spiegelung und/oder der dualen Parität, da sie eine bessere Fehlertoleranz bieten. Insbesondere stellen sie sicher, dass alle Daten sicher und kontinuierlich zugänglich bleiben, auch wenn zwei Fehlerdomänen – mit Storage Spaces Direct, was bedeutet, dass zwei Server von gleichzeitigen Fehlern betroffen sind – beeinträchtigt werden.

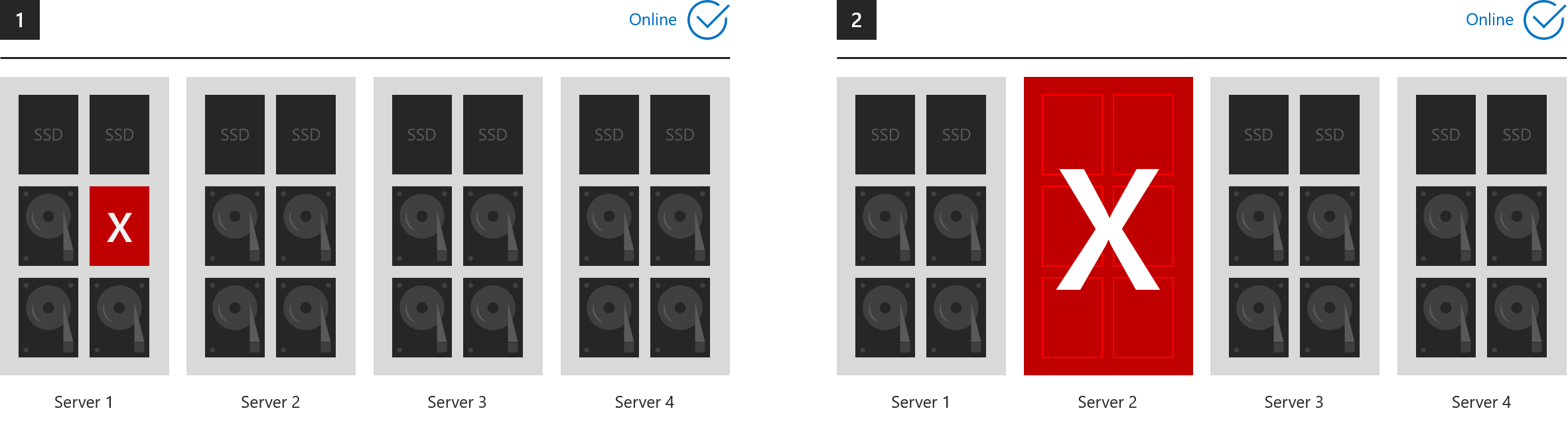

Beispiele, in denen alles online bleibt

Diese sechs Beispiele zeigen, was dreiseitige Spiegelung und/oder duale Parität tolerieren kann.

- 1. Ein Verlorenes Laufwerk (einschließlich Cachelaufwerke)

- 2. Ein Server ist verloren gegangen

- 3. Ein Server und ein Laufwerk verloren

- 4. Zwei Laufwerke gehen auf unterschiedlichen Servern verloren

- 5. Mehr als zwei Laufwerke verloren, solange höchstens zwei Server betroffen sind

- 6. Zwei Server verloren

... in jedem Fall bleiben alle Volumes online. (Stellen Sie sicher, dass Ihr Cluster das Quorum aufrechterhält.)

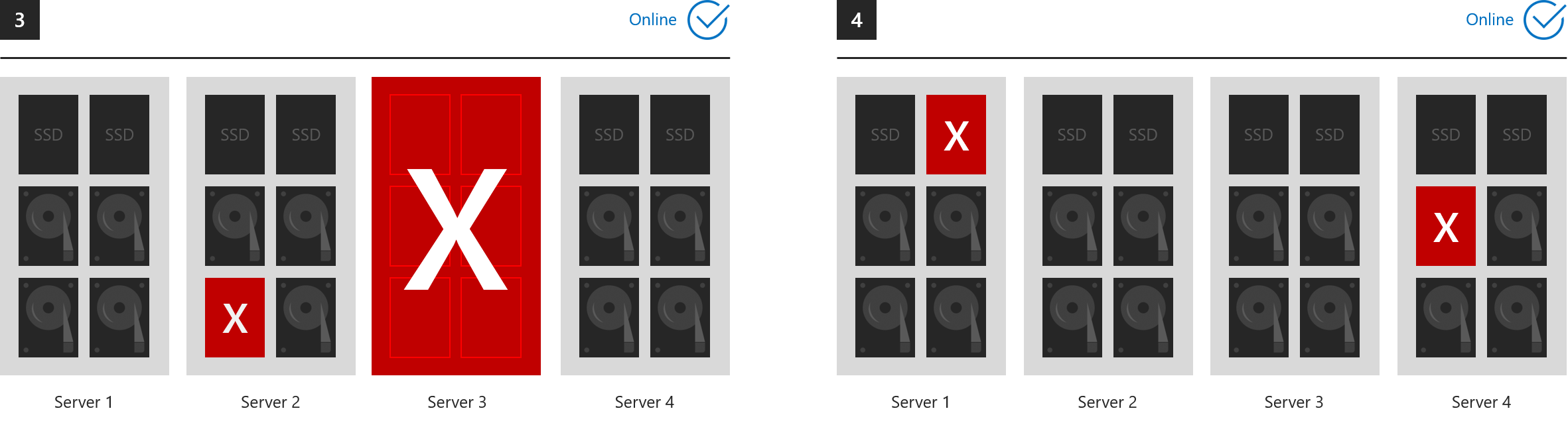

Beispiele, in denen alles offline geht

Während der Lebensdauer kann Storage Spaces eine beliebige Anzahl von Fehlern tolerieren, da es nach jedem Fehler, bei ausreichender Zeit, die vollständige Resilienz wiederherstellt. Allerdings können höchstens zwei Fehlerdomänen zu jedem beliebigen Zeitpunkt sicher betroffen sein. Im Folgenden sind daher Beispiele dafür aufgeführt, was von Drei-Wege-Spiegelung und/oder dualer Parität nicht toleriert werden kann.

- 7. Laufwerke, die in drei oder mehr Servern gleichzeitig verloren gegangen sind

- 8. Drei oder mehr Server verloren gleichzeitig

Verwendung

Sehen Sie sich Erstellen von Volumes an.

Nächste Schritte

Weitere Informationen zu themen, die in diesem Artikel erwähnt werden, finden Sie in den folgenden Themen: