Anmerkung

Der Zugriff auf diese Seite erfordert eine Genehmigung. Du kannst versuchen, dich anzumelden oder die Verzeichnisse zu wechseln.

Der Zugriff auf diese Seite erfordert eine Genehmigung. Du kannst versuchen , die Verzeichnisse zu wechseln.

GILT FÜR: Alle API Management-Ebenen

In diesem Artikel wird gezeigt, wie Sie eine OpenAI-kompatible Google Gemini-API importieren, um auf Modelle wie z.B. gemini-2.0-flash zuzugreifen. Für diese Modelle kann Azure API Management einen OpenAI-kompatiblen Chatabschlussendpunkt verwalten.

Weitere Informationen zum Verwalten von KI-APIs in der API-Verwaltung:

Voraussetzungen

- Eine bestehende API Management-Instanz. Erstellen Sie bitte eine, falls noch nicht geschehen.

- Ein API-Schlüssel für die Gemini-API. Wenn Sie keins haben, erstellen Sie es bei Google AI Studio , und speichern Sie es an einem sicheren Ort.

Importieren einer openAI-kompatiblen Gemini-API mithilfe des Portals

Navigieren Sie im Azure-Portal zu Ihrer API Management-Instanz.

Wählen Sie im linken Menü unter APIs die Option APIs>+ API hinzufügen aus.

Wählen Sie unter "Neue API definieren" die Sprachmodell-API aus.

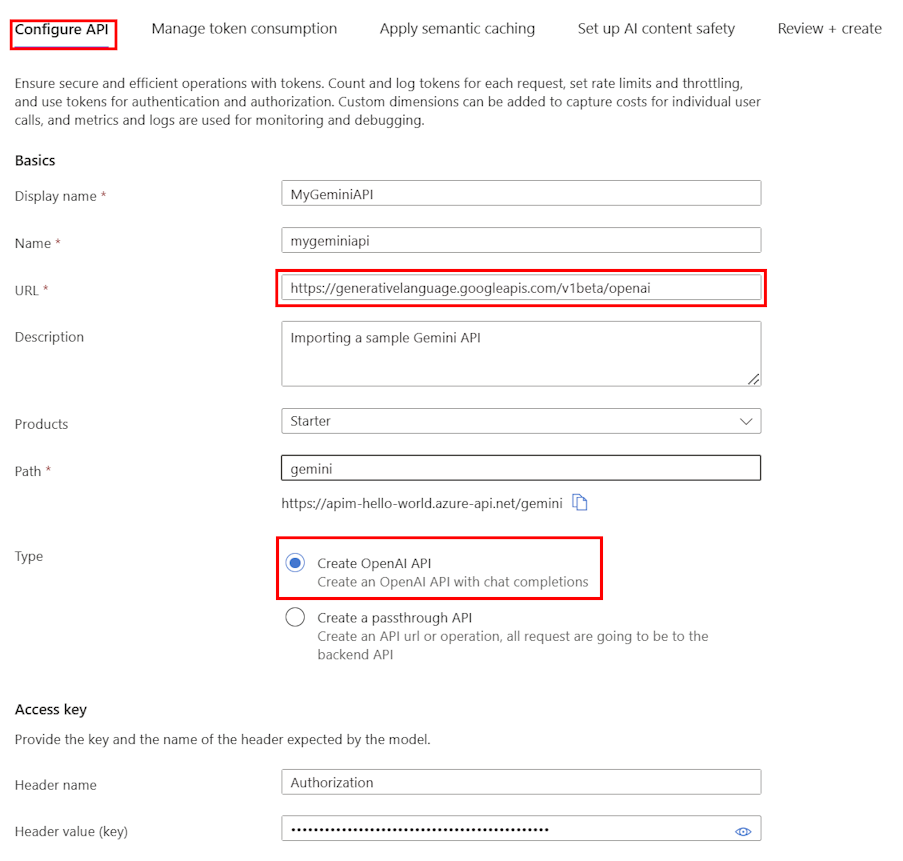

Auf der Registerkarte "API konfigurieren ":

Geben Sie einen Anzeigenamen und optional eine Beschreibung für die API ein.

Geben Sie in der URL die folgende Basis-URL aus der Kompatibilitätsdokumentation von Gemini OpenAI ein:

https://generativelanguage.googleapis.com/v1beta/openaiFügen Sie in Path einen Pfad an, den Ihre API-Verwaltungsinstanz zum Weiterleiten von Anforderungen an die Gemini-API-Endpunkte verwendet.

Wählen Sie in "Typ" die Option "OpenAI-API erstellen" aus.

Geben Sie in Access-Taste Folgendes ein:

- Headername: Autorisierung.

- Headerwert (Schlüssel):

Bearergefolgt von Ihrem API-Schlüssel für die Gemini-API.

Konfigurieren Sie auf den verbleibenden Registerkarten optional Richtlinien zum Verwalten der Tokennutzung, der semantischen Zwischenspeicherung und der SICHERHEIT von KI-Inhalten. Ausführliche Informationen finden Sie unter Importieren einer Sprachmodell-API.

Wählen Sie Überprüfen aus.

Wählen Sie nach der Überprüfung Ihrer Einstellungen Erstellen aus.

Die API-Verwaltung erstellt die API und konfiguriert Folgendes:

- Eine Back-End-Ressource und eine Set-Back-End-Dienstrichtlinie, die API-Anforderungen an den Google Gemini-Endpunkt weiterleiten.

- Zugriff auf das LLM-Back-End mithilfe des von Ihnen bereitgestellten Gemini-API-Schlüssels. Der Schlüssel ist in der API-Verwaltung als geheime Named Value geschützt.

- (optional) Richtlinien, mit denen Sie die API überwachen und verwalten können.

Testen des Gemini-Modells

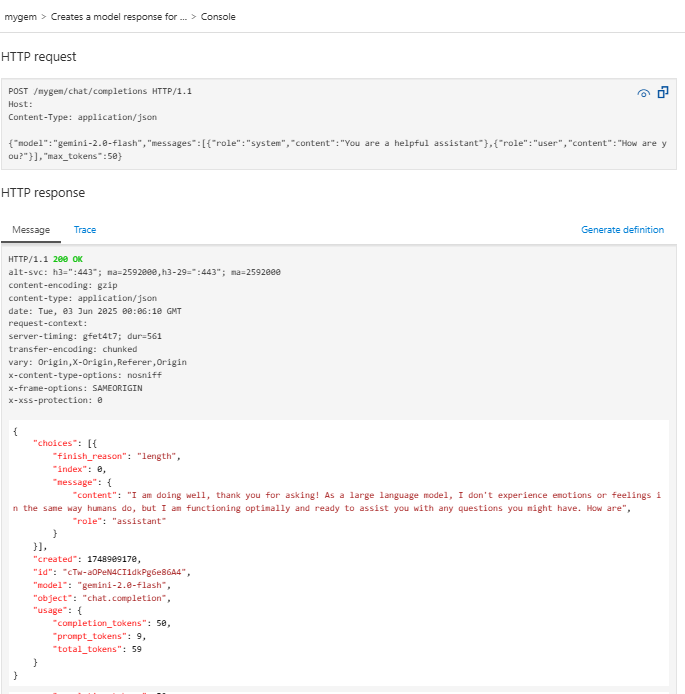

Nach dem Importieren der API können Sie den Endpunkt für Chat-Vervollständigungen der API testen.

Wählen Sie die API aus, die Sie im vorherigen Schritt erstellt haben.

Wählen Sie die Registerkarte Testen aus.

Wählen Sie den

POST Creates a model response for the given chat conversationVorgang aus, bei dem es sich um einePOSTAnforderung an den/chat/completionsEndpunkt handelt.Geben Sie im Abschnitt "Anforderungstext " den folgenden JSON-Code ein, um das Modell und eine Beispielaufforderung anzugeben. In diesem Beispiel wird das

gemini-2.0-flashModell verwendet.{ "model": "gemini-2.0-flash", "messages": [ { "role": "system", "content": "You are a helpful assistant" }, { "role": "user", "content": "How are you?" } ], "max_tokens": 50 }Wenn der Test erfolgreich ist, antwortet das Back-End mit einem erfolgreichen HTTP-Antwortcode und einigen Daten. Angefügt an die Antwort sind Tokennutzungsdaten, die Ihnen beim Überwachen und Verwalten des Sprachmodelltokenverbrauchs helfen.