Exportieren Ihres Modells für die Verwendung mit Mobilgeräten

Mit dem Custom Vision-Dienst können Sie Ihre Klassifizierer für die Offlineausführung exportieren. Sie können den exportierten Klassifizierer in eine Anwendung einbetten und lokal auf einem Gerät ausführen, um eine Klassifizierung in Echtzeit zu erhalten.

Exportoptionen

Custom Vision Service unterstützt die folgenden Exporte:

- TensorFlow für Android.

- TensorFlow.js für JavaScript-Frameworks wie React, Angular und Vue. Dies wird sowohl auf Android- als auch auf iOS-Geräten ausgeführt.

- Core ML für iOS 11

- ONNX für Windows ML, Android und iOS.

- Vision AI Developer Kit .

- Ein Docker-Container für Windows-, Linux- oder ARM-Architekturen. Der Container enthält ein TensorFlow-Modell und Dienstcode zur Verwendung der Custom Vision-API.

Wichtig

Der Custom Vision-Dienst exportiert nur Projekte mit kompakten Domänen. Die durch kompakte Domänen generierten Modelle sind für die Einschränkungen der Klassifizierung in Echtzeit auf Mobilgeräten optimiert. Mit einer kompakten Domäne erstellte Klassifizierer sind möglicherweise etwas weniger genau als eine Standarddomäne mit der gleichen Menge an Trainingsdaten.

Informationen zur Verbesserung der Klassifizierer finden Sie im Dokument Verbessern Ihrer Klassifizierung.

Konvertieren in eine kompakte Domäne

Hinweis

Die Schritte in diesem Abschnitt gelten nur, wenn Sie ein vorhandenes Modell haben, das nicht als kompakte Domäne festgelegt ist.

Gehen Sie zum Konvertieren der Domäne eines vorhandenen Modells folgendermaßen vor:

Wählen Sie auf der Custom Vision-Website das Symbol Home aus, um eine Liste Ihrer Projekte anzuzeigen.

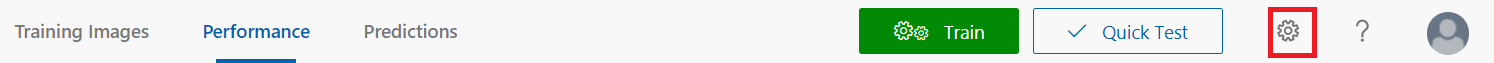

Wählen Sie ein Projekt und dann das Zahnradsymbol in der rechten oberen Ecke der Seite aus.

Wählen Sie im Abschnitt Domänen eine der kompakten Domänen aus. Wählen Sie zum Speichern der Änderungen Änderungen speichern aus.

Hinweis

Für das Vision AI Dev Kit muss das Projekt mit der Domäne Allgemein (Kompakt) erstellt werden, und Sie müssen die Option Vision AI Dev Kit im Abschnitt Exportfunktionen angeben.

Wählen Sie im oberen Bereich der Seite Trainieren aus, um das Training mit der neuen Domäne zu wiederholen.

Exportieren Ihres Modells

Um das Modell nach dem erneuten Training zu exportieren, gehen Sie folgendermaßen vor:

Wechseln Sie zur Registerkarte Leistung, und wählen Sie Exportieren aus.

Tipp

Wenn der Eintrag Exportieren nicht verfügbar ist, verwendet die ausgewählte Iteration keine kompakte Domäne. Wählen Sie im Abschnitt Iterationen dieser Seite eine Iteration aus, die eine kompakte Domäne verwendet, und wählen Sie dann Exportieren aus.

Wählen Sie das gewünschte Exportformat aus, und wählen Sie dann Exportieren aus, um das Modell herunterzuladen.

Nächste Schritte

Integrieren Sie Ihr exportiertes Modell in eine Anwendung, indem Sie einen der folgenden Artikel oder eines der Beispiele untersuchen:

- Verwenden Ihres TensorFlow-Modells mit Python

- Verwenden Ihres ONNX-Modells mit Windows Machine Learning

- Weitere Informationen finden Sie im Beispiel für das Core ML-Modell in einer iOS-Anwendung für die Bildklassifizierung in Echtzeit mit Swift.

- Weitere Informationen finden Sie im Beispiel für das TensorFlow-Modell in einer Android-Anwendung für die Bildklassifizierung in Echtzeit unter Android.

- Weitere Informationen finden Sie im Beispiel für das Core ML-Modell mit Xamarin für die Bildklassifizierung in Echtzeit in einer Xamarin-iOS-App.