Verarbeiten von Daten am Edge mit Datenverarbeitungspipelines

Wichtig

Die von Azure Arc aktivierte Azure IoT Operations Preview befindet sich derzeit in der VORSCHAU. Sie sollten diese Vorschausoftware nicht in Produktionsumgebungen verwenden.

Sie müssen eine neue Azure IoT Operations-Installation bereitstellen, wenn eine allgemein verfügbare Version verfügbar ist, können Sie keine Vorschauinstallation aktualisieren.

Die zusätzlichen Nutzungsbestimmungen für Microsoft Azure-Vorschauen enthalten rechtliche Bedingungen. Sie gelten für diejenigen Azure-Features, die sich in der Beta- oder Vorschauversion befinden oder aber anderweitig noch nicht zur allgemeinen Verfügbarkeit freigegeben sind.

Industrieressourcen generieren Daten in vielen verschiedenen Formaten und verwenden verschiedene Kommunikationsprotokolle. Diese Vielfalt von Datenquellen, gepaart mit unterschiedlichen Schemas und Einheitenmaßen, erschwert die effektive Verwendung und Analyse von Rohdaten. Darüber hinaus können Sie aus Compliance-, Sicherheits- und Leistungsgründen nicht alle Datasets in die Cloud hochladen.

Um diese Daten traditionell zu verarbeiten, sind teure, komplexe und zeitaufwendige Datentechniken erforderlich. Der Datenverarbeiter ist ein konfigurierbarer Datenverarbeitungsdienst, der die Komplexität und Vielfalt industrieller Daten verwalten kann. Verwenden Sie den Datenverarbeiter, um Daten aus unterschiedlichen Quellen verständlicher, nutzbarer und wertvoller zu machen.

Was ist der Datenverarbeiter?

Der Datenverarbeiter ist eine optionale Komponente der Azure IoT Operations Preview. Mit dem Datenauftragsverarbeiter können Sie die Daten von Ihren Geräten aggregieren, anreichern, normalisieren und filtern. Der Datenverarbeiter ist ein pipelinebasiertes Datenverarbeitungsmodul, mit dem Sie Daten am Edge verarbeiten können, bevor Sie sie entweder am Edge oder in der Cloud an die anderen Dienste senden:

Der Datenverarbeiter erfasst Echtzeitstreamingdaten aus Quellen wie OPC UA-Servern, Historikern und anderen industriellen Systemen. Er normalisiert diese Daten, indem verschiedene Datenformate in ein standardisiertes, strukturiertes Format konvertiert werden, das sich leichter abfragen und analysieren lässt. Der Datenprozessor kann die Daten auch kontextualisieren, indem er sie mit Verweisdaten oder zuletzt bekannten Werten (Last Known Values, LKV) anreichert, um einen umfassenden Überblick über Ihre industriellen Vorgänge zu bieten.

Die Ausgabe des Datenauftragsverarbeiters ist sauber, angereichert und standardisierte Daten, die für nachgeschaltete Anwendungen wie Echtzeitanalysen und Insights-Tools bereit sind. Der Datenprozessor reduziert die Zeit, die erforderlich ist, um Rohdaten in umsetzbare Erkenntnisse umzuwandeln, erheblich.

Zu den wichtigsten Datenverarbeitungsfeatures gehören:

Flexible Datennormalisierung zum Konvertieren mehrerer Datenformate in eine standardisierte Struktur.

Anreicherung von Datenströmen mit Verweis- oder LKV-Daten, um den Kontext zu verbessern und bessere Erkenntnisse zu ermöglichen.

Integrierte Microsoft Fabric-Integration zur Vereinfachung der Analyse sauberer Daten.

Die Möglichkeit, Daten aus verschiedenen Quellen zu verarbeiten und die Daten an verschiedenen Zielen zu veröffentlichen.

Als datenagnostische Datenverarbeitungsplattform kann der Datenverarbeiter Daten in einem beliebigen Format aufnehmen, die Daten verarbeiten und dann an ein Ziel schreiben. Zur Unterstützung dieser Funktionen kann der Datenverarbeiter verschiedene Formate deserialisieren und serialisieren. So kann er beispielsweise in das Parquet-Format serialisieren, um Dateien in Microsoft Fabric zu schreiben.

Automatische und konfigurierbare Wiederholungsrichtlinien zum Behandeln vorübergehender Fehler beim Senden von Daten an Cloudziele.

Bereitstellen des Datenauftragsverarbeiters

Standardmäßig ist der Datenauftragsverarbeiter nicht in einer Azure IoT Operations Preview-Bereitstellung enthalten. Wenn Sie beabsichtigen, den Datenverarbeiter zu verwenden, müssen Sie ihn einschließen, wenn Sie Azure IoT Operations Preview bereitstellen – Sie können ihn später nicht hinzufügen. Verwenden Sie zum Bereitstellen des Datenauftragsverarbeiters das --include-dp Argument, wenn Sie den Befehl "az iot ops init " ausführen. Weitere Informationen finden Sie unter Deploy Azure IoT Operations Preview to an Arc-enabled Kubernetes cluster.

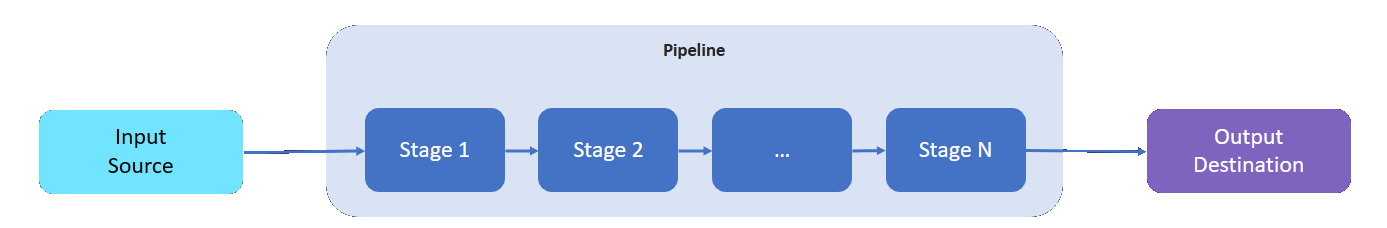

Was ist eine Pipeline?

Eine Datenverarbeitungspipeline verfügt über eine Eingabequelle, aus der Daten gelesen werden, ein Ziel, in das verarbeitete Daten geschrieben werden, und eine variable Anzahl von Zwischenstufen zum Verarbeiten der Daten.

Die Zwischenphasen stellen die verschiedenen verfügbaren Datenverarbeitungsfunktionen dar:

- Sie können einer Pipeline so viele Zwischenphasen hinzufügen, wie benötigt werden.

- Sie können die Zwischenphasen einer Pipeline ganz nach Ihrem Bedarf anordnen. Sie können die Phasen auch noch nach dem Erstellen der Pipeline neu anordnen.

- Jede Phase entspricht einer definierten Implementierungsschnittstelle und einem Eingabe-/Ausgabeschemavertrag..

- Jede Phase ist unabhängig von den anderen Phasen in der Pipeline.

- Alle Phasen werden innerhalb des Gültigkeitsbereichs einer Partition ausgeführt. Daten werden nicht von verschiedenen Partitionen gemeinsam genutzt.

- Daten fließen nur von einer Phase zur nächsten.

Datenverarbeitungspipelines können die folgenden Phasen verwenden:

| Phase | Beschreibung |

|---|---|

| Quelle – MQ | Ruft Daten von einem MQTT Vermittler ab. |

| Quelle – HTTP-Endpunkt | Ruft Daten von einem HTTP-Endpunkt ab. |

| Quelle – SQL | Ruft Daten aus einer Microsoft SQL Server-Datenbank ab. |

| Quelle - ZustromDB | Ruft Daten aus einer ZustromDB-Datenbank ab. |

| Filter | Filtert Daten, die die Phase durchlaufen. Beispielsweise können Sie jede Nachricht mit einer Temperatur ausfiltern, die außerhalb des Bereichs von 50F-150F liegt. |

| Transformieren | Normalisiert die Struktur der Daten. Ändern Sie beispielsweise die Struktur von {"Name": "Temp", "value": 50} in {"temp": 50}. |

| LKV | Speichert ausgewählte Metrikwerte in einem LKV-Speicher. Sie können beispielsweise nur Temperatur- und Feuchtigkeitsmessungen in LKV speichern und den Rest ignorieren. Eine nachfolgende Phase kann eine Nachricht mit den gespeicherten LKV-Daten anreichern. |

| Erweitern | Reichert Nachrichten mit Daten aus dem Verweisdatenspeicher an. Beispielsweise können Sie einen Operatornamen und eine Losnummer aus dem Betriebsdataset hinzufügen. |

| Aggregieren | Aggregiert Werte, die die Phase durchlaufen. Wenn beispielsweise Temperaturwerte alle 100 Millisekunden gesendet werden, geben Sie alle 30 Sekunden eine durchschnittliche Temperaturmetrik aus. |

| Aufruf | Ruft einen externen HTTP- oder gRPC-Dienst auf. Beispielsweise können Sie eine Azure-Funktion aufrufen, um aus einem benutzerdefinierten Nachrichtenformat in JSON zu konvertieren. |

| Ziel – MQ | Schreibt Ihre verarbeiteten, sauberen und kontextualisierten Daten in ein MQTT-Thema. |

| Ziel – Verweis | Schreibt Ihre verarbeiteten Daten in den integrierten Verweisspeicher. Andere Pipelines können den Verweisspeicher verwenden, um ihre Nachrichten anzureichern. |

| Ziel – gRPC | Sendet Ihre verarbeiteten, sauberen und kontextualisierten Daten an einen gRPC-Endpunkt. |

| Ziel – HTTP | Sendet Ihre verarbeiteten, sauberen und kontextualisierten Daten an einen HTTP-Endpunkt. |

| Ziel – Fabric Lakehouse | Sendet Ihre verarbeiteten, sauberen und kontextualisierten Daten an ein Microsoft Fabric Lakehouse in der Cloud. |

| Ziel – Azure Data Explorer | Sendet Ihre verarbeiteten, sauberen und kontextualisierten Daten an einen Azure Data Explorer-Endpunkt in der Cloud. |

Nächster Schritt

Weitere Informationen zum Datenverarbeiter finden Sie unter: