Verwenden von Azure Data Lake Storage Gen1 für Big Data-Anforderungen

Hinweis

Azure Data Lake Storage Gen1 wurde außer Betrieb genommen. Sehen Sie sich hier die Ankündigung zur Einstellung an. Auf Data Lake Storage Gen1-Ressourcen kann nicht mehr zugegriffen werden.

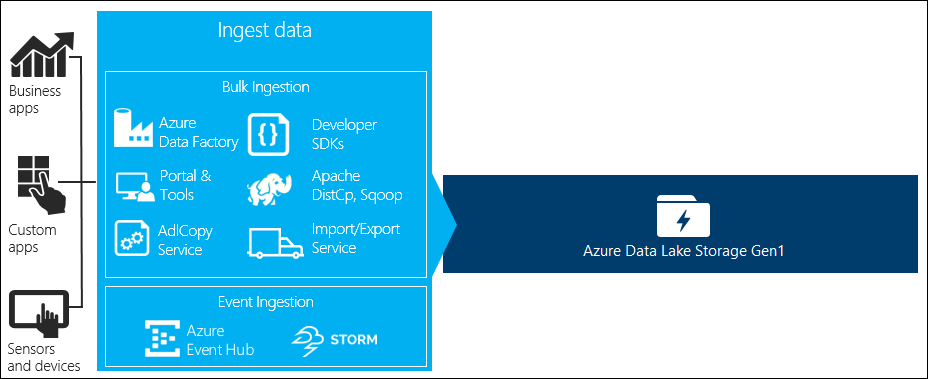

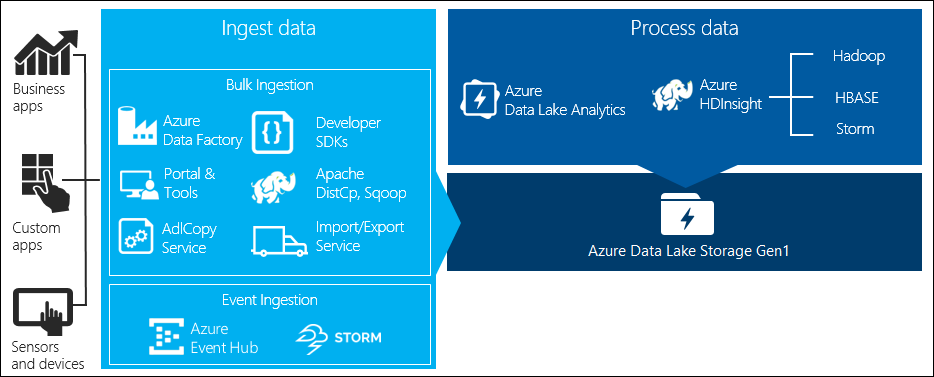

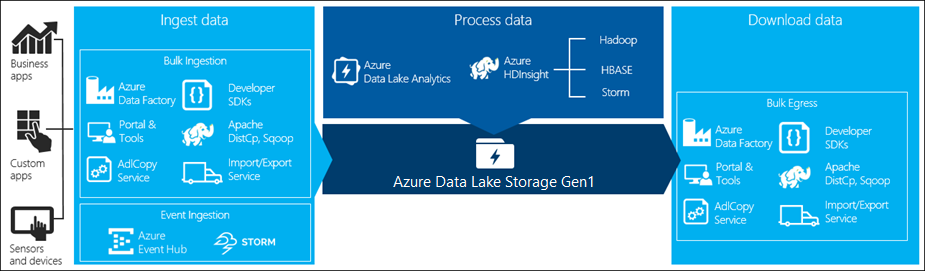

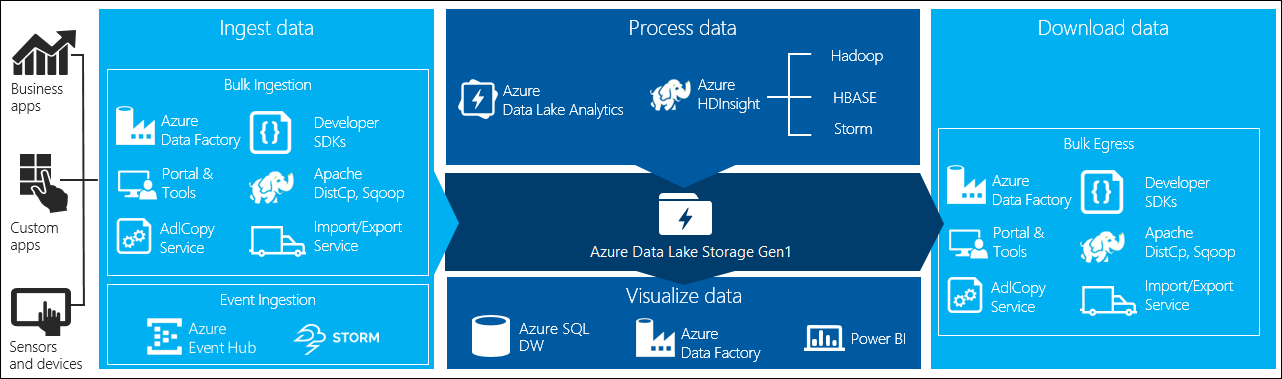

Es gibt vier wichtige Phasen in der Big Data-Verarbeitung:

- Erfassung von großen Datenmengen in einem Datenspeicher, in Echtzeit oder in Batches

- Verarbeiten der Daten

- Herunterladen der Daten

- Visualisieren der Daten

In diesem Artikel betrachten wir diese Phasen in Bezug auf Azure Data Lake Storage Gen1, um die Optionen und Tools kennenzulernen, die zur Erfüllung Ihrer Big Data-Anforderungen verfügbar sind.

Erfassen von Daten in Data Lake Storage Gen1

In diesem Abschnitt werden die unterschiedlichen Quellen von Daten sowie die verschiedenen Methoden hervorgehoben, mit denen Daten in einem Data Lake Storage Gen1-Konto erfasst werden können.

Ad-hoc-Daten

Dies steht für kleinere Datasets, die zum Erstellen von Prototypen einer Big Data-Anwendung verwendet werden. Es gibt, abhängig von der Quelle der Daten, verschiedene Möglichkeiten zum Erfassen von Ad-hoc-Daten.

| Data source | Erfassen Sie mit |

|---|---|

| Lokaler Computer | |

| Azure Storage Blob |

Streamingdaten

Dies stellt Daten dar, die von verschiedenen Quellen wie Anwendungen, Geräten, Sensoren usw. generiert werden können. Diese Daten können mit einer Vielzahl von Tools in Data Lake Storage Gen1 aufgenommen werden. Diese Tools erfassen und verarbeiten die Daten in der Regel Ereignis für Ereignis in Echtzeit und schreiben dann die Ereignisse stapelweise in Data Lake Storage Gen1, damit sie weiterverarbeitet werden können.

Folgende Tools können Sie verwenden:

- Azure Stream Analytics: In Event Hubs erfasste Ereignisse können mithilfe einer Azure Data Lake Storage Gen1-Ausgabe in Azure Data Lake Storage Gen1 geschrieben werden.

- EventProcessorHost: Sie können Ereignisse von Event Hubs empfangen und dann mit dem Data Lake Storage Gen1 .NET SDK in Data Lake Storage Gen1 schreiben.

Relationale Daten

Sie können auch Daten aus relationalen Datenbanken erfassen. Relationale Datenbanken sammeln über einen Zeitraum hinweg umfangreiche Datenmengen, die bei Verarbeitung durch eine Big Data-Pipeline wichtige Einblicke bieten können. Mit den folgenden Tools können Sie solche Daten in Data Lake Storage Gen1 verschieben.

Webserverprotokolldaten (mit benutzerdefinierten Anwendungen hochladen)

Auf diesen Datasettyp wird besonders hingewiesen, da die Analyse von Webserverprotokolldaten eine gängige Praxis für Big Data-Anwendungen ist und voraussetzt, dass zahlreiche Protokolldateien in Data Lake Storage Gen1 hochgeladen werden. Sie können jedes der folgenden Tools nutzen, um eigene Skripts oder Anwendungen zum Hochladen solcher Daten zu schreiben.

- Azure-Befehlszeilenschnittstelle

- Azure PowerShell

- Azure Data Lake Storage Gen1 .NET SDK

- Azure Data Factory

Für das Hochladen von Webserverprotokolldaten und auch anderer Arten von Daten (z. B. soziale Stellungnahmen) ist es ein guter Ansatz, wenn Sie Ihre eigenen benutzerdefinierten Skripts/Anwendungen schreiben, denn dies gibt Ihnen die Flexibilität, Ihre Datenhochladekomponente als Teil in Ihre Big Data-Anwendung einzubeziehen. In einigen Fällen kann dieser Code die Form eines Skripts oder eines einfachen Befehlszeilenprogramms annehmen. In anderen Fällen kann der Code verwendet werden, die Big Data-Verarbeitung in eine Geschäftsanwendung oder -lösung zu integrieren.

Mit Azure HDInsight-Clustern verknüpfte Daten

Die meisten HDInsight-Clustertypen (Hadoop, HBase, Storm) unterstützen Data Lake Storage Gen1 als Datenspeicherrepository. HDInsight-Cluster greifen aus Azure Storage-Blobs (WASB) auf Daten zu. Zur Verbesserung der Leistung können Sie die Daten aus WASB in ein mit dem Cluster verknüpftes Data Lake Storage Gen1-Konto kopieren. Mit den folgenden Tools können Sie die Daten kopieren.

In lokalen oder IaaS Hadoop-Clustern gespeicherte Daten

Große Datenmengen können in vorhandenen Hadoop-Clustern oder lokal auf Computern gespeichert werden, die HDFS verwenden. Die Hadoop-Cluster können sich in einer lokalen Bereitstellung oder innerhalb eines IaaS-Clusters in Azure befinden. Möglicherweise bestehen Anforderungen für das einmalige oder regelmäßige Kopieren solcher Daten in Azure Data Lake Storage Gen1. Hierfür stehen verschiedene Möglichkeiten zur Verfügung. Im Folgenden finden Sie eine Liste der Alternativen und die jeweiligen Vor- und Nachteile.

| Vorgehensweise | Details | Vorteile | Überlegungen |

|---|---|---|---|

| Verwenden Sie Azure Data Factory (ADF), um Daten direkt aus Hadoop-Clustern in Azure Data Lake Storage Gen1 zu kopieren. | ADF unterstützt HDFS als Datenquelle. | ADF bietet sofortige Unterstützung für HDFS und erstklassige End-to-End-Verwaltung und -Überwachung. | Ein Datenverwaltungsgateway muss lokal oder im IaaS-Cluster bereitgestellt werden. |

| Exportieren Sie Daten in Form von Dateien aus Hadoop. Kopieren Sie die Dateien dann mit einer geeigneten Methode in Azure Data Lake Storage Gen1. | Sie können Dateien mithilfe von Azure Data Lake Storage Gen1 kopieren:

|

Lässt sich schnell einrichten. Benutzerdefinierte Uploads sind möglich. | Der Prozess erfordert mehrere Schritte und verschiedene Technologien. Da die Tools benutzerdefiniert sind, werden Verwaltung und Überwachung im Lauf der Zeit schwierig. |

| Verwenden Sie Distcp, um Daten von Hadoop in Azure Storage zu kopieren. Kopieren Sie die Daten dann mit einer geeigneten Methode aus Azure Storage in Data Lake Storage Gen1. | Sie können Daten aus Azure Storage in Data Lake Storage Gen1 kopieren: | Sie können Open Source-Tools verwenden. | Der Prozess erfordert mehrere Schritte und verschiedene Technologien. |

Sehr große Datasets

Das Hochladen von Datasets im Bereich mehrerer Terabyte kann mithilfe der oben beschriebenen Methoden manchmal langsam und kostspielig sein. In solchen Fällen können Sie die folgenden Optionen verwenden:

Verwenden von Azure ExpressRoute. Azure ExpressRoute ermöglicht Ihnen, private Verbindungen zwischen Azure-Rechenzentren und Ihrer lokalen Infrastruktur zu erstellen. Dies ist eine zuverlässige Option zur Übertragung großer Datenmengen. Weitere Informationen finden Sie in der Dokumentation zu Azure ExpressRoute.

Offline-Datenupload. Wenn Azure ExpressRoute aus irgendeinem Grund nicht verwendet werden kann, können Sie über den Azure Import/Export-Dienst Festplattenlaufwerke mit Ihren Daten an ein Azure-Rechenzentrum senden. Ihre Daten werden zunächst in Azure Storage-Blobs hochgeladen. Anschließend können Sie mit Azure Data Factory oder dem AdlCopy-Tool Daten aus Azure Storage-Blobs in Data Lake Storage Gen1 kopieren.

Hinweis

Wenn Sie den Import/Export-Dienst verwenden, sollte die Größe der Dateien auf den Datenträgern, die Sie an das Azure-Rechenzentrum senden, nicht größer als 195 GB sein.

Verarbeiten von in Data Lake Storage Gen1 gespeicherten Daten

Sobald die Daten in Data Lake Storage Gen1 verfügbar sind, können Sie mit den unterstützten Big Data-Anwendungen Analysen für diese Daten ausführen. Derzeit können Sie mit Azure HDInsight und Azure Data Lake Analytics Datenanalyseaufträge für die in Data Lake Storage Gen1 gespeicherten Daten ausführen.

Betrachten Sie die folgenden Beispiele.

- Erstellen eines HDInsight-Clusters mit Data Lake Storage Gen1 als Speicher

- Verwenden von Azure Data Lake Analytics mit Data Lake Storage Gen1

Herunterladen von Daten aus Data Lake Storage Gen1

Vielleicht möchten Sie auch für Szenarien wie die folgenden Daten aus Azure Data Lake Storage Gen1 herunterladen oder verschieben:

- Verschieben von Daten aus anderen Repositorys zur Verbindung mit Ihren vorhandenen Datenverarbeitungspipelines. Sie möchten z. B. Daten aus Data Lake Storage Gen1 in Azure SQL-Datenbank oder SQL Server verschieben.

- Herunterladen von Daten auf Ihren lokalen Computer für die Verarbeitung in IDE-Umgebungen beim Erstellen von Anwendungsprototypen.

In solchen Fällen können Sie eine der folgenden Optionen verwenden:

Sie können auch mit den folgenden Methoden Ihr eigenes Skript/Ihre eigene Anwendung zum Herunterladen von Daten aus Data Lake Storage Gen1 schreiben.

Visualisieren von Daten in Data Lake Storage Gen1

Sie können eine Kombination aus Diensten verwenden, um visuelle Darstellungen von in Data Lake Storage Gen1 gespeicherten Daten zu erstellen.

- Sie können beginnen, indem Sie Daten mithilfe von Azure Data Factory aus Data Lake Storage Gen1 nach Azure Synapse Analytics verschieben

- Danach können Sie Power BI in Azure Synapse Analytics integrieren, um eine visuelle Darstellung der Daten zu erstellen.