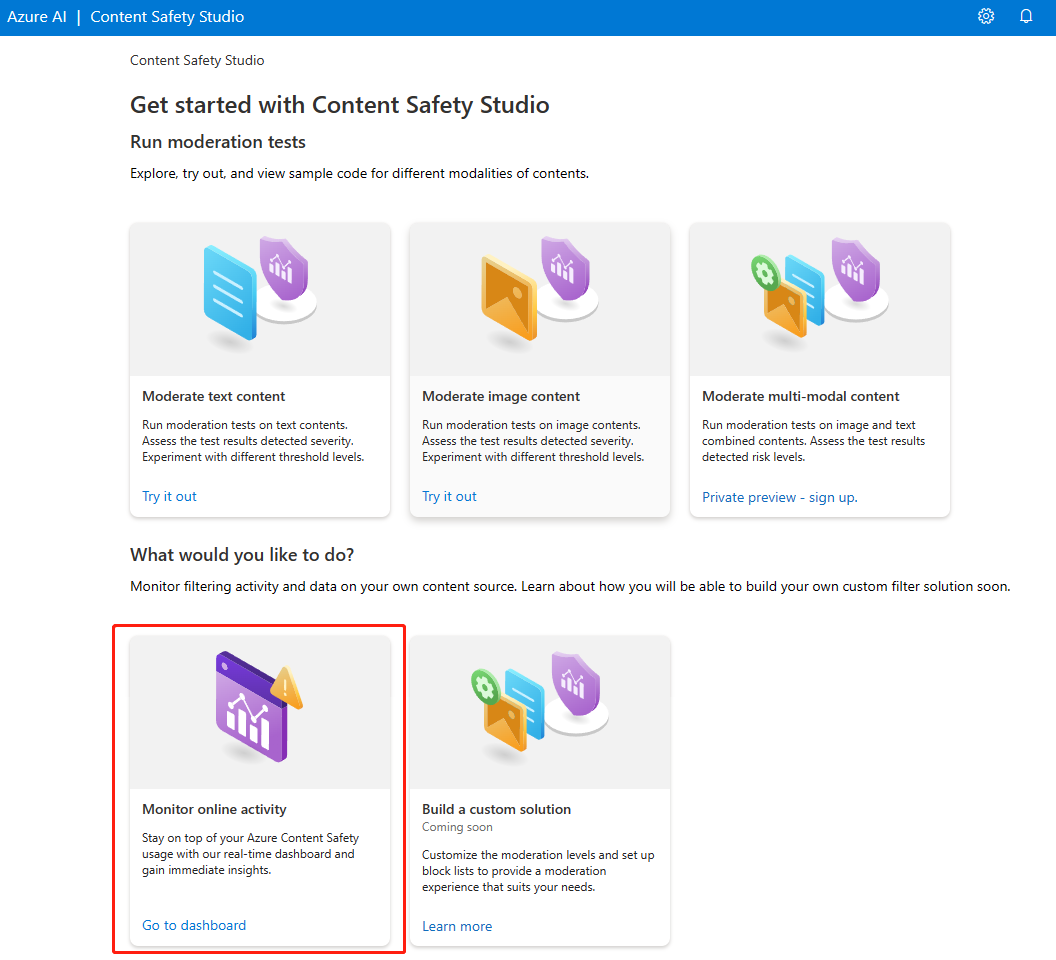

Schnellstart: Content Safety Studio von Azure KI

Diese Schnellstartanleitung enthält Informationen zu den ersten Schritten mit dem Azure KI Content Safety-Dienst unter Verwendung von Content Safety Studio im Browser.

Achtung

Einige der von Content Safety Studio bereitgestellten Beispielinhalte können anstößig sein. Beispielbilder sind standardmäßig verschwommen. Wir raten zu umsichtigem Vorgehen.

Voraussetzungen

- Ein aktives Azure-Konto. Falls Sie keines haben, können Sie kostenlos eines erstellen.

- Eine Azure-Ressource vom Typ Content Safety.

- Weisen Sie Ihrem Konto die Rolle

Cognitive Services Userzu, um die Studioerfahrung sicherzustellen. Navigieren Sie zum Azure Portal und dann zu Ihrer Ressource für Inhaltssicherheit oder Azure KI Services, und wählen Sie auf der linken Navigationsleiste Zugriffssteuerung aus. Klicken Sie anschließend auf + Rollenzuweisung hinzufügen, wählen Sie die RolleCognitive Services Userund das Mitglied Ihres Kontos aus, dem Sie diese Rolle zuweisen müssen, überprüfen Sie die Auswahl, und nehmen Sie die Zuweisung vor. Es kann ein paar Minuten dauern, bis die Zuweisung wirksam wird. - Melden Sie sich mit Ihrem Azure-Abonnement und Ihrer Content Safety-Ressource bei Content Safety Studio an.

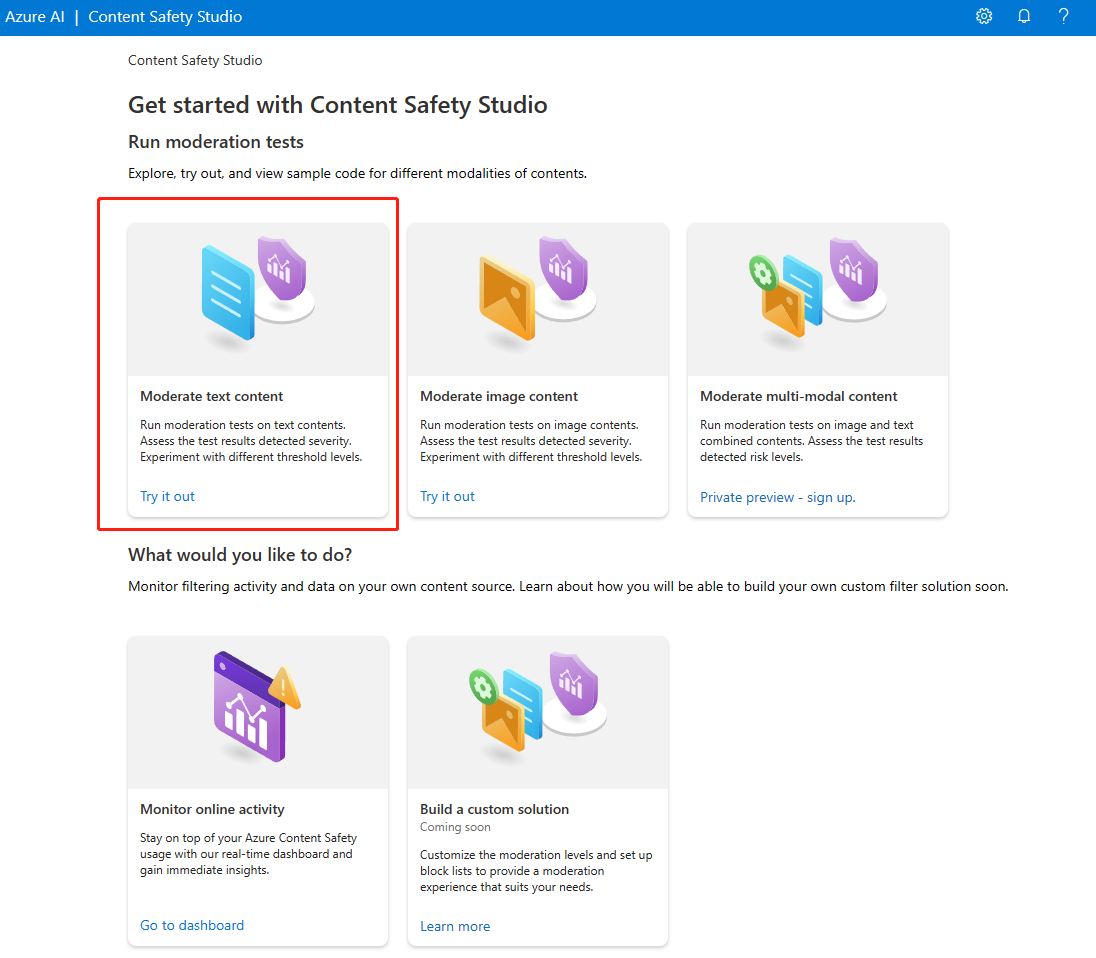

Analysieren von Textinhalten

Auf der Seite Textinhalt moderieren können Sie schnell die Textmoderation ausprobieren.

- Wählen Sie den Bereich Textinhalt moderieren aus.

- Fügen Sie dem Eingabefeld Text hinzu, oder wählen Sie Beispieltext aus den Bereichen auf der Seite aus.

Tipp

Textgröße und Granularität

Informationen zu Einschränkungen für die maximale Textlänge finden Sie unter Eingabeanforderungen.

- Klicken Sie auf Test ausführen.

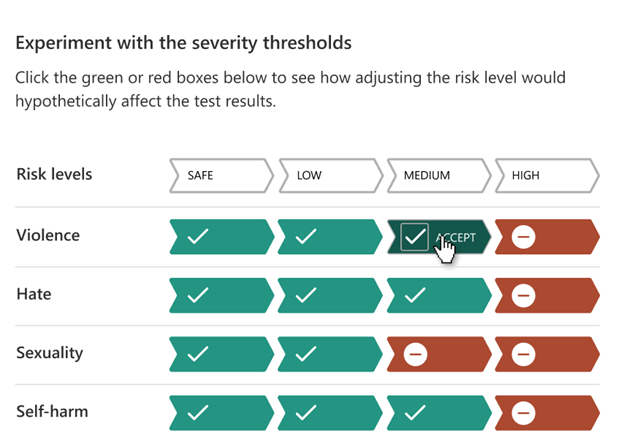

Der Dienst gibt alle erkannten Kategorien sowie jeweils einen Schweregrad zurück. Mögliche Schweregrade sind „0“ (sicher), „2“ (niedrig), „4“ (mittel) und „6“ (hoch). Außerdem wird basierend auf den von Ihnen konfigurierten Filtern ein binäres Ergebnis (Akzeptiert /Abgelehnt) zurückgegeben. Verwenden Sie die Matrix auf der Registerkarte Filter konfigurieren auf der rechten Seite, um die zulässigen bzw. nicht zulässigen Schweregrade für die einzelnen Kategorien festzulegen. Anschließend können Sie die Textanalyse erneut ausführen, um zu sehen, wie der Filter funktioniert.

Auf der Registerkarte Sperrliste verwenden auf der rechten Seite können Sie eine Sperrliste erstellen, bearbeiten und dem Moderationsworkflow hinzufügen. Wenn beim Ausführen des Tests eine Sperrliste aktiviert ist, wird unter Ergebnisse der Bereich Sperrlistenerkennung angezeigt. Dort werden Übereinstimmungen mit der Sperrliste gemeldet.

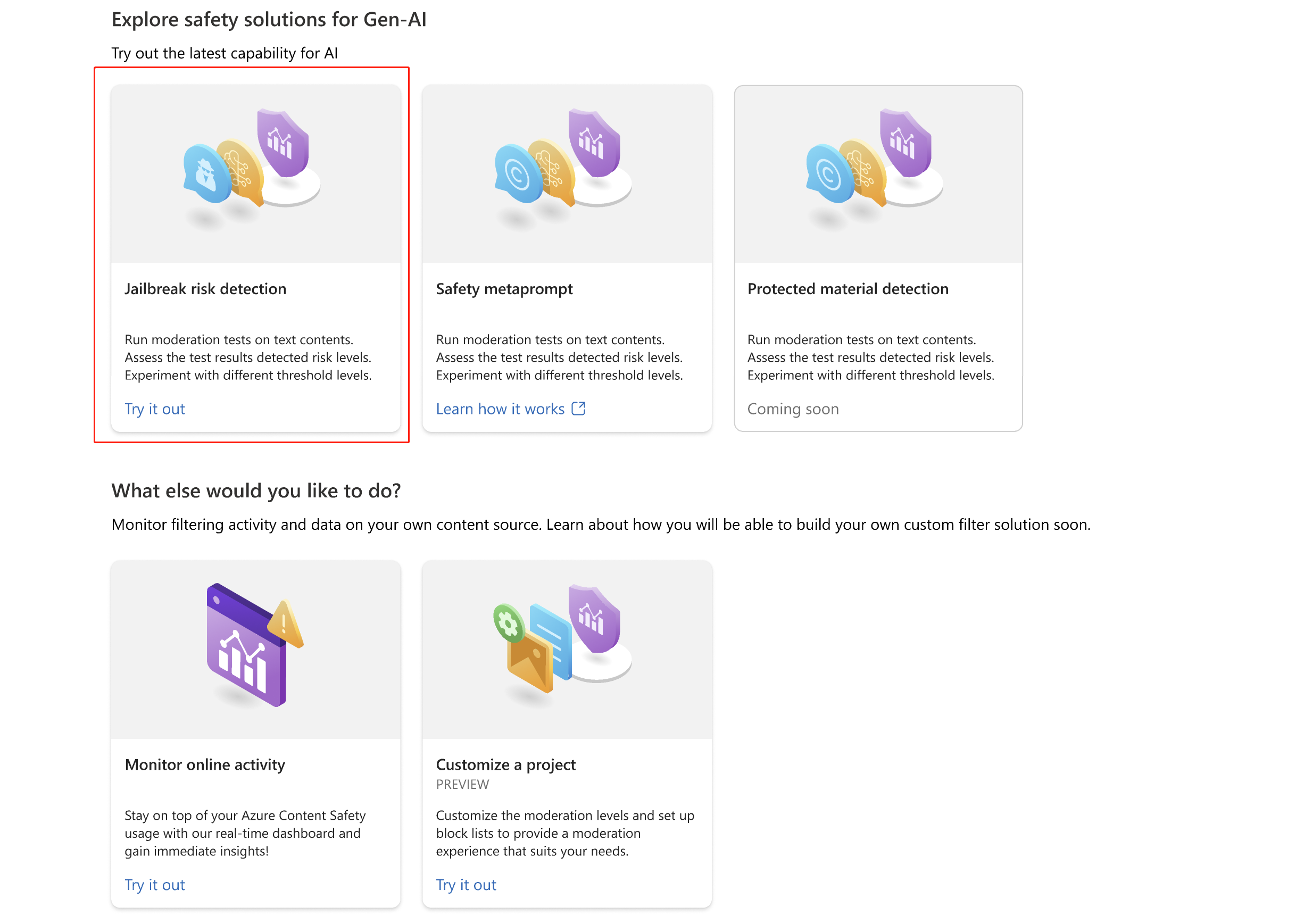

Erkennen von Benutzereingabeangriffen

Im Bereich Prompt Shields können Sie die Erkennung von Benutzereingaberisiken ausprobieren. Detect User Prompts, die darauf abzielen, ein Verhalten des generativen KI-Modells zu provozieren, für dessen Vermeidung es trainiert wurde, oder gegen die in der Systemnachricht festgelegten Regeln zu verstoßen. Diese Angriffe können von komplexem Rollenspiel bis hin zu subtiler Subversion des Sicherheitsziels variieren.

- Wählen Sie den Bereich Prompt Shields aus.

- Wählen Sie einen Beispieltext auf der Seite aus oder geben Sie Ihren eigenen Inhalt zum Testen ein. Sie können auch eine CSV-Datei hochladen, um einen Batchtest auszuführen.

- Klicken Sie auf Test ausführen.

Der Dienst gibt die Risikokennzeichnung und den Typ für jedes Beispiel zurück.

Weitere Informationen finden Sie im konzeptionellen Leitfaden zu Prompt Shields.

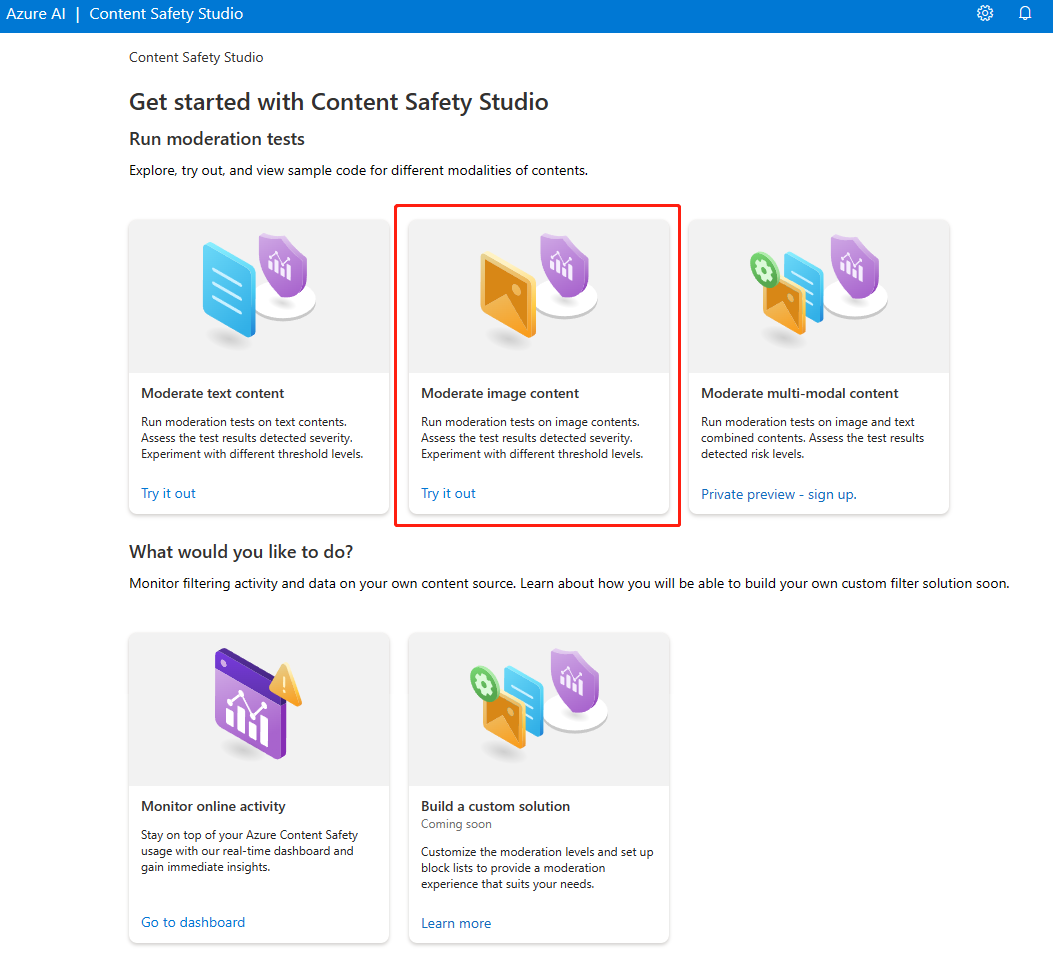

Analysieren von Bildinhalten

Auf der Seite Bildinhalt moderieren können Sie schnell die Bildmoderation ausprobieren.

- Wählen Sie den Bereich Bildinhalt moderieren aus.

- Wählen Sie über die Bereiche auf der Seite ein Beispielbild aus, oder laden Sie ein eigenes Bild hoch. Die maximale Größe für Bildübermittlungen beträgt 4 MB. Die Bildabmessungen müssen zwischen 50 × 50 Pixel und 2.048 × 2.048 Pixel liegen. Bilder können im JPEG-, PNG-, GIF-, BMP-, TIFF- oder WEBP-Format vorliegen.

- Klicken Sie auf Test ausführen.

Der Dienst gibt alle erkannten Kategorien sowie jeweils einen Schweregrad zurück. Mögliche Schweregrade sind „0“ (sicher), „2“ (niedrig), „4“ (mittel) und „6“ (hoch). Außerdem wird basierend auf den von Ihnen konfigurierten Filtern ein binäres Ergebnis (Akzeptiert /Abgelehnt) zurückgegeben. Verwenden Sie die Matrix auf der Registerkarte Filter konfigurieren auf der rechten Seite, um die zulässigen bzw. nicht zulässigen Schweregrade für die einzelnen Kategorien festzulegen. Anschließend können Sie die Textanalyse erneut ausführen, um zu sehen, wie der Filter funktioniert.

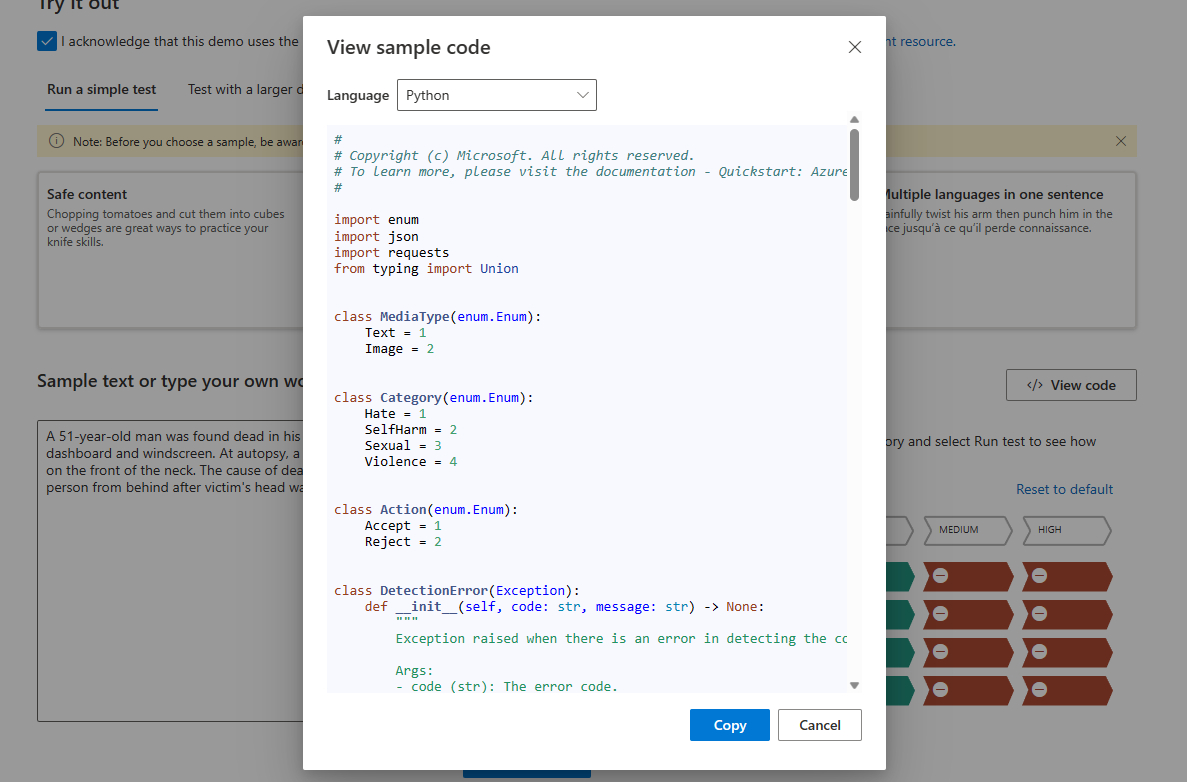

Anzeigen und Exportieren von Code

Das Feature Code anzeigen steht sowohl auf der Seite Textinhalt analysieren als auch auf der Seite Bildinhalt analysieren zur Verfügung und kann verwendet werden, um den Beispielcode anzuzeigen und zu kopieren. Dieser umfasst die Konfiguration für die Schweregradfilterung sowie Sperrlisten und Moderationsfunktionen. Anschließend können Sie den Code bei sich bereitstellen.

Überwachen der Onlineaktivität

Auf der Seite Onlineaktivität überwachen können Sie sich Ihre API-Nutzung und -Trends ansehen.

Sie können auswählen, welcher Medientyp überwacht werden soll. Sie können auch Daten aus diesem Zeitraum anzeigen: auswählen, um den zu überprüfenden Zeitbereich anzugeben.

Im Diagramm Ablehnungsrate pro Kategorie können Sie außerdem die Schweregrad-Schwellenwerte für die einzelnen Kategorien anpassen.

Darüber hinaus können Sie Sperrlisten bearbeiten, wenn Sie einige Begriffe ändern möchten (basierend auf dem Diagramm Zehn am häufigsten blockierte Begriffe).

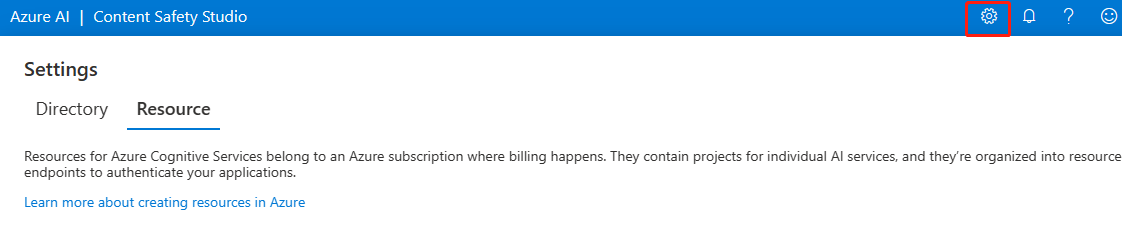

Verwalten Ihrer Ressource

Wenn Sie Ressourcendetails wie Name und Tarif anzeigen möchten, klicken Sie in der rechten oberen Ecke der Startseite von Content Safety Studio auf das Symbol Einstellungen, und wählen Sie die Registerkarte Ressource aus. Falls Sie Zugriff auf andere Ressourcen haben, können Sie hier auch zu einer anderen Ressource wechseln.

Bereinigen von Ressourcen

Wenn Sie eine Azure KI Services-Ressource bereinigen und entfernen möchten, können Sie die Ressource oder die Ressourcengruppe löschen. Wenn Sie die Ressourcengruppe löschen, werden auch alle anderen Ressourcen gelöscht, die ihr zugeordnet sind.

Nächste Schritte

Beginnen Sie als Nächstes mit der Verwendung von Azure KI Content Safety über die REST-APIs oder über ein Client-SDK, damit Sie den Dienst nahtlos in Ihre Anwendung integrieren können.

Quickstart: REST API and client SDKs (Schnellstart: REST-API und Client-SDKs)

Feedback

Bald verfügbar: Im Laufe des Jahres 2024 werden wir GitHub-Issues stufenweise als Feedbackmechanismus für Inhalte abbauen und durch ein neues Feedbacksystem ersetzen. Weitere Informationen finden Sie unter https://aka.ms/ContentUserFeedback.

Feedback senden und anzeigen für