Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

In diesem Artikel erfahren Sie, wie Sie eine professionelle Stimme über das Azure AI Foundry-Portal optimieren.

Wichtig

Professionelle Sprachoptimierung ist derzeit nur in einigen Regionen verfügbar. Nachdem Ihr VoIP-Modell in einer unterstützten Region trainiert wurde, können Sie das professionelle VoIP-Modell nach Bedarf in eine Azure AI Foundry-Ressource in einer anderen Region kopieren. Weitere Informationen finden Sie in den Fußnoten in der Tabelle für Azure Cognitive Service für Speech.

Die Trainingsdauer hängt von der Menge der verwendeten Daten ab. Es dauert etwa 40 Rechenstunden im Durchschnitt, um eine professionelle Stimme zu optimieren. Mit einer Azure AI Foundry-Standardressource (S0) können Sie vier Stimmen gleichzeitig trainieren. Wenn das Limit erreicht wurde, warten Sie, bis der Trainingsvorgang mindestens eines Stimmmodells beendet wurde, und versuchen Sie es dann noch mal.

Hinweis

Zwar unterscheidet sich die Gesamtanzahl der benötigten Stunden je nach Trainingsmethode, doch gilt für alle der gleiche Preis pro Einheit. Weitere Informationen finden Sie unter Preisdetails zum benutzerdefinierten neuronalen Training.

Auswählen einer Trainingsmethode

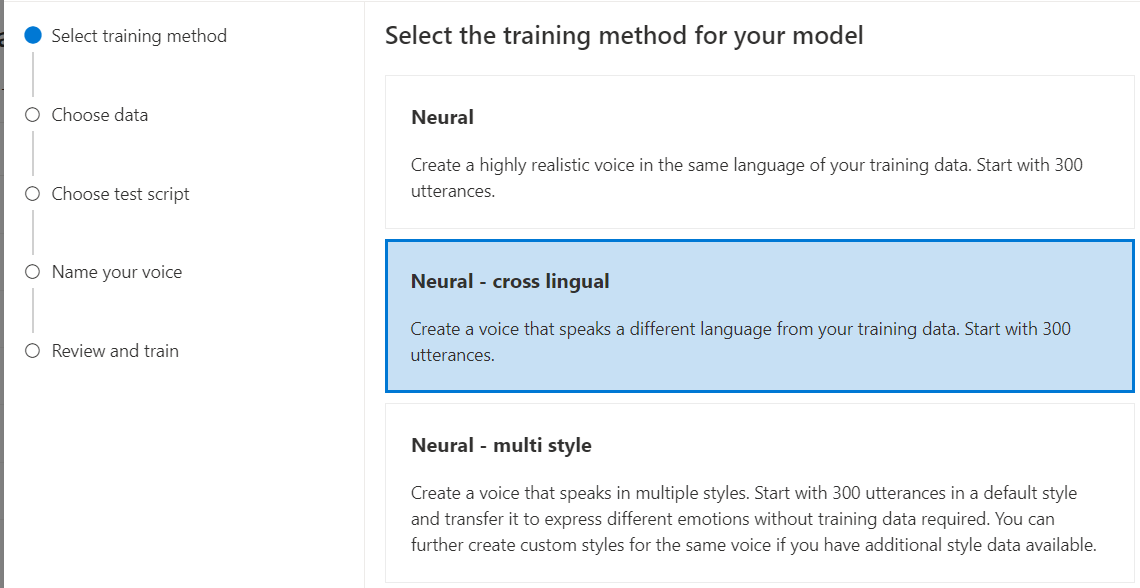

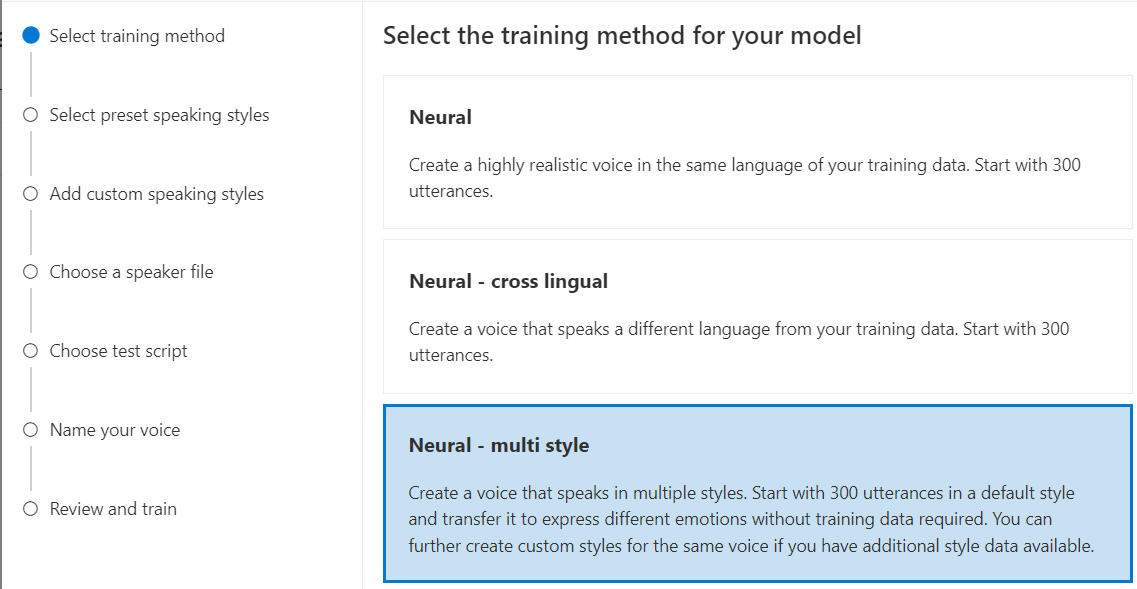

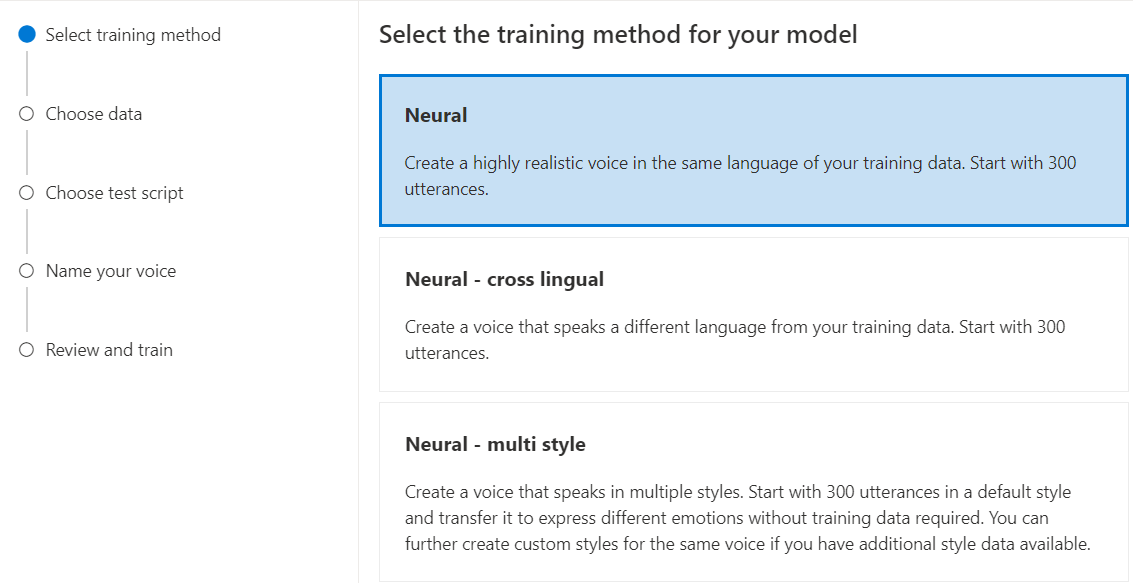

Nachdem Sie Ihre Datendateien überprüft haben, verwenden Sie sie, um Ihr benutzerdefiniertes VoIP-Modell zu erstellen. Wenn Sie eine benutzerdefinierte Stimme erstellen, können Sie diese mit einer der folgenden Methoden trainieren:

Neuronal: Erstellen einer Stimme in der Sprache Ihrer Trainingsdaten.

Neuronal - sprachübergreifend: Erstellen Sie eine Stimme, die eine andere Sprache spricht als Ihre Trainingsdaten. Beispielsweise können Sie mit den

zh-CNTrainingsdaten eine Stimme erstellen, dieen-USspricht.Die Sprache der Trainingsdaten und die Zielsprache müssen beide zu den Sprachen zählen, für die sprachübergreifendes Stimmtraining unterstützt wird. Sie brauchen keine Trainingsdaten in der Zielsprache vorzubereiten, aber Ihr Testskript muss in der Zielsprache abgefasst sein.

Neural - Multistil: Erstellen Sie eine benutzerdefinierte Stimme, die in mehreren Stilen und Emotionen spricht, ohne neue Schulungsdaten hinzuzufügen. Stimmen mit mehreren Stilen eignen sich für Videospielfiguren, Konversations-Chatbots, Hörbücher, Inhaltslesemodule und mehr.

Um eine Stimme mit mehreren Stilen zu erstellen, müssen Sie allgemeine Trainingsdaten vorbereiten, die mindestens 300 Äußerungen umfassen. Wählen Sie mindestens einen voreingestellten Zielsprechstil aus. Sie können auch mehrere benutzerdefinierte Stile erstellen, indem Sie für dieselbe Stimme Stilbeispiele mit mindestens 100 Äußerungen pro Stil als zusätzliche Trainingsdaten bereitstellen. Die unterstützten voreingestellten Stile variieren je nach Sprache. Weitere Informationen finden Sie unter Verfügbare voreingestellte Stile für verschiedene Sprachen.

Neural – mehrsprachig (Vorschau): Erstellen Sie mit Trainingsdaten in einer Sprache eine Stimme, die mehrere Sprachen spricht. Beispielsweise können Sie mit den

en-USprimären Schulungsdaten eine Stimme erstellen, die inen-US,de-DE,zh-CNusw. sekundären Sprachen spricht.Die primäre Sprache der Schulungsdaten und der sekundären Sprachen muss sich in den Sprachen befinden, die für mehrsprachige Sprachschulungen unterstützt werden . Sie müssen keine Schulungsdaten in den sekundären Sprachen vorbereiten.

Die Sprache der Trainingsdaten muss zu den unterstützten Sprachen für das Training zählen, das benutzerdefinierte Stimmen betrifft, sprachübergreifend ist oder mehrere Stile umfasst.

Trainieren Ihres benutzerdefinierten Stimmmodells

Führen Sie die folgenden Schritte aus, um eine benutzerdefinierte Stimme im Azure AI Foundry-Portal zu erstellen:

- Neuronal

- Neuronal – sprachübergreifend

- Neuronal – mehrformatig

- Neural - mehrsprachig (Vorschau)

- Neural - HD Voice (Vorschau)

Melden Sie sich beim Azure AI Foundry-Portal an.

Wählen Sie Feinabstimmung im linken Bereich und dann KI Service Feinabstimmung aus.

Wählen Sie die professionelle Sprach-Feinabstimmungsaufgabe (nach Modellname) aus, die Sie gestartet haben, wie im Artikel zur Erstellung professioneller Stimmen beschrieben.

Wählen Sie Train model>+ Train aus.

Wählen Sie Neural als Trainingsmethode für Ihr Modell aus. Um eine andere Trainingsmethode zu verwenden, siehe Neural - sprachenübergreifend, Neural - Mehrstil, Neural - mehrsprachig (Vorschau) oder Neural - HD Voice (Vorschau).

Wählen Sie eine Version des Trainingsrezepts für Ihr Modell aus. Die neueste Version ist standardmäßig ausgewählt. Die unterstützten Features und die Trainingszeit können sich je nach Version unterscheiden. Normalerweise wird die aktuelle Version empfohlen. In einigen Fällen können Sie eine frühere Version auswählen, um die Trainingsdauer zu verkürzen. Weitere Informationen zu zweisprachigem Training und zu Unterschieden zwischen Gebietsschemas finden Sie unter Zweisprachiges Training.

Wählen Sie Weiter aus.

Wählen Sie die Daten aus, die Sie für das Training verwenden möchten. Doppelte Audionamen werden aus dem Training entfernt. Stellen Sie sicher, dass die ausgewählten Daten nicht die gleichen Audionamen in mehreren ZIP-Dateien enthalten.

Sie können für das Training nur erfolgreich verarbeitete Datasets auswählen. Überprüfen Sie den Datenverarbeitungsstatus, wenn Ihr Trainingssatz nicht in der Liste angezeigt wird.

Wählen Sie eine Sprecherdatei mit der Darbietung Ihres Sprechers aus, die dem Sprecher in Ihren Trainingsdaten entspricht.

Wählen Sie Weiter aus.

Wählen Sie ein Testskript und dann "Weiter" aus.

- Bei jedem Training werden automatisch 100 Beispielaudiodateien generiert, damit Sie das Modell mit einem Standardskript testen können.

- Alternativ können Sie "Eigenes Testskript hinzufügen " auswählen und Ihr eigenes Testskript mit bis zu 100 Äußerungen bereitstellen, um das Modell ohne zusätzliche Kosten zu testen. Die generierten Audiodateien sind eine Kombination aus den automatischen Testskripts und benutzerdefinierten Testskripts. Weitere Informationen finden Sie unter Testskriptanforderungen.

Geben Sie einen VoIP-Modellnamen ein. Wählen Sie den Namen sorgfältig aus. Der Modellname wird als Name der Stimme für Ihre Sprachsyntheseanforderung in der SDK- und SSML-Eingabe verwendet. Zulässig sind nur Buchstaben, Zahlen und einige wenige Satzzeichen. Verwenden Sie unterschiedliche Namen für unterschiedliche neuronale Stimmmodelle.

Geben Sie optional die Beschreibung ein, um das Modell leichter identifizieren zu können. Eine gängige Nutzung der Beschreibung besteht darin, die Namen der Daten festzuhalten, die Sie zum Erstellen des Modells verwendet haben.

Aktivieren Sie das Kontrollkästchen, um die Nutzungsbedingungen zu akzeptieren, und wählen Sie dann "Weiter" aus.

Überprüfen Sie die Einstellungen, und aktivieren Sie das Kontrollkästchen, um die Nutzungsbedingungen zu akzeptieren.

Wählen Sie Trainieren, um mit dem Training des Modells zu beginnen.

Zweisprachiges Training

Wenn Sie den Trainingstyp Neuronal auswählen, können Sie eine Stimme darauf trainieren, in mehreren Sprachen zu sprechen. Die Gebietsschemas zh-CN, zh-HK und zh-TW unterstützen das zweisprachige Training, sodass die Stimme sowohl Chinesisch als auch Englisch sprechen kann. Teilweise in Abhängigkeit von den Trainingsdaten kann die synthetisierte Stimme Englisch mit einem nativen englischen Akzent oder Englisch mit demselben Akzent wie die Trainingsdaten sprechen.

Hinweis

Damit eine Stimme im zh-CN Gebietsschema Englisch mit demselben Akzent wie die Beispieldaten spricht, sollten Sie englische Daten in einen Kontextbezogenen Schulungssatz hochladen oder wählen Chinese (Mandarin, Simplified), English bilingual, wenn Sie ein Projekt erstellen oder das zh-CN (English bilingual) Gebietsschema für die Schulungssatzdaten über die REST-API angeben.

Schließen Sie in Ihrem Kontextschulungssatz mindestens 100 Sätze oder 10 Minuten englischer Inhalte ein, und überschreiten Sie nicht die Menge der chinesischen Inhalte.

Die folgende Tabelle enthält die Unterschiede zwischen den Gebietsschemas:

| Speech Studio-Gebietsschema | REST-API-Gebietsschema | Unterstützung für zweisprachige Vorgänge |

|---|---|---|

Chinese (Mandarin, Simplified) |

zh-CN |

Wenn Ihre Beispieldaten Englisch enthalten, spricht die synthetisierte Stimme Englisch mit einem nativen englischen Akzent anstelle desselben Akzents wie die Beispieldaten, unabhängig von der Menge der englischen Daten. |

Chinese (Mandarin, Simplified), English bilingual |

zh-CN (English bilingual) |

Wenn die synthetisierte Stimme Englisch mit demselben Akzent wie in den Beispieldaten sprechen soll, wird empfohlen, mehr als 10 % Daten in englischer Sprache in Ihren Trainingssatz einzuschließen. Andernfalls fällt der englische Sprachakzent möglicherweise nicht ideal aus. |

Chinese (Cantonese, Simplified) |

zh-HK |

Wenn Sie eine synthetisierte Stimme trainieren möchten, die Englisch mit demselben Akzent wie in Ihren Beispieldaten sprechen kann, stellen Sie sicher, mehr als 10 % Daten in englischer Sprache in Ihrem Trainingssatz bereitstellen. Andernfalls wird standardmäßig ein nativer englischer Akzent verwendet. Der Schwellenwert von 10 % wird basierend auf den Daten berechnet, die nach dem erfolgreichen Hochladen akzeptiert werden, nicht auf den Daten vor dem Hochladen. Wenn einige hochgeladene Daten in englischer Sprache aufgrund von Fehlern abgelehnt werden und der Schwellenwert von 10 % nicht erfüllt wird, erhält die synthetisierte Stimme standardmäßig einen nativen englischen Akzent. |

Chinese (Taiwanese Mandarin, Traditional) |

zh-TW |

Wenn Sie eine synthetisierte Stimme trainieren möchten, die Englisch mit demselben Akzent wie in Ihren Beispieldaten sprechen kann, stellen Sie sicher, mehr als 10 % Daten in englischer Sprache in Ihrem Trainingssatz bereitstellen. Andernfalls wird standardmäßig ein nativer englischer Akzent verwendet. Der Schwellenwert von 10 % wird basierend auf den Daten berechnet, die nach dem erfolgreichen Hochladen akzeptiert werden, nicht auf den Daten vor dem Hochladen. Wenn einige hochgeladene Daten in englischer Sprache aufgrund von Fehlern abgelehnt werden und der Schwellenwert von 10 % nicht erfüllt wird, erhält die synthetisierte Stimme standardmäßig einen nativen englischen Akzent. |

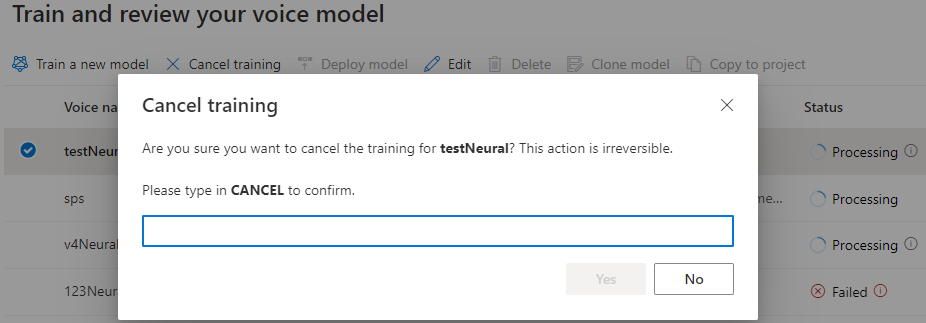

Überwachen des Schulungsvorgangs

In der Tabelle Modell trainieren wird ein neuer Eintrag angezeigt, der diesem neu erstellten Modell entspricht. Der Status gibt Aufschluss über den Fortschritt bei der Konvertierung Ihrer Daten in ein Stimmmodell, wie in dieser Tabelle beschrieben:

| Staat | Bedeutung |

|---|---|

| Verarbeitung | Ihr Stimmmodell wird erstellt. |

| Erfolgreich | Ihr Stimmmodell wurde erstellt und kann bereitgestellt werden. |

| Fehler | Beim Trainieren Ihres Stimmmodells ist ein Fehler aufgetreten. Die Ursache für den Fehler liegt möglicherweise in unerkannten Daten- oder Netzwerkproblemen. |

| Abgesagt | Das Training Ihres Stimmmodells wurde abgebrochen. |

Während der Modellstatus "Verarbeiten" lautet, können Sie das Modell auswählen und dann " Schulung abbrechen" auswählen, um die Schulung abzubrechen. Dieses abgebrochene Training wird Ihnen nicht in Rechnung gestellt.

Nachdem Sie das Training des Modells erfolgreich abgeschlossen haben, können Sie die Modelldetails überprüfen und Ihr Stimmmodell testen.

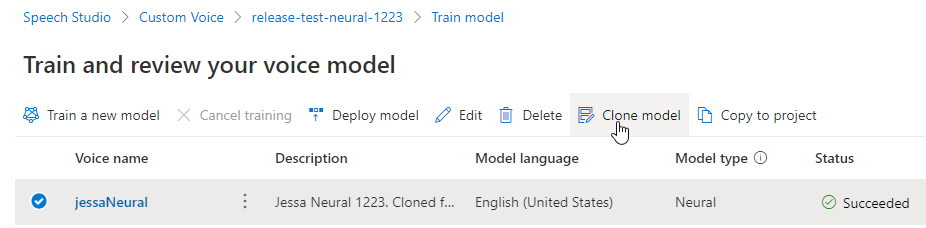

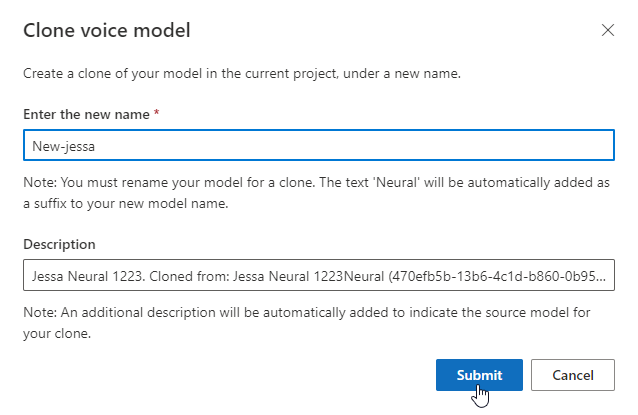

Umbenennen des Modells

Sie müssen Ihr Modell klonen, um es umzubenennen. Sie können das Modell nicht direkt umbenennen.

- Wählen Sie das Modell aus.

- Wählen Sie das Klonmodell aus, um einen Klon des Modells mit einem neuen Namen im aktuellen Projekt zu erstellen.

- Geben Sie den neuen Namen im Fenster " Clone Voice model " ein.

- Wählen Sie "Absenden" aus. Der Text Neuronal wird dem neuen Modellnamen automatisch als Suffix hinzugefügt.

Testen Ihres Stimmmodells

Nach der erfolgreichen Erstellung des Stimmmodells können Sie die generierten Beispielaudiodateien verwenden, um es vor der Bereitstellung zu testen.

Hinweis

Neural - mehrsprachige (Vorschau) und Neural - HD Voice (Vorschau) unterstützen diese Art von Tests nicht.

Die Qualität des Stimmmodells basiert auf zahlreichen Faktoren, wie etwa:

- der Größe der Trainingsdaten

- der Qualität der Aufzeichnung

- der Genauigkeit der Transkriptdatei

- der Eignung der aufgezeichneten Stimme in den Trainingsdaten für die gewünschte Persönlichkeit der Stimme im jeweiligen Anwendungsfall

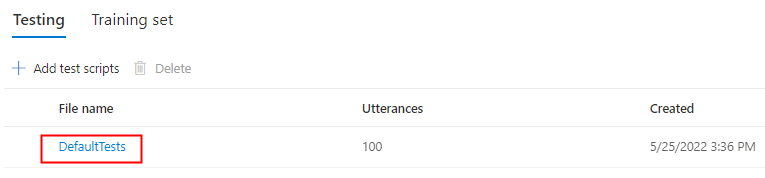

Wählen Sie DefaultTests unter Testen aus, um sich die Beispielaudiodateien anzuhören. Die Standardtestbeispiele umfassen 100 Beispielaudiodateien, die während des Trainings automatisch generiert werden, um Sie beim Testen des Modells zu unterstützen. Zusätzlich zu diesen standardmäßig bereitgestellten 100 Audioclips werden die Äußerungen in Ihrem eigenen Testskript ebenfalls der Gruppe DefaultTests hinzugefügt. Dieser Zusatz umfasst höchstens 100 Äußerungen. Tests mit DefaultTests werden Ihnen nicht in Rechnung gestellt.

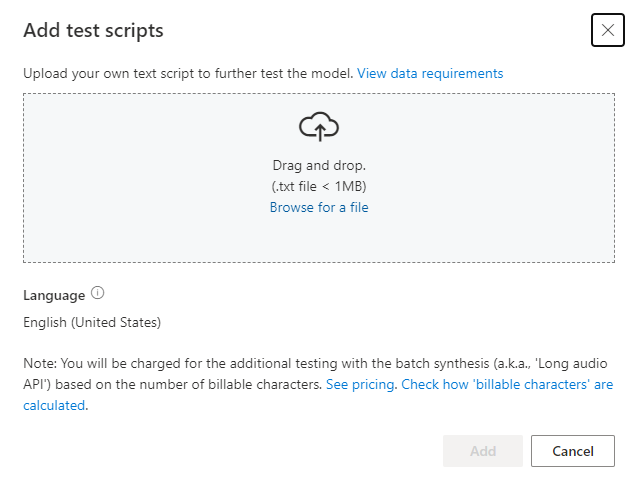

Wenn Sie eigene Testskripts hochladen möchten, um Ihr Modell weiter zu testen, wählen Sie Testskripts hinzufügen aus, um ihr eigenes Testskript hochzuladen.

Überprüfen Sie vor dem Hochladen des Testskripts die Testskriptanforderungen. Die zusätzlichen Tests mit der Batchsynthese werden Ihnen auf der Grundlage der Anzahl der abrechenbaren Zeichen in Rechnung gestellt. Weitere Informationen finden Sie unter Preise für Azure KI Speech.

Wählen Sie unter Testskripts hinzufügen die Option Nach einer Datei suchen aus, um Ihr eigenes Skript auszuwählen, und wählen Sie dann Hinzufügen aus, um es hochzuladen.

Testen von Skriptanforderungen

Das Testskript muss eine TXT-Datei und kleiner als 1 MB sein. Unterstützte Codierungsformate sind z. B. ANSI/ASCII, UTF-8, UTF-8-BOM, UTF-16-LE oder UTF-16-BE.

Im Gegensatz zu den Trainingstranskriptionsdateien sollte das Testskript keine Äußerungs-IDs enthalten. Dabei handelt es sich um die Dateinamen der einzelnen Äußerungen. Andernfalls werden die IDs ausgesprochen.

Hier sehen Sie ein Beispiel für Äußerungen in einer TXT-Datei:

This is the waistline, and it's falling.

We have trouble scoring.

It was Janet Maslin.

Jeder Absatz der Äußerung ergibt eine separate Audiodatei. Wenn Sie alle Sätze in einer Audiodatei kombinieren möchten, fügen Sie sie in einem einzigen Absatz zusammen.

Hinweis

Die generierten Audiodateien sind eine Kombination aus den automatischen Testskripts und benutzerdefinierten Testskripts.

Aktualisieren der Modulversion für Ihr Stimmmodell

Sprachsynthese-Engines von Azure werden regelmäßig aktualisiert, um das neueste Sprachmodell zu erfassen, das die Aussprache der Sprache definiert. Nachdem Sie Ihre Stimme trainiert haben, können Sie sie auf das neue Sprachmodell anwenden, indem Sie auf die neueste Engine-Version aktualisieren.

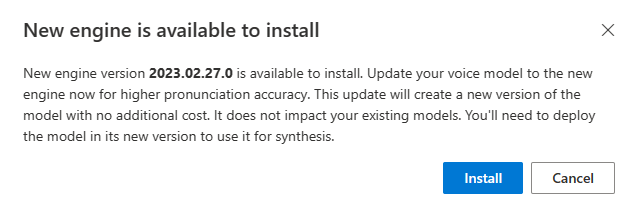

- Wenn ein neues Modul verfügbar ist, werden Sie aufgefordert, Ihr neuronales Stimmmodell zu aktualisieren.

- Wechseln Sie zur Modelldetailseite, und befolgen Sie die Anweisungen auf dem Bildschirm, um die neueste Engine zu installieren.

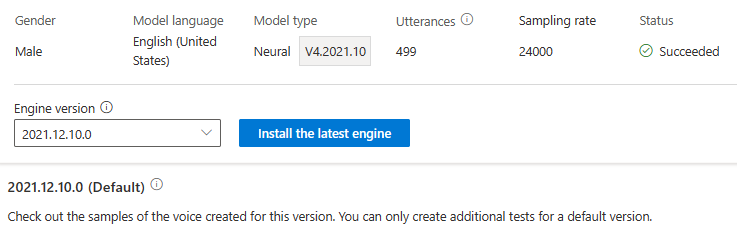

- Wählen Sie alternativ später Installieren des aktuellen Moduls aus, um Ihr Modell auf die neueste Version der Engine zu aktualisieren. Das Modulupdate wird Ihnen nicht berechnet. Die vorherigen Versionen bleiben weiterhin erhalten.

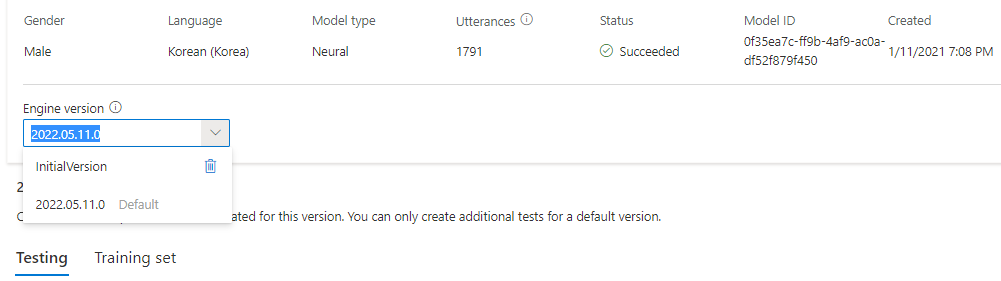

- Sie können alle Engine-Versionen für das Modell in der Dropdownliste Modulversion aktivieren oder eine entfernen, wenn Sie sie nicht mehr benötigen.

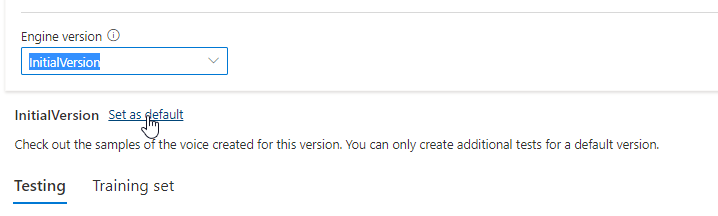

Die aktualisierte Version wird automatisch als Standard festgelegt. Sie können die Standardversion jedoch ändern, indem Sie eine Version aus der Dropdownliste und dann Als Standard festlegen auswählen.

Wenn Sie jede Engine-Version Ihres Stimmmodells testen möchten, können Sie eine Version in der Liste und dann DefaultTests unter Testen auswählen, um sich die Beispielaudiodateien anzuhören. Wenn Sie Ihre eigenen Testskripts hochladen möchten, um die aktuelle Engine-Version weiter zu testen, stellen Sie zunächst sicher, dass die Version als Standard festgelegt ist, und führen Sie dann die Schritte unter Testen Ihres Stimmmodells aus.

Beim Aktualisieren der Engine wird ohne zusätzliche Kosten eine neue Version des Modells erstellt. Nachdem Sie die Engine-Version für Ihr Sprachmodell aktualisiert haben, müssen Sie die neue Version bereitstellen, um einen neuen Endpunkt zu erstellen. Sie können nur die Standardversion bereitstellen.

Wenn Sie einen neuen Endpunkt erstellt haben, müssen Sie den Datenverkehr an den neuen Endpunkt in Ihrem Produkt übertragen.

Weitere Informationen zu den Funktionen und Grenzwerten dieses Features sowie zu den bewährten Methoden zur Verbesserung der Modellqualität finden Sie unter "Merkmale und Einschränkungen für die Verwendung von benutzerdefinierter Sprache".

Kopieren Ihres Stimmmodells in ein anderes Projekt

Hinweis

In diesem Zusammenhang bezieht sich "Projekt" auf einen Feinabstimmungsvorgang und nicht auf ein Azure AI Foundry-Projekt.

Nach dem Training können Sie Ihr VoIP-Modell in ein anderes Projekt für dieselbe Region oder eine andere Region kopieren.

Zum Beispiel können Sie ein professionelles Sprachmodell, das in einer Region trainiert wurde, in ein Projekt für eine andere Region kopieren. Professionelle Sprachoptimierung ist derzeit nur in einigen Regionen verfügbar.

So kopieren Sie Ihr benutzerdefiniertes VoIP-Modell in ein anderes Projekt:

- Wählen Sie auf der Registerkarte Modell trainieren ein Stimmmodell aus, das Sie kopieren möchten, und klicken Sie dann auf In Projekt kopieren.

- Wählen Sie die Ressource Abonnement, Zielregion, Connected KI Service (KI Foundry-Ressource) und Ziel-Feinabstimmungsvorgang aus, in den Sie das Modell kopieren möchten.

- Wählen Sie "Kopieren" aus, um das Modell zu kopieren.

- Wählen Sie unterhalb der Benachrichtigung zum erfolgreichen Kopiervorgang Modell anzeigen aus.

Navigieren Sie zu dem Projekt, in das Sie das Modell kopiert haben, um die Modellkopie bereitzustellen.

Nächste Schritte

In diesem Artikel erfahren Sie, wie Sie eine professionelle Stimme über das Speech Studio-Portal optimieren.

Wichtig

Professionelle Sprachoptimierung ist derzeit nur in einigen Regionen verfügbar. Nachdem Ihr Sprachmodell in einer unterstützten Region trainiert wurde, können Sie es nach Bedarf in eine AI Foundry-Ressource für Sprache in einer anderen Region kopieren. Weitere Informationen finden Sie in den Fußnoten in der Tabelle für Azure Cognitive Service für Speech.

Die Trainingsdauer hängt von der Menge der verwendeten Daten ab. Es dauert etwa 40 Rechenstunden im Durchschnitt, um eine professionelle Stimme zu optimieren. Benutzer mit einem Standard-Abonnement (S0) können vier Stimmen gleichzeitig trainieren. Wenn das Limit erreicht wurde, warten Sie, bis der Trainingsvorgang mindestens eines Stimmmodells beendet wurde, und versuchen Sie es dann noch mal.

Hinweis

Zwar unterscheidet sich die Gesamtanzahl der benötigten Stunden je nach Trainingsmethode, doch gilt für alle der gleiche Preis pro Einheit. Weitere Informationen finden Sie unter Preisdetails zum benutzerdefinierten neuronalen Training.

Auswählen einer Trainingsmethode

Nachdem Sie Ihre Datendateien überprüft haben, verwenden Sie sie, um Ihr benutzerdefiniertes VoIP-Modell zu erstellen. Wenn Sie eine benutzerdefinierte Stimme erstellen, können Sie diese mit einer der folgenden Methoden trainieren:

Neuronal: Erstellen einer Stimme in der Sprache Ihrer Trainingsdaten.

Neuronal - sprachübergreifend: Erstellen Sie eine Stimme, die eine andere Sprache spricht als Ihre Trainingsdaten. Beispielsweise können Sie mit den

zh-CNTrainingsdaten eine Stimme erstellen, dieen-USspricht.Die Sprache der Trainingsdaten und die Zielsprache müssen beide zu den Sprachen zählen, für die sprachübergreifendes Stimmtraining unterstützt wird. Sie brauchen keine Trainingsdaten in der Zielsprache vorzubereiten, aber Ihr Testskript muss in der Zielsprache abgefasst sein.

Neural - Multistil: Erstellen Sie eine benutzerdefinierte Stimme, die in mehreren Stilen und Emotionen spricht, ohne neue Schulungsdaten hinzuzufügen. Stimmen mit mehreren Stilen eignen sich für Videospielfiguren, Konversations-Chatbots, Hörbücher, Inhaltslesemodule und mehr.

Um eine Stimme mit mehreren Stilen zu erstellen, müssen Sie allgemeine Trainingsdaten vorbereiten, die mindestens 300 Äußerungen umfassen. Wählen Sie mindestens einen voreingestellten Zielsprechstil aus. Sie können auch mehrere benutzerdefinierte Stile erstellen, indem Sie für dieselbe Stimme Stilbeispiele mit mindestens 100 Äußerungen pro Stil als zusätzliche Trainingsdaten bereitstellen. Die unterstützten voreingestellten Stile variieren je nach Sprache. Weitere Informationen finden Sie unter Verfügbare voreingestellte Stile für verschiedene Sprachen.

Neural – mehrsprachig (Vorschau): Erstellen Sie mit Trainingsdaten in einer Sprache eine Stimme, die mehrere Sprachen spricht. Beispielsweise können Sie mit den

en-USprimären Schulungsdaten eine Stimme erstellen, die inen-US,de-DE,zh-CNusw. sekundären Sprachen spricht.Die primäre Sprache der Schulungsdaten und der sekundären Sprachen muss sich in den Sprachen befinden, die für mehrsprachige Sprachschulungen unterstützt werden . Sie müssen keine Schulungsdaten in den sekundären Sprachen vorbereiten.

Neural - HD Voice (Vorschau):Erstellen Sie eine HD-Stimme in derselben Sprache Ihrer Schulungsdaten. Azure neurale HD-Stimmen beruhen auf LLM-Technologie und sind für dynamische Unterhaltungen optimiert. Erfahren Sie hier mehr über neurale HD-Stimmen.

Die Sprache der Trainingsdaten muss zu den unterstützten Sprachen für das Training zählen, das benutzerdefinierte Stimmen betrifft, sprachübergreifend ist oder mehrere Stile umfasst.

Trainieren Ihres benutzerdefinierten Stimmmodells

Führen Sie zum Erstellen einer benutzerdefinierten Stimme in Speech Studio die folgenden Schritte für eine der folgenden Methoden aus:

- Neuronal

- Neuronal – sprachübergreifend

- Neuronal – mehrformatig

- Neural - mehrsprachig (Vorschau)

- Neural - HD Voice (Vorschau)

Melden Sie sich in Speech Studio an.

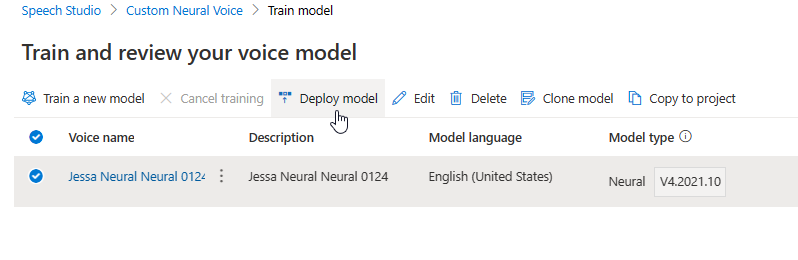

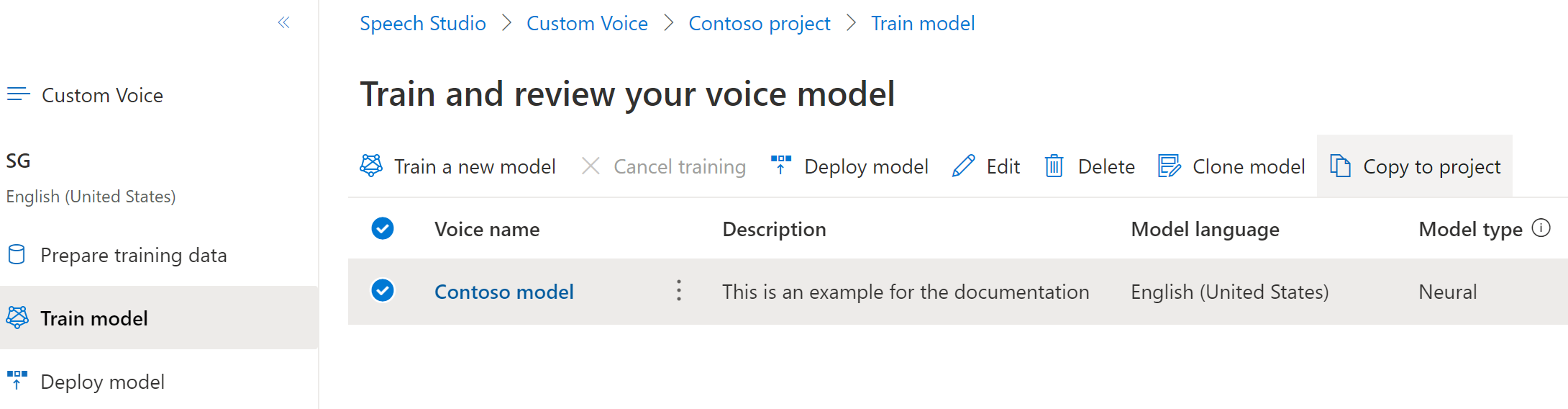

Wählen Sie Custom Voice><Name Ihres Projekts>>Trainingsmodell>Neues Modell trainieren aus.

Wählen Sie Neuronal als Trainingsmethode für Ihr Modell aus, und wählen Sie dann Weiter aus. Wenn Sie eine andere Trainingsmethode verwenden möchten, lesen Sie Neural - cross-lingual oder Neural - Multi-Style oder Neural - Multi lingual (Vorschau) oder Neural - HD Voice (Vorschau).

Wählen Sie eine Version des Trainingsrezepts für Ihr Modell aus. Die neueste Version ist standardmäßig ausgewählt. Die unterstützten Features und die Trainingszeit können sich je nach Version unterscheiden. Normalerweise wird die aktuelle Version empfohlen. In einigen Fällen können Sie eine frühere Version auswählen, um die Trainingsdauer zu verkürzen. Weitere Informationen zu zweisprachigem Training und zu Unterschieden zwischen Gebietsschemas finden Sie unter Zweisprachiges Training.

Hinweis

Modellversionen

V3.0V7.0undV8.0werden bis zum 25. Juli 2025 eingestellt. Die Sprachmodelle, die bereits für diese eingestellten Versionen erstellt wurden, sind nicht betroffen.Wählen Sie die Daten aus, die Sie für das Training verwenden möchten. Doppelte Audionamen werden aus dem Training entfernt. Stellen Sie sicher, dass die ausgewählten Daten nicht die gleichen Audionamen in mehreren ZIP-Dateien enthalten.

Sie können für das Training nur erfolgreich verarbeitete Datasets auswählen. Überprüfen Sie den Datenverarbeitungsstatus, wenn Ihr Trainingssatz nicht in der Liste angezeigt wird.

Wählen Sie eine Sprecherdatei mit der Darbietung Ihres Sprechers aus, die dem Sprecher in Ihren Trainingsdaten entspricht.

Wählen Sie Weiter aus.

Bei jedem Training werden automatisch 100 Beispielaudiodateien generiert, damit Sie das Modell mit einem Standardskript testen können.

Optional können Sie auch Eigenes Testskript hinzufügen aktivieren und Ihr eigenes Testskript mit bis zu 100 Äußerungen bereitstellen, um das Modell ohne zusätzliche Kosten zu testen. Die generierten Audiodateien sind eine Kombination aus den automatischen Testskripts und benutzerdefinierten Testskripts. Weitere Informationen finden Sie unter Testskriptanforderungen.

Geben Sie einen Namen ein, um das Modell zu identifizieren. Wählen Sie den Namen sorgfältig aus. Der Modellname wird als Name der Stimme für Ihre Sprachsyntheseanforderung in der SDK- und SSML-Eingabe verwendet. Zulässig sind nur Buchstaben, Zahlen und einige wenige Satzzeichen. Verwenden Sie unterschiedliche Namen für unterschiedliche neuronale Stimmmodelle.

Geben Sie optional die Beschreibung ein, um das Modell leichter identifizieren zu können. Eine gängige Nutzung der Beschreibung besteht darin, die Namen der Daten festzuhalten, die Sie zum Erstellen des Modells verwendet haben.

Wählen Sie Weiter aus.

Überprüfen Sie die Einstellungen, und aktivieren Sie das Kontrollkästchen, um die Nutzungsbedingungen zu akzeptieren.

Wählen Sie Übermitteln aus, um mit dem Trainieren des Modells zu beginnen.

Zweisprachiges Training

Wenn Sie den Trainingstyp Neuronal auswählen, können Sie eine Stimme darauf trainieren, in mehreren Sprachen zu sprechen. Die Gebietsschemas zh-CN, zh-HK und zh-TW unterstützen das zweisprachige Training, sodass die Stimme sowohl Chinesisch als auch Englisch sprechen kann. Teilweise in Abhängigkeit von den Trainingsdaten kann die synthetisierte Stimme Englisch mit einem nativen englischen Akzent oder Englisch mit demselben Akzent wie die Trainingsdaten sprechen.

Hinweis

Damit eine Stimme im zh-CN Gebietsschema Englisch mit demselben Akzent wie die Beispieldaten spricht, sollten Sie englische Daten in einen Kontextbezogenen Schulungssatz hochladen oder wählen Chinese (Mandarin, Simplified), English bilingual, wenn Sie ein Projekt erstellen oder das zh-CN (English bilingual) Gebietsschema für die Schulungssatzdaten über die REST-API angeben.

Schließen Sie in Ihrem Kontextschulungssatz mindestens 100 Sätze oder 10 Minuten englischer Inhalte ein, und überschreiten Sie nicht die Menge der chinesischen Inhalte.

Die folgende Tabelle enthält die Unterschiede zwischen den Gebietsschemas:

| Speech Studio-Gebietsschema | REST-API-Gebietsschema | Unterstützung für zweisprachige Vorgänge |

|---|---|---|

Chinese (Mandarin, Simplified) |

zh-CN |

Wenn Ihre Beispieldaten Englisch enthalten, spricht die synthetisierte Stimme Englisch mit einem nativen englischen Akzent anstelle desselben Akzents wie die Beispieldaten, unabhängig von der Menge der englischen Daten. |

Chinese (Mandarin, Simplified), English bilingual |

zh-CN (English bilingual) |

Wenn die synthetisierte Stimme Englisch mit demselben Akzent wie in den Beispieldaten sprechen soll, wird empfohlen, mehr als 10 % Daten in englischer Sprache in Ihren Trainingssatz einzuschließen. Andernfalls fällt der englische Sprachakzent möglicherweise nicht ideal aus. |

Chinese (Cantonese, Simplified) |

zh-HK |

Wenn Sie eine synthetisierte Stimme trainieren möchten, die Englisch mit demselben Akzent wie in Ihren Beispieldaten sprechen kann, stellen Sie sicher, mehr als 10 % Daten in englischer Sprache in Ihrem Trainingssatz bereitstellen. Andernfalls wird standardmäßig ein nativer englischer Akzent verwendet. Der Schwellenwert von 10 % wird basierend auf den Daten berechnet, die nach dem erfolgreichen Hochladen akzeptiert werden, nicht auf den Daten vor dem Hochladen. Wenn einige hochgeladene Daten in englischer Sprache aufgrund von Fehlern abgelehnt werden und der Schwellenwert von 10 % nicht erfüllt wird, erhält die synthetisierte Stimme standardmäßig einen nativen englischen Akzent. |

Chinese (Taiwanese Mandarin, Traditional) |

zh-TW |

Wenn Sie eine synthetisierte Stimme trainieren möchten, die Englisch mit demselben Akzent wie in Ihren Beispieldaten sprechen kann, stellen Sie sicher, mehr als 10 % Daten in englischer Sprache in Ihrem Trainingssatz bereitstellen. Andernfalls wird standardmäßig ein nativer englischer Akzent verwendet. Der Schwellenwert von 10 % wird basierend auf den Daten berechnet, die nach dem erfolgreichen Hochladen akzeptiert werden, nicht auf den Daten vor dem Hochladen. Wenn einige hochgeladene Daten in englischer Sprache aufgrund von Fehlern abgelehnt werden und der Schwellenwert von 10 % nicht erfüllt wird, erhält die synthetisierte Stimme standardmäßig einen nativen englischen Akzent. |

Überwachen des Schulungsvorgangs

In der Tabelle Modell trainieren wird ein neuer Eintrag angezeigt, der diesem neu erstellten Modell entspricht. Der Status gibt Aufschluss über den Fortschritt bei der Konvertierung Ihrer Daten in ein Stimmmodell, wie in dieser Tabelle beschrieben:

| Staat | Bedeutung |

|---|---|

| Verarbeitung | Ihr Stimmmodell wird erstellt. |

| Erfolgreich | Ihr Stimmmodell wurde erstellt und kann bereitgestellt werden. |

| Fehler | Beim Trainieren Ihres Stimmmodells ist ein Fehler aufgetreten. Die Ursache für den Fehler liegt möglicherweise in unerkannten Daten- oder Netzwerkproblemen. |

| Abgesagt | Das Training Ihres Stimmmodells wurde abgebrochen. |

Solange der Modellstatus In Bearbeitung ist, können Sie Training abbrechen auswählen, um das Training Ihres Stimmmodells abzubrechen. Dieses abgebrochene Training wird Ihnen nicht in Rechnung gestellt.

Nachdem Sie das Training des Modells erfolgreich abgeschlossen haben, können Sie die Modelldetails überprüfen und Ihr Stimmmodell testen.

Sie können das Tool Audioinhaltserstellung in Speech Studio verwenden, um Audioclips zu erstellen und Ihre bereitgestellte Stimme zu optimieren. Wenn dies für Ihre Stimme zutrifft, können Sie einen von mehreren Stilen auswählen.

Umbenennen des Modells

Wenn Sie das erstellte Modell umbenennen möchten, wählen Sie Modell klonen aus, um im aktuellen Projekt einen Klon des Modells mit einem anderen Namen zu erstellen.

Geben Sie im Fenster Stimmmodell klonen den neuen Namen ein, und klicken Sie dann auf Übermitteln. Der Text Neuronal wird dem neuen Modellnamen automatisch als Suffix hinzugefügt.

Testen Ihres Stimmmodells

Nach der erfolgreichen Erstellung des Stimmmodells können Sie die generierten Beispielaudiodateien verwenden, um es vor der Bereitstellung zu testen.

Hinweis

Neural - mehrsprachige (Vorschau) und Neural - HD Voice (Vorschau) unterstützen diese Art von Tests nicht.

Die Qualität des Stimmmodells basiert auf zahlreichen Faktoren, wie etwa:

- der Größe der Trainingsdaten

- der Qualität der Aufzeichnung

- der Genauigkeit der Transkriptdatei

- der Eignung der aufgezeichneten Stimme in den Trainingsdaten für die gewünschte Persönlichkeit der Stimme im jeweiligen Anwendungsfall

Wählen Sie DefaultTests unter Testen aus, um sich die Beispielaudiodateien anzuhören. Die Standardtestbeispiele umfassen 100 Beispielaudiodateien, die während des Trainings automatisch generiert werden, um Sie beim Testen des Modells zu unterstützen. Zusätzlich zu diesen standardmäßig bereitgestellten 100 Audioclips werden die Äußerungen in Ihrem eigenen Testskript ebenfalls der Gruppe DefaultTests hinzugefügt. Dieser Zusatz umfasst höchstens 100 Äußerungen. Tests mit DefaultTests werden Ihnen nicht in Rechnung gestellt.

Wenn Sie eigene Testskripts hochladen möchten, um Ihr Modell weiter zu testen, wählen Sie Testskripts hinzufügen aus, um ihr eigenes Testskript hochzuladen.

Überprüfen Sie vor dem Hochladen des Testskripts die Testskriptanforderungen. Die zusätzlichen Tests mit der Batchsynthese werden Ihnen auf der Grundlage der Anzahl der abrechenbaren Zeichen in Rechnung gestellt. Weitere Informationen finden Sie unter Preise für Azure KI Speech.

Wählen Sie unter Testskripts hinzufügen die Option Nach einer Datei suchen aus, um Ihr eigenes Skript auszuwählen, und wählen Sie dann Hinzufügen aus, um es hochzuladen.

Testen von Skriptanforderungen

Das Testskript muss eine TXT-Datei und kleiner als 1 MB sein. Unterstützte Codierungsformate sind z. B. ANSI/ASCII, UTF-8, UTF-8-BOM, UTF-16-LE oder UTF-16-BE.

Im Gegensatz zu den Trainingstranskriptionsdateien sollte das Testskript keine Äußerungs-IDs enthalten. Dabei handelt es sich um die Dateinamen der einzelnen Äußerungen. Andernfalls werden die IDs ausgesprochen.

Hier sehen Sie ein Beispiel für Äußerungen in einer TXT-Datei:

This is the waistline, and it's falling.

We have trouble scoring.

It was Janet Maslin.

Jeder Absatz der Äußerung ergibt eine separate Audiodatei. Wenn Sie alle Sätze in einer Audiodatei kombinieren möchten, fügen Sie sie in einem einzigen Absatz zusammen.

Hinweis

Die generierten Audiodateien sind eine Kombination aus den automatischen Testskripts und benutzerdefinierten Testskripts.

Aktualisieren der Modulversion für Ihr Stimmmodell

Sprachsynthese-Engines von Azure werden regelmäßig aktualisiert, um das neueste Sprachmodell zu erfassen, das die Aussprache der Sprache definiert. Nachdem Sie Ihre Stimme trainiert haben, können Sie sie auf das neue Sprachmodell anwenden, indem Sie auf die neueste Engine-Version aktualisieren.

Wenn ein neues Modul verfügbar ist, werden Sie aufgefordert, Ihr neuronales Stimmmodell zu aktualisieren.

Wechseln Sie zur Modelldetailseite, und befolgen Sie die Anweisungen auf dem Bildschirm, um die neueste Engine zu installieren.

Wählen Sie alternativ später Installieren des aktuellen Moduls aus, um Ihr Modell auf die neueste Version der Engine zu aktualisieren.

Das Modulupdate wird Ihnen nicht berechnet. Die vorherigen Versionen bleiben weiterhin erhalten.

Sie können alle Engine-Versionen für das Modell in der Dropdownliste Modulversion aktivieren oder eine entfernen, wenn Sie sie nicht mehr benötigen.

Die aktualisierte Version wird automatisch als Standard festgelegt. Sie können die Standardversion jedoch ändern, indem Sie eine Version aus der Dropdownliste und dann Als Standard festlegen auswählen.

Wenn Sie jede Engine-Version Ihres Stimmmodells testen möchten, können Sie eine Version in der Liste und dann DefaultTests unter Testen auswählen, um sich die Beispielaudiodateien anzuhören. Wenn Sie Ihre eigenen Testskripts hochladen möchten, um die aktuelle Engine-Version weiter zu testen, stellen Sie zunächst sicher, dass die Version als Standard festgelegt ist, und führen Sie dann die Schritte unter Testen Ihres Stimmmodells aus.

Beim Aktualisieren der Engine wird ohne zusätzliche Kosten eine neue Version des Modells erstellt. Nachdem Sie die Engine-Version für Ihr Sprachmodell aktualisiert haben, müssen Sie die neue Version bereitstellen, um einen neuen Endpunkt zu erstellen. Sie können nur die Standardversion bereitstellen.

Wenn Sie einen neuen Endpunkt erstellt haben, müssen Sie den Datenverkehr an den neuen Endpunkt in Ihrem Produkt übertragen.

Weitere Informationen zu den Funktionen und Grenzwerten dieses Features sowie zu den bewährten Methoden zur Verbesserung der Modellqualität finden Sie unter "Merkmale und Einschränkungen für die Verwendung von benutzerdefinierter Sprache".

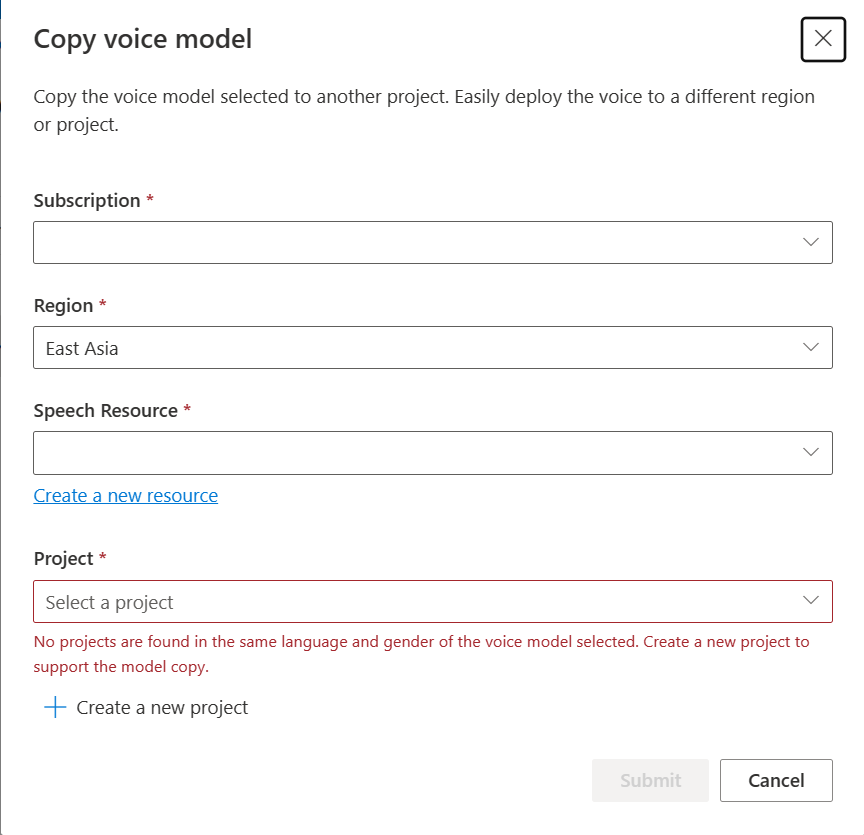

Kopieren Ihres Stimmmodells in ein anderes Projekt

Sie können Ihr Stimmmodell in ein anderes Projekt für dieselbe Region oder eine andere Region kopieren. Beispielsweise können Sie ein neuronales Stimmmodell, das in einer Region trainiert wurde, in ein Projekt für eine andere Region kopieren.

Hinweis

Professionelle Sprachoptimierung ist derzeit nur in einigen Regionen verfügbar. Sie können ein neuronales Stimmmodell aus diesen Regionen in andere Regionen kopieren. Weitere Informationen finden Sie in den Regionen für benutzerdefinierte Spracherkennung.

So kopieren Sie Ihr benutzerdefiniertes VoIP-Modell in ein anderes Projekt:

Wählen Sie auf der Registerkarte Modell trainieren ein Stimmmodell aus, das Sie kopieren möchten, und klicken Sie dann auf In Projekt kopieren.

Wählen Sie das Abonnement, die Region, die Speech-Ressource und das Projekt aus, in das Sie das Modell kopieren möchten. Sie benötigen eine Speech-Ressource und ein Projekt in der Zielregion. Gegebenenfalls müssen Sie diese Elemente zunächst erstellen.

Wählen Sie Übermitteln aus, um das Modell zu kopieren.

Wählen Sie unterhalb der Benachrichtigung zum erfolgreichen Kopiervorgang Modell anzeigen aus.

Navigieren Sie zu dem Projekt, in das Sie das Modell kopiert haben, um die Modellkopie bereitzustellen.

Nächste Schritte

In diesem Artikel erfahren Sie, wie Sie eine professionelle Stimme über die benutzerdefinierte VoIP-API optimieren.

Wichtig

Professionelle Sprachoptimierung ist derzeit nur in einigen Regionen verfügbar. Nachdem Ihr VoIP-Modell in einer unterstützten Region trainiert wurde, können Sie es nach Bedarf in eine AI Foundry-Ressource in einer anderen Region kopieren. Weitere Informationen finden Sie in den Fußnoten in der Tabelle für Azure Cognitive Service für Speech.

Die Trainingsdauer hängt von der Menge der verwendeten Daten ab. Es dauert etwa 40 Rechenstunden im Durchschnitt, um eine professionelle Stimme zu optimieren. Benutzer mit einem Standard-Abonnement (S0) können vier Stimmen gleichzeitig trainieren. Wenn das Limit erreicht wurde, warten Sie, bis der Trainingsvorgang mindestens eines Stimmmodells beendet wurde, und versuchen Sie es dann noch mal.

Hinweis

Zwar unterscheidet sich die Gesamtanzahl der benötigten Stunden je nach Trainingsmethode, doch gilt für alle der gleiche Preis pro Einheit. Weitere Informationen finden Sie unter Preisdetails zum benutzerdefinierten neuronalen Training.

Auswählen einer Trainingsmethode

Nachdem Sie Ihre Datendateien überprüft haben, verwenden Sie sie, um Ihr benutzerdefiniertes VoIP-Modell zu erstellen. Wenn Sie eine benutzerdefinierte Stimme erstellen, können Sie diese mit einer der folgenden Methoden trainieren:

Neuronal: Erstellen einer Stimme in der Sprache Ihrer Trainingsdaten.

Neuronal - sprachübergreifend: Erstellen Sie eine Stimme, die eine andere Sprache spricht als Ihre Trainingsdaten. Beispielsweise können Sie mit den

fr-FRTrainingsdaten eine Stimme erstellen, dieen-USspricht.Die Sprache der Trainingsdaten und die Zielsprache müssen beide zu den Sprachen zählen, für die sprachübergreifendes Stimmtraining unterstützt wird. Sie brauchen keine Trainingsdaten in der Zielsprache vorzubereiten, aber Ihr Testskript muss in der Zielsprache abgefasst sein.

Neural - Multistil: Erstellen Sie eine benutzerdefinierte Stimme, die in mehreren Stilen und Emotionen spricht, ohne neue Schulungsdaten hinzuzufügen. Stimmen mit mehreren Stilen eignen sich für Videospielfiguren, Konversations-Chatbots, Hörbücher, Inhaltslesemodule und mehr.

Um eine Stimme mit mehreren Stilen zu erstellen, müssen Sie allgemeine Trainingsdaten vorbereiten, die mindestens 300 Äußerungen umfassen. Wählen Sie mindestens einen voreingestellten Zielsprechstil aus. Sie können auch mehrere benutzerdefinierte Stile erstellen, indem Sie für dieselbe Stimme Stilbeispiele mit mindestens 100 Äußerungen pro Stil als zusätzliche Trainingsdaten bereitstellen. Die unterstützten voreingestellten Stile variieren je nach Sprache. Weitere Informationen finden Sie unter Verfügbare voreingestellte Stile für verschiedene Sprachen.

- Neural - HD Voice (Vorschau):Erstellen Sie eine HD-Stimme in derselben Sprache Ihrer Schulungsdaten. Azure neurale HD-Stimmen beruhen auf LLM-Technologie und sind für dynamische Unterhaltungen optimiert. Erfahren Sie hier mehr über neurale HD-Stimmen.

Die Sprache der Schulungsdaten muss eine der Sprachen sein, die für benutzerdefinierte, sprachübergreifende, mehrstilige oder HD-Sprachtrainings unterstützt werden.

Erstellen eines VoIP-Modells

- Neuronal

- Neuronal – sprachübergreifend

- Neuronal – mehrformatig

- Neural - mehrsprachig (Vorschau)

- Neural - HD Voice (Vorschau)

Um eine neuronale Stimme zu erstellen, verwenden Sie den Vorgang Models_Create der benutzerdefinierten Sprach-API. Erstellen Sie den Anforderungstext wie folgt:

- Legen Sie die erforderliche

projectId-Eigenschaft fest. Siehe Erstellen eines Projekts. - Legen Sie die erforderliche

consentId-Eigenschaft fest. Siehe VoIP-Talentzustimmung hinzufügen. - Legen Sie die erforderliche

trainingSetId-Eigenschaft fest. Siehe Erstellen eines Trainingssatzes. - Legen Sie die erforderliche

kindRezepteigenschaft fürDefaultneurale Sprachtraining fest. Die Rezeptart gibt die Trainingsmethode an und kann später nicht geändert werden. Um eine andere Trainingsmethode zu verwenden, lesen Sie Neural - cross lingual oder Neural - Multi-Style oder Neural - HD Voice (Vorschau). Weitere Informationen zu zweisprachigem Training und zu Unterschieden zwischen Gebietsschemas finden Sie unter Zweisprachiges Training. - Legen Sie die erforderliche

voiceName-Eigenschaft fest. Wählen Sie den Namen sorgfältig aus. Der Sprachename wird als Name der Stimme für Ihre Sprachsyntheseanforderung in der SDK- und SSML-Eingabe verwendet. Zulässig sind nur Buchstaben, Zahlen und einige wenige Satzzeichen. Verwenden Sie unterschiedliche Namen für unterschiedliche neuronale Stimmmodelle. - Legen Sie optional die

description-Eigenschaft für die Sprachbeschreibung fest. Die Sprachbeschreibung kann später geändert werden.

Stellen Sie eine HTTP PUT-Anforderung unter Verwendung der URI, wie im folgenden Beispiel Models_Create gezeigt.

- Ersetzen Sie

YourResourceKeydurch Ihren Speech-Ressourcenschlüssel. - Ersetzen Sie

YourResourceRegiondurch Ihre Sprachressourcenregion. - Ersetzen Sie

JessicaModelIddurch eine Modell-ID Ihrer Wahl. Die ID für Groß-/Kleinschreibung wird im URI des Modells verwendet und kann später nicht geändert werden.

curl -v -X PUT -H "Ocp-Apim-Subscription-Key: YourResourceKey" -H "Content-Type: application/json" -d '{

"voiceName": "JessicaNeural",

"description": "Jessica voice",

"recipe": {

"kind": "Default"

},

"projectId": "ProjectId",

"consentId": "JessicaConsentId",

"trainingSetId": "JessicaTrainingSetId"

} ' "https://YourResourceRegion.api.cognitive.microsoft.com/customvoice/models/JessicaModelId?api-version=2024-02-01-preview"

Sie sollten einen Antworttext im folgenden Format erhalten:

{

"id": "JessicaModelId",

"voiceName": "JessicaNeural",

"description": "Jessica voice",

"recipe": {

"kind": "Default",

"version": "V10.0"

},

"projectId": "ProjectId",

"consentId": "JessicaConsentId",

"trainingSetId": "JessicaTrainingSetId",

"locale": "en-US",

"engineVersion": "2023.07.04.0",

"status": "NotStarted",

"createdDateTime": "2023-04-01T05:30:00.000Z",

"lastActionDateTime": "2023-04-02T10:15:30.000Z"

}

Zweisprachiges Training

Wenn Sie den Trainingstyp Neuronal auswählen, können Sie eine Stimme darauf trainieren, in mehreren Sprachen zu sprechen. Die Gebietsschemas zh-CN, zh-HK und zh-TW unterstützen das zweisprachige Training, sodass die Stimme sowohl Chinesisch als auch Englisch sprechen kann. Teilweise in Abhängigkeit von den Trainingsdaten kann die synthetisierte Stimme Englisch mit einem nativen englischen Akzent oder Englisch mit demselben Akzent wie die Trainingsdaten sprechen.

Hinweis

Damit eine Stimme im zh-CN Gebietsschema Englisch mit demselben Akzent wie die Beispieldaten spricht, sollten Sie englische Daten in einen Kontextbezogenen Schulungssatz hochladen oder wählen Chinese (Mandarin, Simplified), English bilingual, wenn Sie ein Projekt erstellen oder das zh-CN (English bilingual) Gebietsschema für die Schulungssatzdaten über die REST-API angeben.

Schließen Sie in Ihrem Kontextschulungssatz mindestens 100 Sätze oder 10 Minuten englischer Inhalte ein, und überschreiten Sie nicht die Menge der chinesischen Inhalte.

Die folgende Tabelle enthält die Unterschiede zwischen den Gebietsschemas:

| Speech Studio-Gebietsschema | REST-API-Gebietsschema | Unterstützung für zweisprachige Vorgänge |

|---|---|---|

Chinese (Mandarin, Simplified) |

zh-CN |

Wenn Ihre Beispieldaten Englisch enthalten, spricht die synthetisierte Stimme Englisch mit einem nativen englischen Akzent anstelle desselben Akzents wie die Beispieldaten, unabhängig von der Menge der englischen Daten. |

Chinese (Mandarin, Simplified), English bilingual |

zh-CN (English bilingual) |

Wenn die synthetisierte Stimme Englisch mit demselben Akzent wie in den Beispieldaten sprechen soll, wird empfohlen, mehr als 10 % Daten in englischer Sprache in Ihren Trainingssatz einzuschließen. Andernfalls fällt der englische Sprachakzent möglicherweise nicht ideal aus. |

Chinese (Cantonese, Simplified) |

zh-HK |

Wenn Sie eine synthetisierte Stimme trainieren möchten, die Englisch mit demselben Akzent wie in Ihren Beispieldaten sprechen kann, stellen Sie sicher, mehr als 10 % Daten in englischer Sprache in Ihrem Trainingssatz bereitstellen. Andernfalls wird standardmäßig ein nativer englischer Akzent verwendet. Der Schwellenwert von 10 % wird basierend auf den Daten berechnet, die nach dem erfolgreichen Hochladen akzeptiert werden, nicht auf den Daten vor dem Hochladen. Wenn einige hochgeladene Daten in englischer Sprache aufgrund von Fehlern abgelehnt werden und der Schwellenwert von 10 % nicht erfüllt wird, erhält die synthetisierte Stimme standardmäßig einen nativen englischen Akzent. |

Chinese (Taiwanese Mandarin, Traditional) |

zh-TW |

Wenn Sie eine synthetisierte Stimme trainieren möchten, die Englisch mit demselben Akzent wie in Ihren Beispieldaten sprechen kann, stellen Sie sicher, mehr als 10 % Daten in englischer Sprache in Ihrem Trainingssatz bereitstellen. Andernfalls wird standardmäßig ein nativer englischer Akzent verwendet. Der Schwellenwert von 10 % wird basierend auf den Daten berechnet, die nach dem erfolgreichen Hochladen akzeptiert werden, nicht auf den Daten vor dem Hochladen. Wenn einige hochgeladene Daten in englischer Sprache aufgrund von Fehlern abgelehnt werden und der Schwellenwert von 10 % nicht erfüllt wird, erhält die synthetisierte Stimme standardmäßig einen nativen englischen Akzent. |

Verfügbare voreingestellte Stile für verschiedene Sprachen

In der folgenden Tabelle sind die verschiedenen voreingestellten Stile gemäß den verschiedenen Sprachen zusammengefasst.

| Sprechweise | Sprache (lokal) |

|---|---|

| Wütend | Englisch (Nordamerika) (en-US)Japanisch (Japan) ( ja-JP) 1Chinesisch (Mandarin, vereinfacht) ( zh-CN) 1 |

| Ruhig | Chinesisch (Mandarin, vereinfacht) (zh-CN) 1 |

| Chat | Chinesisch (Mandarin, vereinfacht) (zh-CN) 1 |

| Fröhlich | Englisch (Nordamerika) (en-US)Japanisch (Japan) ( ja-JP) 1Chinesisch (Mandarin, vereinfacht) ( zh-CN) 1 |

| Verärgert | Chinesisch (Mandarin, vereinfacht) (zh-CN) 1 |

| Aufgeregt | Englisch (Nordamerika) (en-US) |

| Ängstlich | Chinesisch (Mandarin, vereinfacht) (zh-CN) 1 |

| Freundlich | Englisch (Nordamerika) (en-US) |

| Hoffnungsvoll | Englisch (Nordamerika) (en-US) |

| Traurig | Englisch (Nordamerika) (en-US)Japanisch (Japan) ( ja-JP) 1Chinesisch (Mandarin, vereinfacht) ( zh-CN) 1 |

| Schreiend | Englisch (Nordamerika) (en-US) |

| Ernst | Chinesisch (Mandarin, vereinfacht) (zh-CN) 1 |

| Verängstigt | Englisch (Nordamerika) (en-US) |

| unfreundlich | Englisch (Nordamerika) (en-US) |

| Flüsternd | Englisch (Nordamerika) (en-US) |

1 Die neuronale Stimme ist in der öffentlichen Vorschau verfügbar. Stimmen in der öffentlichen Vorschauversion sind nur in drei Dienstregionen verfügbar: USA, Osten, Europa, Westen und Asien, Südosten.

Abrufen des Trainingsstatus

Um den Trainingsstatus eines Sprachmodells abzurufen, verwenden Sie den Vorgang Models_Get der benutzerdefinierten Sprach-API. Erstellen Sie den Anforderungstext wie folgt:

Stellen Sie eine HTTP-GET-Anforderung unter Verwendung der URI, wie im folgenden Beispiel Models_Get gezeigt.

- Ersetzen Sie

YourResourceKeydurch Ihren Speech-Ressourcenschlüssel. - Ersetzen Sie

YourResourceRegiondurch Ihre Sprachressourcenregion. - Ersetzen Sie

JessicaModelId, wenn Sie im vorherigen Schritt eine andere Modell-ID angegeben haben.

curl -v -X GET "https://YourResourceRegion.api.cognitive.microsoft.com/customvoice/models/JessicaModelId?api-version=2024-02-01-preview" -H "Ocp-Apim-Subscription-Key: YourResourceKey"

.Sie sollten einen Antworttext im folgenden Format erhalten.

Hinweis

Das Rezept kind und andere Eigenschaften hängen davon ab, wie Sie die Stimmetrainiert haben. In diesem Beispiel ist Default die Rezeptart für neurale Sprachtrainings vorgesehen.

{

"id": "JessicaModelId",

"voiceName": "JessicaNeural",

"description": "Jessica voice",

"recipe": {

"kind": "Default",

"version": "V7.2023.03"

},

"projectId": "ProjectId",

"consentId": "JessicaConsentId",

"trainingSetId": "JessicaTrainingSetId",

"locale": "en-US",

"engineVersion": "2023.07.04.0",

"status": "Succeeded",

"createdDateTime": "2023-04-01T05:30:00.000Z",

"lastActionDateTime": "2023-04-02T10:15:30.000Z"

}

Möglicherweise müssen Sie mehrere Minuten warten, bevor das Training abgeschlossen ist. Schließlich ändert sich der Status in entweder Succeeded oder Failed.