Azure AI Video Indexer-Objekterkennung

Azure AI Video Indexer kann Objekte in Videos erkennen. Der Einblick ist Teil von Standard- und erweiterten Videovoreinstellungen. Die Objekterkennung ist in den Erkenntnissen enthalten, die das Ergebnis einer Upload-Videoanforderung sind.

Transparenzhinweis

Bevor Sie die Objekterkennung verwenden, überprüfen Sie die Übersicht über Transparenzhinweise.

JSON-Schlüssel und -Definitionen

| Schlüssel | Definition |

|---|---|

| Kennung | Inkrementelle Anzahl der IDs der erkannten Objekte in der Mediendatei |

| type | Typ von Objekten, z. B. Car |

| ThumbnailID | GUID, die eine einzelne Erkennung des Objekts darstellt |

| displayName | Name, der in der VI-Portaloberfläche angezeigt werden soll |

| WikiDataID | Ein eindeutiger Bezeichner in der WikiData-Struktur |

| Instanzen | Liste aller Instanzen, die nachverfolgt wurden |

| Zuverlässigkeit | Eine Bewertung zwischen 0 und 1, die die Vertrauenswürdigkeit der Objekterkennung angibt |

| adjustedStart | angepasste Startzeit des Videos bei Verwendung des Editors |

| adjustedEnd | angepasste Endzeit des Videos bei Verwendung des Editors |

| start | die Uhrzeit, zu der das Objekt im Frame angezeigt wird |

| end | die Zeit, zu der das Objekt nicht mehr im Frame angezeigt wird |

JSON-Antwort

Erkannte und nachverfolgte Objekte

Erkannte und nachverfolgte Objekte werden unter "erkannte Objekte" in der heruntergeladenen insights.json Datei angezeigt. Jedes Mal, wenn ein eindeutiges Objekt erkannt wird, erhält es eine ID. Dieses Objekt wird auch nachverfolgt, was bedeutet, dass das Modell auf das erkannte Objekt überwacht, um zum Frame zurückzukehren. Wenn dies der Fall ist, wird eine andere Instanz den Instanzen für das Objekt mit unterschiedlichen Anfangs- und Endzeiten hinzugefügt.

In diesem Beispiel wurde das erste Auto erkannt und erhielt eine ID von 1, da es auch das erste Objekt erkannt wurde. Dann wurde ein anderes Auto erkannt und das Auto wurde die ID von 23 erhalten, da es das 23. Objekt erkannt wurde. Später erschien das erste Auto wieder und eine andere Instanz wurde dem JSON hinzugefügt. Hier sehen Sie den resultierenden JSON-Code:

detectedObjects: [

{

id: 1,

type: "Car",

thumbnailId: "1c0b9fbb-6e05-42e3-96c1-abe2cd48t33",

displayName: "car",

wikiDataId: "Q1420",

instances: [

{

confidence: 0.468,

adjustedStart: "0:00:00",

adjustedEnd: "0:00:02.44",

start: "0:00:00",

end: "0:00:02.44"

},

{

confidence: 0.53,

adjustedStart: "0:03:00",

adjustedEnd: "0:00:03.55",

start: "0:03:00",

end: "0:00:03.55"

}

]

},

{

id: 23,

type: "Car",

thumbnailId: "1c0b9fbb-6e05-42e3-96c1-abe2cd48t34",

displayName: "car",

wikiDataId: "Q1420",

instances: [

{

confidence: 0.427,

adjustedStart: "0:00:00",

adjustedEnd: "0:00:14.24",

start: "0:00:00",

end: "0:00:14.24"

}

]

}

]

Unterstützte Objekte

- airplane

- apple

- backpack

- Banane

- Baseballhandschuh

- Bett

- bench

- bicycle

- boat

- book (Buch)

- Flasche

- bowl

- Brokkoli

- Bus

- Kuchen

- Auto

- Karotte

- cell phone

- Stuhl

- clock

- Computermaus

- Couch

- Tasse

- Speisetisch

- Ring

- fire hydrant

- Fork

- Frisbee

- Fön

- Handtasche

- Hot Dog

- Tastatur

- Drachen

- knife

- laptop

- Mikrowelle

- Motorrad

- Computermaus

- Krawatte

- orange

- oven

- parking meter

- pizza

- Topfpflanze

- sandwich

- scissors

- sink

- Skateboard

- Ski

- Snowboard

- Löffel

- Sportball

- stop sign

- Koffer

- Surfbrett

- Teddybär

- Tennisschläger

- toaster

- Toilette

- Zahnbürste

- Ampel

- Training

- Regenschirm

- Vase

- Waffen, siehe Spezifische Klassennotizen für die Waffenklasse

- Weinglas

Begrenzungen

- Es gibt bis zu 20 Erkennungen pro Frame für Standard- und erweiterte Verarbeitung und 35 Spuren pro Klasse.

- Die Objektgröße sollte nicht größer als 90 Prozent des Frames sein. Sehr große Objekte, die sich konsistent über einen großen Teil des Frames erstrecken, werden möglicherweise nicht erkannt.

- Kleine oder verschwommene Objekte können schwer zu erkennen sein. Sie können entweder verpasst oder falsch klassifiziert werden (Weinglas, Tasse).

- Objekte, die vorübergehend sind und in sehr wenigen Frames angezeigt werden, werden möglicherweise nicht erkannt.

- Andere Faktoren, die sich auf die Genauigkeit der Objekterkennung auswirken können, sind niedrige Lichtverhältnisse, Kamerabewegungen und Okklusionen.

- Azure AI Video Indexer unterstützt nur reale Objekte. Es gibt keine Unterstützung für Animationen oder CGI. Computer generierte Grafiken (z. B. News-Aufkleber) können seltsame Ergebnisse erzeugen.

- Sehen Sie sich bestimmte Kursnotizen an.

Bestimmte Kursnotizen

Gebundene schriftliche Materialien

Binder, Broschüren und andere schriftliche Materialien werden meist als "Buch" erkannt.

Waffe

- Die Waffenklasse umfasst Darstellungen von Handgewehren und Gewehren.

- Hände, die dunkle Objekte halten (meist, aber nicht auf verschwommene Objekte) können mit Waffen verwechselt werden.

- Waffen über einem sehr dunklen Hintergrund können verpasst werden.

- Videos mit geringer Qualität (Auflösung, Komprimierung usw.) können sich auf die Fähigkeit des Modells auswirken, die Waffe zu identifizieren.

- Mechanische Objekte (einschließlich Roboter) und komplizierte Maschinen können manchmal als Waffen erkannt werden.

- Für rückruforientierte Aufgaben stehen die gefilterten Spuren unter "filtered_tracks" zur Verfügung. Diese Spuren hatten eine niedrigere Gesamtvertrauensbewertung und werden nicht im Azure AI Video Indexer-Portal angezeigt.

Testen der Objekterkennung

Sie können die Objekterkennung mit dem Webportal oder mit der API ausprobieren.

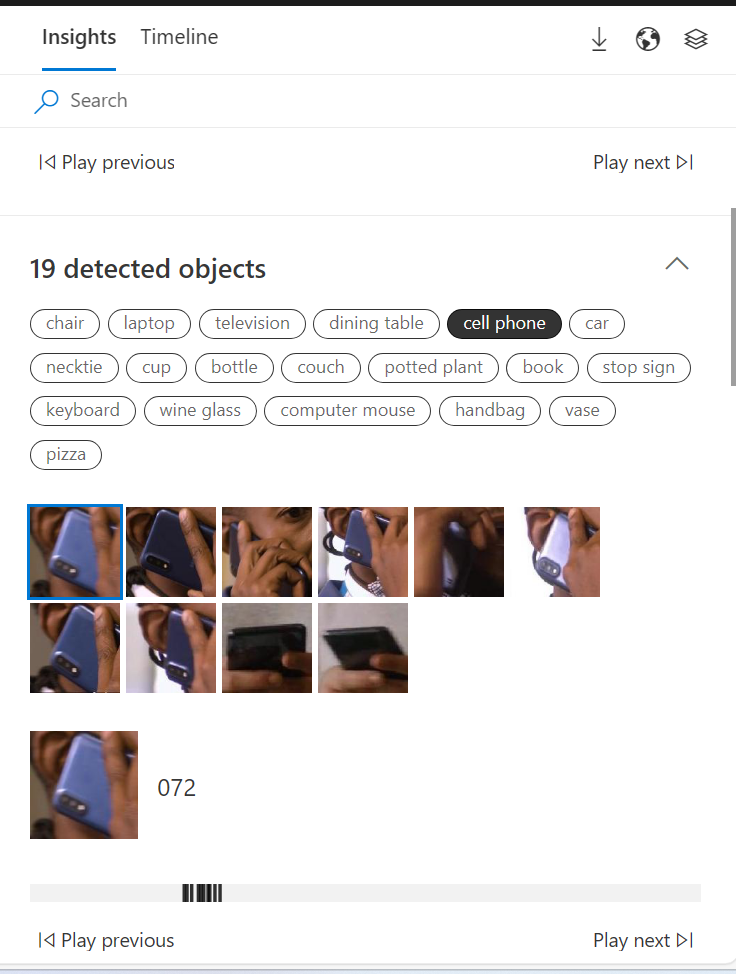

Sobald ein Video hochgeladen wurde, können Sie die Einblicke anzeigen. Auf der Registerkarte "Einblicke" können Sie die Liste der erkannten Objekte und deren Standard Instanzen anzeigen.

Erkenntnisse

Wählen Sie die Registerkarte "Insights" aus. Die Objekte befinden sich in absteigender Reihenfolge der Anzahl der Darstellungen im Video.

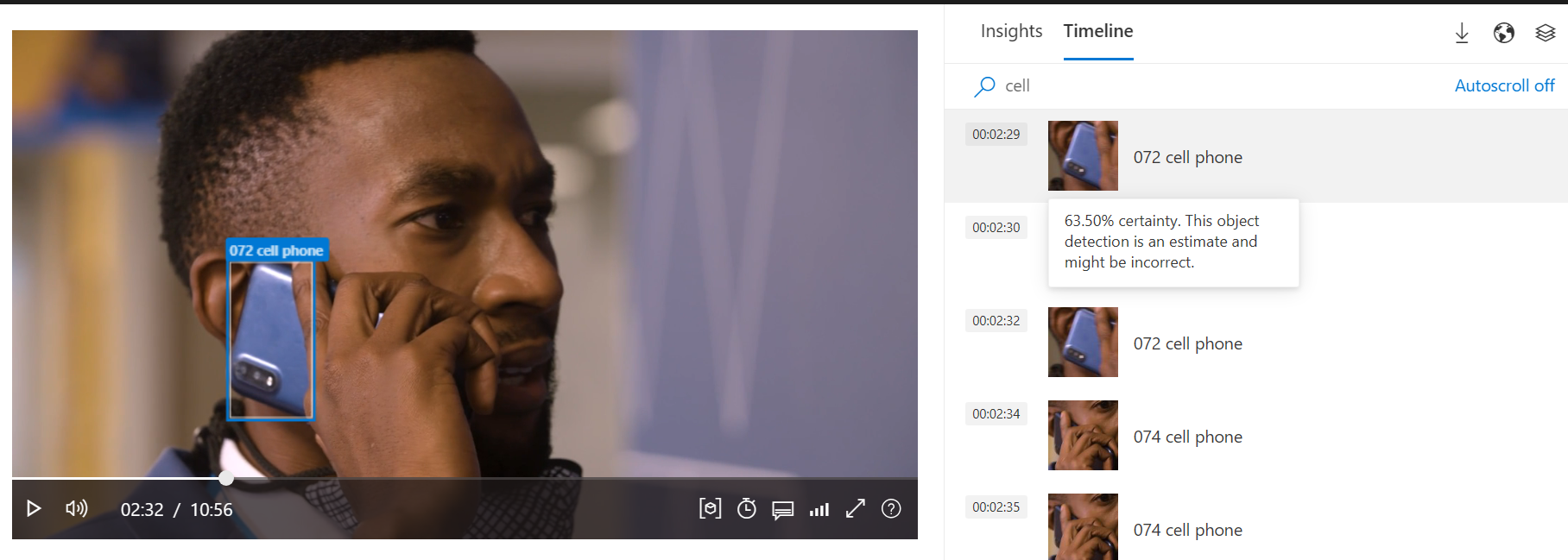

Zeitachse

Wählen Sie die Registerkarte Zeitachse.

Unter der Registerkarte Zeitleiste werden alle erkannten Objekte entsprechend der Darstellungszeit angezeigt. Wenn Sie mit dem Mauszeiger auf eine bestimmte Erkennung zeigen, wird der Erkennungsprozentsatz der Sicherheit angezeigt.

Spieler

Der Spieler markiert automatisch das erkannte Objekt mit einem umgebenden Feld. Das ausgewählte Objekt aus dem Bereich "Einblicke" wird blau hervorgehoben, wobei auch der Objekttyp und die Seriennummer angezeigt werden.

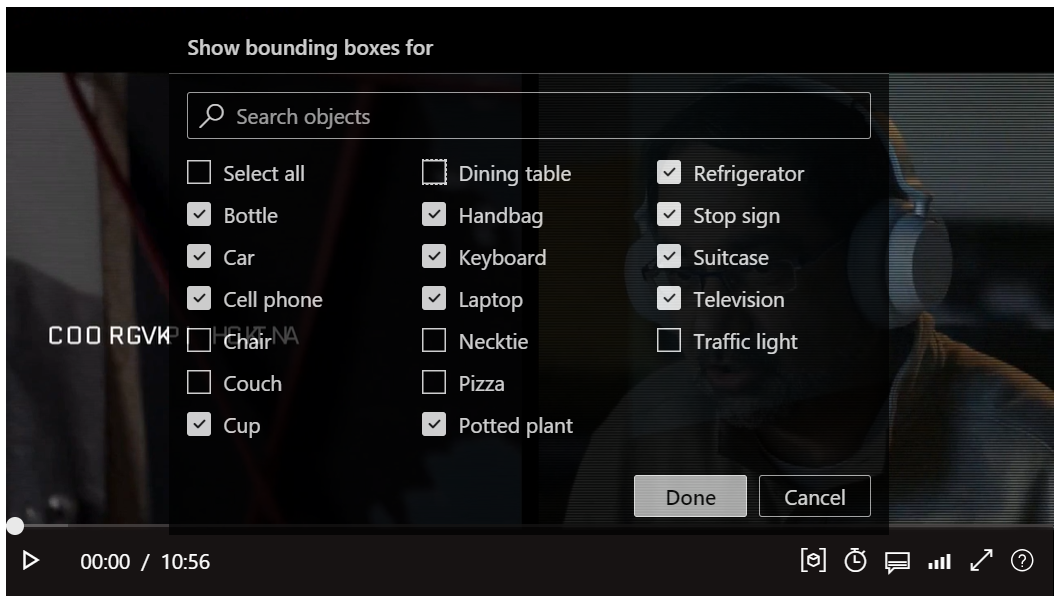

Filtern Sie die umgebenden Felder um Objekte, indem Sie das umgebende Feldsymbol auf dem Spieler auswählen.

![]()

Aktivieren oder deaktivieren Sie dann die erkannten Objekte Kontrollkästchen.

Laden Sie die Insights herunter, indem Sie "Herunterladen" und dann "Insights" (JSON) auswählen.

Feedback

Bald verfügbar: Im Laufe des Jahres 2024 werden wir GitHub-Issues stufenweise als Feedbackmechanismus für Inhalte abbauen und durch ein neues Feedbacksystem ersetzen. Weitere Informationen finden Sie unter https://aka.ms/ContentUserFeedback.

Feedback senden und anzeigen für