Szenen, Aufnahmen und Keyframes

Wichtig

Aufgrund der Ankündigung zur Einstellung von Azure Media Services kündigt Azure AI Video Indexer Anpassungen an. Siehe Änderungen im Zusammenhang mit der Einstellung von Azure Media Service (AMS), um zu verstehen, was dies für Ihr Azure AI Video Indexer-Konto bedeutet. Weitere Informationen finden Sie im Leitfaden zur Vorbereitung auf die Einstellung von AMS: VI-Update und -Migration.

Azure AI Video Indexer unterstützt das Segmentieren von Videos in zeitliche Einheiten basierend auf strukturellen und semantischen Eigenschaften. Diese Funktion ermöglicht es Kunden, ihre Videoinhalte auf der Grundlage unterschiedlicher Granularitäten einfach zu durchsuchen, zu verwalten und zu bearbeiten. Beispielsweise basierend auf Szenen, Aufnahmen und Keyframes, die in diesem Thema beschrieben werden.

Szenenerkennung

Azure AI Video Indexer bestimmt, wann sich eine Szene basierend auf visuellen Hinweisen in Videos ändert. Eine Szene zeigt ein einzelnes Ereignis und besteht aus einer Reihe aufeinander folgender Aufnahmen, die semantisch miteinander verknüpft sind. Ein Szenenminiaturbild ist das erste Keyframe der zugrunde liegenden Aufnahme. Azure AI Video Indexer segmentiert ein Video basierend auf der Farbkohärenz in aufeinander folgende Aufnahmen und ruft die Anfangs- und Endzeit jeder Szene ab. Die Szenenerkennung stellt eine anspruchsvolle Aufgabe dar, da sie die Quantifizierung semantischer Aspekte von Videos beinhaltet.

Hinweis

Sie kann für Videos mit mindestens drei Szenen angewendet werden.

Szenenwechselerkennung

Azure AI Video Indexer bestimmt, wann sich ein Bild im Video basierend auf visuellen Hinweisen ändert, indem er sowohl abrupte als auch graduelle Übergänge im Farbschema benachbarter Frames nachverfolgt. Die Metadaten der Aufnahme beinhalten eine Start- und Endzeit sowie die Liste der Keyframes, die darin enthalten sind. Die Aufnahmen sind aufeinanderfolgende Bilder, die gleichzeitig von derselben Kamera aufgenommen werden.

Keyframe-Erkennung

Azure AI Video Indexer wählt die Frames aus, die die einzelnen Aufnahmen am besten darstellen. Keyframes sind die repräsentativen Einzelframes, die basierend auf ästhetischen Eigenschaften (z.B. Kontrast und Stabilität) aus dem gesamten Video ausgewählt werden. Azure AI Video Indexer ruft eine Liste von Keyframe-IDs als Teil der Metadaten des Screenshots ab, basierend darauf, welche Kunden den Keyframe als hochauflösendes Bild extrahieren können.

Extrahieren von Keyframes

Um Keyframes mit hoher Auflösung für das Video zu extrahieren, müssen Sie das Video zunächst hochladen und indizieren.

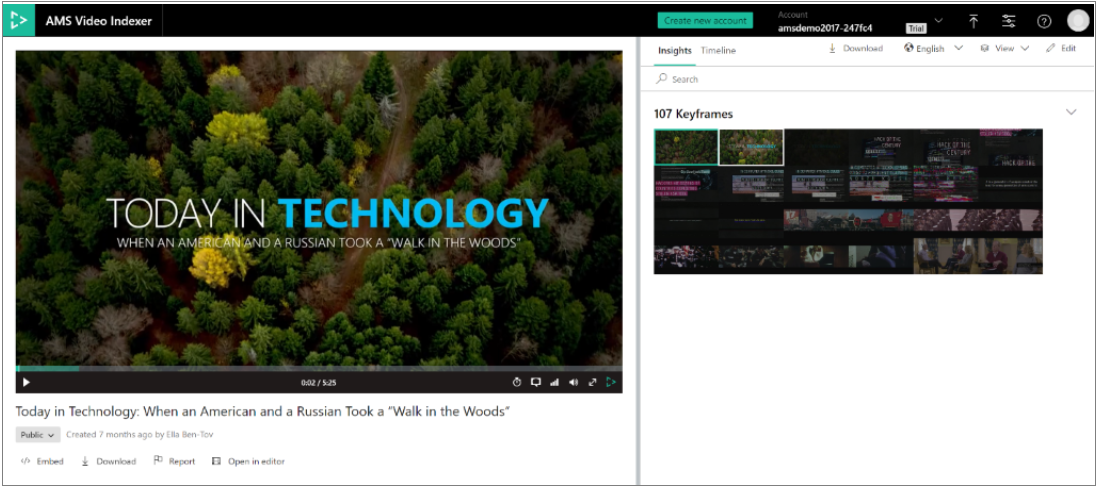

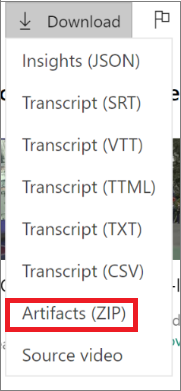

Mit der Azure AI Video Indexer-Website

Um Keyframes mithilfe der Azure AI Video Indexer-Website zu extrahieren, laden Sie Ihr Video hoch und indizieren Sie es. Klicken Sie nach Abschluss des Indizierungsauftrags auf die Schaltfläche Herunterladen, und wählen Sie Artefakte (ZIP) aus. Dadurch wird der Ordner „Artefakte“ auf Ihren Computer heruntergeladen (lesen Sie unbedingt die nachstehende Warnung zu Artefakten). Entzippen und öffnen Sie den Ordner. Im Ordner _KeyframeThumbnail finden Sie alle Keyframes, die aus dem Video extrahiert wurden.

Warnung

Es wird nicht empfohlen, Daten direkt aus dem Artefakte-Ordner für Produktionszwecke zu verwenden. Artefakte sind Zwischenausgaben des Indizierungsprozesses. Sie sind im Wesentlichen Rohdaten der verschiedenen KI-Engines, die die Videos analysieren; das Schema der Artefakte kann sich im Laufe der Zeit ändern. Es wird empfohlen, die Get Video Index-API zu verwenden, wie unter Abrufen von Erkenntnissen, die von der API erzeugt werden beschrieben.

Mit der Azure AI Video Indexer-API

Wenn Sie Keyframes über die Video Indexer-API abrufen möchten, können Sie das Video mithilfe des Aufrufs zum Hochladen des Videos (Upload Video) hochladen und indizieren. Rufen Sie Get Video Index (Videoindex abrufen) auf, nachdem der Indizierungsauftrag abgeschlossen wurde. Dadurch erhalten Sie alle Erkenntnisse, die mit Video Indexer aus den Inhalten in eine JSON-Datei extrahiert wurden.

Sie erhalten eine Liste der Keyframe-IDs als Teil der Metadaten der einzelnen Aufnahmen.

"shots":[

{

"id":0,

"keyFrames":[

{

"id":0,

"instances":[

{

"thumbnailId":"00000000-0000-0000-0000-000000000000",

"start":"0:00:00.209",

"end":"0:00:00.251",

"duration":"0:00:00.042"

}

]

},

{

"id":1,

"instances":[

{

"thumbnailId":"00000000-0000-0000-0000-000000000000",

"start":"0:00:04.755",

"end":"0:00:04.797",

"duration":"0:00:00.042"

}

]

}

],

"instances":[

{

"start":"0:00:00",

"end":"0:00:06.34",

"duration":"0:00:06.34"

}

]

},

]

Sie müssen nun jede dieser Keyframe-IDs für den Aufruf zum Abrufen von Miniaturansichten (Get Thumbnails) ausführen. Dadurch werden alle Keyframe-Bilder auf Ihren Computer heruntergeladen.

Erkennung von redaktionellen Aufnahmetypen

Keyframes sind mit Aufnahmen in der Ausgabe-JSON verknüpft.

Der einer einzelnen Aufnahme im Erkenntnis-JSON zugeordnete Aufnahmetyp stellt deren redaktionellen Typ dar. Diese Art Aufnahmetyp-Charakterisierung kann beim Bearbeiten von Videos zu Clips oder Trailern oder bei der Suche nach einem bestimmten Stil oder Keyframe zu künstlerischen Zwecken nützlich sein. Die verschiedenen Typen werden auf der Grundlage einer Analyse des ersten Keyframes jeder Aufnahme bestimmt. Aufnahmen werden anhand des Maßstabs, der Größe und der Position der Gesichter identifiziert, die in ihrem ersten Keyframe abgebildet sind.

Größe und Maßstab der Aufnahme werden auf der Grundlage des Abstands zwischen der Kamera und den Gesichtern bestimmt, die im Frame dargestellt sind. Mit diesen Eigenschaften erkennt Azure AI Video Indexer die folgenden Aufnahmetypen:

- Wide (Totale): Zeigt den gesamten Körper einer Person.

- Medium (Halbtotale): Zeigt Oberkörper und Gesicht einer Person.

- Close up (Nahaufnahme): Zeigt in der Hauptsache das Gesicht einer Person.

- Extreme close-up (Extreme Nahaufnahme): Zeigt das Gesicht einer Person bildschirmfüllend.

Aufnahmetypen können auch anhand der Position der Hauptfiguren im Verhältnis zum Mittelpunkt des Frames bestimmt werden. Diese Eigenschaft definiert die folgenden Aufnahmetypen in Azure AI Video Indexer:

- Left face (Gesicht links): Eine Person ist auf der linken Seite des Frames dargestellt.

- Center face (Gesicht Mitte): Eine Person ist im mittleren Bereich des Frames dargestellt.

- Right face (Gesicht rechts): Eine Person ist auf der rechten Seite des Frames dargestellt.

- Outdoor (Außen): Eine Person ist in einer Außenumgebung dargestellt.

- Indoor (Innen): Eine Person ist in einer Innenumgebung dargestellt.

Zusätzliche Merkmale:

- Two shots (Zwei Aufnahmen): Zeigt die Gesichter von zwei Personen mit mittlerer Größe.

- Multiple faces (Mehrere Gesichter): mehr als zwei Personen.

Feedback

Bald verfügbar: Im Laufe des Jahres 2024 werden wir GitHub-Issues stufenweise als Feedbackmechanismus für Inhalte abbauen und durch ein neues Feedbacksystem ersetzen. Weitere Informationen finden Sie unter https://aka.ms/ContentUserFeedback.

Feedback senden und anzeigen für