Demokratisieren von Daten mit digitalen Innovationen

Kohle, Öl und menschliches Potenzial waren während der industriellen Revolution die drei entscheidenden Ressourcen. Diese Ressourcen bildeten das Fundament für Unternehmen und bewirkten schließlich einen grundsätzlichen Wandel von Märkten und Nationen. In der digitalen Wirtschaft gibt es drei gleichermaßen wichtige Ressourcen für Innovation: Daten, Geräte und menschliches Potenzial. Diese Ressourcen weisen ein hervorragendes Innovationspotenzial auf. In der heutigen Zeit sind bei jeder Innovationsinitiative die Daten das neue Öl.

In jedem Unternehmen gibt es Daten, die genutzt werden können, um Kundenbedürfnisse zu ermitteln und zu erfüllen. Leider kann der Prozess des Minings dieser Daten zur Förderung von Innovationen kostspielig und zeitaufwändig sein, sodass Bedürfnisse und Anforderungen nicht erkannt und keine Lösungen entwickelt werden. Dieses Problem kann durch die Demokratisierung von Daten gelöst werden.

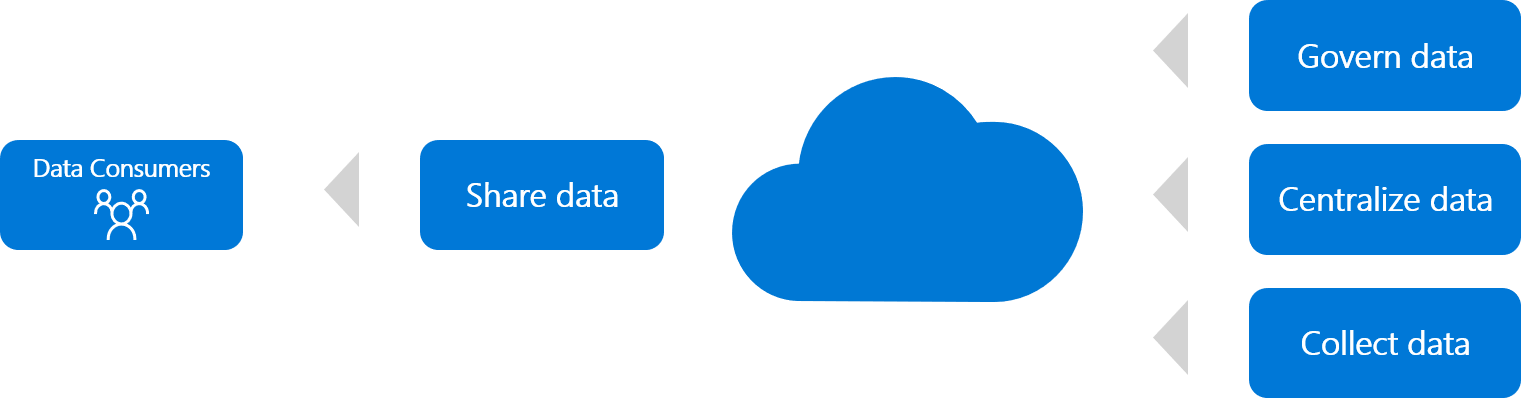

Was ist die Demokratisierung von Daten? Die Demokratisierung von Daten ist der Prozess, Daten in die richtigen Hände zu geben, um Innovationen voranzutreiben. Dieser Demokratisierungsprozess kann verschiedene Formen annehmen, umfasst jedoch im Allgemeinen Lösungen für erfasste oder integrierte Rohdaten, die Zentralisierung und Freigabe von Daten sowie das Schützen von Daten. Wenn Daten demokratisiert werden, können sie von Experten im ganzen Unternehmen verwendet werden, um Hypothesen aufzustellen und zu testen. In vielen Fällen können Cloudeinführungsteams ausschließlich mithilfe von Daten Lösungen mit Blick auf die Kundenanforderungen erstellen und so schnell auf Kundenbedürfnisse reagieren.

Möglichkeiten zum Demokratisieren von Daten

Es gibt verschiedene Möglichkeiten, Daten zu demokratisieren, die meisten beinhalten jedoch Methoden zum Sammeln, Zentralisieren, Steuern und Freigeben der Daten. In den folgenden Abschnitten werden einige dieser Methoden beschrieben. Wenn Sie eine Lösung für eine Kundenhypothese erstellen, sollten Sie bewerten, ob und in welchem Umfang Daten demokratisiert werden sollen und wie Sie dazu vorgehen.

Freigeben von Daten

Wenn Sie Lösungen mit Blick auf die Kundenanforderungen erstellen, muss der Kunde der Maßstab sein. Wenn der Kunde Daten benötigt, ermöglicht es ihm die Lösung, die Daten ohne Unterstützung durch IT-Mitarbeiter direkt abzufragen, zu analysieren und zu melden.

Viele erfolgreiche Innovationen beginnen als Minimum Viable Product (MVP), das Daten für den Kunden bereitstellt. Ein MVP ist eine Version des Produkts, die das Mindestmaß an Features bietet, um vom Kunden genutzt werden zu können. Es zeigt das mögliche Potenzial des Produkts und dient dazu, Feedback von Kunden zu sammeln. In diesem Concierge-Modell ist ein Mitarbeiter der Datenconsumer. Dieser Mitarbeiter verwendet Daten, um den Kunden zu unterstützen. Jedes Mal, wenn der Kunde die manuelle Unterstützung einbindet, kann eine Hypothese getestet und überprüft werden. Dieser Ansatz ist oft ein kostengünstiges Mittel, um eine kundenorientierte Hypothese vor hohen Investitionen in integrierte Lösungen zu testen.

Mit den wichtigsten Tools für die direkte Freigabe von Daten für Datenconsumer wie Power BI werden u. a. Self-Service-Berichte erstellt oder Daten verarbeitet, die in andere Umgebungen eingebettet sind.

Hinweis

Bevor Sie Daten freigeben, sollten Sie unbedingt die folgenden Abschnitte gelesen haben. Die Freigabe von Daten erfordert möglicherweise Governance, um den Schutz der Daten zu gewährleisten. Sind die Daten auf mehrere Clouds verteilt, ist u. U. auch eine Zentralisierung erforderlich. Wenn Daten in Anwendungen enthalten sind, müssen Sie sie sammeln, damit Sie sie freigeben können.

Steuern von Daten

Aus dem Freigeben von Daten kann schnell ein Minimum Viable Product resultieren, das für den Dialog mit dem Kunden verwendet werden kann. Um diese freigegebenen Daten in umsetzbare Informationen umzuwandeln, ist jedoch im Allgemeinen mehr erforderlich.

Nachdem eine Hypothese durch die Datenfreigabe überprüft wurde, ist die nächste Entwicklungsphase meist die Data Governance.

Datengovernance ist ein umfassendes Thema, das ein eigenes dediziertes Framework erfordern kann, und geht daher über den Rahmen des Cloud Adoption Frameworks hinaus.

Bei der Überprüfung der Kundenhypothese müssen mehrere Aspekte der Datengovernance berücksichtigt werden. Zum Beispiel:

- Sind die freigegebenen Daten vertraulich? Vor jeder öffentlichen Freigabe sollten die Daten klassifiziert werden, um die Interessen der Kunden und des Unternehmens zu schützen.

- Wenn die Daten vertraulich sind, wurden sie geschützt? Der Schutz vertraulicher Daten ist ein Muss für demokratisierte Daten. Unter Schützen von Datenlösungen finden Sie die Beschreibung einer Beispielworkload und weiterführende Informationen zum Schützen von Daten.

- Sind die Daten katalogisiert? Die Art der freigegebenen Daten zu identifizieren, erleichtert die langfristige Datenverwaltung. Tools zum Dokumentieren von Daten wie Azure Data Catalog können diesen Prozess in der Cloud erheblich vereinfachen. Mit unseren Leitfäden zum Kommentieren von Daten und Dokumentieren von Datenquellen können Sie den Prozess beschleunigen.

Wenn die Demokratisierung von Daten für eine kundenorientierte Hypothese wichtig ist, sollte die Governance von freigegebenen Daten im Releaseplan enthalten sein. Dies schützt Kunden, Datenconsumer und das Unternehmen.

Zentralisieren von Daten

Die Datenzentralisierung führt zu aussagekräftigeren Berichten, stellt sicher, dass die gleichen Daten in der gesamten Organisation verfügbar sind, und erhöht Ihren ROI. Wenn die Daten in einer IT-Umgebung verteilt sind, können die Innovationsmöglichkeiten äußerst eingeschränkt, teuer und zeitaufwändig sein. Die Cloud bietet neue Möglichkeiten zur Zentralisierung von Daten. Wenn zum Erstellen von Lösungen mit Blick auf die Kundenanforderungen eine Zentralisierung mehrerer Datenquellen erforderlich ist, kann die Cloud das Testen von Hypothesen beschleunigen.

Achtung

Die Zentralisierung von Daten stellt bei jedem Innovationsprozess ein Risiko dar. Wenn die Datenzentralisierung statt einer Kundenwertquelle eine technische Spitze ist, sollte die Zentralisierung aufgeschoben werden, bis die Kundenhypothese überprüft wurde.

Wenn Sie Daten zentralisieren, benötigen Sie einen geeigneten Datenspeicher für die zentralisierten Daten. Es ist ratsam, ein Data Warehouse in der Cloud einzurichten. Diese skalierbare Option bietet einen zentralen Speicherort für Ihre sämtlichen Daten. Diese Art von Lösung ist in den Optionen „Analytische Onlineverarbeitung“ (Online Analytical Processing, OLAP) oder „Big Data“ verfügbar.

Die Referenzarchitekturen für OLAP- und Big Data-Lösungen können bei der Auswahl der geeignetsten Zentralisierungslösung in Azure helfen. Wenn eine Hybridlösung erforderlich ist, kann die Referenzarchitektur für das Erweitern lokaler Datenlösungen auf die Cloud auch zur Beschleunigung der Lösungsentwicklung beitragen.

Wichtig

Für manche Kundenanforderungen und -lösungen kann ein einfacher Ansatz ausreichen. Der Cloudarchitekt sollte das Team auffordern, insbesondere in der frühen Phase der Entwicklung kostengünstige Lösungen zum Überprüfen der Kundenhypothese in Erwägung zu ziehen. In diesem Abschnitt zum Sammeln von Daten werden einige Szenarien beschrieben, die möglicherweise eine andere Lösung für Ihre Situation nahelegen.

Sammeln von Daten

Es gibt zwei primäre Formen der Datensammlung: Integration und Erfassung.

Integration: Daten, die sich in einem vorhandenen Datenspeicher befinden, können mithilfe herkömmlicher Datenverschiebungstechniken in den zentralisierten Datenspeicher integriert werden. Dies gilt insbesondere für Szenarien, in denen die Multicloud-Datenspeicherung eine Rolle spielt. Zu diesen Techniken gehört das Extrahieren der Daten aus dem vorhandenen Datenspeicher und das anschließende Laden in den zentralen Datenspeicher. An einem bestimmten Punkt in diesem Prozess werden die Daten typischerweise transformiert, sodass sie im zentralen Speicher besser verwendbar und relevant sind.

Mit cloudbasierten Tools stehen diese Techniken in Form von Tools mit nutzungsabhängiger Bezahlung zur Verfügung und senken so die Hemmschwelle für den Einstieg in Datensammlung und -zentralisierung. Tools wie Azure Database Migration Service und Azure Data Factory sind zwei Beispiele. Die Referenzarchitektur für Data Factory mit einem OLAP-Datenspeicher ist ein Beispiel einer solchen Lösung.

Erfassung: Einige Daten befinden sich nicht in einem vorhandenen Datenspeicher. Wenn diese temporären Daten eine primäre Quelle für die Innovation sind, sollten alternative Ansätze in Erwägung gezogen werden. Temporäre Daten finden Sie in einer Vielzahl von vorhandenen Quellen, z. B. Anwendungen, APIs, Datenströme, IoT-Geräte, Blockchain, Anwendungscache, Medieninhalt oder sogar Flatfiles.

Diese unterschiedlichen Datenformen können Sie im Rahmen einer OLAP- oder Big Data-Lösung in einen zentralen Datenspeicher integrieren. Für frühe Iterationen von Erstellen-Messen-Lernen-Zyklen ist eine Lösung für die Onlinetransaktionsverarbeitung (Online Transactional Processing, OLTP) jedoch möglicherweise ausreichend, um eine Kundenhypothese zu überprüfen. OLTP-Lösungen sind nicht für alle Berichterstellungsszenarios die beste Lösung. Wenn Sie jedoch Beim Erstellen einen Blick auf die Kundenanforderungen behalten, sollten Sie sich mehr auf die Kundenanforderungen als auf die Entscheidungen zu den technischen Tools konzentrieren. Nachdem die Kundenhypothese bedarfsabhängig überprüft wurde, ist möglicherweise eine geeignetere Plattform erforderlich. Die Referenzarchitektur für OLTP-Datenspeicher kann bei der Ermittlung des für Ihre Lösung am besten geeigneten Datenspeichers helfen.

Virtualisieren: Die Integration und Erfassung von Daten kann manchmal die Innovation bremsen. Wenn bereits eine Lösung für die Datenvirtualisierung verfügbar ist, stellt dies möglicherweise ein geeigneteren Ansatz dar. Erfassung und Integration können sowohl Speicher- als auch Entwicklungsanforderungen duplizieren, die Datenlatenz steigern, die Angriffsfläche vergrößern, Qualitätsprobleme verursachen und den Governanceaufwand erhöhen. Die Datenvirtualisierung ist eine zeitgemäße Alternative, bei der die ursprünglichen Daten an einem einzigen Ort gespeichert werden und Pass-Through- oder zwischengespeicherte Abfragen der Quelldaten erstellt werden.

SQL Server 2017 und Azure SQL Data Warehouse unterstützen PolyBase. Dies ist der in Azure am häufigsten verwendete Ansatz zur Datenvirtualisierung.

Nächste Schritte

Wenn die Strategie zur Demokratisierung von Daten feststeht, evaluieren Sie im nächsten Schritt Ansätze für die Anwendungsentwicklung.

Feedback

Bald verfügbar: Im Laufe des Jahres 2024 werden wir GitHub-Issues stufenweise als Feedbackmechanismus für Inhalte abbauen und durch ein neues Feedbacksystem ersetzen. Weitere Informationen finden Sie unter https://aka.ms/ContentUserFeedback.

Feedback senden und anzeigen für