Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Der Zielzonenbeschleuniger für HPC (High Performance Computing) automatisiert die Bereitstellung einer Umgebung. Diese Umgebung bietet ein Basisframework, das Sie anpassen können, um einen lückenlosen Bereitstellungsmechanismus für eine vollständige HPC-Clusterlösung in Azure zu erstellen. Der Beschleuniger ist eine Sammlung von Open-Source-Skripts und -Vorlagen, die Ihre Zielzonen im gesamten Unternehmen vorbereiten können. Er kann einen spezifischen Architekturansatz und eine Referenzimplementierung bereitstellen, die der Architektur und den bewährten Methoden im Cloud Adoption Framework entspricht.

Kunden führen HPC auf unterschiedliche Weise ein, um ihre Geschäftsanforderungen zu erfüllen, und Sie können den Zielzonenbeschleuniger für HPC so anpassen, dass eine Architektur entsteht, die Ihren Anforderungen entspricht. Der Beschleuniger hilft Ihnen, Ihre Organisation auf den Weg zu einer nachhaltigen Skalierung zu bringen.

Implementieren einer Zielzone auf Unternehmensebene

Der Zielzonenbeschleuniger für HPC geht davon aus, dass Sie mit einer erfolgreich implementierten Zielzone auf Unternehmensebene beginnen. Weitere Informationen zu dieser Voraussetzung finden Sie in den folgenden Artikeln:

- Erste Schritte mit Cloud Adoption Framework-Zielzonen auf Unternehmensebene

- Implementieren von Cloud Adoption Framework-Zielzonen auf Unternehmensebene in Azure

Was der Beschleuniger für HPC-Zielzonen bietet

Der Ansatz für Zielzonen des Zielzonenbeschleunigers für HPC stellt Ihrem Projekt die folgenden Ressourcen zur Verfügung:

- Ein modularer Ansatz zum Anpassen von Umgebungsvariablen

- Entwurfsrichtlinien zur Unterstützung der Bewertung kritischer Entscheidungen

- Architektur der Zielzone

- Eine Implementierung, die Folgendes umfasst:

- Eine bereitstellbare Referenz zum Erstellen der Umgebung für Ihre HPC-Bereitstellung

- Eine von Microsoft genehmigte HPC-Referenzimplementierung zum Testen der bereitgestellten Umgebung

Entwurfsleitlinien für den Energie-, Fertigungs- und Finanzsektor

Die Architekturen von Zielzonen variieren je nach Unternehmenssektor und auch nach Organisation. In diesem Abschnitt sind Artikel nach Sektor aufgeführt, die Leitlinien zum Erstellen Ihrer Zielzone enthalten:

Energiesektor (Öl und Gas)

- Azure-Abrechnung und Microsoft Entra-Mandanten für HPC im Energiesektor

- Identitäts- und Zugriffsverwaltung für Azure HPC im Energiesektor

- Verwaltung von Azure HPC im Energiesektor

- Netzwerktopologie und -konnektivität für Azure HPC im Energiesektor

- Plattformautomatisierung und DevOps für Azure HPC im Energiesektor

- Ressourcenorganisation für HPC im Energiesektor

- Governance für HPC in der Energiebranche

- Sicherheit für Azure HPC im Energiesektor

- Berechnen umfangreicher HPC-Anwendungsworkloads auf Azure-VMs

- Speicher für HPC-Umgebungen im Energiesektor

Fertigung

- Azure-Abrechnung und Active Directory-Mandanten für HPC im Fertigungssektor

- Azure-Identitäts- und Zugriffsverwaltung für HPC im Fertigungssektor

- Verwaltung für HPC im Fertigungssektor

- HPC-Netzwerktopologie und -konnektivität im Fertigungssektor

- Plattformautomatisierung und DevOps für Azure HPC im Fertigungssektor

- Ressourcenorganisation für HPC im Fertigungssektor

- Azure-Governance für HPC im Fertigungssektor

- Sicherheit für HPC im Fertigungssektor

- HPC-Speicher in der Fertigung

Finanzen

- Azure-Abrechnungsangebote und Active Directory-Mandanten für HPC im Finanzsektor

- Azure-Identitäts- und Zugriffsverwaltung für HPC im Finanzsektor

- Verwaltung für HPC im Finanzsektor

- Netzwerktopologie und -konnektivität für HPC im Finanzsektor

- Plattformautomatisierung und DevOps für HPC im Finanzsektor

- Ressourcenorganisation für Azure HPC im Finanzsektor

- Governance für HPC im Finanzsektor

- Sicherheit für HPC im Finanzsektor

- Speicher für HPC im Finanzsektor

Entwurfsrichtlinien für die Auswahl von HPC-Compute für KI-Workloads

Die Auswahl der richtigen SKU für GPU-optimiertes Compute für KI-Workloads ist wichtig, um die Leistung zu optimieren und die Kosten zu steuern. Microsoft bietet viele verschiedene SKUs, die für Workloads optimiert sind, die von mehr GPU-Leistung profitieren. Bei der Auswahl der richtigen SKU für KI-Workloads sind verschiedene Überlegungen anzustellen. Kleinere Workloads nutzen möglicherweise nur einen Bruchteil der CPU, GPU und Bandbreite leistungsstärkerer SKUs wie NDv4. Für kleinere Aufträge sollten Sie andere Compute-SKUs wie NCv4 und NDv2 in Betracht ziehen. Im Folgenden finden Sie einige Überlegungen bei der Auswahl der richtigen SKU für GPU-optimiertes Compute für KI-Workloads:

- Setzen von Prüfpunkten. Berücksichtigen Sie Faktoren wie das Prüfpunktintervall, wenn Sie Ihre Machine Learning-Modelle ausführen. Dies kann sich auf die GPU-Leistung während der Trainingsphase auswirken. Finden Sie ein Gleichgewicht zwischen Speichereffizienz und reibungslosen GPU-Vorgängen. Überwachen Sie Ihre GPU-Nutzung.

- Rückschließen. Rückschlussanforderungen unterscheiden sich von Trainingsanforderungen mit einer möglicherweise höheren CPU-Last, die die CPU-Leistung maximal beeinträchtigen kann. Berücksichtigen Sie die Rückschlussanforderungen Ihres Modells, wenn Sie eine Compute-SKU auswählen. Überwachen Sie Ihre CPU-Auslastung.

- Training. Berücksichtigen Sie die Anforderungen Ihres Modells während des Trainings und überwachen Sie sowohl die CPU- als auch die GPU-Auslastung.

- Auftragsdimensionierung. Wenn Sie die Compute-SKU für Ihre KI-Workloads in Betracht ziehen, sollten Sie die Größe des Auftrags berücksichtigen. Kleinere Aufträge, z. B. ungefähr OPT 1,3B, ziehen möglicherweise keinen Vorteil aus größeren SKU-Größen und lassen die CPU- und GPU-Leistung abhängig von der Phase des Auftrags (Rückschlüsse, Training) im Leerlauf.

- Bandbreite. Eine größere, geringere Latenzbandbreite kann bei Nichtnutzung Kosten erzeugen. Ziehen Sie InfiniBand nur für die größten Modelle in Betracht, die die zusätzliche Bandbreite benötigen.

Sehen Sie sich für GPU optimierte VM-Größen von Azure an.

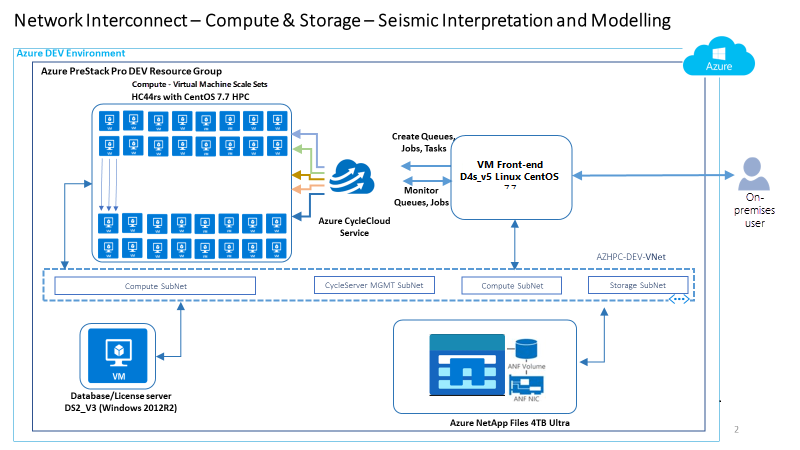

Beispiel einer konzeptionellen Referenzarchitektur für den Energiesektor

Die folgende konzeptionelle Referenzarchitektur ist ein Beispiel, das Entwurfsbereiche und bewährte Methoden für Umgebungen im Energiesektor veranschaulicht.

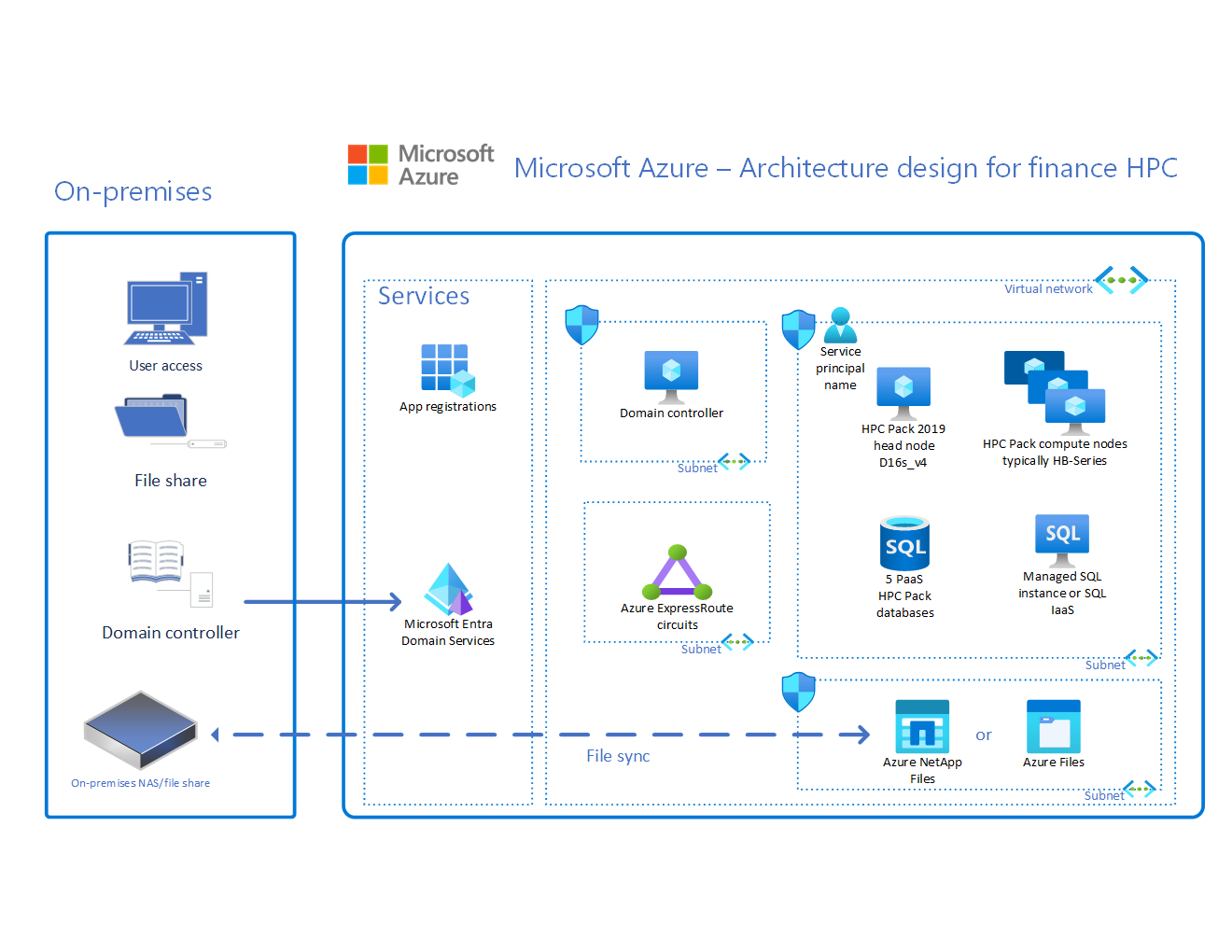

Beispiel einer konzeptionellen Referenzarchitektur im Finanzsektor

Die folgende konzeptionelle Referenzarchitektur ist ein Beispiel, das Entwurfsbereiche und bewährte Methoden für Umgebungen im Finanzsektor veranschaulicht.

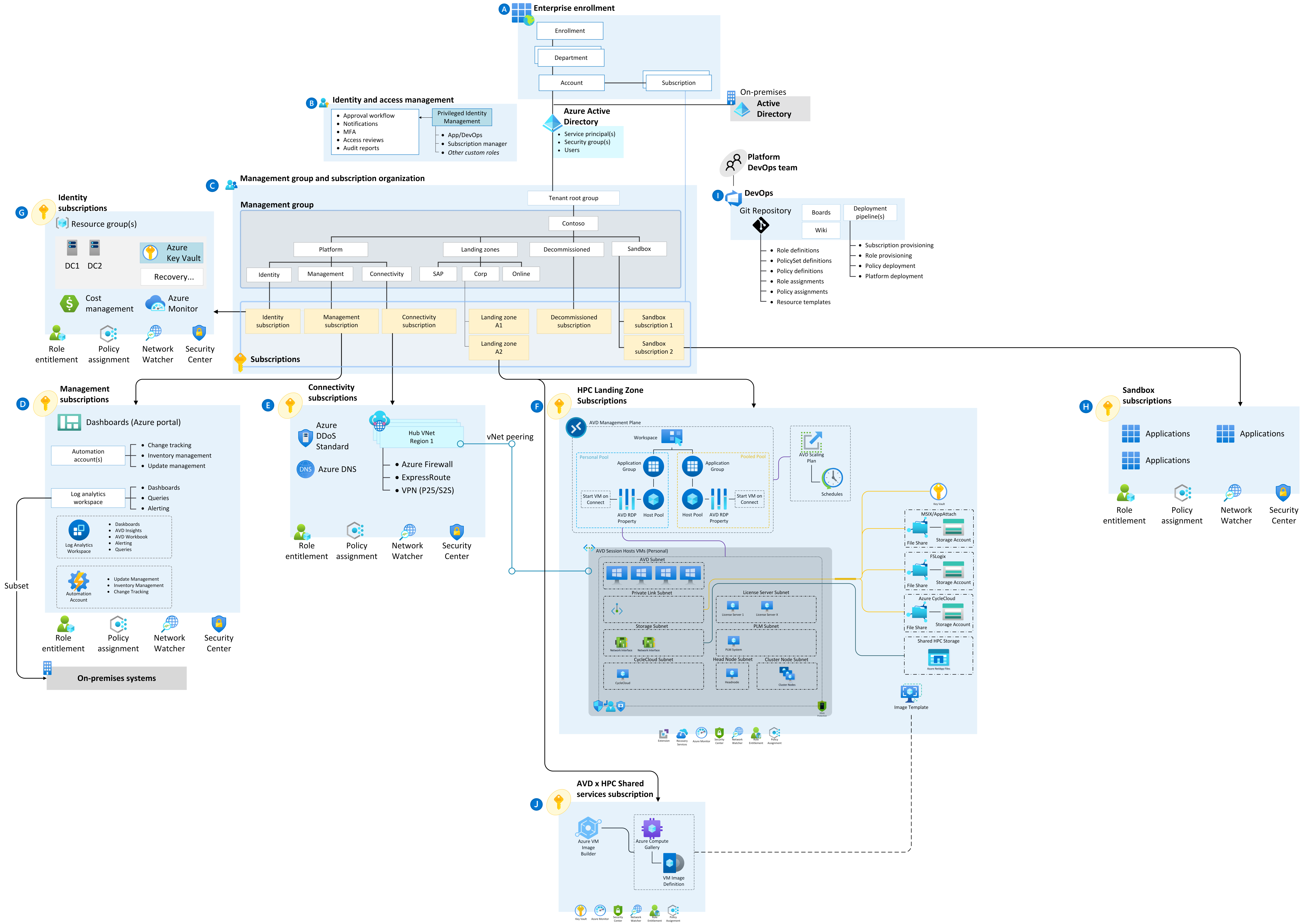

Beispiel einer konzeptionellen Referenzarchitektur für den Fertigungssektor

Die folgende konzeptionelle Referenzarchitektur ist ein Beispiel, das Entwurfsbereiche und bewährte Methoden für Umgebungen im Finanzsektor veranschaulicht.

Herunterladen des Zielzonenbeschleunigers für HPC

Der Zielzonenbeschleuniger für HPC ist auf GitHub verfügbar: Azure HPC OnDemand Platform Accelerator

Nächste Schritte

Überlegungen und Empfehlungen für die Architektur Ihres Zielzonenbeschleunigers für HPC finden Sie in den kritischen Entwurfsbereichen des Zielzonenbeschleunigers für HPC unter Identitäts- und Zugriffsverwaltung für Azure HPC.