Bereitstellen Ihres professionellen VoIP-Modells als Endpunkt

Nachdem Sie Ihr Stimmmodell erfolgreich erstellt und trainiert haben, stellen Sie es auf einem Endpunkt für benutzerdefinierte neuronale Stimmen bereit.

Hinweis

Sie können bis zu 50 Endpunkte mit einer Standard-Sprachressource (S0) erstellen, jeder mit seiner eigenen benutzerdefinierten neuronalen Stimme.

Um Ihre benutzerdefinierte neuronale Stimme zu verwenden, müssen Sie den Namen des Stimmmodells angeben und die benutzerdefinierte URI direkt in einer HTTP-Anforderung verwenden. Außerdem müssen Sie die gleiche Sprachressource verwenden, um die Authentifizierung des Sprachsynthese-Dienstes zu durchlaufen.

Hinzufügen eines Bereitstellungsendpunkts

So erstellen Sie einen Endpunkt für benutzerdefinierte neuronale Stimmen

Melden Sie sich in Speech Studio an.

Wählen Sie Custom Voice> Ihr Projektname >Modell bereitstellen>Modell bereitstellen aus.

Wählen Sie ein Stimmmodell aus, das Sie diesem Endpunkt zuordnen möchten.

Geben Sie als nächstes einen Wert für Name und eine Beschreibung für Ihren benutzerdefinierten Endpunkt ein.

Wählen Sie den Typ des Endpunkts entsprechend Ihrem Szenario aus. Wenn sich Ihre Ressource in einer unterstützten Region befindet, lautet die Standardeinstellung für den Endpunkttyp Hohe Leistung. Andernfalls, wenn sich die Ressource in einer nicht unterstützten Region befindet, ist die einzige verfügbare Option Schnelle Fortsetzung.

- Hohe Leistung: Optimiert für Szenarien mit Syntheseanforderungen in Echtzeit und hohem Volumen, z. B. Konversations-KI, Callcenter-Bots. Die Bereitstellung oder Fortsetzung eines Endpunkts dauert etwa 5 Minuten. Informationen zu Regionen, in denen der Endpunkttyp für Hohe Leistung unterstützt wird, finden Sie in den Fußnoten der Tabelle der Regionen.

- Schnelle Fortsetzung: Optimiert für Audioinhaltserstellungsszenarien mit weniger häufigen Syntheseanforderungen. Einfache und schnelle Bereitstellung oder Fortsetzung eines Endpunkts in unter einer Minute. Der Endpunkttyp Schnelle Fortsetzung wird in allen Regionen unterstützt, in denen Text-zu-Sprache verfügbar ist.

Wählen Sie Bereitstellen aus, um Ihren Endpunkt zu erstellen.

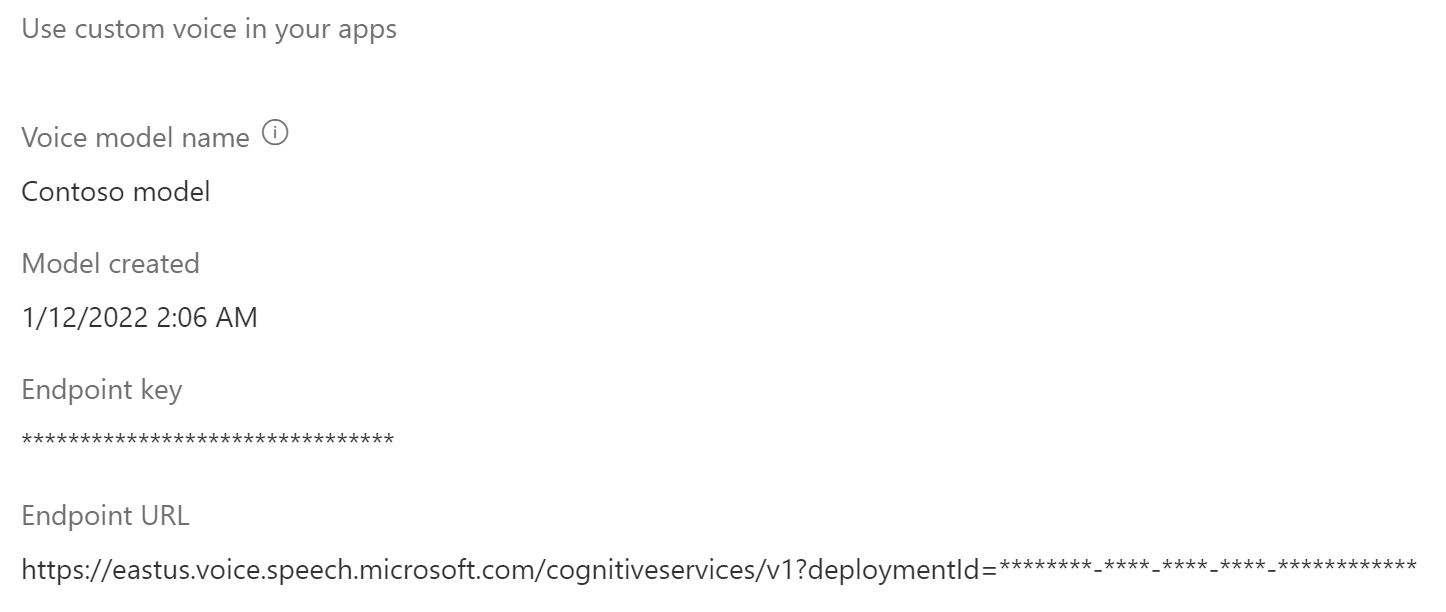

Nachdem Sie Ihren Endpunkt bereitgestellt haben, wird sein Name als Link angezeigt. Wählen Sie den Link aus, um spezifische Informationen zu Ihrem Endpunkt anzuzeigen (z. B. Endpunktschlüssel, Endpunkt-URL und Beispielcode). Wenn als Bereitstellungsstatus Erfolgreich angezeigt wird, kann der Endpunkt verwendet werden.

Anwendungseinstellungen

Die Anwendungseinstellungen, die Sie als REST-API-Anforderungsparameter verwenden, sind auf der Registerkarte Deploy-Modell in Speech Studio verfügbar.

- Der Endpunktschlüssel zeigt den Speech-Ressourcenschlüssel an, der dem Endpunkt zugeordnet ist. Verwenden Sie den Endpunktschlüssel als Wert für Ihren

Ocp-Apim-Subscription-Key-Anforderungsheader. - Die Endpunkt-URL zeigt Ihre Dienstregion an. Verwenden Sie den Wert vor

voice.speech.microsoft.comals Anforderungsparameter für die Dienstregion. Verwenden Sie beispielsweiseeastus, wenn die Endpunkt-URLhttps://eastus.voice.speech.microsoft.com/cognitiveservices/v1lautet. - Die Endpunkt-URL zeigt Ihre Endpunkt-ID an. Verwenden Sie den an den Abfrageparameter

?deploymentId=angefügten Wert als Wert für den Endpunkt-ID-Anforderungsparameter.

Verwenden Ihrer benutzerdefinierten Stimme

Der benutzerdefinierte Endpunkt verfügt über dieselben Funktionen wie der Standardendpunkt für Sprachsynthese-Anforderungen.

Ein Unterschied besteht darin, dass die EndpointId angegeben werden muss, wenn die benutzerdefinierte Stimme über das Speech SDK verwendet werden soll. Sie können mit dem Sprachsynthese-Schnellstart beginnen und dann den Code mit EndpointId und SpeechSynthesisVoiceNameaktualisieren. Weitere Informationen finden Sie unter Verwenden eines benutzerdefinierten Endpunkts.

Zum Verwenden einer benutzerdefinierten neuronalen Stimme mithilfe von Speech Synthesis Markup Language (SSML) geben Sie den Modellnamen als Stimmnamen an. In diesem Beispiel wird die Stimme YourCustomVoiceName verwendet.

<speak version="1.0" xmlns="http://www.w3.org/2001/10/synthesis" xml:lang="en-US">

<voice name="YourCustomVoiceName">

This is the text that is spoken.

</voice>

</speak>

Wechseln zu einem neuen Stimmmodell in Ihrem Produkt

Nachdem Sie Ihr Stimmmodell auf die neueste Modulversion aktualisiert haben oder wenn Sie in Ihrem Produkt zu einer neuen Stimme wechseln möchten, müssen Sie das neue Stimmmodell auf einen neuen Endpunkt erneut bereitstellen. Die erneute Bereitstellung eines neuen Stimmmodells auf Ihrem vorhandenen Endpunkt wird nicht unterstützt. Leiten Sie nach der Bereitstellung den Datenverkehr zu dem neu erstellten Endpunkt. Es wird empfohlen, den Datenverkehr zum neuen Endpunkt zuerst in eine Testumgebung zu übertragen, um sicherzustellen, dass alles funktioniert, und erst dann zum neuen Endpunkt in der Produktionsumgebung zu wechseln. Während der Übergangsphase müssen Sie den alten Endpunkt beibehalten. Wenn in der Übergangsphase Probleme mit dem neuen Endpunkt auftreten, können Sie wieder zum alten Endpunkt wechseln. Wenn der Datenverkehr etwa 24 Stunden lang (empfohlener Wert) ordnungsgemäß auf dem neuen Endpunkt ausgeführt wurde, können Sie Ihren alten Endpunkt löschen.

Hinweis

Wenn sich der Name der Stimme ändert und Sie die Speech Synthesis Markup Language (SSML) verwenden, müssen Sie den neuen Stimmnamen in SSML verwenden.

Anhalten und Fortsetzen eines Endpunkts

Sie können einen Endpunkt anhalten oder fortsetzen, um die Kosten zu begrenzen und nicht genutzte Ressourcen freizugeben. Während der Endpunkt angehalten ist, werden Ihnen keine Gebühren berechnet. Wenn Sie einen Endpunkt fortsetzen, können Sie in Ihrer Anwendung weiterhin dieselbe Endpunkt-URL für die Sprachsynthese verwenden.

Hinweis

Der Vorgang zum Anhalten wird nahezu sofort ausgeführt. Der Vorgang zum Fortsetzen dauert in etwa so lange wie eine neue Bereitstellung.

In diesem Abschnitt wird beschrieben, wie Sie einen Endpunkt für benutzerdefinierte neuronale Stimmen in Speech Studio anhalten und fortsetzen.

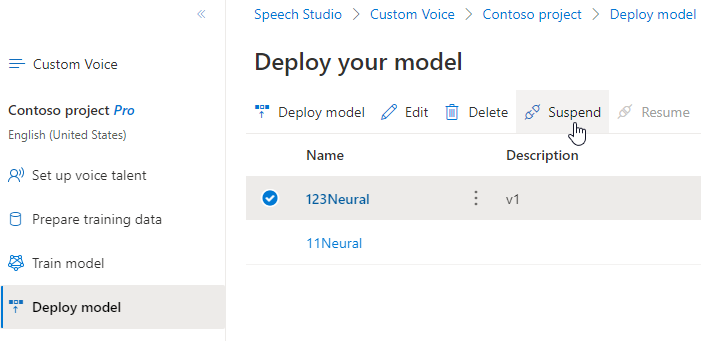

Anhalten eines Endpunkts

Wählen Sie zum Anhalten und Deaktivieren Ihres Endpunkts in Speech Studio auf der Registerkarte Modell bereitstellen die Option Anhalten aus.

Wählen Sie im angezeigten Dialogfeld Übermitteln aus. Nachdem der Endpunkt angehalten wurde, zeigt Speech Studio die Benachrichtigung Endpunkt erfolgreich angehalten an.

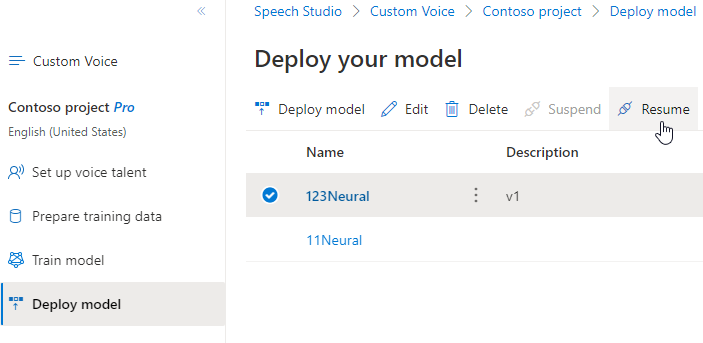

Fortsetzen des Endpunkts

Wählen Sie zum Fortsetzen und Aktivieren Ihres Endpunkts in Speech Studio auf der Registerkarte Modell bereitstellen die Option Fortsetzen aus.

Wählen Sie im angezeigten Dialogfeld Übermitteln aus. Nachdem Sie den Endpunkt erfolgreich reaktiviert haben, ändert sich der Status von Angehalten in Erfolgreich.

Nächste Schritte

Nachdem Sie Ihr Stimmmodell erfolgreich erstellt und trainiert haben, stellen Sie es auf einem Endpunkt für benutzerdefinierte neuronale Stimmen bereit.

Hinweis

Sie können bis zu 50 Endpunkte mit einer Standard-Sprachressource (S0) erstellen, jeder mit seiner eigenen benutzerdefinierten neuronalen Stimme.

Hinzufügen eines Bereitstellungsendpunkts

Verwenden Sie zum Erstellen eines Endpunkts den Vorgang Endpoints_Create der Custom Voice-API. Erstellen Sie den Anforderungstext gemäß den folgenden Anweisungen:

- Legen Sie die erforderliche

projectId-Eigenschaft fest. Siehe Erstellen eines Projekts. - Legen Sie die erforderliche

modelId-Eigenschaft fest. Siehe Trainieren eines Sprachmodells. - Legen Sie die erforderliche

description-Eigenschaft fest. Die Beschreibung kann später geändert werden.

Senden Sie eine HTTP PUT-Anforderung, und verwenden Sie dabei den URI, wie im folgenden Beispiel für Endpoints_Create gezeigt.

- Ersetzen Sie

YourResourceKeydurch Ihren Speech-Ressourcenschlüssel. - Ersetzen Sie

YourResourceRegiondurch Ihre Speech-Ressourcenregion. - Ersetzen Sie

EndpointIddurch eine Endpunkt-ID Ihrer Wahl. Die ID muss eine GUID sein und innerhalb Ihrer Speech-Ressource eindeutig sein. Die ID wird in der URI des Projekts verwendet und kann später nicht mehr geändert werden.

curl -v -X PUT -H "Ocp-Apim-Subscription-Key: YourResourceKey" -H "Content-Type: application/json" -d '{

"description": "Endpoint for Jessica voice",

"projectId": "ProjectId",

"modelId": "JessicaModelId",

} ' "https://YourResourceRegion.api.cognitive.microsoft.com/customvoice/endpoints/EndpointId?api-version=2023-12-01-preview"

Sie sollten einen Antworttext im folgenden Format erhalten:

{

"id": "9f50c644-2121-40e9-9ea7-544e48bfe3cb",

"description": "Endpoint for Jessica voice",

"projectId": "ProjectId",

"modelId": "JessicaModelId",

"properties": {

"kind": "HighPerformance"

},

"status": "NotStarted",

"createdDateTime": "2023-04-01T05:30:00.000Z",

"lastActionDateTime": "2023-04-02T10:15:30.000Z"

}

Der Antwortheader enthält die Operation-Location-Eigenschaft. Verwenden Sie diesen URI, um Details zum Endpoints_Create-Vorgang abzurufen. Hier ist ein Beispiel für die Antwort:

Operation-Location: https://eastus.api.cognitive.microsoft.com/customvoice/operations/284b7e37-f42d-4054-8fa9-08523c3de345?api-version=2023-12-01-preview

Operation-Id: 284b7e37-f42d-4054-8fa9-08523c3de345

Sie verwenden den Endpunkt Operation-Location in nachfolgenden API-Anforderungen, um einen Endpunkt anzusetzen und fortzusetzen und einen Endpunktzu löschen.

Verwenden Ihrer benutzerdefinierten Stimme

Um Ihre benutzerdefinierte neuronale Stimme zu verwenden, müssen Sie den Namen des Stimmmodells angeben und die benutzerdefinierte URI direkt in einer HTTP-Anforderung verwenden. Außerdem müssen Sie die gleiche Sprachressource verwenden, um die Authentifizierung des Sprachsynthese-Dienstes zu durchlaufen.

Der benutzerdefinierte Endpunkt verfügt über dieselben Funktionen wie der Standardendpunkt für Sprachsynthese-Anforderungen.

Ein Unterschied besteht darin, dass die EndpointId angegeben werden muss, wenn die benutzerdefinierte Stimme über das Speech SDK verwendet werden soll. Sie können mit dem Sprachsynthese-Schnellstart beginnen und dann den Code mit EndpointId und SpeechSynthesisVoiceNameaktualisieren. Weitere Informationen finden Sie unter Verwenden eines benutzerdefinierten Endpunkts.

Zum Verwenden einer benutzerdefinierten neuronalen Stimme mithilfe von Speech Synthesis Markup Language (SSML) geben Sie den Modellnamen als Stimmnamen an. In diesem Beispiel wird die Stimme YourCustomVoiceName verwendet.

<speak version="1.0" xmlns="http://www.w3.org/2001/10/synthesis" xml:lang="en-US">

<voice name="YourCustomVoiceName">

This is the text that is spoken.

</voice>

</speak>

Anhalten eines Endpunkts

Sie können einen Endpunkt anhalten oder fortsetzen, um die Kosten zu begrenzen und nicht genutzte Ressourcen freizugeben. Während der Endpunkt angehalten ist, werden Ihnen keine Gebühren berechnet. Wenn Sie einen Endpunkt fortsetzen, können Sie in Ihrer Anwendung weiterhin dieselbe Endpunkt-URL für die Sprachsynthese verwenden.

Verwenden Sie zum Anhalten eines Endpunkts den Vorgang Endpoints_Suspend der Custom Voice-API.

Senden Sie eine HTTP POST-Anforderung, und verwenden Sie dabei den URI, wie im folgenden Beispiel für Endpoints_Suspend gezeigt.

- Ersetzen Sie

YourResourceKeydurch Ihren Speech-Ressourcenschlüssel. - Ersetzen Sie

YourResourceRegiondurch Ihre Speech-Ressourcenregion. - Ersetzen Sie

YourEndpointIddurch die Endpunkt-ID, die Sie beim Erstellen des Endpunkts erhalten haben.

curl -v -X POST "https://YourResourceRegion.api.cognitive.microsoft.com/customvoice/endpoints/YourEndpointId:suspend?api-version=2023-12-01-preview" -H "Ocp-Apim-Subscription-Key: YourResourceKey" -H "content-type: application/json" -H "content-length: 0"

Sie sollten einen Antworttext im folgenden Format erhalten:

{

"id": "9f50c644-2121-40e9-9ea7-544e48bfe3cb",

"description": "Endpoint for Jessica voice",

"projectId": "ProjectId",

"modelId": "JessicaModelId",

"properties": {

"kind": "HighPerformance"

},

"status": "Disabling",

"createdDateTime": "2023-04-01T05:30:00.000Z",

"lastActionDateTime": "2023-04-02T10:15:30.000Z"

}

Fortsetzen eines Endpunkts

Verwenden Sie zum Anhalten eines Endpunkts den Vorgang Endpoints_Resume der Custom Voice-API.

Senden Sie eine HTTP POST-Anforderung, und verwenden Sie dabei den URI, wie im folgenden Beispiel für Endpoints_Resume gezeigt.

- Ersetzen Sie

YourResourceKeydurch Ihren Speech-Ressourcenschlüssel. - Ersetzen Sie

YourResourceRegiondurch Ihre Speech-Ressourcenregion. - Ersetzen Sie

YourEndpointIddurch die Endpunkt-ID, die Sie beim Erstellen des Endpunkts erhalten haben.

curl -v -X POST "https://YourResourceRegion.api.cognitive.microsoft.com/customvoice/endpoints/YourEndpointId:resume?api-version=2023-12-01-preview" -H "Ocp-Apim-Subscription-Key: YourResourceKey" -H "content-type: application/json" -H "content-length: 0"

Sie sollten einen Antworttext im folgenden Format erhalten:

{

"id": "9f50c644-2121-40e9-9ea7-544e48bfe3cb",

"description": "Endpoint for Jessica voice",

"projectId": "ProjectId",

"modelId": "JessicaModelId",

"properties": {

"kind": "HighPerformance"

},

"status": "Running",

"createdDateTime": "2023-04-01T05:30:00.000Z",

"lastActionDateTime": "2023-04-02T10:15:30.000Z"

}

Einen Endpunkt löschen

Verwenden Sie zum Löschen eines Endpunkts den Vorgang Endpoints_Delete der Custom Voice-API.

Erstellen Sie eine HTTP DELETE-Anforderung, und verwenden Sie dabei den URI, wie im folgenden Beispiel für Endpoints_Delete gezeigt.

- Ersetzen Sie

YourResourceKeydurch Ihren Speech-Ressourcenschlüssel. - Ersetzen Sie

YourResourceRegiondurch Ihre Speech-Ressourcenregion. - Ersetzen Sie

YourEndpointIddurch die Endpunkt-ID, die Sie beim Erstellen des Endpunkts erhalten haben.

curl -v -X DELETE "https://YourResourceRegion.api.cognitive.microsoft.com/customvoice/endpoints/YourEndpointId?api-version=2023-12-01-preview" -H "Ocp-Apim-Subscription-Key: YourResourceKey"

Sie sollten einen Antwortheader mit Statuscode 204 erhalten.

Wechseln zu einem neuen Stimmmodell in Ihrem Produkt

Nachdem Sie Ihr Stimmmodell auf die neueste Modulversion aktualisiert haben oder wenn Sie in Ihrem Produkt zu einer neuen Stimme wechseln möchten, müssen Sie das neue Stimmmodell auf einen neuen Endpunkt erneut bereitstellen. Die erneute Bereitstellung eines neuen Stimmmodells auf Ihrem vorhandenen Endpunkt wird nicht unterstützt. Leiten Sie nach der Bereitstellung den Datenverkehr zu dem neu erstellten Endpunkt. Es wird empfohlen, den Datenverkehr zum neuen Endpunkt zuerst in eine Testumgebung zu übertragen, um sicherzustellen, dass alles funktioniert, und erst dann zum neuen Endpunkt in der Produktionsumgebung zu wechseln. Während der Übergangsphase müssen Sie den alten Endpunkt beibehalten. Wenn in der Übergangsphase Probleme mit dem neuen Endpunkt auftreten, können Sie wieder zum alten Endpunkt wechseln. Wenn der Datenverkehr etwa 24 Stunden lang (empfohlener Wert) ordnungsgemäß auf dem neuen Endpunkt ausgeführt wurde, können Sie Ihren alten Endpunkt löschen.

Hinweis

Wenn sich der Name der Stimme ändert und Sie die Speech Synthesis Markup Language (SSML) verwenden, müssen Sie den neuen Stimmnamen in SSML verwenden.