Importieren von DAGs mithilfe von Azure Blob Storage

Hinweis

Dieses Feature befindet sich in der Phase der öffentlichen Vorschau. Workflow Orchestration Manager wird von Apache Airflow unterstützt.

In diesem Artikel wird Schritt für Schritt beschrieben, wie Sie gerichtete azyklische Graphen (Directed Acyclic Graphas, DAGs) mithilfe von Azure Blob Storage in Workflow Orchestration Manager importieren.

Voraussetzungen

- Azure-Abonnement: Wenn Sie über kein Azure-Abonnement verfügen, können Sie ein kostenloses Azure-Konto erstellen, bevor Sie beginnen.

- Azure Data Factory: Erstellen Sie eine Data Factory-Instanz in einer Region, in der die Vorschau von Workflow Orchestration Manager unterstützt wird, oder wählen Sie eine vorhandene Instanz aus.

- Azure Storage-Konto: Wenn Sie kein Speicherkonto haben, finden Sie unter Erstellen eines Azure Storage-Kontos die erforderlichen Schritte zum Erstellen eines solchen Kontos. Stellen Sie sicher, dass das Speicherkonto nur den Zugriff über ausgewählte Netzwerke zulässt.

Blob Storage hinter virtuellen Netzwerken wird während der Vorschau nicht unterstützt. Die Azure Key Vault-Konfiguration in storageLinkedServices wird zum Importieren von DAGs nicht unterstützt.

Importieren von DAGs

Kopieren Sie entweder Sample Apache Airflow v2.x DAG oder Sample Apache Airflow v1.10 DAG basierend auf der von Ihnen eingerichteten Airflow-Umgebung. Fügen Sie den Inhalt in eine neue Datei mit dem Namen tutorial.py ein.

Laden Sie die Datei tutorial.py in Blob Storage hoch. Weitere Informationen finden Sie unter Hochladen einer Datei in ein Blob.

Hinweis

Sie müssen einen Verzeichnispfad aus einem Blob Storage-Konto auswählen, das Ordner mit dem Namen dags und plugins enthält, um sie in die Airflow-Umgebung zu importieren. Plug-Ins sind nicht obligatorisch. Sie können auch einen Container mit dem Namen dags verwenden und alle Airflow-Dateien in ihn hochladen.

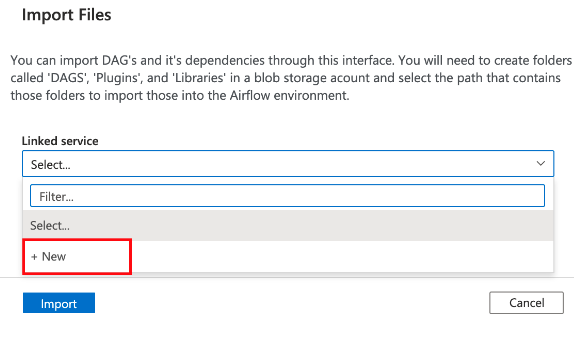

Wählen Sie unter dem Hub Verwalten die Option Apache Airflow aus. Zeigen Sie dann auf die zuvor erstellte Airflow-Umgebung, und wählen Sie Dateien importieren aus, um alle DAGs und Abhängigkeiten in die Airflow-Umgebung zu importieren.

Erstellen Sie einen neuen verknüpften Dienst für das im Abschnitt „Voraussetzungen“ genannte barrierefreie Speicherkonto. Sie können auch einen vorhandenen Dienst verwenden, wenn Sie bereits über eigene DAGs verfügen.

Verwenden Sie das Speicherkonto, in das Sie den DAG hochgeladen haben. (Überprüfen Sie den Abschnitt „Voraussetzungen“.) Testen Sie die Verbindung, und klicken Sie auf Erstellen.

Suchen Sie nach Airflow, und wählen Sie diese Option aus, wenn Sie die SAS-Beispiel-URL verwenden. Sie können auch den Ordner auswählen, der den Ordner dags mit DAG-Dateien enthält.

Hinweis

Sie können DAGs und deren Abhängigkeiten über diese Schnittstelle importieren. Sie müssen einen Verzeichnispfad aus einem Blob Storage-Konto auswählen, das Ordner mit dem Namen dags und plugins enthält, um diese in die Airflow-Umgebung zu importieren. Plug-Ins sind nicht obligatorisch.

Wählen Sie Importieren aus, um Dateien zu importieren.

Das Importieren von DAGs kann während der Vorschau einige Minuten dauern. Mithilfe der Benachrichtigungszentrale (Glockensymbol auf der Data Factory-Benutzeroberfläche) können Sie die Aktualisierungen des Importstatus nachverfolgen.