Laden von Daten aus Microsoft 365 (Office 365) mithilfe von Azure Data Factory

GILT FÜR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tipp

Testen Sie Data Factory in Microsoft Fabric, eine All-in-One-Analyselösung für Unternehmen. Microsoft Fabric deckt alle Aufgaben ab, von der Datenverschiebung bis hin zu Data Science, Echtzeitanalysen, Business Intelligence und Berichterstellung. Erfahren Sie, wie Sie kostenlos eine neue Testversion starten!

In diesem Artikel wird gezeigt, wie Sie mithilfe von Data Factory Daten aus Microsoft 365 (Office 365) in Azure Blob Storage laden. Zum Kopieren von Daten in Azure Data Lake Gen1 oder Gen2 werden ähnliche Schritte ausgeführt. Lesen Sie den Artikel zum Microsoft 365-Connector (Office 365) zum Kopieren von Daten aus Microsoft 365 (Office 365) im Allgemeinen.

Erstellen einer Data Factory

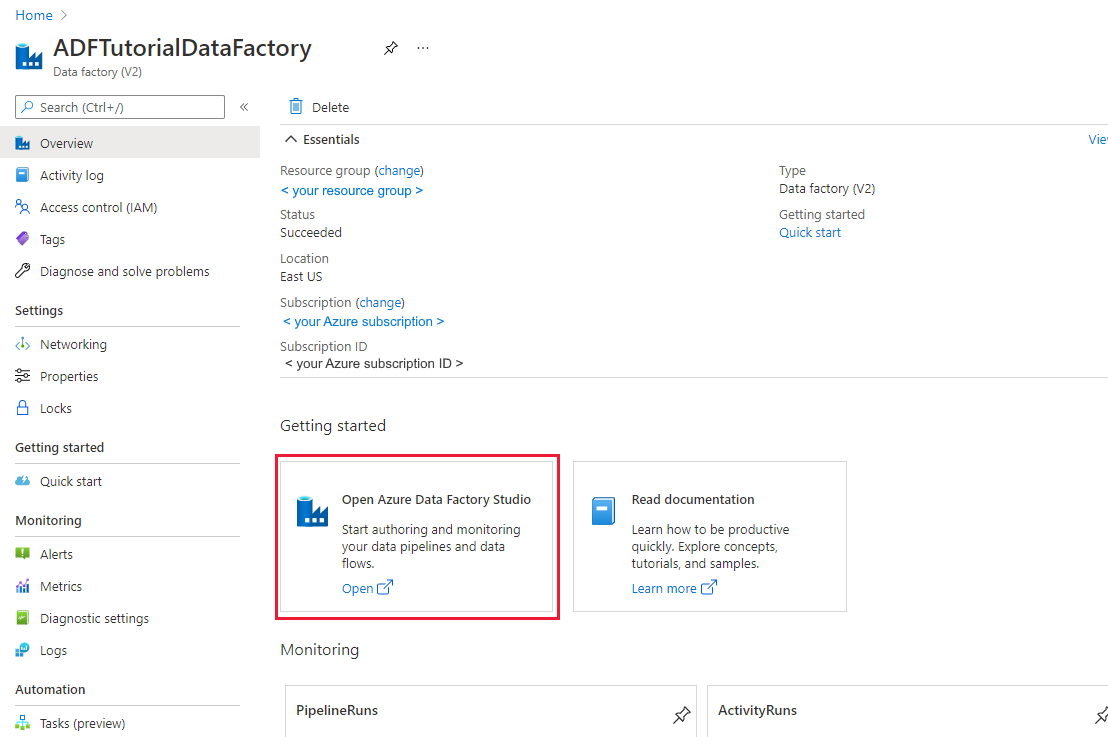

Wenn Sie Ihre Data Factory noch nicht erstellt haben, befolgen Sie die Schritte im Schnellstart: Erstellen einer Data Factory mithilfe des Azure-Portals und Azure Data Factory Studio, um eine zu erstellen. Navigieren Sie nach dem Erstellen zur Data Factory im Azure-Portal.

Klicken Sie auf der Kachel Open Azure Data Factory Studio auf Öffnen, um die Datenintegrationsanwendung in einer separaten Registerkarte zu starten.

Erstellen einer Pipeline

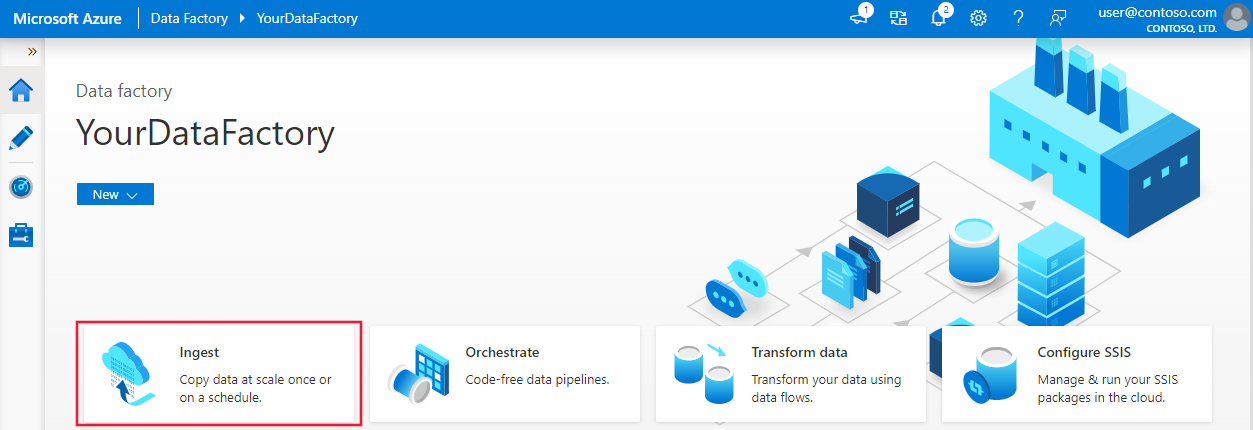

Wählen Sie auf der Startseite die Option Orchestrieren aus.

Geben Sie auf der Registerkarte Allgemein der Pipeline als Name der Pipeline „CopyPipeline“ ein.

Ziehen Sie im Feld "Aktivitäten" > die Kategorie > "Verschieben und Transformieren" und legen Sie die Copy-Aktivität aus dem Toolfeld auf die Pipeline-Designeroberfläche ab. Geben Sie „CopyFromOffice365ToBlob“ als Aktivitätsnamen an.

Hinweis

Verwenden Sie Azure Integration Runtime sowohl in verknüpften Quellen- als auch in Senkendiensten. Die selbstgehostete Integration Runtime und die verwaltete Integration Runtime für virtuelle Netzwerke werden nicht unterstützt.

Konfigurieren der Quelle

Navigieren Sie zur Pipeline und zur Registerkarte >Quelle, und wählen Sie + Neu aus, um ein Quelldataset zu erstellen.

Wählen Sie im Fenster „Neues Dataset“ die Option Microsoft 365 (Office 365) aus, und klicken Sie dann auf Weiter.

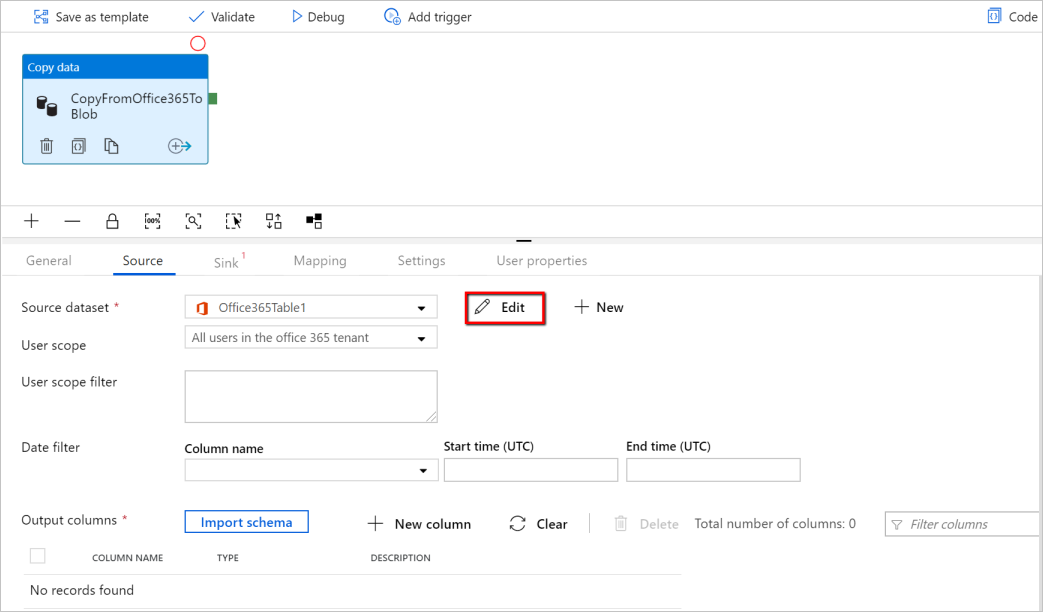

Sie befinden sich jetzt auf der Registerkarte zum Konfigurieren der Kopieraktivität. Klicken Sie auf die Schaltfläche Bearbeiten neben dem Microsoft 365 (Office 365)-Dataset, um die Datenkonfiguration fortzusetzen.

Eine neue Registerkarte für das Microsoft 365 (Office 365)-Dataset wird geöffnet. Geben Sie unten im Eigenschaftenfenster auf der Registerkarte Allgemein unter „Name“ den Namen „SourceOffice365Dataset“ ein.

Wechseln Sie im Eigenschaftenfenster zur Registerkarte Verbindung. Klicken Sie neben dem Textfeld „Verknüpfter Dienst“ auf + Neu.

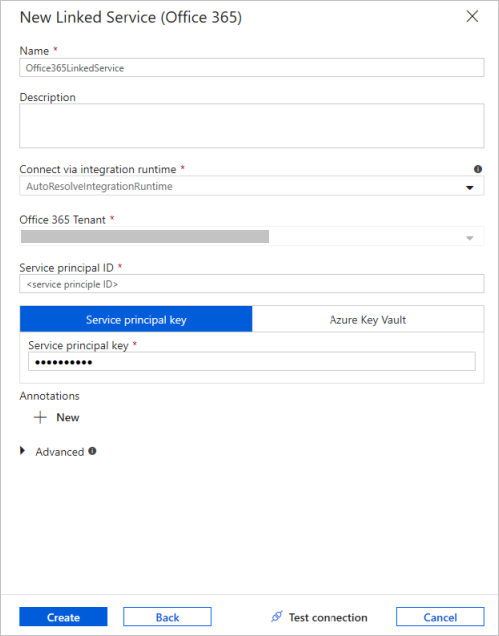

Geben Sie im Fenster „New Linked Service“ (Neuer verknüpfter Dienst) als Name „Office365LinkedService“ sowie die Dienstprinzipal-ID und den Dienstprinzipalschlüssel ein. Testen Sie anschließend die Verbindung, und wählen Sie Erstellen aus, um den verknüpften Dienst bereitzustellen.

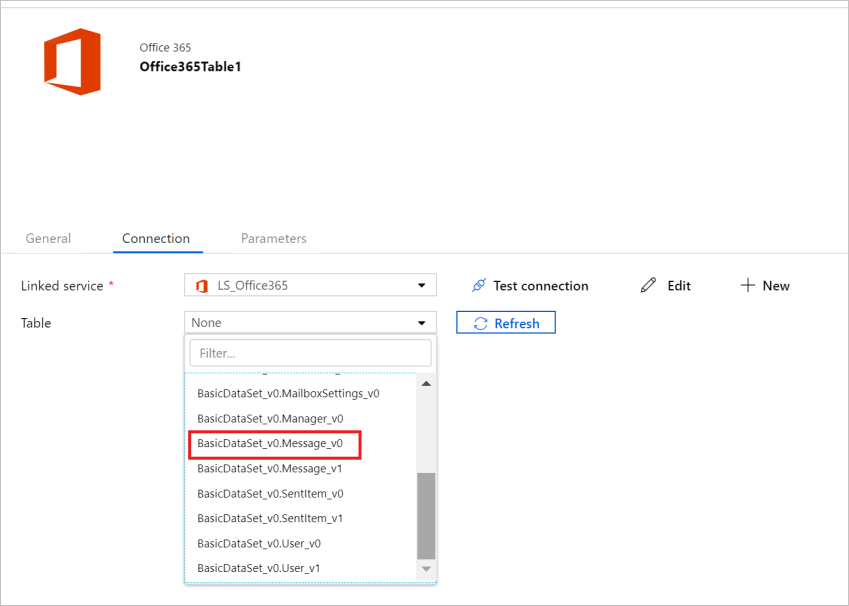

Nach der Erstellung des verknüpften Diensts werden wieder die Dataseteinstellungen angezeigt. Klicken Sie neben Tabelle auf den Pfeil nach unten, um die Liste der verfügbaren Microsoft 365 (Office 365)-Datasets zu erweitern, und wählen Sie dann in der Dropdownliste „BasicDataSet_v0.Message_v0“ aus:

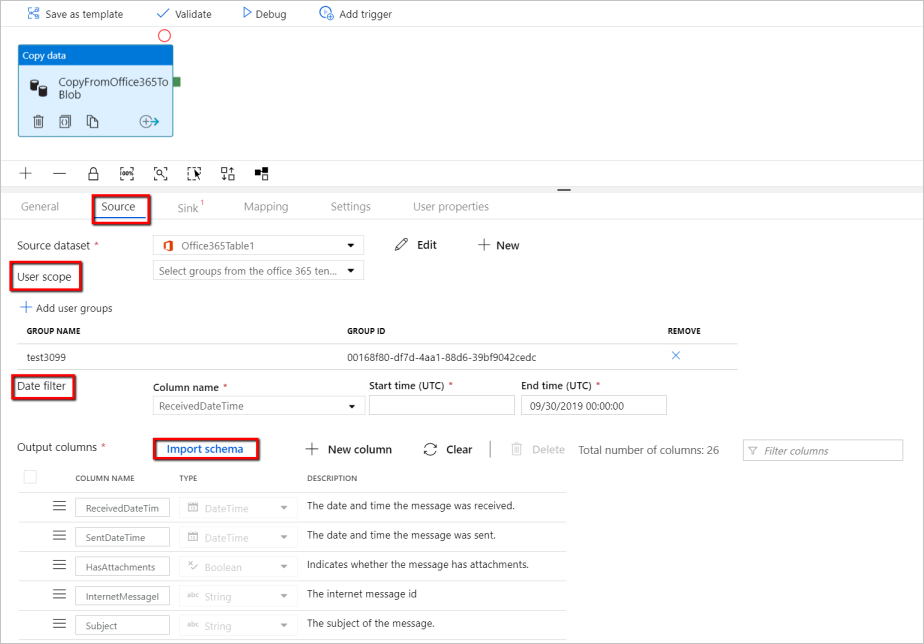

Wechseln Sie nun zurück zur Registerkarte Pipeline>Quelle, um die Konfiguration zusätzlicher Eigenschaften für die Microsoft 365 (Office 365)-Datenextraktion fortzusetzen. Benutzerbereich und Benutzerbereichsfilter sind optionale Prädikate, die Sie definieren können, um die Daten einzuschränken, die aus Microsoft 365 (Office 365) extrahiert werden sollen. Informationen zum Konfigurieren dieser Einstellungen finden Sie im Abschnitt Microsoft 365 (Office 365) – Dataset-Eigenschaften.

Sie müssen einen der Datumsfilter auswählen und Werte für die Start- und Endzeit angeben.

Klicken Sie auf die Registerkarte Schema importieren, um das Schema für das Nachrichtendataset zu importieren.

Konfigurieren der Senke

Wechseln Sie zur Pipeline und zur >Registerkarte Senke, und wählen Sie + Neu aus, um ein Senkendataset zu erstellen.

Im Fenster „Neues Dataset“ werden beim Kopieren aus Microsoft 365 (Office 365) nur die unterstützten Ziele ausgewählt. Wählen Sie Azure Blob Storage, das Binärformat und dann Weiter aus. In diesem Tutorial kopieren Sie Microsoft 365 (Office 365)-Daten in Azure Blob Storage.

Klicken Sie neben dem Azure Blob Storage-Dataset auf die Schaltfläche Bearbeiten, um die Datenkonfiguration fortzusetzen.

Geben Sie im Eigenschaftenfenster auf der Registerkarte Allgemein unter „Name“ den Namen „OutputBlobDataset“ ein.

Wechseln Sie im Eigenschaftenfenster zur Registerkarte Verbindung. Klicken Sie neben dem Textfeld „Verknüpfter Dienst“ auf + Neu.

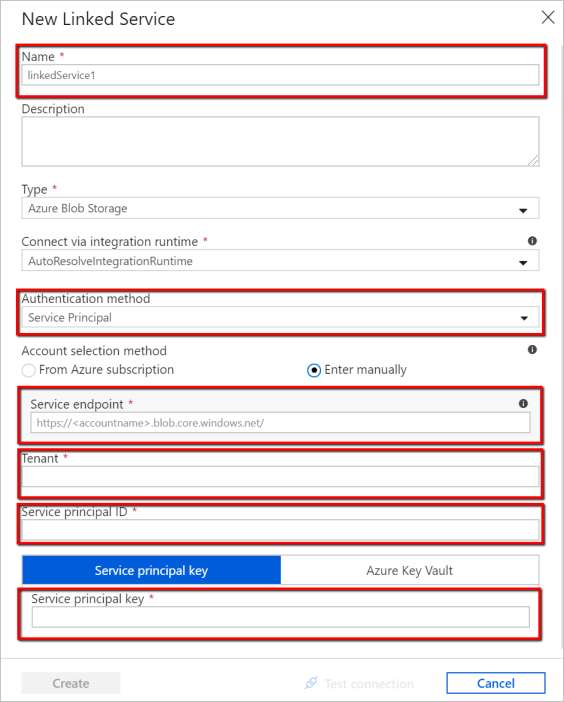

Geben Sie im Fenster „New Linked Service“ (Neuer verknüpfter Dienst) als Name „AzureStorageLinkedService“ ein, wählen Sie in der Dropdownliste der Authentifizierungsmethoden die Option „Dienstprinzipal“ aus, und geben Sie den Dienstendpunkt, den Mandanten, die Dienstprinzipal-ID und den Dienstprinzipalschlüssel ein. Wählen Sie anschließend „Speichern“ aus, um den verknüpften Dienst bereitzustellen. Hier finden Sie Informationen zum Einrichten der Dienstprinzipalauthentifizierung für Azure Blob Storage.

Überprüfen der Pipeline

Klicken Sie auf der Symbolleiste auf Überprüfen, um die Pipeline zu überprüfen.

Sie können den JSON-Code der Pipeline auch anzeigen, indem Sie oben rechts auf „Code“ klicken.

Veröffentlichen der Pipeline

Wählen Sie auf der oberen Symbolleiste Publish All (Alle veröffentlichen). Mit dieser Aktion werden erstellte Entitäten (Datasets und Pipelines) in Data Factory veröffentlicht.

Manuelles Auslösen der Pipeline

Wählen Sie in der Symbolleiste die Option Trigger hinzufügen und dann Jetzt auslösen. Klicken Sie auf der Seite „Pipeline Run“ (Pipelineausführung) auf Fertig stellen.

Überwachen der Pipeline

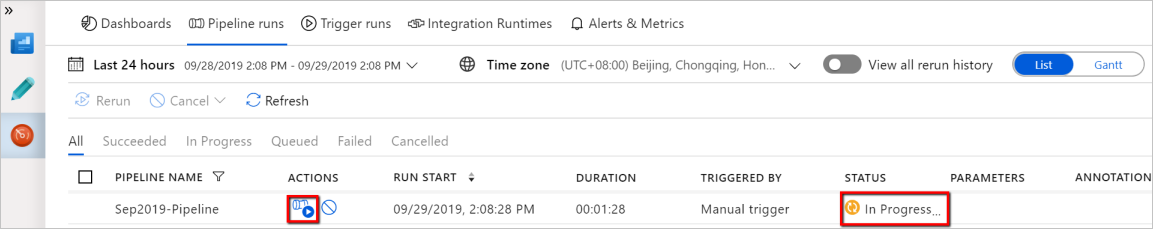

Wechseln Sie links zur Registerkarte Überwachen. Sie sehen eine Pipelineausführung, die von einem manuellen Trigger ausgelöst wird. Sie können über Links in der Spalte Aktionen Aktivitätsdetails anzeigen und die Pipeline erneut ausführen.

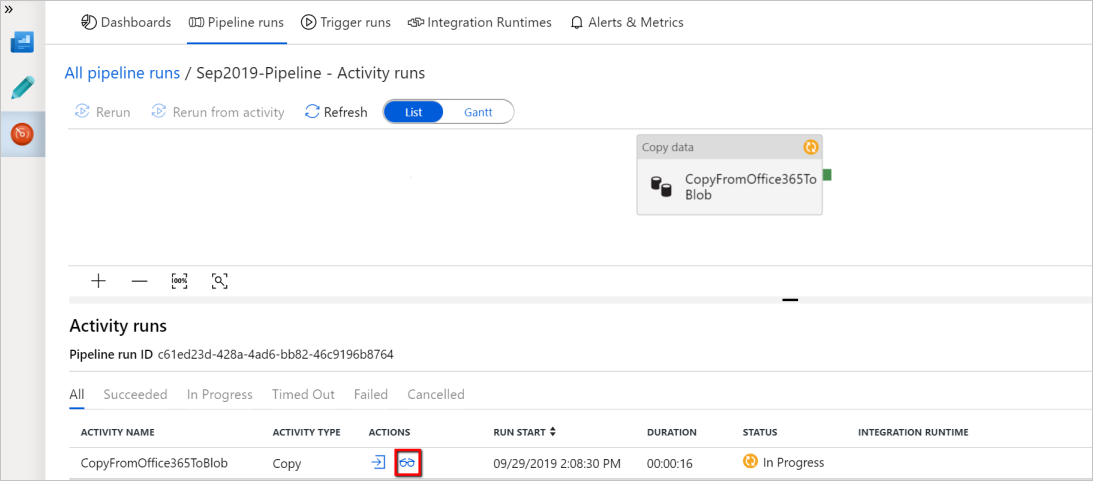

Klicken Sie in der Spalte „Aktionen“ auf den Link View Activity Runs (Aktivitätsausführungen anzeigen), um mit der Pipelineausführung verknüpfte Aktivitätsausführungen anzuzeigen. Da in diesem Beispiel nur eine Aktivität vorhanden ist, wird in der Liste nur ein Eintrag angezeigt. Wenn Sie Details zum Kopiervorgang anzeigen möchten, wählen Sie in der Spalte „Aktionen“ den Link Details (Brillensymbol) aus.

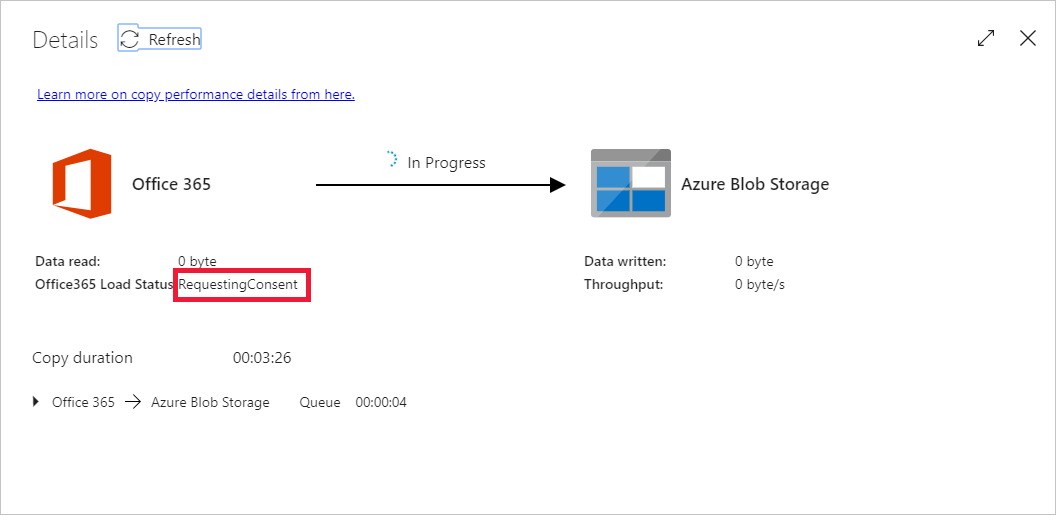

Wenn Sie erstmals Daten für diesen Kontext anfordern (also für eine Kombination daraus, auf welche Datentabelle zugegriffen wird, in welches Zielkonto die Daten geladen werden und welche Benutzeridentität die Datenzugriffsanforderung sendet), wird als Status der Kopieraktivität In Bearbeitung angezeigt. Nur wenn Sie unter „Aktionen“ den Link „Details“ auswählen, wird als Status RequestingConsent angezeigt. Ein Mitglied aus der Gruppe der Datenzugriffsgenehmiger muss die Anforderung in Privileged Access Management genehmigen, bevor die Datenextraktion fortgesetzt werden kann.

Status, in dem Zustimmung angefordert wird:

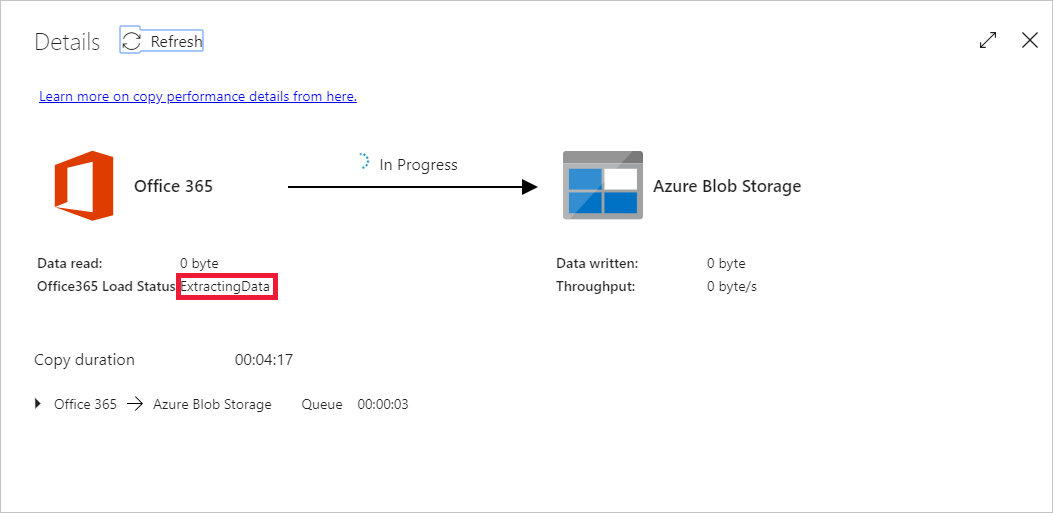

Status, in dem Daten extrahiert werden:

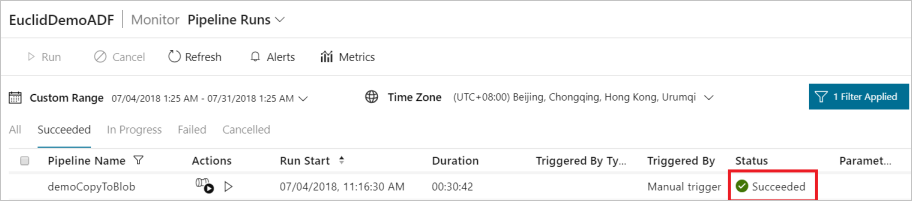

Nach dem Erteilen der Zustimmung wird die Datenextraktion fortgesetzt, und nach einiger Zeit wird die Pipelineausführung als erfolgreich angezeigt.

Navigieren Sie nun zur Azure Blob Storage-Zielinstanz, und überprüfen Sie, ob die Microsoft 365 (Office 365)-Daten im Binärformat extrahiert wurden.

Zugehöriger Inhalt

Lesen Sie den folgenden Artikel, um mehr über die Unterstützung von Azure Synapse Analytics zu erfahren: