Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

GILT FÜR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tipp

Testen Sie Data Factory in Microsoft Fabric, eine All-in-One-Analyselösung für Unternehmen. Microsoft Fabric deckt alle Aufgaben ab, von der Datenverschiebung bis hin zu Data Science, Echtzeitanalysen, Business Intelligence und Berichterstellung. Erfahren Sie, wie Sie kostenlos eine neue Testversion starten!

In diesem Tutorial verwenden Sie das Azure-Portal, um eine Data Factory zu erstellen. Anschließend verwenden Sie das Tool „Daten kopieren“, um eine Pipeline zu erstellen, die neue Dateien basierend auf dem zeitpartitionierten Dateinamen aus einem Azure-Blobspeicher in einen anderen kopiert.

Hinweis

Falls Sie noch nicht mit Azure Data Factory vertraut sind, ist es ratsam, den Artikel Einführung in Azure Data Factory zu lesen.

In diesem Tutorial führen Sie die folgenden Schritte aus:

- Erstellen einer Data Factory.

- Erstellen einer Pipeline mithilfe des Tools zum Kopieren von Daten

- Überwachen der Pipeline- und Aktivitätsausführungen.

Voraussetzungen

- Azure-Abonnement: Wenn Sie kein Azure-Abonnement besitzen, können Sie ein kostenloses Konto erstellen, bevor Sie beginnen.

- Azure-Speicherkonto: Verwenden Sie Blob Storage als Quelldatenspeicher und Senkendatenspeicher. Falls Sie noch nicht über ein Azure-Speicherkonto verfügen, finden Sie Anweisungen dazu unter Erstellen eines Speicherkontos.

Erstellen von zwei Containern im Blobspeicher

Bereiten Sie Ihren Blobspeicher folgendermaßen auf das Tutorial vor.

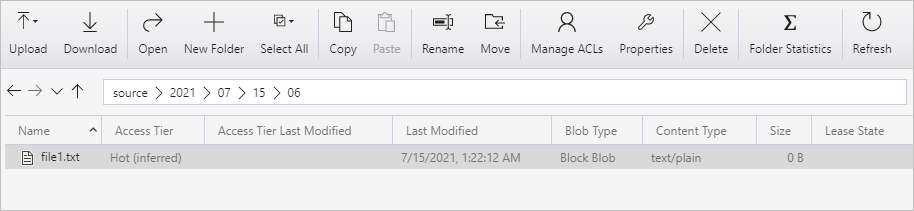

Erstellen Sie einen Container mit dem Namen source (Quelle). Erstellen Sie in Ihrem Container den Ordnerpfad 2021/07/15/06. Erstellen Sie eine leere Textdatei, und nennen Sie sie file1.txt. Laden Sie die Datei „file1.txt“ in den Ordnerpfad source/2021/07/15/06 in Ihrem Speicherkonto hoch. Sie können für diese Aufgaben verschiedene Tools verwenden, etwa Azure Storage-Explorer.

Hinweis

Passen Sie den Ordnernamen an Ihre UTC-Zeit an. Wenn die aktuelle UTC-Zeit beispielsweise „15. Juli 2021, 06:10 Uhr“ lautet, können Sie gemäß dem Format source/{Jahr}/{Monat}/{Tag}/{Stunde}/ den Ordnerpfad source/2021/07/15/06/ erstellen.

Erstellen Sie einen Container mit dem Namen destination (Ziel). Sie können für diese Aufgaben verschiedene Tools verwenden, etwa Azure Storage-Explorer.

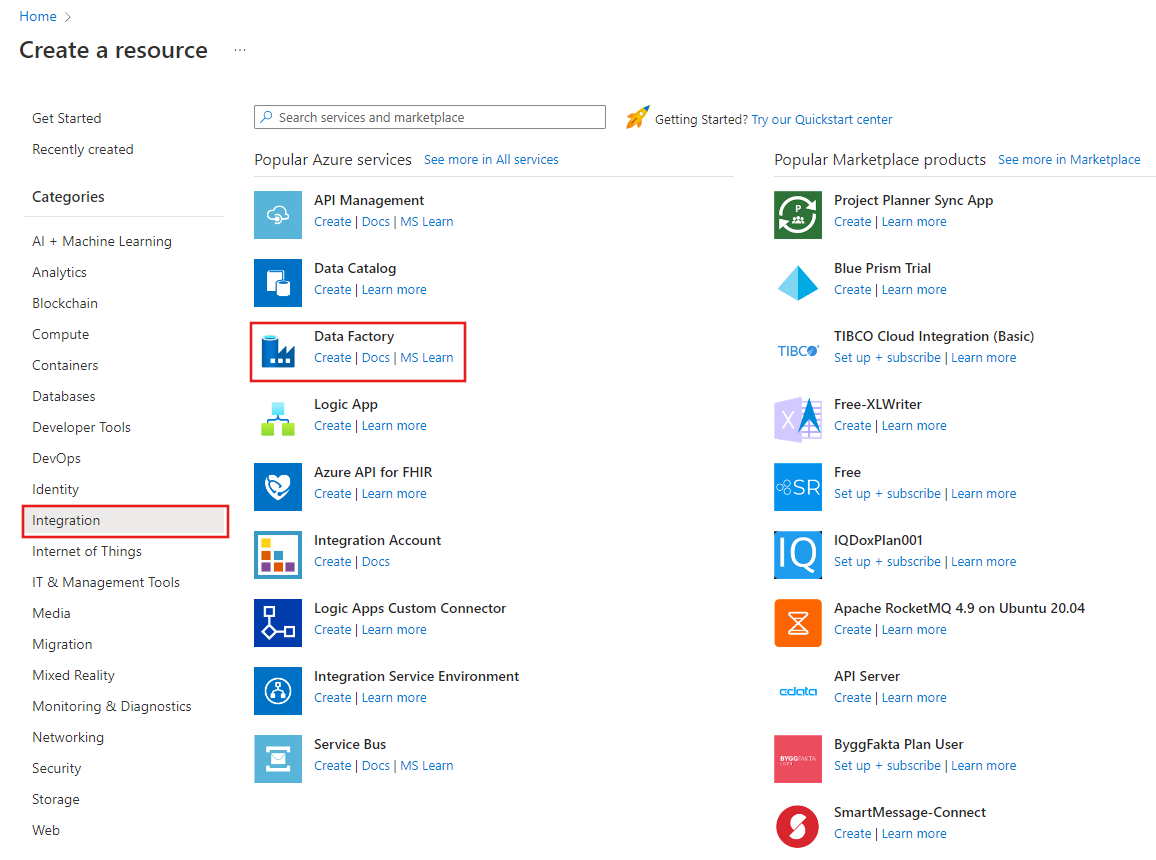

Erstellen einer Data Factory

Wählen Sie im oberen Menü die Option "Resource>Analytics>Data Factory erstellen" aus:

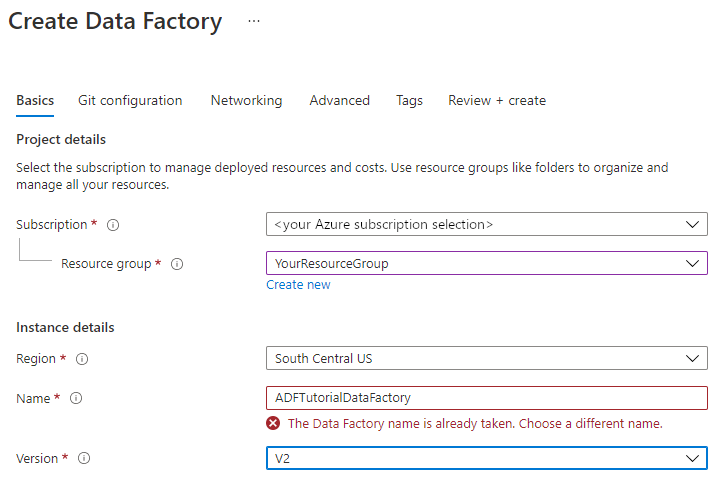

Geben Sie auf der Seite Neue Data Factory unter Name den Namen ADFTutorialDataFactory ein.

Der Name der Data Factory muss global eindeutig sein. Sie erhalten unter Umständen die folgende Fehlermeldung:

Wenn eine Fehlermeldung zum Namenswert angezeigt wird, geben Sie einen anderen Namen für die Data Factory ein. Verwenden Sie beispielsweise den Namen IhrNameADFTutorialDataFactory. Benennungsregeln für Data Factory-Artefakte finden Sie im Thema Data Factory – Benennungsregeln.

Wählen Sie das Azure-Abonnement aus, in dem die neue Data Factory erstellt werden soll.

Führen Sie unter Ressourcengruppe einen der folgenden Schritte aus:

a) Wählen Sie die Option Use existing(Vorhandene verwenden) und dann in der Dropdownliste eine vorhandene Ressourcengruppe.

b. Wählen Sie Neu erstellen, und geben Sie den Namen einer Ressourcengruppe ein.

Weitere Informationen zu Ressourcengruppen finden Sie unter Verwenden von Ressourcengruppen zum Verwalten von Azure-Ressourcen.

Wählen Sie unter Version die Option V2.

Wählen Sie unter Standort den Standort für die Data Factory aus. In der Dropdownliste werden nur unterstützte Standorte angezeigt. Die Datenspeicher (etwa Azure Storage und SQL-Datenbank) und Computeeinheiten (etwa Azure HDInsight), die von der Data Factory genutzt werden, können sich an anderen Standorten und in anderen Regionen befinden.

Klicken Sie auf Erstellen.

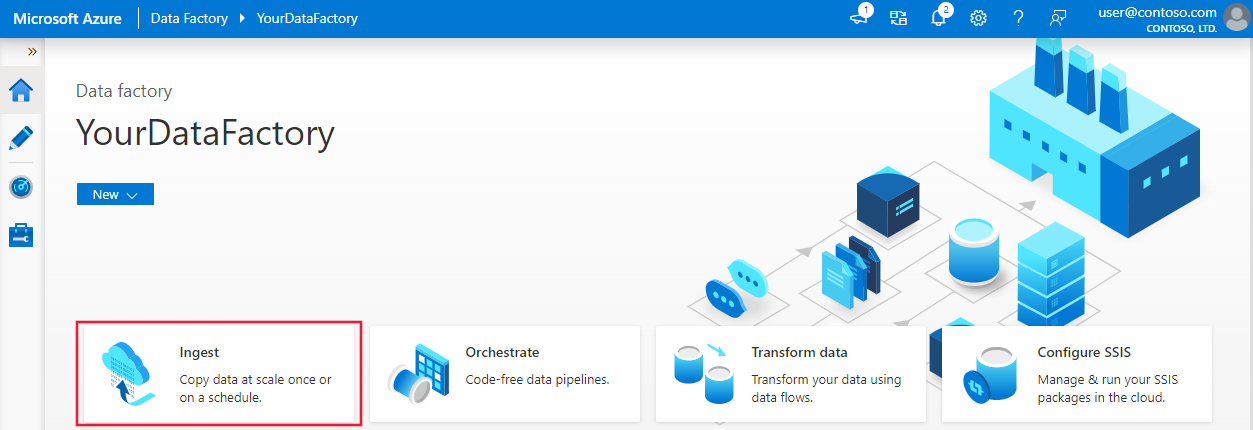

Nach Abschluss der Erstellung wird die Startseite von Data Factory angezeigt.

Zum Starten des Azure Data Factory-Benutzers wählen Sie auf der Kachel Open Azure Data Factory Studio die Option Öffnen aus.

Erstellen einer Pipeline mithilfe des Tools zum Kopieren von Daten

Wählen Sie auf der Azure Data Factory-Homepage den Titel Erfassen, um das Tool zum Kopieren der Daten zu starten.

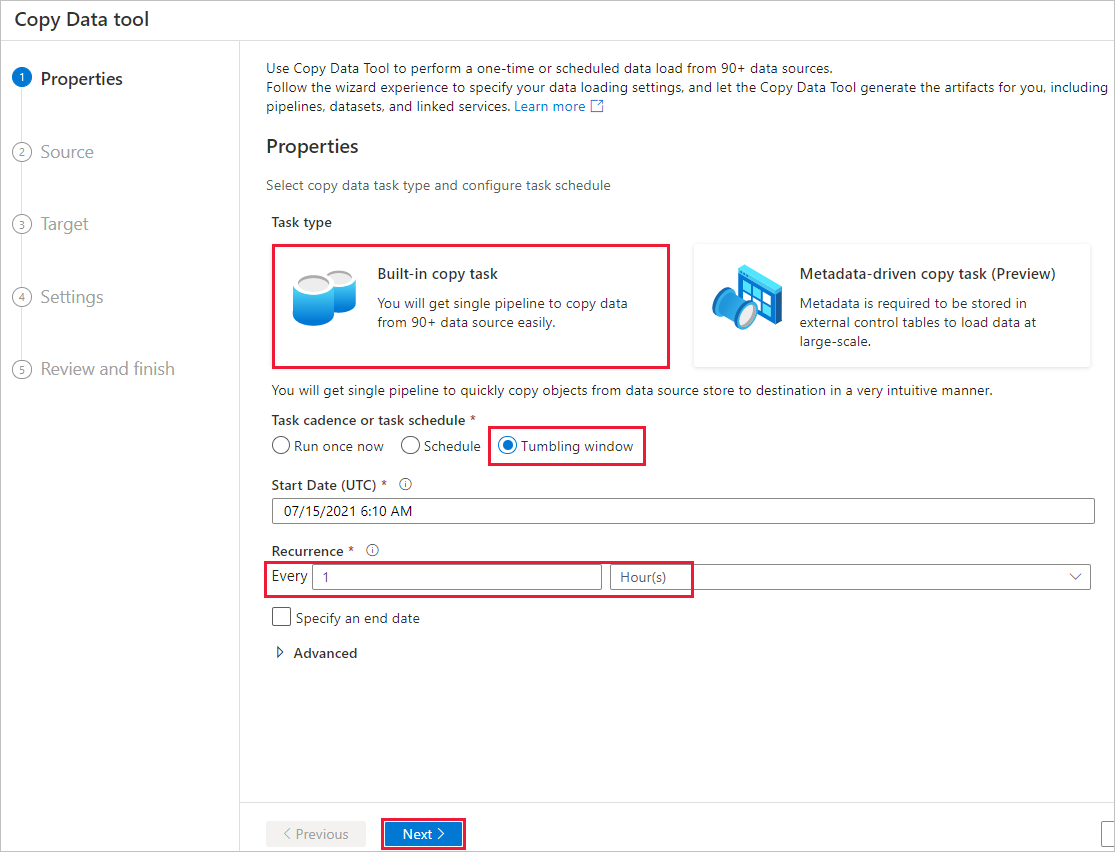

Gehen Sie auf der Seite Properties (Eigenschaften) wie folgt vor:

Wählen Sie unter Task type (Aufgabentyp) Built-in copy task (Integrierte Kopieraufgabe) aus.

Wählen Sie unter Task cadence or task schedule (Aufgabenhäufigkeit oder Aufgabenzeitplan) Tumbling window (Rollierendes Fenster) aus.

Geben Sie unter Recurrence (Wiederholung) 1 Hour(s) (1 Stunde[n]) ein.

Wählen Sie Weiter aus.

Führen Sie auf der Seite Quelldatenspeicher die folgenden Schritte aus:

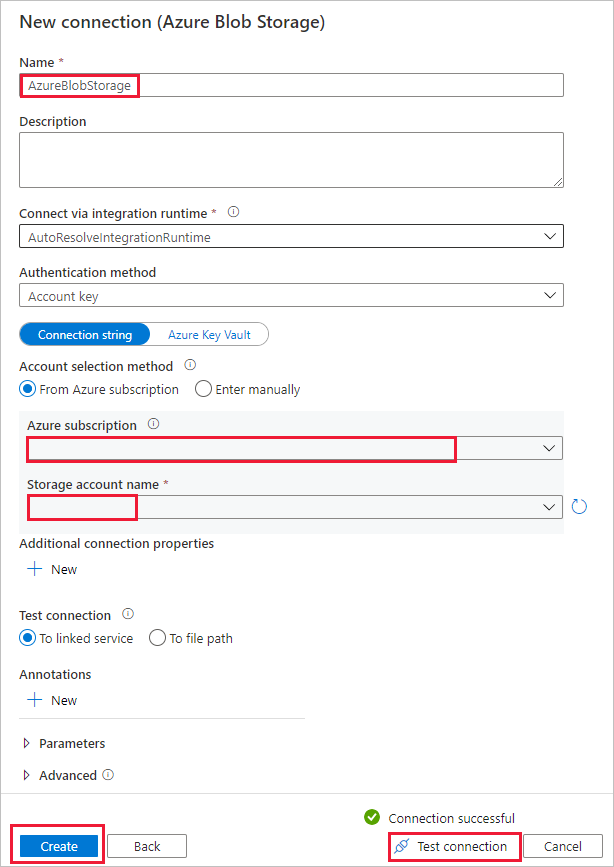

a) Wählen Sie + New connection (Neue Verbindung) aus, um eine Verbindung hinzuzufügen.

b. Wählen Sie im Katalog Azure Blob Storage aus, und klicken Sie dann auf Fortsetzen.

Abschnitt c. Geben Sie auf der Seite New connection (Azure Blob Storage) (Neue Verbindung [Azure Blob Storage]) einen Namen für die Verbindung ein. Wählen Sie Ihr Azure-Abonnement und anschließend in der Liste Speicherkontoname Ihr Speicherkonto aus. Testen Sie die Verbindung, und wählen Sie Fertig stellen aus.

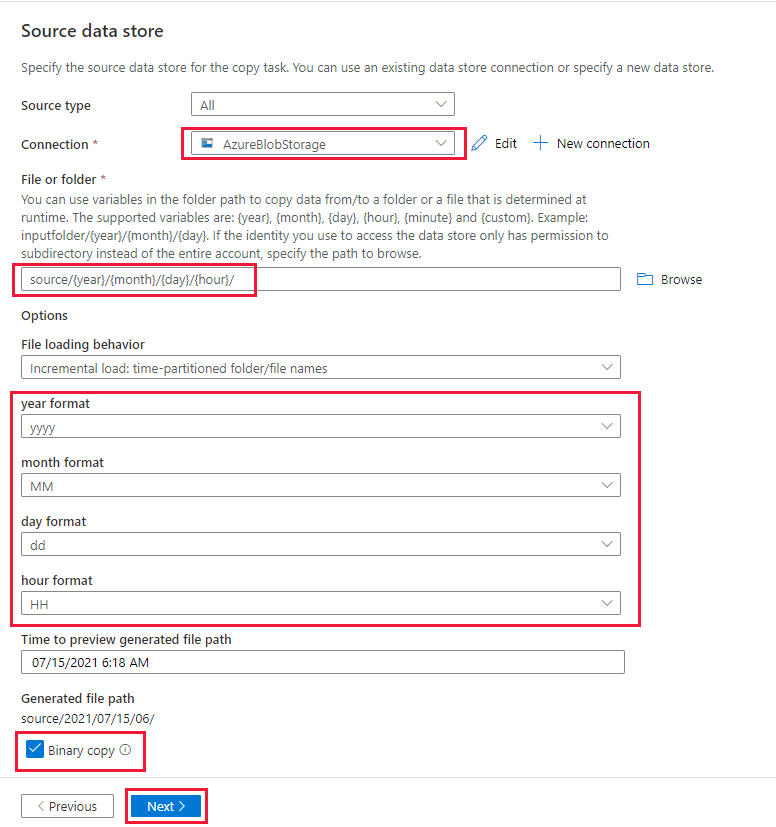

d. Wählen Sie auf der Seite Source data store (Quelldatenspeicher) die neu erstellte Verbindung in dem Abschnitt Verbindung aus.

e. Suchen Sie im Abschnitt File or folder (Datei oder Ordner) nach dem Container source (Quelle) und wählen Sie ihn aus. Wählen Sie anschließend OK.

f. Wählen Sie unter File loading behavior (Dateiladeverhalten) die Option Incremental load: time-partitioned folder/file names (Inkrementell laden: zeitpartionierter Ordner/Dateinamen).

g. Schreiben Sie den dynamischen Ordnerpfad im Format source/{Jahr}/{Monat}/{Tag}/{Stunde}/ , und ändern Sie das Format wie im folgenden Screenshot.

h. Aktivieren Sie das Kontrollkästchen Binary copy (Binärkopie), und wählen Sie Next (Weiter) aus.

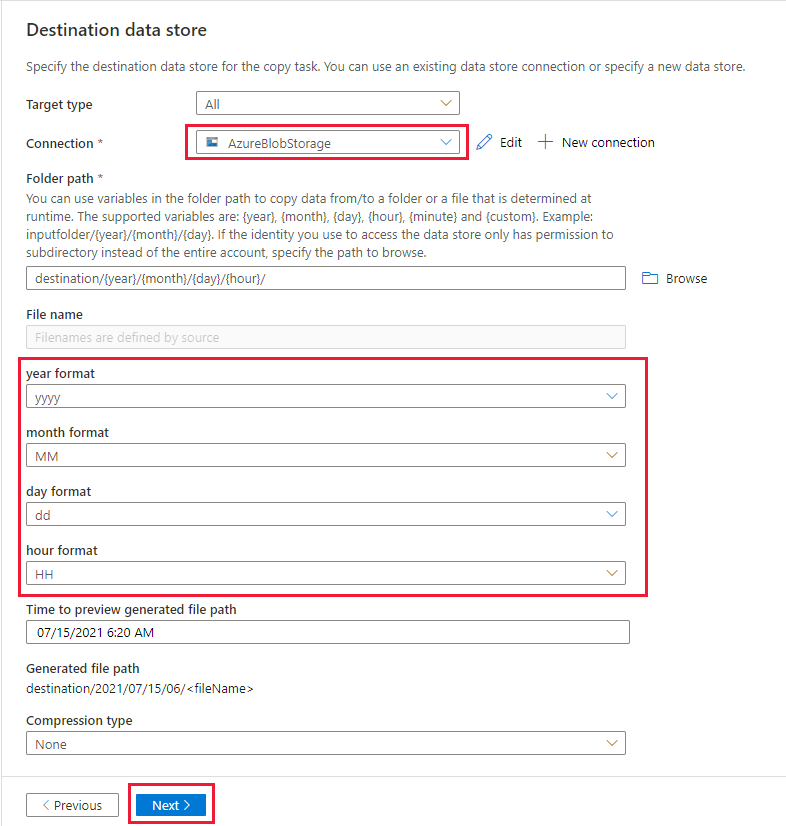

Führen Sie auf der Seite Zieldatenspeicher die folgenden Schritte aus:

Wählen Sie AzureBlobStorage aus, bei dem es sich um das gleiche Speicherkonto wie im Datenquellspeicher handelt.

Suchen Sie nach dem Ordner destination (Ziel), wählen Sie diesen aus, und wählen Sie anschließend OK.

Schreiben Sie den dynamischen Ordnerpfad im Format destination/{Jahr}/{Monat}/{Tag}/{Stunde}/ , und ändern Sie das Format wie im folgenden Screenshot.

Wählen Sie Weiter aus.

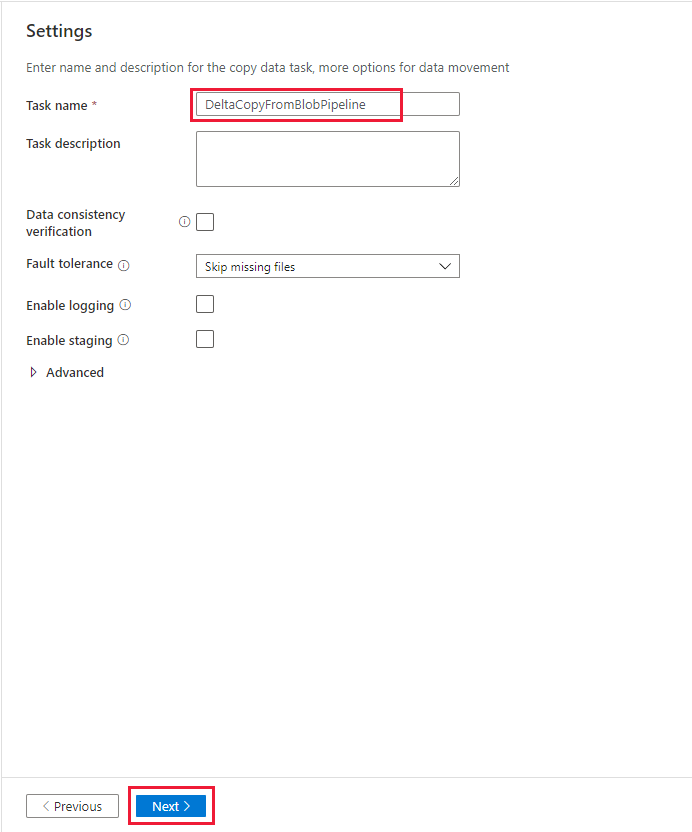

Geben Sie auf der Seite Settings (Einstellungen) unter Taskname den Namen DeltaCopyFromBlobPipeline ein, und klicken Sie dann auf Weiter. Über die Data Factory-Benutzeroberfläche wird eine Pipeline mit dem angegebenen Tasknamen erstellt.

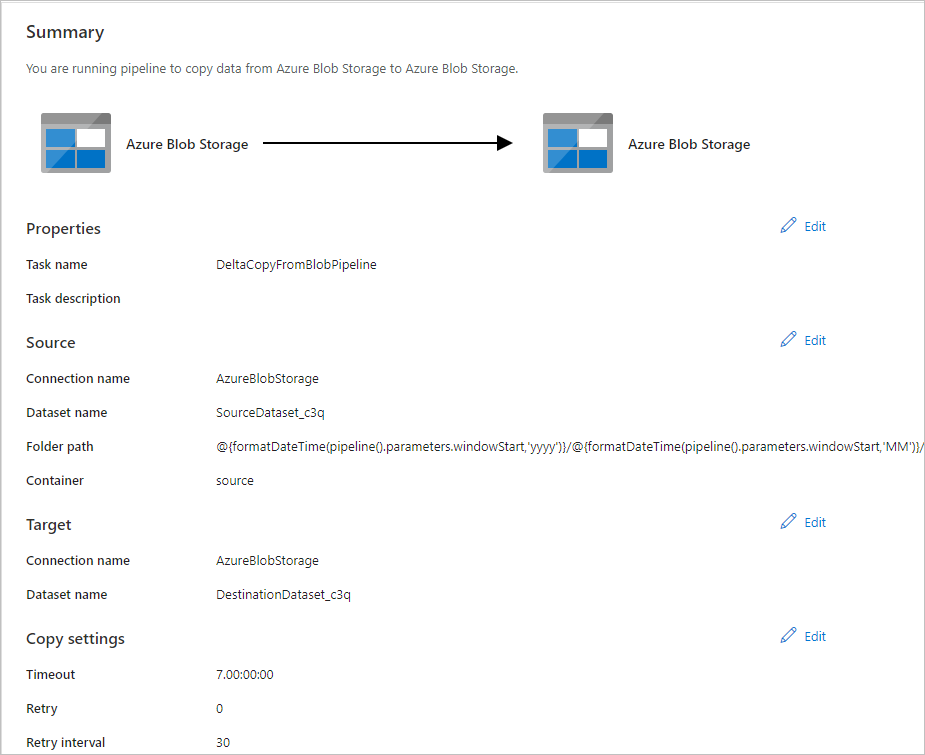

Überprüfen Sie auf der Seite Zusammenfassung die Einstellungen, und klicken Sie anschließend auf Weiter.

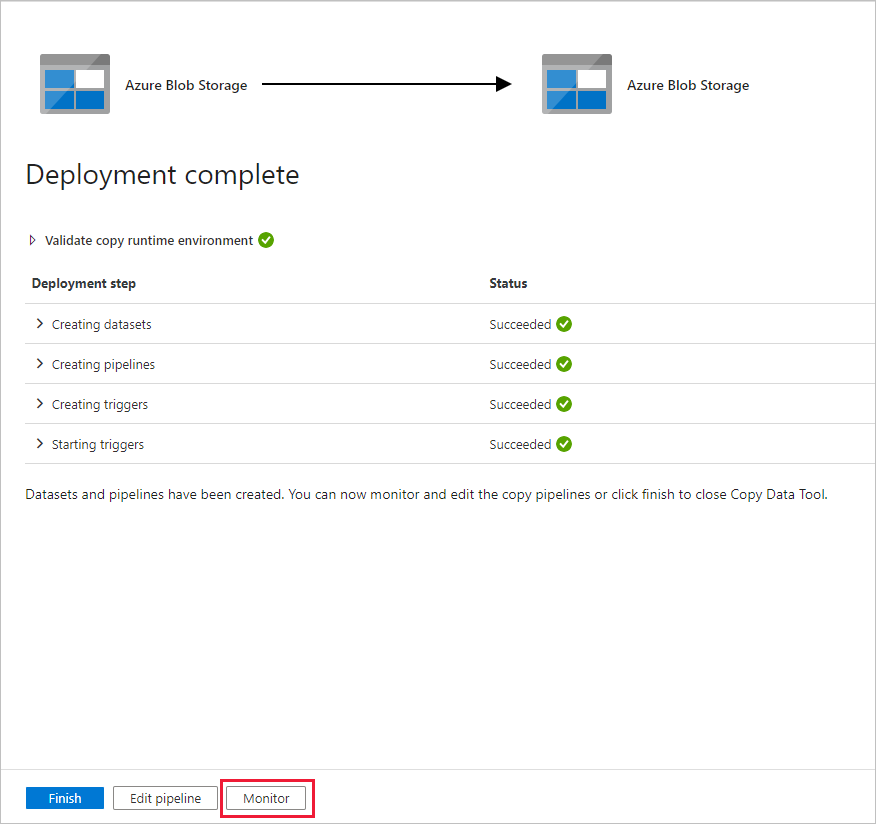

Wählen Sie auf der Seite Bereitstellung die OptionÜberwachen aus, um die Pipeline (Aufgabe) zu überwachen.

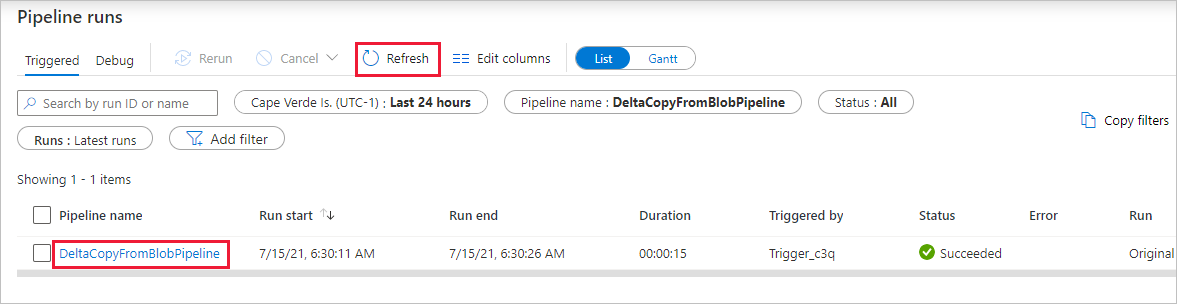

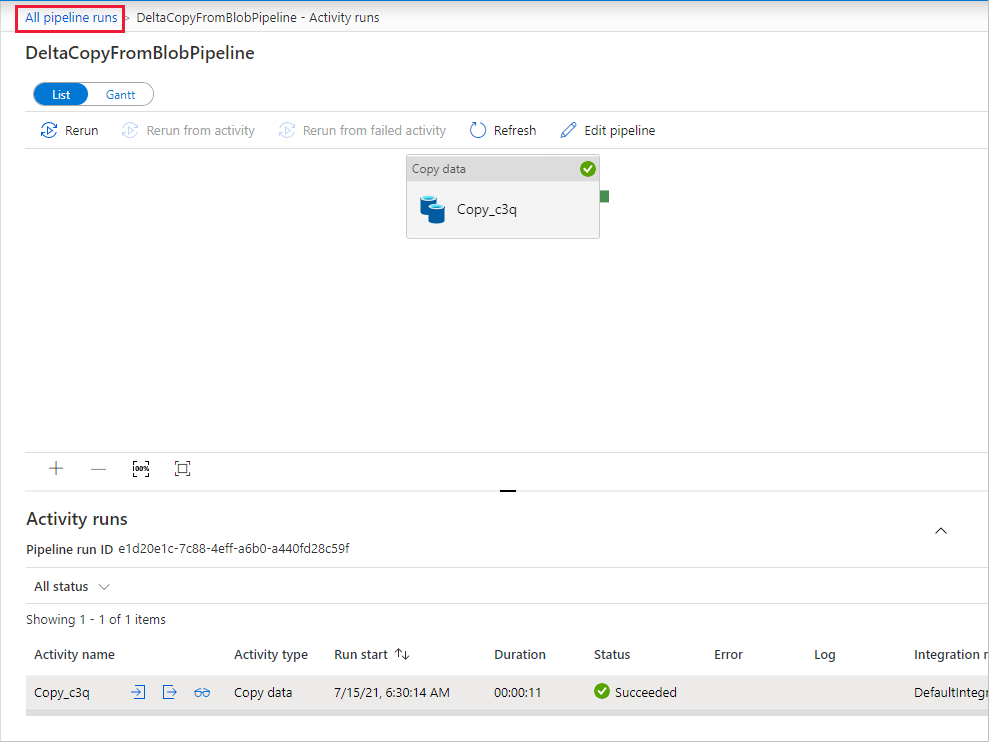

Beachten Sie, dass die Registerkarte Überwachen auf der linken Seite automatisch ausgewählt ist. Sie müssen auf die Ausführung der Pipeline warten, wenn sie (etwa nach einer Stunde) automatisch ausgelöst wird. Wählen Sie während der Ausführung den Link auf dem Pipelinenamen DeltaCopyFromBlobPipeline, um Details zur Aktivitätsausführung aufzurufen oder die Pipeline erneut auszuführen. Klicken Sie zum Aktualisieren der Liste auf Aktualisieren.

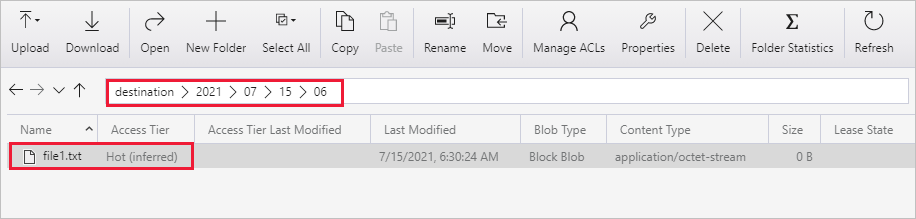

Da die Pipeline nur eine Aktivität (Copy-Aktivität) enthält, wird nur ein Eintrag angezeigt. Passen Sie die Breite der Spalten Quelle und Ziel bei Bedarf an, um weitere Details anzuzeigen. Ihnen wird angezeigt, dass die Quelldatei (file1.txt) mit demselben Dateinamen von source/2021/07/15/06/ nach destination/2021/07/15/06/ kopiert wurde.

Sie können dies auch bestätigen, indem Sie den Azure Storage-Explorer (https://storageexplorer.com/) verwenden, um die Dateien zu überprüfen.

Erstellen Sie eine weitere leere Textdatei, und nennen Sie sie file2.txt. Laden Sie die Datei „file2.txt“ in den Ordnerpfad source/2021/07/15/07 in Ihrem Speicherkonto hoch. Sie können für diese Aufgaben verschiedene Tools verwenden, etwa Azure Storage-Explorer.

Hinweis

Möglicherweise muss ein neuer Ordnerpfad erstellt werden. Passen Sie den Ordnernamen an Ihre UTC-Zeit an. Wenn zum Beispiel die aktuelle koordinierte Weltzeit (UTC) am 15. Juli 2021 7:30 Uhr lautet, können Sie gemäß dem Format {Jahr}/{Monat}/{Tag}/{Stunde}/ den Ordnerpfad source/2021/07/15/07/ erstellen.

Wählen Sie All Pipelines runs (Alle Pipelineausführungen) aus, und warten Sie, bis die gleiche Pipeline nach einer Stunde wiederholt automatisch ausgelöst wird, um zur Ansicht Pipeline Runs (Pipelineausführungen) zurückzukehren.

Klicken Sie für die zweite Pipelineausführung auf den neuen Link DeltaCopyFromBlobPipeline, wenn es soweit ist, und tun Sie dasselbe, um Details anzuzeigen. Ihnen wird angezeigt, dass die Quelldatei (file2.txt) mit demselben Dateinamen von source/2021/07/15/07/ nach destination/2021/07/15/07/ kopiert wurde. Sie können dies auch überprüfen, indem Sie den Azure Storage-Explorer (https://storageexplorer.com/) verwenden, um die Dateien im Container destination zu überprüfen.

Zugehöriger Inhalt

Fahren Sie mit dem nächsten Tutorial fort, um zu erfahren, wie Sie mithilfe eines Spark-Clusters in Azure Daten transformieren: