Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Hinweis

In der Organisation dieses Artikels wird davon ausgegangen, dass Sie die einfache Benutzeroberfläche für die Berechnung von Formularen verwenden. Eine Übersicht über die Aktualisierungen des einfachen Formulars finden Sie unter Verwenden des einfachen Formulars zum Verwalten der Berechnung.

In diesem Artikel werden die Konfigurationseinstellungen erläutert, die beim Erstellen einer neuen All-Purpose- oder Auftrags-Computeressource verfügbar sind. Die meisten Benutzer erstellen Computeressourcen mithilfe ihrer zugewiesenen Richtlinien, wodurch die konfigurierbaren Einstellungen begrenzt sind. Wenn eine bestimmte Einstellung auf der Benutzeroberfläche nicht angezeigt wird, liegt dies daran, dass die von Ihnen ausgewählte Richtlinie ihnen nicht erlaubt, diese Einstellung zu konfigurieren.

Empfehlungen zum Konfigurieren von Compute für Ihre Workload finden Sie unter Computekonfigurationsempfehlungen.

Die in diesem Artikel beschriebenen Konfigurationen und Verwaltungstools gelten sowohl für Allzweck- als auch für Auftragscomputes. Weitere Überlegungen zum Konfigurieren der Auftragsberechnung finden Sie unter Konfigurieren von Compute für Aufträge.

Erstellen einer neuen All-Purpose Compute-Ressource

Um eine neue universelle Rechnerressource zu erstellen:

- Wählen Sie auf der Randleiste des Arbeitsbereichs Compute aus.

- Wählen Sie die Schaltfläche Compute erstellen.

- Konfigurieren Sie die Computeressource.

- Klicken Sie auf Erstellen.

Ihre neue Rechenressource wird automatisch gestartet und kann bald verwendet werden.

Compute-Policy

Bei Richtlinien handelt es sich um eine Reihe von Regeln, mit denen die Konfigurationsoptionen eingeschränkt werden, die Benutzern beim Erstellen von Computeressourcen zur Verfügung stehen. Wenn ein Benutzer nicht über die Berechtigung zum Erstellen eines uneingeschränkten Clusters verfügt, kann er nur Computeressourcen mithilfe seiner erteilten Richtlinien erstellen.

Um Computeressourcen gemäß einer Richtlinie zu erstellen, wählen Sie im Dropdownmenü Richtlinie eine Richtlinie aus.

Standardmäßig haben alle Benutzer*innen Zugriff auf die Personal Compute-Richtlinie, mit der sie Einzelcomputer-Computeressourcen erstellen können. Wenn Sie Zugriff auf Personal Compute oder zusätzliche Policies benötigen, wenden Sie sich an Ihren Arbeitsbereichsadministrator.

Leistungseinstellungen

Die folgenden Einstellungen werden im Abschnitt "Leistung " der Benutzeroberfläche für einfache Formularberechnungen angezeigt:

- Databricks Runtime-Versionen

- Verwenden der Photonbeschleunigung

- Arbeitsknotentyp

- Einzelknoten-Rechenleistung

- Aktivieren der automatischen Skalierung

- Erweiterte Leistungseinstellungen

Databricks Runtime-Versionen

Bei Databricks Runtime handelt es sich um die Gruppe von Kernkomponenten, die auf Ihren Rechenressourcen laufen. Wählen Sie die Laufzeit im Dropdownmenü Databricks Runtime Version aus. Ausführliche Informationen zu bestimmten Databricks Runtime-Versionen finden Sie unter Versionshinweise zu Databricks Runtime-Versionen und -Kompatibilität. Alle Versionen enthalten Apache Spark. Databricks empfiehlt Folgendes:

- Verwenden Sie für Allzweck-Compute die aktuellste Version, um sicherzustellen, dass Sie die neuesten Optimierungen und die aktuellste Kompatibilität zwischen Ihrem Code und den vorinstallierten Paketen haben.

- Bei Auftragscomputes, auf denen betriebsbereite Workloads ausgeführt werden, sollten Sie die LTS-Version von Databricks Runtime (Long Term Support, Langfristige Unterstützung) verwenden. Wenn Sie die LTS-Version verwenden, stellen Sie sicher, dass keine Kompatibilitätsprobleme auftreten und Ihre Workload vor dem Upgrade gründlich testen können.

- Für Data Science- und Machine Learning-Anwendungsfälle sollten Sie Databricks Runtime ML-Version in Betracht ziehen.

Verwenden von Photon-Beschleunigung

Photon ist in Computes mit Databricks Runtime 9.1 LTS und höher standardmäßig aktiviert.

Zum Aktivieren oder Deaktivieren der Photon-Beschleunigung aktivieren Sie das Kontrollkästchen Photon-Beschleunigung verwenden. Weitere Informationen zu Photon finden Sie unter Was ist Photon?.

Arbeitsknotentyp

Eine Computeressource besteht aus einem Treiberknoten und null oder mehr Workerknoten. Sie können separate Cloudanbieter-Instanztypen für den Treiber- und den Workerknoten auswählen, auch wenn der Treiberknoten standardmäßig denselben Instanztyp verwendet wie der Workerknoten. Die Treiberknoteneinstellung befindet sich unterhalb des Abschnitts "Erweiterte Leistung ".

Es gibt verschiedene Familien von Instanztypen für unterschiedliche Anwendungsfälle, z. B. speicherintensive oder rechenintensive Workloads. Sie können auch einen Pool auswählen, der als Worker- oder Treiberknoten verwendet werden soll.

Wichtig

Verwenden Sie keinen Pool mit Spotinstanzen als Treibertyp. Wählen Sie einen On-Demand-Treibertyp aus, um zu verhindern, dass Ihr Treiber zurückgezogen wird. Siehe Verbinden mit Pools.

Bei einem Mehrknoten-Computing führen die Workerknoten die Spark Executors und andere Dienste aus, die für den vorschriftsmäßigen Betrieb der Rechenressource erforderlich sind. Wenn Sie Ihre Arbeitslast mit Spark verteilen, erfolgt die verteilte Verarbeitung auf Arbeitsknoten. Azure Databricks führt einen Executor pro Arbeitsknoten aus. Daher werden die Begriffe „Executor“ und „Worker“ im Kontext der Databricks-Architektur synonym verwendet.

Tipp

Zum Ausführen eines Spark-Auftrags benötigen Sie mindestens einen Workerknoten. Bei einer Rechenressource mit keinen Workern können Sie Nicht-Spark-Befehle auf dem Treiberknoten ausführen, aber Spark-Befehle werden fehlschlagen.

Flexible Knotentypen

Wenn Ihr Arbeitsbereich flexible Knotentypen aktiviert hat, können Sie flexible Knotentypen für Ihre Computeressource verwenden. Flexible Knotentypen ermöglichen es Ihrer Computeressource, auf alternative, kompatible Instanztypen zurückzugreifen, wenn der angegebene Instanztyp nicht verfügbar ist. Dieses Verhalten verbessert die Zuverlässigkeit des Computestarts, indem kapazitätsausfälle während der Computestarts reduziert werden. Weitere Informationen finden Sie unter Verbesserte Zuverlässigkeit von Computerstartern durch flexible Knotentypen.

IP-Adressen der Workerknoten

Azure Databricks startet Workerknoten mit jeweils zwei privaten IP-Adressen. Die primäre private IP-Adresse des Knotens hostet den internen Azure Databricks-Datenverkehr. Die sekundäre private IP-Adresse wird vom Spark-Container für die clusterinterne Kommunikation verwendet. Mit diesem Modell kann Azure Databricks eine Isolation zwischen mehreren Computeressourcen im gleichen Arbeitsbereich bieten.

GPU-Instanztypen

Für rechenintensive Aufgaben, die eine hohe Leistung erfordern (z. B. Aufgaben im Zusammenhang mit Deep Learning), unterstützt Azure Databricks Computeressourcen, die mit Grafikprozessoren (Graphics Processing Units, GPUs) beschleunigt werden. Weitere Informationen finden Sie unter GPU-fähige Berechnungen.

Azure Confidential Computing-VMs

Vertrauliche Azure Computing-VM-Typen verhindern nicht autorisierten Zugriff auf Daten, während sie verwendet wird, einschließlich des Cloudoperators. Dieser VM-Typ ist für stark regulierte Branchen und Regionen sowie für Unternehmen mit vertraulichen Daten in der Cloud von Vorteil. Weitere Informationen zum vertraulichen Computing von Azure finden Sie unter Azure Vertraulich Computing.

Um Ihre Workloads mithilfe von Azure Confidential Computing-VMs auszuführen, wählen Sie aus den VM-Typen der DC- oder EC-Serie in den Dropdownlisten der Worker- und Treiberknoten aus. Weitere Informationen finden Sie unter Azure Confidential VM-Optionen.

Einzelknoten-Compute

Mit dem Kontrollkästchen "Einzelner Knoten " können Sie eine einzelne Knoten-Computeressource erstellen.

Einzelknotencomputes sind für Aufträge vorgesehen, die kleine Datenmengen oder nicht verteilte Workloads wie maschinelle Lernbibliotheken mit nur einem Knoten verwenden. Multiknoten-Compute sollte für größere Aufträge mit verteilten Workloads verwendet werden.

Eigenschaften eines einzelnen Knotens

Eine Einzelknoten-Computeressource hat die folgenden Eigenschaften:

- Sie führt Spark lokal aus.

- Der Treiber fungiert sowohl als Master als auch als Worker ohne Workerknoten.

- Sie erzeugt einen Executor-Thread pro logischem Kern in der Computeressource, abzüglich eines Kerns für den Treiber.

- Speichert alle

stderr,stdoutundlog4j-Protokollausgaben im Treiberprotokoll. - Kann nicht in eine Computeressource mit mehreren Knoten konvertiert werden.

Auswählen eines einzelnen oder mehrerer Knoten

Berücksichtigen Sie Ihren Anwendungsfall, wenn Sie sich zwischen Single-Node- oder Multi-Node-Computing entscheiden.

Die Verarbeitung großer Datenmengen erschöpft die Ressourcen einer Einzelknoten-Computeressource. Für diese Workloads empfiehlt Databricks den Einsatz von Multi-Node-Computing.

Eine Multiknoten-Computeressource kann nicht auf 0 Worker skaliert werden. Verwenden Sie stattdessen eine Einzelknoten-Computeressource.

Die GPU-Planung ist bei Einzelknotenberechnungen nicht aktiviert.

Bei Einzelknoten-Compute kann Spark keine Parquet-Dateien mit einer UDT-Spalte (User-Defined Type, benutzerdefinierter Typ) lesen. Die folgende Fehlermeldung wird angezeigt:

The Spark driver has stopped unexpectedly and is restarting. Your notebook will be automatically reattached.Deaktivieren Sie den nativen Parquet-Reader, um dieses Problem zu beheben:

spark.conf.set("spark.databricks.io.parquet.nativeReader.enabled", False)

Aktivieren der automatischen Skalierung

Wenn die Option Autoskalierung aktivieren aktiviert ist, können Sie eine Mindest- und Höchstanzahl von Workern für die Computeressource angeben. Databricks wählt anschließend die für die Ausführung des Auftrags erforderliche Anzahl von Workern aus.

Verwenden Sie die Felder "Min " und "Max " neben der Dropdownliste " Worker type ", um das Minimum und die maximale Anzahl von Mitarbeitern festzulegen, zwischen denen ihre Computeressource automatisch skalieren wird.

Wenn Sie die automatische Skalierung nicht aktivieren, müssen Sie eine feste Anzahl von Mitarbeitern im Feld "Worker " neben der Dropdownliste " Worker type " eingeben.

Hinweis

Wenn die Computeressource ausgeführt wird, wird auf der Seite „Computedetails“ die Anzahl zugeordneter Worker angezeigt. Sie können die Anzahl von zugewiesenen Workern mit der Workerkonfiguration vergleichen und bei Bedarf Anpassungen vornehmen.

Vorteile der automatischen Skalierung

Bei der automatischen Skalierung weist Azure Databricks die Worker dynamisch neu zu, um die Merkmale Ihres Auftrags zu berücksichtigen. Bestimmte Teile Ihrer Pipeline sind möglicherweise rechenintensiver als andere, und Databricks fügt während dieser Phasen Ihres Auftrags automatisch zusätzliche Mitarbeiter hinzu (und entfernt sie, wenn sie nicht mehr benötigt werden).

Die automatische Skalierung erleichtert das Erreichen einer hohen Auslastung, da Sie die Rechenressourcen nicht an die Arbeitslast anpassen müssen. Dies gilt insbesondere für Workloads, deren Anforderungen sich im Laufe der Zeit ändern (z. B. die Erkundung eines Datasets im Laufe eines Tages), aber auch für einmalige Workloads mit kürzerer Laufzeit, deren Bereitstellungsanforderungen unbekannt sind. Die automatische Skalierung bietet somit zwei Vorteile:

- Workloads können im Vergleich zu einer unterdimensionierten Computeressource mit fester Größe schneller ausgeführt werden.

- Durch die automatische Skalierung können die Gesamtkosten im Vergleich zu einer Computeressource mit fester Größe gesenkt werden.

Abhängig von der festen Größe der Computeressource und der Workload bietet Ihnen die automatische Skalierung einen oder beide dieser Vorteile. Die Rechenkapazität kann unter die ausgewählte Mindestanzahl von Workern sinken, wenn der Cloudanbieter Instanzen beendet. In diesem Fall versucht Azure Databricks fortlaufend, Instanzen erneut bereitzustellen, um die Mindestanzahl von Workern aufrecht zu erhalten.

Hinweis

Die automatische Skalierung steht für spark-submit-Aufträge nicht zur Verfügung.

Hinweis

Die automatische Autoskalierung hat Einschränkungen beim Herunterskalieren der Clustergröße für strukturierte Streaming-Workloads. Databricks empfiehlt die Verwendung von Lakeflow Spark Declarative Pipelines mit verbesserter automatischer Skalierung für Streaming-Workloads. Siehe Optimieren der Clusternutzung von Lakeflow Spark Declarative Pipelines mit automatischer Skalierung.

Verhalten der automatischen Skalierung

Arbeitsbereiche im Premium-Plan bzw. -Tarif verwenden die optimierte automatische Skalierung. Arbeitsbereiche im Standard-Plan verwenden die standardmäßige automatische Skalierung.

Die optimierte automatische Skalierung weist die folgenden Merkmale auf:

- Die Skalierung erfolgt in 2 Schritten vom Mindestwert zum Höchstwert.

- Selbst wenn die Rechenressource nicht untätig ist, kann sie durch Überprüfung des Status der Shuffle-Datei herunterskaliert werden.

- Das Herunterskalieren erfolgt basierend auf einem Prozentsatz der aktuellen Knoten.

- Bei Job Compute wird herunterskaliert, wenn die Computeressource in den letzten 40 Sekunden unterausgelastet war.

- Bei All-Purpose Compute wird herunterskaliert, wenn die Computeressource in den letzten 150 Sekunden unterausgelastet war.

- Die Spark-Konfigurationseigenschaft

spark.databricks.aggressiveWindowDownSgibt an, wie häufig (in Sekunden) ein Compute Skalierungsentscheidungen trifft. Das Erhöhen dieses Werts führt dazu, dass die Rechenleistung langsamer verringert wird. Der Höchstwert lautet 600.

Die standardmäßige automatische Skalierung wird in Arbeitsbereichen im Standardtarif verwendet. Die standardmäßige automatische Skalierung weist die folgenden Merkmale auf:

- Beginnt mit dem Hinzufügen von 8 Knoten. Anschließend wird er exponentiell hochskaliert, wobei so viele Schritte wie nötig ausgeführt werden, um das Maximum zu erreichen.

- Es wird herunterskaliert, wenn 90% der Knoten 10 Minuten lang nicht ausgelastet sind und sich das Compute mindestens 30 Sekunden lang im Leerlauf befindet.

- Der Cluster wird exponentiell herunterskaliert, beginnend mit 1 Knoten.

Automatische Skalierung mit Pools

Berücksichtigen Sie Folgendes, wenn Sie Ihre Computeressource an einen Pool anfügen:

- Stellen Sie sicher, dass die angeforderte Berechnungsgröße kleiner oder gleich der minimalen Anzahl von ungenutzten Instanzen im Pool ist. Wenn dies größer ist, entspricht die Startzeit der Berechnung dem Rechnen, das keinen Pool verwendet.

- Stellen Sie sicher, dass die maximale Computegröße kleiner oder gleich der maximalen Kapazität des Pools ist. Wenn sie größer ist, kann die Computeressource nicht erstellt werden.

Beispiel für die automatische Skalierung

Wenn Sie eine statische Computeressource für die automatische Skalierung neu konfigurieren, passt Azure Databricks die Größe der Computeressource sofort innerhalb der Mindest- und Höchstgrenzen an und startet dann die automatische Skalierung. Die folgende Tabelle veranschaulicht anhand eines Beispiels, was mit einer Computeressource mit einer bestimmten Anfangsgröße geschieht, wenn Sie sie für die automatische Skalierung zwischen fünf und zehn Knoten neu konfigurieren.

| Ursprüngliche Größe | Größe nach der Neukonfiguration |

|---|---|

| 6 | 6 |

| 12 | 10 |

| 3 | 5 |

Erweiterte Leistungseinstellungen

Die folgende Einstellung wird im Abschnitt "Erweiterte Leistung " in der Benutzeroberfläche für einfache Formularberechnungen angezeigt.

Spotinstanzen

Um Kosten zu sparen, können Sie sich für die Verwendung von Spot-Instanzen, auch bekannt als Azure Spot-VMs, entscheiden, indem Sie das Kontrollkästchen Spot-Instanzen aktivieren.

Die erste Instanz ist immer bedarfsgesteuert (der Treiberknoten ist immer bedarfsgesteuert), nachfolgende Instanzen sind Spot-Instanzen.

Wenn Instanzen aufgrund der Nichtverfügbarkeit entfernt werden, versucht Azure Databricks, neue Spotinstanzen zu erwerben, um die entfernten Instanzen zu ersetzen. Wenn keine Spotinstanzen erworben werden können, werden On-Demand-Instanzen bereitgestellt, um die entfernten Instanzen zu ersetzen. Dieses On-Demand-Failback wird nur für Spotinstanzen unterstützt, die vollständig erworben wurden und ausgeführt werden. Spot-Instanzen, die während des Setups fehlschlagen, werden nicht automatisch ersetzt.

Wenn vorhandenen Computeressourcen neue Knoten hinzugefügt werden, versucht Azure Databricks außerdem, Spot-Instanzen für diese Knoten abzurufen.

Automatische Beendigung

Sie können die automatische Beendigung für die Berechnung im Abschnitt "Erweiterte Leistung " festlegen. Geben Sie während der Erstellung der Compute-Instanz einen Inaktivitätszeitraum in Minuten an, nach dem die Rechenressource beendet werden soll.

Wenn der Unterschied zwischen der aktuellen Uhrzeit und dem letzten Befehl, der auf der Computeressource ausgeführt wird, größer als der angegebene Inaktivitätszeitraum ist, beendet Azure Databricks diese Computeressource automatisch. Weitere Informationen zum Beenden der Berechnung finden Sie unter "Beenden einer Berechnung".

Treibertyp

Sie können den Treibertyp unter dem Abschnitt "Erweiterte Leistung " auswählen. Der Treiberknoten behält die Zustandsinformationen aller Notebooks bei, die an die Computeressource angefügt sind. Der Treiberknoten behält außerdem den SparkContext bei, interpretiert alle Befehle, die Sie über ein Notebook oder eine Bibliothek auf der Computeressource ausführen, und führt den Apache Spark-Master aus, der mit den Spark-Executors koordiniert wird.

Der Standardwert für den Treiberknotentyp entspricht dem Workerknotentyp. Sie können einen größeren Treiberknoten mit mehr Arbeitsspeicher auswählen, wenn Sie umfangreiche Daten von Spark-Workern erfassen (collect()) und im Notebook analysieren möchten.

Tipp

Da der Treiberknoten alle Zustandsinformationen der angefügten Notebooks verwaltet, sollten Sie sicherstellen, nicht verwendete Notebooks vom Treiberknoten abzukoppeln.

Stichwörter

Tags ermöglichen es Ihnen, die Kosten der Computeressourcen, die von verschiedenen Gruppen in Ihrer Organisation verwendet werden, auf einfache Weise zu überwachen. Geben Sie Tags als Schlüsselwertpaare an, wenn Sie Compute erstellen, und Azure Databricks wendet diese Tags auf Cloudressourcen wie VMs und Datenträgervolumes sowie die Databricks-Verwendungsprotokolle an.

Bei Computing-Prozessen, die aus Pools gestartet werden, werden die benutzerdefinierten Computing-Tags nur auf die DBU-Nutzungsberichte angewendet und nicht an die Cloud-Ressourcen weitergegeben.

Ausführliche Informationen dazu, wie Pool- und Computetagtypen zusammenarbeiten, finden Sie unter Verwenden von Tags zum Attributieren und Nachverfolgen der Nutzung

So fügen Sie Ihrer Computeressource Tags hinzu

- Fügen Sie im Abschnitt Tags ein Schlüssel-Wert-Paar für jedes benutzerdefinierte Tag hinzu.

- Klicken Sie auf Hinzufügen.

Erweiterte Einstellungen

Die folgenden Einstellungen werden im Abschnitt "Erweitert " der Benutzeroberfläche für einfache Formularberechnungen angezeigt:

- Zugriffsmodi

- Aktivieren der automatischen Skalierung des lokalen Speichers

- Verschlüsselung lokaler Datenträger

- Spark-Konfiguration

- SSH-Zugriff auf Compute

- Umgebungsvariablen

- Computeprotokollübermittlung

Zugriffsmodi

Der Zugriffsmodus ist eine Sicherheitsfunktion, die bestimmt, wer die Rechenressource verwenden kann und auf welche Ressourcen und Daten man über die Rechenressource zugreifen kann. Jede Computeressource in Azure Databricks verfügt über einen Zugriffsmodus. Einstellungen für den Zugriffsmodus finden Sie im Abschnitt "Erweitert " der Benutzeroberfläche für einfache Formularberechnungen.

Die Auswahl des Zugriffsmodus ist standardmäßig automatisch , d. h. der Zugriffsmodus wird automatisch basierend auf der ausgewählten Databricks-Runtime für Sie ausgewählt. Der Standardwert ist "Standard" , es sei denn, eine Machine Learning-Laufzeit oder eine Databricks-Runtime unter 14.3 ist ausgewählt, in diesem Fall wird "Dedicated" verwendet.

Databricks empfiehlt, den Standardzugriffsmodus zu verwenden, es sei denn, Ihre erforderliche Funktionalität wird nicht unterstützt.

| Zugriffsmodus | Description | Unterstützte Sprachen |

|---|---|---|

| Norm | Kann von mehreren Benutzer*innen mit Datenisolation unter Benutzer*innen verwendet werden. | Python, SQL, Scala |

| Dediziert | Kann einem einzelnen Benutzer oder einer einzelnen Gruppe zugewiesen und verwendet werden. | Python, SQL, Scala, R |

Ausführliche Informationen zur Funktionalitätsunterstützung für jeden dieser Zugriffsmodi finden Sie unter Standard compute requirements and limitations , and Dedicated compute requirements and limitations.

Hinweis

In Databricks Runtime 13.3 LTS und höher werden Initialisierungsskripts und -bibliotheken von allen Zugriffsmodi unterstützt. Anforderungen und Supportebenen variieren. Weitere Informationen finden Sie unter Wo können Initialisierungsskripts installiert werden? und Bibliotheken im Computebereich.

Automatische Skalierung des lokalen Speichers aktivieren

Es ist oft schwierig abzuschätzen, wie viel Speicherplatz auf dem Datenträger ein bestimmter Auftrag beanspruchen wird. Damit Sie beim Erstellen Ihrer Compute-Instanz nicht selbst schätzen müssen, wie viele Gigabytes an verwaltetem Datenträger Sie anschließen müssen, aktiviert Azure Databricks automatisch die automatische Skalierung des lokalen Speichers für alle Azure Databricks-Compute-Instanzen.

Mit der automatischen Skalierung des lokalen Speichers überwacht Azure Databricks die Menge an freiem Speicherplatz, der auf den Spark-Workern Ihrer Compute verfügbar ist. Wenn der Speicherplatz eines Workers knapp wird, fügt Databricks automatisch einen neuen verwalteten Datenträger an den Worker an, bevor der Speicherplatz aufgebraucht ist. Datenträger sind bis zu einem Limit von 5 TB Gesamtspeicherplatz pro virtueller Maschine angebracht, einschließlich des ursprünglichen lokalen Speichers der virtuellen Maschine.

Die an eine VM angefügten verwalteten Datenträger werden nur getrennt, wenn die VM an Azure zurückgegeben wird. Das heißt, verwaltete Datenträger werden nie von einer VM abgekoppelt, solange sie Teil eines ausgeführten Computes sind. Zum Herunterskalieren der Nutzung von verwalteten Datenträgern empfiehlt Azure Databricks die Verwendung dieser Funktion in einem Compute, das mit automatischer Computeskalierung oder automatischer Beendigung konfiguriert ist.

Verschlüsselung lokaler Datenträger

Wichtig

Dieses Feature befindet sich in der Public Preview.

Einige Instanztypen, die Sie zum Ausführen von Computes verwenden, verfügen möglicherweise über lokal angefügte Datenträger. Azure Databricks kann Shuffledaten oder kurzlebige Daten auf diesen lokal angefügten Datenträgern speichern. Um sicherzustellen, dass alle ruhenden Daten für alle Speichertypen verschlüsselt sind, einschließlich shuffle-Daten, die vorübergehend auf den lokalen Datenträgern Ihrer Computeressource gespeichert sind, können Sie die lokale Datenträgerverschlüsselung aktivieren.

Wichtig

Ihre Workloads werden möglicherweise langsamer ausgeführt, da sich das Lesen und Schreiben verschlüsselter Daten auf und von lokalen Volumes auf die Leistung auswirkt.

Wenn die Verschlüsselung lokaler Datenträger aktiviert ist, generiert Azure Databricks lokal einen Verschlüsselungsschlüssel, der für jeden Computeknoten eindeutig ist und zum Verschlüsseln aller auf lokalen Datenträgern gespeicherten Daten verwendet wird. Der Schlüssel ist nur lokal für den jeweiligen Computeknoten gültig und wird zusammen mit dem Computeknoten selbst zerstört. Während seiner Lebensdauer befindet sich der Schlüssel zur Ver- und Entschlüsselung im Arbeitsspeicher und wird verschlüsselt auf dem Datenträger gespeichert.

Zum Aktivieren der Verschlüsselung lokaler Datenträger müssen Sie die Cluster-API verwenden. Legen Sie während der Computeerstellung oder -bearbeitung enable_local_disk_encryption auf true fest.

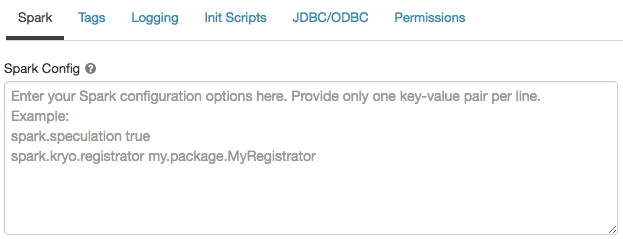

Spark-Konfiguration

Um Spark-Aufträge zu optimieren, können Sie benutzerdefinierte Spark-Konfigurationseigenschaften bereitstellen.

Klicken Sie auf der Seite „Computekonfiguration“ auf die Umschaltfläche Erweitert.

Klicken Sie auf die Registerkarte Spark.

Geben Sie in der Spark-Konfiguration die Konfigurationseigenschaften als ein Schlüssel-Wert-Paar pro Zeile ein.

Wenn Sie ein Compute mit der Cluster-API konfigurieren, legen Sie Spark-Eigenschaften im Feld spark_conf in der API zum Erstellen von Clustern oder der API zum Aktualisieren der Cluster fest.

Um Spark-Konfigurationen auf Berechnungsressourcen durchzusetzen, können Administratoren Berechnungsrichtlinien verwenden.

Abrufen einer Spark-Konfigurationseigenschaft aus einer geheimen Quelle

Databricks empfiehlt, vertrauliche Informationen wie Kennwörter nicht als Klartext, sondern in einem Geheimnis zu speichern. Verwenden Sie die folgende Syntax, um auf ein Geheimnis in der Spark-Konfiguration zu verweisen:

spark.<property-name> {{secrets/<scope-name>/<secret-name>}}

Verwenden Sie beispielsweise folgenden Code, um eine Spark-Konfigurationseigenschaft namens password auf den Wert des in secrets/acme_app/password gespeicherten Geheimnisses festzulegen:

spark.password {{secrets/acme-app/password}}

Weitere Informationen finden Sie unter Verwalten von geheimen Schlüsseln.

SSH-Zugriff auf Rechenressourcen

Aus Sicherheitsgründen ist der SSH-Port in Azure Databricks standardmäßig geschlossen. Informationen zum Aktivieren des SSH-Zugriffs auf Ihre Spark-Cluster finden Sie unter SSH-Verbindung mit dem Treiberknoten.

Hinweis

SSH kann nur aktiviert werden, wenn Ihr Arbeitsbereich in Ihrem eigenen virtuellen Azure-Netzwerk bereitgestellt wird.

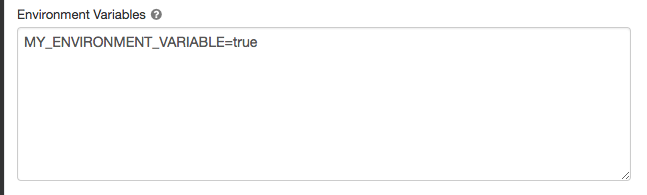

Umgebungsvariablen

Konfigurieren Sie benutzerdefinierte Umgebungsvariablen, auf die Sie über Initialisierungsskripts, die auf der Computeressource ausgeführt werden, zugreifen können. Databricks bietet auch vordefinierte Umgebungsvariablen, die Sie in Initialisierungsskripts verwenden können. Sie können diese vordefinierten Umgebungsvariablen nicht außer Kraft setzen.

Klicken Sie auf der Seite „Computekonfiguration“ auf die Umschaltfläche Erweitert.

Klicken Sie auf die Registerkarte Spark.

Legen Sie die Umgebungsvariablen im Feld "Umgebungsvariablen" fest .

Sie können auch Umgebungsvariablen mithilfe des Felds spark_env_vars in der API zum Erstellen von Clustern oder der API zum Aktualisieren der Cluster festlegen.

Computeprotokollübermittlung

Wenn Sie eine All-Purpose- oder Auftragsberechnung erstellen, können Sie einen Speicherort angeben, an dem die Clusterprotokolle für den Spark-Treiberknoten, Workerknoten und Ereignisse bereitgestellt werden sollen. Protokolle werden alle fünf Minuten übermittelt und stündlich am ausgewählten Ziel archiviert. Databricks liefert alle Protokolle, die bis zum Beenden der Computeressource generiert wurden.

So konfigurieren Sie den Speicherort für die Protokollbereitstellung

- Klicken Sie auf der Seite „Compute“ auf die Umschaltfläche Erweitert.

- Klicken Sie auf die Registerkarte Protokollierung.

- Wählen Sie einen Zieltyp aus.

- Geben Sie den Protokollpfad ein.

Um die Protokolle zu speichern, erstellt Databricks einen Unterordner in Ihrem ausgewählten Protokollpfad, der nach der Berechnung cluster_idbenannt ist.

Wenn z. B. der angegebene Protokollpfad /Volumes/catalog/schema/volume ist, werden Protokolle für 06308418893214 an /Volumes/catalog/schema/volume/06308418893214 geliefert.

Hinweis

Die Bereitstellung von Protokollen an Volumes befindet sich in der öffentlichen Vorschau und wird nur auf Unity Catalog-fähigem Computing mit Standard oder Dediziertem Zugriffsmodus unterstützt. Überprüfen Sie im Standardzugriffsmodus, ob der Clusterbesitzer Dateien auf das Volume hochladen kann. Stellen Sie im Modus "Dedizierter Zugriff" sicher, dass der zugewiesene Benutzer oder die Gruppe Dateien auf das Volume hochladen kann. Siehe den Vorgang zum Erstellen, Löschen oder Aktualisieren von Dateien in Berechtigungen für Unity-Katalog-Volumes.

Hinweis

Dieses Feature ist auch in der REST-API verfügbar. Weitere Informationen finden Sie unter Cluster-API.