Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Mit der Databricks-Erweiterung für Visual Studio Code können Sie Ihren Python-Code auf einem Cluster oder Ihren Python-, R-, Scala- oder SQL-Code oder Ihr Notebook als Auftrag in Azure Databricks ausführen.

In diesem Artikel wird davon ausgegangen, dass Sie die Databricks-Erweiterung für Visual Studio Code bereits installiert und eingerichtet haben. Weitere Informationen finden Sie unter Installieren der Databricks-Erweiterung für Visual Studio Code.

Hinweis

Verwenden Sie Databricks Connect zum Debuggen von Code oder Notebooks über Visual Studio Code. Siehe Debuggen von Code mithilfe von Databricks Connect für die Databricks-Erweiterung für Visual Studio Code und Ausführen und Debuggen von Notebookzellen mit Databricks Connect mithilfe der Databricks-Erweiterung für Visual Studio Code.

Ausführen einer Python-Datei auf einem Cluster

Hinweis

Dieses Feature ist nicht verfügbar, wenn serverlose Berechnungen verwendet werden.

Gehen Sie zum Ausführen einer Python-Datei auf einem Azure Databricks-Cluster mithilfe der Databricks-Erweiterung bei geöffneter Erweiterung und geöffnetem Projekt folgendermaßen vor:

- Öffnen Sie die Python-Datei, die Sie im Cluster ausführen möchten.

- Führen Sie eines der folgenden Verfahren aus:

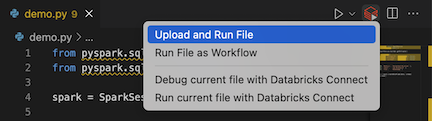

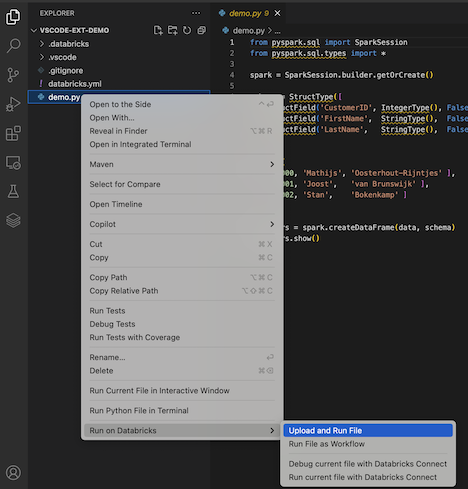

Klicken Sie in der Titelleiste des Datei-Editors auf das Symbol " Auf Databricks ausführen ", und klicken Sie dann auf "Datei hochladen" und "Datei ausführen".

Klicken Sie in der Ansicht Explorer (Ansicht > Explorer) mit der rechten Maustaste auf die Datei und wählen Sie dann im Kontextmenü Datei in Databricks ausführen>Datei hochladen und ausführen aus.

Die Datei wird im Cluster ausgeführt, und die Ausgabe ist in der Debugging-Konsole (Ansicht > Debugging-Konsole) verfügbar.

Ausführen einer Python-Datei als Auftrag

Gehen Sie zum Ausführen einer Python-Datei als Azure Databricks-Auftrag mithilfe der Databricks-Erweiterung für Visual Studio Code bei geöffneter Erweiterung und geöffnetem Projekt folgendermaßen vor:

- Öffnen Sie die Python-Datei, die Sie als Auftrag ausführen möchten.

- Führen Sie eines der folgenden Verfahren aus:

Klicken Sie in der Titelleiste des Datei-Editors auf das Symbol Auf Databricks ausführen und dann auf „Datei als Workflow ausführen“.

Klicken Sie in der Ansicht Explorer (Ansicht > Explorer) mit der rechten Maustaste auf die Datei und wählen Sie dann im Kontextmenü In Databricks ausführen>Datei als Workflow ausführen aus.

Eine neue Editor-Registerkarte mit dem Titel Databricks-Auftragsausführung wird angezeigt. Die Datei wird als Aufgabe im Arbeitsbereich ausgeführt, und jede Ausgabe wird im Ausgabe-Bereich der neuen Editorregisterkarte angezeigt.

Um Informationen zur Ausführung des Jobs anzuzeigen, klicken Sie auf den Link "Taskausführungs-ID" in der neuen Registerkarte "Databricks Jobausführungs-Editor". Ihr Arbeitsbereich wird geöffnet und die Details der Jobausführung werden im Arbeitsbereich angezeigt.

Ausführen eines Python-, R-, Scala- oder SQL-Notebooks als Auftrag

Gehen Sie zum Ausführen eines Notebooks als Azure Databricks-Auftrag mithilfe der Databricks-Erweiterung für Visual Studio Code bei geöffneter Erweiterung und geöffnetem Projekt folgendermaßen vor:

Öffnen Sie das Notebook, das Sie als Auftrag ausführen möchten.

Tipp

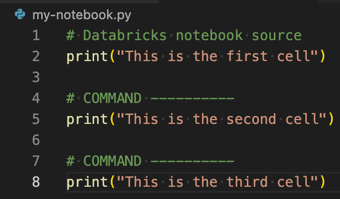

Um eine Python-, R-, Scala- oder SQL-Datei in ein Azure Databricks-Notebook umzuwandeln, fügen Sie den Kommentar

# Databricks notebook sourceam Anfang der Datei und den Kommentar# COMMAND ----------vor jeder Zelle hinzu. Weitere Informationen finden Sie unter Konvertieren einer Datei in ein Notizbuch.

Führen Sie eines der folgenden Verfahren aus:

- Klicken Sie in der Titelleiste des Notizbuchdatei-Editors auf das Symbol "Auf Databricks ausführen" und dann auf "Datei als Workflow ausführen".

Hinweis

Wenn In Databricks als Workflow ausführen nicht verfügbar ist, finden Sie weitere Informationen unter Erstellen einer benutzerdefinierten Ausführungskonfiguration.

- Klicken Sie in der Ansicht Explorer (Ansicht > Explorer) mit der rechten Maustaste auf die Notebookdatei und wählen Sie dann im Kontextmenü In Databricks ausführen>Datei als Workflow ausführen aus.

Eine neue Editor-Registerkarte mit dem Titel Databricks-Auftragsausführung wird angezeigt. Das Notebook wird im Arbeitsbereich als Auftrag ausgeführt. Das Notizbuch und seine Ausgabe werden im Ausgabebereich des neuen Editor-Tabs angezeigt.

Zum Anzeigen von Informationen zum Jobdurchlauf klicken Sie auf der Registerkarte Databricks-Auftragseditor auf den Link Task-Ausführungs-ID. Ihr Arbeitsbereich wird geöffnet, und die Details des Jobdurchlaufs werden im Arbeitsbereich angezeigt.

Erstellen einer benutzerdefinierten Ausführungskonfiguration

Mit einer benutzerdefinierten Ausführungskonfiguration für die Databricks-Erweiterung in Visual Studio Code können Sie benutzerdefinierte Argumente an einen Auftrag oder ein Notebook übergeben oder verschiedene Ausführungseinstellungen für verschiedene Dateien erstellen.

Klicken Sie zum Erstellen einer benutzerdefinierten Ausführungskonfiguration im Hauptmenü in Visual Studio Code auf Ausführen > Konfiguration hinzufügen. Wählen Sie dann Databricks für eine clusterbasierte Ausführungskonfiguration oder Databricks: Workflow für eine auftragsbasierte Ausführungskonfiguration aus.

Die folgende benutzerdefinierte Ausführungskonfiguration ändert z. B. den Startbefehl Datei als Workflow ausführen so, dass das Argument --prod an den Auftrag übergeben wird:

{

"version": "0.2.0",

"configurations": [

{

"type": "databricks-workflow",

"request": "launch",

"name": "Run on Databricks as Workflow",

"program": "${file}",

"parameters": {},

"args": ["--prod"]

}

]

}

Tipp

Fügen Sie "databricks": true Ihrer "type": "python" Konfiguration hinzu, wenn Sie die Python-Konfiguration verwenden möchten, und nutzen Sie die Databricks Connect-Authentifizierung, die Teil des Erweiterungssetups ist.

Mithilfe von benutzerdefinierten Ausführungskonfigurationen können Sie auch Befehlszeilenargumente übergeben und Ihren Code ausführen, indem Sie einfach F5 drücken. Weitere Informationen finden Sie unter Starten von Konfigurationen in der Visual Studio Code-Dokumentation.