Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Azure Machine Learning-Prompt-Flow ist ein Entwicklungstool, das dazu dient, den gesamten Entwicklungszyklus von KI-Anwendungen zu optimieren, die auf LLMs (Large Language Models, große Sprachmodelle) basieren. Prompt flow bietet eine umfassende Lösung, die den Prozess der Prototyperstellung, des Experimentierens, Durchlaufens und Bereitstellens Ihrer KI-Anwendungen vereinfacht.

Azure Machine Learning Prompt Flow ermöglicht Ihnen Folgendes:

- Erstellen ausführbarer Flows, die LLMs, Prompts und Python-Tools über einen visualisierten Graphen verknüpfen

- Einfaches Debuggen, Freigeben und Iterieren Ihrer Flows in Zusammenarbeit mit dem ganzen Team

- Erstellen von Prompt-Varianten und Bewerten von deren Leistung durch umfangreiche Tests

- Bereitstellen eines Echtzeitendpunkts, der die volle Leistungsfähigkeit der LLMs für Ihre Anwendung verfügbar macht

Azure Machine Learning Prompt Flow bietet eine vielseitige, intuitive Möglichkeit, Ihre LLM-basierte KI-Entwicklung zu optimieren.

Vorteile der Verwendung von Azure Machine Learning-Prompt-Flow

Azure Machine Learning-Prompt-Flow bietet eine Vielzahl von Vorteilen, die Benutzer*innen von der Idee für eine Anwendung über die Experimente bis zur finalen Fertigstellung produktionsbereiter LLM-basierter Anwendungen unterstützen:

Flexibilität beim Prompt Engineering

- Interaktive Erstellungsumgebung: Visuelle Darstellung der Struktur des Flows, sodass Benutzer und Benutzerinnen ihre Projekte leicht verstehen und darin navigieren können. Er bietet auch eine Notebook-ähnliche Programmierumgebung für das effiziente Entwickeln und Debuggen von Flows.

- Varianten für die Prompt-Optimierung: Benutzer*innen können mehrere Prompt-Varianten erstellen und miteinander vergleichen, um den Flow schrittweise zu verfeinern.

- Auswertung: Integrierte Auswertungsflows ermöglichen Benutzer*innen, die Qualität und Effektivität ihrer Prompts und Flows zu bewerten.

- Umfassende Ressourcen: Zugriff auf eine Bibliothek mit integrierten Tools, Beispielen und Vorlagen, die als Ausgangspunkt für die Entwicklung dienen, die Kreativität anregen und den Prozess beschleunigen.

Unternehmensbereite LLM-basierte Anwendungen

- Zusammenarbeit: Unterstützt die Zusammenarbeit im Team, sodass mehrere Teammitglieder gemeinsam an Prompt-Engineering-Projekten arbeiten, Wissen austauschen und die Versionskontrolle aufrecht erhalten können.

- Zentralisierte Plattform: Rationalisiert den gesamten Prompt-Engineering-Prozess, von der Entwicklung und Bewertung bis hin zur Bereitstellung und Überwachung. Benutzer*innen können ihre Flows mühelos als Azure Machine Learning-Endpunkte bereitstellen und ihre Leistung in Echtzeit überwachen, um einen optimalen Betrieb sicherzustellen und kontinuierlich Verbesserungen vorzunehmen.

- Azure Machine Learning-Lösungen für Unternehmensbereitschaft: Prompt-Flow verwendet die robusten Azure Machine Learning-Lösungen für Unternehmensbereitschaft und bietet ein sicheres, skalierbares und zuverlässiges Fundament für die Entwicklung, für Experimente und für die Bereitstellung von Flows.

Azure Machine Learning Prompt Flow ermöglicht agiles Prompt-Engineering, nahtlose Zusammenarbeit und robuste LLM-basierte Unternehmensanwendungsentwicklung und -bereitstellung.

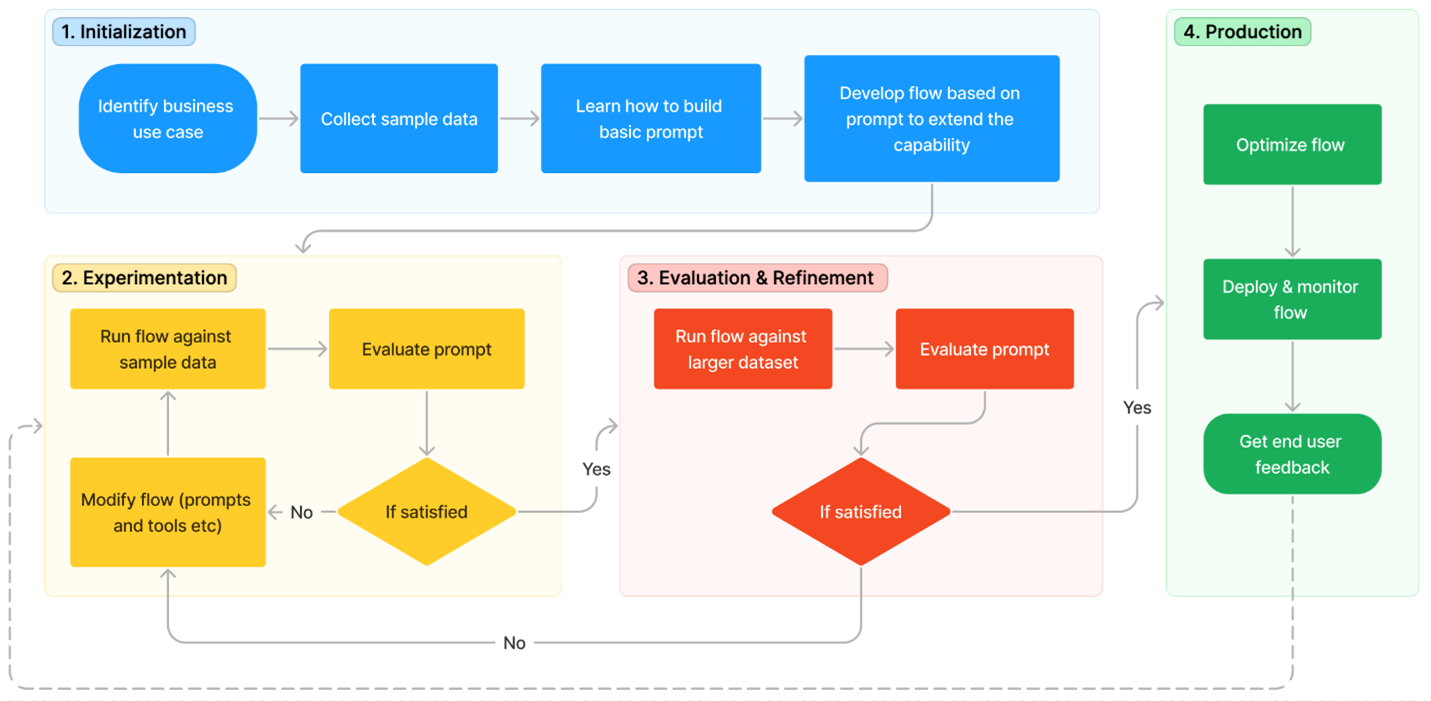

Lebenszyklus der Entwicklung LLM-basierter Anwendungen

Azure Machine Learning Prompt Flow optimiert die KI-Anwendungsentwicklung und führt Sie durch die Entwicklung, Tests, Optimierung und Bereitstellung von Flows zum Erstellen vollständiger KI-Anwendungen.

Der Lebenszyklus umfasst die folgenden Phasen:

- Initialisierung: Identifizieren Sie den geschäftlichen Anwendungsfall, sammeln Sie Beispieldaten, erfahren Sie, wie Sie einen einfachen Prompt erstellen, und entwickeln Sie einen Flow, der seine Funktionen erweitert.

- Experimente: Führen Sie den Flow anhand von Beispieldaten aus, werten Sie die Leistung des Prompts aus, und iterieren Sie den Flow bei Bedarf. Experimentieren Sie so lange, bis Sie mit den Ergebnissen zufrieden sind.

- Auswertung und Optimierung: Bewerten Sie die Leistung des Flows, indem Sie ihn auf ein größeres Dataset anwenden, die Effektivität des Prompts auswerten und ihn bei Bedarf optimieren. Fahren Sie mit der nächsten Phase fort, wenn die Ergebnisse die gewünschten Kriterien erfüllen.

- Produktion: Optimieren Sie die Effizienz und Effektivität des Flows, stellen Sie ihn bereit, überwachen Sie seine Leistung in einer Produktionsumgebung, und sammeln Sie Nutzungsdaten und Feedback. Verwenden Sie diese Informationen dazu, den Ablauf zu verbessern und bei früheren Phasen nachfolgender Iterationen zu helfen.

Dank des methodischen Prozesses von Prompt Flows können Sie anspruchsvolle KI-Anwendungen sicher entwickeln, testen, verfeinern und bereitstellen.