Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

In diesem Tutorial wird gezeigt, wie Sie den No-Code-Editor von Stream Analytics verwenden, um einen Auftrag zu erstellen, der Event Hubs-Daten in Azure Data Lake Storage Gen2 im Parquetformat aufzeichnet.

In diesem Tutorial lernen Sie Folgendes:

- Bereitstellen eines Ereignis-Generators, der Beispielereignisse an einen Event Hub sendet

- Erstellen eines Stream Analytics-Auftrags mit dem No-Code-Editor

- Überprüfen von Eingabedaten und Schema

- Konfigurieren von Azure Data Lake Storage Gen2, in den Event Hub-Daten erfasst werden

- Ausführen des Stream Analytics-Auftrags

- Verwenden von Azure Synapse Analytics zum Abfragen Parquet-Dateien

Voraussetzungen

Stellen Sie zunächst sicher, dass Sie folgende Schritte abgeschlossen haben:

- Wenn Sie kein Azure-Abonnement besitzen, können Sie ein kostenloses Konto erstellen.

- Stellen Sie die Ereignis-Generator-App „TollApp“ in Azure bereit. Legen Sie den Parameter „interval“ auf 1 fest, und verwenden Sie für diesen Schritt eine neue Ressourcengruppe.

- Erstellen Sie einen Azure Synapse Analytics-Arbeitsbereich mit einem Data Lake Storage Gen2-Konto.

Verwenden des No-Code-Editors zum Erstellen eines Stream Analytics-Auftrags

Suchen Sie die Ressourcengruppe, in der der TollApp-Ereignisgenerator bereitgestellt wurde.

Wähen Sie den Azure Event Hubs-Namespace aus. Möglicherweise möchten Sie sie auf einer separaten Registerkarte oder in einem Fenster öffnen.

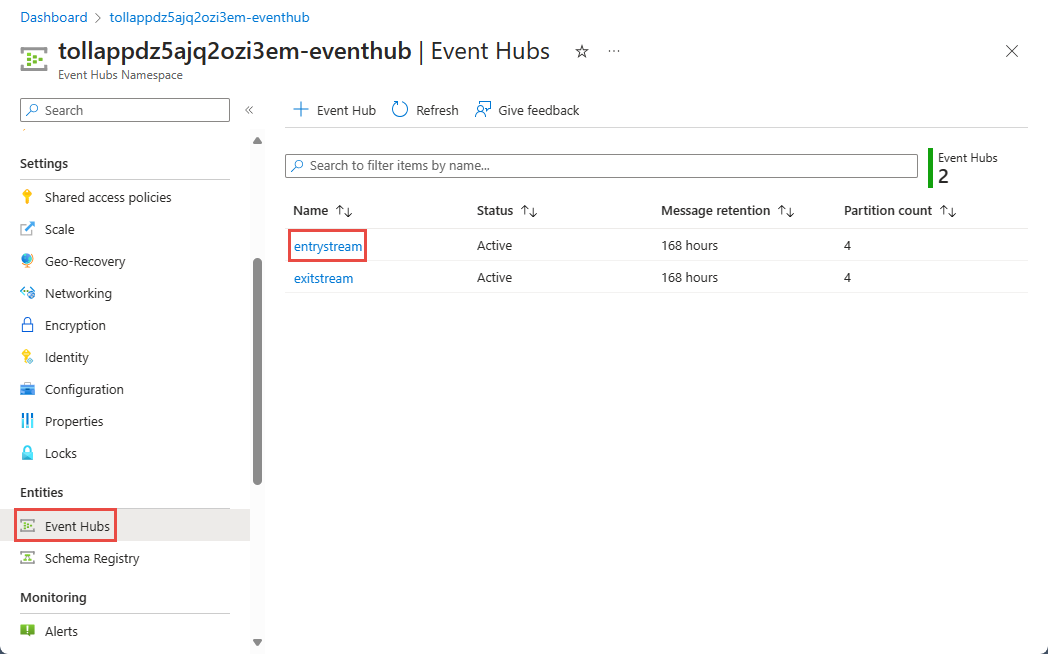

Wählen Sie auf der Seite Event Hubs-NamespaceEvent Hubs unter Entitäten im linken Menü aus.

Wählen Sie die

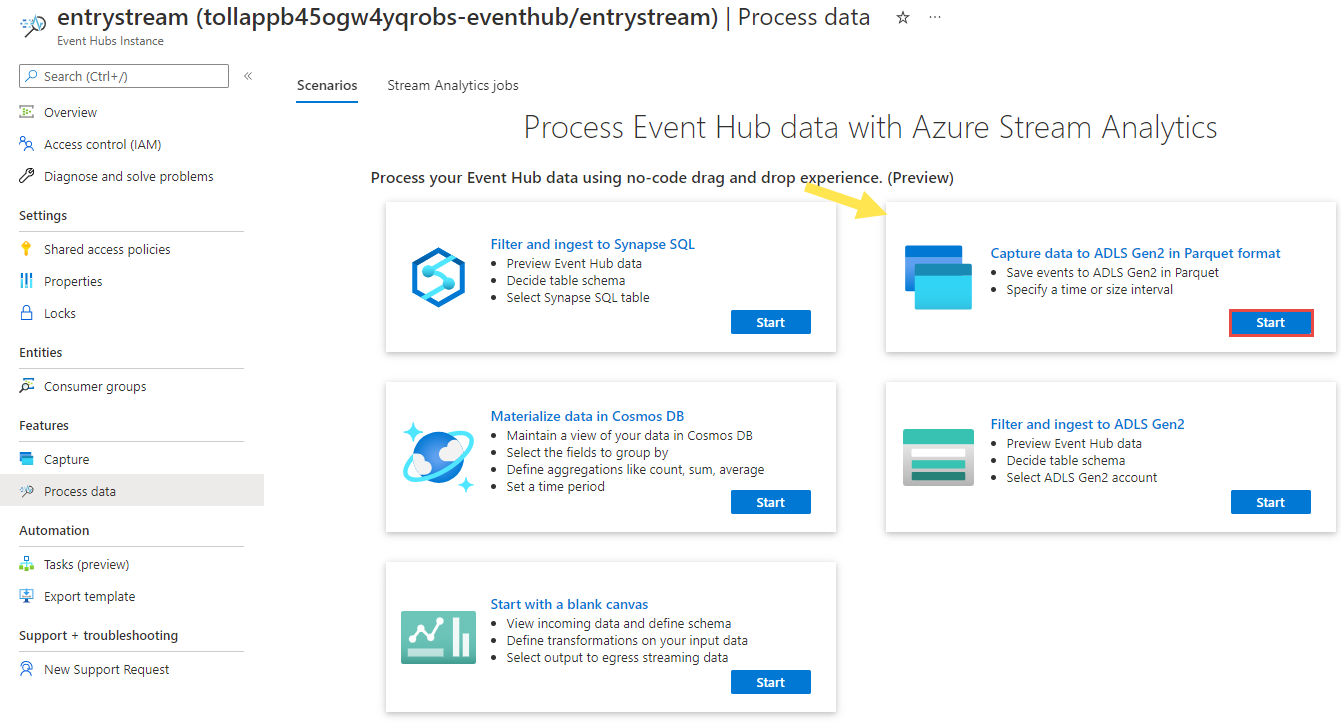

entrystream-Instanz aus.Wählen Sie auf der Seite Event Hubs-Instanz die Option Daten verarbeiten im Abschnitt Features im linken Menü aus.

Wählen Sie auf der Kachel Daten im Parquet-Format in ADLS Gen2 erfassen die Option Start aus.

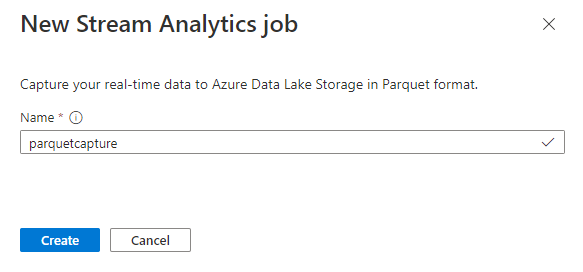

Benennen Sie Ihren Auftrag

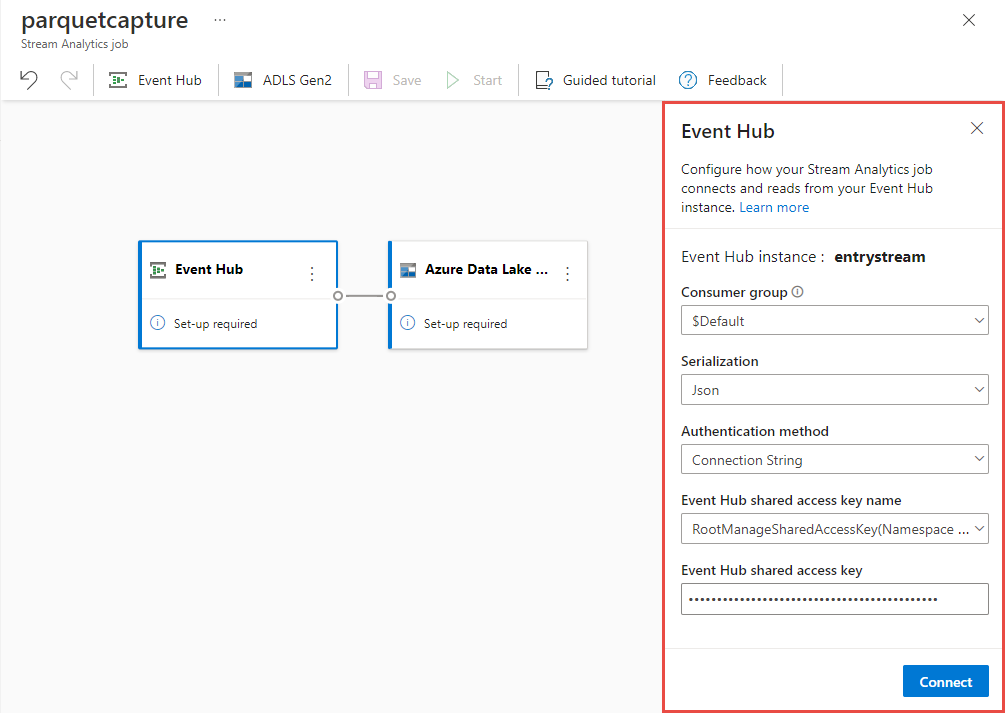

parquetcapture, und wählen Sie Erstellen aus.Führen Sie auf der Event Hub-Konfigurationsseite die folgenden Schritte aus:

Wählen Sie für Consumergruppe die Option Vorhandene verwenden aus.

Vergewissern Sie sich, dass

$DefaultConsumergruppe ausgewählt ist.Vergewissern Sie sich, dass die Serialisierung auf „JSON“ festgelegt ist.

Vergewissern Sie sich, dass Authentifizierungsmethode auf Verbindungszeichenfolge festgelegt ist.

Vergewissern Sie sich, dass der Name des freigegebenen Zugriffsschlüssels für den Event Hub auf RootManageSharedAccessKey festgelegt ist.

Wählen Sie unten im Fenster die Option Verbinden aus.

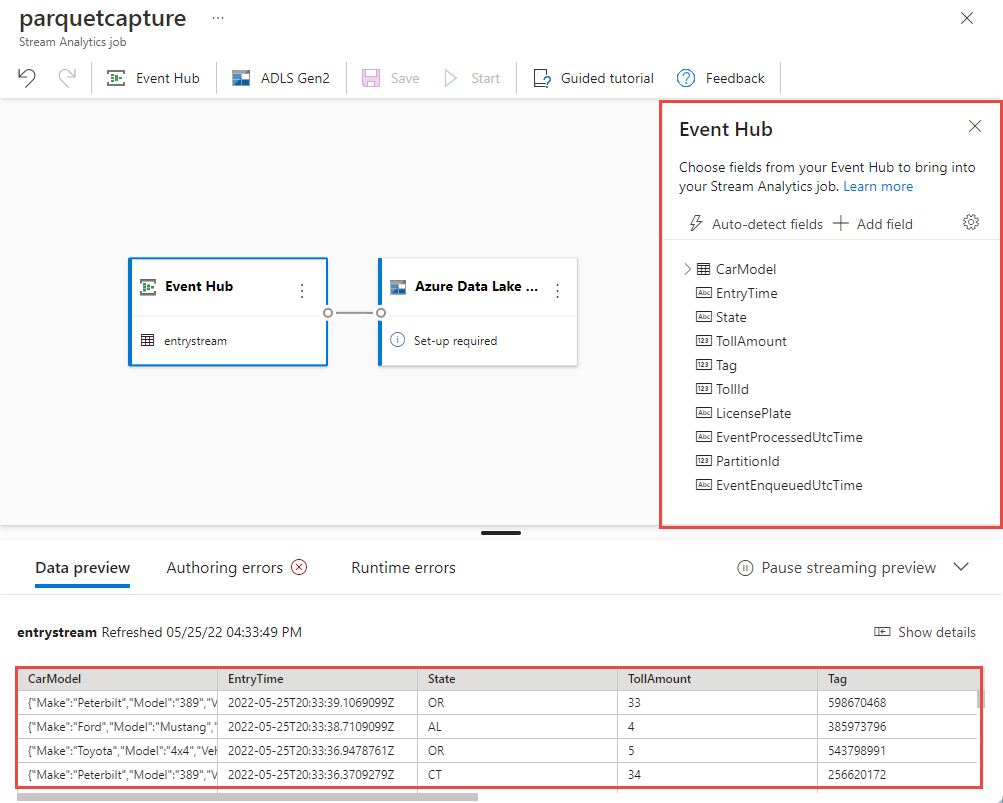

Innerhalb weniger Sekunden werden Beispieleingabedaten und das Schema angezeigt. Sie können Felder löschen, Felder umbenennen oder den Datentyp ändern.

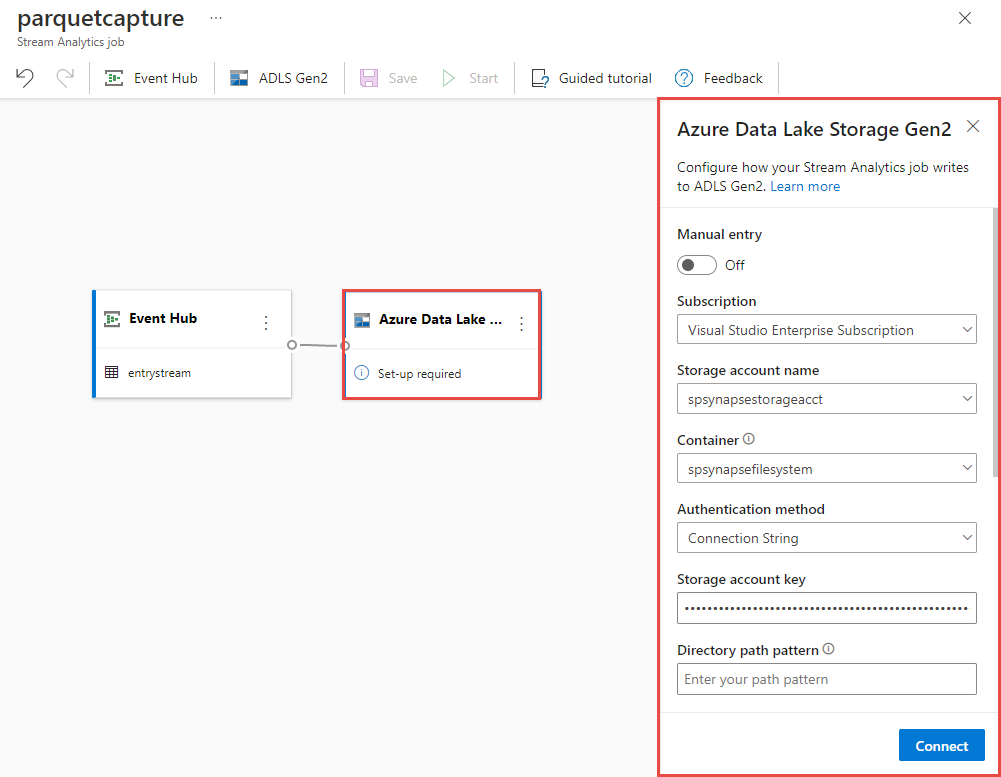

Wählen Sie die Kachel Azure Data Lake Storage Gen2 im Zeichenbereich aus, und konfigurieren Sie mit folgenden Angaben:

Abonnement, in dem sich Ihr Azure Data Lake Gen2-Konto befindet

Name des Speicherkontos, der mit dem ADLS Gen2-Konto übereinstimmen sollte, das mit Ihrem Azure Synapse Analytics-Arbeitsbereich aus dem Abschnitt „Voraussetzungen“ verwendet wurde.

Container, in dem die Parquet-Dateien erstellt werden.

Geben Sie für den Delta-Tabellenpfad einen Namen für die Tabelle an.

Datums- und Uhrzeitmuster wie Standard (JJJJ-MM-TT und HH).

Wählen Sie Verbinden aus.

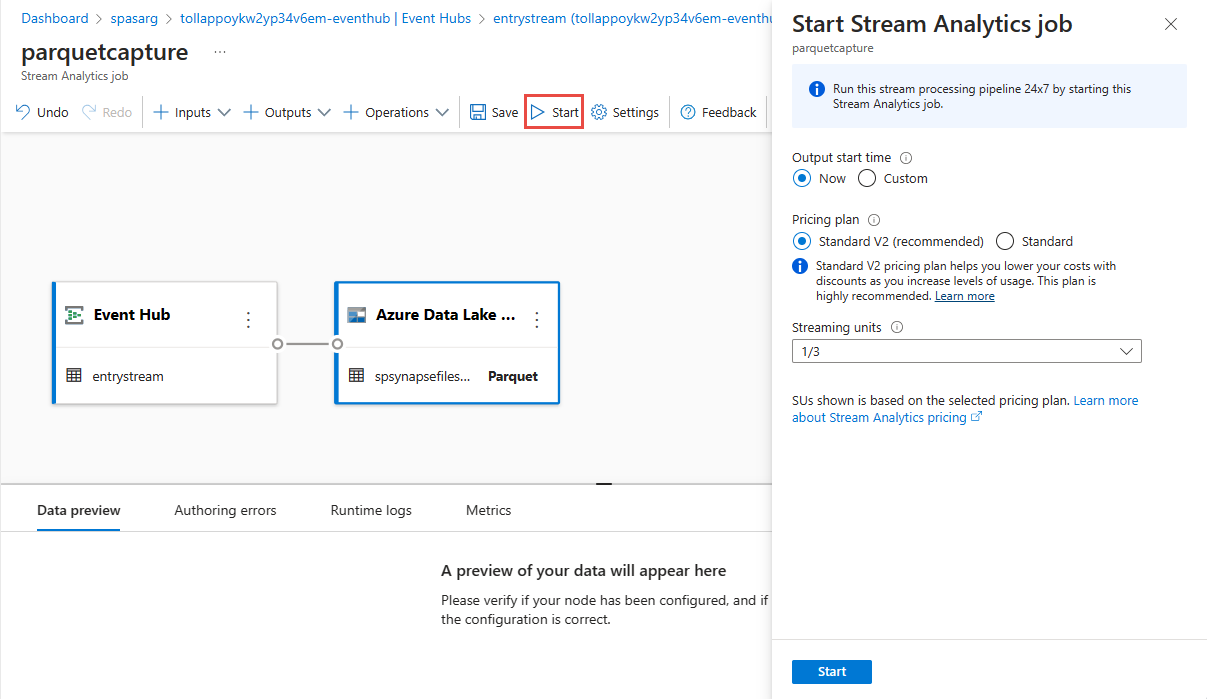

Wählen Sie im oberen Menüband Speichern aus, um Ihren Auftrag zu speichern, und wählen Sie dann Start aus, um Ihren Auftrag auszuführen. Nachdem der Auftrag gestartet wurde, wählen Sie in der rechten Ecke X aus, um die Stream Analytics-Auftragsseite zu schließen.

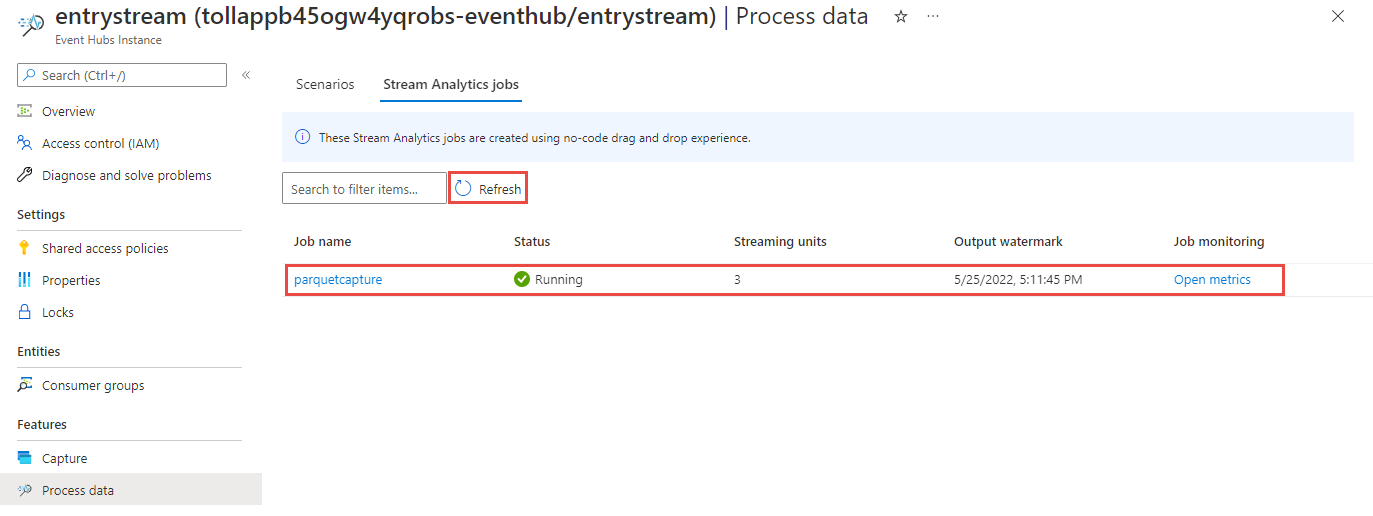

Anschließend wird eine Liste aller Stream Analytics-Aufträge angezeigt, die mit dem No-Code-Editor erstellt wurden. Und innerhalb von zwei Minuten wechselt Ihr Auftrag in den Zustand Wird ausgeführt. Wählen Sie die Schaltfläche Aktualisieren auf der Seite aus, um zu sehen, wie der Status von „Erstellt“ > „Wird gestartet“ > „Wird ausgeführt“ wechselt.

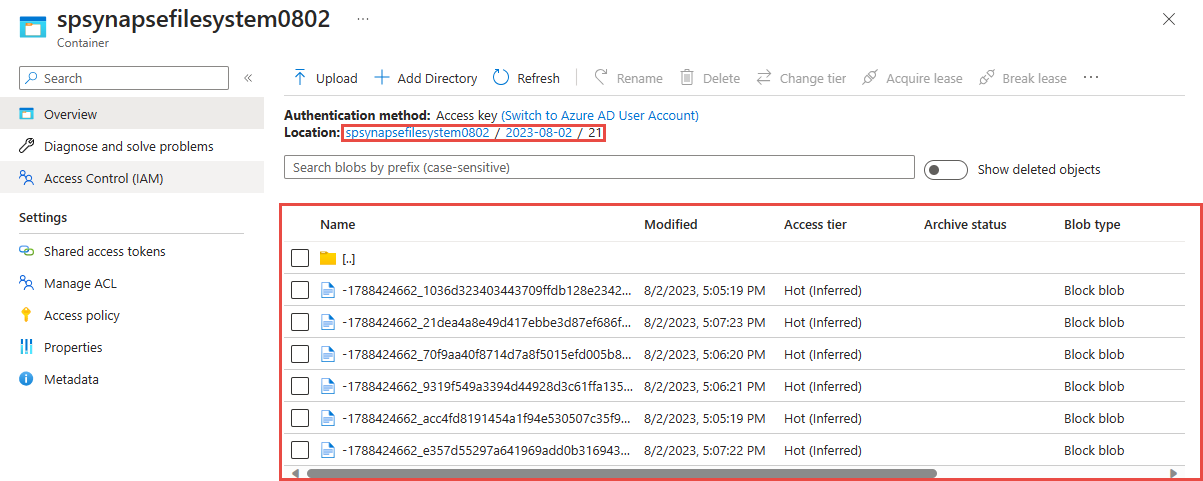

Anzeigen der Ausgabe in Ihrem Azure Data Lake Storage Gen 2-Konto

Suchen Sie das Azure Data Lake Storage Gen2-Konto, das Sie im vorherigen Schritt verwendet haben.

Wählen Sie den Container aus, den Sie im vorherigen Schritt verwendet haben. In dem Ordner, den Sie zuvor angegeben haben, werden Parkettdateien angezeigt.

Abfragen erfasster Daten im Parquet-Format mit Azure Synapse Analytics

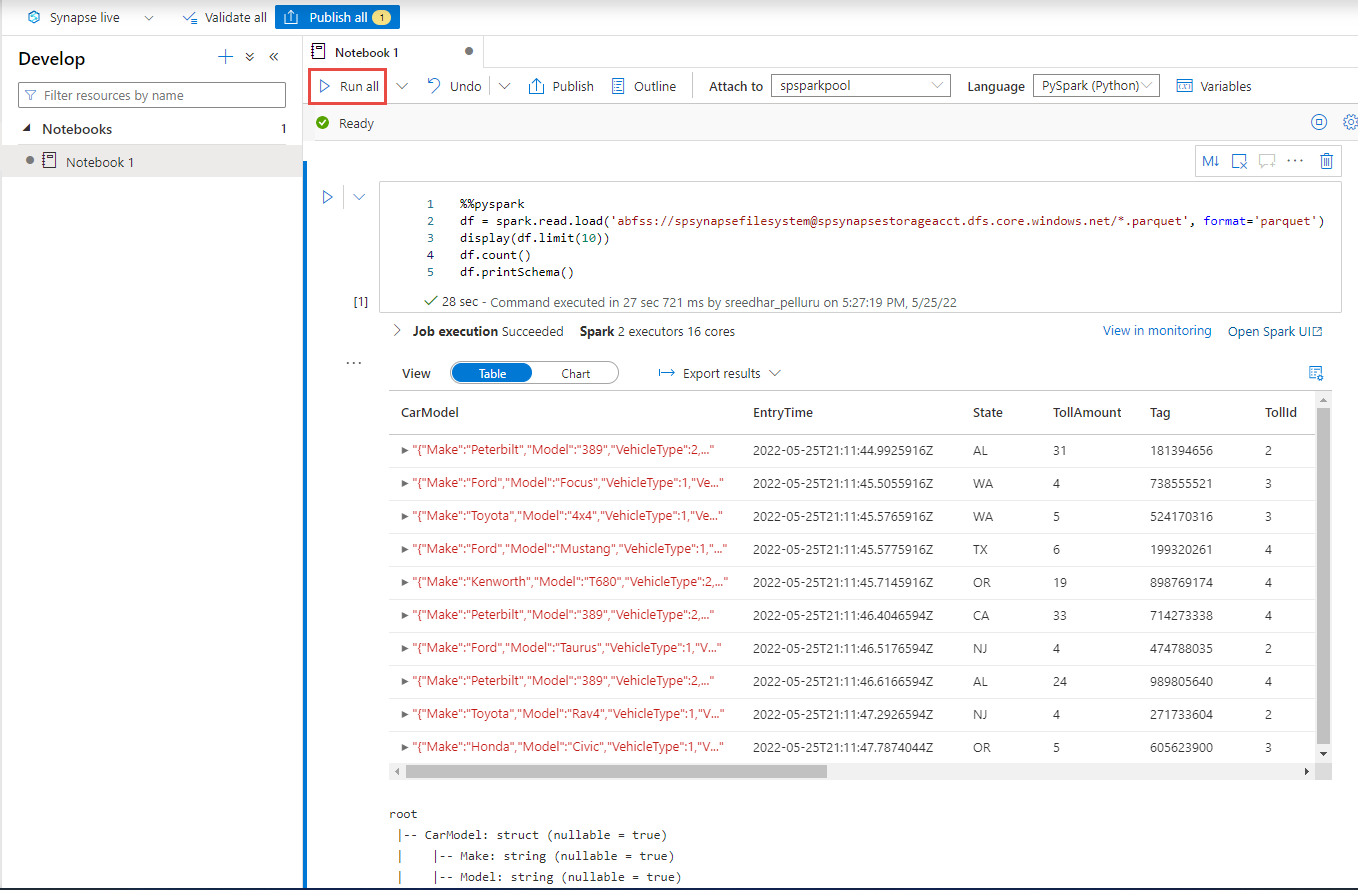

Abfragen mit Azure Synapse Spark

Suchen Sie Ihren Azure Synapse Analytics-Arbeitsbereich, und öffnen Sie Synapse Studio.

Erstellen Sie einen serverlosen Apache Spark-Pool in Ihrem Arbeitsbereich, wenn noch nicht vorhanden ist.

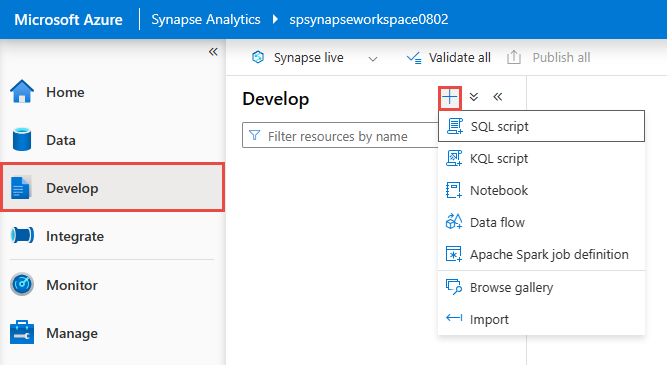

Navigieren Sie in Synapse Studio zum Hub Entwickeln, und erstellen Sie ein neues Notebook.

Erstellen Sie eine neue Codezelle, und fügen Sie den folgenden Code in diese Zelle ein. Ersetzen Sie container durch den Namen des Containers und adlsname durch den Namen des ADLS Gen2-Kontos, die im vorherigen Schritt verwendet wurden.

%%pyspark df = spark.read.load('abfss://container@adlsname.dfs.core.windows.net/*/*.parquet', format='parquet') display(df.limit(10)) df.count() df.printSchema()Wählen Sie unter Anfügen an auf der Symbolleiste Ihren Spark-Pool aus der Dropdownliste aus.

Wählen Sie Alle Ausführen aus, um die Ergebnisse anzuzeigen.

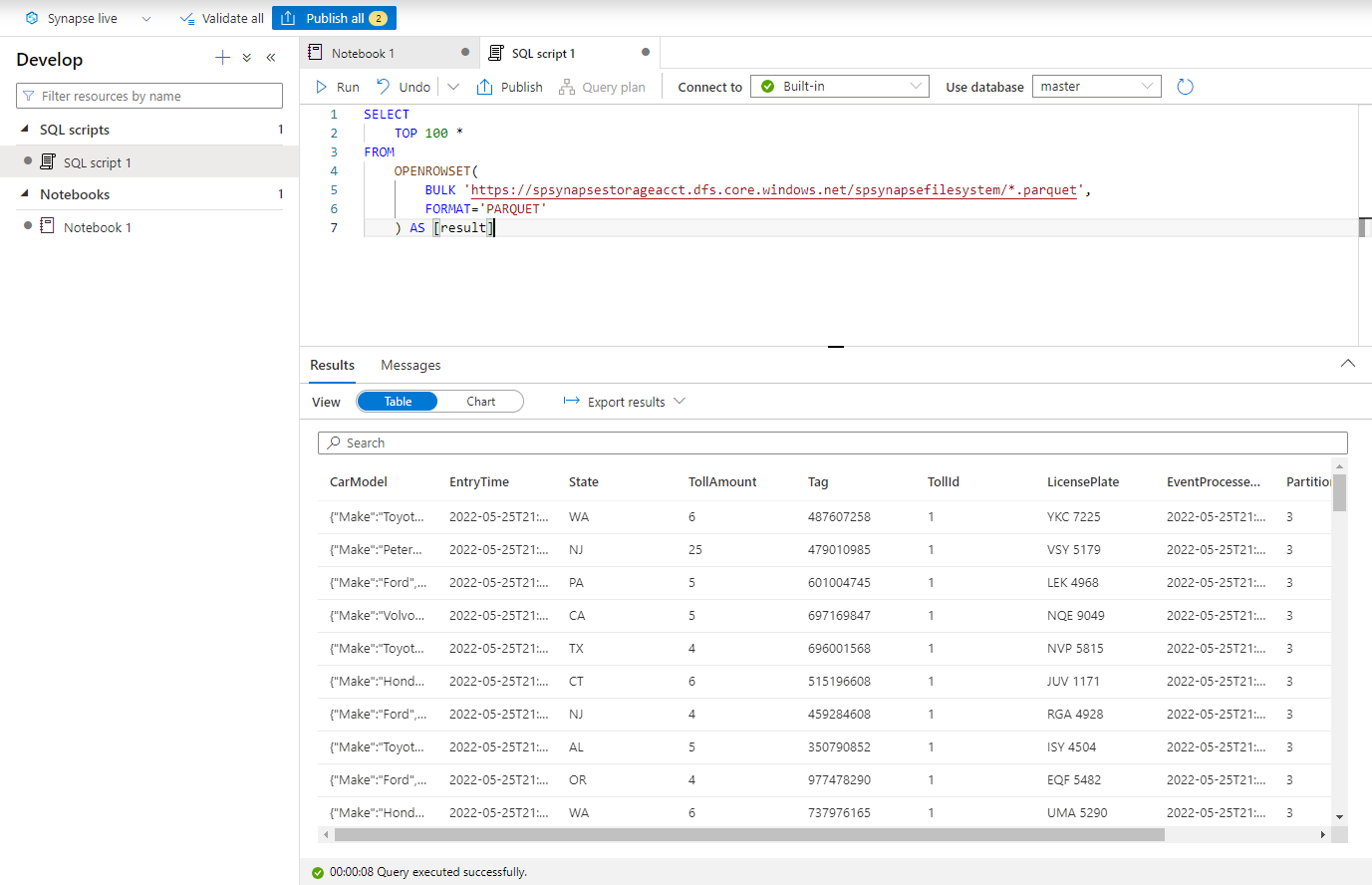

Abfragen mit Azure Synapse SQL (serverlos)

Erstellen Sie im Hub Entwickeln ein neues SQL-Skript.

Fügen Sie das folgende Skript ein, und führen Sie es mithilfe des integrierten serverlosen SQL Endpunkts aus. Ersetzen Sie container durch den Namen des Containers und adlsname durch den Namen des ADLS Gen2-Kontos, die im vorherigen Schritt verwendet wurden.

SELECT TOP 100 * FROM OPENROWSET( BULK 'https://adlsname.dfs.core.windows.net/container/*/*.parquet', FORMAT='PARQUET' ) AS [result]

Bereinigen von Ressourcen

- Suchen Sie Ihre Event Hubs-Instanz, und sehen Sie sich die Liste der Stream Analytics-Aufträge im Abschnitt Daten verarbeiten an. Beenden Sie alle ausgeführten Aufträge.

- Wechseln Sie zur Ressourcengruppe, die Sie beim Bereitstellen des TollApp-Ereignisgenerators verwendet haben.

- Wählen Sie die Option Ressourcengruppe löschen. Geben Sie den Namen der Ressourcengruppe ein, um den Löschvorgang zu bestätigen.

Nächste Schritte

In diesem Tutorial haben Sie gelernt, wie Sie einen Stream Analytics-Auftrag mit dem No-Code-Editor erstellen, um Event Hubs-Datenströme im Parquet-Format zu erfassen. Anschließend haben Sie Azure Synapse Analytics verwendet, um die Parquet-Dateien mithilfe von Synapse Spark und Synapse SQL abzufragen.