Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

In dieser Schnellstartanleitung wird erläutert, wie Sie eine Spark-Auftragsdefinition erstellen, die Python-Code mit strukturiertem Spark-Streaming enthält, um Daten in einem Lakehouse zu speichern und sie dann über einen SQL-Analyseendpunkt bereitzustellen. Nach Abschluss dieser Schnellstartanleitung verfügen Sie über eine Spark-Auftragsdefinition, die kontinuierlich ausgeführt wird, und der SQL-Analyseendpunkt kann die eingehenden Daten anzeigen.

Erstellen eines Python-Skripts

Verwenden Sie das folgende Python-Skript, um eine Streaming-Delta-Tabelle in einem Lakehouse mit Apache Spark zu erstellen. Das Skript liest einen Datenstrom generierter Daten (eine Zeile pro Sekunde) und schreibt ihn im Anfügemodus in eine Delta-Tabelle mit dem Namen streamingtable. Es speichert die Daten und Prüfpunktinformationen im angegebenen Lakehouse.

Verwenden Sie den folgenden Python-Code, der strukturiertes Spark-Streaming verwendet, um Daten in einer Lakehouse-Tabelle abzurufen.

from pyspark.sql import SparkSession if __name__ == "__main__": # Start Spark session spark = SparkSession.builder \ .appName("RateStreamToDelta") \ .getOrCreate() # Table name used for logging tableName = "streamingtable" # Define Delta Lake storage path deltaTablePath = f"Tables/{tableName}" # Create a streaming DataFrame using the rate source df = spark.readStream \ .format("rate") \ .option("rowsPerSecond", 1) \ .load() # Write the streaming data to Delta query = df.writeStream \ .format("delta") \ .outputMode("append") \ .option("path", deltaTablePath) \ .option("checkpointLocation", f"{deltaTablePath}/_checkpoint") \ .start() # Keep the stream running query.awaitTermination()Speichern Sie Ihr Skript als Python-Datei (.py) auf Ihrem lokalen Computer.

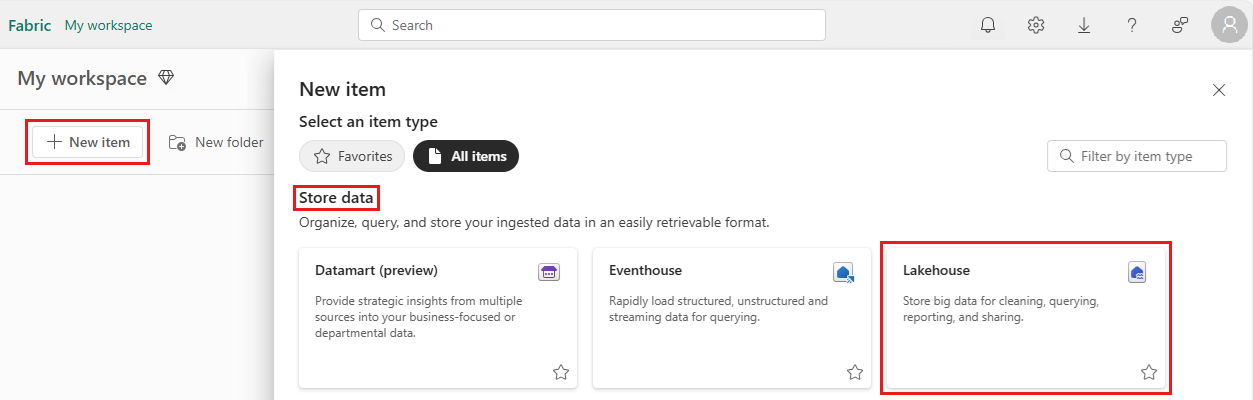

Erstellen eines Lakehouse

Führen Sie die folgenden Schritte aus, um ein Lakehouse zu erstellen:

Melden Sie sich beim Microsoft Fabric-Portal an.

Navigieren Sie zu Ihrem gewünschten Arbeitsbereich, oder erstellen Sie bei Bedarf einen neuen Arbeitsbereich.

Um ein Lakehouse zu erstellen, wählen Sie im Arbeitsbereich Neues Element und dann im daraufhin geöffneten Bereich die Option Lakehouse aus.

Geben Sie den Namen Ihres Lakehouse ein, und wählen Sie Erstellen aus.

Erstellen einer Spark-Auftragsdefinition

Führen Sie die folgenden Schritte aus, um eine Spark-Auftragsdefinition zu erstellen:

Wählen Sie in dem Arbeitsbereich, in dem Sie ein Lakehouse erstellt haben, die Option Neues Element aus.

Wählen Sie im daraufhin geöffneten Bereich unter Daten abrufen die Option Spark-Auftragsdefinition aus.

Geben Sie den Namen Ihrer Spark-Auftragsdefinition ein, und wählen Sie Erstellen aus.

Wählen Sie Hochladen aus, und wählen Sie die Python-Datei aus, die Sie im vorherigen Schritt erstellt haben.

Wählen Sie unter Lakehouse-Referenz das von Ihnen erstellte Lakehouse aus.

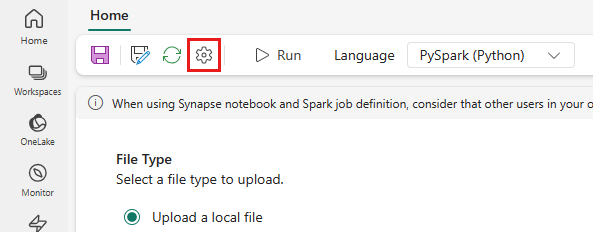

Festlegen der Wiederholungsrichtlinie für die Spark-Auftragsdefinition

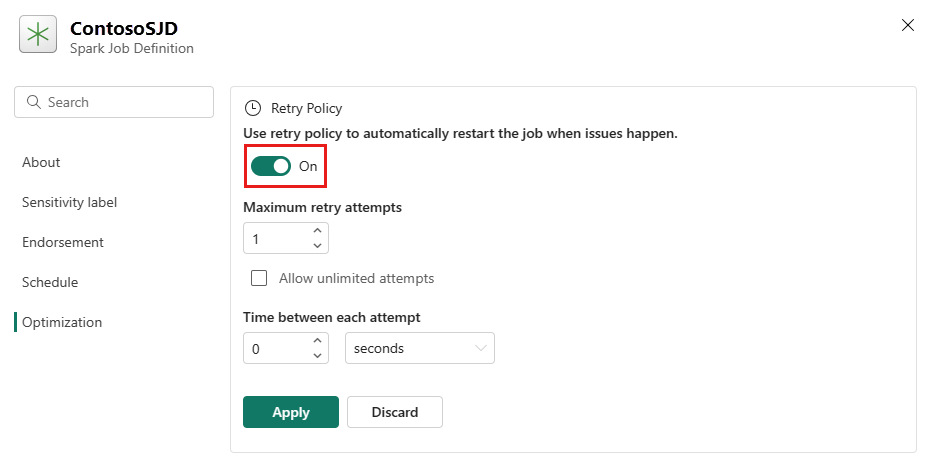

Führen Sie die folgenden Schritte aus, um die Wiederholungsrichtlinie für Ihre Spark-Auftragsdefinition festzulegen:

Wählen Sie im oberen Menü das Symbol Einstellung aus.

Öffnen Sie die Registerkarte Optimierung, und legen Sie den Trigger Wiederholungsrichtlinie auf Ein fest.

Definieren Sie die maximale Anzahl der Wiederholungsversuche, oder aktivieren Sie Unbegrenzte Versuche zulassen.

Geben Sie die Zeit zwischen den einzelnen Wiederholungsversuchen an, und wählen Sie Anwenden aus.

Hinweis

Für die Einrichtung einer Wiederholungsrichtlinie gilt eine maximale Gültigkeitsdauer von 90 Tagen. Nach dem Aktivieren der Wiederholungsrichtlinie wird der Auftrag innerhalb von 90 Tagen gemäß der Richtlinie neu gestartet. Nach diesem Zeitraum werden die Wiederholungsrichtlinie und der Auftrag automatisch beendet. Benutzer*innen müssen dann den Auftrag manuell neu starten, wodurch wiederum die Wiederholungsrichtlinie erneut aktiviert wird.

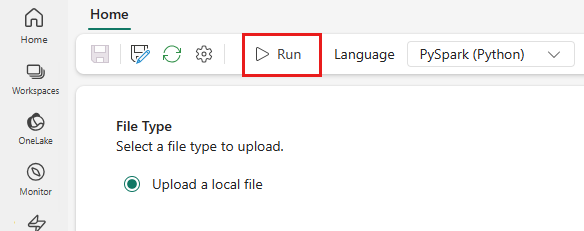

Ausführen und Überwachen der Spark-Auftragsdefinition

Wählen Sie im oberen Menü das Symbol Ausführen aus.

Überprüfen Sie, ob die Spark-Auftragsdefinition erfolgreich übermittelt und ausgeführt wurde.

Anzeigen von Daten mithilfe eines SQL-Analyseendpunkts

Nach Ausführung des Skripts wird eine Tabelle mit dem Namen streamingtable mit Zeitstempel und Wert-Spalten im Lakehouse erstellt. Sie können die Daten mithilfe des SQL-Analyseendpunkts anzeigen:

Öffnen Sie Ihr Lakehouse aus dem Arbeitsbereich.

Wechseln Sie von der oberen rechten Ecke zum SQL-Analyseendpunkt .

Erweitern Sie im linken Navigationsbereich "Schemas > dbo >Tables", wählen Sie "Streamingtable " aus, um eine Vorschau der Daten anzuzeigen.