Modul 1: Erstellen einer Pipeline mit Data Factory

Dieses Modul nimmt ca. zehn Minuten in Anspruch und behandelt das Erfassen von Rohdaten aus dem Quellspeicher in der Bronze-Tabelle eines Data Lakehouse mithilfe der Copy-Aktivität in einer Pipeline.

Die allgemeinen Schritte in Modul 1 lauten wie folgt:

- Erstellen einer Datenpipeline.

- Verwenden einer Copy-Aktivität in der Pipeline zum Laden von Beispieldaten in ein Data Lakehouse

Erstellen einer Datenpipeline

Sie benötigen ein Microsoft Fabric-Mandantenkonto mit einem aktiven Abonnement. Erstellen Sie ein kostenloses Konto.

Stellen Sie sicher, dass Sie über einen für Microsoft Fabric aktivierten Arbeitsbereich verfügen: Erstellen eines Arbeitsbereichs.

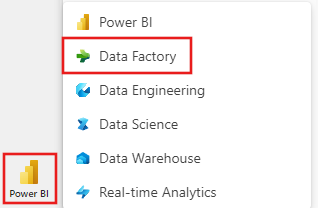

Melden Sie sich bei Power BI an.

Wählen Sie unten links auf dem Bildschirm das Power BI-Standardsymbol aus, und wechseln Sie zur Data Factory-Benutzeroberfläche.

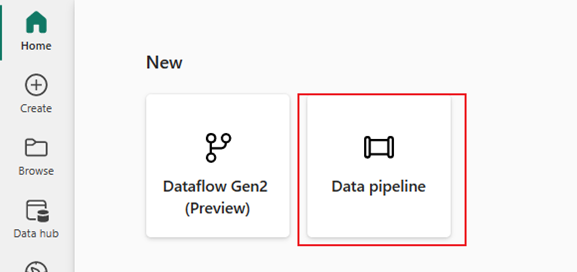

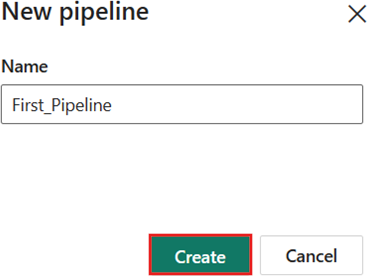

Wählen Sie Datenpipeline aus, und geben Sie einen Pipelinenamen an. Klicken Sie anschließend auf Erstellen.

Verwenden einer Copy-Aktivität in der Pipeline zum Laden von Beispieldaten in ein Data Lakehouse

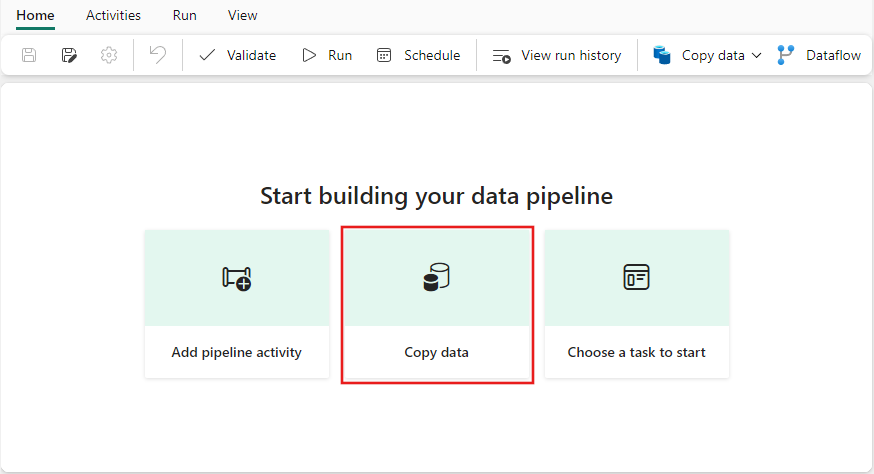

Schritt 1: Verwenden des Kopier-Assistenten zum Konfigurieren einer Copy-Aktivität

Wählen Sie Daten kopieren aus, um den Kopier-Assistenten zu öffnen.

Schritt 2: Konfigurieren der Einstellungen im Kopier-Assistenten

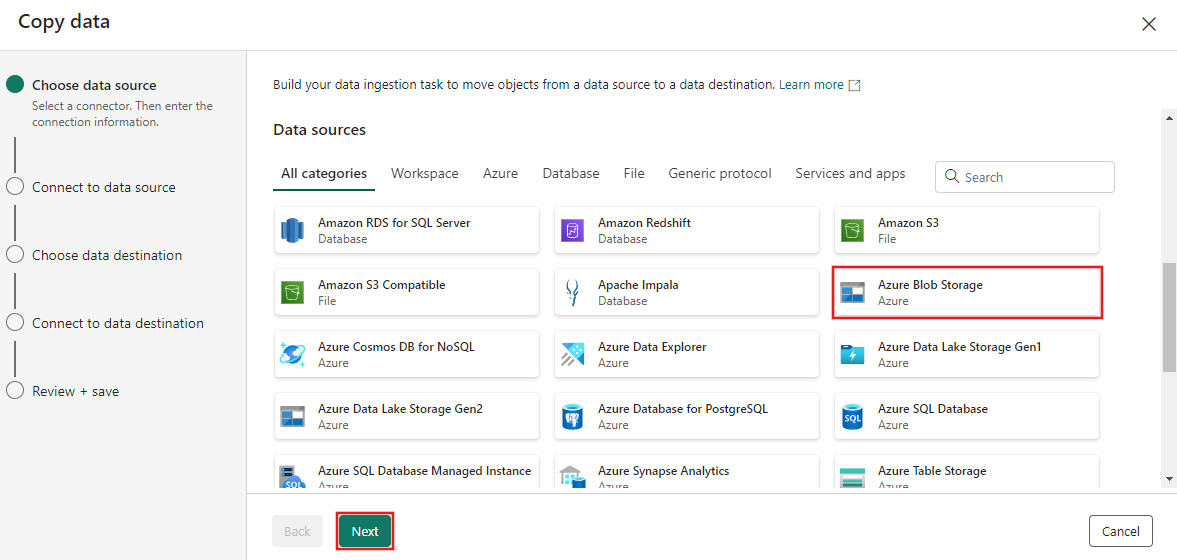

Das Dialogfeld Daten kopieren wird mit hervorgehobenem ersten Schritt Datenquelle auswählen angezeigt. Scrollen Sie bei Bedarf nach unten zum Abschnitt Datenquellen, und wählen Sie den Datenquellentyp Azure Blob Storage aus. Wählen Sie Weiteraus.

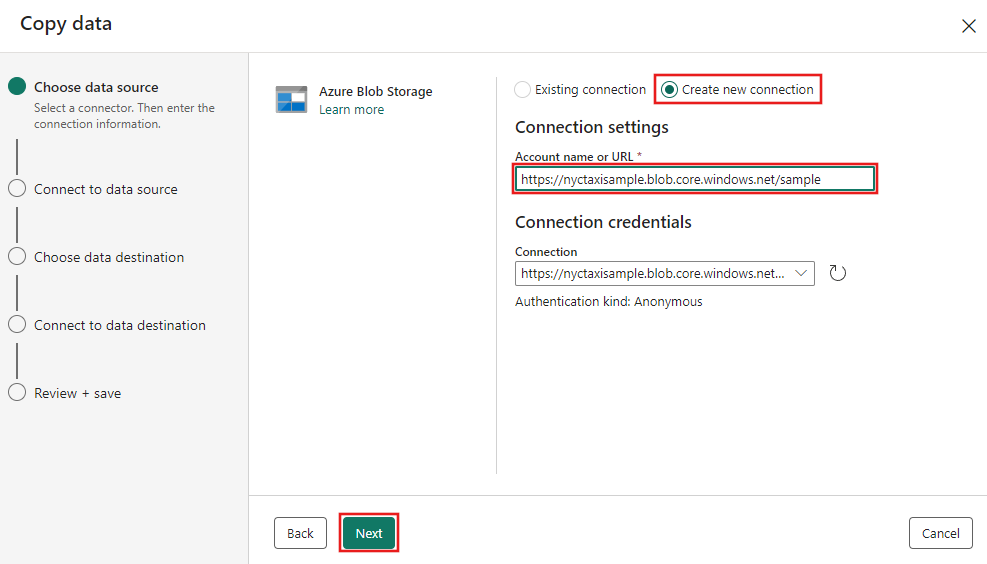

Wählen Sie im nächsten Schritt Neue Verbindung erstellen aus, und geben Sie dann die URL für den Blobspeicher an, der die Beispieldaten für dieses Tutorial unter

https://nyctaxisample.blob.core.windows.net/samplehostet. Die Authentifizierungsart entspricht Anonym. Klicken Sie auf Weiter, nachdem Sie die URL bereitgestellt haben.

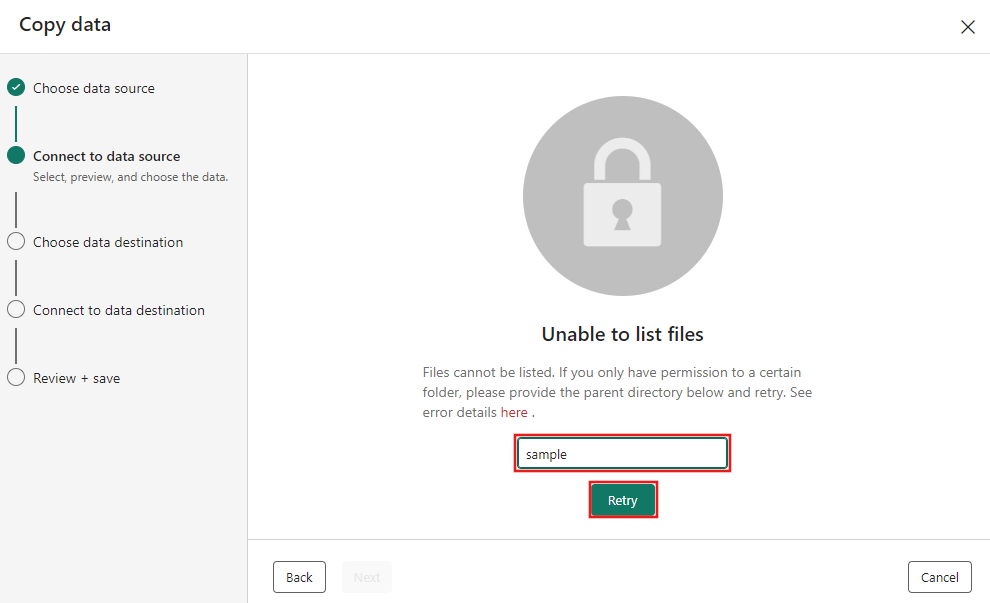

Der Schritt Verbindung mit Datenquelle herstellen wird angezeigt, und zunächst erhalten Sie die Fehlermeldung Dateien können nicht aufgelistet werden, da Berechtigungen nur für den sample-Ordner im Blobspeicher erteilt wurden. Geben Sie den Ordnernamen (sample) an, und klicken Sie auf Erneut versuchen.

Hinweis

Beim Blobspeicherordner wird die Groß-/Kleinschreibung berücksichtigt. Es sollen nur Kleinbuchstaben verwendet werden.

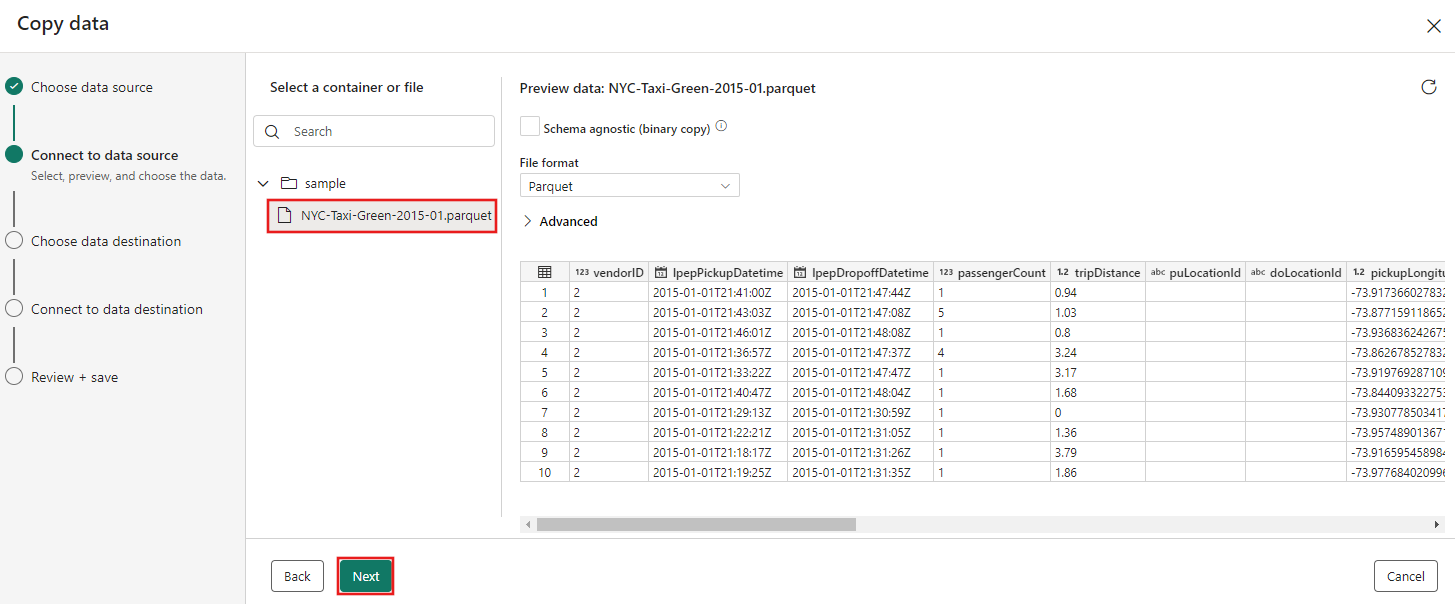

Als Nächstes wird der Blobspeicherbrowser angezeigt. Wählen Sie die Datei NYC-Taxi-Green-2015-01.parquet aus, und warten Sie, bis die Datenvorschau angezeigt wird. Wählen Sie Weiteraus.

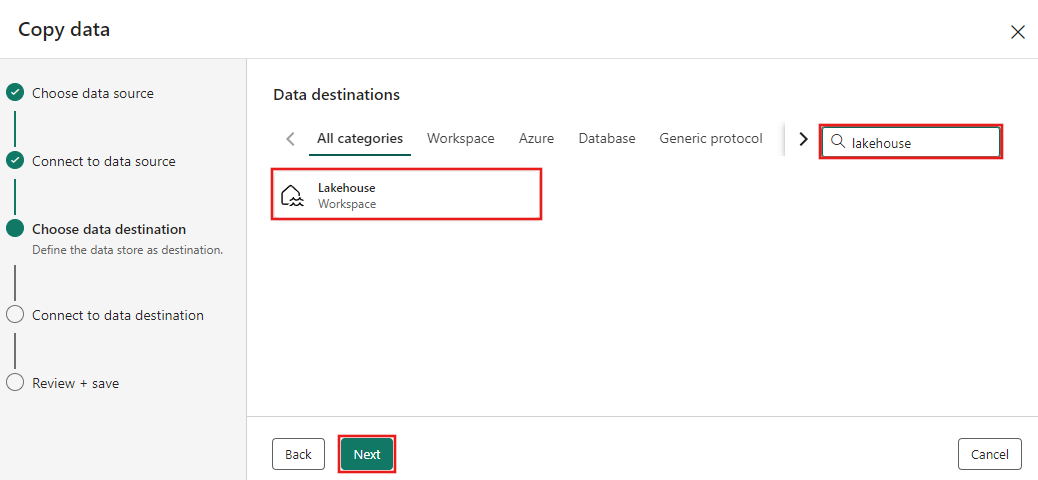

Wählen Sie beim Schritt Datenziel auswählen im Kopier-Assistenten die Option Lakehouse aus, und klicken Sie dann auf Weiter.

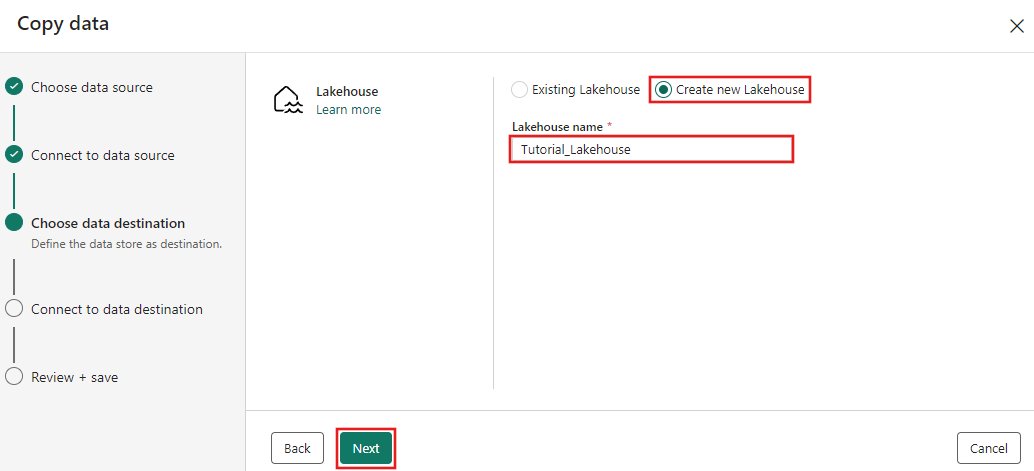

Wählen Sie auf der angezeigten Konfigurationsseite für das Datenziel Neues Lakehouse erstellen aus, und geben Sie einen Namen für das neue Lakehouse ein. Klicken Sie dann erneut auf Weiter.

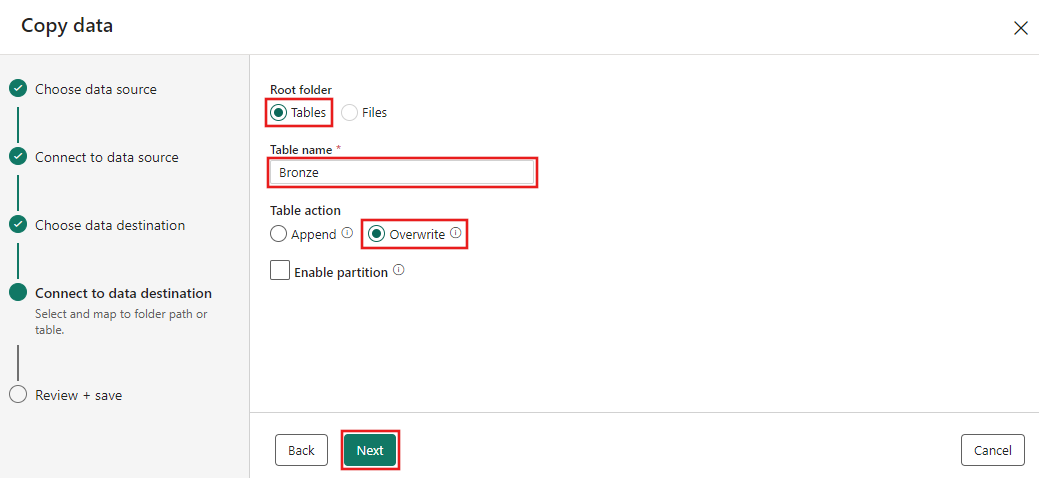

Konfigurieren Sie nun die Details Ihres Lakehouse-Ziels auf der Seite Ordnerpfad oder Tabelle auswählen und zuordnen. Wählen Sie Tabellen für den Stammordner aus, geben Sie einen Tabellennamen an, und wählen Sie die Aktion Überschreiben aus. Aktivieren Sie nicht das Kontrollkästchen Partition aktivieren, das angezeigt wird, nachdem Sie die Tabellenaktion Überschreiben ausgewählt haben.

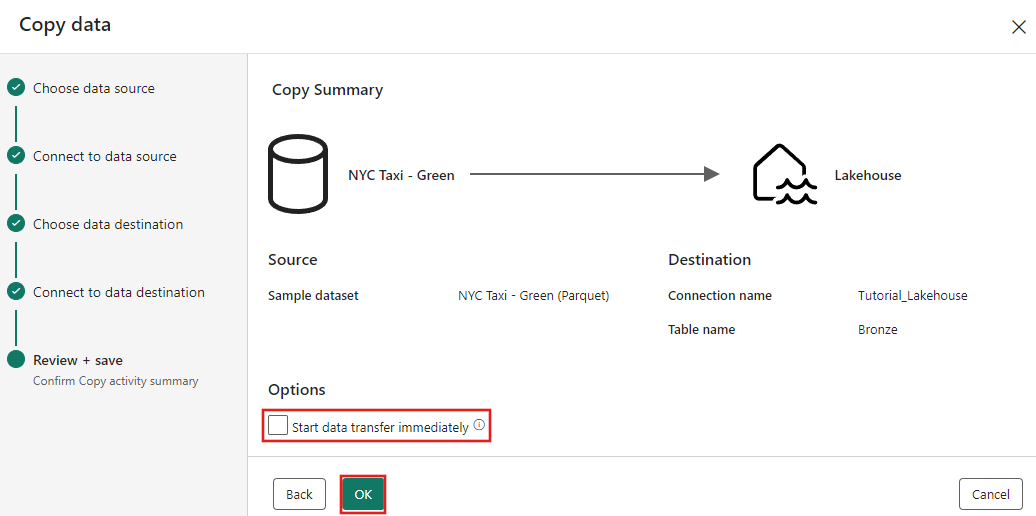

Überprüfen Sie abschließend auf der Seite Überprüfen + speichern des Assistent zum Kopieren von Daten die Konfiguration. Deaktivieren Sie für dieses Tutorial das Kontrollkästchen Datenübertragung sofort starten, da Sie die Aktivität im nächsten Schritt manuell ausführen. Klicken Sie anschließend auf OK.

Schritt 3: Ausführen und Überprüfen der Ergebnisse der Copy-Aktivität

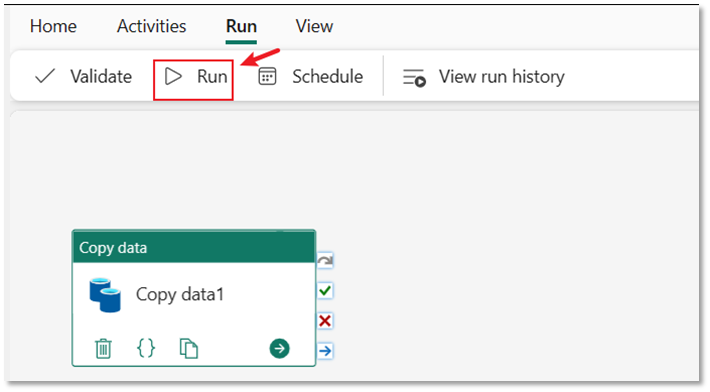

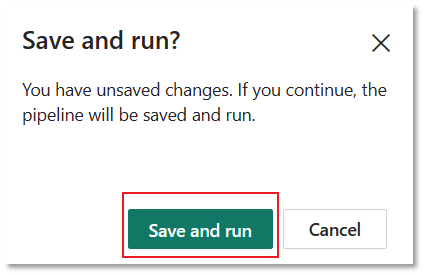

Wählen Sie im Pipeline-Editor die Registerkarte Ausführen aus. Klicken Sie zunächst auf die Schaltfläche Ausführen und dann in der Eingabeaufforderung auf Speichern und ausführen, um die Copy-Aktivität auszuführen.

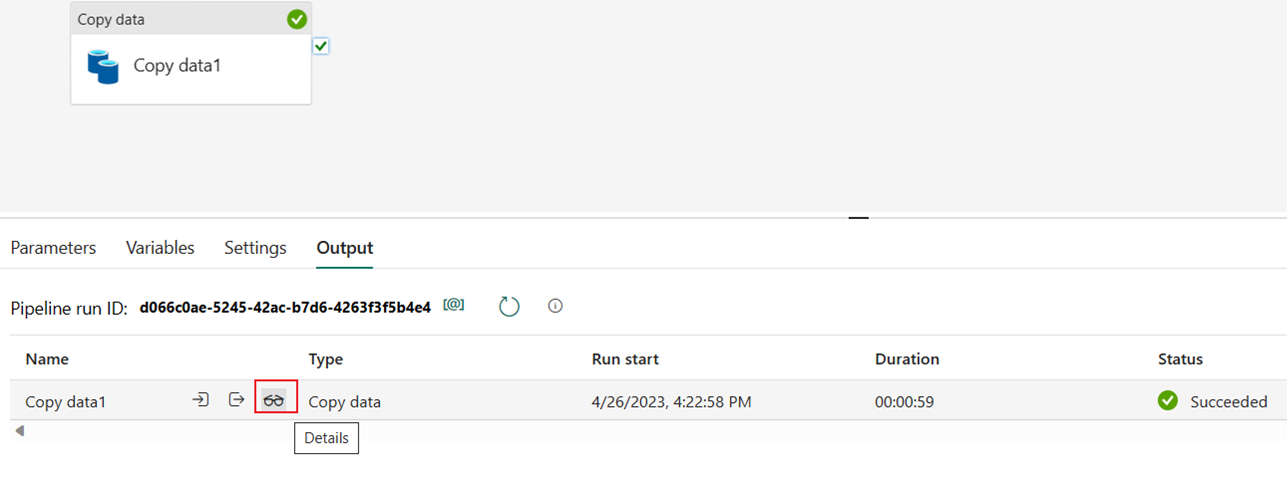

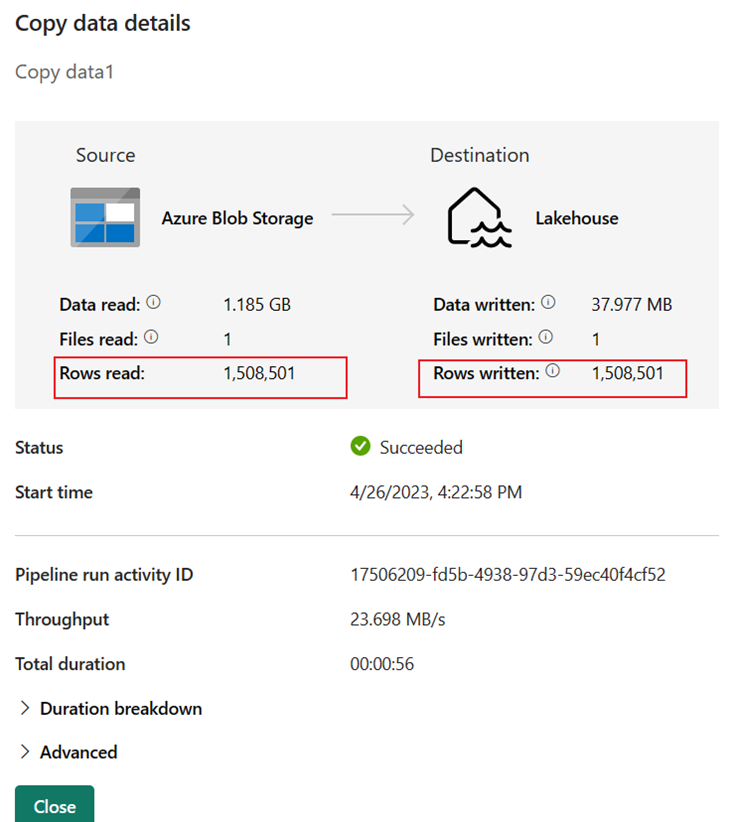

Sie können die Ausführung überwachen und die Ergebnisse auf der Registerkarte Ausgabe unterhalb der Pipelinecanvas überprüfen. Wählen Sie die Schaltfläche für Ausführungsdetails aus (Brillensymbol, das angezeigt wird, wenn Sie den Mauszeiger auf die Pipelineausführung bewegen), um die Ausführungsdetails anzuzeigen.

Die Ausführungsdetails geben an, dass 1.508.501 Zeilen gelesen und geschrieben wurden.

Erweitern Sie den Abschnitt Aufschlüsselung der Ausführungsdauer, um die Dauer der einzelnen Phasen der Copy-Aktivität anzuzeigen. Nachdem Sie die Kopierdetails überprüft haben, klicken Sie auf Schließen.

Zugehöriger Inhalt

In diesem ersten Modul im Rahmen des umfassenden Tutorials für Ihre erste Datenintegration mit Data Factory in Microsoft Fabric haben Sie Folgendes gelernt:

- Erstellen einer Datenpipeline.

- Hinzufügen einer Copy-Aktivität zu Ihrer Pipeline

- Verwenden von Beispieldaten und Erstellen eines Data Lakehouse zum Speichern der Daten in einer neuen Tabelle

- Ausführen der Pipeline und Anzeigen von Details und der Aufschlüsselung der Ausführungsdauer

Fahren Sie jetzt mit dem nächsten Abschnitt fort, um Ihren Dataflow zu erstellen.

Feedback

Bald verfügbar: Im Laufe des Jahres 2024 werden wir GitHub-Issues stufenweise als Feedbackmechanismus für Inhalte abbauen und durch ein neues Feedbacksystem ersetzen. Weitere Informationen finden Sie unter https://aka.ms/ContentUserFeedback.

Feedback senden und anzeigen für