Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Direkte Speicherplätze in Windows Server ermöglichen es Ihnen, hoch verfügbare und skalierbare Speicherlösungen mithilfe von Branchenstandardservern mit lokalem Speicher zu erstellen. Bevor Sie bereitstellen, ist es wichtig, sicherzustellen, dass Ihre Hardware die Mindestanforderungen für Zuverlässigkeit und Leistung erfüllt. In diesem Artikel werden die unterstützten Hardwarekonfigurationen, empfohlenen Verfahren und wichtige Überlegungen für physische und virtuelle Bereitstellungen von Storage Spaces Direct in Windows Server beschrieben. Verwenden Sie diese Anleitung, um Ihre Umgebung zu planen und zu überprüfen, um optimale Ergebnisse zu erzielen.

Mit physischer Hardware empfiehlt Microsoft, eine validierte Hardware-/Softwarelösung von unseren Partnern zu erwerben, die Bereitstellungstools und -verfahren umfassen. Diese Lösungen wurden anhand unserer Referenzarchitektur entworfen, zusammengestellt und validiert und garantieren Kompatibilität und Zuverlässigkeit, sodass Sie sofort loslegen können.

Tipp

Direkte Speicherplätze werden auch in Azure Local verwendet, unser Betriebssystem für hyperkonvergierte Bereitstellungen mit einer Verbindung mit der Cloud. Spezifische Hardwareanforderungen für Azure Local finden Sie unter Systemanforderungen für Azure Local. Informationen zu verfügbaren Hardwarelösungen und einem Größentool finden Sie auf der Website der lokalen Azure-Lösungen.

Sie können "Direkte Speicherplätze" auch in Hyper-V oder virtuellen Azure-Computern verwenden, wie unter Verwendung von Direkte Speicherplätze in Gastcomputerclustern beschrieben.

Basisanforderungen

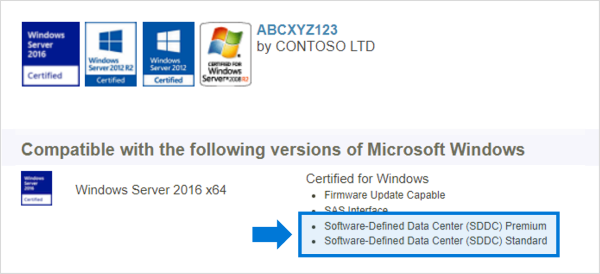

Systeme, Komponenten, Geräte und Treiber müssen für das verwendete Betriebssystem im Windows Server-Katalog zertifiziert sein. Darüber hinaus wird empfohlen, dass Server und Netzwerkadapter auch über die Software-Defined Data Center (SDDC) Standard und/oder Software-Defined Data Center (SDDC) Premium-Qualifikationen (AQs) verfügen, wie in der folgenden Abbildung gezeigt. Die SDDC-AQs enthalten mehr als 1.000 Komponenten.

**

Der vollständig konfigurierte Cluster (Server, Netzwerk und Speicher) muss alle Cluster-Validierungstests mithilfe des Assistenten im Failover-Cluster-Manager oder mit dem Test-ClusterPowerShell-Cmdlet bestehen.

Von Bedeutung

In Szenarien, in denen Clusterknoten implementiert sind, müssen NIC-Adapter, Treiber und Firmware exakt übereinstimmen, damit SET Teaming ordnungsgemäß funktioniert.

Serveranforderungen

Hier sind die Mindestserveranforderungen:

- Mindestens zwei Server, maximal 16 Server.

- Es wird empfohlen, dass alle Server derselbe Hersteller und das gleiche Modell sind.

Prozessor

Hier sind die minimalen CPU-Anforderungen:

- Intel Nehalem oder ein höherer kompatibler Prozessor. Oder

- AMD EPYC-Prozessor oder kompatibler Prozessor einer späteren Generation.

Gedächtnis

Hier sind die Mindestspeicheranforderungen:

- Arbeitsspeicher für Windows Server, VMs und andere Apps oder Workloads. Plus

- 4 GB RAM pro Terabyte (TB) der Cache-Laufwerkskapazität auf jedem Server für die Storage Spaces Direct-Metadaten.

Start

Hier sind die Mindestanforderungen für den Systemstart.

- Jedes Startgerät, das von Windows Server unterstützt wird, jetzt einschließlich SATADOM.

- RAID 1-Spiegelung ist nicht erforderlich, wird jedoch für den Bootvorgang unterstützt.

- Empfohlen: Mindestgröße von 200 GB.

Netzwerk

Direkte Speicherplätze erfordert eine zuverlässige Netzwerkverbindung mit hoher Bandbreite und geringer Latenz zwischen den einzelnen Knoten.

Hier sind die Mindestnetzwerkanforderungen:

Für ein minimales Interconnect bei einem kleinen 2-3-Knoten-Cluster:

- 10 GBit/s Netzwerkschnittstellenkarte (NIC) oder schneller.

- Zwei oder mehr Netzwerkverbindungen von jedem Knoten werden zur Redundanz und Leistungssteigerung empfohlen.

Empfohlene Verbindung für hohe Leistung bei großem Maßstab sowie Bereitstellungen von Clustern mit 4 oder mehr Knoten:

- NICs, die remote-direct memory access (RDMA) fähig sind, iWARP (empfohlen) oder RoCE.

- Zwei oder mehr Netzwerkverbindungen von jedem Knoten werden zur Redundanz und Leistungssteigerung empfohlen.

- 25 GBit/s NIC oder schneller.

Verkabelte oder kabellose Knotenverbindungen:

- Mit Switches: Die Netzwerkswitches müssen ordnungsgemäß konfiguriert sein, um die Bandbreite und den Netzwerktyp richtig zu verarbeiten. Wenn Sie RDMA verwenden, das das RoCE-Protokoll implementiert, ist die Konfiguration von Netzwerkgeräten und Switchen noch wichtiger.

- Ohne Switches: Knoten können über direkte Verbindungen miteinander verbunden werden, um die Verwendung eines Switches zu vermeiden. Jeder Knoten muss über eine direkte Verbindung mit jedem anderen Knoten des Clusters verfügen.

Antriebe

Direkte Speicherplätze kann mit direkt verbundenen SATA-, SAS- oder NVME-Laufwerken oder Laufwerken für persistenten Speicher (PMem), die physisch an nur jeweils einen Server angeschlossen sind, verwendet werden. Weitere Informationen zur Auswahl von Laufwerken finden Sie in den Artikeln Auswählen von Laufwerken und Grundlegendes zu und Bereitstellen von persistentem Arbeitsspeicher.

- SATA-, SAS-, persistenter Speicher und NVMe-Laufwerke (M.2, U.2 und Add-In-Karten) werden alle unterstützt.

- 512n-, 512e- und 4K-Laufwerke mit nativer Sektorengröße werden unterstützt.

- Festkörperlaufwerke müssen Schutz vor Stromverlust bieten.

- Gleiche Anzahl und Typen von Laufwerken auf jedem Server – siehe Überlegungen zur Laufwerksymmetrie.

- Cachegeräte müssen 32 GB oder größer sein.

- Geräte für beständigen Speicher werden im Blockspeichermodus verwendet.

- Wenn Sie persistente Speichergeräte als Cachegeräte verwenden, müssen Sie NVMe- oder SSD-Kapazitätsgeräte verwenden (Sie können keine HDDs verwenden).

- Wenn Sie HDDs verwenden, um Speicherkapazität bereitzustellen, müssen Sie die Speicherbuszwischenspeicherung verwenden. Speicher-Bus-Caching ist nicht erforderlich, wenn All-Flash-Bereitstellungen verwendet werden.

- DER NVMe-Treiber ist der von Microsoft bereitgestellte Treiber, der in Windows enthalten ist (der Treiberdateiname ist

stornvme.sys). - Empfohlen: Die Anzahl der Kapazitätslaufwerke ist ein ganzes Vielfaches der Anzahl der Cachelaufwerke.

- Empfohlen: Cachelaufwerke sollten eine hohe Schreibausdauer aufweisen: mindestens 3 Drive-Writes-Pro-Tag (DWPD) oder mindestens 4 Terabytes geschrieben (TBW) pro Tag – siehe Grundlegendes zu Drive-Writes-Pro-Tag (DWPD), Terabytes geschrieben (TBW) und dem minimal empfohlenen Wert für Storage Spaces Direct.

Hinweis

Wenn Sie alle Flash-Laufwerke ausschließlich zur Erweiterung der Speicherkapazität verwenden, sind die Vorteile des Cacheings von Speicherpools eingeschränkt. Erfahren Sie mehr über den Speicherpoolcache.

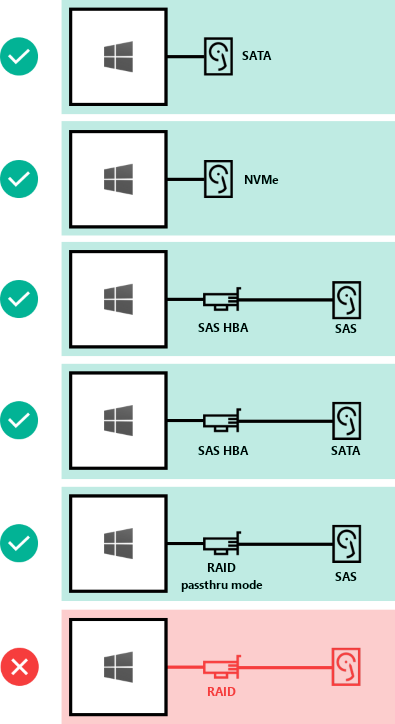

So können Laufwerke für Direkte Speicherplätze verbunden werden:

- Direkt angeschlossene SATA-Laufwerke.

- Direkt angeschlossene NVMe-Laufwerke.

- SAS-Hostbusadapter (HBA) mit SAS-Laufwerken.

- SAS-Hostbusadapter (HBA) mit SATA-Laufwerken.

- NUR RAID-Controllerkarten, die direkt über SAS-physische Speichergeräte übergeben werden.

Von Bedeutung

NICHT UNTERSTÜTZT: RAID-Controller-Karten, die keinen direkten Pass-Through für SAS-physische Speichergeräte oder SAN-Speicher (Fibre Channel, iSCSI, FCoE) unterstützen. HBA-Karten (Hostbusadapter) müssen einen einfachen Passthrough-Modus für alle Speichergeräte implementieren, die für direkte Speicherplätze verwendet werden.

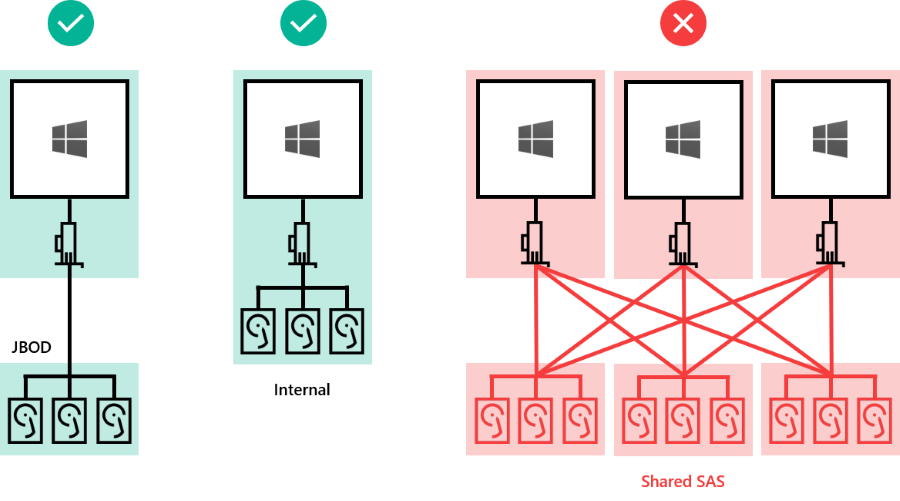

Laufwerke können sein:

- Intern auf dem Server

- In einem externen Gehäuse ("JBOD") mit einem Server verbunden. SES (SCSI Enclosure Services) ist für die Zuordnung und Identifikation von Slots erforderlich. Jedes externe Gehäuse muss einen eindeutigen Bezeichner (eindeutige ID) besitzen.

Von Bedeutung

NICHT UNTERSTÜTZT: Mit mehreren Servern verbundene, gemeinsam genutzte SAS-Gehäuse und jegliche Art von Multipfad-E/A (Multi-Path IO, MPIO), bei dem über mehrere Pfade auf Laufwerke zugegriffen werden kann.

Mindestanzahl von Laufwerken (ohne Startlaufwerk)

Die Mindestanzahl der benötigten Kapazitätslaufwerke hängt von Ihrem Bereitstellungsszenario ab. Wenn Sie planen, den Speicherpoolcache zu verwenden, müssen mindestens zwei Cachegeräte pro Server vorhanden sein.

Sie können Direkte Speicherplätze auf einem Cluster physischer Server oder auf Virtuellen Computern (VM)-Gastclustern bereitstellen. Sie können Ihr Direkte Speicherplätze-Entwurf für Leistung, Kapazität oder ausgeglichene Szenarien basierend auf der Auswahl physischer oder virtueller Speichergeräte konfigurieren. Virtualisierte Bereitstellungen nutzen die der privaten oder öffentlichen Cloud zugrunde liegende Speicherleistung und Resilienz. Direkte Speicherplätze, die auf VM-Gastclustern bereitgestellt werden, ermöglichen es Ihnen, Hochverfügbarkeitslösungen in einer virtuellen Umgebung zu verwenden.

In den folgenden Abschnitten werden die Mindestanforderungen an das Laufwerk für physische und virtuelle Bereitstellungen beschrieben.

Physische Bereitstellungen

Diese Tabelle zeigt die Mindestanzahl von Kapazitätslaufwerken nach Typ für Hardwarebereitstellungen mit Windows Server oder Azure Local.

| Laufwerktyp (nur Kapazität) | Erforderliche Mindestlaufwerke (Windows Server) | Erforderliche Mindestlaufwerke (Azure Local) |

|---|---|---|

| Alle persistenten Arbeitsspeicher (gleiches Modell) | 4 x persistenter Arbeitsspeicher | 2 Persistenter Arbeitsspeicher |

| Alle NVMe (gleiches Modell) | 4x NVMe | 2 NVMe |

| Alle SSD (gleiches Modell) | 4x SSD | 2 SSD |

Wenn Sie den Speicherpoolcache verwenden, müssen mindestens 2 weitere Laufwerke für den Cache konfiguriert sein. Die Tabelle enthält die Mindestanzahl der Laufwerke, die für Windows Server- und Azure Local-Bereitstellungen mit mindestens zwei Knoten erforderlich sind.

| Vorhandener Laufwerkstyp | Erforderliche Mindestlaufwerke |

|---|---|

| Persistenter Arbeitsspeicher + NVMe oder SSD | 2 x persistenter Arbeitsspeicher + 4 x NVMe oder SSD |

| NVMe + SSD | 2x NVMe und 4x SSD |

| NVMe + HDD | 2x NVMe und 4x HDD |

| SSD + HDD | 2x SSD und 4x HDD |

Von Bedeutung

Der Speicherpoolcache kann nicht mit Azure Local in einer Einzelknotenbereitstellung verwendet werden.

Virtuelle Bereitstellung

Diese Tabelle zeigt die Mindestanzahl von Laufwerken nach Typ für virtuelle Bereitstellungen wie Windows Server-Gast-VMs oder Windows Server Azure Edition.

| Laufwerktyp (nur Kapazität) | Erforderliche Mindestlaufwerke |

|---|---|

| Virtuelle Festplatten | 2 |

Tipp

Um die Leistung für Gast-VMs bei der Ausführung auf Azure Local oder Windows Server zu steigern, sollten Sie den CSV-In-Memory-Lesecache verwenden, um ungepufferte Lesevorgänge zwischenzuspeichern.

Wenn Sie Direkte Speicherplätze in einer virtuellen Umgebung verwenden, müssen Sie Folgendes berücksichtigen:

- Virtuelle Datenträger sind nicht anfällig für Fehler wie physische Laufwerke, sie sind jedoch von der Leistung und Zuverlässigkeit der öffentlichen oder privaten Cloud abhängig.

- Es wird empfohlen, eine einzelne Ebene mit geringer Latenz / hochleistungsstarken Speicher zu verwenden.

- Virtuelle Datenträger dürfen nur für Kapazität verwendet werden.

Erfahren Sie mehr über die Bereitstellung von 'Storage Spaces Direct' in Clustern virtueller Gastcomputer.

Maximale Kapazität

Die Anzahl der Server im Cluster und der verwendete Laufwerktyp bestimmt die maximale Kapazität von "Direkte Speicherplätze". In der folgenden Tabelle sind die Höchstwerte für Windows Server 2019 oder höher und Windows Server 2016 aufgeführt.

| Höchstwerte | Windows Server 2019 oder höher | Windows Server 2016 |

|---|---|---|

| Rohkapazität pro Server | 400 TB | 100 TB |

| Poolkapazität | 4 PB (4.000 TB) | 1 PB |